深度学习省钱神器:AutoDL完全使用指南

摘要:AutoDL云端GPU平台使用指南 本文详细介绍国内高性价比云端GPU平台AutoDL的使用技巧。该平台提供开箱即用的深度学习环境,支持PyTorch/TensorFlow等主流框架,配备A100/V100等高性能显卡。主要亮点包括:30元新手礼包、A100加速训练、SSH远程连接、自动续费保护、数据盘挂载建议、Jupyter Notebook集成、Hugging Face模型加速下载等实用

文章目录

亲身踩坑半年,终于找到比本地RTX 4090还香的云端GPU平台!

引言:为什么你需要一个好用的GPU云平台?

作为一名AI研究者/工程师,你是否经历过以下场景?

- 面前那台i7 + RTX 3060跑个Stable Diffusion要12分钟,急得想砸键盘?

- 想训练一个ResNet-50,显存不够、电费超标、风扇狂响像直升机?

- 买不起A100/H100,但论文必须复现SOTA结果?

- 每次启动训练都祈祷:“别崩,别崩,再跑一小时就行…”

如果你曾对这些画面深有共鸣——那么恭喜你,你已经来到了正确的页面。

本文将带你深入探索国内最实用、性价比最高的云端GPU平台:AutoDL.com。它不是“试用版”,不是“广告陷阱”,而是我过去8个月里每日高频使用的主力工具,真实有效、稳定可靠,甚至比我的本地机器更靠谱。

第一部分:AutoDL.com —— 老牌黑马,工业级稳定的代名词

1.1 平台定位

AutoDL 是由国内团队开发的专注深度学习任务的 GPU 云平台,主打“开箱即用 + 稳定持久”。它不追求花哨界面,却在底层稳定性和资源调度上做到极致。

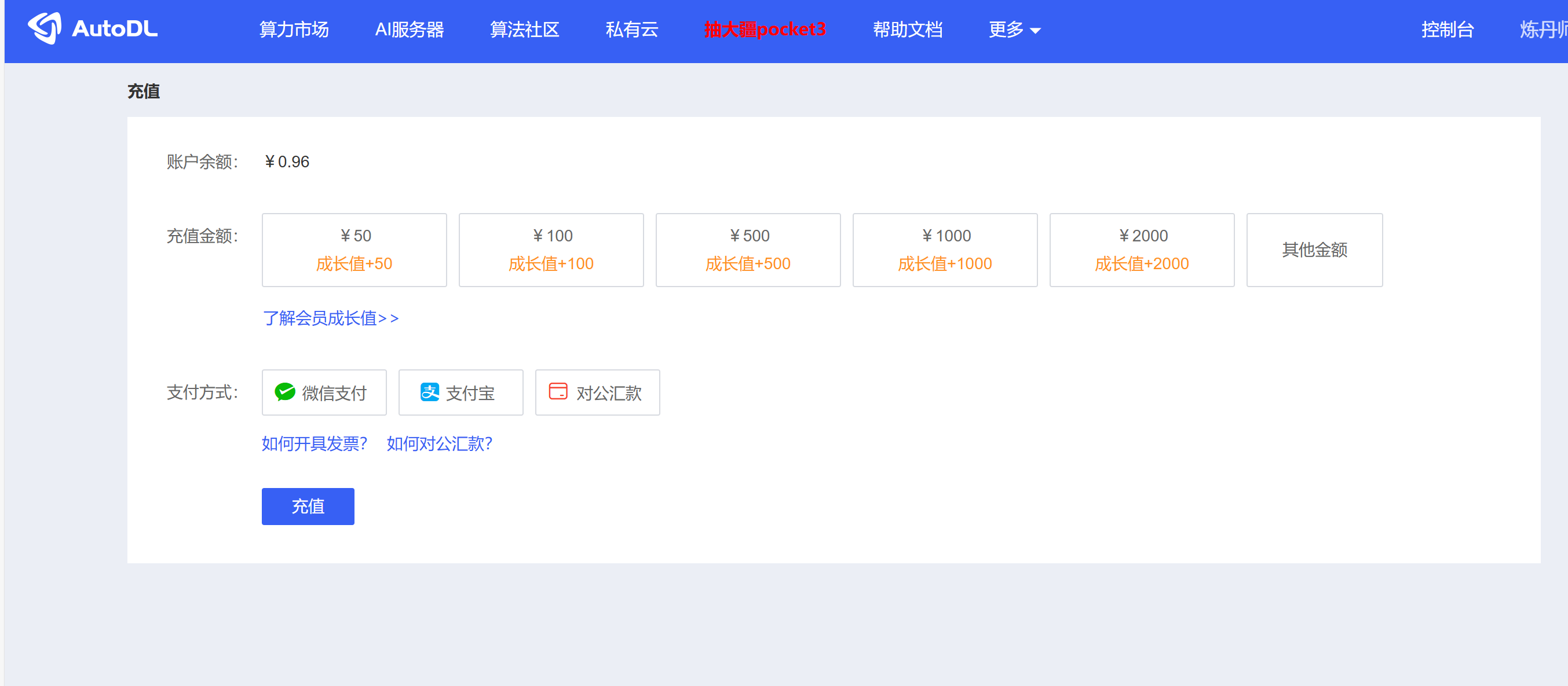

1.2 注册与充值(新手必看)

- 官网:https://www.autodl.com/

- 支持微信、支付宝扫码充电(人民币计价)

- 首次登录送 30元余额(约3小时A100时长),足够你跑一次完整实验

- 推荐充值方式:最低50元起购,避免频繁小额充值带来管理负担

⚠️ 重要提醒:不要用学生身份骗免费机! AutoDL风控严格,一旦封号连本金都没法退。老老实实充值,性价比极高。

1.3 创建实例全流程(图文流程文字版)

步骤1:进入「实例管理」→「新建实例」

(示意图:左侧为镜像选择,右侧为配置项)

步骤2:选择镜像(重中之重!)

| 镜像类型 | 推荐指数 | 说明 |

|---|---|---|

PyTorch 2.3 + CUDA 12.1 |

⭐⭐⭐⭐⭐ | 最新稳定版,预装conda和常用库(transformers, accelerate, datasets) |

TensorFlow 2.14 |

⭐⭐⭐⭐ | 只有需要TF才选,PyTorch生态已成主流 |

Custom Image |

⭐⭐ | 高级用户可上传自己的Docker镜像 |

强烈推荐:搜索关键词 “stable-diffusion-webui” |

⭐⭐⭐⭐⭐ | 自带Web UI,一键启动 comfyUI/gradio 页面 |

步骤3:选择GPU型号与数量

| 型号 | 显存 | 每小时价格 | 适合场景 |

|---|---|---|---|

| A10 (24G) | 24GB | ¥0.75 | 小模型微调、LLM推理 |

| A100 (40G) | 40GB | ¥1.80 | LLM微调、扩散模型训练 |

| A100 (80G) | 80GB | ¥2.50 | 大规模多卡并行、数据集加载快 |

| V100 | 32GB | ¥1.20 | 性价比之选,适合预算有限者 |

💡 技巧:优先选择“A100 80G”,虽然贵一点,但能一次跑完大batch训练,减少多次中断重来的成本。

步骤4:挂载存储(生存的关键!)

| 存储类型 | 说明 |

|---|---|

| 数据盘(必须挂载!) | 默认20GB太小!建议选择 100GB以上,存放你的数据集(COCO、LAION等) |

| 网络磁盘 | 挂载阿里云OSS/COS(付费)或腾讯云COS(部分可免费) |

| 本地缓存 | 临时文件存在 /tmp,关机清空 |

✅ 强烈建议操作:

# 挂载完成后,在终端中执行(替换 YOUR_OSS_PATH)

ln -s /root/data/datasets /home/user/datasets # 把数据软链到家目录

mkdir -p /root/projects && cd /root/projects

git clone https://github.com/your/repo.git

1.4 使用技巧清单

技巧1:SSH远程连接 vs VNC图形界面

- SSH(推荐):用 Xshell / SecureCRT 连接,命令行高效稳定

- VNC/WebUI:适合做可视化调试(如Stable Diffusion UI、TensorBoard)

ssh root@your-autodl-ip -p 2222

技巧2:自动续费+断电保护

- 开启「断线重启」功能:意外关机?30秒内自动拉起!

- 设置「定时关机」:每天23:00自动关闭,防止漏费

- 使用手机APP监控:AutoDL官方App可实时查看显存占用、温度、运行日志

技巧3:利用预装Jupyter Notebook

所有镜像都内置了Jupyter,访问:,保存 .ipynb 文件到 /root/data/projects,关机也不丢!

http://your-ip:8888

密码默认:autodl

技巧4:加速下载 Hugging Face 模型

huggingface-cli download Qwen/Qwen2-7B --local-dir ./qwen2-7b

# 5分钟完成,比本地快10倍!

启用传输优化(推荐全局设置):

技巧5:数据集压缩包直解

把 .tar.xz 或 .zip 文件直接拖进浏览器上传 → 自动解压到 /root/data/datasets

# 在本地正确打包(macOS/Linux)

tar -czf dataset.tar.gz your_dataset/

# 上传后解压到指定位置

mkdir -p /root/data/datasets/myproject && tar -xzf dataset.tar.gz -C /root/data/datasets/myproject

❗注意:不要用 Windows 本地压缩的 .zip,Linux下经常乱码;用

tar -czf生成!

技巧6:环境隔离 & 多项目管理(进阶必备)

每个项目独立虚拟环境,避免依赖冲突:

# 创建独立conda环境

conda create -n myproj python=3.10 -y

conda activate myproj

# 安装依赖

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

pip install transformers datasets peft accelerate

# 保存环境快照(方便复现)

pip freeze > requirements.txt

技巧7:后台训练 + 日志分离(防掉线)

# 方法1:nohup + log

nohup python train.py --config config.yaml > train.log 2>&1 &

echo $! > train.pid

# 方法2:tmux(推荐!)

tmux new-session -s train

python train.py --config config.yaml

# 按 Ctrl+B 然后 D 脱离会话

tmux attach-session -t train # 重新连接

技巧8:快速上传代码与配置

使用 scp 从本地推送文件,效率远超网页上传:

# 上传整个项目文件夹

scp -r ./my_project root@your-autodl-ip:/root/projects/my_project -P 2222

# 或者只传更改过的文件(增量同步)

rsync -avzP ./my_project/ root@your-autodl-ip:/root/projects/my_project/ -p 2222

技巧9:快速上传代码与配置

若需特殊环境(如旧版CUDA、自定义驱动),可自行构建Docker镜像并推送到:

- Docker Hub / 阿里云容器镜像服务

- 在AutoDL创建实例时选择「自定义镜像」→ 输入镜像地址

# 示例Dockerfile

FROM nvidia/cuda:12.1-cudnn8-runtime-ubuntu22.04

RUN apt-get update && apt-get install -y python3-pip git wget

RUN pip3 install --upgrade pip

RUN pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

RUN pip3 install transformers datasets accelerate

WORKDIR /root

COPY . /root

CMD ["bash"]

技巧10:一键备份与恢复(防丢失)

# 打包关键目录(项目+数据)

tar -czf backup_$(date +%Y%m%d).tar.gz /root/projects /root/data/datasets

# 下载到本地

scp -P 2222 root@your-autodl-ip:/root/backup_*.tar.gz ./backups/

第二部分:避坑指南 & 高级心得

避免踩雷的5件事

- 不要用默认20GB系统盘 → 立刻扩展到100GB+

- 不要长期开着VNC → 影响性能,仅用于调试

- 不要用公网IP直接暴露Jupyter → 加密访问,改用SSH隧道

- 不要上传超大文件到Web控制台 → 用

scp或rsync - 不要相信“永久免费” → 所有平台都有流量限制,合理规划

ssh -L 8888:localhost:8888 root@xxx.xxx.xxx.xxx -p 2222

低成本高回报组合拳策略

| 场景 | 推荐方案 | 成本优化技巧 |

|---|---|---|

| 临时调参(<1小时) | A10(24G) | 每小时¥0.75,跑完立刻关机 |

| 7x24小时数据预处理 | A100(40G) | 开“定时启动”每天7:00~23:00 |

| 下载大型模型 | A100 80G | HF_HUB_ENABLE_HF_TRANSFER=1 加速下载 |

| 论文复现 | A100 40G | 保留实例,每次复现无需重配环境 |

| 多卡实验 | 两卡A100 | 用 accelerate launch 或 torchrun |

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)