阅读:Agent AI:Surveying the Horizons of Multimodal Interaction (1-2.2)

原论文地址:https://arxiv.org/abs/2401.03568![]() https://arxiv.org/abs/2401.03568

https://arxiv.org/abs/2401.03568

摘要

多模态人工智能系统很可能在我们的日常生活中无处不在。一个让这些系统更具交互性的有效方法,是将它们以“代理”(Agent)的形式“具身化”(embody)到物理和虚拟环境中。目前,行业内的系统利用现有的基础模型作为创建具身代理的基本构建模块。将代理嵌入到这样的环境中,有助于模型处理和解释视觉及上下文数据,这对于创建更复杂、更具情境感知能力的人工智能系统至关重要。例如,一个能够感知用户行为、人类举止、环境物体、音频表达以及场景整体情绪的系统,可以被用来指导和决定代理在特定环境中的反应。

为了加速基于代理的多模态智能研究,我们将“代理AI”(Agent AI)定义为一类交互式系统,它能够感知视觉刺激、语言输入以及其他基于环境的数据,并能产生有意义的具身化行动。我们特别探讨了那些旨在通过整合外部知识、多感官输入和人类反馈来改进代理“下一步具身行动预测”能力的系统。我们认为,通过在有根有据的(grounded)环境中开发代理式AI系统,还可以减轻大型基础模型的“幻觉”问题及其生成不符合环境事实的输出的倾向。“代理AI”这个新兴领域涵盖了多模态交互中更广泛的具身化和代理化方面。除了在物理世界中行动和交互的代理之外,我们设想在未来,人们可以轻松创建任何虚拟现实或模拟场景,并与具身于其中的虚拟代理进行互动。

导读与解释

这篇摘要为我们描绘了“代理AI”(Agent AI)这一前沿领域的基本轮廓。它不仅仅是关于传统的聊天机器人,而是关于能够感知、理解并行动于真实或虚拟世界中的智能体。

以下是核心要点的分解和阐释:

1. 核心概念:从“多模态”到“具身代理”

-

多模态AI (Multi-modal AI):指的是能同时理解和处理多种信息类型(如文本、图像、声音、视频)的AI。比如,它能一边看图一边听你描述,并理解两者之间的关联。

-

具身代理 (Embodied Agent):这是关键的升级。它不再仅仅是一个处理数据的“大脑”,而是拥有了“身体”(即使是虚拟的),可以存在于一个环境中。这个“身体”让它能够:

-

感知 (Perceive):通过摄像头、麦克风等传感器(或虚拟传感器)接收环境信息。

-

行动 (Act):在环境中执行具体操作,比如移动、抓取物体、说话。

-

简单来说,“具身代理”就是一个被放入了环境、能看、能听、能动的多模态AI。 这让AI从一个“旁观者”变成了“参与者”。

2. 构建方式:站在“基础模型”的肩膀上

论文指出,我们不需要从零开始构建这些复杂的代理。现有的基础模型 (Foundation Models),如大型语言模型(GPT系列)和视觉模型(CLIP, DALL-E等),可以作为代理的“大脑”或核心认知引擎。

-

语言模型提供推理、规划和语言理解能力。

-

视觉模型提供图像和场景理解能力。

-

将它们结合,代理就能理解“拿起桌上的红苹果”这样的指令,因为它既能理解语言,也能在视觉上识别出“桌子”、“红苹果”。

3. 关键目标:提升“情境感知”和“行动预测”

代理AI的核心智能体现在它如何根据环境做出反应。

-

情境感知 (Context-aware):代理需要理解它所处的完整情境,包括:

-

环境物体: 桌子、椅子、电脑。 -

人类行为: 有人在挥手、有人在皱眉。 -

音频信息: 警报声、笑声。 -

场景情绪: 氛围是紧张还是轻松。

-

-

下一步行动预测 (Next-embodied action prediction):这是代理研究的核心问题。基于对当前情境的全面理解,代理需要预测出最合理、最有用的下一步行动是什么。论文提到,可以通过外部知识、多感官输入和人类反馈来不断优化这个预测能力。

4. 重要意义:解决基础模型的“幻觉”问题

大型语言模型有时会“一本正经地胡说八道”,即产生幻觉 (Hallucinations),生成不符合事实的内容。

论文认为,将AI“具身化”并置于一个有根有据的环境 (grounded environment) 中,是解决这个问题的有效途径。因为环境本身就是一种“事实检查器”。

-

例如:如果一个语言模型说“房间里有一头大象”,一个具身代理可以通过它的“视觉”传感器立即验证房间里并没有大象,从而纠正这个错误。环境为AI的输出提供了即时的、物理的约束和反馈。

5. 未来愿景:从物理世界到无限的虚拟世界

论文的视野非常开阔,它不仅局限于物理机器人,更展望了一个未来:人们可以随心所欲地创建任何虚拟现实 (VR) 或模拟场景,并在其中与高度智能的虚拟代理互动。

-

想象一下:你可以创建一个古代罗马的模拟场景,并与一个扮演凯撒的AI代理对话;或者在模拟的外科手术室里,与一个AI助手共同完成一台复杂的手术。

总而言之,这篇摘要定义了“代理AI”是一个能够感知多模态信息、在环境中执行具体行动的交互式系统。它利用基础模型作为起点,致力于解决“幻觉”等现有AI的局限,并为我们开启了在物理和虚拟世界中与AI进行更深度、更有意义互动的可能性。

1 引言

1.1 动机

从历史上看,人工智能系统在1956年的达特茅斯会议上被定义为能够从环境中收集信息并以有用的方式与之互动的“人造生命体”。受此定义启发,明斯基(Minsky)在麻省理工学院(MIT)的研究小组于1970年构建了一个名为“复制演示”(Copy Demo)的机器人系统。该系统能够观察“积木世界”(blocks world)的场景,并成功地重建所观察到的多面体积木结构。这个系统包含了观察、规划和操作三个模块,它揭示了这些子问题中的每一个都极具挑战性,需要进一步的研究。此后,人工智能领域分裂成多个专门的子领域,这些子领域在解决这些及其他问题上各自取得了巨大进展,但**过度简化主义(over-reductionism)**模糊了人工智能研究的总体目标。

为了超越现状,有必要回归到受亚里士多德整体论(Aristotelian Holism)启发的人工智能基本原则。幸运的是,近期大型语言模型(LLMs)和视觉语言模型(VLMs)的革命使得创建符合整体论理想的新型AI代理成为可能。抓住这一机遇,本文探讨了那些集成了语言能力、视觉认知、情境记忆、直觉推理和适应性的模型。它探索了利用LLMs和VLMs完成这种整体性综合的潜力。在我们的探索中,我们还重新审视了基于亚里士多德的“目的因”(Final Cause)——即“系统为何存在”的目的论——进行系统设计,这一点在以往的人工智能发展中可能被忽视了。

随着强大的预训练LLMs和VLMs的出现,自然语言处理和计算机视觉领域迎来了一场复兴。LLMs现在展示出令人印象深刻的能力,能够解读真实世界语言数据的细微差别,其能力常常能与甚至超越人类专家的水平(OpenAI, 2023)。最近,研究人员已经证明,当与特定领域的知识和模块相结合时,LLMs可以被扩展为在各种环境中充当代理,执行复杂的动作和任务(Xi et al., 2023)。这些场景以复杂的推理、对代理角色及其环境的理解以及多步规划为特征,考验了代理在其环境约束下做出高度精细和复杂决策的能力(Wu et al., 2023; Meta Fundamental AI Research (FAIR) Diplomacy Team et al., 2022)。

在这些初步努力的基础上,人工智能社区正处于一个重要范式转变的风口浪尖,即从为被动的、结构化的任务创建AI模型,转向能够在多样化和复杂的环境中扮演动态的、代理角色的模型。在此背景下,本文研究了将LLMs和VLMs用作代理的巨大潜力,重点关注那些融合了语言能力、视觉认知、情境记忆、直觉推理和适应性的模型。将LLMs和VLMs作为代理来利用,尤其是在游戏、机器人和医疗健康等领域,不仅为最先进的AI系统提供了一个严格的评估平台,也预示了以代理为中心的AI将对整个社会和行业产生的变革性影响。当其潜力被充分利用时,代理式模型可以重新定义人类体验并提升运营标准。这些模型带来的广泛自动化潜力,预示着行业和社经动态的巨大转变。这样的进步将与多方面的排行榜(leader-board)交织在一起,不仅是技术的,也是伦理的,我们将在第11节中详细阐述。我们深入探讨了代理AI这些子领域的重叠区域,并在图1中阐明了它们的相互关联性。

导读与解释

这部分引言为整篇论文奠定了理论基础和宏大叙事。作者的核心论点是:AI的发展走偏了,现在是时候利用LLM和VLM等新技术,回归初心,构建一个统一、完整的智能体。

以下是关键点的详细解读:

-

回溯本源:AI最初的梦想是什么?

-

达特茅斯会议 (1956):作者首先引用AI领域的“开山会议”,强调AI的初衷是创造一个能与环境互动的“人造生命体”。这不仅仅是会计算或下棋,而是要能感知、能行动。

-

“复制演示” (Copy Demo, 1970):这个早期机器人项目是一个缩影,它试图整合**观察(视觉)-> 规划(思考)-> 操作(行动)**于一体。但这个项目也暴露了任务的艰巨性,导致后来AI领域“分家”了。

-

批判现状:“过度简化主义”的问题

-

过度简化主义 (Over-reductionism):这是作者提出的核心问题。意思是,AI领域为了解决难题,把自己拆分成了很多独立的子领域(如计算机视觉、自然语言处理、机器人学等)。大家各自为战,虽然在自己的领域取得了巨大成功,但却忘记了最终要将这些能力整合起来,创造一个完整智能体的宏伟目标。

-

后果:AI变得像一个只有“超级大脑”或“超级眼睛”的专家,而不是一个能应对复杂现实世界的完整“人”。

-

提出方案:回归“整体论”和“目的因”

-

亚里士多德整体论 (Aristotelian Holism):这是一个哲学概念,核心思想是“整体大于部分之和”。作者借此呼吁,我们不应再满足于拼凑各个独立的AI模块,而应致力于创造一个原生统一、各部分协同工作的智能系统。

-

目的因 (Final Cause):这是亚里士多德提出的四因说之一,指的是事物存在的最终目的或“为什么”。作者认为,过去的AI开发过于关注“如何实现”(技术细节),而忽略了“为什么要做这个系统”(它的终极目标)。对于代理AI,这个“为什么”就是要在真实世界中完成有意义的任务。

-

新的机遇:LLMs和VLMs是“统一”的催化剂

-

范式转变 (Paradigm Shift):作者明确指出,我们正从“被动AI”时代走向“主动AI”时代。

-

被动AI:处理结构化、预设好的任务(如图像分类、文本翻译)。

-

主动AI (代理式AI):在动态、不可预测的环境中主动扮演角色,做出决策并执行行动。

-

-

LLMs/VLMs的角色:它们是实现这一转变的关键。因为它们天生就具备了强大的语言理解和视觉认知能力,可以作为代理的“认知核心”,将感知、推理和行动规划无缝连接起来。

-

代理AI的核心特征与未来影响

-

五大核心能力:作者强调,理想的代理AI应具备:

-

语言能力 (Linguistic proficiency)

-

视觉认知 (Visual cognition)

-

情境记忆 (Contextual memory)

-

直觉推理 (Intuitive reasoning)

-

适应性 (Adaptability)

-

-

应用前景与社会影响:论文预言,代理AI将在游戏、机器人、医疗等领域产生巨大影响,不仅是技术评估的平台,更会带来深刻的社会和经济变革(如大规模自动化)。同时,作者也埋下伏笔,指出这会带来复杂的伦理问题(将在第11节讨论)。

总而言之,这篇引言通过“回顾历史 -> 批判现状 -> 提出哲学理念 -> 拥抱新技术”的逻辑链,清晰地阐述了为什么“代理AI”是AI发展的必然方向,并为整篇论文的研究内容(如何构建、评估和思考这种AI)设定了基调。

1.2 背景

现在我们将介绍相关的研究论文,这些论文为代理AI的概念、理论背景和现代实现提供了支持。

大型基础模型 (Large Foundation Models):大型语言模型(LLMs)和视觉语言模型(VLMs)一直在推动通用智能机器的开发工作(Bubeck et al., 2023; Mirchandani et al., 2023)。尽管它们是使用大型文本语料库进行训练的,但其卓越的问题解决能力并不仅限于传统的语言处理领域。LLMs有潜力解决以前被认为是人类专家或特定领域算法专属的复杂任务,范围从数学推理(Imani et al., 2023; Wei et al., 2022; Zhu et al., 2022)到回答专业法律问题(Blair-Stanek et al., 2023; Choi et al., 2023; Nay, 2022)。最近的研究表明,利用LLMs为机器人和游戏AI生成复杂计划是可能的(Liang et al., 2022; Wang et al., 2023a,b; Yao et al., 2023a; Huang et al., 2023a),这标志着LLMs作为通用智能代理的一个重要里程碑。

具身AI (Embodied AI):许多工作利用LLMs来执行任务规划(Huang et al., 2022a; Wang et al., 2023b; Yao et al., 2023a; Li et al., 2023a),特别是利用LLMs所拥有的万维网(WWW)规模的领域知识和其涌现出的零样本具身能力来执行复杂的任务规划和推理。近期的机器人研究也利用LLMs来执行任务规划(Ahn et al., 2022a; Huang et al., 2022b; Liang et al., 2022),其方法是将自然语言指令分解为一系列子任务(以自然语言或Python代码的形式),然后使用一个低级控制器来执行这些子任务。此外,它们还整合环境反馈来提升任务性能(Huang et al., 2022b; Liang et al., 2022; Wang et al., 2023a; Ikeuchi et al., 2023)。

交互式学习 (Interactive Learning):为交互式学习而设计的AI代理结合了机器学习技术和用户互动来进行运作。最初,AI代理在一个大型数据集上进行训练。根据代理的预期功能,这个数据集包含各种类型的信息。例如,一个为语言任务设计的AI会在海量的文本语料库上进行训练。训练过程涉及使用机器学习算法,可能包括像神经网络这样的深度学习模型。这些训练模型使AI能够根据其训练数据识别模式、做出预测并生成响应。AI代理还可以从与用户的实时互动中学习。这种交互式学习可以通过多种方式发生:1) 基于反馈的学习:AI根据用户的直接反馈来调整其响应(Li et al., 2023b; Yu et al., 2023a; Parakh et al., 2023; Zha et al., 2023; Wake et al., 2023a,b,c)。例如,如果用户纠正了AI的回答,AI可以利用这个信息来改进未来的响应(Zha et al., 2023; Liu et al., 2023a)。2) 观察式学习:AI通过观察用户互动并进行隐式学习。例如,如果用户频繁地问相似的问题或以特定的方式与AI互动,AI可能会调整其响应以更好地适应这些模式。这使得AI代理能够理解和处理人类语言、多模态设置,解释跨现实情境,并生成符合人类用户期望的响应。随着时间的推移,通过更多的用户互动和反馈,AI代理的性能通常会持续提升。这个过程通常由人类操作员或开发者监督,以确保AI在正确地学习,而不会产生偏见或错误的模式。

导读与解释

这部分内容为论文的核心观点——“代理AI”——提供了三大技术支柱的文献综述。作者通过引用相关研究,告诉我们构建代理AI并非空中楼阁,而是建立在近年来AI各领域坚实进展之上的。

这三大支柱分别是:

-

支柱一:大型基础模型 (LLMs & VLMs) —— 代理的“大脑”

-

核心思想:LLMs(如GPT-4)和VLMs(能理解图文的模型)不仅仅是“聊天机器人”或“图像生成器”。它们已经演变成一种通用的问题解决引擎。

-

跨领域能力:论文列举了几个例子来证明这一点:

-

数学和法律:这些是需要高度逻辑、推理和专业知识的领域。LLMs能胜任,说明它们具备了超越简单文本模仿的深度智能。

-

为机器人/游戏AI做规划:这是迈向“代理AI”的关键一步。LLMs可以理解一个高层目标(比如“帮我拿杯水”),并将其分解成一系列机器人可以执行的步骤。这证明了LLMs可以成为代理的“大脑”或“规划师”。

-

-

关键启示:我们不需要为代理AI从头开发一个大脑,强大的、现成的基础模型就是最佳选择。

-

支柱二:具身AI (Embodied AI) —— 代理的“身体”与“行动”

-

核心思想:将LLMs的“大脑”与一个能与物理世界(或虚拟世界)互动的“身体”连接起来。

-

关键技术:任务规划 (Task Planning)

-

分解任务:这是核心环节。具身AI将一个模糊的人类指令(如“整理房间”)分解成一个具体的、可执行的动作序列(如:1. 找到垃圾;2. 拿起垃圾;3. 走到垃圾桶;4. 扔掉垃圾...)。

-

输出形式:这个动作序列可以是自然语言,也可以是直接能运行的

Python代码。

-

-

重要机制:环境反馈 (Environmental Feedback)

-

这解决了“纸上谈兵”的问题。如果代理在执行任务时出错了(比如,想抓一个东西但没抓到),它能通过传感器(摄像头、力传感器等)感知到这个失败。

-

然后,它可以利用这个反馈信息来调整计划,进行重试或改变策略。这形成了一个“感知-思考-行动-反馈”的闭环,让代理变得更智能、更鲁棒。

-

-

支柱三:交互式学习 (Interactive Learning) —— 代理的“成长”与“进化”

-

核心思想:一个好的代理不应该是出厂后就一成不变的,它必须能够在使用过程中不断学习和进步。

-

两种学习方式:

-

基于反馈的学习 (Feedback-based Learning):这是显式的学习。用户像老师一样直接纠正AI。

-

例子:你对AI说“你错了,这句话应该这么翻译”,AI会记住这次纠正,下次遇到类似情况时就会做得更好。这正是类似

ChatGPT等模型中“点赞/点踩”按钮背后的原理(即RLHF - 从人类反馈中强化学习)。

-

-

观察式学习 (Observational Learning):这是隐式的学习。AI像一个细心的学徒,通过观察用户的行为模式来领悟用户的偏好和意图。

-

例子:AI发现你总是在早上询问天气预报,它可能会学会在早上主动为你推送天气信息。

-

-

-

监督的重要性:作者特别提到,这个学习过程需要人类的监督,以防止AI学到坏习惯、偏见或错误信息,确保其“健康成长”。

总结一下,这三个背景领域共同描绘了构建一个理想“代理AI”的蓝图:

-

用大型基础模型作为强大的大脑,负责思考和规划。

-

用具身AI的技术,赋予它一个可以行动的身体,并通过环境反馈在行动中学习。

-

用交互式学习的机制,让它在使用过程中像人一样不断成长和进化。

1.3 概述

多模态代理AI(Multimodal Agent AI, MAA)是一类系统,它们基于对多模态感官输入的理解,在给定的环境中生成有效的行动。随着大型语言模型(LLMs)和视觉语言模型(VLMs)的出现,从基础研究到应用等各个领域,涌现出了大量的MAA系统。尽管这些研究领域通过与各自领域的传统技术(例如,视觉问答和视觉语言导航)相结合而迅速发展,但它们拥有共同的关注点,如数据收集、基准测试和伦理视角。在本文中,我们聚焦于MAA的一些代表性研究领域,即多模态、游戏(VR/AR/MR)、机器人技术和医疗健康,旨在就这些领域中讨论的共同问题提供全面的知识。我们期望通过本文学习MAA的基础知识,并为进一步推动其研究获得见解。具体的学习成果包括:

MAA概述:深入探讨其原理和在当代应用中的作用,为研究人员提供对其重要性和用途的透彻理解。

方法论:通过在游戏、机器人和医疗健康领域的案例研究,详细举例说明LLMs和VLMs如何增强MAA。

性能评估:提供使用相关数据集评估MAA的指南,重点关注其有效性和泛化能力。

伦理考量:讨论部署代理AI的社会影响和伦理挑战,强调负责任的开发实践。

新兴趋势与未来方向:对每个领域的最新发展进行分类,并讨论未来的方向。

基于计算机的行动和**通用代理(Generalist Agents, GAs)**在许多任务中都很有用。一个GA要真正对其用户有价值,它需要能够自然地进行交互,并能泛化到广泛的情境和模态中。我们的目标是培养一个充满活力的研究生态系统,并在代理AI社区中建立共同的身份认同和目标感。MAA有潜力广泛应用于各种情境和模态,包括来自人类的输入。因此,我们相信代理AI这个领域可以吸引广泛的研究人员,从而培养一个充满活力的代理AI社区和共同的目标。在来自学术界和工业界的资深专家带领下,我们期望本文将成为一种互动的、丰富的体验,包含代理指令、案例研究、任务会议和实验讨论,确保为所有研究人员提供全面且引人入胜的学习体验。

本文旨在提供关于代理AI领域当前研究的通用和全面的知识。为此,本文其余部分的组织结构如下:

第2节 概述代理AI如何从与相关新兴技术(特别是大型基础模型)的集成中受益。

第3节 描述我们提出的一个用于训练代理AI的新范式和框架。

第4节 概述了在代理AI训练中广泛使用的方法论。

第5节 对各种类型的代理进行分类和讨论。

第6节 介绍代理AI在游戏、机器人和医疗健康领域的应用。

第7节 探讨研究社区为开发一种能够跨越不同模态、领域并弥合**模拟到现实(sim-to-real)**差距的通用代理AI所做的努力。

第8节 讨论代理AI不仅依赖预训练基础模型,而且通过利用与环境和用户的互动来持续学习和自我完善的潜力。

第9节 介绍我们为训练多模态代理AI设计的新数据集。

第11节 讨论关于AI代理的伦理考量、局限性以及本文的社会影响等热点话题。

导读与解释

这部分“概述”是整篇论文的“路线图”和“内容预告”。它清晰地告诉读者,这篇论文要讲什么、为什么重要、具体会涵盖哪些内容,以及文章的结构是怎样的。

以下是核心要点的解读:

-

正式定义核心概念:MAA

-

多模态代理AI (Multimodal Agent AI, MAA):作者在这里给出了一个明确的定义。它不是被动地回答问题,而是主动地生成行动 (generate effective actions)。它的决策依据是多模态感官输入 (multimodal sensory input),比如同时看到图像、听到声音、读到文字。这是理解全文的钥匙。

-

明确论文的四大焦点领域

作者坦诚,代理AI领域非常庞大,所以他们选择聚焦于四个典型且重要的领域。这四个领域代表了从“虚拟”到“物理”,从“通用技术”到“垂直应用”的完整光谱:

-

多模态 (Multimodality):这是MAA的技术基石,即处理多种信息源的能力。

-

游戏 (Gaming, VR/AR/MR):这是一个完美的“沙盒”。在虚拟世界里,我们可以低成本、高效率地开发和测试代理,让它们在复杂的环境中学习交互。

-

机器人 (Robotics):这是MAA的物理化身,是将AI智能从虚拟世界带入现实世界的关键,挑战和价值都巨大。

-

医疗健康 (Healthcare):这是一个高影响力的应用领域,展示了MAA解决现实世界复杂问题的巨大潜力,例如辅助诊断、手术规划等。

-

承诺给读者的五大学习成果

这部分就像一本书的目录简介,告诉读者读完之后能收获什么。这五点构成了论文的核心价值主张:

-

概述 (Overview):让你明白MAA是什么,有什么用。

-

方法论 (Methodologies):通过案例教你MAA是怎么实现的。

-

评估 (Evaluation):教你如何衡量一个MAA的好坏。

-

伦理 (Ethics):引导你思考这项技术的社会责任。

-

未来 (Future):为你展望未来的发展方向。

-

提出一个更高的目标:通用代理 (Generalist Agents, GAs)

-

论文的雄心不止于在特定领域做好,而是要迈向通用代理 (GAs)。这种代理的核心特征是泛化能力 (generalize),即能适应各种不同的环境、任务和交互方式,而不是一个“专才”。这呼应了引言中提到的AI“整体论”的理想。

-

论文结构导览

最后,作者清晰地列出了从第2节到第11节的全部内容,让读者可以快速索引到自己感兴趣的部分。几个特别值得关注的点:

-

第3节 (新范式和框架):这通常是论文理论创新的核心部分。

-

第7节 (弥合模拟到现实的差距):这是机器人和具身智能领域一个经典且关键的难题。在模拟器里训练得再好,如何无缝应用到混乱、不可预测的真实世界中?

-

第8节 (持续学习和自我完善):这指向了代理AI的终极形态——一个能自主进化的智能体,而不仅仅是依赖一次性的预训练。

-

第9节 (新数据集):发布新数据集是推动一个领域发展的重要贡献,说明作者团队不仅有理论,还有实践。

总而言之,这一节为读者提供了一个清晰的导航,说明了论文的研究范围、核心贡献和内容结构,展现了作者希望构建一个全面、系统、并富有前瞻性的“代理AI”知识体系的意图。

2 代理AI集成

先前研究中提出的基于LLM和VLM的基础模型,在具身AI领域的表现仍然有限,特别是在理解、生成、编辑和在未曾见过的环境或场景中进行互动方面(Huang et al., 2023a; Zeng et al., 2023)。因此,这些局限性导致AI代理的输出不尽如人意。当前以代理为中心的AI建模方法主要关注直接可访问和明确定义的数据(例如,世界状态的文本或字符串表示),并通常使用从大规模预训练中学到的、独立于领域和环境的模式来预测每个环境的行动输出(Xi et al., 2023; Wang et al., 2023c; Gong et al., 2023a; Wu et al., 2023)。

在 (Huang et al., 2023a) 的研究中,我们通过结合大型基础模型,探索了知识引导的协作式和交互式场景生成任务,并展示了令人鼓舞的结果,表明基于知识的(knowledge-grounded)LLM代理可以提升2D和3D场景理解、生成和编辑的性能,以及其他人类-代理的互动(Huang et al., 2023a)。通过集成一个代理AI框架,大型基础模型能够更深入地理解用户输入,从而形成一个复杂的、自适应的人机交互(HCI)系统。

LLM和VLM的涌现能力在许多领域正悄然发挥作用,包括生成式AI、具身AI、多模态学习的知识增强、混合现实生成、文本到视觉的编辑,以及游戏或机器人任务中的2D/3D模拟人机交互。代理AI在基础模型方面的最新进展,为解锁具身代理的通用智能提供了一个迫在眉睫的催化剂。大型行动模型(Large action models),或称为代理-视觉-语言模型(agent-vision-language models),为通用具身系统(如在复杂环境中进行规划、解决问题和学习)开辟了新的可能性。代理AI在元宇宙中迈出了更深一步,并为早期通用人工智能(AGI)开辟了道路。

导读与解释

这一部分开始深入探讨一个核心问题:当前的基础模型(LLMs/VLMs)本身还不够好,直接拿来做代理会有什么问题?以及,应该如何“集成”它们,才能构建出更强大的代理AI?

以下是关键点的解读:

-

诊断问题:基础模型作为“代理”的局限性

-

核心痛点:直接使用LLMs/VLMs做代理,效果并不理想(sub-optimal)。

-

具体表现:它们在面对未曾见过的环境 (unseen environments) 时,表现尤其糟糕。在理解新场景、根据指令生成或编辑场景中的物体、以及与新环境互动等方面能力有限。

-

深层原因:当前的方法过于依赖“文本化”的世界。它们倾向于将世界状态简化为文本或字符串,然后利用在海量文本上学到的通用模式去“套用”到所有环境中。这种方法缺乏对具体环境的深度、物理和情境化理解。

-

好比:一个只通过读万卷书来学开车的司机,理论知识丰富,但一上真车、新路段就手足无措。他知道“方向盘是圆的”,但不知道在结冰的路上打方向盘需要多轻柔。

-

-

提出解法:“知识引导”的集成

-

解决方案:不能只让模型“纸上谈兵”,必须将知识 (Knowledge) 注入(或称“锚定”)到代理中。这种“基于知识的LLM代理” (knowledge-grounded LLM agent) 是关键。

-

什么是“知识”? 在这里,“知识”是多层次的:

-

常识知识:关于世界如何运作的基本规则(比如,杯子是用来装水的,苹果可以吃)。

-

领域知识:特定场景下的专业知识(比如,在厨房里,“打蛋”通常先于“炒蛋”)。

-

环境知识:从当前环境中实时感知到的具体信息(比如,这个房间里有一张红色的椅子)。

-

-

效果:论文引用了自己的研究 (Huang et al., 2023a),证明这种方法可以显著提升代理在2D/3D场景理解、生成和编辑方面的能力。这意味着代理不再是盲目地根据文本生成内容,而是能理解场景的结构和意义。

-

展望未来:新物种的诞生

-

催化剂作用:作者认为,将“代理AI框架”与“基础模型”集成的最新进展,是点燃“通用智能”的催化剂。

-

新概念:大型行动模型 (Large Action Models):这是一个非常前沿和重要的概念。如果说大型语言模型(LLM)的输出是“文本”,那么大型行动模型的输出就是“行动”。它是一个以“行动”为核心,融合了视觉、语言和决策能力的新模型范式。

-

终极目标:这种集成和进化最终将通向何方?

-

元宇宙 (Metaverse):代理AI是构建真正沉浸式、交互式元宇宙的核心技术。

-

通用人工智能 (AGI):作者大胆地提出,代理AI是通往早期AGI的一条可行路径。因为AGI的核心特征之一,就是能在复杂、动态的世界中自主学习和解决问题,这正是代理AI的研究目标。

-

总结一下,这一节的核心论点是:单纯的LLM/VLM不足以胜任复杂的代理任务。出路在于“集成”,特别是将“知识”与模型深度融合,创造出一种新的、以行动为导向的“大型行动模型”**。这不仅能解决当前具身AI的瓶颈,更是通往元宇宙和AGI的关键一步。

2.1 无限AI代理 (Infinite AI agent)

AI代理有能力根据其训练和输入数据进行解释、预测和响应。虽然这些能力很先进且在不断提升,但认识到它们的局限性以及它们所依赖的底层训练数据的影响,是非常重要的。AI代理系统通常具备以下能力:

预测建模:AI代理可以根据历史数据和趋势预测可能的结果或建议下一步行动。例如,它们可能预测一段文本的续写、一个问题的答案、一个机器人的下一个动作,或一个场景的解决方案。

决策制定:在某些应用中,AI代理可以根据其推断做出决策。通常,代理会将其决策建立在最有可能实现特定目标的基础上。对于像推荐系统这样的AI应用,代理可以根据其对用户偏好的推断来决定推荐哪些产品或内容。

处理模糊性:AI代理通常可以通过根据上下文和训练推断出最可能的解释来处理模糊的输入。然而,它们这样做的能力受到其训练数据和算法范围的限制。

持续改进:虽然一些AI代理有能力从新数据和互动中学习,但许多大型语言模型在训练后并不会持续更新其知识库或内部表征。它们的推断通常完全基于其最后一次训练更新时点之前可用的数据。

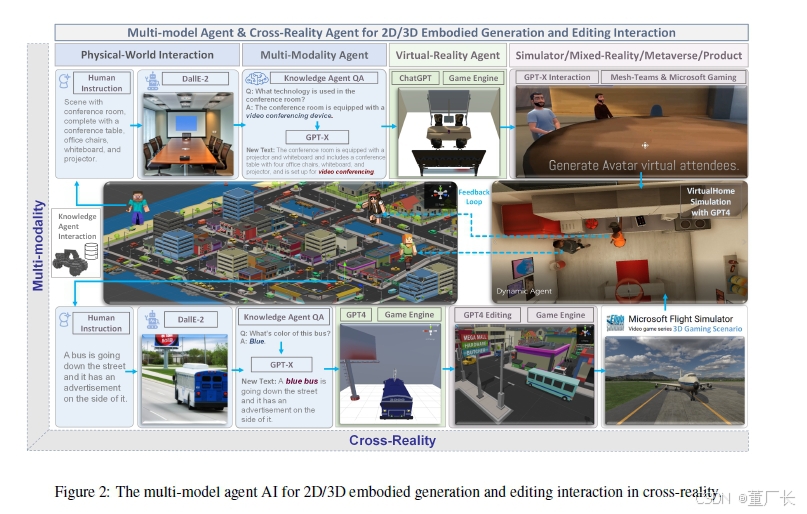

我们在图2中展示了一种用于多模态和跨现实(cross reality-agnostic)集成的增强型交互代理,该代理带有一种涌现机制。一个AI代理需要为每个新任务收集大量的训练数据,这对于许多领域来说成本高昂,甚至是不可能的。在这项研究中,我们开发了一种无限代理(infinite agent),它学习将通用基础模型(例如,GPT-X, DALL-E)的记忆信息迁移到新的领域或场景中,用于在物理或虚拟世界中进行场景理解、生成和交互式编辑。

这种无限代理在机器人领域的一个应用是RoboGen (Wang et al., 2023d)。在这项研究中,作者们提出了一个能够自主运行任务提议、环境生成和技能学习循环的流程。RoboGen是一项将大型模型中嵌入的知识迁移到机器人学的努力。

导读与解释

这一节提出了一个极具前瞻性的概念——“无限AI代理”(Infinite AI agent),并将其作为解决当前AI代理核心瓶颈的方案。

以下是关键点的解读:

-

铺垫:当前AI代理的能力与“天花板”

作者首先总结了现有AI代理的四种能力,这既是肯定它们的成就,也是为了引出它们的根本局限。

-

能力:预测、决策、处理模糊性。这些能力让AI看起来很智能。

-

局限(天花板):持续改进 (Continuous Improvement) 能力的缺失。大多数强大的基础模型(如GPT系列)一旦训练完成,其知识就被“冻结”了。它们无法像人一样,在与世界互动时实时、持续地学习新知识。它们只是在调用一个庞大但静态的数据库。

这个“知识冻结”的问题,引出了一个核心矛盾:我们希望AI能适应无限的新任务和新环境,但训练AI却需要为每个任务收集昂贵的数据,这是一个不可持续的模式。

-

核心概念:什么是“无限AI代理”?

“无限AI代理”正是为了打破上述矛盾而提出的。它的核心思想不是让AI拥有无限的知识,而是让它拥有无限学习和适应的能力。

-

解决的问题:避免为每个新任务都进行昂贵、独立的训练。

-

核心机制:知识迁移 (Knowledge Transfer)。它不从零开始学,而是聪明地“站在巨人(基础模型)的肩膀上”。它学习如何将GPT、DALL-E等通用模型中蕴含的庞大世界知识和推理能力,迁移和应用到它从未见过的新领域和新任务中。

-

“无限”的含义:这里的“无限”指的是其适应范围的潜力是无限的。理论上,只要掌握了知识迁移的方法,它就可以不断地进入新领域、解决新问题,而无需重新进行大规模训练。它学会了“如何学习”。

-

实例解析:RoboGen如何体现“无限”?

为了让“无限代理”这个抽象概念更具体,作者引入了RoboGen这个例子。RoboGen完美地诠释了“无限学习”的理念。

它创建了一个自主学习的闭环:

-

任务提议 (Task Proposition):代理自己“发明”一个新任务。(例如:“我应该学习如何把积木堆成金字塔。”)

-

环境生成 (Environment Generation):为了学习这个任务,代理自己创造一个合适的虚拟训练环境。(例如:生成一个有积木和平台的场景。)

-

技能学习 (Skill Learning):在自己创造的环境中,通过尝试和探索,学习完成自己提出的任务所需的技能。

这个循环可以无限地进行下去。完成一个任务后,代理可以举一反三,提出更复杂的任务,生成更复杂的环境,学习更高级的技能。这是一种自我驱动、自我完善的成长模式,是“无限代理”精神的体现。

总结一下,这一节从指出当前AI代理“知识固化”的局限性出发,提出了“无限AI代理”这一革命性概念。其核心是通过知识迁移,让代理具备适应无限新任务的能力。RoboGen的自主学习循环则生动地展示了这种“无限”学习模式在实践中的样子,标志着AI正从一个“被动执行者”向一个“主动学习者”和“自我进化者”转变。

2.2 采用大型基础模型的代理AI

最近的研究表明,大型基础模型在创建作为基准(benchmarks)的数据方面扮演着至关重要的角色,这些基准用于决定代理在环境施加的约束下的行动。例如,在机器人操作(Black et al., 2023; Ko et al., 2023)和导航(Shah et al., 2023a; Zhou et al., 2023a)中利用基础模型。

举例来说,Black等人利用一个图像编辑模型作为高层规划器,来生成未来子目标的图像,从而指导低层策略(Black et al., 2023)。在机器人导航方面,Shah等人提出了一个系统,该系统利用一个LLM从文本中识别地标,并利用一个VLM将这些地标与视觉输入关联起来,从而通过自然语言指令增强了导航能力(Shah et al., 2023a)。

此外,根据语言和环境因素生成受条件约束的人类动作也引起了越来越多的兴趣。已经有几个AI系统被提出来,用于生成针对特定语言指令的定制化动作(Kim et al., 2023; Zhang et al., 2022; Tevet et al., 2022),并适应各种3D场景(Wang et al., 2022a)。这一系列研究强调了生成模型在增强AI代理在不同场景下的适应性和响应能力方面日益增长的实力。

导读与解释

如果说前面几节还在讨论“为什么”和“是什么”,那么这一节则开始深入探讨“怎么做”。它通过三个具体的、前沿的研究案例,生动地展示了如何将强大的基础模型(LLMs/VLMs/图像模型)作为“大脑”或“军师”,来指导AI代理完成复杂的物理任务。

这里的核心思想是一种分层控制(Hierarchical Control)或“规划者-执行者”(Planner-Executor)的模式。

核心模式:聪明的“大脑” + 忠实的“双手”

想象一下,一个复杂的任务(比如“给我从冰箱里拿一瓶可乐”)可以被分解为两部分:

-

高层规划 (Planning):由一个非常聪明但“四体不勤”的大脑(基础模型)负责。它负责思考“我该怎么做?”,并将任务分解成一系列更简单的子目标。

-

低层执行 (Execution):由一个相对简单但“手脚麻利”的执行器(低层策略/控制器)负责。它接收来自大脑的指令,并将其转化为具体的物理动作。

本节的三个例子完美地诠释了这种模式:

案例一:机器人操作(用“想象”指导行动)

-

任务:让机器人手臂精确地操作物体。

-

方法:

-

大脑 (高层规划器):一个图像编辑模型(类似Midjourney或DALL-E)。

-

指令形式:不是文本,而是一幅图像!这个模型会“想象”并生成出任务的下一个步骤应该是什么样子的图片。例如,生成一张“机械臂已经移动到可乐正上方”的图片。

-

双手 (低层执行器):一个简单的控制器。它的唯一目标就是控制机械臂,让摄像头看到的真实画面尽可能地与“大脑”生成的目标图像相匹配。

-

-

精妙之处:这种方法非常直观且强大。它将一个复杂的规划问题,转化成了一个简单的“看图说话”式的图像匹配问题,大大降低了低层控制的难度。

案例二:机器人导航(语言理解 + 视觉识别)

-

任务:让机器人能听懂自然语言指令并在真实环境中导航(例如,“走过那个红色的邮筒,然后在下一个路口左转”)。

-

方法:这是一个“团队合作”。

-

大脑成员1 (语言专家):一个LLM。它负责从指令“走过那个红色的邮筒...”中,提取出关键的地标 (landmark):“红色的邮筒”。

-

大脑成员2 (视觉专家):一个VLM。它接收到“红色的邮筒”这个文本信息,然后在机器人的摄像头视野中,找出哪个物体是“红色的邮筒”。

-

双手 (执行器):导航系统。一旦地标在视觉上被定位,它就控制机器人朝那个方向移动。

-

-

精妙之处:它完美地结合了LLM的语言理解能力和VLM的跨模态(文本到视觉)识别能力,让机器人真正“听懂”了指令并“看懂”了世界。

案例三:生成人类动作(为虚拟人注入灵魂)

-

任务:让虚拟角色(游戏NPC、虚拟人)或人形机器人能够根据指令和环境,做出自然、协调的动作。

-

方法:使用生成模型,其输出的动作会受到两个条件的约束:

-

语言指令:比如输入“做一个挥手的动作”。

-

环境因素:比如角色面前有一堵墙,那么它在行走时就会自动绕开,而不是穿墙而过。

-

-

精妙之处:这使得代理的行为不再是僵硬的、预设的动画,而是动态生成、实时适应的,从而大大提升了代理的真实感和交互性。

总结一下,这一节通过具体的例子告诉我们,构建高级代理AI的有效路径,不是造一个无所不能的“巨无霸”模型,而是聪明地“集成”——让不同类型的基础模型各司其职(一个负责语言,一个负责视觉,一个负责想象),共同组成一个强大的“决策大脑”,来指导底层的行动,从而实现1+1>2的效果。

2.2.1 幻觉 (Hallucinations)

生成文本的代理通常容易产生幻觉,即生成的文本毫无意义或不忠实于所提供的源内容(Raunak et al., 2021; Maynez et al., 2020)。幻觉可以分为两类:内在幻觉和外在幻觉(Ji et al., 2023)。内在幻觉是指与源材料相矛盾的幻觉,而外在幻觉则是指生成的文本包含了源材料中最初未包含的额外信息。

一些用于降低语言生成中幻觉率的有前景的方法包括使用检索增强生成(retrieval-augmented generation, RAG)(Lewis et al., 2020; Shuster et al., 2021)或其他通过外部知识检索来为自然语言输出提供依据(grounding)的方法(Dziri et al., 2021; Peng et al., 2023)。通常,这些方法旨在通过检索额外的源材料来增强语言生成,并提供机制来检查生成的响应与源材料之间是否存在矛盾。

在多模态代理系统的背景下,视觉语言模型(VLM)同样被证明会产生幻觉(Zhou et al., 2023b)。对于基于视觉的语言生成来说,一个常见的幻觉原因是过度依赖训练数据中物体和视觉线索的共现性(co-occurrence)(Rohrbach et al., 2018)。那些完全依赖预训练LLM或VLM、且仅使用有限的环境特定微调的AI代理,可能特别容易产生幻觉,因为它们依赖预训练模型的内部知识库来生成行动,并且可能无法准确理解它们所部署的世界状态的动态变化。

导读与解释

这一节深入探讨了当前AI(尤其是代理AI)面临的一个核心顽疾——“幻觉”。幻觉问题是阻碍AI在严肃、高风险场景中应用的关键障碍。

以下是关键点的解读:

-

什么是AI的“幻觉”?

-

核心定义:AI“一本正经地胡说八道”。它生成的内容要么是无中生有,要么是与事实相悖,但其语气却非常自信。

-

两种类型:

-

内在幻觉 (Intrinsic Hallucination):与事实冲突。

-

例子:源材料说“天空是蓝色的”,AI却生成“天空是绿色的”。这是直接的矛盾。

-

-

外在幻觉 (Extrinsic Hallucination):无中生有。

-

例子:源材料只描述了“一个男人走进房间”,AI却生成“一个穿着红色夹克的男人走进房间”。“红色夹克”这个信息是AI自己“脑补”的,源材料里并没有。虽然它不一定与事实矛盾,但它不可靠。

-

-

-

如何对抗“幻觉”?—— 给AI一个“事实检查器”

作者介绍了一种目前最主流、最有效的技术:检索增强生成 (Retrieval-Augmented Generation, RAG)。

-

工作原理:不要让AI只凭自己的“记忆”(预训练知识)来回答问题。

-

检索 (Retrieve):当AI收到一个问题或指令时,它首先去一个可靠的、最新的外部知识库(比如公司的内部文档、最新的网络新闻)中搜索最相关的信息。

-

增强 (Augment):将检索到的这些信息,连同原始问题一起,作为“上下文”或“参考资料”提供给AI。

-

生成 (Generate):要求AI基于这些提供的参考资料来生成答案。

-

-

效果:这相当于给AI开卷考试,而不是闭卷考试。它迫使AI的回答必须有据可依 (grounded),从而大大减少了凭空捏造和与事实矛盾的可能性。

-

幻觉的“多模态”版本

-

幻觉不仅存在于文本中,视觉语言模型 (VLM) 也会产生幻觉。

-

原因:过度依赖统计规律(共现性)。模型在训练时学习到的是“A和B经常一起出现”,而不是真正的因果关系或物理规律。

-

经典例子:如果训练数据里绝大多数的“草地”图片都是绿色的,模型就会学到“草=绿色”这个强关联。当你给它一张因为干旱而变黄的草地图片,并问它“草是什么颜色?”,它很可能会“幻觉”出“绿色”的答案,因为它过度依赖了它学到的统计偏见,而忽略了眼前图片的真实内容。

-

-

为什么“代理AI”特别容易产生幻觉?

这是本节的落脚点,也是与论文主题最相关的部分。

-

核心风险:一个被部署到真实环境(比如你家里的机器人)的代理,如果它完全依赖自己预训练的、通用的“内部知识”,而没有对当前环境进行充分的理解和微调,那么它就非常危险。

-

场景举例:

-

一个预训练模型知道“杯子通常放在桌子上”。

-

你把一个杯子放在了沙发上。

-

你对机器人代理说:“把沙发上的杯子递给我。”

-

如果这个代理“幻觉”了,它可能会径直走向桌子去寻找杯子,因为它脑中“杯子在桌上”的先验知识过于强大,压倒了它对当前环境的真实感知。它没有真正“理解”你家里的具体情况。

-

总结一下,这一节清晰地定义了AI的幻觉问题,介绍了主流的解决方案(RAG),并将其扩展到多模态领域。最重要的是,它强调了“幻觉”对于具身代理AI的致命风险,再次论证了论文的核心观点:必须让代理AI深深植根于(grounded in)其所处的具体环境中,通过环境反馈和特定微调来对抗基于通用知识的幻-觉,否则它将永远是一个不可靠的工具。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)