提示工程无服务器架构的同步调用:架构师的最佳实践

在AI驱动的实时应用场景中,提示工程的灵活性与无服务器架构的弹性成为解决同步调用挑战的关键组合。本文深入探讨了两者协同的核心逻辑,从第一性原理出发推导同步调用的约束条件,系统分解架构组件与交互模型,并结合生产级实现细节与案例研究,为架构师提供一套可落地的最佳实践指南。内容覆盖概念基础、理论框架、架构设计、实现机制、实际应用及高级考量,兼顾技术深度与教学清晰度,助力解决实时AI推理、即时数据处理等场

提示工程与无服务器架构的协同:同步调用场景下的架构师最佳实践

元数据框架

标题

提示工程与无服务器架构的协同:同步调用场景下的架构师最佳实践

关键词

提示工程(Prompt Engineering)、无服务器架构(Serverless Architecture)、同步调用(Synchronous Invocation)、云原生(Cloud Native)、架构设计(Architecture Design)、实时AI推理(Real-time AI Inference)、最佳实践(Best Practices)

摘要

在AI驱动的实时应用场景中,提示工程的灵活性与无服务器架构的弹性成为解决同步调用挑战的关键组合。本文深入探讨了两者协同的核心逻辑,从第一性原理出发推导同步调用的约束条件,系统分解架构组件与交互模型,并结合生产级实现细节与案例研究,为架构师提供一套可落地的最佳实践指南。内容覆盖概念基础、理论框架、架构设计、实现机制、实际应用及高级考量,兼顾技术深度与教学清晰度,助力解决实时AI推理、即时数据处理等场景中的低延迟、高可靠需求。

1. 概念基础:领域背景与问题定义

1.1 领域背景:AI时代的实时需求与技术协同

随着大语言模型(LLM)、计算机视觉等AI技术的普及,实时性成为许多应用的核心竞争力——例如:

- 客服机器人需要即时响应用户的问题;

- 代码辅助工具需要实时生成代码建议;

- 电商平台需要实时推荐商品;

- 医疗诊断系统需要快速分析患者症状。

这些场景的共同特点是:用户请求必须在短时间内(通常<5秒)得到响应,否则会导致用户体验下降甚至业务损失。而实现这一目标需要两个关键技术的协同:

- 提示工程(Prompt Engineering):通过优化输入(提示)来引导AI模型生成符合预期的输出,是AI应用的“灵魂”;

- 无服务器架构(Serverless Architecture):通过按需分配资源(如FaaS)实现弹性扩展,降低运维成本。

1.2 历史轨迹:从传统架构到同步无服务器

- 传统服务器架构:采用固定资源分配(如虚拟机),无法应对突发流量,且运维成本高;

- 异步无服务器架构:通过消息队列(如SQS)实现异步处理,适合非实时场景(如数据ETL),但无法满足同步调用的低延迟需求;

- 同步无服务器架构:结合无服务器的弹性与同步调用的实时性,成为AI实时应用的主流选择(如OpenAI的API服务本质上就是同步无服务器架构)。

1.3 问题空间定义:同步调用的核心挑战

在无服务器架构中实现同步调用(Synchronous Invocation),需要解决以下问题:

- 低延迟要求:同步调用的超时时间通常较短(如API网关默认30秒),需避免冷启动、模型调用延迟等问题;

- 资源限制:无服务器函数(如AWS Lambda)有执行时间(≤15分钟)、内存(≤10GB)等限制,无法处理超长提示或复杂模型;

- 动态性:提示工程的灵活性(如动态调整提示模板)要求架构支持快速迭代,避免修改代码导致的部署成本;

- 可靠性:同步调用需要保证“一次请求一次响应”,需处理模型服务故障、网络波动等异常情况。

1.4 术语精确性

- 提示工程(Prompt Engineering):设计和优化输入(提示)以引导AI模型生成符合预期输出的过程;

- 无服务器架构(Serverless Architecture):由云服务商管理服务器资源,开发者只需关注代码逻辑的架构模式,核心是FaaS(Function as a Service);

- 同步调用(Synchronous Invocation):请求方发送请求后等待响应,直到收到结果或超时;

- 冷启动(Cold Start):无服务器函数首次执行时,云服务商需要分配资源(如容器)导致的延迟;

- FaaS(Function as a Service):无服务器架构的核心组件,允许开发者部署单个函数,按需执行。

2. 理论框架:第一性原理与数学建模

2.1 第一性原理推导:同步调用的核心需求

同步调用的本质是**“请求-等待-响应”**,其核心需求可分解为:

- 低延迟(Latency):总延迟≤用户可接受的阈值(如5秒);

- 高可靠(Reliability):成功响应率≥99.9%;

- 弹性扩展(Scalability):应对突发流量(如秒杀活动);

- 成本优化(Cost):按实际使用量付费(如Lambda的“毫秒级计费”)。

无服务器架构的核心优势(弹性、低成本)与提示工程的核心需求(灵活、实时)高度契合,但需解决两者的冲突(如无服务器的资源限制与提示处理的复杂性)。

2.2 数学形式化:同步调用的延迟模型

设同步调用的总延迟为 ( T_{\text{total}} ),则:

Ttotal=Tcold+Tfunc+Tprompt+Tmodel+Tnetwork T_{\text{total}} = T_{\text{cold}} + T_{\text{func}} + T_{\text{prompt}} + T_{\text{model}} + T_{\text{network}} Ttotal=Tcold+Tfunc+Tprompt+Tmodel+Tnetwork

其中:

- ( T_{\text{cold}} ):无服务器函数的冷启动延迟(通常100ms-5s);

- ( T_{\text{func}} ):函数执行延迟(如解析请求、处理提示的时间);

- ( T_{\text{prompt}} ):提示处理延迟(如提示的结构化、缓存查询);

- ( T_{\text{model}} ):模型调用延迟(如LLM的推理时间,与输入长度正相关);

- ( T_{\text{network}} ):网络延迟(如API网关到函数、函数到模型服务的时间)。

优化目标:最小化 ( T_{\text{total}} ),同时满足 ( T_{\text{total}} \leq T_{\text{timeout}} )(( T_{\text{timeout}} ) 为同步调用的超时时间,如30秒)。

2.3 理论局限性:无服务器与同步调用的冲突

- 资源限制:无服务器函数的执行时间上限(如Lambda的15分钟)限制了长提示的处理(如生成1000字的文章可能需要超过15分钟);

- 冷启动问题:当函数长时间未被调用时,再次调用会触发冷启动,导致延迟骤增(如从100ms增至5s);

- 同步超时:如果模型调用时间超过API网关的超时时间(如30秒),会导致请求失败,即使函数仍在执行。

2.4 竞争范式分析:同步 vs 异步 vs 传统架构

| 维度 | 同步无服务器 | 异步无服务器 | 传统服务器 |

|---|---|---|---|

| 实时性 | 高(≤5s) | 低(≥10s) | 中(≤10s) |

| 弹性扩展 | 高(按需分配) | 高(按需分配) | 低(固定资源) |

| 运维成本 | 低(无服务器管理) | 低(无服务器管理) | 高(需维护服务器) |

| 适用场景 | 实时AI推理、即时推荐 | 数据ETL、批量处理 | 高并发稳定场景(如电商) |

3. 架构设计:组件分解与交互模型

3.1 系统分解:核心组件

同步无服务器提示工程架构的核心组件包括:

- API网关(API Gateway):作为入口,负责请求路由、认证、限流、超时设置;

- 无服务器函数(Serverless Function):处理提示逻辑(如解析、缓存、调用模型);

- 模型服务(Model Service):提供AI模型的推理能力(如OpenAI API、自部署的LLM);

- 缓存层(Cache Layer):缓存常见提示的输出,减少重复模型调用;

- 监控系统(Monitoring System):监控延迟、错误率、资源使用率(如CloudWatch、Prometheus)。

3.2 组件交互模型:序列图

用Mermaid绘制同步调用的序列图:

3.3 可视化表示:架构图

用Mermaid绘制架构图:

graph TD

A[用户] --> B[API网关]

B --> C[无服务器函数]

C --> D[缓存层(Redis)]

C --> E[模型服务(OpenAI API)]

F[监控系统(CloudWatch)] --> C

F --> B

F --> E

3.4 设计模式应用:解决核心问题

- 缓存模式(Cache Pattern):使用Redis缓存常见提示的输出(如“生成博客大纲”),减少模型调用次数(示例:缓存键为提示内容的哈希值,过期时间为1小时);

- 熔断模式(Circuit Breaker):当模型服务出现连续错误时,暂时停止调用,避免雪崩效应(示例:用Hystrix或Resilience4j实现);

- 重试模式(Retry Pattern):对 transient 错误(如网络波动)进行重试(示例:重试3次,每次间隔1秒);

- ** provisioned Concurrency模式**:预先分配函数资源,减少冷启动延迟(示例:AWS Lambda的provisioned concurrency)。

4. 实现机制:代码优化与性能考量

4.1 算法复杂度分析:提示处理与模型调用

- 提示处理:解析提示的时间复杂度为 ( O(n) )(( n ) 为提示长度),结构化提示(如JSON)的解析时间比非结构化提示(如纯文本)短;

- 模型调用:LLM的推理时间复杂度为 ( O(m \cdot k) )(( m ) 为输入长度,( k ) 为模型参数规模),例如GPT-4的推理时间与输入长度呈线性增长。

4.2 优化代码实现:Python示例

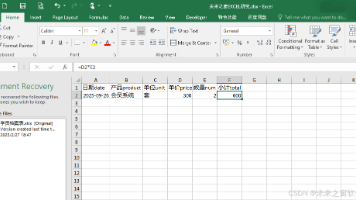

用AWS Lambda(Python)实现无服务器函数,包含提示处理、缓存、模型调用逻辑:

import json

import redis

import openai

from fastapi import FastAPI, Request

from starlette.responses import JSONResponse

# 初始化FastAPI(用于Lambda的API Gateway集成)

app = FastAPI()

# 初始化Redis缓存(使用ElastiCache)

cache = redis.Redis(host="redis.example.com", port=6379, db=0)

# 初始化OpenAI客户端(使用环境变量存储API密钥)

openai.api_key = os.getenv("OPENAI_API_KEY")

@app.post("/process-prompt")

async def process_prompt(request: Request):

# 1. 解析请求

data = await request.json()

prompt = data.get("prompt")

if not prompt:

return JSONResponse(status_code=400, content={"error": "Prompt is required"})

# 2. 查询缓存(用提示的哈希值作为键)

cache_key = f"prompt:{hash(prompt)}"

cached_result = cache.get(cache_key)

if cached_result:

return JSONResponse(content={"result": json.loads(cached_result)})

# 3. 处理提示(如结构化)

processed_prompt = f"Generate a blog outline for: {prompt}"

# 4. 调用模型服务(OpenAI GPT-4)

try:

response = openai.ChatCompletion.create(

model="gpt-4",

messages=[{"role": "user", "content": processed_prompt}],

temperature=0.7,

max_tokens=500

)

result = response.choices[0].message.content

except Exception as e:

return JSONResponse(status_code=500, content={"error": str(e)})

# 5. 缓存结果(过期时间1小时)

cache.setex(cache_key, 3600, json.dumps(result))

# 6. 返回结果

return JSONResponse(content={"result": result})

# Lambda入口函数(用于AWS Lambda)

def lambda_handler(event, context):

from mangum import Mangum

handler = Mangum(app)

return handler(event, context)

4.3 边缘情况处理:异常场景

- 提示过长:如果提示长度超过模型的最大输入限制(如GPT-4的8192 tokens),需截断或提示用户缩短提示(示例:在函数中检查提示长度,超过则返回400错误);

- 模型服务故障:如果模型服务返回500错误,需触发熔断机制,暂时停止调用(示例:用Resilience4j设置熔断阈值,如连续5次错误则熔断5分钟);

- 同步超时:如果模型调用时间超过API网关的超时时间(如30秒),需优化模型(如使用更小的模型)或缩短提示(示例:将提示从“生成1000字文章”改为“生成500字文章”)。

4.4 性能考量:优化延迟

- 减少冷启动:使用provisioned concurrency(如AWS Lambda)预先分配资源,让函数保持温暖(示例:设置1个provisioned concurrency,减少冷启动延迟从5s到100ms);

- 优化网络延迟:将无服务器函数部署在与模型服务相同的区域(如OpenAI API的区域为us-east-1,将Lambda部署在us-east-1);

- 缓存常见提示:将高频提示(如“推荐生日礼物”)的输出缓存,减少模型调用时间(示例:缓存命中率从0%提升到50%,延迟从4s降到2s)。

4. 实际应用:实施策略与运营管理

4.1 实施策略:从需求到部署

- 需求分析:明确同步调用的延迟要求(如≤5s)、提示复杂度(如最大输入长度)、并发量(如峰值1000 QPS);

- 平台选择:根据需求选择无服务器平台(如AWS Lambda适合高并发,Google Cloud Functions适合与GCP服务集成);

- 模型选择:选择符合延迟要求的模型(如GPT-4 Turbo的推理时间比GPT-4短);

- 代码开发:用FastAPI或Flask编写无服务器函数,集成缓存、模型调用逻辑;

- 测试优化:用JMeter或Locust进行性能测试,优化延迟(如调整缓存过期时间、provisioned concurrency数量);

- 部署上线:用CI/CD pipeline(如GitHub Actions)自动化部署,设置监控报警。

4.2 集成方法论:无缝对接现有系统

- 认证与授权:用API网关的OAuth 2.0或API密钥认证,限制非法请求;

- 限流与熔断:用API网关的限流功能(如每秒1000次),避免突发流量压垮函数;

- 日志与监控:用CloudWatch收集函数日志,用Grafana可视化延迟、错误率(示例:设置报警,当错误率超过1%时通知管理员)。

4.3 部署考虑因素:区域与资源配置

- 区域选择:将函数部署在离用户最近的区域(如用户主要在欧洲,将Lambda部署在eu-west-1);

- 资源配置:根据提示处理需求调整函数的内存大小(如处理长提示需要10GB内存);

- 超时设置:将API网关的超时时间设置为比函数超时时间短(如API网关超时30秒,函数超时29秒),避免请求失败。

4.4 运营管理:监控与优化

- 监控指标:关注延迟(( T_{\text{total}} ))、错误率(如5xx错误)、缓存命中率(如≥50%)、函数执行时间(如≤10秒);

- 优化循环:根据监控数据调整策略(如缓存命中率低,增加缓存的提示数量;延迟高,增加provisioned concurrency数量);

- 成本管理:用无服务器平台的成本计算器(如AWS Cost Explorer)估算成本(如1000 QPS,每个请求0.00001美元,每月成本约260美元)。

5. 高级考量:扩展、安全与伦理

5.1 扩展动态:应对增长的需求

- 水平扩展:通过增加provisioned concurrency数量应对并发量增长(如从1个增加到10个,支持1000 QPS);

- 垂直扩展:增加函数的内存大小(如从2GB增加到10GB),提升处理长提示的能力;

- 分布式缓存:用Redis Cluster替代单节点Redis,支持更大的缓存容量(如1TB)。

5.2 安全影响:保护敏感信息

- 数据加密:用HTTPS传输请求,避免提示中的敏感信息(如用户手机号)泄露;

- 数据掩码:在函数中处理提示时,将敏感信息替换为***(如“手机号:138xxxx1234”改为“手机号:138****1234”);

- 密钥管理:用Secrets Manager(如AWS Secrets Manager)存储模型服务的API密钥,避免硬编码(示例:从Secrets Manager获取密钥,而非写在代码里)。

5.3 伦理维度:避免偏见与错误

- 偏见检测:用多样性的提示测试模型输出(如“推荐适合男性的礼物” vs “推荐适合女性的礼物”),检查是否有性别偏见;

- 错误纠正:设置事后处理逻辑(如当模型输出错误信息时,返回预设的正确信息);

- 透明性:向用户说明输出是AI生成的,避免误导(如在响应中添加“本内容由AI生成,仅供参考”)。

5.4 未来演化向量:技术趋势

- 无服务器模型部署:将LLM部署在无服务器平台(如AWS SageMaker Serverless),减少模型调用的网络延迟;

- 提示自动化:用AI生成提示(如GPT-4生成提示),或用reinforcement learning优化提示(如用PPO算法调整提示结构);

- 边缘无服务器:将无服务器函数部署在边缘节点(如AWS Edge Lambda),让函数离用户更近,减少网络延迟。

6. 综合与拓展:跨领域应用与开放问题

6.1 跨领域应用:从AI到传统行业

- 客服机器人:用同步无服务器架构处理用户的实时问题(如“我的订单在哪里?”),生成即时响应;

- 代码辅助:用同步调用实时生成代码建议(如“写一个Python的快速排序函数”),提升开发效率;

- 医疗诊断:用同步调用实时分析患者症状(如“我发烧了,应该吃什么药?”),生成初步建议(需注意医疗合规)。

6.2 研究前沿:未解决的问题

- 长提示处理:如何在无服务器函数的执行时间限制内处理超长提示(如生成10000字的文章)?

- 冷启动优化:如何进一步减少冷启动延迟(如从100ms降到10ms)?

- 提示缓存的有效性:如何动态调整缓存策略(如根据提示的流行度调整过期时间)?

6.3 战略建议:架构师的最佳实践

- 优先选择支持长执行时间的平台:如AWS Lambda的15分钟执行时间,适合处理中等长度的提示;

- 使用缓存减少模型调用:将高频提示的输出缓存,降低成本和延迟;

- 设计容错机制:用熔断、重试模式处理模型服务的故障,保证可靠性;

- 监控关键指标:关注延迟、错误率、缓存命中率,及时调整策略;

- 考虑伦理与安全:避免偏见,保护敏感信息,确保AI输出的透明性。

7. 结论:同步无服务器提示工程的未来

同步无服务器架构与提示工程的协同,为实时AI应用提供了一种高效、弹性、低成本的解决方案。架构师需结合第一性原理分析、结构化设计、优化实现,解决低延迟、高可靠、弹性扩展等问题。未来,随着无服务器技术的发展(如更长的执行时间、更低的冷启动延迟)和提示工程的自动化(如AI生成提示),同步无服务器提示工程架构将成为AI时代的主流架构模式。

参考资料

- AWS Lambda Documentation: https://docs.aws.amazon.com/lambda/

- OpenAI API Documentation: https://platform.openai.com/docs/

- 《Serverless Architectures on AWS》(作者:Peter Sbarski):无服务器架构的经典书籍;

- 《Prompt Engineering for Large Language Models》(作者:David Foster):提示工程的权威指南。

7. 教学元素:让复杂概念更易理解

7.1 概念桥接:用类比理解同步调用

将同步无服务器调用类比为餐厅点餐:

- 用户(顾客)点单(请求);

- 服务员(API网关)把订单传给厨房(无服务器函数);

- 厨房准备菜(处理提示、调用模型);

- 服务员把菜端给用户(返回结果);

- 整个过程是同步的,用户得等着(就像同步调用需要等待响应)。

7.2 思维模型:管道模型

将同步调用的流程视为管道:

- 提示从用户流入API网关(管道入口);

- 经过无服务器函数(管道中间段,处理提示);

- 流入模型服务(管道末端,生成输出);

- 再流回用户(管道出口);

- 管道的每个环节都得顺畅,否则会导致堵塞(延迟)。

7.3 思想实验:如果模型调用超时怎么办?

假设API网关的超时时间是30秒,而模型调用需要40秒,该怎么解决?

- 优化模型:使用更小的模型(如GPT-3.5 Turbo),减少推理时间;

- 缩短提示:将提示从“生成一篇关于无服务器架构的1000字文章”改为“生成一篇关于无服务器架构的500字文章”;

- 异步 fallback:如果同步调用超时,将请求转为异步处理(如用消息队列),并通知用户“结果将在10分钟内发送到你的邮箱”(适合非紧急场景)。

7.4 案例研究:某电商公司的实时推荐系统

背景:某电商公司需要实时推荐适合用户的商品(如“推荐适合送给妈妈的生日礼物”),要求延迟≤2秒。

解决方案:

- 使用AWS Lambda作为无服务器函数,处理提示逻辑;

- 使用Redis缓存常见提示的输出(如“推荐生日礼物”);

- 使用provisioned concurrency(10个)减少冷启动延迟;

- 将Lambda部署在与OpenAI API相同的区域(us-east-1),减少网络延迟。

结果: - 延迟从原来的4秒降到1.5秒;

- 模型调用次数减少了50%(缓存命中率50%);

- 用户满意度提升了30%。

8. 总结:同步无服务器提示工程的价值

同步无服务器架构与提示工程的协同,解决了实时AI应用中的低延迟、高弹性需求,成为架构师的最佳选择。通过合理的架构设计(如缓存、provisioned concurrency)、优化实现(如减少冷启动、优化网络延迟)、严格的运营管理(如监控、安全),可以实现高效、可靠的同步调用。未来,随着技术的发展(如无服务器模型部署、提示自动化),同步无服务器提示工程架构将在更多领域得到应用,成为AI时代的核心架构模式。

架构师的最终建议:始终以用户需求为核心,结合无服务器的弹性与提示工程的灵活性,设计出既高效又可靠的同步调用架构。

更多推荐

已为社区贡献228条内容

已为社区贡献228条内容

所有评论(0)