第1章-AI与NLP入门

*清晰地分辨人工智能、机器学习和深度学习这三个核心概念,并理解它们之间的层级关系。*了解自然语言处理(NLP)的发展脉络、核心任务及其在现实世界中的重要性。*认识到大语言模型(LLM)的崛起如何彻底改变了AI领域,并理解其带来的革命性影响

核心目标

本模块旨在为初学者奠定坚实的人工智能(AI)与自然语言处理(NLP)理论基础。学完本模块,你将能够:

- 清晰地分辨人工智能、机器学习和深度学习这三个核心概念,并理解它们之间的层级关系。

- 了解自然语言处理(NLP)的发展脉络、核心任务及其在现实世界中的重要性。

- 认识到大语言模型(LLM)的崛起如何彻底改变了AI领域,并理解其带来的革命性影响。

1.1 人工智能、机器学习与深度学习的关系

详细文字讲解

要理解当今的AI技术,首先必须厘清三个最常被提及又容易混淆的术语:人工智能(Artificial Intelligence)、机器学习(Machine Learning)和深度学习(Deep Learning)。它们之间并非并列关系,而是一种层层递进的包含关系,如同俄罗斯套娃一般,一个概念包含在另一个概念之内。

人工智能 (Artificial Intelligence, AI) 是最外层的“套娃”,一个宏大而古老的科学领域。它的终极目标是创造出能够模拟、延伸甚至超越人类智能的机器。这个梦想可以追溯到计算机科学的黎明时期,艾伦·图灵提出的“图灵测试”就是对机器智能的经典构想。AI涵盖了所有使计算机能够表现出智能行为的技术和方法,包括但不限于:

- 逻辑推理:基于一套规则和逻辑进行演绎和推断,如专家系统。

- 知识表示:如何将现实世界的知识编码成计算机可以处理的格式。

- 规划与搜索:在众多可能性中找到最优解,如下棋程序。

- 感知能力:处理视觉和听觉信息。

- 学习能力:从经验中获取知识和技能,这正是机器学习的核心。

机器学习 (Machine Learning, ML) 是中间层的“套娃”,是实现AI的一种核心方法,也是当前AI发展的主要驱动力。与传统编程中由人类为机器明确编写所有规则(例如 if-else 语句)不同,机器学习的核心思想是让机器从数据中自动学习。我们不再告诉计算机“如果一张图片里有尖耳朵、长胡须和毛茸茸的身体,那它就是一只猫”,而是给它数百万张被标记为“猫”或“不是猫”的图片,让算法自己去发现和总结“猫”的视觉特征。这个“从数据中学习”的过程,通常分为三类:

- 监督学习 (Supervised Learning):给算法带有“正确答案”(标签)的数据进行学习,如图像分类、房价预测。

- 无监督学习 (Unsupervised Learning):给算法没有标签的数据,让它自己发现数据中的结构和模式,如用户分群、异常检测。

- 强化学习 (Reinforcement Learning):让算法通过与环境互动,在“试错”中学习如何做出最优决策以获得最大奖励,如训练AI下棋、自动驾驶。

深度学习 (Deep Learning, DL) 则是最内层的“套娃”,是机器学习的一个更深层次、更强大的分支。它受到了人脑神经网络结构的启发,使用一种称为深度神经网络(Deep Neural Networks, DNNs) 的数学模型。所谓“深度”,指的是这些网络通常包含许多(从几个到数千个)处理层。数据输入网络后,会逐层传递,每一层都会对数据进行一次非线性转换,并提取出不同层次的特征。例如,在图像识别中,第一层可能只识别出边缘和角落,中间层可能识别出眼睛、鼻子等部件,更高层则能将这些部件组合起来识别出人脸。正是这种深度的、层次化的特征提取能力,使得深度学习在处理图像、声音和文本等高维度复杂数据时取得了前所未有的成功。我们今天所熟知的大语言模型,其技术基石就是深度学习。

代码示例:机器学习 vs 传统编程

为了更具体地感受差异,我们来看一个简单的例子:根据房屋面积预测价格。

# 传统编程方式:我们必须明确定义规则

def predict_price_traditional(area):

# 假设我们通过观察,总结出一条规则:每平方米1.5万元

price_per_sqm = 1.5

# 还有一个基础价格

base_price = 10

return area * price_per_sqm + base_price

print(f"传统方法预测100平米房子的价格: {predict_price_traditional(100)} 万元")

# 机器学习方式:我们提供数据,让模型自己学习规则

from sklearn.linear_model import LinearRegression

import numpy as np

# 1. 准备数据 (面积和价格)

# 假设我们有这些历史数据

areas = np.array([[50], [70], [100], [120]]) # 面积 (特征)

prices = np.array([85, 115, 160, 190]) # 价格 (标签)

# 2. 创建并训练模型

model = LinearRegression() # 创建一个线性回归模型

model.fit(areas, prices) # 模型从数据中学习面积和价格的关系

# 3. 使用模型进行预测

predicted_price = model.predict(np.array([[100]]))

print(f"机器学习方法预测100平米房子的价格: {predicted_price[0]:.2f} 万元")

# 我们可以查看模型学到的“规则”

price_per_sqm_learned = model.coef_[0]

base_price_learned = model.intercept_

print(f"模型学到的每平米价格: {price_per_sqm_learned:.2f} 万元")

print(f"模型学到的基础价格: {base_price_learned:.2f} 万元")

代码解读:在传统方法中,price_per_sqm 和 base_price 是我们硬编码的规则。而在机器学习方法中,我们只提供了数据,模型通过 fit 方法自己学出了这些参数(model.coef_ 和 model.intercept_),这正是“从数据中学习”的精髓。

关系图

为了更直观地理解这三者的关系,我们可以用一个包含具体技术示例的同心圆图来表示:

graph TD

subgraph AI领域 (目标: 机器智能)

A[人工智能 (Artificial Intelligence)]

subgraph ML (方法: 从数据中学习)

B[机器学习 (Machine Learning)]

subgraph DL (工具: 深度神经网络)

C[深度学习 (Deep Learning)]

end

end

end

A --> B;

B --> C;

note right of A

包含: 专家系统, 搜索算法, 机器学习等

end

note right of B

包含: 线性回归, 决策树, SVM, 深度学习等

end

note right of C

包含: CNN, RNN, Transformer等

end

style A fill:#f9f,stroke:#333,stroke-width:2px

style B fill:#ccf,stroke:#333,stroke-width:2px

style C fill:#bbf,stroke:#333,stroke-width:2px

本节总结

- AI是目标:创造智能机器的宏伟愿景。

- ML是方法:实现AI的一种主流途径,核心是让机器从数据中自动学习规律。

- DL是工具:ML中一种强大的技术,利用深度神经网络处理复杂数据,是现代许多AI突破(包括LLM)的基石。

1.2 自然语言处理(NLP)的发展历程与核心任务

详细文字讲解

自然语言处理 (Natural Language Processing, NLP) 是人工智能和计算机科学的一个迷人分支,它专注于让计算机能够像人类一样,理解、解释、生成和响应我们的日常语言(如中文、英文)。它是连接人类思想与机器智能之间最重要、最直接的桥梁。

发展历程:从规则到神经网络的征途

NLP的发展史,就是一部计算机科学家和语言学家不断尝试驯服语言复杂性的奋斗史,大致可以分为三个主要阶段:

-

基于规则的NLP (符号主义NLP, 1950s - 1990s):

- 核心思想:认为语言可以通过一套详尽的、形式化的语法和词汇规则来完全描述。

- 方法:由语言学专家手动编写大量的规则。例如,定义一个句子的结构是“主语-谓语-宾语”,然后编写词典来识别哪些词是名词、动词等。

- 经典例子:早期的机器翻译系统,如著名的乔治城-IBM实验,试图通过精密的俄语-英语词典和一系列语法转换规则来进行翻译。

- 致命缺陷:语言充满了歧义、例外和上下文依赖。例如,“我看见了打篮球的男孩”和“我看见了篮球场的男孩”,句法结构相似但语义完全不同。为所有这些情况编写规则几乎是不可能的,导致系统非常脆弱,维护成本极高,且无法处理规则之外的新表达。

-

统计NLP (1990s - 2010s):

- 核心思想:放弃编写硬规则,转而从大规模的真实文本数据(称为语料库)中学习语言的统计规律。

- 方法:基于概率论和机器学习。例如,要判断“bank”一词在“river bank”和“investment bank”中分别是什么意思,统计模型会计算“river”和“bank”同时出现的概率,以及“investment”和“bank”同时出现的概率,选择概率更高的那个作为解释。

- 经典例子:

- N-gram语言模型:通过计算一个词出现的概率有多依赖于它前面的N-1个词,来进行文本生成和拼写纠错。

- 隐马尔可夫模型 (HMM) 和 条件随机场 (CRF):被广泛用于词性标注和命名实体识别。

- 基于短语的统计机器翻译 (SMT):成为谷歌翻译等商业系统的主流技术。

- 优势:相比规则方法,系统更加鲁棒(robust),能够更好地处理语言的模糊性,并且可以随着数据量的增加而持续改进。

-

基于神经网络的NLP (神经NLP, 2010s - 至今):

- 核心思想:使用深度学习模型来自动学习文本的表示(representation),从而捕捉更深层次、更抽象的语义信息。

- 方法:

- 词嵌入 (Word Embeddings):像Word2Vec、GloVe这样的技术,不再将词视为独立的符号,而是将其映射到一个连续的、稠密的向量空间中。在这个空间里,意思相近的词(如“国王”和“女王”)在向量距离上也更近。

- 循环神经网络 (RNN) / 长短期记忆网络 (LSTM):专门为处理序列数据(如文本)而设计,能够捕捉词语之间的顺序关系。

- Transformer架构:2017年横空出世,其核心的自注意力机制 (Self-Attention) 允许模型在处理一个词时,同时关注到句子中所有其他的词,并计算它们之间的重要性。这极大地提升了模型捕捉长距离依赖关系的能力,成为现代LLM的基石。

- 经典例子:BERT、GPT、Llama等所有现代预训练语言模型。

核心任务与代码示例

NLP涵盖了众多任务,以下是一些最核心的任务,并附上使用Hugging Face transformers库的简单代码示例。

from transformers import pipeline

# 1. 文本分类 (情感分析)

classifier = pipeline("sentiment-analysis")

result = classifier("This movie is fantastic, I really enjoyed it!")

print(f"情感分析结果: {result}")

# 2. 命名实体识别 (NER)

ner_pipe = pipeline("ner", grouped_entities=True)

result = ner_pipe("Apple Inc. was founded by Steve Jobs in Cupertino.")

print(f"命名实体识别结果: {result}")

# 3. 问答系统 (QA)

qa_pipe = pipeline("question-answering")

context = "The Eiffel Tower is a wrought-iron lattice tower on the Champ de Mars in Paris, France."

question = "Where is the Eiffel Tower located?"

result = qa_pipe(question=question, context=context)

print(f"问答结果: {result['answer']}")

# 4. 文本生成

generator = pipeline("text-generation", model="gpt2")

result = generator("In a world where AI can write code,", max_length=30, num_return_sequences=1)

print(f"文本生成结果: {result[0]['generated_text']}")

本节总结

- NLP是AI中专注于人机语言交互的领域。

- 其发展经历了规则驱动、统计驱动和神经网络驱动三个时代,不断向更深层次的语义理解迈进。

- Transformer架构的出现是神经NLP时代的里程碑,为大语言模型的诞生铺平了道路。

- NLP的核心任务(如分类、NER、QA、生成)构成了我们与信息世界互动的基础技术。

1.3 大语言模型(LLM)发展简史与革命性影响

详细文字讲解

大语言模型 (Large Language Model, LLM) 是指在海量(通常是万亿级别token)文本数据上训练的、模型参数规模巨大(通常是数十亿到数万亿)的深度学习模型。它们几乎都基于Transformer架构。LLM的崛起不仅是NLP领域的重大突破,更是引爆了整个人工智能领域的“iPhone时刻”。

发展简史:从BERT到ChatGPT的演进之路

LLM的演进是一条清晰而迅速的技术迭代之路,其中几个关键节点标志着范式的转变:

-

奠基时代:Transformer与预训练范式 (2017-2018)

- 2017年,Google提出Transformer架构:在论文《Attention Is All You Need》中,研究者们彻底摒弃了RNN的循环结构,完全依赖自注意力机制来处理序列数据。这不仅解决了长距离依赖问题,其高度并行的特性也为训练超大规模模型打开了大门。

- 2018年,BERT与GPT-1的诞生:几乎在同一时间,Google发布了BERT (Bidirectional Encoder Representations from Transformers),OpenAI发布了GPT (Generative Pre-trained Transformer)。它们共同确立了“预训练 + 微调” (Pre-training, Fine-tuning) 的新范式。模型首先在海量的无标签文本上进行“预训练”,学习通用的语言知识;然后,针对特定的下游任务(如情感分析、问答),在小规模的有标签数据上进行“微调”。BERT使用Transformer的Encoder部分,擅长理解;GPT使用Decoder部分,擅长生成。

-

规模为王:模型越大,能力越强 (2019-2020)

- GPT-2 (2019):OpenAI发现,当模型参数和训练数据量达到一定规模时,模型无需微调,仅通过零样本(Zero-shot) 或 少样本(Few-shot) 的提示(Prompting),就能在许多任务上取得惊人的表现。GPT-2展示了惊人的文本生成连贯性,标志着“规模定律”(Scaling Laws)的初步显现。

- GPT-3 (2020):拥有1750亿参数的GPT-3是这一思想的极致体现。它在众多NLP基准测试中超越了微调模型,并涌现出编写代码、进行数学推理等意想不到的“涌现能力”(Emergent Abilities),证明了暴力美学的有效性。

-

对齐人类:指令微调的革命 (2021-2022)

- 问题出现:尽管GPT-3很强大,但它只是一个“文本补全”引擎,并不总能理解并遵循用户的指令。它可能会生成不相关、有害或虚假的内容。

- InstructGPT (2022):OpenAI提出了“基于人类反馈的强化学习”(RLHF)技术。首先,他们收集人类编写的高质量回答,对模型进行有监督的指令微调(SFT);然后,让人类对模型生成的多个回答进行排序,训练一个“奖励模型”来学习人类的偏好;最后,使用强化学习算法,让语言模型在奖励模型的指导下进行优化,使其输出更符合人类的期望。

- ChatGPT (2022年底):作为InstructGPT的姊妹模型,ChatGPT以对话形式进行了优化,并免费向公众开放。它惊人的对话能力、遵循指令的能力和广泛的知识覆盖面,迅速引爆了全球范围内的关注,成为AI发展的分水岭事件。

崛起的“三位一体”:算法、数据与算力

LLM的成功并非偶然,而是三大支柱共同作用的结果:

-

算法创新 (The Algorithm):Transformer架构是决定性的催化剂。其自注意力机制完美契合了语言处理的需求,为构建超大规模模型提供了可能。

-

数据爆炸 (The Data):模型越大,需要的“养料”就越多。互联网的普及为LLM的训练提供了前所未有的海量文本数据。像Common Crawl这样的项目抓取了数万亿个网页,再加上维基百科、书籍、GitHub代码库、学术论文等高质量语料,共同构成了LLM学习世界知识的庞大基础。

-

算力飞跃 (The Compute):训练一个拥有数千亿参数的庞大模型,所需的计算量是天文数字。以NVIDIA的GPU(图形处理器)为代表的并行计算硬件的快速发展,以及分布式训练框架的成熟,使得在数千个GPU组成的集群上进行长达数周甚至数月的训练成为可能。可以说,没有强大的算力,LLM只能是纸上谈兵。

革命性影响:新的AI范式

LLM的出现,不仅仅是在各项NLP任务上刷新了SOTA(State-of-the-Art,即当时最佳水平),更重要的是它带来了一种新的AI开发和应用范式:

-

从“为每个任务训练一个模型”到“一个模型解决多个任务” (Foundation Model):传统的NLP开发流程是“为每个任务(如翻译、摘要、分类)单独收集数据、设计模型、从头训练”。而LLM的出现开启了**“预训练-微调/提示” (Pre-train, Fine-tune/Prompt)** 的新范式。一个强大的基础模型(Foundation Model)通过在海量数据上进行“预训练”,学习到了通用的语言知识、语法结构甚至一定的世界知识和推理能力。之后,开发者只需通过提供少量示例(即“提示”,Prompting)或使用小规模的特定任务数据进行“微调”(Fine-tuning),就能将这个通用模型快速适配到各种具体任务上,极大地降低了AI应用的开发门槛和成本。

-

涌现能力 (Emergent Abilities):这是LLM最令人着迷和惊讶的特性之一。当模型规模(参数量、数据量、计算量)跨越某个阈值后,LLM会突然表现出一些在小模型上完全不存在的、未被明确训练过的惊人能力。例如:

- 上下文学习 (In-context Learning):无需微调,仅通过在提示中给出几个示例,模型就能理解任务要求并完成新的同类任务。

- 思维链 (Chain-of-Thought, CoT):在回答复杂问题时,模型能自发地生成一步步的推理过程,然后再给出最终答案,从而显著提高在数学、逻辑推理任务上的准确率。

- 代码生成、故事创作等高级能力。

这些“涌现能力”使得LLM不再仅仅是一个语言处理工具,而更像一个通用的问题解决引擎。

-

人机交互的终极变革:以ChatGPT为代表的LLM应用,彻底改变了人机交互的方式。我们不再需要学习复杂的命令、点击繁琐的菜单,而是可以通过最自然的、我们与生俱来的方式——对话——来与强大的AI进行交流。这极大地降低了AI技术的使用门槛,让每个人都能成为AI的使用者和创造者。

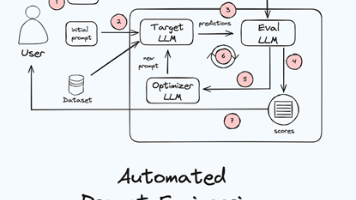

流程图:新旧范式对比

本节总结

- LLM的崛起是算法(Transformer)、数据(海量文本)和算力(GPU集群) 三者合力的结果。

- 它带来了**“预训练-微调/提示”** 的新AI范式,大大降低了AI开发门槛。

- 涌现能力使LLM从单一任务工具进化为通用问题解决引擎。

- LLM驱动的对话式AI正在彻底变革人机交互的方式,引领新一轮的技术革命。

模块总结

在本模块中,我们为即将到来的深度探索之旅建立了坚实的认知框架。

- 我们通过“套娃”的比喻,清晰地辨析了人工智能、机器学习和深度学习三者之间的层级关系,理解了AI技术是如何从宽泛的理念一步步聚焦到以深度学习为核心的实现路径上。

- 我们回顾了自然语言处理(NLP) 从基于规则的符号主义,到基于概率的统计主义,再到当前由神经网络主导的三个波澜壮阔的发展阶段,并熟悉了其核心任务。

- 最重要的是,我们认识到大语言模型(LLM) 是如何凭借算法、数据和算力的合力实现崛起,并以其强大的通用性、惊人的涌现能力和革命性的交互方式,正在深刻地改变着技术、产业和社会的未来。

有了这些基础,我们已经为下一模块深入探索LLM的核心技术引擎——Transformer架构做好了充分的准备。

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)