论文阅读:International Journal of Artificial Intelligence in Education 2024 Cheating Automatic Short Ans

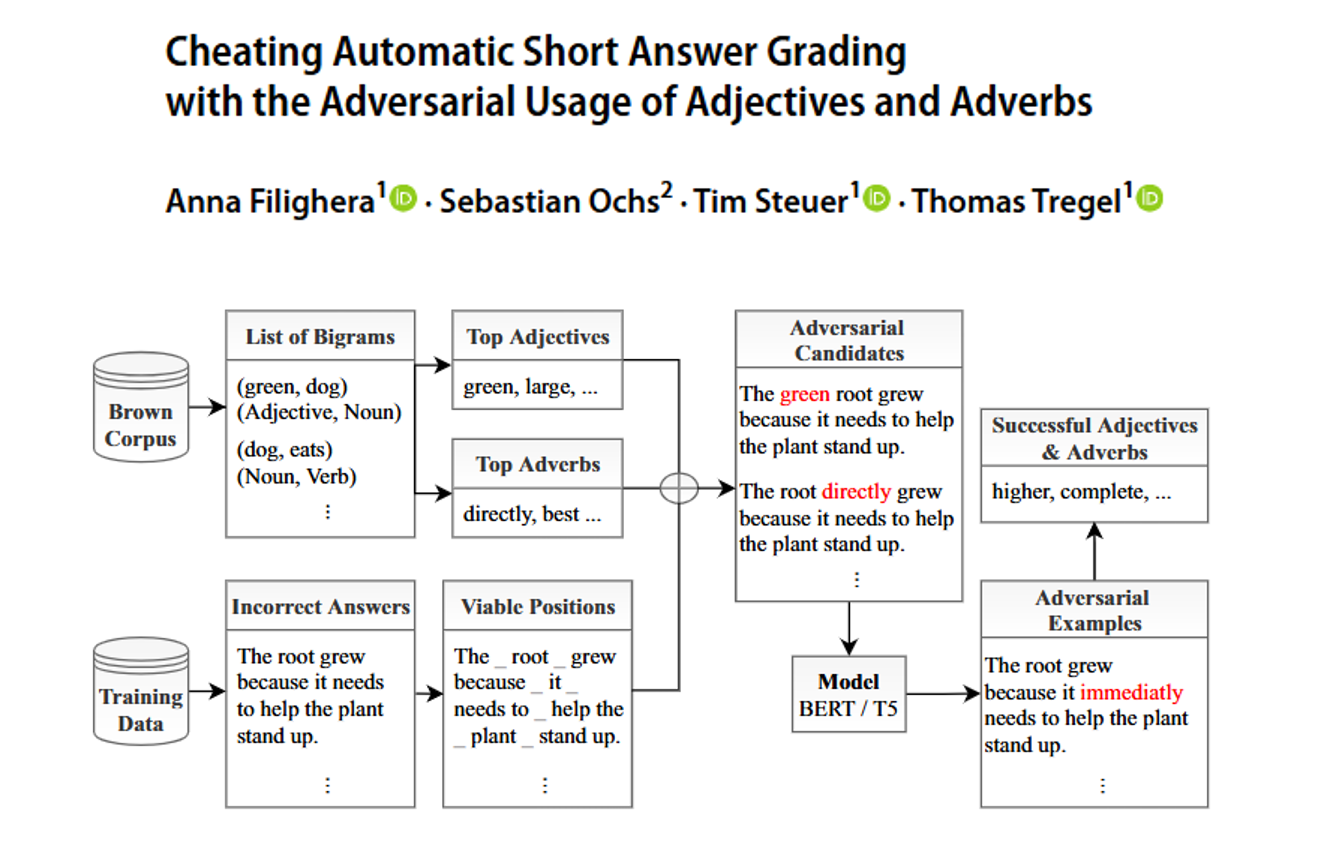

具体方法很简单——在错误答案里“加词”:从英语语料库(叫Brown Corpus)里挑了100个常用的形容词(比如“green”“large”)和副词(比如“immediately”“directly”),往错误答案的语法合理位置插(比如“根要帮植物站稳”改成“根。而且对比了当时最先进的“骗AI”方法(叫TextFooler),这个“加形容词/副词”的方法在批改简答题时效果还更好,甚至对更先进的T

总目录 大模型相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

https://dl.acm.org/doi/10.1007/978-3-031-79032-4_12

https://www.doubao.com/chat/20601726565678850

Cheating Automatic Short Answer Grading with the Adversarial Usage of Adjectives and Adverbs

速览

这篇文档主要研究了一个和“AI自动批改作业”相关的问题——学生能不能通过简单技巧“骗”过AI批改系统,让错误答案被判定为正确,以及怎么避免这种情况。下面用大白话分几个核心部分讲清楚:

首先,得先知道背景:现在很多老师用AI自动批改简答题(比如“种子发芽时根为什么先长”这类题),因为学生多、改作业费时间,AI能省力气还能快速给反馈。而且现在的AI模型(比如文中常提的BERT、T5)已经挺厉害,有些场景下改得快赶上人类老师了。但问题是,这些AI可能“走捷径”——不是真的理解答案对不对,而是靠一些表面特征判断(比如正确答案里形容词、副词多,AI就误以为“有这些词就是对的”)。

然后,研究团队做了个“作弊实验”:他们想看看能不能利用AI的这个弱点,让错误答案被AI判对。具体方法很简单——在错误答案里“加词”:从英语语料库(叫Brown Corpus)里挑了100个常用的形容词(比如“green”“large”)和副词(比如“immediately”“directly”),往错误答案的语法合理位置插(比如“根要帮植物站稳”改成“根立刻要帮植物站稳”)。

实验结果挺让人惊讶的:用这个方法,AI的批改准确率直接掉了10到22个百分点——比如原本AI能对80%,加词后可能只剩60%多。而且对比了当时最先进的“骗AI”方法(叫TextFooler),这个“加形容词/副词”的方法在批改简答题时效果还更好,甚至对更先进的T5模型,效果比老一点的BERT还明显。

接下来,他们还找了7个有经验的大学老师做“人工判断”:让老师看改前的错误答案和加词后的答案,打分(自然度、正确性、会不会怀疑作弊)。结果有两个关键发现:

- 加词后的答案确实没那么“自然”了(老师能感觉到有点别扭),但没让老师觉得更像作弊——甚至有些老师还会把“不自然”当成“学生英语不好”,反而不怀疑;

- 加词后答案的“实际正确性”没变化(老师还是觉得是错的),说明这个方法只是骗了AI,没让错误答案真的变对。

最后,他们给用AI批改的老师提了几个建议,避免学生用这种方法作弊:

- 先搞懂自己用的AI是靠什么判题的——比如看看训练数据里是不是“正确答案形容词多”,提前排除这种表面特征的干扰;

- 对AI“没把握”的答案多留心——AI判题时会有“信心分”,如果信心低(比如觉得这个答案60%是错的,不是90%),就手动再查一遍;

- 培训老师怎么识别“骗AI”的答案——别让老师误以为“英语差、答案别扭”就是作弊,也别漏了真的作弊答案;

- 平衡“AI透明”和“不暴露弱点”——别让学生知道AI靠什么判题(不然学生更容易找漏洞),但也得让学生明白自己为啥得这个分。

总的来说,这篇文章就是想提醒大家:AI批改虽然方便,但有明显弱点,学生可能用简单的“加词”方法作弊;不过只要提前注意这些问题,比如人工复查可疑答案、优化AI的判断逻辑,还是能让AI批改更靠谱的。

更多推荐

已为社区贡献77条内容

已为社区贡献77条内容

所有评论(0)