AI架构师实战:智能文本生成应用的多模态融合架构设计

随着生成式AI的普及,纯文本生成已无法满足复杂场景需求(如电商商品描述、教育教案生成、医疗诊断报告),多模态融合(文本+图像+语音)成为智能文本生成的核心升级方向。本文从第一性原理出发,拆解多模态融合的本质逻辑,构建分层架构设计框架,覆盖从模态编码、跨模态对齐到生成解码的全流程,并结合实战案例(如电商多模态商品描述系统)讲解实现细节。同时,本文探讨了多模态系统的性能优化、安全伦理及未来演化方向,为

AI架构师实战:智能文本生成应用的多模态融合架构设计

元数据框架

标题

AI架构师实战:智能文本生成应用的多模态融合架构设计——从理论到落地的系统化实践

关键词

智能文本生成, 多模态融合, AI架构设计, 跨模态对齐, 系统集成, 性能优化, 生成式AI

摘要

随着生成式AI的普及,纯文本生成已无法满足复杂场景需求(如电商商品描述、教育教案生成、医疗诊断报告),多模态融合(文本+图像+语音)成为智能文本生成的核心升级方向。本文从第一性原理出发,拆解多模态融合的本质逻辑,构建分层架构设计框架,覆盖从模态编码、跨模态对齐到生成解码的全流程,并结合实战案例(如电商多模态商品描述系统)讲解实现细节。同时,本文探讨了多模态系统的性能优化、安全伦理及未来演化方向,为AI架构师提供从理论到落地的完整实践指南。

1. 概念基础:为什么需要多模态融合的智能文本生成?

1.1 领域背景化:从“纯文本”到“多模态”的需求升级

智能文本生成的核心目标是将输入信息转化为符合人类需求的自然语言。早期系统(如基于规则的模板生成、RNNseq2seq模型)仅依赖文本输入,无法处理复杂场景:

- 电商场景:用户上传商品图像后,需要生成包含“颜色、材质、款式”的详细描述,纯文本输入(如“红色连衣裙”)无法覆盖图像中的细节(如“V领设计”“蕾丝花边”);

- 教育场景:教师输入教案大纲(文本)和知识点示意图(图像),需要生成包含“图文对应解释”的教案,纯文本生成无法关联图像中的视觉信息;

- 医疗场景:医生输入病历(文本)和X光片(图像),需要生成包含“图像异常描述”的诊断报告,纯文本生成无法解读图像中的医学特征。

多模态融合的价值在于整合不同模态的互补信息(文本的语义精确性+图像的视觉细节+语音的情感特征),生成更丰富、更准确的文本输出。

1.2 历史轨迹:多模态融合的演化历程

多模态融合的发展可分为三个阶段:

- 早期探索(2010年前):基于规则的多模态检索(如用文本关键词搜索图像),核心是“模态间映射”,未涉及生成;

- 深度学习初期(2010-2018):多模态分类/回归(如用图像+文本判断商品类别),采用“特征拼接+全连接层”的简单融合方式;

- 生成式AI时代(2018至今):多模态生成(如DALL·E、Flamingo),采用跨模态对齐+生成解码器的架构,实现“图像→文本”“文本→图像”的双向生成。

1.3 问题空间定义:多模态融合的核心挑战

多模态融合的本质是解决“异构信息协同”问题,核心挑战包括:

- 模态异构性:文本(序列结构)、图像(空间结构)、语音(时间结构)的表示方式差异大,无法直接拼接;

- 跨模态语义鸿沟:不同模态的语义关联需要学习(如“图像中的红色”与“文本中的热情”),无先验规则;

- 生成一致性:融合后的文本需与所有输入模态保持语义一致(如输入“猫”的图像和“狗”的文本,生成的文本需指出冲突);

- 性能瓶颈:多模态模型的计算复杂度远高于单模态,难以满足实时应用需求。

1.4 术语精确性

- 多模态(Multimodal):指两种或多种信息模态(文本、图像、语音、视频等);

- 跨模态对齐(Cross-Modal Alignment):将不同模态的表示映射到同一语义空间,使语义相关的模态表示距离更近;

- 模态间注意力(Inter-Modal Attention):通过注意力机制动态学习模态间的语义关联(如文本关注图像中的关键区域);

- 联合表示(Joint Representation):融合多模态信息后的统一表示,作为生成解码器的输入。

2. 理论框架:多模态融合的第一性原理推导

2.1 第一性原理:信息论视角的多模态价值

根据信息论,联合信息熵(H(X,Y)H(X,Y)H(X,Y))表示两个随机变量XXX(文本)和YYY(图像)的联合不确定性,公式为:

H(X,Y)=H(X)+H(Y∣X)H(X,Y) = H(X) + H(Y|X)H(X,Y)=H(X)+H(Y∣X)

其中,H(Y∣X)H(Y|X)H(Y∣X)是条件熵,表示已知XXX时YYY的不确定性。多模态融合的本质是最大化联合信息熵——通过整合XXX和YYY的信息,减少生成文本的不确定性(即提高准确性)。

例如,输入“红色连衣裙”(文本XXX)和一张红色连衣裙的图像(YYY),联合信息熵H(X,Y)H(X,Y)H(X,Y)远大于单模态信息熵H(X)H(X)H(X)或H(Y)H(Y)H(Y),因为图像提供了文本未包含的“V领设计”“蕾丝花边”等信息,使生成的文本更丰富。

2.2 数学形式化:多模态表示与融合

多模态融合的核心流程可抽象为**“编码→对齐→融合→生成”**,数学形式化如下:

-

模态编码:将输入模态转化为向量表示:

- 文本TTT:用Transformer编码器(如BERT)编码为t=Transformer(T)∈Rn×dt = \text{Transformer}(T) \in \mathbb{R}^{n \times d}t=Transformer(T)∈Rn×d(nnn为文本长度,ddd为隐藏维度);

- 图像III:用Vision Transformer(如ViT)编码为v=ViT(I)∈Rm×dv = \text{ViT}(I) \in \mathbb{R}^{m \times d}v=ViT(I)∈Rm×d(mmm为图像patch数量);

- 语音SSS:用Wav2Vec编码为s=Wav2Vec(S)∈Rk×ds = \text{Wav2Vec}(S) \in \mathbb{R}^{k \times d}s=Wav2Vec(S)∈Rk×d(kkk为语音帧数量)。

-

跨模态对齐:通过注意力机制学习模态间的语义关联,例如文本关注图像中的关键区域:

tatt=Attention(t,v,v)∈Rn×dt_{\text{att}} = \text{Attention}(t, v, v) \in \mathbb{R}^{n \times d}tatt=Attention(t,v,v)∈Rn×d

其中,Attention\text{Attention}Attention是 scaled dot-product attention,公式为:

Attention(Q,K,V)=softmax(QKTd)V\text{Attention}(Q,K,V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d}}\right)VAttention(Q,K,V)=softmax(dQKT)V

QQQ(查询)来自文本表示ttt,KKK(键)和VVV(值)来自图像表示vvv。 -

联合表示:将对齐后的模态表示融合为统一向量:

h=Concat(t,tatt)∈Rn×2dh = \text{Concat}(t, t_{\text{att}}) \in \mathbb{R}^{n \times 2d}h=Concat(t,tatt)∈Rn×2d

或采用残差连接(更常用):

h=t+tatt∈Rn×dh = t + t_{\text{att}} \in \mathbb{R}^{n \times d}h=t+tatt∈Rn×d -

生成解码:用Transformer解码器(如GPT)将联合表示转化为文本:

T^=Decoder(h)∈Rn×V\hat{T} = \text{Decoder}(h) \in \mathbb{R}^{n \times V}T^=Decoder(h)∈Rn×V

其中,VVV是词汇表大小,T^\hat{T}T^是生成的文本序列。

2.3 理论局限性:当前框架的边界

- 模态噪声敏感性:图像中的背景干扰(如杂物)或文本中的错别字会导致对齐错误,进而影响生成结果;

- 语义鸿沟未完全解决:隐喻性关联(如“图像中的乌云”与“文本中的悲伤”)需要大量数据学习,小样本场景效果差;

- 固定融合策略:多数模型采用静态融合(如固定注意力权重),无法适应动态输入(如模态质量变化)。

2.4 竞争范式分析:不同融合方法的优缺点

| 融合方法 | 核心逻辑 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| 特征拼接 | 直接拼接多模态特征 | 简单易实现 | 无模态间交互 | 实时应用(如客服机器人) |

| 模态间注意力 | 动态学习模态关联 | 语义对齐准确 | 计算复杂度高 | 高精度应用(如医疗诊断) |

| 跨模态对比学习 | 用对比损失对齐模态表示 | 表示泛化能力强 | 需要大量配对数据 | 预训练模型(如CLIP) |

| 模态自适应融合 | 根据模态质量调整权重 | 适应动态输入 | 需额外质量评估模块 | 多模态信息不均衡场景 |

3. 架构设计:多模态融合的分层系统框架

3.1 系统分解:核心组件定义

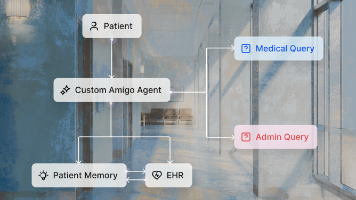

多模态智能文本生成系统的核心组件包括输入层、多模态编码器、跨模态对齐模块、生成解码器、输出层,如图1所示:

图1:多模态智能文本生成系统架构图

3.1.1 输入层:多模态数据预处理

输入层负责接收多模态数据(文本、图像、语音),并进行标准化处理:

- 文本:采用Byte-Pair Encoding(BPE) tokenization,截断/填充至固定长度(如512 tokens);

- 图像:resize至统一尺寸(如224×224),归一化(均值、标准差采用ImageNet预训练参数);

- 语音:转换为梅尔频谱图(Mel-Spectrogram),提取特征向量(如用Wav2Vec 2.0)。

3.1.2 多模态编码器:模态特征提取

多模态编码器采用专用编码器+参数共享策略:

- 文本编码器:选用BERT或RoBERTa(擅长语义理解),输出文本特征ttt;

- 图像编码器:选用ViT或ResNet(擅长视觉特征提取),输出图像特征vvv;

- 语音编码器:选用Wav2Vec 2.0或HuBERT(擅长语音特征提取),输出语音特征sss。

关键设计:所有编码器的隐藏维度ddd保持一致(如768),便于后续跨模态对齐。

3.1.3 跨模态对齐模块:语义关联学习

跨模态对齐模块是架构的核心,采用双向交叉注意力(Bidirectional Cross-Attention):

- 文本→图像注意力:文本作为查询(Q=tQ=tQ=t),图像作为键(K=vK=vK=v)和值(V=vV=vV=v),学习文本对图像的关注;

- 图像→文本注意力:图像作为查询(Q=vQ=vQ=v),文本作为键(K=tK=tK=t)和值(V=tV=tV=t),学习图像对文本的关注;

- 融合策略:将双向注意力结果拼接(或残差连接),得到联合表示hhh。

数学形式:

tatt=Attention(t,v,v)t_{\text{att}} = \text{Attention}(t, v, v)tatt=Attention(t,v,v)

vatt=Attention(v,t,t)v_{\text{att}} = \text{Attention}(v, t, t)vatt=Attention(v,t,t)

h=Concat(tatt,vatt)h = \text{Concat}(t_{\text{att}}, v_{\text{att}})h=Concat(tatt,vatt)

3.1.4 生成解码器:文本生成

生成解码器选用自回归Transformer(如GPT-2、T5),输入联合表示hhh,生成文本序列T^\hat{T}T^。

关键设计:解码器采用因果注意力(Causal Attention),确保生成过程的单向性(只能关注前面的 tokens)。

3.1.5 输出层:文本后处理

输出层负责对生成的文本进行优化:

- 去重复:采用n-gram惩罚(如禁止连续3个相同的词);

- 格式调整:根据应用场景调整文本格式(如电商商品描述采用 bullet point);

- 质量评估:用BLEU、ROUGE或人类评价指标评估生成质量,过滤低质量输出。

3.2 组件交互模型:数据流与控制流

系统的数据流遵循**“输入→编码→对齐→生成→输出”**的单向流程,控制流则负责处理边缘情况(如模态缺失、质量异常):

- 模态缺失:若某一模态未输入(如无图像),则跳过该模态的编码与对齐,直接用其他模态的特征生成文本;

- 质量异常:若某一模态质量差(如模糊图像),则降低其在联合表示中的权重(如用图像质量评估模型输出的分数调整注意力权重)。

3.3 设计模式应用:提升架构灵活性

- 适配器模式(Adapter Pattern):为不同模态的预处理设计适配器(如文本适配器处理tokenization,图像适配器处理resize),输入层可统一接收多模态数据;

- 策略模式(Strategy Pattern):为跨模态对齐设计多种策略(如特征拼接、Cross-Attention、对比学习),根据应用场景动态选择;

- 观察者模式(Observer Pattern):跨模态对齐模块观察多模态编码器的输出,当某一模态特征更新时,自动触发对齐流程。

4. 实现机制:从代码到性能优化

4.1 算法复杂度分析:多模态Transformer的计算瓶颈

多模态Transformer的核心计算瓶颈是跨模态注意力层,其时间复杂度为:

O(n×m×d)O(n \times m \times d)O(n×m×d)

其中,nnn为文本长度(如512),mmm为图像patch数量(如196,ViT-Base的patch size为16×16),ddd为隐藏维度(如768)。

以 batch size=32 为例,跨模态注意力层的计算量为:

32×512×196×768≈2.5×1010 operations32 \times 512 \times 196 \times 768 \approx 2.5 \times 10^{10} \text{ operations}32×512×196×768≈2.5×1010 operations

这需要高性能GPU(如A100)才能满足实时推理需求(延迟<1秒)。

4.2 优化代码实现:PyTorch实战示例

以下是多模态Transformer的PyTorch实现示例,采用**ViT(图像)+ BERT(文本)+ GPT-2(解码器)**的架构:

import torch

import torch.nn as nn

from transformers import ViTModel, BertModel, GPT2LMHeadModel, AutoTokenizer

class MultimodalTextGenerator(nn.Module):

def __init__(self, vit_model_name: str, bert_model_name: str, gpt2_model_name: str):

super().__init__()

# 1. 多模态编码器

self.vit = ViTModel.from_pretrained(vit_model_name)

self.bert = BertModel.from_pretrained(bert_model_name)

self.tokenizer = AutoTokenizer.from_pretrained(gpt2_model_name)

# 2. 跨模态对齐:双向Cross-Attention

self.text_to_image_attn = nn.MultiheadAttention(

embed_dim=self.bert.config.hidden_size,

num_heads=8,

batch_first=True

)

self.image_to_text_attn = nn.MultiheadAttention(

embed_dim=self.vit.config.hidden_size,

num_heads=8,

batch_first=True

)

# 3. 投影层:统一模态维度

self.vit_proj = nn.Linear(self.vit.config.hidden_size, self.bert.config.hidden_size)

self.bert_proj = nn.Linear(self.bert.config.hidden_size, self.vit.config.hidden_size)

# 4. 生成解码器:GPT-2

self.gpt2 = GPT2LMHeadModel.from_pretrained(gpt2_model_name)

def forward(

self,

text_input_ids: torch.Tensor,

text_attention_mask: torch.Tensor,

image_pixel_values: torch.Tensor,

max_length: int = 128

) -> torch.Tensor:

# 步骤1:模态编码

# 文本编码(BERT)

bert_output = self.bert(

input_ids=text_input_ids,

attention_mask=text_attention_mask

)

text_embeds = bert_output.last_hidden_state # (batch_size, seq_len, bert_hidden)

# 图像编码(ViT)

vit_output = self.vit(pixel_values=image_pixel_values)

image_embeds = vit_output.last_hidden_state # (batch_size, num_patches, vit_hidden)

# 步骤2:跨模态对齐(双向注意力)

# 文本→图像注意力:文本关注图像

text_embeds_proj = self.bert_proj(text_embeds) # 投影到ViT维度

text_attn_output, _ = self.text_to_image_attn(

query=text_embeds_proj,

key=image_embeds,

value=image_embeds

) # (batch_size, seq_len, vit_hidden)

# 图像→文本注意力:图像关注文本

image_embeds_proj = self.vit_proj(image_embeds) # 投影到BERT维度

image_attn_output, _ = self.image_to_text_attn(

query=image_embeds_proj,

key=text_embeds,

value=text_embeds

) # (batch_size, num_patches, bert_hidden)

# 步骤3:联合表示(拼接+投影)

joint_embeds = torch.cat([text_attn_output, image_attn_output], dim=1) # (batch_size, seq_len+num_patches, hidden)

joint_embeds = self.vit_proj(joint_embeds) # 统一到GPT-2输入维度

# 步骤4:生成解码(GPT-2)

gpt2_output = self.gpt2.generate(

inputs_embeds=joint_embeds,

attention_mask=torch.ones(joint_embeds.shape[:2], device=joint_embeds.device),

max_length=max_length,

num_beams=4,

early_stopping=True

)

return gpt2_output

4.3 边缘情况处理:模态缺失与质量异常

4.3.1 模态缺失处理

若用户未输入图像(image_pixel_values is None),则跳过图像编码与对齐,直接用文本特征生成文本:

def forward(...):

if image_pixel_values is None:

# 仅用文本生成

joint_embeds = text_embeds

else:

# 多模态融合

... # 上述图像编码与对齐逻辑

4.3.2 质量异常处理

采用图像质量评估(BIQA)模型(如NRQM)评估图像质量,根据质量分数调整图像在联合表示中的权重:

from torchvision.models import resnet50

class ImageQualityAssessor(nn.Module):

def __init__(self):

super().__init__()

self.resnet = resnet50(pretrained=True)

self.fc = nn.Linear(1000, 1) # 输出质量分数(0-1)

def forward(self, image_pixel_values: torch.Tensor) -> torch.Tensor:

features = self.resnet(image_pixel_values)

score = torch.sigmoid(self.fc(features)) # 归一化到0-1

return score

# 在MultimodalTextGenerator中使用

self.qa_model = ImageQualityAssessor()

def forward(...):

if image_pixel_values is not None:

image_score = self.qa_model(image_pixel_values) # (batch_size, 1)

image_embeds = image_embeds * image_score.unsqueeze(1) # 用质量分数调整图像特征权重

... # 后续对齐逻辑

4.4 性能考量:推理速度优化

4.4.1 模型压缩

- 蒸馏:用大模型(如ViT-Base)蒸馏小模型(如TinyViT),减少参数数量;

- 量化:将模型参数从FP32量化到INT8,用PyTorch的

torch.quantization工具; - 剪枝:移除模型中的冗余参数(如注意力层中的低权重连接)。

4.4.2 分布式推理

- 数据并行:将batch数据分配到多个GPU,并行计算;

- 模型并行:将大模型(如GPT-2)的层分配到多个GPU,减少单GPU内存占用;

- TensorRT加速:用NVIDIA TensorRT优化模型推理,提升速度2-5倍。

5. 实际应用:电商多模态商品描述系统

5.1 需求分析

某电商平台需要构建多模态商品描述系统,用户上传商品图像并输入简短文本(如“红色连衣裙”),系统生成包含“颜色、材质、款式、适合场合”的详细描述(如“这款红色V领连衣裙采用蕾丝材质,裙摆呈A字型,适合约会或派对穿着”)。

5.2 实施策略

- 数据准备:收集100万条商品数据(图像+文本描述),采用CLIP进行跨模态预训练;

- 模型选择:选用ViT(图像)+ BERT(文本)+ GPT-2(解码器)的架构,预训练模型采用Hugging Face的

vit-base-patch16-224、bert-base-uncased、gpt2-medium; - 微调:用电商商品数据微调模型,损失函数采用交叉熵损失(生成文本与真实描述的差异)+ 跨模态对比损失(图像与文本表示的对齐);

- 部署:用FastAPI构建推理接口,部署在AWS p3实例(A100 GPU),支持每秒100次推理。

5.3 集成方法论

- 与CMS系统集成:将推理接口嵌入电商CMS系统,用户上传图像后自动触发描述生成;

- 用户反馈 loop:允许用户修改生成的描述,将修改后的文本作为监督数据,定期微调模型;

- A/B测试:同时部署单模态(仅文本)和多模态模型,根据用户点击率和转化率选择最优模型。

5.4 运营管理

- 质量监控:用BLEU-4(≥0.4)和人类评价(≥4分/5分)监控生成质量;

- 延迟监控:用Prometheus监控推理延迟,确保95%的请求延迟<1秒;

- 模型更新:每季度用新数据微调模型,每年更换一次预训练模型(如从GPT-2升级到GPT-3)。

6. 高级考量:安全、伦理与未来演化

6.1 扩展动态:从“文本+图像”到“多模态+实时”

未来多模态系统的扩展方向包括:

- 更多模态:支持视频(ViViT编码)、触觉(传感器数据编码)、嗅觉(化学传感器数据编码);

- 实时交互:采用流式推理(如用Llama 2的流式生成),支持用户实时修改输入(如调整图像或文本);

- 跨语言多模态:支持多语言文本生成(如输入英文文本和中文图像,生成中文描述)。

6.2 安全影响:多模态虚假信息检测

多模态生成的虚假信息(如“假新闻图像+假文本”)更具迷惑性,需开发多模态虚假信息检测系统:

- 图像伪造检测:用GAN指纹检测(如StyleGAN生成的图像);

- 文本虚假检测:用事实核查模型(如FEVER);

- 多模态融合检测:用跨模态注意力模型(如检测图像与文本的语义冲突)。

6.3 伦理维度:隐私与公平性

- 隐私保护:对用户上传的图像进行匿名化处理(如模糊面部),采用联邦学习(Federated Learning)训练模型,避免数据泄露;

- 公平性:确保模型生成的文本不包含偏见(如对某一性别或种族的歧视),采用对抗性去偏(Adversarial Debiasing)方法优化模型。

6.4 未来演化向量:大模型与多模态统一

未来多模态系统的核心演化方向是大模型的多模态统一(如GPT-4V、Gemini):

- 统一编码器:用一个Transformer编码器处理所有模态(文本、图像、语音);

- 统一表示:将所有模态映射到同一语义空间,实现“模态无关”的生成;

- 因果推理:学习模态间的因果关系(如“图像中的乌云”导致“文本中的悲伤”),提高生成的可解释性。

7. 综合与拓展:从实践到战略

7.1 跨领域应用

- 教育:输入教案大纲(文本)和知识点示意图(图像),生成包含“图文对应解释”的教案;

- 医疗:输入病历(文本)和X光片(图像),生成包含“图像异常描述”的诊断报告;

- 媒体:输入新闻标题(文本)和现场照片(图像),生成包含“图像细节”的新闻报道。

7.2 研究前沿

- 多模态大模型的小样本学习:用少量数据微调大模型,适应特定领域(如医疗);

- 模态间因果推理:用因果图模型(Causal Graph)学习模态间的因果关系;

- 动态模态融合:根据输入模态的质量动态调整融合策略(如图像质量高时增加图像权重)。

7.3 开放问题

- 如何解决模态间的语义鸿沟?:需要更有效的跨模态对齐方法(如基于知识图谱的对齐);

- 如何实现多模态生成的可解释性?:需要开发模态间注意力可视化工具(如显示文本关注的图像区域);

- 如何平衡多模态模型的性能与效率?:需要更高效的模型架构(如稀疏Transformer)。

7.4 战略建议

- 业务驱动:根据业务需求选择模态(如电商选图像+文本,教育选文本+图像+视频);

- 技术栈选择:采用Hugging Face的Transformers库(快速集成预训练模型)、PyTorch(灵活定制)、FastAPI(快速部署);

- 人才培养:培养懂计算机视觉、自然语言处理、架构设计的复合型人才;

- 逐步迭代:从单模态到多模态,从简单到复杂(如先做图像+文本,再做图像+文本+语音)。

结语

多模态融合是智能文本生成的未来方向,其核心是整合异构信息,生成更符合人类需求的文本。本文从理论到实践,构建了多模态融合的架构框架,讲解了实现细节与优化策略,并结合电商案例说明了落地流程。未来,随着大模型的发展,多模态系统将更加智能、实时、可解释,为各个领域带来更丰富的应用场景。

作为AI架构师,需始终站在业务需求与技术前沿的交叉点,平衡模型的性能、效率与伦理,才能构建出真正有价值的多模态智能文本生成系统。

参考资料

- Radford, A., et al. (2021). “Learning Transferable Visual Models From Natural Language Supervision.” ICML.

- Ramesh, A., et al. (2022). “Hierarchical Text-Conditional Image Generation with CLIP Latents.” NeurIPS.

- Alayrac, J. B., et al. (2022). “Flamingo: a Visual Language Model for Few-Shot Learning.” ICML.

- Hugging Face Transformers Documentation: https://huggingface.co/docs/transformers/index

- PyTorch Documentation: https://pytorch.org/docs/stable/index.html

更多推荐

已为社区贡献199条内容

已为社区贡献199条内容

所有评论(0)