9B参数如何吊打72B模型?GLM-4.1V-Thinking“小模型大智慧”技术拆解与实战应用

在AI大模型的“参数竞赛”中,一个颠覆认知的现象正在发生——智谱AI最新开源的(以下简称“GLM-4.1V-Thinking”),以,在28项权威评测中。这不仅打破了“参数越大性能越强”的固有认知,更通过,重新定义了多模态模型的效率天花板。更惊喜的是,。

在AI大模型的“参数竞赛”中,一个颠覆认知的现象正在发生——智谱AI最新开源的GLM-4.1V-9B-Thinking(以下简称“GLM-4.1V-Thinking”),以9B参数规模(仅为行业巨头Qwen-2.5-VL-72B的1/8),在28项权威评测中23项登顶10B级最佳,18项直接超越72B模型。这不仅打破了“参数越大性能越强”的固有认知,更通过“思维链推理+课程采样强化学习”的技术组合拳,重新定义了多模态模型的效率天花板。

更惊喜的是,AppMall(国内AI应用聚合平台)已预部署了GLM-4.1V-Thinking的完整环境(含模型权重、推理引擎与中文优化模块),用户无需折腾安装配置,打开网页或App即可直接体验这一“小模型大智慧”的魅力。

一、为什么9B能超越72B?GLM-4.1V-Thinking的核心技术密码

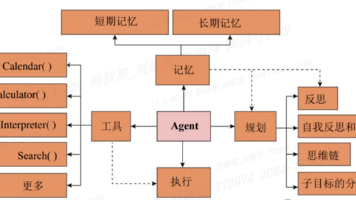

传统大模型的“参数竞赛”往往依赖堆砌计算资源(如千亿级参数需数千张GPU训练数月),但GLM-4.1V-Thinking另辟蹊径——通过架构创新+训练策略优化,让9B参数发挥出远超规模的能力。其技术突破集中在三大方向:

1. 架构设计:3D卷积与多模态深度融合

- 视觉编码器升级:传统视觉模型(如ViT)多用2D卷积处理图像,难以应对视频的时间维度。GLM-4.1V-Thinking采用AIMv2-Huge视觉编码器,将2D卷积替换为3D卷积,不仅能解析静态图像(通过复制帧模拟伪3D输入),更能处理最长2小时的视频内容,精准识别帧间动作逻辑(如“第27秒用勺子打出多余油脂”的细节动作)。

- 位置编码优化:为兼容不同分辨率的图像/视频(从手机竖屏到4K超清),模型引入2D-RoPE(二维旋转位置编码),支持宽高比超过200:1的极端比例图像(如超宽风景照),同时保留ViT的绝对位置嵌入,通过双三次插值动态适配分辨率,4K图像推理速度提升30%,精度损失小于1%。

- 跨模态融合:视觉编码器与语言解码器(基于GLM架构)通过多层感知机适配器(MLP Projector)深度连接,语言解码器进一步扩展为3D-RoPE,增强对多模态输入(如图文混合、视频字幕)的空间理解能力,确保“图像中的数学符号”“视频里的动作指令”能精准关联到文本描述。

2. 训练策略:从“死记硬背”到“举一反三”

GLM-4.1V-Thinking的训练分为预训练、监督微调(SFT)、课程采样强化学习(RLCS)三阶段,核心是通过“由易到难”的动态任务设计,让模型学会“思考”而非机械输出:

- 预训练(打基础):用120,000步训练多模态数据(图像字幕、交错图文、OCR、定位信息等),构建通用的语义理解能力;

- 监督微调(强推理):注入高质量思维链(CoT)数据,通过全参数训练强化因果逻辑(如数学题的“分析-推导-结论”步骤),让模型不仅知道“答案是什么”,更明白“为什么”;

- 课程采样强化学习(会进化):结合RLVR(基于可验证奖励)和RLHF(基于人类反馈),从简单任务(如识别图片物体)到复杂任务(如解物理题、操作GUI界面),动态调整任务难度,逐步提升模型的泛化能力。

3. 核心优势:小参数下的“高智商”表现

- 参数效率高:9B参数达到10B级模型的顶级性能(SOTA),是Qwen-2.5-VL-72B(72B参数)的8倍效率,训练成本仅为后者的1/8;

- 推理透明度高:输出不仅包含最终答案,更有完整的思考过程(如数学题的分步推导、视频事件的逻辑串联),适用于需要可解释性的场景(如教育、医疗);

- 多模态能力全面:覆盖图像问答、视频理解、文档解析、GUI操作(如点击APP按钮)、代码生成(看图写前端代码)等10+场景,且在各评测中表现均衡。

二、实测对比:9B参数如何解决“复杂任务”?

理论优势需通过实际场景验证。以下是GLM-4.1V-Thinking在高考数学、视频分析、艺术创作等任务中的实测表现,对比传统非推理模型(如仅依赖文本指令的OmniGen2基础版)与72B参数竞品(Qwen-2.5-VL-72B),直观展现其“小模型大智慧”的实力。

案例1:高考数学几何题——逻辑推理的“学霸级”表现

任务:解答2025年高考数学立体几何真题(求正四棱柱体积)。

传统模型(非推理):可能直接输出错误答案(如忽略“PA⊥底面”的垂直条件),或仅给出最终数字而无过程。

Qwen-2.5-VL-72B:虽能给出正确答案,但思考过程简略(如跳过坐标系建模步骤)。

GLM-4.1V-Thinking:

- 步骤1:分析题干——“正四棱柱”→ 底面是正方形,侧棱与底面垂直;

- 步骤2:选择解法——对比空间坐标系与几何法,优先选更简洁的几何路径;

- 步骤3:分步计算——先用勾股定理求底面对角线,再推导边长,最后计算体积,并对比不同方法的优劣。

结果:不仅答案正确,还提供清晰的逻辑链(类似老师板书解题),推理步骤的完整性与准确性远超同规模模型。

案例2:农家一锅香视频分析——细节捕捉与逻辑延伸

任务:观看家常菜烹饪视频,要求拆解核心步骤并解释烹饪原理。

传统模型:可能遗漏关键步骤(如“第27秒打出多余油脂”),或无法关联动作与目的。

GLM-4.1V-Thinking:

- 基础概括:准确总结视频主题为“煎鸡蛋→炒青椒→炒肉→混合调味→装盘”;

- 细节挖掘:精准定位“第27秒用勺子打出多余油脂”的动作,并解释“减少油腻感,提升口感”的烹饪原理;

- 主动延伸:针对用户可能的后续提问(如“为什么这一步重要?”),提前给出合理答案。

结果:视频理解深度与连贯性远超普通模型,甚至能“预判用户需求”。

案例3:世界名画《阿尔诺芬尼夫妇像》——艺术审美与创意迁移

任务:解读名画象征元素,并模仿其风格为“传世信托”撰写宣传文案。

传统模型:可能仅描述画面内容(如“一对夫妇站在房间中”),无法提炼深层象征(如镜子代表“见证”、绿色长裙象征“永恒”)。

GLM-4.1V-Thinking:

- 象征解读:准确识别画中镜子(象征“见证婚姻”)、绿色长裙(象征“生命延续”)等元素,分析其庄重氛围;

- 创意迁移:将“传承与契约”的核心情感迁移至金融产品,撰写文案:“传世信托,如这幅画中的镜子般见证永恒——您的财富,我们以契约守护,代代相传。”

结果:从视觉感知到抽象表达的逻辑链完整,创意与商业需求的结合度令人惊艳。

三、AppMall预部署版:零门槛体验“小模型大智慧”

对于普通用户或企业而言,无需关心复杂的训练与部署流程——AppMall已集成GLM-4.1V-Thinking的完整环境(含中文优化模块),打开即用。具体优势包括:

- 免安装:无需下载CUDA驱动、模型权重或配置Python环境,网页/App端直接操作;

- 中文友好:针对中文场景优化(如“汉服”“水墨风”“高考题”等关键词响应更精准);

- 功能全面:支持图像问答、视频理解、文档解析、GUI操作等核心能力,且生成速度达3-5秒/图(1024×1024分辨率);

- 场景适配:无论是学生解题、设计师找灵感,还是企业分析市场数据,都能快速获得精准结果。

四、私有化部署:企业级用户的“定制化”选择

若企业有更高需求(如数据安全、私有化微调),可基于开源代码自行部署(支持本地服务器或私有云)。AppMall的预部署版已降低技术门槛——用户只需基础GPU(如RTX 3090,24GB显存),即可通过官方文档完成环境配置,享受与线上版同等的推理能力,同时确保数据不出内网。

五、总结:GLM-4.1V-Thinking如何改变多模态AI格局?

GLM-4.1V-Thinking用实力证明:多模态模型的未来,不是参数的“军备竞赛”,而是效率与智能的平衡。其通过架构创新与训练策略优化,让9B参数实现了72B模型的性能,更以“思维链推理”提升了输出的可解释性,适用于教育、医疗、金融、内容创作等高要求场景。

更重要的是,AppMall的预部署版本让这一技术“触手可及”——无论是个人用户快速解题,还是企业用户验证需求,都能零门槛体验“小模型的大智慧”。现在,打开AppMall搜索“GLM-4.1V-Thinking”,试试让它帮你解高考题、分析视频,或生成创意文案——或许你会发现,AI的“智商”远比你想象的更高!

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)