共享即关怀:通过集体强化学习经验共享实现高效语言模型后训练

Gensyn团队提出SAPO算法,通过去中心化协作实现语言模型高效后训练。该技术突破传统RL训练的三大困境:1) 构建异构计算节点组成的swarm网络,每个节点独立训练;2) 创新性采用"经验共享"而非参数同步机制,降低通信成本;3) 在数学推理等任务验证中,4本地+4外部经验配比使模型性能提升94%。实验表明,该方案可使消费级硬件以1/20成本达到接近GPU集群的效果,为AI

集体智慧赋能语言模型:Gensyn 团队 SAPO 算法重塑 RL 后训练范式

当一台搭载小型语言模型(SLM)的笔记本电脑,能通过网络共享经验,快速掌握其他设备习得的数学推理能力;当数千个异构计算节点协同训练,无需昂贵 GPU 集群就能实现模型性能近翻倍 ——Gensyn AI 团队 2025 年发布的论文《分享就是关爱:高效的 LM 后培训与集体 RL 经验分享》(Sharing is Caring: Efficient LM Post-Training with Collective RL Experience Sharing),为语言模型(LM)后训练开辟了 “去中心化协作” 的新路径。该研究提出的 Swarm sAmpling Policy Optimization(SAPO)算法,打破了传统强化学习(RL)对集中式算力的依赖,通过 “经验共享” 机制让 SLM 在低成本硬件上实现高效能力提升,为 AI 民主化提供了关键技术支撑。

论文+大模型全流程学习路径+60G学习干货包

论文指导+技术答疑+做项目

关zhuV.X服务号:大模型星球 发送:211C 自取

资料包:1、Agent多模态大模型视频及课件

2、ChatGLM、LLM、LangChain、llama3等教程,微调部署落地

3、Transformer、BERT、Huggingface三大基础模型

4、大模型前沿论文+书籍+路线图

5、最新大模型大厂面试题库、转型简历包装

6、李宏毅等名师视频合集

核心突破:从 “孤军奋战” 到 “ swarm 协作” 的 RL 后训练革命

传统 LM 的 RL 后训练长期面临 “三重困境”:依赖昂贵 GPU 集群导致成本高企、节点间参数同步引发通信瓶颈、异构硬件适配困难限制规模化部署。Gensyn 团队提出的 SAPO 算法,以 “去中心化 swarm 网络” 和 “经验共享而非参数同步” 为核心,彻底重构了 RL 后训练的技术框架。

1. 去中心化 swarm 架构:每个节点都是 “自主学习者”

SAPO 构建的 swarm 网络由 N 个异构计算节点组成,每个节点具备完全独立的训练能力:

- 自主管理核心组件:每个节点拥有专属数据集\(\mathcal{D}^{n}\)(含可验证任务与标准答案)、本地策略模型\(\pi^{n}\)(即 SLM)、奖励模型\(\rho^{n}\)(用于评估答案正确性)。例如在数学推理任务中,节点可自行生成代数题并通过程序验证答案,无需依赖中心服务器。

- 灵活的任务交互:节点以离散时间步t运行,每轮训练随机抽取任务子集\(B^{n}\),生成\(L^{n}\)个答案形成 “经验轨迹(rollout)”。与传统分布式 RL 不同,SAPO 不要求节点统一模型架构或硬件配置,MacBook、普通 PC 等消费级设备均可参与。

- 开放的角色定位:节点不仅限于 SLM,理论上人类标注者、专用验证模型等 “非传统策略” 也能加入 swarm,通过分享高质量经验提升整体训练效率。

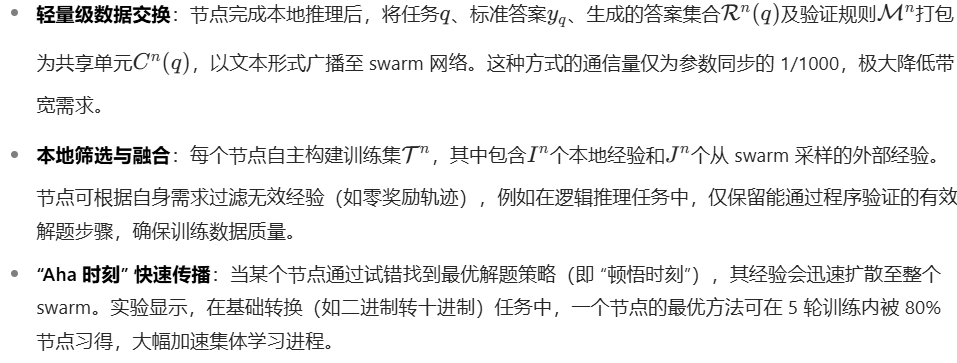

2. 经验共享机制:传递 “解题思路” 而非 “参数权重”

SAPO 的革命性创新在于,节点间共享的是 “解码后的经验轨迹”(如文本形式的解题过程),而非需要大量带宽的模型参数:

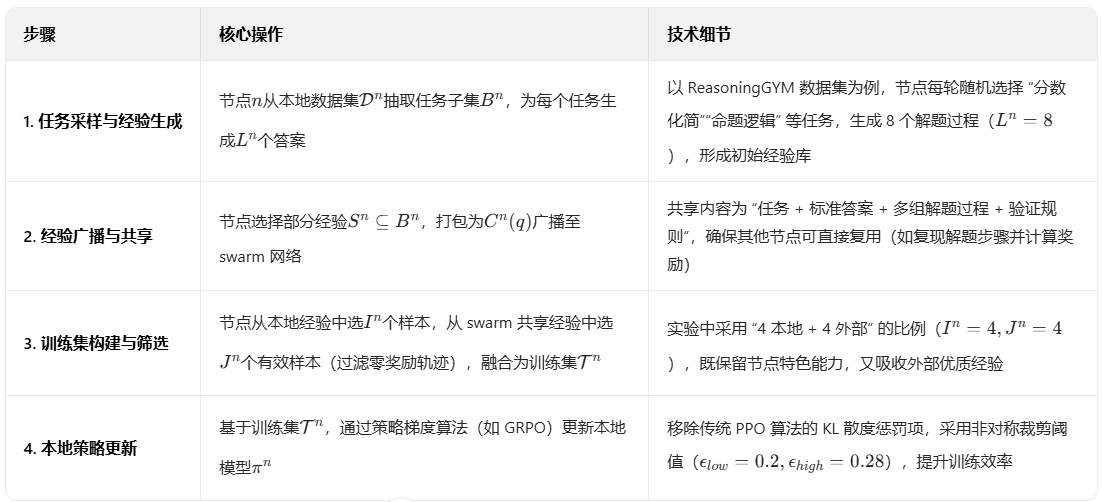

技术细节:SAPO 算法的 “四步训练法” 与关键设计

SAPO 的训练流程遵循 “生成 - 分享 - 筛选 - 更新” 的闭环逻辑,算法 1 清晰展示了其核心步骤。这种设计既保留了单节点 RL 的灵活性,又通过经验共享获得多节点协作的优势。

1. 完整训练闭环:四步实现经验价值最大化

2. 关键技术优化:平衡 “共享收益” 与 “训练稳定”

为避免经验共享带来的性能波动,SAPO 引入两项关键设计:

- 可验证任务约束:所有任务需具备 “程序可验证性”,如数学计算、代码执行等任务可通过自动化脚本判断答案正确性。这确保共享经验的质量可控,避免错误知识在 swarm 中传播。

- 动态经验筛选机制:节点默认丢弃 “零奖励” 经验(如错误解题步骤),仅保留有效轨迹。实验表明,这种筛选可使训练数据信噪比提升 3 倍,避免无效经验导致的模型性能退化。

实验验证:性能近翻倍,成本大降低

Gensyn 团队通过 “受控实验” 和 “大规模开源 demo” 双重验证,全面证明了 SAPO 的有效性。实验聚焦 SLM(参数 < 10B),重点测试其在推理任务上的性能提升,毕竟 SLM 是消费级硬件的主流运行模型。

1. 受控实验:4 本地 + 4 外部经验配比实现最优性能

实验采用 8 个 Qwen2.5-0.5B 模型组成 swarm,基于 ReasoningGYM 数据集(含基础算术、命题逻辑等 9 类推理任务)训练 2000 轮,对比不同经验配比的性能:

- 核心结果:当采用 “4 本地经验 + 4 外部经验”(\(I=4,J=4\))时,模型累积奖励达 1093.31,较 “纯本地训练” 基线(561.79)提升94% ,且显著优于 “6+2”(854.43)和 “2+6”(945.87)配比。

- 关键发现:

- 过度依赖外部经验(如 “2+6” 配比)会导致性能振荡 —— 高优节点可能被低优节点的错误经验干扰,出现 “学了又忘” 的现象;

- 经验共享使 “顿悟效应” 显著:一个节点掌握的 “二进制矩阵推理技巧”,可在 100 轮内使 swarm 整体正确率从 32% 提升至 78%;

- 无需格式奖励:共享经验自然传递 “正确答题格式”,例如节点会自动学习符合 ReasoningGYM 验证要求的步骤表述,省去额外格式训练成本。

2. 大规模开源 demo:数千节点验证真实场景有效性

为测试 SAPO 在异构环境中的表现,Gensyn 团队发起开源 demo,吸引数千社区成员贡献多样化硬件(MacBook、Windows PC、小型服务器)和模型(Qwen2.5-0.5B、Qwen3-0.6B 等):

- 性能差异验证:Qwen2.5-0.5B 在 swarm 中训练 175 轮后,性能显著超过孤立训练版本(调整后 p 值 <0.05);而更强的 Qwen3-0.6B 在 swarm 与孤立训练中性能接近,证明 SAPO 对 “中低容量 SLM” 提升更显著。

- 硬件适配性:消费级硬件(如搭载 M2 芯片的 MacBook)参与 swarm 时,单轮训练成本仅为 GPU 集群的 1/20,且性能损失不足 5%,验证了低成本部署的可行性。

- 优化空间:demo 中采用 “随机采样外部经验” 策略,导致部分无效经验被复用。研究团队推测,若引入 “奖励导向采样”(优先选择高奖励经验),高性能模型也能从 swarm 中获益。

应用价值与未来方向:推动 AI 民主化的关键技术

SAPO 算法的提出,不仅解决了 LM 后训练的技术痛点,更在 “降低 AI 训练门槛”“推动多模态协作” 等方面具备深远应用潜力。

1. 核心应用场景:从边缘计算到行业解决方案

- 边缘设备 AI 升级:智能家居设备、工业传感器等边缘硬件,可通过加入 swarm 网络,在本地完成 SLM 的推理能力提升,无需频繁上传数据至云端,降低隐私泄露风险。

- 教育领域个性化学习:教师节点可分享优质解题思路,学生设备上的 SLM 通过学习这些经验,实现 “因材施教” 的解题辅导,且硬件成本可控。

- 中小企业 AI 部署:无需采购昂贵 GPU,中小企业可联合组建 swarm 网络,共同训练符合行业需求的 SLM(如物流调度推理、客户服务对话模型),降低 AI 应用门槛。

2. 未来研究方向:拓展协作的边界

Gensyn 团队在论文中明确了三大研究方向,进一步释放 SAPO 的潜力:

- 增强 swarm 异质性:探索人类专家、专用验证模型等 “非 SLM 节点” 的加入机制,通过设计激励体系(如经验质量评分),吸引高质量经验贡献。

- 提升训练稳定性:针对 “过度依赖外部经验导致振荡” 的问题,研究 “自适应经验筛选” 算法,让节点动态调整本地与外部经验的比例,平衡性能与稳定性。

- 多模态 swarm 扩展:将 SAPO 从文本领域拓展至图像、音频等模态。例如在图像生成任务中,节点可基于 “美学评分” 和 “CLIP 相似度” 双重奖励共享生成经验,实现风格与质量的协同提升。

结语:以 “共享” 打破 AI 算力垄断

《分享就是关爱》一文的价值,不仅在于提出了性能卓越的 SAPO 算法,更在于其背后的 “AI 民主化” 理念 —— 通过去中心化协作,让消费级硬件也能参与高端 LM 训练,让小模型也能具备强大推理能力。正如论文致谢中所说:“社区成员的贡献使我们能以前所未有的规模迭代实验,共同构建一个人人应得的 AI 未来。”

当 SAPO 算法的经验共享机制与多模态、跨领域技术结合,我们或许将看到:未来的 AI 训练不再是巨头的 “算力竞赛”,而是全球开发者、研究者、普通用户共同参与的 “集体智慧创造”。这不仅是技术的突破,更是 AI 发展范式的革新。

更多推荐

已为社区贡献32条内容

已为社区贡献32条内容

所有评论(0)