聊一聊AI大模型技术基本原理和应用

AI大模型的核心是基于Transformer架构,通过在海量数据上预训练出超大规模参数的模型,再通过指令微调和RLHF与人类对齐。它们已经从一项前沿技术迅速转变为推动各行各业变革的基础性生产力工具,其应用正在不断拓宽我们想象力的边界。然而,如何安全、可靠、高效地发展和使用它们,仍然是全社会需要共同面对的重要课题。

本文简单聊一聊AI大模型技术基本原理和应用,从基本原理开始,逐步深入到其应用、挑战与未来趋势。

第一部分:AI大模型的基本原理

要理解大模型,核心是抓住几个关键词:“大”、“预训练” 和 “Transformer”。

1. 核心架构:Transformer

这是所有现代大模型(如GPT、PaLM、LLaMA等)的基石。由Google在2017年的论文《Attention Is All You Need》中提出。它解决了传统循环神经网络(RNN)处理长序列文本时信息衰减的问题。

- 自注意力机制 (Self-Attention):这是Transformer的灵魂。它可以计算序列中每个单词与其他所有单词之间的关联强度(权重)。例如,在句子“The animal didn’t cross the street because it was too tired”中,自注意力机制能帮助模型确定“it”指的是“animal”而不是“street”。这让模型能够更好地理解上下文和长距离依赖关系。

- 编码器-解码器结构 (Encoder-Decoder):最初的设计包含两部分。

- 编码器:负责理解和编码输入信息(如将句子压缩为一种语义表示)。

- 解码器:负责根据编码器的输出生成目标内容(如翻译另一种语言)。

- 纯解码器架构 (Decoder-Only):像GPT系列这样的生成式大模型,通常只使用解码器堆叠而成。这种架构非常适合自回归生成任务,即根据已经生成的内容来预测下一个词,逐词生成整个序列。

2. “大”在哪里?(Scale is All You Need)

大模型的“大”体现在三个维度,它们相互促进,带来了质的飞跃(涌现能力):

- 数据量大 (Data):使用互联网规模的海量文本、代码等进行训练,数据量可达TB甚至PB级别。

- 参数规模大 (Parameters):模型中的可调节参数(可理解为模型的“ synapses 突触”)数量极其庞大。从早期的百万级(BERT-base: 1.1亿)发展到现在的万亿级(GPT-4据估计超过1万亿)。参数是模型存储知识和学习规律的地方。

- 计算量大 (Compute):训练这些模型需要巨大的算力,通常需要成千上万个高端GPU/TPU进行数周甚至数月的并行计算。

这种 scaling law(缩放定律)表明,简单地扩大这三个维度,模型的性能就会持续、可预测地提升,甚至在某些任务上产生涌现能力 (Emergent Abilities)——即在小模型中不存在,但在大模型中突然出现的能力,如复杂推理、思维链(Chain-of-Thought)等。

3. 核心技术:预训练 + 微调 (Pre-training + Fine-tuning)

这是大模型的工作范式。

-

a. 预训练 (Pre-training)

- 目标:在海量无标注数据上,让模型学习通用的语言规律、世界知识和推理能力。这是一个非常耗钱耗时的过程。

- 方法:

- 自回归语言建模 (Autoregressive):例如GPT系列。给定前文,预测下一个最可能的词。目标:生成。

- 自编码语言建模 (Autoencoding):例如BERT系列。随机掩盖输入中的一些词(如[MASK]),让模型根据上下文预测被掩盖的词。目标:理解。

-

b. 指令微调与对齐 (Instruction Tuning & Alignment)

- 预训练后的模型知识渊博,但还不会很好地遵循人类的指令。因此需要第二步。

- 指令微调 (Instruction Tuning):使用高质量的(指令,期望回复)数据对来微调模型,教会它如何回答问题、总结文章、写邮件等。

- 人类反馈强化学习 (RLHF):这是让ChatGPT如此“听话”和“有用”的关键技术。通过人类对模型输出的偏好进行评分,训练一个奖励模型,然后用强化学习(PPO算法)来进一步优化语言模型,使其输出更符合人类价值观和偏好( helpful, honest, harmless)。

第二部分:AI大模型的应用

大模型是基础模型 (Foundation Model),意味着它们可以作为基石,被应用到无数下游任务中。

1. 自然语言处理 (NLP)

- 对话与聊天机器人:如ChatGPT、文心一言、通义千问,提供近乎人类的对话体验。

- 内容创作与生成:撰写邮件、新闻稿、小说、诗歌、广告文案、视频脚本等。

- 信息摘要与提取:快速阅读长篇文章、报告、论文,并生成核心要点摘要。

- 代码生成与辅助:如GitHub Copilot,根据自然语言描述生成代码、解释代码、调试和转换编程语言。

- 翻译:提供比传统统计机器翻译更流畅、更符合语境的翻译结果。

2. 多模态 (Multimodal)

大模型正从纯文本走向能理解和生成多种信息形态。

- 文生图 (Text-to-Image):如Midjourney, Stable Diffusion, DALL-E 3,根据文字描述生成高质量、高创意性的图像。

- 文生视频 (Text-to-Video):如Sora, RunwayML,根据文本生成短视频片段,是当前最前沿的应用。

- 图生文 (Image-to-Text):图像描述、视觉问答(VQA)、解读图表等。

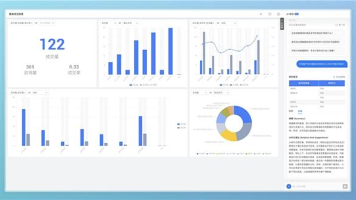

3. 企业与行业应用

- 智能客服:自动回答客户常见问题,提升服务效率。

- 办公助手:集成到Office、钉钉、飞书等工具中,帮助写PPT、分析Excel数据、整理会议纪要。

- 教育与科研:作为个性化的辅导老师,解答学生问题;帮助研究人员快速阅读和综述海量文献。

- 医疗健康:辅助医生进行病历分析、医学影像诊断和药物研发。

- 金融:进行风险分析、撰写投研报告、自动化合规审查。

第三部分:挑战与未来趋势

挑战:

- 算力与成本:训练和部署成本极高,造成了较高的技术门槛。

- 幻觉 (Hallucination):模型可能会生成看似合理但完全不实或错误的信息。

- 偏见与毒性:模型会学习并放大训练数据中存在的社会偏见和有害内容。

- 安全与滥用:可能被用于生成虚假信息、网络钓鱼邮件、恶意代码等。

- 能耗:巨大的计算量消耗大量电力,引发环保担忧。

未来趋势:

- 多模态融合:未来的模型将是“全能型”的,能无缝理解和生成文本、图像、音频、视频、3D模型等。

- 智能体 (Agents):大模型不再仅仅是问答工具,而是能自主规划、使用工具(搜索引擎、API、软件)、执行复杂任务的智能代理。

- 小型化与效率:研究如模型压缩、剪枝、量化、蒸馏等技术,让更小、更高效的模型在边缘设备(如手机)上运行成为可能。

- 持续学习与更新:探索如何让大模型在不遗忘旧知识的情况下,高效地学习新知识,而无需全部重新训练。

- 可信与可靠:加强对齐研究,减少幻觉和偏见,提高模型输出的准确性和安全性。

总结

AI大模型的核心是基于Transformer架构,通过在海量数据上预训练出超大规模参数的模型,再通过指令微调和RLHF与人类对齐。它们已经从一项前沿技术迅速转变为推动各行各业变革的基础性生产力工具,其应用正在不断拓宽我们想象力的边界。然而,如何安全、可靠、高效地发展和使用它们,仍然是全社会需要共同面对的重要课题。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)