小白入门智能体agent — 畅读《A SURVEY OF SELF-EVOLVING AGENTS: ON PATH TOARTIFICIAL SUPER INTELLIGENCE》分篇(二)

本文深入解读了《自进化智能体综述:迈向人工超级智能ASI之路》论文的引言部分。文章以达尔文适者生存的进化论开篇,强调适应能力比固有优势更重要,这与当前静态LLM的局限性形成对比。作者系统阐释了自进化智能体(ANI/AGI/ASI)的概念层级,指出其通过实时学习和适应环境反馈的特性,将成为通向人工超级智能(ASI)的关键路径。

本篇文章摘取原论文中重点表达进行讲解,面向纯小白,不需要系统阅读原综述论文,即可迅速掌握self-evolving agents的概要,也可作为原论文的伴读博文。

论文的讲解第二篇更新来了。

先放上我们要读的论文title:

自进化智能体综述:迈向人工超级智能ASI之路

《A SURVEY OF SELF-EVOLVING AGENTS: ON PATH TOARTIFICIAL SUPER INTELLIGENCE》

第一篇我们讲解了“摘要”部分,这一篇仍是讲解“what to evolve, when to evolve, and how to evolve”的奠基,即 “引入Introduction” 。

建议小白先行阅读完分篇(一),因为很多分篇(一)讲解过的点,后续不再进行二次讲解。

1. Introduction

引入部分先是引用的达尔文的格言,比较有趣,放到下面:

01 " It is not the most intellectual of the species that survives; it is not the strongest that survives; but the species that survives is the one that is able best to adapt and adjust to the changing environment in which it finds itself. " — Charles Darwin

【译】能够生存下来的不是最聪明的物种,也不是最强壮的物种;而是能够最好地适应和调整自己以应对所处环境的不断变化。

【讲解】这是充满真理和哲思的一段话,适应优于绝对实力。同时,“最智力”和“最强壮”代表了一种静态的、固有的优势,说明在开放互动式的环境,但如果环境剧变,曾经的优势可能瞬间变为劣势。就比如,恐龙作为白垩纪最强壮的物种,却无法适应小行星撞击后的“核冬天”环境。“能够最好地适应和调整”,代表了一种动态的、可变的能力,这是一种学习、进化以应对新挑战的能力。

当然可以也可以和分篇(一)中“开放式、互动式环境的特性,及静态LLMs的相应瓶颈”一起理解:https://blog.csdn.net/2302_77292227/article/details/151613961?spm=1001.2014.3001.5501

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

02 ...from scaling up static models to developing self-evolving agents... ,

This shift is currently driving us toward a promising and transformative path to Artificial Super Intelligence (ASI) , where the agents not only can learn and evolve from experience with an unpredictable speed but also perform at or above human-level intelligence across a wide array of tasks .

【译】当前这一转变正推动我们走向一条充满希望且具有变革性的路径,即人工超级智能(ASI)。在这样的系统中,agent不仅能够以不可预测的速度从经验中学习和进化,而且能够在广泛的任务范围内以或超过人类水平的智能表现。

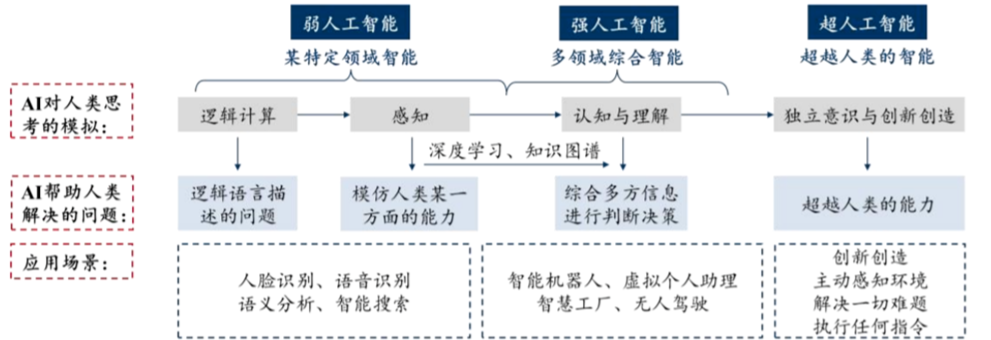

【讲解】这里主要是关注到了,针对“人工超级智能Artificial Super Intelligence (ASI) ”的定义,at or above human-level intelligence,但目前ASI 仍处于理论阶段,实现 ASI 的关键在于通用人工智能 (AGI) 的发展,当前大多数人工智能属于狭义人工智能 (ANI) 。

-

狭义人工智能 (Artificial Narrow Intelligence, ANI):称为“弱人工智能”,专注于且只能高效完成特定任务的人工智能,无法将知识迁移到未经训练的其他领域。人脸识别系统、语音助手、围棋程序AlphaGo、推荐算法、垃圾邮件过滤器等。当前所有已投入应用的AI,包括最先进的大语言模型(如ChatGPT),都属于ANI范畴。

-

通用人工智能 (Artificial General Intelligence, AGI):称为“强人工智能”,指具备与人类同等水平通用智能的AI。它能够理解、学习和应用其智力来解决任何复杂问题,而非仅限于特定任务。尚未实现,是全球AI研究的核心目标和关键瓶颈。

-

人工超级智能(Artificial Super Intelligence, ASI):指在几乎所有认知领域都远远超过最聪明人类大脑的智能水平。一个ASI将能够自主地改进自身的架构和算法,其智能水平可能会以无法预测的速度无限增长,迅速脱离人类的可控范围。完全处于理论和哲学探讨阶段。

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

03 Unlike static LLMs, which remain constrained by their inability to adapt to novel and evolving contexts, self-evolving agents are designed to overcome these limitations by continuously learning from real-world feedback.

【译】与静态大型语言模型不同,后者因其无法适应新颖和不断演变的上下文而受到限制,自进化agent 被设计为通过持续从现实世界反馈中学习来克服这些限制。

【讲解】自进化agent 从现实世界反馈中学习、进化。

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

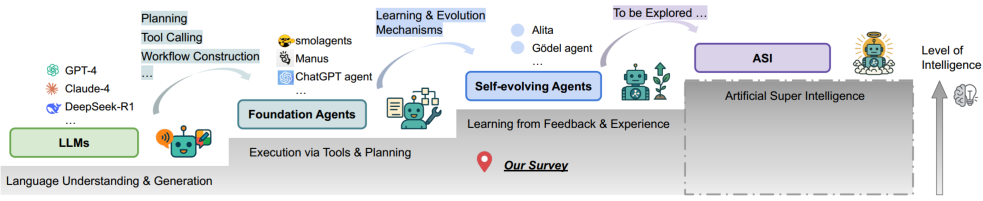

04 Self-evolving agents, as a core concept, will be the precursors to ASI, acting as intermediaries that pave the way for the ultimate evolution of intelligence, as shown in Figure 1.

【译】自我进化的 agent 作为一个核心概念,将是人工通用智能(ASI)的前身,作为中介铺平了通往智力最终演化的道路,如下图所示。

【讲解】通往ASI的技术路径。

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

05 What aspects of an agent should evolve? When should adaptation occur? And how should that evolution be implemented in practice?

【译】一个 agent 的哪些方面应该进化?应该在何时适应?以及这种进化应该如何在实际中实施?

【讲解】这是本篇综述survey探讨的核心问题。

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

接下来,这里讲了全文的组织框架,Section 1是引入Introduction,Section 2是定义和基础Definitions and Foundations,以及第3/4/5/6/7/8章节的内容概括。

6.1 Section 3 内容概括:

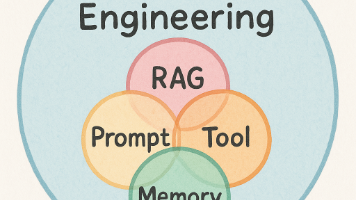

Specifically, we systematically examine individual agent components, including the model, memory, tools and corresponding workflow, investigating their distinct evolutionary mechanisms (what to evolve of agent in Section 3);

【译】具体来说,我们系统地检查了各个 agent 组件,包括模型、记忆、工具以及相应的工作流程,探讨了它们独特的进化机制(第3节中 agent 应进化什么)。

【讲解】模型、记忆、工具以及相应的工作流程,分别怎么理解

-

Model(模型):是一个经过大量数据训练得到的、具有特定能力的参数化函数。通常扮演着核心推理引擎(Reasoning Engine) 。 同一个架构Architectures(例如ReAct)可以使用不同的模型作为其引擎。比如,你可以用GPT-4、Claude 3或Gemini 1.5来驱动同一个ReAct架构,但性能会有显著差异。

-

Memory(记忆):一个存储和检索信息的系统,通常分为缓存当前的对话上下文的短期记忆(Short-term Memory)和保存着过去的对话、学到的知识、执行结果等的长期记忆(Long-term Memory)。

-

Tools(工具):智能体的“手脚”,智能体赖以与外部世界(数字世界或物理世界)交互的函数和API,使其能执行超越文本生成的操作,如操作软件、发送邮件、控制智能家居、调用搜索引擎获取实时信息等

-

Corresponding Workflow(相应的工作流):定义了模型、记忆和工具如何协同工作的固定流程,经典的工作流包括:

-

ReAct(Reason + Act):

思考 -> 执行工具 -> 观察结果 -> 继续思考... -

Reflection:

尝试解决问题 -> 检查结果 -> 如有错误则进行反思 -> 生成新的解决方案

-

关于工作流也可以参考这篇文章

智能体(Agent)与工作流(Workflow)_智能体工作流-CSDN博客 https://blog.csdn.net/weixin_58811620/article/details/143617084

https://blog.csdn.net/weixin_58811620/article/details/143617084

6.2 Section 4 内容概括:

then we divide existing evolving methods according to different temporal stages with different learning paradigms such as supervised fine-tuning, reinforcement learning and inference-time evolving (when to evolve in Section 4).

【译】然后我们根据不同的时间阶段和不同的学习范式(如监督微调、强化学习和推理时进化)对现有的进化方法进行划分,例如在第4节中何时进行进化。

【讲解】监督微调、强化学习和推理时进化,简要理解

-

监督微调 (Supervised Fine-Tuning, SFT):通常在模型初始训练之后、部署之前进行。模型通过最小化其预测和真实值之间的差异来调整其内部参数,让一个通用的基础模型(Foundation Model)专门化于某个特定领域。

-

强化学习 (Reinforcement Learning, RL):智能体通过尝试各种动作来探索环境,好的动作会获得正奖励,坏的动作会获得负奖励(惩罚),从而学习出一套能最大化累积奖励的策略。

-

推理时进化 (Inference-Time Evolving):在模型应用阶段实现的适应方法,不改变其原始参数,通过动态地构建和利用上下文信息(如对话历史、实时检索到的文档、系统指令等)来改变模型的行为和输出,从而实现实时适应。

例如,在多轮对话中,系统会将历史对话记录作为上下文提供给模型,使其能“记住”用户刚才提供的信息并做出连贯回应。这种方法优点是成本低、见效快且安全,但其适应能力受限于上下文窗口的长度,且无法让模型永久性地掌握新知识。

6.3 Section 5 内容概括:

We finally summarize different signals to guide the evolution of agents, such as textual feedback or scalar rewards, and also different architectures of agents to evolve, such as single-agent and multi-agent evolution (how to evolve in Section 5).

【译】我们最终总结了指导代理演化的不同信号,例如文本反馈或标量奖励,以及代理架构的不同演化方式,例如单一智能体和多智能体演化(在第五节中如何进化)。

【讲解】

-

标量奖励 (Scalar Rewards):提供一个简单的数字分数来评价智能体行为的好坏。这个数字代表了在某个目标上的达成度。主要用于强化学习(RL) 框架,智能体通过不断尝试,目标就是最大化这个累积奖励的总和。它非常适合目标明确、可以量化的任务。

-

文本反馈 (Textual Feedback):提供一段自然的语言文本来解释智能体行为的优缺点,并提出改进建议,需要先将这些文本反馈转化成计算机可以处理的形式。用于让模型的行为更符合人类复杂的、难以量化的偏好和价值观。它是从人类反馈中进行强化学习(RLHF) 的关键组成部分。

6.4 Section 6 内容概括:

Furthermore, we review certain evaluation metrics and benchmarks to track existing advancements of self-evolving agents, emphasizing the importance of co-evolution between evaluation and agents (Section 6).

【译】此外,我们回顾了一些评估指标和基准,以追踪自进化agent的现有进展,强调评估与agent之间共同进化的重要性(第6节)。

6.5 Section 7 内容概括:

We also examine emerging applications in domains such as coding, education, and healthcare, where continual adaptation and evolution are essential (Section 7).

【译】我们也探讨了在编码、教育和医疗等领域中新兴应用的情况,这些领域中持续适应和演变至关重要(第7节)。

6.6 Section 8 内容概括:

Finally, we identify persistent challenges and outline promising research directions to guide the development of self-evolving agents (Section 8).

【译】最终,我们确定了持续的挑战,概述了有前景的研究方向,以指导自进化代理的发展(第8节)。

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

引入Introduction结尾部分,作者对《A SURVEY OF SELF-EVOLVING AGENTS: ON PATH TOARTIFICIAL SUPER INTELLIGENCE》的贡献做出总结:(上文也有提到)

1. 我们建立了一个统一的理论框架,用于描述agent系统中的自我进化过程,该框架围绕三个基本维度构建:什么在进化,如何进化,以及何时进化,为未来自我进化的agent系统提供了清晰的设计指导。

2. 我们进一步调查了为自我进化agent量身定制的评估基准或环境,突出了与适应性、鲁棒性和现实世界复杂性相关的新兴指标和挑战。

3. 我们展示了几个关键的实际应用领域,包括自主软件工程、个性化教育、医疗保健和智能虚拟辅助,以说明自我进化的代理的实际潜力.

4. 我们确定了关键的开放性挑战和有前景的未来研究方向,强调了安全性、个性化、多智能体共同进化以及可扩展性等方面。

07 As LLM-based agents are increasingly integrated into mission-critical applications, understanding their evolutionary dynamics becomes essential, extending beyond academic research to encompass industrial applications, regulatory considerations, and broader societal implications.

【译】随着 基于大语言模型的智能体 越来越多地集成到关键任务应用中,理解它们的进化动态变得至关重要,这不仅扩展到学术研究之外,包括工业应用、监管考虑以及更广泛的社会影响。

【讲解】理解 LLM-based Agents(基于大语言模型的智能体)被集成到“关键任务应用”中这一现实背景

LLM-based Agents(基于大语言模型的智能体)不再只是一个对话式的语言模型,它是一个能够自主理解目标、制定计划、执行动作、并完成复杂任务的AI系统,可以理解成是由LLM作为“大脑”的有“四肢”的虚拟机器人。

LLM和早期的Agent主要被用于研究、演示、娱乐和一般性辅助任务(如写诗、总结文章、编代码),但近来越来越多地被被嵌入到现有的、关键的业务流程和软件系统中,一旦失效或出错就会导致严重业务中断、巨大经济损失、甚至危及生命安全。

正是因为被用在了“关键任务”中,所以我们必须去透彻地理解这些AI智能体,这种“理解”超越了传统的模型性能指标(如准确率、F1分数),而是要求我们洞悉其进化动态,确保它始终安全、可靠、可控且符合我们的价值观。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)