上下文工程进阶指南:万字详解 Context Processing 的核心机制与实战技巧(建议收藏)

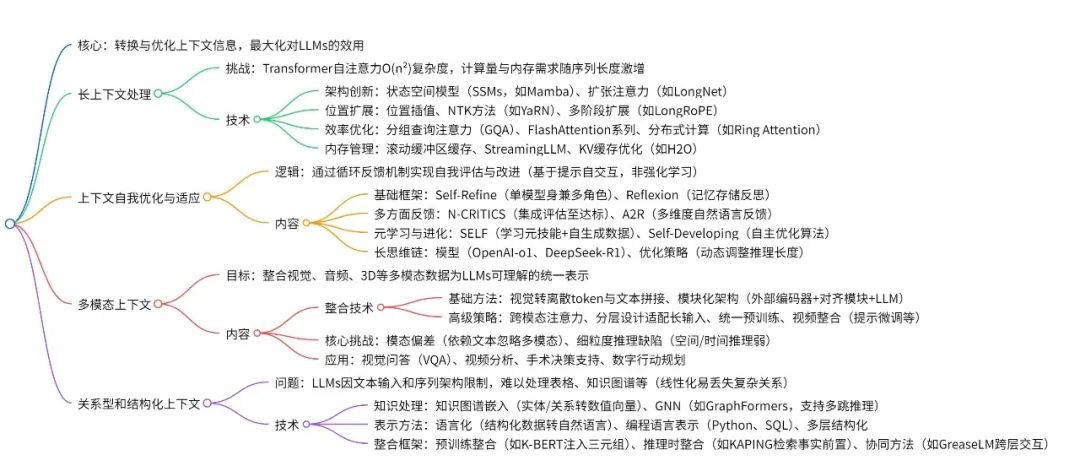

本文详细介绍了上下文工程的第二大基础组件——"上下文处理",探讨了其解决长上下文、多模态、关系型与结构化数据整合等问题的技术方法。从架构创新、位置插值、优化技术到自我适应机制,全面剖析了如何转换优化上下文信息以最大化大模型性能。文章为AI学习者提供了理解大模型如何高效处理复杂上下文的技术地图,是初学者入门大模型的重要参考资料。

01. 上下文处理(Context Processing)的概念

“上下文处理(Context Processing)”,我在前面的文章里面曾经把这个阶段比喻成为“精加工”——就是把第一阶段捞取到的“相关”信息再做进一步的整理,让大模型能够在有限的上下文窗口和算力约束下极致利用信息。用原文的话来说就是:

“Context Processing focuses on transforming and optimizing acquired contextual information to maximize its utility for LLMs.

(‘上下文处理’专注于转换和优化已经获得的上下文信息,以最大化大语言模型在各种任务中的表现。)”

02. 上下文处理(Context Processing)在解决什么问题?

“上下文处理(Context Processing)”是提示词工程的第二大基础组件,仔细读完发现其实它也是在解决前一个章节已经提到的几个典型问题,让我自己来总结就是:

- “长”上下文怎么办?

- “多模态”上下文怎么办?

- “关系型和结构化”上下文怎么办?

- 在处理各种各样的上下文的同时,要怎么去搭建一个“自优化与自适应”的机制?

“长”上下文计算复杂度高,计算复杂度高会导致占用内容空间大或者是计算使用的时间比较长。

所以学者们首先使用了各种架构创新来把O(N^2)的复杂度降低;在此基础之上,还研究内存管理与上下文压缩技术,让“长”上下文的处理占用的内存空间受到管理;研究高效处理的优化技术,让“长”上下文的计算效率提高。

由于“上下文窗口”有限,想要处理更“长”的上下文,学者们也在研究突破上下文窗口的位置插值和上下文扩展技术。

“多模态”上下文首先需要做的是怎么把不同模态的信息融合在一起。

经典的解决方案是利用一些外部多模态编码器CLIP、CLAP、VPGs把多模态信息映射到LLMs可理解的空间,然后使用一些对齐模块如Q-Former让LLMs把各种模态的数据一起处理。

进阶的解决方案是直接在预训练阶段就联合多模态数据进行训练,我(个人)理解为更加“端到端”的训练,产生更加深度的融合与理解?

多模态需要解决一些现行算法带来的局限,比如模态偏见问题。同时如何融合多模态信息进行“上下文学习(In-Context Learning)”与“长上下文学习(Long Context Learning)”也是未来研究的方向。

“关系型和结构型”上下文特指一些知识图谱、数据库信息,这些信息跟文本不是一种逻辑,所以也需要一些特殊的处理机制。

基础是先把知识图谱、数据库等信息变成LLMs好理解的版本,涉及语言化(Verbalization)、编程语言表示、文本分层重组等等技术。

然后要把这些“关系型和结构型信息”和“文本信息”整合起来。

有的整合发生在预训练阶段,如K-BERT,在训练的时候就加入知识图谱的数据。

有的整合发生在推理阶段,可以使用检索的方法(如KAPING),或者更加计算密集型的办法——适配器模块(Adapter Modules)+交叉注意力机制(Cross-Attention Mechanisms)+ Text2Graph Mappers。

还有一种整合办法是“数据+知识”一起用,实现双向推理,比如GreaseLM、QA-GNN。

那么在了解完各种类型的上下文处理方法之后,要怎么搭建一个上下文自优化和自适应的机制呢?

首先有一些**基础自我优化框架(Foundational Self-Refinement Frameworks),**涉及到让单个大模型自己进行生产、监督、反思;让多个大模型各司其职进行合作;或者引入一些显式的、详细的专业评价标准。

更加抽象的办法,不是让大模型依据你给的评价体系来进行迭代,而是让大模型自己拥有**元学习与自主进化(Meta-Learning and Autonomous Evolution)**的能力。所谓元技能,是指模型在完成具体任务之外的一些高层次能力,是主导完成具体任务的那些能力。

所以这里学者们提出的框架让模型可以自己推理、创建自己需要的工具,自己优化自己的算法(什么左脚踩右脚上天的科幻剧情)。

除此之外,还需要给模型装配外部知识、记忆和自适应能力,研究了记忆增强适应框架(Memory-Augmented Adaptation Frameworks)。

然后就发展让模型能够更长的推理和更加高效的推理能力,涉及长思维链与高级推理(Long Chain-of-Thought and Advanced Reasoning)的内容。

以上就是我个人的总结,接下来是对原文内容的一些更细节的理解,按照原文对于上下文处理这章节的分段来叙述,不想看二手信息的朋友建议直接读原文。

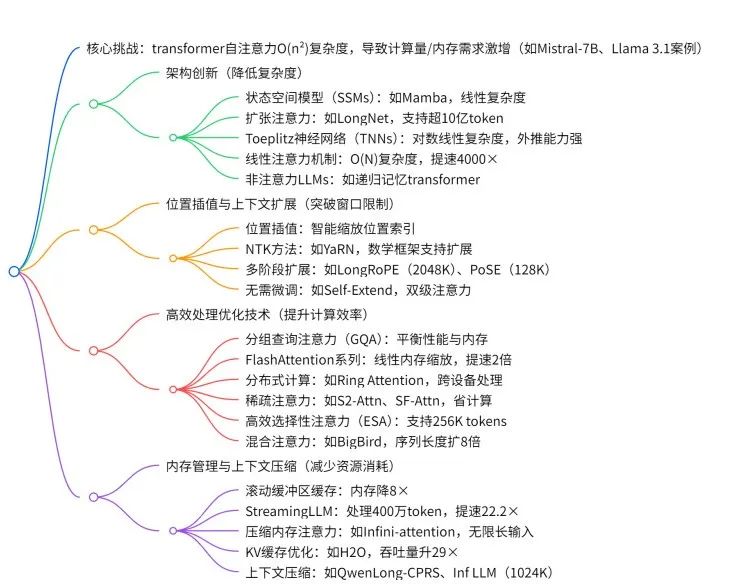

03. 长上下文处理(Long Context Processing)

基于Transformer自注意力机制的大模型,“计算复杂度”随输入序列长度平方级增长,并且在“占用的内存空间”会非常大,属于是典型用空间换时间的架构了。

将Mistral-7B的输入从4K增加到128K个token需要122倍的计算量增长,Llama 3.1 8B在处理128K-token请求时需要高达16GB的内存。

为了处理计算复杂度和内存占用的问题,学者们从以下几个方面来进行研究:

- 长上下文处理的架构创新(Architectural Innovations for Long Context)

- 位置插值与上下文扩展(Position Interpolation and Context Extension)

- 实现高效处理的优化技术(Optimization Techniques for Efficient Processing)

- 内存管理和上下文压缩(Memory Management and Context Compression)

长上下文处理的架构创新(Architectural Innovations for Long Context)

为了解决上面说的计算复杂度的问题,学者们从架构上进行了创新。

**状态空间模型(State Space Models,SSMs):**是一类用一阶微分或差分方程组描述动态系统的数学框架。通过固定大小的隐藏状态,让计算复杂度保持线性,内存需求保持恒定。用Kimi告诉我的比喻来说:

“”"

传统 Transformer 像“每到一个路口就把整条街地图展开重看”,地图越长,看得越慢;

SSM 则像“只翻最新一页笔记,再瞄一眼上一页”,翻页速度跟街道长度几乎无关,所以长路也不累。

“”"

**Mamba:**一种选择性的状态空间模型,用线性复杂度O(N)的循环结构取代 Transformer 的二次复杂度 O(N^2) 的自注意力机制。同时引入“选择机制(selective mechanism)”,让模型可以根据输入内容动态决定保留或遗忘信息。

同样给一个Kimi的比喻:

“”"

把阅读长文档比作 “拆快递”:

Transformer 像一位强迫症分拣员:每来一个新包裹(token),都要把之前 所有包裹再翻一遍 才能决定放哪,包裹越多,耗时呈平方暴涨。

Mamba 则像一位 边走边记笔记的快递员:他只带一张便签(固定大小的状态),每拆一个包裹就在便签上更新关键信息——该留的留,该扔的扔。包裹再多,也只需线性时间,而且便签大小不变,口袋就能装下。

“”“”

LongNet: 核心创新是Dilated Attention(扩张注意力),指对第 i 个token,只与其“指数级间隔”的邻居做注意力,使得任意两 token之间的依赖路径长度被压缩到 log(L)级别,而计算量仅随L线性增长。

Toeplitz Neural Networks (TNNs):TNNs 的核心思想是用 Toeplitz 矩阵(一种每条主对角线上的元素都相等的矩阵)替换全连接层或卷积核矩阵,通过循环位移参数化将权重降至 O(n) 级(因为 Toeplitz 矩阵的有规律的元素性质可以省下一些参数不必估计),显著减少参数量与内存。

线性注意力机制(Linear attention mechanisms): 通过引入核函数映射或调整计算顺序,将注意力权重的计算转化为线性运算,从而将复杂度降至O(N)。

核函数的核心价值是在 “压缩信息” 和 “保留关键关联” 之间找到平衡:它通过映射把高维、复杂的原始数据转化为低维、易计算的特征,让注意力机制既能避开 O(N^2) 的计算爆炸,又能准确捕捉重要的关联信息(如语义相似性、图像局部相关性)。

除此之外论文还提及了非注意力机制的大语言模型(non-attention LLMs),TA 们尝试通过其他方式来建模上下文信息或捕捉序列中的长程依赖。

位置插值与上下文扩展(Position Interpolation and Context Extension)

位置插值(Position interpolation)是一种通过调整位置索引来适应更长序列的技术,它避免了直接外推到未见过的位置,从而提高了模型对长序列的处理能力。论文中提到了两种位置插值的技术:

神经切线核方法(Neural Tangent Kernel,NTK): 其核心思想是将神经网络视为“无限宽的极限情况”,此时网络的行为可通过核函数来描述,从而将复杂的非线性训练过程转化为线性代数问题。

传统神经网络的训练像 “黑箱”,难以预测参数如何变化。NTK 则像 “水晶球”,通过分析初始化时的网络结构,就能预测训练过程中哪些特征会被优先学习。例如,在图像分类任务中,NTK 能提前告诉我们:“网络会先学会识别物体的大致轮廓(低频特征),再逐步细化纹理细节(高频特征)”

YaRN: 将 NTK 插值与线性插值以及注意力分布校正相结合,使模型能够处理远超训练时的序列长度(如从 16K 扩展至 100K tokens),同时保持计算效率和语义准确性。

上下文扩展(Context Extension)的目标是让模型能够理解和生成超过其原始设计限制的更长文本序列,从而提升在长文档处理、多轮对话等任务中的性能。

LongRoPE: 采用了一种两阶段的方法——先对模型进行微调以适应较短的上下文长度(256K标记),然后再通过位置插值技术逐步扩展到更长的上下文(2048K标记)。这种方法的优点在于它在一定程度上平衡了计算资源的需求与性能优化之间的关系。

PoSE: 则通过结合多种位置插值策略,显著提升了模型在处理超长序列(最长可达128K标记)时的能力。相比LongRoPE,PoSE的关注点更多地集中在如何优化插值技术本身,以实现更高效率的序列扩展。

Self-Extend: 提供了一种无需微调即可处理长上下文的技术方案。它通过引入分组注意力(grouped attention)和邻近注意力(neighbor attention)两种策略,使得模型可以在不增加额外训练成本的情况下,有效地捕捉远距离和相邻标记之间的依赖关系。这种技术特别适合于需要动态调整上下文长度的应用场景。

实现高效处理的优化技术(Optimization Techniques for Efficient Processing)

(感觉是各种改注意力机制的合集)

Grouped-Query Attention (GQA) : 核心思想是将查询头分组,并让这些组共享键和值头,从而在计算效率和模型表现之间找到一个折中点。这种方法相较于传统的多头注意力(multi-head attention),能够在一定程度上降低内存需求,尤其是在解码阶段,这使得其更适用于需要高效处理长序列的任务。

FlashAttention: 专注于硬件层面的优化,充分利用 GPU 内存架构的特点,将内存需求从二次方扩展降低为线性扩展,显著提升了运行效率。FlashAttention-2进一步优化了这一机制,通过减少非矩阵乘法操作以及优化任务分配,使速度提升至原来的两倍左右。这种优化不仅提高了计算效率,还减少了对硬件资源的需求,具有较高的实际应用价值。

分块环形注意力(Ring Attention with Blockwise Transformers) : 一种通过分块计算和跨设备分布计算来优化注意力机制的技术。它通过将长序列分成小块并利用环形结构进行计算,解决了传统 Transformer 在处理长序列时的内存和计算瓶颈问题。

稀疏注意力(Sparse Attention): 一种优化注意力机制的技术,通过减少参与计算的注意力矩阵元素数量来降低计算复杂度。稀疏注意力技术包括 LongLoRA 中的 Shifted sparse attention (S2-Attn) 和 SinkLoRA 中的 SF-Attn,都是通过精心设计的稀疏模式来捕捉全局信息,同时减少了计算量。

内存管理和上下文压缩(Memory Management and Context Compression)

(内存管理策略:感觉是计算机科学的内存管理机制一种迁移,涉及什么buffer啦,cache啦…)

滚动缓冲区缓存(Rolling Buffer Cache): 通过限制注意力机制的范围来减少内存占用。

StreamingLLM : 引入了 “滑动窗口注意力”(Sliding Window Attention) 和 “锚点 token 保留”(Anchor Token Retention) 机制。

滑动窗口注意力:模型仅对最近的一段文本(窗口内的 token)进行精细的注意力计算,减少实时处理的计算量。

锚点 token 保留:在滑动窗口外,保留少量关键 token(如对话主题词、文档核心概念等 “锚点”),避免因窗口滑动丢失对全局上下文的理解。

Infini-attention: 核心思想是将压缩记忆(compressive memory)与传统的注意力机制(vanilla attention)结合。将历史序列的关键信息(如 token 的 key-value 对)压缩为固定大小的记忆向量,避免内存占用随序列长度线性增长。对压缩记忆进行线性计算,替代传统注意力的二次复杂度操作。

Heavy Hitter Oracle (H2O): 专注于优化 Transformer 模型中的 KV 缓存管理。它提出了一种基于观察的缓存淘汰策略(KV cache eviction policies),即模型中少量 token 对注意力值的贡献最大。通过对这些关键 token 的优先保留,H2O 不仅显著提升了吞吐量(最高达 29 倍),还大幅减少了延迟(最高减少 1.9 倍)。

QwenLong-CPRS: 实现了动态上下文优化机制,能够根据自然语言指令进行多粒度压缩。多粒度压缩是指在不同层次或粒度上对上下文信息进行压缩的技术。这种方法允许模型根据任务需求选择合适的压缩级别,从而在计算效率和信息保留之间取得平衡。

Inf LLM: 将远距离上下文存储在额外的内存单元中,并通过高效的检索机制来支持注意力计算。使得在几千个token序列上预训练的模型能够有效地处理长达 1024K token的序列。

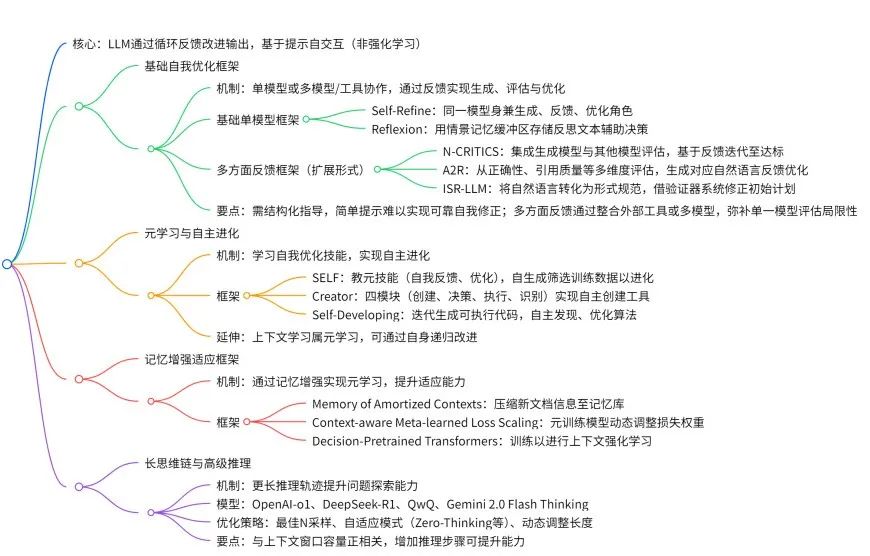

04. 上下文自我优化与适应(Contextual Self-Refinement and Adaptation)

通过模拟人类修订过程的循环反馈机制改进输出,依赖提示工程实现的对话式自我交互进行自我评价。原文从5个维度系统阐述了上下文自我优化与适应的具体机制和框架:

- 基础自我优化框架:单模型或多模型/工具协作,通过反馈实现生成、评估与优化;

- 元学习与自主进化:LLM学习自我优化技能,实现自主进化;

- 记忆增强适应框架:通过记忆增强实现元学习,提升适应能力;

- 长思维链与高级推理:更长推理轨迹提升探索能力,优化策略平衡质量与效率;

基础自我优化框架(Foundational Self-Refinement Frameworks):

Self-Refine框架: 使用相同的模型作为生成器、反馈提供者和优化器,研究表明“识别和修复错误”通常比”生成完美的初始解决方案”更容易。

Reflexion框架: 通过语言反馈形成反思文本,并将这些文本存储在情景记忆缓冲区中,以便为未来的决策提供参考。这种机制的关键点在于它利用了“反思”的概念,通过累积经验来提升模型的长期性能,而不是仅仅依赖于即时的输入输出交互。此外,文中提到,单纯的简单提示(simplistic prompting)不足以支持可靠的自我修正,进一步凸显了结构化指导的重要性。

多方面反馈(Multi-Aspect Feedback): 通过整合“冻结的语言模型”(即固定参数的预训练模型)以及外部工具来处理特定类型的错误类别(例如语法、逻辑一致性等)。这种设计使得评估更加全面,并且能够独立完成,而不需要依赖人工干预。这种方法的核心优势在于它的针对性和模块化,可以有效识别问题并提供改进建议。

N-CRITICS 框架: 采用了基于集成学习的评估方式。其工作流程是首先生成初始输出,然后由多个模型(包括生成型大语言模型和其他专门模型)对这些输出进行评估。评估结果被汇总为反馈信息,用来指导后续的优化过程。这个过程会持续迭代,直到达到某种任务特定的停止条件(例如,输出的质量达到某个阈值或满足某些性能指标)。该框架的优势在于其动态性和适应性,能够通过多模型协作逐步提升输出质量。

A2R框架 : 其特点在于采用显式评估(explicit evaluation),即在多个维度上对模型输出进行细致分析,比如正确性(correctness)和引用质量(citation quality)。对于每个评估维度,系统会生成自然语言形式的反馈(natural language feedback),并利用这些反馈不断优化输出结果。这种方法强调了对输出的全面评估和持续改进。

ISR-LLM方法 : 该方法专注于改进基于LLM的规划能力。它通过将自然语言输入转化为“形式化规范(formal specifications)”来实现这一目标。

所谓形式化规范是指一种用数学化语言(如 PDDL、时态逻辑)精确描述系统行为的方法,在 ISR-LLM 中起到语义锚点作用。

具体过程包括三个主要步骤:首先生成初始计划(initial plan),然后通过一个验证器(validator)对其进行评判,然后对其进行系统化的优化(systematic refinement)。这种方法的优势在于将自然语言的灵活性与形式化规范的精确性结合起来,从而提高规划的质量和可靠性。

元学习与自主进化(Meta-Learning and Autonomous Evolution)

SELF(Self-Evolution Framework,自我进化框架):SELF是一种旨在提升LLMs自主学习和进化能力的框架。该框架通过有限示例教授模型元技能(Meta-skills),并通过自我生成和筛选训练数据的方式实现自我进化。

所谓元技能,是指模型在完成具体任务之外的一些高层次能力,例如自我反馈(self-feedback)和自我优化(self-refinement)。这些技能使模型能够在没有外部指导的情况下,主动识别问题、调整策略并提高性能。

The CREATOR 框架: 核心是通过 “工具创建” 解耦抽象推理与具体执行,使模型能自主设计、生成和调用定制化工具,提升复杂任务处理能力。这标志着LLMs从被动接受任务到主动参与任务设计的重要转变。

Self-Developing框架(Self-Developing framework): 代表了一种“最自主”的方法,它使LLMs能够通过闭环迭代过程自主发现、实现并优化用于提升自身的“算法”。

其核心机制包括:算法生成:模型通过上下文学习和代码合成生成候选算法(如 Python 脚本);效果评估:在模拟环境或真实任务中测试每个算法,自动跟踪性能指标(如准确率、效率);强化学习优化:使用直接偏好优化(DPO)递归增强算法设计,优先选择能最大化自我提升收益的策略;泛化验证:框架包含 “跨域验证模块”,确保发现的算法在未见过的任务中依然有效(如将数学推理算法迁移到代码调试)。

上下文学习(In-context learning) 从根本上代表了一种元学习(meta-learning) 形式,模型在预训练过程中学习优化策略,这些策略能够泛化到多种任务中,从而在推理阶段快速适应新的挑战 。

元上下文学习(Meta-in-context learning) 表明,上下文学习“能力”可以通过“上下文学习本身”递归地改进,自适应地重塑模型对预期任务的先验知识,并调整上下文学习策略。

记忆增强适应框架(Memory-Augmented Adaptation Frameworks)

记忆增强指通过附加的记忆模块或机制扩展模型的能力,使其能够存储和利用先前学习到的信息,从而提高模型在新任务上的表现。

MoAC(Memory of Amortized Contexts,摊销上下文记忆) :MoAC是一种具体实现记忆增强的框架,其核心思想是通过特征提取和信息压缩将上下文信息存储在记忆库中。

上下文感知的元学习损失缩放(Context-aware Meta-learned Loss Scaling): 该框架通过动态调整语言模型在实时数据上的损失函数权重,实现高效的在线适应。

其核心机制包括:元学习初始化:预训练一个小型自回归模型,学习如何根据输入上下文生成动态的损失缩放因子;动态损失加权:在线微调过程中,模型为每个 token 分配个性化的损失权重,突出关键信息(如事实性内容)并抑制噪声;梯度信号优化:通过单次加权梯度更新,最大化模型对新文档的信息吸收能力,避免传统微调中梯度被噪声淹没的问题。

决策预训练 Transformer(Decision-Pretrained Transformers): 一种经过预训练的 Transformer 模型,专门用于强化学习任务。它通过预训练学习上下文信息,从而能够在面对未见过的强化学习问题时进行泛化。这种方法的优势在于能够减少对大量标注数据的依赖,同时提高模型的适应性和灵活性。

基于上下文的元强化学习(Context-based Meta-Reinforcement Learning): 核心是通过学习任务上下文变量(Context Variable)来实现智能体对新任务的快速适应。

具体而言:智能体在与环境交互过程中,会动态提取和更新一个 “上下文向量”,该向量编码了当前任务的关键特征(如环境规则、目标函数、奖励机制等),并基于此向量快速调整策略,以适应新任务。简言之,基于上下文的元强化学习让 AI 从“逐个学任务”升级为“学一类任务的规律”,特别适合需要快速适应多变环境的场景。

长思维链与高级推理(Long Chain-of-Thought and Advanced Reasoning)

长思维链(Long Chain-of-Thought,简称LongCoT) 特征是显著更长的推理轨迹,能够实现对问题的深入探索。这一特性已在包括OpenAI-o1、DeepSeek-R1、QwQ和Gemini 2.0 Flash Thinking在内的先进模型中得以实现。LongCoT的有效性似乎与上下文窗口容量相关,实证研究表明更大的上下文窗口通常会导致更强的推理性能。

扩展推理(Extended reasoning)能使模型在问题解决过程中具备自我反思和纠错机制,即通过增加推理步骤的长度(如分步拆解问题、逐步推导),模型可以识别并修正自身的错误。即使不引入新的信息,仅通过在测试阶段增加推理步骤的长度(即测试时缩放,test-time scaling),也能显著提升模型在多个数据集上的推理能力。

冗长推理路径会导致的计算效率低下,对应的优化策略包括:通过best-of-N 采样生成更短的自优化推理路径;采用自适应推理模式(如“零思考”Zero-Thinking 和“少思考”Less-Thinking);显式的紧凑思维链(compact CoT) 方法;自动长短推理(Auto Long-Short Reasoning),能根据问题复杂度动态调整推理路径长度(简单问题用短链,复杂问题用长链)。

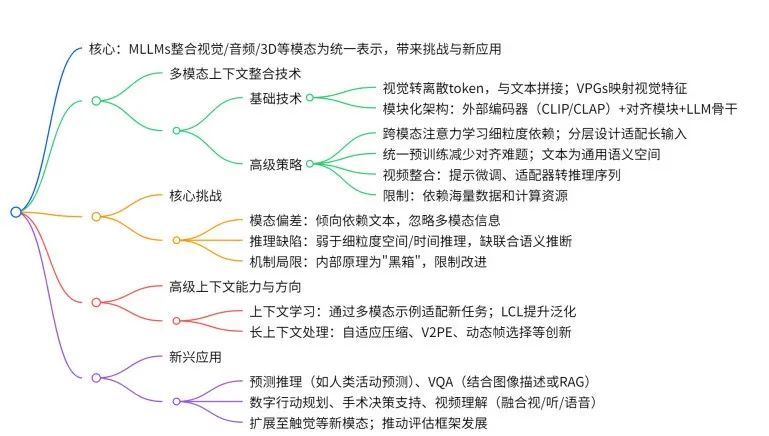

05. 多模态上下文(Multimodal Context)

多模态大型语言模型(MLLMs)通过将包括视觉、音频和3D环境在内的多种数据模态整合到统一的上下文表示中,从而将上下文工程扩展到文本之外。这种扩展在模态融合、跨模态推理和长上下文处理方面引入了新的挑战,同时也使能够利用丰富多模态上下文理解的复杂应用成为可能。

这段内容主要分为以下几个部分:

- 多模态上下文整合技术(Multimodal Context Integration)

- 多模态上下文处理的核心挑战(Core Challenges in Multimodal Context Processing)

- 高级上下文能力与未来方向(Advanced Contextual Capabilities and Future Directions)

多模态上下文整合技术(Multimodal Context Integration)

*基础技术: *一种主要的整合方法是将视觉输入转换为离散的token,与文本token连接起来,从而在综合表示的基础上调节LLM的生成过程。这一过程通常由视觉提示生成器(VPGs)来辅助实现,这些生成器通过对图像-标题对进行训练,将视觉特征映射到LLM的嵌入空间中。

当前主流的架构范式是通过对齐模块(例如Q-Former或简单的MLP)将专门的外部多模态编码器(如用于视觉的CLIP或用于音频的CLAP)连接到LLM主干上,这种模块化设计允许独立更新编码器而无需重新训练整个模型。

VPGs(Visual Prompt Generators,视觉提示生成器): VPGs是一种专门用于将视觉数据映射到LLM嵌入空间的技术。它们通过对图像-标题对进行训练,将视觉特征转化为LLM可以理解的形式,从而促进多模态信息的融合。

CLIP(Contrastive Language–Image Pre-training,对比语言-图像预训练): CLIP是一种用于视觉处理的编码器,擅长从图像中提取特征,并将其映射到与文本相关的嵌入空间中。在这篇文章中,CLIP被用作多模态MLLM中的视觉编码器。

CLAP(Contrastive Language–Audio Pre-training,对比语言-音频预训练) : CLAP是一种类似于CLIP的编码器,但专门用于处理音频数据。它通过对比学习方法将音频特征映射到语言模型的嵌入空间中。

Q-Former(Querying Transformer,查询Transformer) : 指多模态模型中连接视觉编码器和大型语言模型(LLM)的核心模块,其核心功能是通过可学习的查询向量(learnable queries)提取视觉特征中的语义信息,并将其转化为 LLM 可理解的语言友好型表示。这些查询向量通过交叉注意力机制与视觉特征交互,同时通过自注意力机制整合多模态信息,最终作为 “软提示” 引导 LLM 完成跨模态任务(如图像描述、视觉问答)。

MLP(Multilayer Perceptron,多层感知机) : MLP是一种简单的神经网络架构,常用于实现线性或非线性映射。在本文中,MLP被用作对齐模块的一种选择,用于连接外部多模态编码器和LLM主干。

高级技术:

Cross-modal Attention Mechanism(跨模态注意力机制): 其核心原理是通过计算不同模态特征之间的相关性,动态分配注意力权重,使模型能够聚焦于跨模态语义关联最紧密的区域或元素。例如,在视觉问答任务中,该机制会引导模型关注图像中与问题文本语义对应的区域(如“图片中的红色物体是什么?”对应的视觉特征),并将这些信息整合到语言模型的推理过程中。

为了处理长输入,“分层设计(Hierarchical Designs)”通过分阶段处理模态以确保可扩展性,而“浏览与聚焦(Browse-and-Concentrate Paradigm)”范式则在LLM摄入前融合多张图像的上下文,克服孤立处理的局限性。

一些研究跳过仅针对文本的LLM适配,选择统一的训练范式,从一开始就联合预训练模型于多模态数据和文本语料库上,以减轻对齐挑战。

其他方法将文本作为通用语义空间,利用LLM的上下文学习来提高跨多种模态组合的泛化能力。

对于视频内容,上下文整合技术范围广泛,从提示调优到基于适配器的方法,将视频内容转化为序列以进行推理。

多模态上下文处理的核心挑战(Core Challenges in Multimodal Context Processing)

在多模态大语言模型(MLLM)开发中的一个主要障碍是模态偏见,即模型倾向于文本输入,通过依赖学习到的语言模式生成看似合理,但实际上缺乏多模态基础的响应,并没有整合视觉或听觉信息。

这一问题因训练方法而加剧,例如:在简单图像字幕任务上训练的视觉提示生成器(VPG)仅学会提取与字幕相关的显著特征,而忽视了对更复杂的指令型任务至关重要的其他视觉细节,这从根本上限制了深度多模态理解能力。

同时由于我们对MLLM内部机制的理解有限;其内部运作很大程度上是一个黑箱,阻碍了更好架构的开发。

因此,MLLM在细粒度空间或时间推理方面经常遇到困难,例如精准的目标定位或理解视频中的详细事件序列,尤其是在像社交媒体这样的复杂领域中,解释文本和图像之间的相互作用以理解虚假信息或讽刺变得更加困难。

高级上下文能力与未来方向(Advanced Contextual Capabilities and Future Directions)

上下文学习(In-Context Learning)& 长上下文学习(Long-Context Learning):

MLLMs(多模态大语言模型)的一项关键能力是上下文学习(In-Context Learning),即模型能够在提示中通过多模态示例适应新任务,而无需更新权重。

**链接上下文学习(LCL)**通过提供带有显式因果关系的演示来增强这种能力,从而改善泛化性能。然而,上下文学习受到固定上下文窗口的限制,因为图像标记会占用大量空间,这限制了多样本学习。性能还对输入顺序敏感,并且每种模态的相对重要性因任务而异。

处理长多模态上下文(Long-Context Learning)仍然是一个主要的研究前沿 。相关创新包括用于视频的自适应分层标记压缩、****可变视觉位置编码(V2PE)、用于对话记忆的专用模块(如 ContextQFormer)以及针对视频的动态、查询感知帧选择。

此外,MLLMs 在长时间交互中表现出新兴的通信效率(指随着交互次数的增加,模型能够更高效地传递信息),这一现象仍在研究中。

可变视觉位置编码(Variable Visual Position Encoding,V2PE) :一种用于优化多模态输入处理的技术,通过动态调整视觉位置编码来提高模型的灵活性和效率。

ContextQFormer:一种专门设计的模块,旨在增强模型在对话场景中的记忆能力,使其能够更好地处理多轮交互任务。

动态、查询感知帧选择(Dynamic, Query-aware Frame Selection) :这是一种针对视频处理的创新技术,通过动态选择与查询相关的帧来减少计算复杂度,同时提高模型的性能。

多模态上下文的新兴应用(Emerging Applications)

处理丰富多模态上下文的能力正在解锁新的应用。

MLLM被用于预测性推理,例如从视觉场景中预测人类活动,并在各种多模态基准测试中展示了令人印象深刻感知与认知能力。

在VQA(视觉问答)中,通过上下文来获得更精确的答案,例如,通过提示MLLM生成图像的描述性文本上下文,或者通过RAG整合外部知识。

其他应用包括基于感官输入规划数字动作,通过记忆增强的上下文理解提升外科决策支持,以及通过将视觉信息与语音和音频线索相结合实现细致的视频理解。

研究人员还扩展了MLLM以适应新兴模态,如触觉信息、事件数据和图结构。这些现实世界用例日益增长的重要性推动了全面评估框架的发展,以评估上下文理解能力。这些进步使得以前仅靠文本模型无法实现的应用成为可能,例如图像描述生成和复杂的多模态推理。

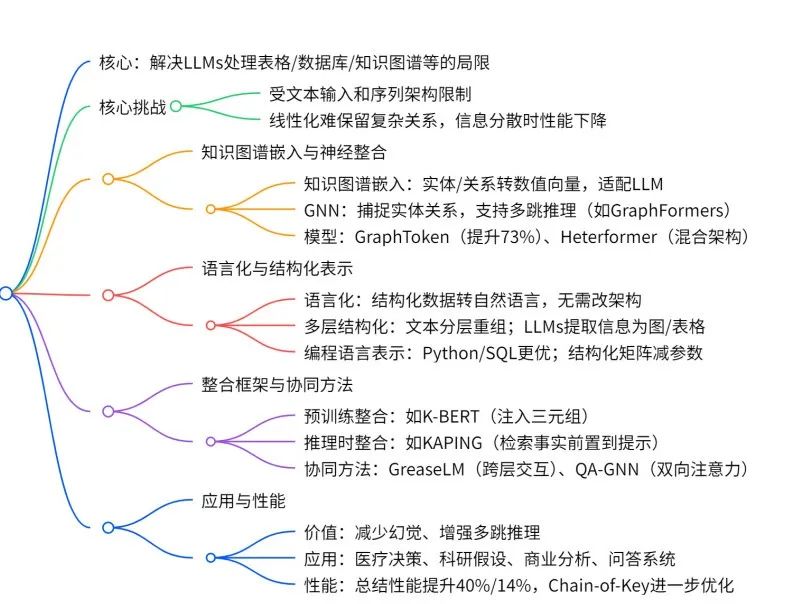

06. 关系型和结构化上下文(Relational and Structured Context)

大型语言模型在处理关系型数据和结构化数据(包括表格、数据库和知识图谱)时,由于基于文本的输入要求和序列架构的限制,面临着根本性的约束。线性化处理往往无法保留复杂的关系和结构属性,当信息分散在上下文中时,性能会下降。为了解决这些问题,文章介绍了以下内容:

- 知识图谱嵌入与神经(网络)集成(Knowledge Graph Embeddings and Neural Integration)

- 语言化与结构化表示(Verbalization and Structured Data Representations)

- 整合框架与协同方法(Integration Frameworks and Synergized Approaches)

- 应用与表现提升(Applications and Performance Enhancement)

知识图谱嵌入与神经(网络)集成(Knowledge Graph Embeddings and Neural Integration)

首先,知识图谱嵌入通过将实体和关系转化为数值向量,使得语言模型能够更高效地处理复杂的结构化数据。这种方法为后续的推理和分析提供了基础支持。

其次,图神经网络(GNN)被引入以捕捉实体之间的复杂关系,并通过专门设计的架构(如 GraphFormers)实现多跳推理。多跳推理是指模型能够在知识图谱中沿着多个节点进行推理,从而挖掘深层次的关系。

此外,GraphToken 的创新在于通过显式表示结构信息来进一步优化模型性能,尤其是在图推理任务中表现卓越。相比之下,Heterformer 等混合架构则聚焦于解决异构数据(即文本和结构化数据)的统一编码问题。这些方法不仅提高了模型的性能,还缓解了计算资源的限制,使模型能够更好地扩展到更大规模的数据集。

语言化与结构化表示(Verbalization and Structured Data Representations)

这段涉及的一些技术在上个章节其实也有提及:

语言化技术(Verbalization):将结构化数据(包括知识图谱三元组、表格行和数据库记录)转换为自然语言句子,从而在不进行架构修改的情况下实现与现有语言系统的无缝集成。

编程语言表示:用Python表示知识图谱,用SQL表示数据库,比传统自然语言表示效果更优。

多层次结构化方法:基于语言学关系将输入文本重新分层处理。

结构化矩阵:通过结构化矩阵表示来减少模型参数的数量,同时确保在处理结构化数据任务时仍能维持较高的性能。这种方法的核心优势在于能够在不显著降低模型性能的前提下优化计算资源的使用,从而提升模型的效率和可扩展性。

整合框架与协同方法(Integration Frameworks and Synergized Approaches)

知识图谱与语言模型的“集成”遵循不同的范式。这种集成分为两种主要范式:一种是在预训练阶段完成的集成(Pre-training Integration),另一种是在推理阶段实现的集成(Inference-time Integration)。

对于预训练集成方法,例如 K-BERT,其核心思想是在语言模型的训练过程中引入知识图谱中的三元组(即主体-关系-客体的形式),从而使模型能够“内化”这些事实性知识。这种方式的优点在于,模型在训练完成后可以直接利用这些知识生成更准确的输出,但缺点是需要在训练阶段就对知识图谱进行处理,并可能增加训练的复杂性。

相比之下,推理时集成方法的特点是灵活性更高,它允许在模型推理阶段动态地访问外部知识图谱,而无需重新训练模型。这种方法的优势在于可以实时获取最新的知识,但可能会因为额外的知识查询步骤导致一定的性能开销。

如何通过知识图谱(KG)增强大型语言模型(LLMs)的能力呢?

这篇文章提出两种方法:一种是较为简单的方式,即通过基于检索的方法(如KAPING),从知识图谱中提取与问题相关的事实信息,并将其直接添加到输入提示中,这种方式无需额外的模型训练。

另一种是更为复杂和技术密集型的方式,即通过适配器模块(Adapter Modules)和交叉注意力机制(Cross-Attention Mechanisms),将知识图谱中的信息嵌入到模型的潜在空间中,同时使用Text2Graph Mappers,让它在输入文本和知识图谱的嵌入空间之间建立联系,进一步增强模型对知识的利用能力。

一些协同方法创建了统一的系统,通过“数据”和“知识驱动”的双向推理。比如:

GreaseLM: 提出将图神经网络(GNN)与预训练语言模型(如 BERT)深度融合,使语言上下文表示能够基于结构化的世界知识进行建模,同时语言细微差别也能反过来影响图表示。

QA-GNN:实现了文本语义与结构化知识的双向动态交互,通过动态子图检索和图神经网络(GNN)消息传递,解决了传统问答系统在事实性、可解释性和结构化推理上的瓶颈。

应用与表现提升(Applications and Performance Enhancement)

结构化数据集成在多个维度上显著增强了LLM(大语言模型)的能力:

知识图谱通过提供结构化信息减少了幻觉现象,将回答基于可验证的事实,并通过明确的信息来源提高事实准确性。

知识图谱通过提供结构化的实体关系,增强了推理能力,使复杂的多跳推理和逻辑推断成为可能,其丰富的分层知识库显著提高了推理的精确性和可靠性。

实际应用表明,在专业领域中也取得了显著进展。

医疗系统通过检索增强生成框架,结合结构化的医学知识与上下文理解,改善了疾病进展建模和临床决策。

科学研究平台将研究发现组织为结构化知识,支持假设生成和研究空白识别,而商业分析系统则平衡基于规则的精确性与AI模式识别,以提供更具操作性的见解。

问答系统从自然语言接口与结构化数据源的结合中受益,这种集成创建了更强大的系统,能够处理多模态查询并提供个性化响应,克服了静态知识库的局限性 。

研究表明,相较于非结构化记忆方法,结构化知识表示可以将公共数据集上的摘要性能提升40%和14%,而动态结构化记忆更新的Chain-of-Key策略进一步提升了性能 。

07. 小结

至此“上下文处理(Context Processing)”的机制就介绍完毕了。在上文中如果有一些描述错误,也欢迎批评指正。

说起来其实读到后面感觉上下文工程的三个基础组件都在解决这几个问题:

- 处理超长上下文;

- 上下文的自我迭代和自适应机制;

- 多模态上下文;

- 关系型(比如知识图谱类的信息)和结构化信息(比如数据库类的信息)的整合和连贯表示。

在我看来,了解AI对于普通人来说不是一个“决定”,而是当技术浪潮来临的时“根本没得选”。

不过好在,我也不是想要成为专家,我就是想要比原来的自己,更加接近“新浪潮”一点。还是那句话,祝愿我们享受learning~

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

更多推荐

已为社区贡献263条内容

已为社区贡献263条内容

所有评论(0)