从1959年到现在,一文读懂AI Agent的发展历史与核心架构,小白也能入门大模型技术!

本文系统梳理了AI Agent从1959年麦卡锡提出"建议接受者"概念至今的发展历程,详细介绍了传统Agent的三种核心架构:审议式BDI架构、反应式包容架构及混合Touring Machine架构。分析了不同架构对智能本质的不同理解,并指出传统架构受限于硬件瓶颈和预编程僵化性,最终推动了学习驱动型AI Agent的发展,为理解现代大模型技术提供了历史脉络。

简介

本文系统梳理了AI Agent从1959年麦卡锡提出"建议接受者"概念至今的发展历程,详细介绍了传统Agent的三种核心架构:审议式BDI架构、反应式包容架构及混合Touring Machine架构。分析了不同架构对智能本质的不同理解,并指出传统架构受限于硬件瓶颈和预编程僵化性,最终推动了学习驱动型AI Agent的发展,为理解现代大模型技术提供了历史脉络。

第1节:AI Agent 的起点

我们今天谈的“AI Agent” 是可以自主感知、理解、计划并执行任务的智能体。但你可能不知道,这个概念的雏形其实很早就出现了,并且一开始就带有一种“类人”特质。

早期的研究者就已经提出,所谓Agent,不是一个被动等待命令的程序,而是一个具备基本主动性和判断力的数字角色。它应该:

自己做决定(自主性)

和其他系统协作沟通(社交能力)

能快速响应环境变化(反应性)

还要有一定的行动计划意识(主动性)

可以说,这套“人格特质”定义了 Agent 的精神内核——不是一个被动的工具,而是一个有目的地“做事”的存在。

不过话说回来,早期Agent 虽然在概念上很“丰满”,现实中却活得很“骨感”。

受限于那个时代的硬件性能,以及必须靠人手逐条预先写死的逻辑规则,这些Agent 的实际表现更像是:

“你提前喂它什么,它就能做什么”;

面对预料之外的情况,它就“宕机”或者“胡乱反应”;

缺乏学习能力,无法真正适应现实的复杂性。

换句话说——那时候的Agent 有意识的“野心”,却没有智能的“器官”。

直到今天,我们才终于看到一代具备语言理解、策略规划、知识学习、工具调用能力的AI Agent 真的出现,并开始走向实用化与普及。

1.1 什么是 Agent?一段起源于 1959 年的人工智能想象

AI Agent 听起来像是某种未来的高科技产品,但它的思想,其实可以追溯到 1959 年。

那一年,人工智能领域的奠基人之一,**约翰·麦卡锡(John McCarthy)****,**提出了一个设想中的系统,叫作“建议接受者(Advice Taker)”。

他设想的不是一个死板执行命令的程序,而是一个能理解建议、推理判断,并采取行动的智能体。它要能够听懂话,理解情境,有常识,还要能自己行动。

你可以把它想象成一个知道自己要干什么、而不是一条条等待命令的助手。

这,就是Agent 概念的起点。

1995 年,《人工智能:一种现代方法》的作者,斯图尔特·罗素与彼得·诺维格**,**给出了更系统的定义:

“能通过传感器感知环境并以执行器作用于环境的任何事物。”

从某种意义上说,这把范围大大拓宽了:只要你能接收环境信息+ 主动做出反应,无论是带有传感器和执行器的移动机器人,还是运行在电脑或网络中的智能程序,都可以算作Agent。

同年,AI 学者 Wooldridge 和 Jennings 提出了著名的“强 Agent / 弱 Agent”之分。

现实中,大多数Agent 系统采用的都是所谓“弱定义”:它像人类一样思考问题,也没有主观意识,只要满足四个基本条件:

在这种定义下,Agent 就像一个‘能感知、能行动、能持续运行’的小型数字角色。它不是被动等待调用的函数,也不是死板存储的数据,而是一个始终在线、对环境有反馈能力的智能执行体。

这个“弱定义”由于其通用性与实用性,被学界广泛采纳,并逐渐成为之后所有 AI Agent 技术与框架的基础。

1.2 传统 Agent 架构的三种思路:理性思考、本能反应、两者结合

在AI Agent 的发展早期,也就是上世纪 70 到 90 年代之间,学者们围绕“一个智能体到底该怎么思考与行动”这个问题,走出了三条颇具哲学意味的技术路径:

第一种叫****审议式架构(Deliberative Architecture)

这套架构的出发点是:智能应该是一种有条理的思考过程,类似人类的逻辑推理与理性决策。在它的设计中,Agent 拥有一个内部世界模型,对外部环境有一套符号化的表示。它会像棋手一样,基于自己当前所“相信”的事实,去推导、计划、评估,然后再采取行动。

第二种是****反应式架构(Reactive Architecture)

与其说是“计划后行动”,不如说是“感到刺激立刻反应”。它的灵感来源于生物系统,比如昆虫的逃跑反射——**无需建模,也不做深度推理,而是用直接的感知-反应通道进行快速决策。**它不构建世界模型,也不去思考“我要什么”,但它可以在复杂、未知的环境中表现出很强的鲁棒性。

第三种是****混合架构(Hybrid Architecture)

这是一种折衷方案,试图结合前两者的优点:保留反应式的快速本能,应对突发情况;同时也拥有审议式的逻辑计划能力,处理复杂任务。

1.2.1 审议式架构:BDI 架构**(Belief-Desire-Intention Architecture)**

在早期的人工智能研究者看来,如果一个Agent 要像人一样做出复杂决策,那它就必须先理解自己所处的世界,再做计划,然后才是执行。

这一思路发展出了审议式架构(Deliberative Architecture),也叫符号架构(Symbolic Architecture)。它的核心理念是:

要让智能体变得聪明,先要教它“用符号去理解世界”。

这听起来抽象,但其实就是把真实世界中复杂的状态(比如天气好不好、车多不多、人饿不饿)——用一组**程序能识别的“标签”**来表示,然后在这些标签之间设定规则、推理关系,从而让系统做出决策。

这套理念背后有一个影响深远的假说,叫做物理符号系统假说(Physical Symbol System Hypothesis)。由AI 先驱纽厄尔和西蒙在 1970 年代提出。

它的意思是:

“如果一个系统能操作符号,就有潜力实现通用智能。”

也就是,只要能让机器像我们处理文字和语言一样去操作信息,它就有可能学会像人一样思考。

BDI 架构:像人一样从“知道”到“想做”再到“去做”

在这套思路下,出现了最具代表性的设计之一:BDI 架构,全称是Belief-Desire-Intention,意思是:

信念(Belief):我知道什么?

愿望(Desire):我想要什么?

意图(Intention):我决定现在做什么?

你可以把它想象成一个心理决策漏斗:

信念 是Agent 对当前世界的认识,比如“现在是白天”、“门是开的”、“我身边有一个目标物体”;

愿望 是基于这些认知,它可能想完成的事情,比如“我想进入房间”、“我想避开障碍”;

意图 则是从多个愿望中挑出一个此刻要真正去做的,比如“我决定现在就去推门”。

一旦意图形成,它就会启动相应的执行计划,把这个决定真正落地。

BDI 的关键在于:它不是马上就执行,而是逐层筛选、逐步承诺:

从世界中提取有用信息,构成信念;

在信念中生成多个可能的愿望;

再从愿望中选出一个能执行的意图;

然后再启动相应的动作或计划。

这就像一个学生:

信念:现在是晚上9 点,我明天有考试;

愿望:我想复习、我也想玩手机;

意图:我决定现在复习一小时。

它模拟的不是“反应”,而是“抉择”。

BDI 架构特别适用于那些需要目标保持稳定、任务结构复杂、需要理性规划的应用场景。它可以支持多目标之间的权衡、任务进度跟踪、和意图驱动的协调行动。

1.2.2 反应式架构**:**包容架构(Subsumption Architecture)

在智能体的世界里,有一种极端思潮认为:

“越是聪明的系统,越不应该浪费时间去思考。”

听起来似乎违反常识,但它背后的哲学其实是:

与其先理解世界再做决定,不如直接行动,通过不断与环境互动,逐步进化出合适的行为,而这正是**反应式架构(Reactive Architecture)**的核心。

它的代表人物,是机器人科学家罗德尼·布鲁克斯(Rodney Brooks),他在1986 年提出了著名的包容架构(Subsumption Architecture),这是一种专为移动机器人设计的控制架构,强调无需世界模型、分层并行控制。

布鲁克斯批评传统AI(如 BDI 架构)那种“先建世界模型 → 再推理计划 → 然后执行”的决策流程,认为这在真实环境中太过迟缓且不稳定。

他指出:现实世界变化迅速,等你完成建模,现实可能早已发生了变化。

与其如此,不如让Agent 像昆虫一样,依靠一套由底层到高层的行为反应模块,直接用感知驱动行动,不再依赖中心化世界模型。

在包容架构中,Agent 的智能不是来自一个统一的大脑,而是来自一组分层的、本能化的行为模块,每个模块负责一个独立的动作目标,比如:

每一层都是一个独立的、小型行为系统,自己感知、自己做决策,不依赖全局调度。这些层级不是线性依赖,而是叠加组合、并行运行。

所谓“包容”,指的是:

在布鲁克斯的设计里,高层行为不是完全替代底层行为,而是在需要时接管或覆盖它们的输出。

举个例子:

一个机器人正在执行“寻找出口”的复杂任务(高层行为)。

如果它的传感器检测到前方突然出现障碍物,底层的“避障”机制会立即发挥作用,让它先转向或停止。

这意味着:

高层的决策只能在条件允许时掌控行动;

底层的反应始终保持活跃,即使上层迟迟没有响应,机器人依旧能表现出最基本的合理行为。

由于这些行为模块是并行运行的,系统需要一种方式来决定“谁来控制动作”。

布鲁克斯提出了所谓的抑制机制(inhibitory control):

当高层有明确输出时,它会覆盖掉底层的行为输出;

如果高层暂时失效或来不及反应,控制权会自动回落到底层,让机器人依然能够继续行动。

包容架构的最大优势是:鲁棒性极强**(即使环境突变或部分模块出错,系统依然能维持基本功)****,反应迅速。**

它不依赖复杂的推理链条,因此在面对快速变化的环境时不会因为长时间建模和推理而错过反应时机;

底层行为经过反复调试,可以保证即便高层宕机,系统也不会彻底崩溃;

适用于机器人、无人机、战场自动设备等高度动态、对反应速度要求极高的场景。

1.2.3 混合架构:Touring Machine —— 理性与本能的双重引擎

审议式架构有远见,能做长期规划,但反应太慢,遇到突发状况容易被打断;

反应式架构反应迅速、鲁棒,但目光短浅,只顾眼前,可能带来次优甚至有害的结果。

研究者逐渐意识到:真正的智能系统,既不能只靠“深思熟虑”,也不能只靠“即时反应”。

于是便诞生了混合架构(Hybrid Architecture),试图融合两者的优点:

从反应式架构继承快速响应与鲁棒性;

从审议式架构引入目标导向与前瞻性规划。

Touring Machine 架构:三层并行的大脑

在1992 年,Innes Ferguson 提出了一个典型的混合架构模型:Touring Machine。

Touring Machine 架构(Ferguson, 1992)

核心思想:

把智能体的控制系统分成三层,每一层都可以独立感知环境并提出行动建议,然后由一个仲裁机制来决定执行哪一个。

1.2.4. 传统 Agent 架构的对比与反思

在智能体研究的早期,不同架构背后不仅有技术选择的分歧,更隐藏着对“智能究竟是什么”这一根本问题的不同理解。

BDI 架构:它认为智能的本质,是在符号化的世界模型上进行推理与计划。智能体像一个逻辑学家,依赖抽象表征去决定行动。

包容架构:它认为智能来源于与环境的直接互动。智能体像昆虫一样,不必建模和推理,而是通过分层的反应机制,实时适应外部变化。

这两种看似对立的思路,在学术上曾长期争论:

智能究竟是“在头脑中演算出来的逻辑”,还是“在世界里摸索出来的行为”?

而Touring Machine 架构的出现,提供了一种折衷的技术方案。它一方面保留了规划和建模的前瞻性,另一方面也融入了反应式架构的鲁棒与实时性。

研究者因此逐渐认识到:

一个真正完整的智能体,既需要审议式层面的远见,能设定目标、制定策略;

也需要反应式层面的现实根基,在复杂环境中能当机立断、确保生存。

1.3. 传统 Agent 架构的局限性

早期的Agent 架构发展受制于两个层面的系统性困境:

一方面是硬件瓶颈,另一方面是预编程方式的僵化。这使得传统Agent 在复杂、动态的环境中显得力不从心。

1) 硬件瓶颈

在20 世纪 80–90 年代,主流的计算平台是 CPU,其核心特征是串行处理 ——一次只能处理一条指令。

这使得基于推理循环的BDI 架构(逐步更新信念、筛选意图、执行计划)相对容易实现,但对并行性要求高的设计则受限。

与此同时,计算机体系结构领域暴露出一个著名的问题:“内存墙”(Memory Wall)。

处理器性能在当时呈指数级提升;

但内存的带宽和延迟改善远远跟不上。

结果是:CPU 虽然很快,但常常在等待数据时被拖慢。

对Agent 而言,这意味着推理和决策过程过于耗时,在面对快速变化的环境时无法实时响应。

2) 知识更新的困境

另一大局限在于:传统Agent 高度依赖开发者的预编程。

行为逻辑和计划大多由专家事先写入系统;

系统假设“常见情况”都能被预先覆盖;

Agent 执行的,只是这些写死的规则。

这种方式的问题在于:

缺乏学习能力:系统无法从经验中改进;

缺乏适应性:面对未曾预设的情境时,会直接“失灵”;

缺乏灵活性:行为表现僵化,难以处理复杂而动态的真实环境。

简单来说,传统Agent 更像是一个“剧本演员”,只会照本宣科,而不是一个能因事变通、主动学习的智能体。

总结

回顾传统Agent 的发展历程,我们可以看到一条清晰的脉络:

从BDI 架构的符号推理,到包容架构的本能反应,再到Touring Machine 的折衷整合,每一次架构创新都对应着研究者对“智能本质”的不同理解。

BDI 架构强调理性与逻辑,让Agent 能够进行目标导向的规划;

包容架构凸显环境互动与即时反应,保证系统在迅速变化环境下的反应;

Touring Machine 则试图结合两者,构建出既能深思熟虑又能当机立断的混合型智能体。

然而,受限于硬件性能(CPU 串行与“内存墙”问题)与 静态预编程的僵化性,传统Agent 在实际应用中仍显不足。它们往往难以处理高速变化的环境,更缺乏学习与自我更新的能力。

换句话说,传统架构为“什么是智能体”提供了理论雏形,但也清楚地揭示了仅靠符号逻辑或简单反应难以满足复杂世界的需求。

这些局限,最终推动了研究者们走向新的探索方向:学习驱动的智能体、具备生成与自适应能力的AI Agent。也正是在这些后续的发展中,今天的“AI Agent 浪潮”才逐渐成型。

AI大模型从0到精通全套学习大礼包

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

只要你是真心想学AI大模型,我这份资料就可以无偿共享给你学习。大模型行业确实也需要更多的有志之士加入进来,我也真心希望帮助大家学好这门技术,如果日后有什么学习上的问题,欢迎找我交流,有技术上面的问题,我是很愿意去帮助大家的!

如果你也想通过学大模型技术去帮助就业和转行,可以扫描下方链接👇👇

大模型重磅福利:入门进阶全套104G学习资源包免费分享!

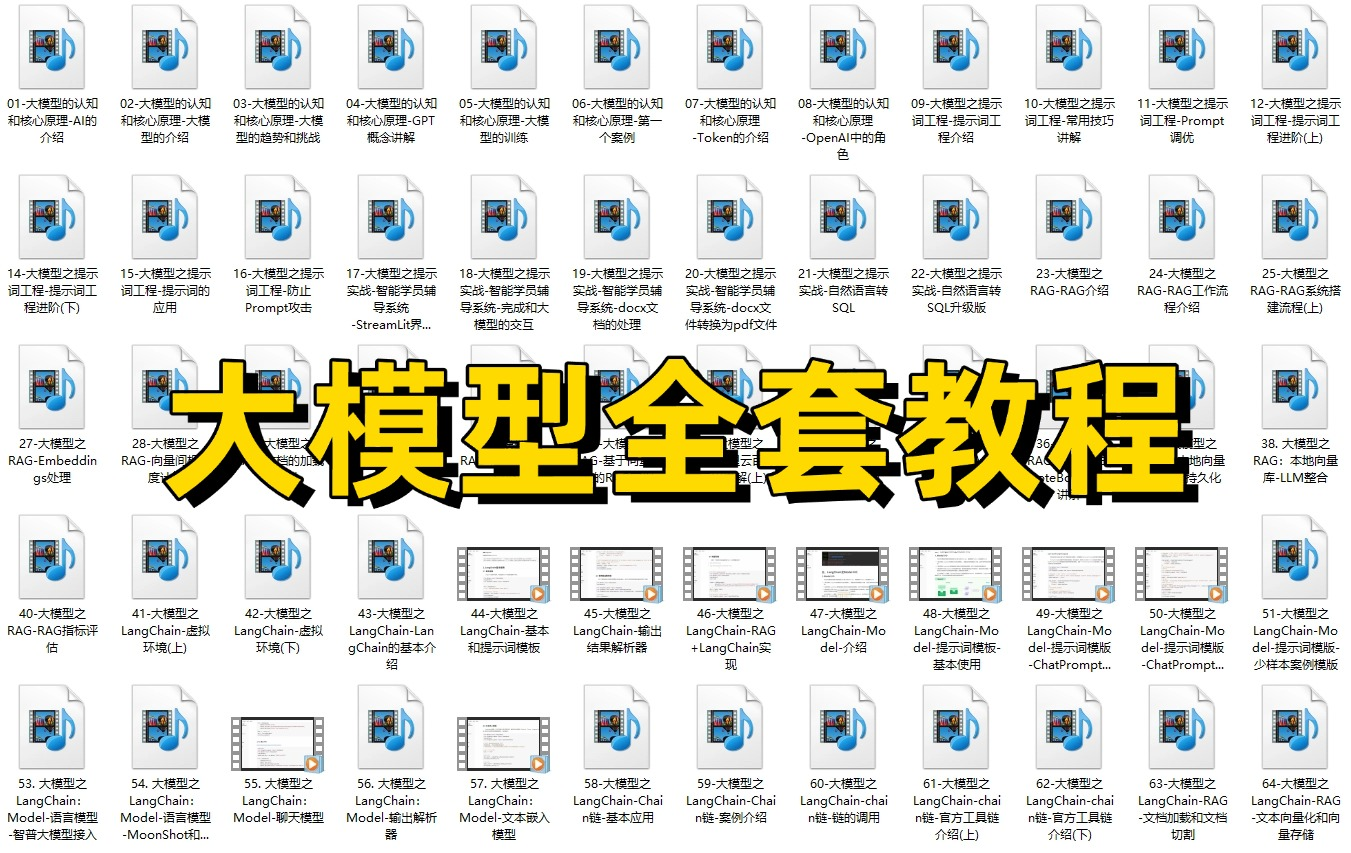

01.从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

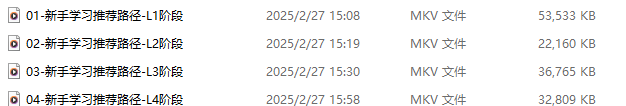

02.AI大模型学习路线图(还有视频解说)

全过程AI大模型学习路线

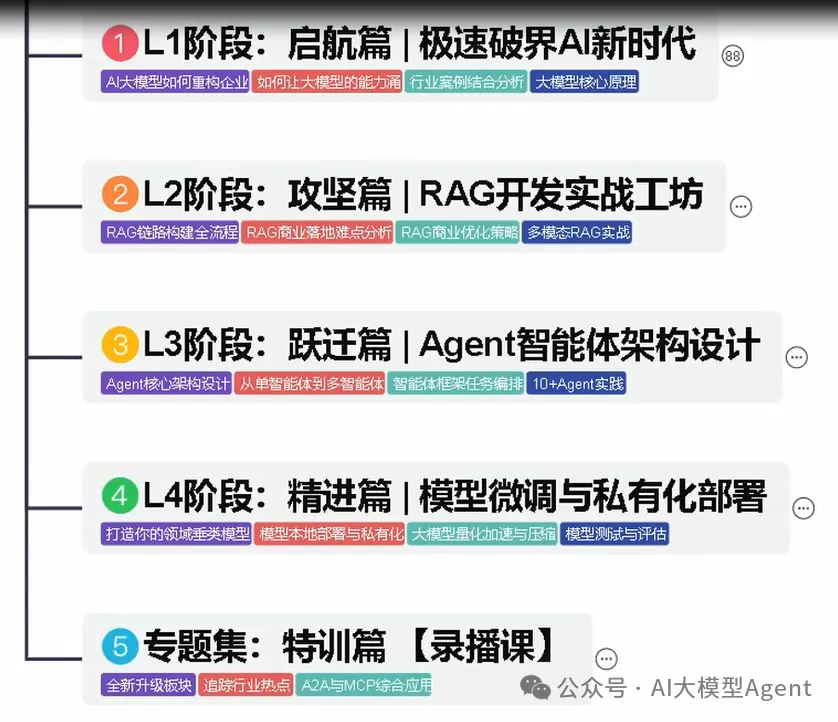

03.学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

04.大模型面试题目详解

05.这些资料真的有用吗?

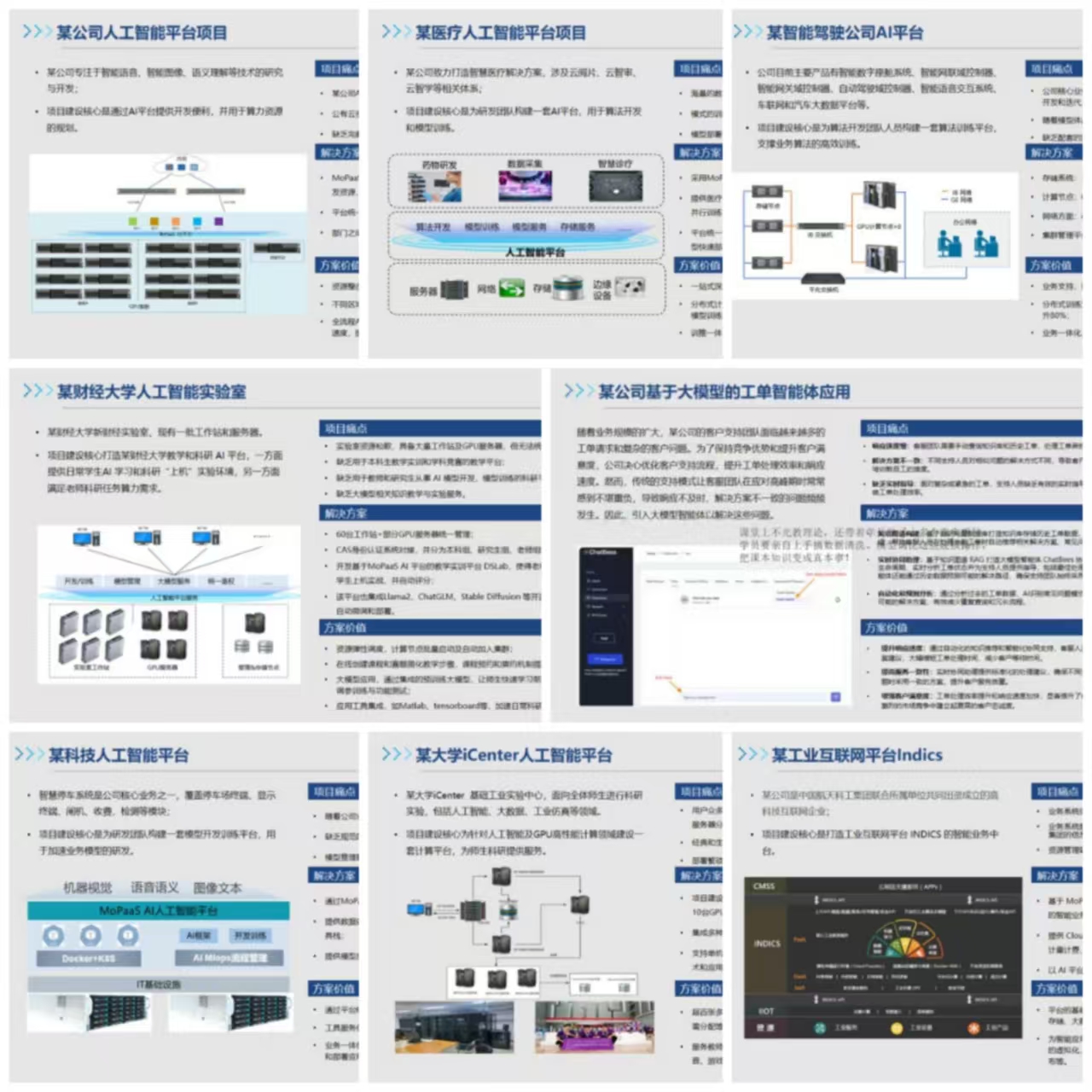

这份资料由我和鲁为民博士共同整理,鲁为民博士先后获得了北京清华大学学士和美国加州理工学院博士学位,在包括IEEE Transactions等学术期刊和诸多国际会议上发表了超过50篇学术论文、取得了多项美国和中国发明专利,同时还斩获了吴文俊人工智能科学技术奖。目前我正在和鲁博士共同进行人工智能的研究。

所有的视频由智泊AI老师录制,且资料与智泊AI共享,相互补充。这份学习大礼包应该算是现在最全面的大模型学习资料了。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

智泊AI始终秉持着“让每个人平等享受到优质教育资源”的育人理念,通过动态追踪大模型开发、数据标注伦理等前沿技术趋势,构建起"前沿课程+智能实训+精准就业"的高效培养体系。

课堂上不光教理论,还带着学员做了十多个真实项目。学员要亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献281条内容

已为社区贡献281条内容

所有评论(0)