Matrix-Game 2.0: 开源、实时、流式交互世界模型

25年8月来自昆仑万维(Skywork AI)的论文“Matrix-Game 2.0: An Open-Source, Real-Time, and Streaming Interactive World Model”。交互式视频生成领域的最新进展证明,扩散模型通过捕捉复杂的物理动态和交互行为作为世界模型的潜力。然而,现有的交互式世界模型依赖于双向注意和冗长的推理步骤,严重限制了实时性能。因此,它

25年8月来自昆仑万维(Skywork AI)的论文“Matrix-Game 2.0: An Open-Source, Real-Time, and Streaming Interactive World Model”。

交互式视频生成领域的最新进展证明,扩散模型通过捕捉复杂的物理动态和交互行为作为世界模型的潜力。然而,现有的交互式世界模型依赖于双向注意和冗长的推理步骤,严重限制了实时性能。因此,它们很难模拟现实世界的动态,在现实世界中,结果必须根据历史背景和当前动作即时更新。为了解决这个问题,Matrix-Game 2.0,一个交互式世界模型,通过几步自回归扩散即时生成长视频。该框架由三个关键组件组成:(1)一个适用于虚幻引擎和 GTA 5 环境的可扩展数据生产流水线,可有效生成具有各种交互注释的海量(约 1200 小时)视频数据;(2)一个动作注入模块,支持帧级鼠标和键盘输入作为交互条件;(3)基于随意架构的几步蒸馏,用于实时和流视频生成。 Matrix-Game 2.0 能够以 25 FPS 的超快速度生成涵盖各种场景的高质量分钟级视频。

如图所示:Matrix-Game 2.0 交互实时生成的结果

世界模型 [2, 23, 31] 因其能够理解现实世界的交互并预测未来状态 [47] 而备受关注。通过使智体能够感知周围环境并对动作做出响应,这些模型降低现实世界试验的成本并促进交互式模拟。因此,世界模型在游戏引擎 [9, 12, 42]、自动驾驶 [17] 和空间智能 [2, 3, 29, 46] 等领域展现出巨大的潜力。

视频生成模型 [4, 21, 26, 40, 43] 的最新进展表明,它们在从大规模现实世界数据集中学习知识方面取得了显著进展,这些知识涵盖了从物理定律到交互式场景的各个方面。这展现了它们作为世界模型的巨大潜力。在该领域的众多研究方向中,交互式长视频生成 [5, 6] 因其实际应用而变得越来越重要,在这些应用中,长视频需要根据连续的用户输入流实时生成。具体来说,当以用户动作(例如相机移动和键盘输入)为条件时,该模型会因果地生成帧,从而实现实时用户交互。

尽管交互式视频生成取得令人瞩目的进展,但现有方法仍面临着几个重大挑战:

• 由于成本高昂且采集难度大,缺乏用于训练的大规模、高质量且包含丰富注释(例如精确的动作和相机动态)的交互式视频数据集。

• 双向视频扩散模型 [23, 27, 57] 存在延迟问题,生成单帧需要处理整个视频。这使得它们不适用于实时流媒体应用,因为在这类应用中,模型必须适应动态用户命令并动态生成帧。计算和内存需求相对于帧长度呈二次方增长,再加上大量的去噪迭代,使得长视频生成计算量巨大且经济上不切实际。

• 现有的自回归视频扩散模型存在严重的误差累积问题 [9,19,40]。虽然这些模型会根据前几帧生成下一帧,但它们在生成过程中经常会遇到错误累积的问题,导致视频质量随着时间的推移而下降。

为了应对实时交互式生成中的这些关键挑战, Matrix-Game 2.0 成为一个专为实现实时性能和跨不同场景的稳健泛化能力而设计的框架。首先,技术核心是一个集成动作控制模块的视频扩散 transformer,通过基于 Self-Forcing [18] 的技术,将其蒸馏为一个因果关系几步实现的自回归模型。该架构通过高效的 KV 缓存机制支持训练和推理,在单个 H100 GPU 上实现 25 FPS 的生成速度,同时保持长达一分钟的时间一致性和精确的动作可控性——即使在超出训练分布的复杂野外场景中也是如此。

该模型强大的泛化能力源于另一项创新:一个全面的数据生产流程,它解决了交互式训练数据的根本限制。该流程基于虚幻引擎,包含基于导航网格的路径规划系统(用于实现数据多样性)和四元数精度优化模块(用于实现精确的摄像机控制)。此外,针对《侠盗猎车手 5》(GTA 5),开发一套集成脚本钩子(Script Hook)的数据记录系统,该系统能够同步捕捉视觉内容和相应的用户交互。这些组件共同生成带有帧级注释的大规模数据集,满足了两个关键需求:(1) 视觉内容与控制信号之间的精确对齐;(2) 动态游戏交互的有效建模。

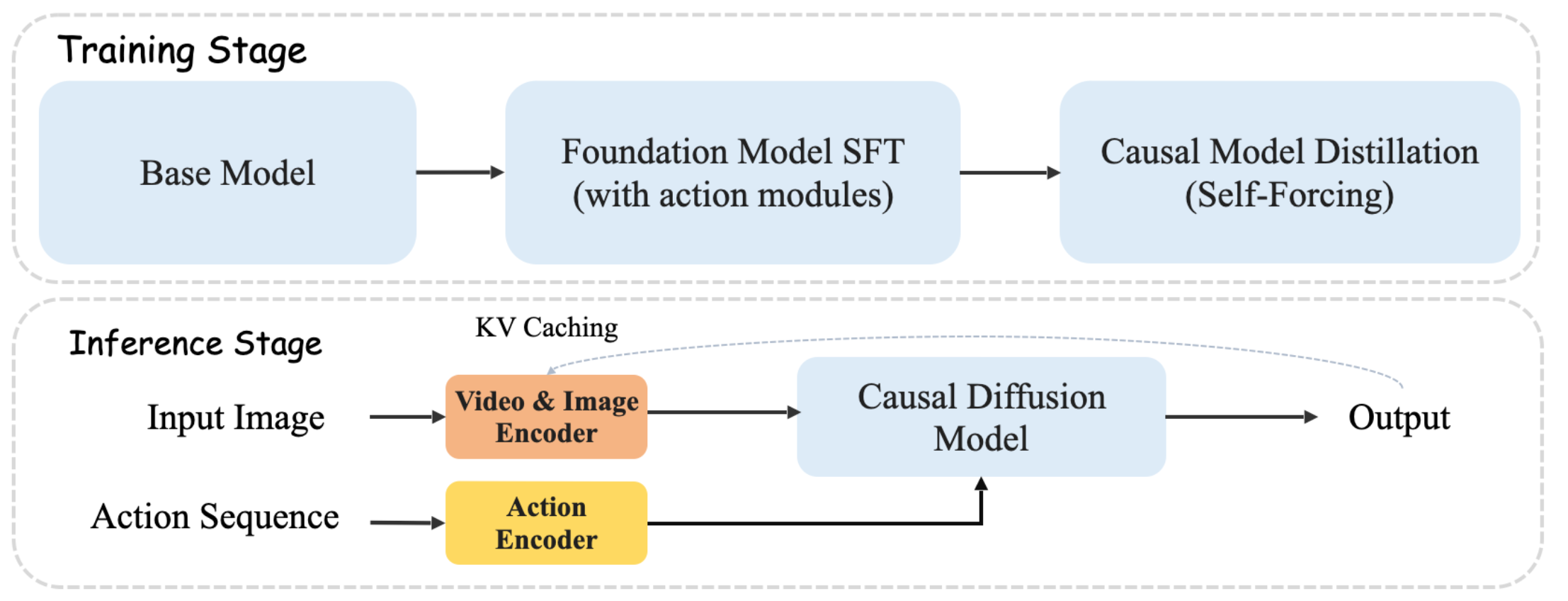

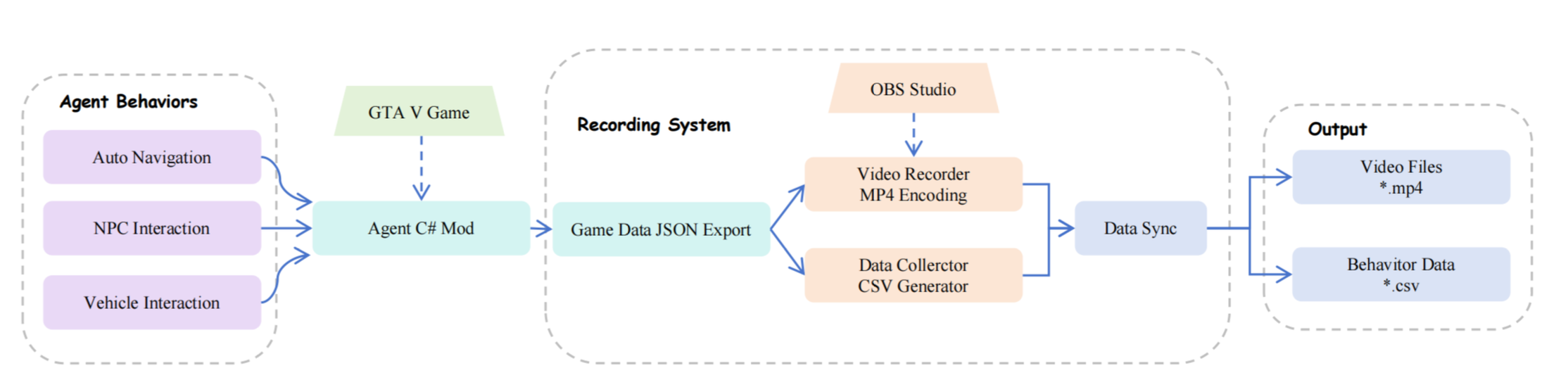

Matrix-Game 2.0 同时应对了效率和可控性的挑战,并引入了专为实时模拟和交互定制的高效框架,在世界建模方面取得了重大进展。如图所示:Matrix-Game 2.0 的流水线

其设计并实现全面的数据生产流水线,促进 Matrix-Game 2.0 的大规模训练。具体而言,该工作解决两个关键挑战:(1) 生成与键盘和摄像头信号注释精确对齐的游戏视频数据;(2) 实现由碰撞-觉察导航规则和强化学习训练的智体驱动交互式视频捕捉机制,从而更好地模拟动态游戏交互。为了实现实际部署,开发并整理一套多样化的数据集生产流水线,其中包含来自虚幻引擎和 GTA5 模拟环境的静态和动态场景。

基于虚幻引擎的数据生产

高性能交互式视频生成模型的开发需要大规模数据集,这些数据集应具有精确同步的视觉内容和控制信号,例如精确对齐的键盘输入和摄像头参数。虽然现有数据集通常缺乏游戏画面与相应输入之间精确的时间对齐,但基于虚幻引擎的流水线通过受控的合成数据生成系统地解决这一问题。虚幻引擎的精确环境控制和确定性渲染使其特别适合创建可扩展的多模态训练数据,并保证注释的准确性。

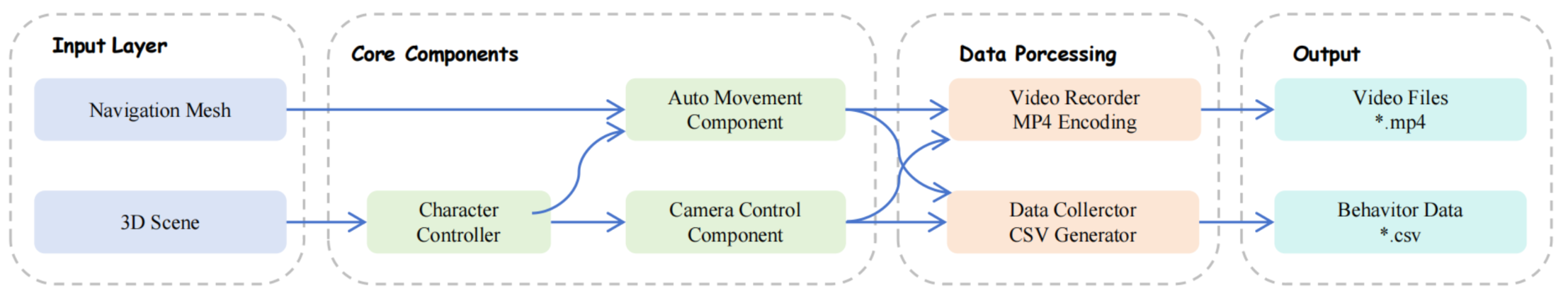

如图所示,基于虚幻引擎的数据流水线以导航网格和 3D 场景作为输入。然后,系统采用自动移动和摄像机控制模块来模拟智体导航和动态视点转换。最后,生成的视觉数据和相应的动作注释通过集成的 MP4 编码器和 CSV 生成器进行记录和导出。

系统的关键创新包括:(1) 基于导航网格的路径规划模块,用于生成多样化的轨迹;(2) 精确的系统输入和摄像机控制机制,用于确保动作和视点的精确对齐;以及 (3) 用于高质量数据管理的结构化后处理流水线。

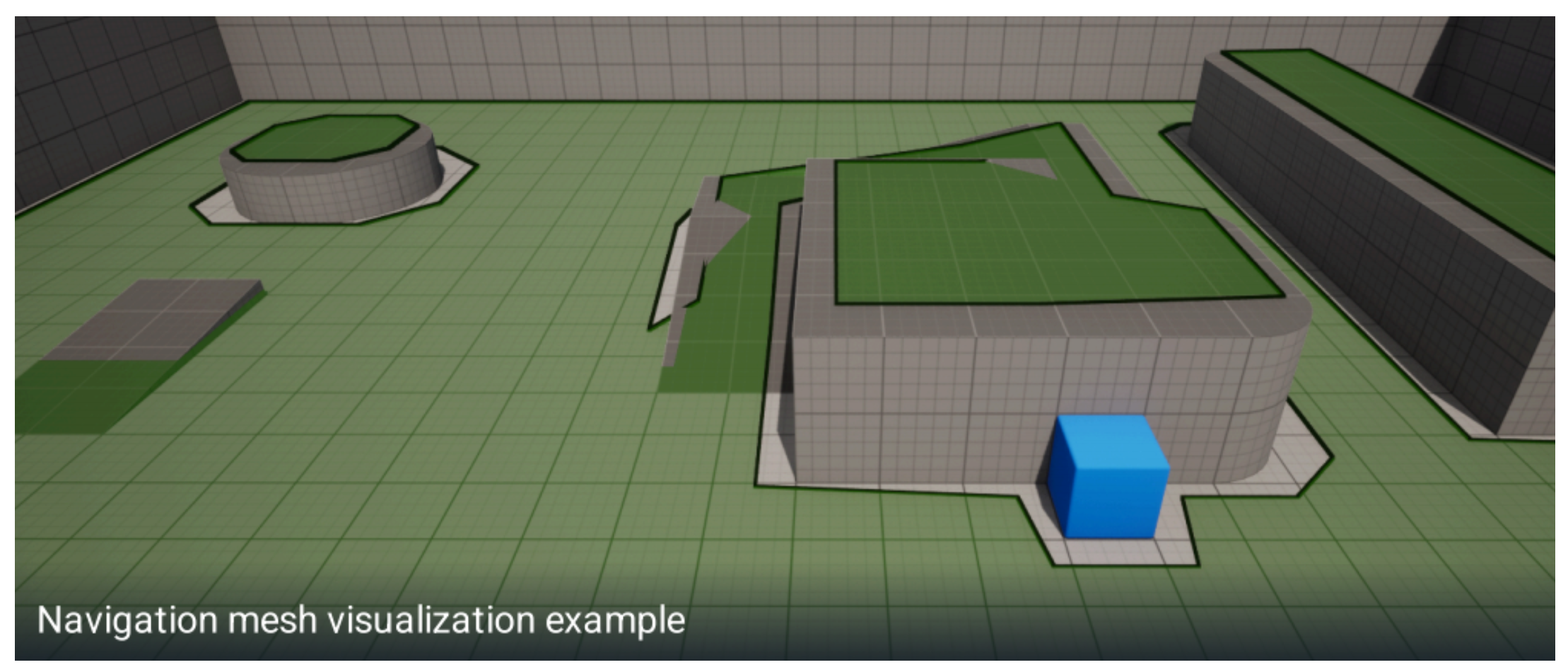

基于导航网格的路径规划系统。为了增强生成训练数据的真实感和行为多样性,开发一种先进的基于导航网格的路径规划系统,该系统可促进非玩家角色 (NPC) 动态自适应的移动。该系统支持实时、确定性的路径规划,这是生成可重复且高保真训练数据的关键要求。

实现基于虚幻引擎原生的 NavMesh 基础架构,并添加定制的路径规划优化,将平均查询延迟降低至 2 毫秒以下。此外,该系统在智体行为中引入受控随机性,从而在严格遵守逻辑导航约束的同时,实现多样化且上下文连贯的运动模式。这种方法通过引入逼真的智体交互动态和运动轨迹,显著增强训练语料库的丰富性,从而提升下游视频生成模型的泛化能力。如图所示展示了一个导航示例。图中的绿色区域表示智体可以自由移动的区域,防止智体撞到墙壁而卡住。

强化学习——增强智体训练。为了进一步提升数据收集智体的行为真实感和决策能力,将强化学习 (RL) 框架与基于碰撞的导航规则集成在一起,该框架采用典型的 RL 方法,例如近端策略优化 (PPO) [35]。强化学习 (RL) 智体采用结合防撞、探索效率和轨迹多样性的奖励函数进行训练。这个基于碰撞的规则在训练期间充当安全约束,确保强化学习 (RL) 智体在学习最佳导航策略的同时保持物理合理性。

这种混合方法将基于规则防撞的确定性安全性与强化学习 (RL) 训练行为的自适应智能相结合,从而使智体能够生成更真实、更多样化的交互模式,同时保持数据收集的可靠性。

精准的输入和摄像机控制。集成虚幻引擎的增强输入系统,能够以毫秒级精度同时捕捉多个键盘输入。该系统维护一个与渲染帧对齐的同步输入事件缓冲区,以确保训练过程中输入与视觉的精确同步。为了消除摄像机旋转计算中 0.2% 的临界错误率,在中间计算中使用双精度算法实现四元数精度优化。这项优化将旋转误差降低到几乎可以忽略不计的水平。

数据管理。开发一种基于 OpenCV 的视频帧过滤算法,用于检测并消除时间冗余帧,从而提高数据效率。此外,还引入基于速度的验证机制,用于识别和排除以零速度或负速度为特征的无效样本,这些样本通常表示静止或物理上不合理的运动状态。此标准确保仅保留语义上有意义的运动数据以供后续模型训练。

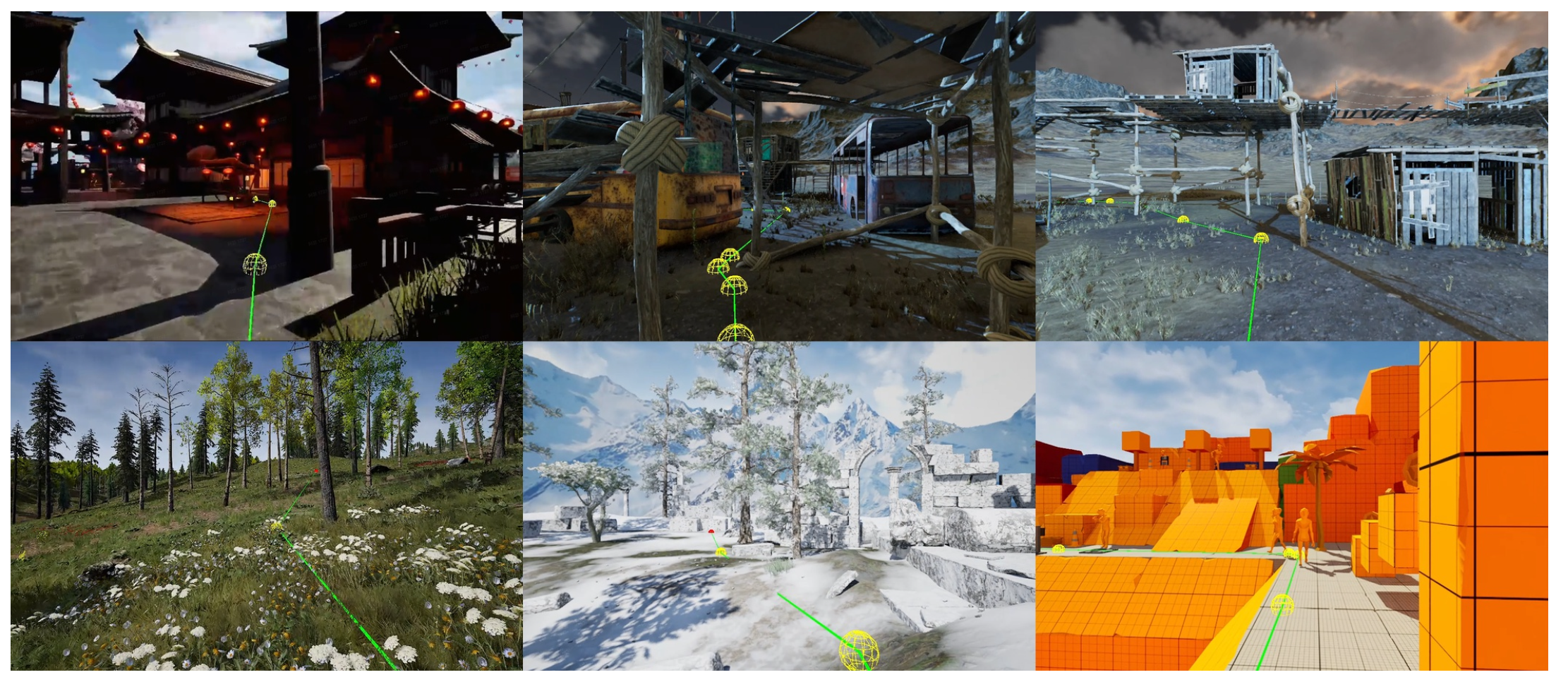

多线程流水线加速。数据处理流水线经过重新设计,支持多线程执行,可在单个 RTX 3090 GPU 上实现双流数据生成。该系统采用独立的渲染线程和共享内存池,以实现高效的资源利用。如图所示展示一些具有代表性的轨迹示例。绿色线段表示智体的路径。在复杂场景中,还可以规划合理的路径。

GTA 5 交互数据录取系统

为了方便采集丰富的交互式动态场景,用 Script Hook 集成技术,在 GTA 5 中开发一套全面的录制系统,该系统能够同步捕捉视觉内容和相应的用户操作。

用 Script Hook V 实现一个自定义插件架构,在 GTA 5 环境中建立录制流程。该插件能够同时捕捉鼠标和键盘操作,并实现帧精确同步。采集到的每个数据项都包含 RGB 帧以及相应的鼠标和键盘操作。

如图所示,系统包含三个主要组件:智体行为、GTA V 游戏环境和录制系统。智体行为模块包含自主导航、NPC 交互和车辆交互功能,这些功能通过自定义 C# 代码集成到 GTA V 游戏中。游戏将行为数据以 JSON 格式导出到录制系统,该系统使用 OBS Studio 进行视频采集(MP4 编码),并使用数据收集器生成 CSV 文件。同步机制确保视频帧和行为数据之间的时间对齐,最终输出同步的视频文件 (.mp4) 和行为数据集 (.csv)。动态控制机制(包括自主导航、NPC 交互和车辆交互)可选择性启用,从而生成第一人称或第三人称视角的交互场景。环境参数(例如车辆密度、NPC 数量、天气模式和时间设置)可调整,以模拟各种动态场景,从而增强所收集数据的多样性和真实感。具体而言,车辆密度参数可在 [0.1, 2.0] 范围内配置,而 NPC 密度参数则可在 [0.2, 1.5] 范围内配置。

为了在车辆导航模拟过程中获得最佳视角,系统通过每次更新位置来确保精确的摄像头标定,从而在整个模拟过程中保持相对于车辆的最佳且一致的视角:

Camera_position = Vehicle_position + offset × rotation

基于车辆动力学,系统推断并记录相应的键盘输入,从而生成包含速度、加速度和转向角的全面且时间一致的交互数据。

此外,开发一个运行时系统,用于动态访问导航网格信息,从而实现智能摄像头定位和运动预测。该系统对导航网格数据结构执行查询,以提取空间约束和有效的遍历路径,从而实现摄像机轨迹的最佳规划。导航网格查询过程涉及实时空间数据检索和路径验证,以确保摄像机运动限制在可导航区域内,同时保持最佳视角以实现有效的数据采集。

定量数据评估

通过数据采集流水线收集超过 120 万个视频片段,该流水线在多个关键指标上展现强大的性能。数据整体准确率超过 99%,系统在摄像机旋转精度方面实现了 50 倍的提升。此外,该流水线支持每块 GPU 的双并发数据流,有效提升了生产效率。如图展示一个典型的轨迹示例。GTA 5 中的游戏环境复杂多样。图中的线条代表智体的移动路径。可以规划合理的路径,避免智体发生碰撞或阻挡,从而有效提升数据的准确性。

Matrix-Game 2.0 首先用多样化的数据集训练一个基础模型,随后蒸馏方法将基础模型转化为一个几步自回归扩散模型,从而能够在保持视觉质量的同时实时生成长视频序列。

基础模型架构

Matrix-Game 2.0,是一个视觉驱动世界模型框架,旨在探索无需依赖语言描述即可理解和生成世界的智能。在当代研究中,文本引导已成为控制的主要方式——例如 SORA [28]、HunyuanVideo [22] 和 Wan [43],它们都利用文本描述进行生成。然而,此类方法通常会引入语义先验,使生成过程偏向于语言推理而非物理定律,从而阻碍模型掌握视觉世界基本属性的能力。

相比之下,Matrix-Game 2.0 消除所有形式的语言输入,仅专注于从图像中学习空间结构和动态模式。这种去语义化的建模方法受到空间智能 [46] 概念的启发,强调模型的能力应该源于对视觉和物理规律的直观理解,而非抽象的语义框架。

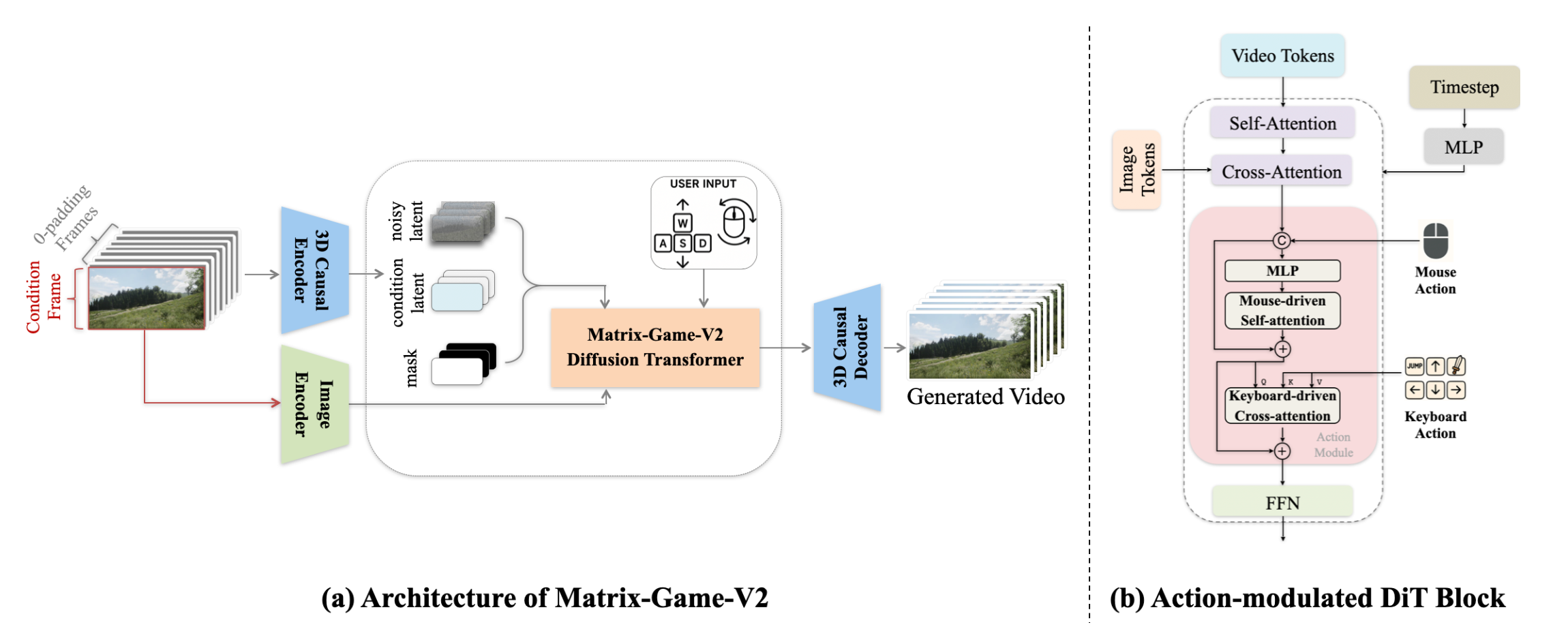

如图 (a) 所示,Matrix-Game 2.0 以单个参考图像和相应的动作作为输入,生成物理上可信的视频。首先采用 3D 因果变分自编码器 [20, 55] 在空间和时间维度上对原始视频数据进行压缩——在空间上压缩 8×8 倍,在时间上压缩 4 倍——从而提升训练效率和建模能力。图像输入由 3D VAE 编码器编码,CLIP 图像编码器 [33] 作为条件输入。在用户输入动作的引导下,扩散 transformer (DiT) 生成视觉 token 序列,随后通过 3D VAE 解码器将其解码为视频。

为了实现用户与生成内容之间的交互,Matrix-Game 2.0 引入动作模块,以实现可控的视频生成。受 GameFactory [54] 和 Matrix-Game [57] 的控制设计范式启发,将帧级动作信号嵌入到 DiT 模块中,如图 (b) 所示。

注入的动作信号分为两类:通过键盘输入的离散移动动作和通过鼠标移动的连续视点动作。具体而言,连续鼠标动作直接连接到输入的潜表示,通过 MLP 层转发,然后通过时间自注意层。此外,键盘动作通过交叉注意层由融合特征查询,从而实现交互的精确可控性。与 Matrix-Game [57] 不同,其用旋转位置编码 [39] (RoPE) 来替换添加到键盘输入中的正余弦嵌入,以促进长视频生成。

实时交互式自回归视频生成

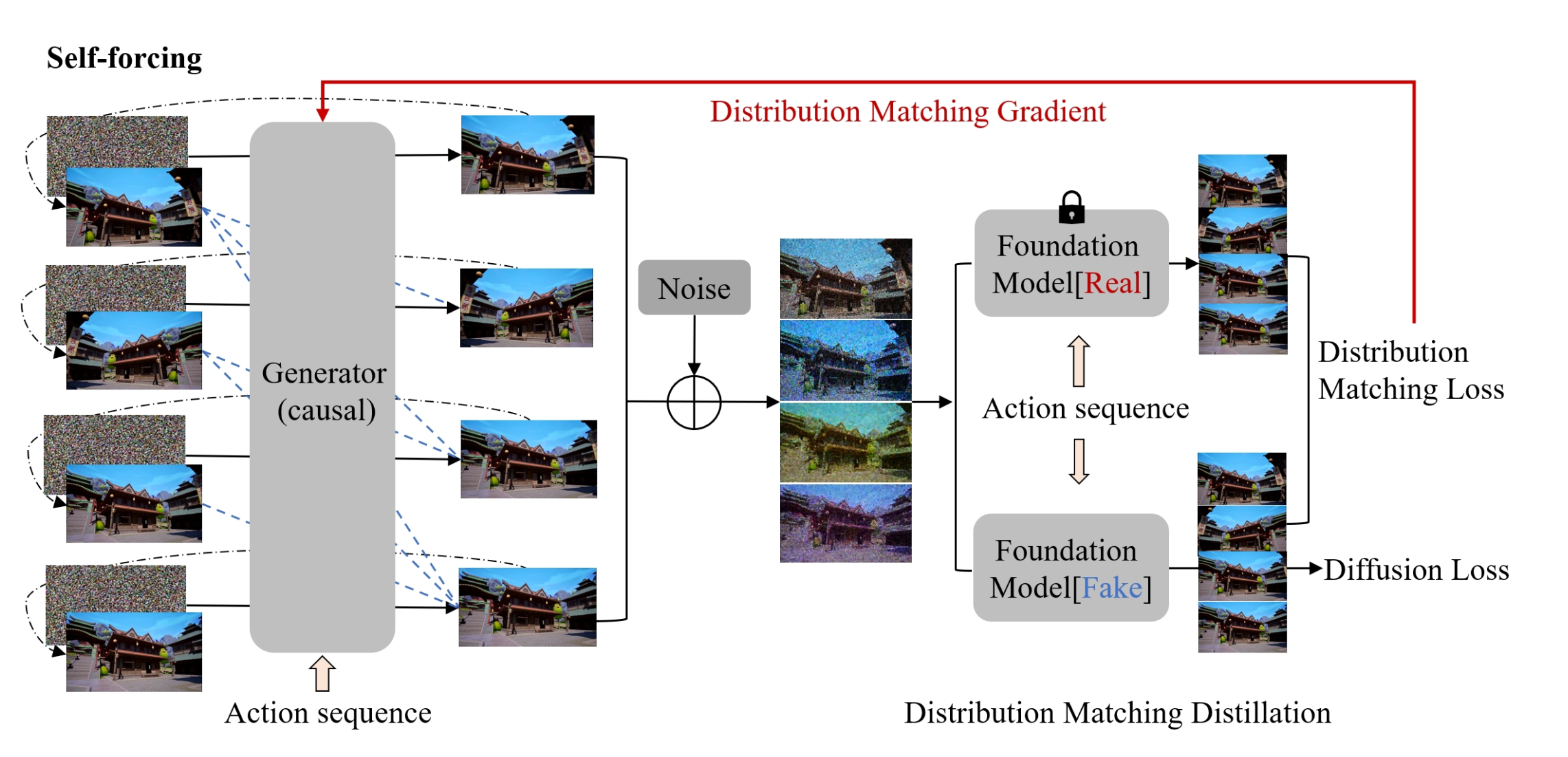

与矩阵游戏 [57] 采用仅限于固定长度生成的全序列扩散模型不同,本文开发一种用于实时长视频合成的自回归扩散模型。其方法通过self-forcing [18] 将双向基础模型转化为高效的自回归变体,该模型通过以先前自生成的输出(而非真实值)为条件来调节每一帧来解决曝光偏差问题。这显著降低教师强迫 [19] 或扩散强迫 [7] 方法的误差累积特性。

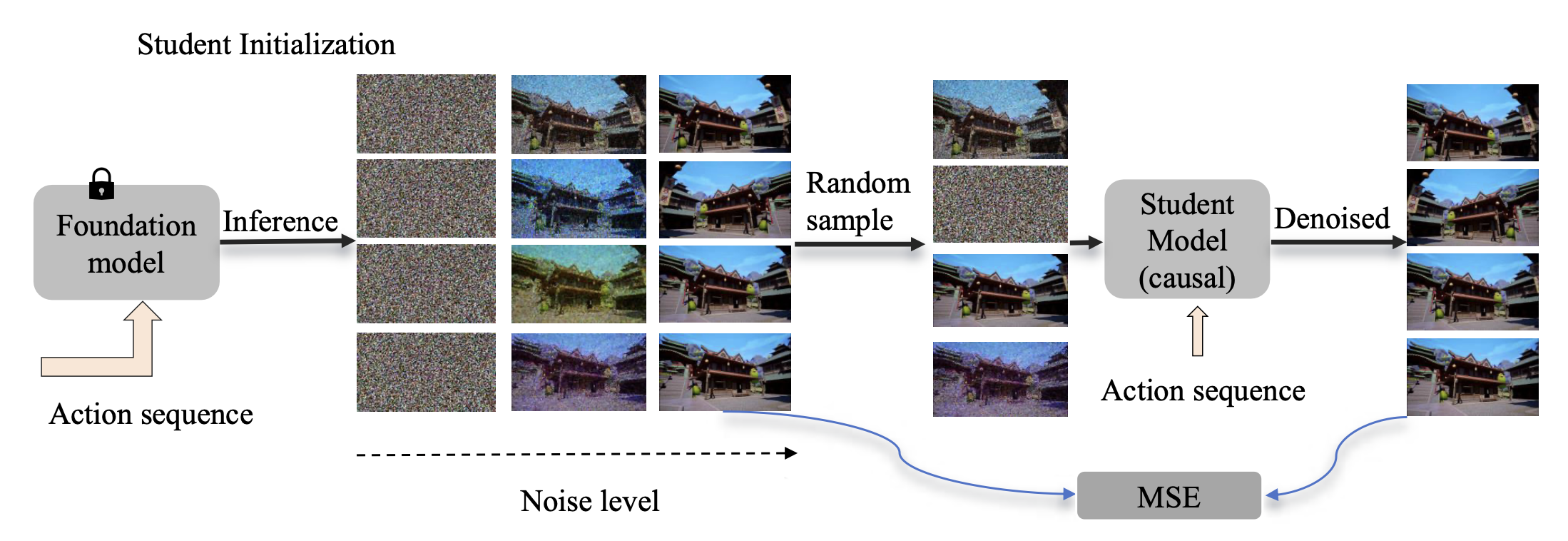

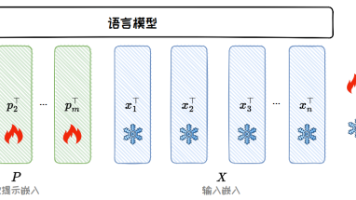

蒸馏过程包含两个关键阶段:学生生成器初始化和基于 DMD [52] 的自强迫训练。首先使用基础模型中的权重初始化学生生成器 G_φ,然后构建一个微分方程轨迹 xi_t 的数据集,其中 t 从 [0, T ] 的 3 步子集中采样。在训练期间,将分块因果掩码应用于每个注意层中的键和值。如图所示首先从 ODE 轨迹中采样一个包含 N 帧的噪声输入序列,并将其拆分成 L 个具有独立时间步 xi_T 的块。学生生成器将相应的动作作为输入,并利用去噪输出和干净输出之间的回归损失进行反向传播。

随后的 DMD 阶段(如下图所示)通过自强制 (Self-Forcing) 将学生模型的分布 p_θ,t (x^1:N_t) 与教师模型的 p_real,t(x1:N_t) 对齐。至关重要的是,生成器从其自身的分布(而不是真实的训练数据)中采样先前的帧,从而缩小了训练-推理差距并减少了由此造成的错误累积。

KV 缓存机制通过维护一个固定长度的近期潜向量和动作嵌入缓存,实现了高效的顺序生成。展开的缓存实现,会在超出容量时自动清除最旧的tokens,从而支持无限长度的生成。为了解决图像转视频场景中潜训练-推理差距问题(在长视频推理过程中,首帧可能会被排、、、限制了 KV 缓存窗口的大小。这迫使模型更多地依赖于其学习到的先验知识和对输入动作的理解来进行生成,同时通过在训练期间使初始帧对后续潜在帧不可见来提高鲁棒性。

实验设置

实施细节。为了训练基础模型,用 SkyReels-V2-I2V-1.3B [8] 初始化模型,该版本遵循 Wan 2.1 [44] 架构。1.3B 版本在生成质量和计算效率之间实现最佳平衡,实现了实时且高质量的生成性能。从已发布的检查点中删除文本注入模块。为了稳定整个训练过程,首先对模型进行 5k 步的微调。之后,在每个 DiT 块中添加动作模块,使模型总首先收集 40k 个 ODE 对,并对因果学生模型进行 6k 步的微调,随后通过基于 DMD 的自强制 (Self-Forcing) 进行 4k 步的训练。学习率为 6e-6。潜帧的块大小和注意局部大小分别设置为 3 和 6。此外,self-forcing 是一种无需数据的训练方法,允许手动设计动作序列分布,该分布可以更好地与用户输入的动作对齐,而不是自动脚本生成的随机动作序列。

数据集。训练数据集由其提出的流水线生成,包含约 800 小时的带动作注释的 360p 分辨率视频。数据包含 153 小时的 Minecraft 视频数据和 615 小时的 Unreal Engine 数据,每个视频片段被排列成 57 帧。对于真实场景,利用开源 Sekai 数据集 [24],在数据整理后获得额外的 85 小时训练数据。鉴于 Sekai 数据集中的环境导航速度和 FPS 与 Unreal Engine 场景不同,对 Sekai 数据进行帧重采样,以对齐时间动态和运动。为了验证框架的普适性,进一步收集 574 小时的 GTA 车手数据和 560 小时的 Temple Run 游戏数据,其中包含动态场景交互,以便进行进一步的微调。所有视频均调整为 352×640 分辨率。

评估指标和基准。用 Matrix-Game 1.0 中引入的综合 GameWorld Score Benchmark [57] 来评估通用实时模型。该基准测试提供一个多维评估框架,检查四个关键能力:视觉质量、时间质量、动作可控性和物理规则理解。鉴于当前开源交互式世界模型的稀缺性,对两个不同的领域进行单独的评估:Minecraft 和野外场景。对于 Minecraft 环境,与 Oasis [12] 作为主要基线进行比较,而 YUME [27] 用于更复杂的野外场景生成任务。所有实验都使用 597 帧的复合动作序列,对 32 个 Minecraft 场景和 16 个不同的野外场景图像进行评估,以涵盖不同的交互条件。

更多推荐

已为社区贡献121条内容

已为社区贡献121条内容

所有评论(0)