【室内导航通过视觉惯性数据融合】将用户携带的智能手机收集的惯性数据与手机相机获取的视觉信息进行融合研究(Matlab代码实现)

视觉惯性数据融合在室内导航中的核心价值在于互补纠偏与环境适应性。通过紧耦合算法、多传感器冗余及深度学习优化,系统在复杂场景下的定位误差可控制在1%以内(如100米路径误差<1米)。随着MEMS传感器精度的提升(如下一代陀螺仪零偏不稳定性目标<5°/hr),以及边缘AI算力的发展,智能手机将成为室内外无缝导航的关键载体。📚2 运行结果部分代码:i=0;i=i+1;endfrq=30;🎉3参考文献

💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。当哲学课上老师问你什么是科学,什么是电的时候,不要觉得这些问题搞笑。哲学是科学之母,哲学就是追究终极问题,寻找那些不言自明只有小孩子会问的但是你却回答不出来的问题。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能让人胸中升起一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它居然给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

基于智能手机的视觉惯性数据融合室内导航技术研究

摘要:

本文旨在通过将用户携带的智能手机收集的惯性数据与手机相机获取的视觉信息进行融合,提升第一人称室内导航和场景理解体验。我们在一个期望最大化框架中采用消失方向概念以及人工环境的正交约束,以估计人在视频帧中相对于已知室内坐标的方向。该框架允许包含有关相机旋转轴的先验信息,以提高估计精度,并从单眼视频帧中选择候选边线,估计走廊的深度和宽度,并进行场景的三维建模。我们提出的算法同时使用Kalman滤波器将基于视觉的估计方向与惯性数据结合,以改进估计并消除惯性传感器产生的显著测量漂移。我们在一个由IMU增强视频上评估了我们的视觉惯性数据融合方法的性能,视频记录了参与者完成一整圈旋转走廊的过程。我们证明了这种融合提供了几乎无漂移的即时关于人的相对方向的信息。我们能够估计走廊的深度和宽度,并从约60米一圈的旋转走廊生成一个闭环路径地图。

人类自然地利用视觉感知和导航周围世界,视觉作为主要输入方式与自我本体感觉反馈相结合。然后,他们的大脑重建被可视化场景的三维模型,使他们能够在环境中导航或探索新位置。然而,要从A点到B点旅行,必须通过地图(物理或数字)以及定位系统或用户对位置/路径的先前知识来向用户提供路径信息。随时间收集的全球导航卫星系统(GNSS)数据提供了定位和路径信息。然而,在室内场所,如建筑物内部或隧道等地方,通常无法获得GNSS信号,或者信号非常微弱。为了在GNSS信号不可用的区域估计准确的定位,已经使用惯性测量单元(IMUs)的数据进行相对航向和方向检测。

然而,IMU的数据容易产生大量漂移和失真,通常是由于累积误差引起的。由于与时间积分,加速度计数据中的恒定误差(无论多么小)导致速度中的线性误差和位置估计中的二次误差增长。此外,由于加速度计数据是以本地设备坐标给出的,因此需要除去其中的重力分量以计算位移,而没有准确的姿态(角度)估计是无法实现的。陀螺仪测量可以被积分以产生短时间内可靠的角度估计,但对长时间会产生漂移。姿态速率中的恒定误差导致方位的线性误差,速度中的二次误差和位置中的三次误差增长。为了校正陀螺仪测量,可以利用从加速度计估计的重力分量计算的偏航和俯仰角度。然而,加速度计对短时间内的振动和其他非重力加速度敏感。

一、视觉惯性数据融合的基本原理

视觉惯性导航系统(VINS)通过融合智能手机的惯性测量单元(IMU)和相机数据,实现室内外环境中的高精度定位与导航。其核心在于互补性:

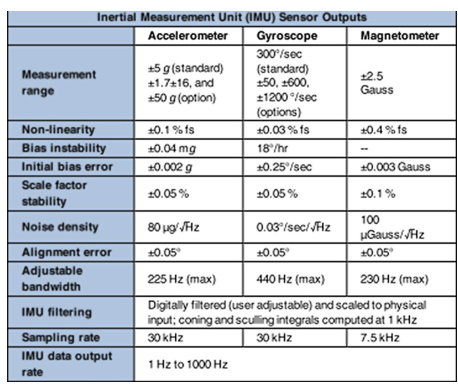

- IMU特性:提供高频(100-1000 Hz)的加速度和角速度数据,但存在积分累积误差(如加速度计的零偏不稳定度为±0.04 mg,陀螺仪漂移达18°/hr)。

- 视觉特性:通过特征点(如SIFT、ORB)匹配实现相对位姿估计,局部精度高,但易受光照变化、遮挡影响(例如夜间场景下特征点数量减少50%以上)。

融合方法主要分为两类:

- 松耦合(Loosely Coupled) :独立处理视觉和惯性数据后融合,如MSCKF;

- 紧耦合(Tightly Coupled) :直接融合原始数据,如VINS-Mono,通过预积分技术减少计算量。

典型系统如ORB-SLAM3在全局优化中结合IMU数据,但长期运行仍面临尺度漂移问题(误差累积速率达0.5%每小时)。

二、智能手机传感器的数据类型与特性

智能手机内置的MEMS传感器构成多模态数据源:

| 传感器类型 | 参数范围与误差特性 | 应用场景 |

|---|---|---|

| 加速度计 | 测量范围±5 g,噪声密度80 μg/√Hz,初始偏置误差±0.002 g | 步态检测、动态姿态估计 |

| 陀螺仪 | 角速度范围±300°/s,噪声密度0.03°/s/√Hz | 旋转运动跟踪 |

| 磁力计 | 测量范围±2.5 Gauss,非线性误差±0.4% fs | 航向校准(受金属干扰) |

| 相机(RGB/深度) | 分辨率1080p-4K,帧率30-60 fps,支持特征点提取(如ORB特征每秒提取500-1000个) | 环境特征匹配 |

数据融合挑战:

- IMU漂移:步行10分钟后位置误差可达2-3米;

- 视觉退化:低光照场景下特征点匹配失败率增加40%;

- 多传感器同步:需时间对齐至毫秒级精度(如IMU与相机采样率差异达10倍)。

三、视觉信息处理与SLAM技术流程

智能手机相机的视觉处理流程包含以下关键步骤:

- 预处理:去畸变(径向/切向畸变校正)、降噪(高斯滤波)。

- 特征提取:

- 特征点法:ORB(效率高,适合移动端)、SIFT(尺度不变性,计算量大);

- 直接法:利用像素灰度变化(如LSD-SLAM),适用于弱纹理环境。

- 特征匹配与运动估计:

- RANSAC算法剔除误匹配(错误率降低至5%以下);

- 通过本质矩阵(Essential Matrix)计算帧间相对位姿。

- 地图构建:稀疏特征点地图(ORB-SLAM3)或半稠密地图(LSD-SLAM),存储关键帧与三维点云。

四、室内导航场景下的融合挑战与优化方案

主要挑战:

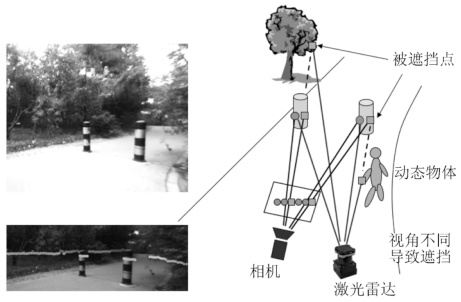

- 动态遮挡:行人或移动物体导致特征点丢失(如商场场景下遮挡率超30%);

- 光照突变:从室内到室外切换时,相机曝光适应延迟造成特征追踪中断;

- 多路径效应:Wi-Fi/蓝牙信号反射导致定位偏差达3-5米。

优化方案:

- 多传感器融合增强鲁棒性:

- 超声辅助:在视觉退化区域提供绝对位置约束(精度±0.1米);

- 地磁指纹:结合磁场异常实现无信号区域航向校准。

- 自适应滤波算法:

- 迭代自适应多状态约束卡尔曼滤波(IA-MSCKF):动态调整噪声协方差,实验显示局部精度提升88.9%;

- 交互式多模型(IMM) :根据环境复杂度切换融合模型,相比ORB-SLAM3提升17%定位精度。

- 深度学习辅助:

- CNN+EKF融合:利用卷积神经网络优化单目尺度估计,KITTI数据集平动误差减少45.4%;

- GRU-ESKF架构:通过门控循环单元预测IMU误差,复杂环境下RMSE降低23%。

五、实际应用案例与技术扩展

- AR导航系统:

- 结合Unity引擎与Indoor Atlas SDK,实现基于视觉惯性融合的增强现实路径指引(用户认知负担降低60%)。

- 盲人导航辅助:

- 多模态系统集成Wi-Fi信号强度地图与视觉匹配,路径规划响应时间<1秒,适用于复杂室内结构。

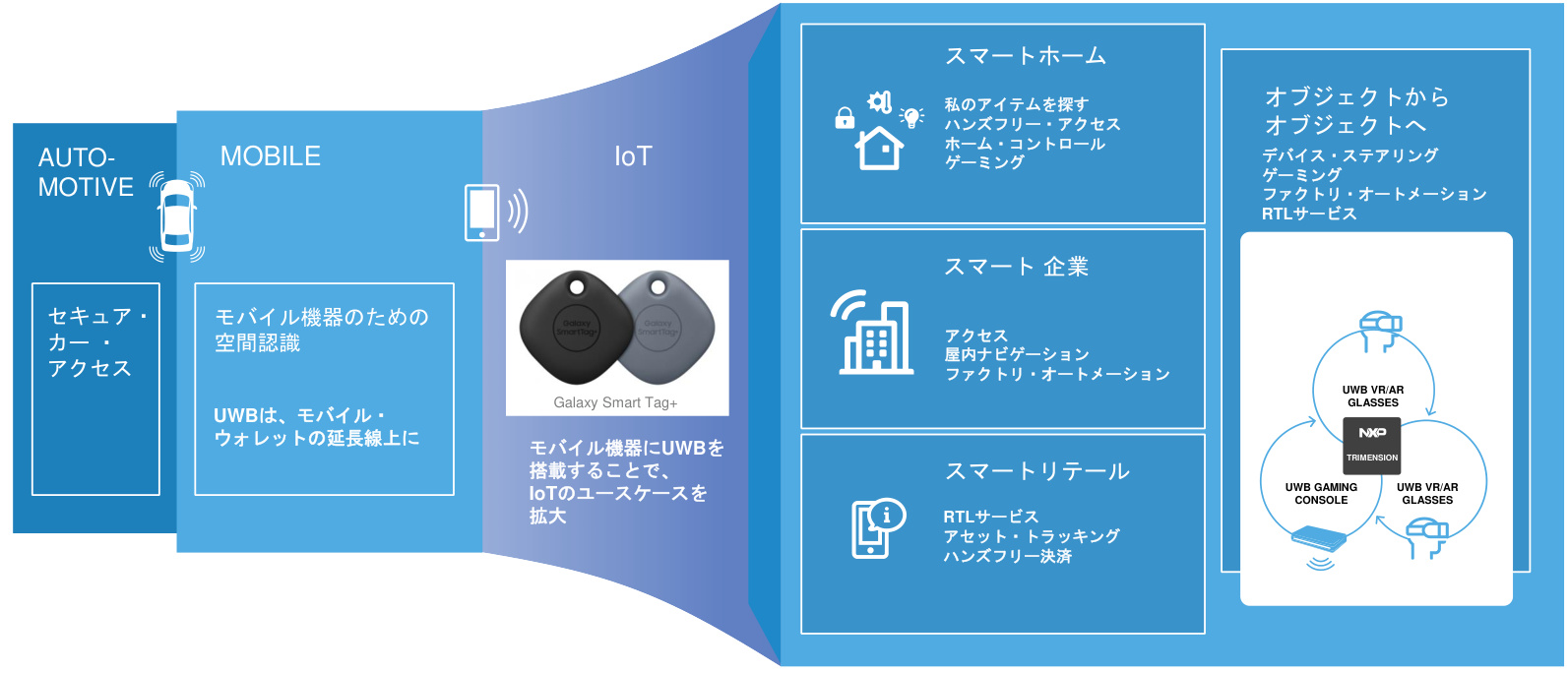

- UWB融合定位:

- 超宽带技术(UWB)提供厘米级测距,与视觉惯性数据融合后,商场导航精度达±0.3米。

- 超宽带技术(UWB)提供厘米级测距,与视觉惯性数据融合后,商场导航精度达±0.3米。

六、未来研究方向

- 跨模态学习:利用Transformer模型统一处理IMU时序数据与视觉特征;

- 边缘计算优化:轻量化SLAM算法(如MonoSLAM移动端部署帧率提升至20 fps);

- 多机器人协同建图:通过5G传输共享视觉惯性数据,减少单设备建图时间50%。

总结

视觉惯性数据融合在室内导航中的核心价值在于互补纠偏与环境适应性。通过紧耦合算法、多传感器冗余及深度学习优化,系统在复杂场景下的定位误差可控制在1%以内(如100米路径误差<1米)。随着MEMS传感器精度的提升(如下一代陀螺仪零偏不稳定性目标<5°/hr),以及边缘AI算力的发展,智能手机将成为室内外无缝导航的关键载体。

📚2 运行结果

部分代码:

%% Read Entire Video %%%%

mov = VideoReader('sample_video\aclab_video_TF.mp4'); %WIN_20170508_13_45_27_Pro

i=0;

while hasFrame(mov)

i=i+1;

vid = rgb2gray(readFrame(mov));

video(:,:,i)=vid;

end

%% Synchonize IMU and Video

video=video(:,:,1:size(video,3)/339:end); %obtain this number from csv file

%% Read IMU data %%%

showfig = 0;

l_start = 1;

l_end = 339; %size(video,3); obtain this number from csv file

frq=30;

filename='sample_video\aclab_data_TF.csv';

[data_IMU,data_lables,t] = iPhone_IMU_reading(filename,frq,l_start,l_end,showfig);

%%%Acceleration & Gravity data

x_g = data_IMU(:,5)*9.81; % X gravity * g

y_g = data_IMU(:,6)*9.81; % Y gravity * g

z_g = data_IMU(:,7)*9.81; % Z gravity * g

acc_x=data_IMU(:,2)*9.81; % X acceleration * g

acc_y=data_IMU(:,3)*9.81; % Y acceleration * g

acc_z=data_IMU(:,4)*9.81; % Z acceleration * g

%%%The 3 attitudes reported by iPhone

AttPitch = data_IMU(:,12); %rotation over x axis

AttYaw = data_IMU(:,13); %rotation over z axis

AttYaw = ThetaCorrect(AttYaw);

AttRoll = data_IMU(:,14); %rotation over y axis

%%%Angle computed by integration of gyro measurement

x_gyro = data_IMU(:,15);

y_gyro = data_IMU(:,16);

z_gyro = data_IMU(:,17);

delta_t = [t(1) ; t(2:end) - t(1:end-1)];

pitch_gyro = cumsum(x_gyro.*delta_t,1);

roll_gyro = cumsum(y_gyro.*delta_t,1);

yaw_gyro = cumsum(z_gyro.*delta_t,1);

%%%Angle computed by geometry of gravity

pitch_g = atan2(y_g , z_g) + pi;

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。

A. Farnoosh, M. Nabian, P. Closas and S. Ostadabbas, "First-person indoor navigation via vision-inertial data fusion," 2018 IEEE/ION Position, Location and Navigation Symposium (PLANS), Monterey, CA, USA, 2018, pp. 1213-1222, doi: 10.1109/PLANS.2018.8373507. keywords: {Estimation;Cameras;Three-dimensional displays;Accelerometers;Indoor navigation;Simultaneous localization and mapping;Computer vision;Data fusion;Expectation maximization algorithm;In-door navigation;Simultaneous localization and mapping (SLAM)},

🌈4 Matlab代码实现

更多推荐

已为社区贡献39条内容

已为社区贡献39条内容

所有评论(0)