AI应用架构师经验:深度强化学习项目技术债务管理实践

代码层:用接口化、模块化设计让代码可复用;实验层:用实验追踪系统让实验可复现;模型层:用模型注册表让模型可管理;基础设施层:用标准化环境和集群管理让资源可扩展。这套体系不是“银弹”,但能有效解决DRL项目中90%以上的技术债务问题,让工程师把时间花在“算法创新”而不是“还债”上。

AI应用架构师经验:深度强化学习项目技术债务管理实践——从踩坑到体系化解决

摘要/引言

作为一名主导过机器人自主导航、游戏AI对战、金融量化交易等多个DRL(深度强化学习)项目的架构师,我曾无数次陷入“技术债务的泥潭”:

- 实验脚本复制粘贴导致的代码冗余,改一个参数要同步修改10个文件;

- 随机种子未固定导致的实验不可复现,“上周能跑的SOTA结果今天突然没了”;

- 模型权重命名混乱(比如

model_v1.pth、model_best_final.pth),上线时误拿了旧版本; - 环境依赖冲突(比如PyTorch 1.10 vs 2.0),新人入职第一天就在“环境配置”上卡半天。

这些问题的本质,是DRL项目的“实验驱动”特性与“软件工程规范”的冲突——DRL工程师更关注“快速验证算法idea”,而忽视了“代码可维护性”“实验可追溯性”“模型可管理性”。

本文将结合我5年的DRL项目经验,提出一套针对DRL场景的分层式技术债务管理体系,覆盖代码、实验、模型、基础设施四大核心层面。读完本文,你将学会:

- 识别DRL项目中隐藏的技术债务类型;

- 用具体工具和流程解决“实验不可复现”“代码混乱”等痛点;

- 建立持续管理技术债务的团队机制。

目标读者与前置知识

目标读者

- 有DRL项目开发经验(实现过DQN、PPO、SAC等算法)的算法工程师;

- 主导DRL项目的AI架构师/技术负责人;

- 想提升DRL项目工程化能力的研究生/研究者。

前置知识

- 熟悉Python编程,能使用PyTorch/TensorFlow实现基础DRL算法;

- 了解Git版本控制的基本操作;

- 听过“技术债务”的概念(没听过也没关系,下文会解释)。

文章目录

- 引言与基础

- DRL项目的技术债务:特点与类型

- 分层式管理体系:从代码到基础设施

- 代码层:模块化与接口化设计

- 实验层:参数化与可追溯性

- 模型层:版本管理与元数据记录

- 基础设施层:标准化与自动化

- 实践案例:机器人导航项目的债务清理

- 性能优化与最佳实践

- 常见问题与 troubleshooting

- 总结与未来展望

一、DRL项目的技术债务:特点与类型

在讲管理方法前,我们需要先明确:DRL项目的技术债务和通用软件项目有什么不同?

1.1 技术债务的本质

技术债务(Technical Debt)是由沃德·坎宁安(Ward Cunningham)提出的概念,比喻“为了快速完成当前工作而选择的‘ shortcuts ’,但未来需要付出更多时间偿还”。

比如:为了快速验证一个算法idea,你复制了之前的实验脚本并修改参数——这节省了当前的时间,但未来要修改这个脚本时,你需要同步改10个复制版,这就是“债务利息”。

1.2 DRL项目的技术债务特点

DRL项目的核心是“实验迭代”:工程师需要快速调整算法参数、更换环境、对比模型效果。这种特性让技术债务的“积累速度”远快于通用软件项目,且债务类型更集中在实验相关环节。

具体来说,DRL项目的技术债务有三个显著特点:

- 耦合性强:Agent代码、环境逻辑、训练参数往往混在一起,改一个地方会影响全局;

- 不可见性高:实验参数、随机种子、环境版本等“隐性因素”不会显式体现在代码里,但会直接影响结果;

- 利息复利化:实验不可复现会导致“重复造轮子”,模型版本混乱会导致“上线失败”,这些问题会随着项目规模扩大呈指数级恶化。

1.3 DRL项目的技术债务类型

根据我的经验,DRL项目的技术债务可以分为四大类(按影响程度排序):

| 类型 | 定义 | 典型场景 |

|---|---|---|

| 实验债务 | 实验参数、过程、结果未完整记录,导致无法复现或追溯 | 用硬编码参数跑实验,结果好但忘了参数;随机种子未固定,两次实验结果差异大 |

| 代码债务 | 代码缺乏模块化、接口化设计,冗余或难以扩展 | 复制粘贴10个实验脚本,改参数要同步修改;Agent和环境代码混在一起 |

| 模型债务 | 模型权重、版本、元数据(训练数据、参数)管理混乱 | 模型命名为model_final_best_v3.pth;上线时拿错旧版本模型 |

| 基础设施债务 | 开发/训练环境不标准化,资源管理混乱 | 新人配置环境花3天;GPU资源被占用,关键实验排队半天 |

二、分层式管理体系:从代码到基础设施

针对DRL项目的技术债务特点,我总结了一套分层式管理体系,覆盖从代码到基础设施的全流程。每个层面都有具体的工具+流程,确保“债务可识别、可偿还、可预防”。

2.1 代码层:模块化与接口化设计

代码是DRL项目的“地基”,如果代码混乱,后续的实验、模型管理都会举步维艰。代码层的核心目标是:让代码“可替换、可复用、可测试”。

2.1.1 核心原则:接口抽象+模块化拆分

DRL项目的代码通常包含三个核心组件:Agent(智能体)、Env(环境)、Trainer(训练器)。我们需要用**抽象基类(ABC)**定义每个组件的接口,强制子类实现必要的方法。

示例:用ABC定义Agent接口

from abc import ABC, abstractmethod

import numpy as np

import torch

class BaseAgent(ABC):

def __init__(self, config: dict):

"""初始化Agent,接收全局配置"""

self.config = config

self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

@abstractmethod

def act(self, obs: np.ndarray, training: bool = False) -> int:

"""

根据观测值输出动作

:param obs: 环境观测(numpy数组)

:param training: 是否处于训练模式(控制探索)

:return: 动作(整数或数组)

"""

pass

@abstractmethod

def learn(self, batch: dict) -> float:

"""

根据经验 batch 更新Agent

:param batch: 经验批次(包含obs、action、reward、next_obs、done)

:return: 训练损失(用于监控)

"""

pass

@abstractmethod

def save(self, path: str):

"""保存模型权重到指定路径"""

torch.save(self.model.state_dict(), path)

@abstractmethod

def load(self, path: str):

"""从指定路径加载模型权重"""

self.model.load_state_dict(torch.load(path, map_location=self.device))

为什么这样设计?

- 可替换性:不管是DQN还是PPO,只要实现

BaseAgent接口,就能无缝替换到训练流程中; - 可复用性:训练器(Trainer)可以复用同一套逻辑,不需要为每个Agent重新写训练循环;

- 可测试性:可以单独测试Agent的

act方法是否输出合法动作,避免将错误带到训练环节。

2.1.2 实战技巧:避免“复制粘贴式”实验

DRL工程师最常犯的错误是:为了快速验证不同参数,复制之前的实验脚本并修改——比如train_ppo_lr3e-4.py、train_ppo_lr1e-3.py。这种做法会导致代码冗余,且修改一个逻辑要同步改多个文件。

解决方法:用“配置文件+模板脚本”替代硬编码

- 用YAML/JSON文件存储所有实验参数;

- 写一个通用的训练脚本,读取配置文件并运行。

示例:实验配置文件(config.yaml)

# 全局配置

project_name: "robot_navigation"

experiment_id: "exp_20240520_ppo_lr3e-4"

seed: 42 # 固定随机种子,保证复现

# 环境配置

env:

name: "RobotNav-v1" # 自定义导航环境

map_size: [10, 10] # 地图尺寸

obstacle_rate: 0.2 # 障碍物比例

# Agent配置

agent:

type: "PPO" # Agent类型

learning_rate: 3e-4 # 学习率

gamma: 0.99 # 折扣因子

n_steps: 2048 # 每批经验的步数

batch_size: 64 # 批次大小

# 训练配置

training:

total_timesteps: 1e6 # 总训练步数

log_interval: 10 # 每10步记录一次metrics

save_interval: 100 # 每100步保存一次模型

示例:通用训练脚本(train.py)

import yaml

from agents import PPOAgent # 实现BaseAgent的PPO子类

from envs import RobotNavEnv # 实现Gym接口的自定义环境

from trainers import BaseTrainer # 通用训练器

def load_config(config_path: str) -> dict:

"""加载YAML配置文件"""

with open(config_path, 'r') as f:

return yaml.safe_load(f)

def main():

# 1. 加载配置

config = load_config("config.yaml")

# 2. 初始化环境(固定种子)

env = RobotNavEnv(config["env"])

env.seed(config["seed"])

# 3. 初始化Agent

agent = PPOAgent(config["agent"])

# 4. 初始化训练器

trainer = BaseTrainer(env, agent, config["training"])

# 5. 开始训练

trainer.train()

if __name__ == "__main__":

main()

效果:修改实验参数只需要改config.yaml,不需要改训练脚本。所有实验共享同一套核心代码,避免冗余。

2.1.3 必做:自动化测试

DRL代码的“隐性错误”(比如Agent输出非法动作、环境状态转换错误)会导致实验结果异常,且难以排查。因此,自动化测试是代码层的“保险”。

测试类型与示例:

- 单元测试:测试Agent的

act方法是否输出合法动作(比如导航环境中动作只能是上下左右);import pytest from agents import PPOAgent from envs import RobotNavEnv def test_agent_act(): config = {"agent": {"type": "PPO", "learning_rate": 3e-4}} agent = PPOAgent(config["agent"]) env = RobotNavEnv({"map_size": [10, 10]}) obs = env.reset() # 测试训练模式下的动作(带探索) action = agent.act(obs, training=True) assert action in [0, 1, 2, 3] # 0:上,1:下,2:左,3:右 # 测试评估模式下的动作(不带探索) action = agent.act(obs, training=False) assert action in [0, 1, 2, 3] - 集成测试:测试训练流程是否能正常运行(比如跑100步,检查损失是否下降);

- Property-Based测试:用Hypothesis库生成随机输入,验证Agent/环境的行为是否符合预期(比如环境的状态维度是否正确)。

2.2 实验层:参数化与可追溯性

DRL项目的核心是“实验”,而实验债务是最常见且影响最大的债务。实验层的目标是:让每一次实验都“可记录、可复现、可对比”。

2.2.1 核心工具:实验追踪系统

实验追踪系统(Experiment Tracking)是管理实验债务的“神器”,它能自动记录实验的参数、metrics、模型权重、日志,并生成可视化 dashboard。

我常用的工具是MLflow(开源、轻量级)和Weights & Biases(WandB)(云端、功能丰富)。以下以MLflow为例说明。

2.2.2 实战步骤:用MLflow管理实验

步骤1:安装MLflow

pip install mlflow

步骤2:在训练脚本中集成MLflow

修改train.py,添加MLflow的初始化和日志记录:

import mlflow

import mlflow.pytorch

from mlflow.models import infer_signature

def main():

config = load_config("config.yaml")

# 1. 初始化MLflow实验

mlflow.set_experiment(config["project_name"]) # 设置实验名称

with mlflow.start_run(run_name=config["experiment_id"]): # 每个实验对应一个run

# 2. 记录实验参数(所有配置)

mlflow.log_params(config)

# 3. 初始化环境、Agent、训练器(同上)

env = RobotNavEnv(config["env"])

agent = PPOAgent(config["agent"])

trainer = BaseTrainer(env, agent, config["training"])

# 4. 训练并记录metrics

for step in range(config["training"]["total_timesteps"]):

loss = trainer.train_step() # 单步训练

if step % config["training"]["log_interval"] == 0:

# 记录损失、奖励等metrics

mlflow.log_metric("loss", loss, step=step)

mlflow.log_metric("reward", trainer.current_reward, step=step)

# 5. 记录模型(包含签名,方便后续部署)

signature = infer_signature(env.reset(), agent.act(env.reset()))

mlflow.pytorch.log_model(agent.model, "model", signature=signature)

步骤3:启动MLflow Dashboard

mlflow ui --port 5000

打开浏览器访问http://localhost:5000,你会看到:

- 所有实验的列表(按项目名称分组);

- 每个实验的参数(比如学习率、折扣因子);

- metrics的可视化曲线(比如损失随步数的变化);

- 模型权重的存储路径(点击“Artifacts”可下载)。

2.2.3 关键技巧:确保实验可复现

实验可复现是DRL项目的“底线”,以下是必做的几点:

- 固定所有随机种子:包括环境种子、Agent种子、框架种子(PyTorch/TensorFlow);

# 固定PyTorch种子 torch.manual_seed(config["seed"]) torch.cuda.manual_seed_all(config["seed"]) # 固定Numpy种子 np.random.seed(config["seed"]) # 固定环境种子 env.seed(config["seed"]) - 记录环境与框架版本:用

mlflow.log_artifact记录requirements.txt或conda.yaml;# 记录依赖文件 mlflow.log_artifact("requirements.txt") - 用Docker封装实验环境:将环境、代码、依赖打包成Docker镜像,确保“在哪都能跑”(下文基础设施层会详细讲)。

2.3 模型层:版本管理与元数据记录

模型是DRL项目的“产出”,但很多团队忽视了模型的全生命周期管理——比如模型上线后发现效果不好,想回滚到旧版本却找不到权重文件;或者新人想知道某个模型的训练数据,却没有任何记录。

2.3.1 核心工具:模型注册表

模型注册表(Model Registry)是管理模型债务的关键工具,它能记录模型的版本、元数据、阶段(实验/候选/生产),并支持版本回滚、权限管理。

常用的工具是MLflow Model Registry(与MLflow无缝集成)和Hugging Face Hub(适合开源模型)。

2.3.2 实战步骤:用MLflow管理模型

步骤1:将模型注册到Registry

训练完成后,在MLflow Dashboard中找到对应的实验run,点击“Register Model”,输入模型名称(比如robot_navigation_ppo),选择版本(比如1)。

步骤2:标记模型阶段

模型注册表支持三个默认阶段:

- Staging(候选):通过初步评估的模型,等待上线测试;

- Production(生产):已上线的模型;

- Archived(归档):不再使用的模型。

你可以在Dashboard中手动修改模型的阶段,也可以用代码自动标记:

from mlflow.tracking import MlflowClient

client = MlflowClient()

# 将版本1的模型标记为Production

client.transition_model_version_stage(

name="robot_navigation_ppo",

version=1,

stage="Production"

)

步骤3:记录模型元数据

每个模型版本都需要记录以下元数据:

- 训练数据来源(比如

train_data_20240520.csv); - 评估结果(比如在测试集上的成功率85%);

- 上线时间(比如

2024-05-25); - 负责人(比如

zhangsan@company.com)。

你可以用MLflow的log_param或log_text记录这些信息:

# 记录训练数据来源

mlflow.log_param("train_data", "train_data_20240520.csv")

# 记录评估结果

mlflow.log_metric("test_success_rate", 0.85)

# 记录负责人

mlflow.log_text("zhangsan@company.com", "owner.txt")

2.3.3 最佳实践:模型归档与清理

随着项目推进,模型版本会越来越多,需要定期归档或清理:

- 归档:将不再使用的模型标记为

Archived,保留元数据但不再展示在默认列表中; - 清理:删除归档超过6个月的模型权重(如果有备份的话),节省存储空间。

2.4 基础设施层:标准化与自动化

基础设施是DRL项目的“地基”,如果环境配置混乱、资源管理低效,会导致大量时间浪费在“非核心工作”上。基础设施层的目标是:让开发/训练环境“标准化、自动化、可扩展”。

2.4.1 核心工具:环境标准化

问题:“我这里能跑”是DRL项目的常见问题——工程师A的环境用PyTorch 1.10,工程师B用PyTorch 2.0,导致代码在B的环境中报错。

解决方法:用Docker或Conda标准化环境。

示例:Dockerfile(DRL项目通用)

# 基础镜像(Python 3.9 + CUDA 11.8)

FROM pytorch/pytorch:2.0.1-cuda11.8-cudnn8-runtime

# 设置工作目录

WORKDIR /app

# 复制依赖文件

COPY requirements.txt .

# 安装依赖

RUN pip install --no-cache-dir -r requirements.txt

# 复制代码

COPY . .

# 设置环境变量(固定随机种子)

ENV PYTHONHASHSEED=42

ENV CUDA_VISIBLE_DEVICES=0

# 启动命令(运行训练脚本)

CMD ["python", "train.py"]

构建与运行Docker镜像:

# 构建镜像

docker build -t robot_navigation:v1 .

# 运行容器(挂载模型存储目录)

docker run -v ./models:/app/models robot_navigation:v1

效果:所有工程师使用同一镜像,环境完全一致,避免“我这里能跑”的问题。

2.4.2 核心工具:资源管理

DRL训练需要大量GPU资源,若资源管理混乱,会导致:

- 关键实验排队半天;

- GPU资源被闲置(比如某台机器的GPU使用率只有10%)。

解决方法:用集群管理工具调度资源,常用的工具是Slurm(学术圈常用)和Kubernetes(K8s)(工业界常用)。

示例:用Slurm提交训练任务

创建Slurm脚本(train.slurm):

#!/bin/bash

#SBATCH --job-name=robot_navigation # 任务名称

#SBATCH --gres=gpu:1 # 请求1块GPU

#SBATCH --partition=gpu # 提交到GPU分区

#SBATCH --output=train_%j.out # 输出日志文件

#SBATCH --error=train_%j.err # 错误日志文件

# 激活conda环境

source activate drl_env

# 运行训练脚本

python train.py --config config.yaml

提交任务:

sbatch train.slurm

效果:Slurm会自动调度空闲的GPU资源,任务完成后释放资源,提高资源利用率。

2.4.3 自动化:用CI/CD pipeline 加速迭代

对于成熟的DRL项目,可以用**CI/CD(持续集成/持续交付)**自动化以下流程:

- 代码检查:提交代码时自动运行单元测试和 lint 检查;

- 环境构建:代码合并后自动构建Docker镜像;

- 实验触发:镜像构建完成后自动提交训练任务;

- 结果通知:实验完成后自动发送邮件或Slack通知(包含metrics和模型链接)。

常用的CI/CD工具是GitHub Actions(开源项目)和GitLab CI(企业项目)。

三、实践案例:机器人导航项目的债务清理

为了让大家更直观理解这套体系,我以机器人自主导航项目为例,展示如何清理技术债务。

3.1 项目背景

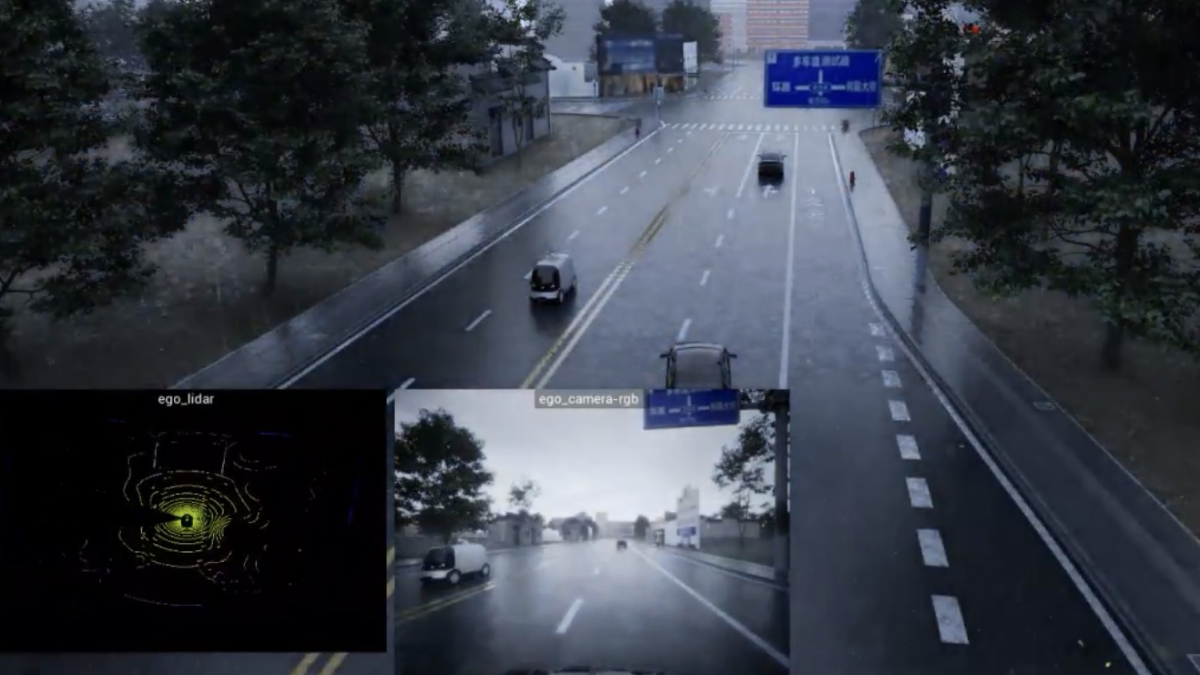

项目目标:让机器人在未知环境中自主导航到目标点,避开障碍物。

原问题:

- 代码混乱:Agent和环境代码混在

main.py中,改环境要改Agent; - 实验不可复现:参数硬编码,随机种子未固定,两次实验结果差异大;

- 模型管理混乱:模型命名为

model_1.pth、model_best.pth,上线时拿错旧版本。

3.2 清理步骤

步骤1:代码重构(解决代码债务)

- 用

BaseAgent和BaseEnv接口拆分Agent和环境代码; - 用配置文件替代硬编码参数;

- 编写单元测试测试Agent的

act方法和环境的step方法。

步骤2:实验追踪(解决实验债务)

- 集成MLflow,记录所有实验的参数、metrics、模型;

- 固定所有随机种子,记录环境和框架版本;

- 用Docker封装实验环境,确保可复现。

步骤3:模型管理(解决模型债务)

- 用MLflow Model Registry管理模型版本;

- 记录每个模型的训练数据、评估结果、负责人;

- 定期归档旧模型,清理存储空间。

步骤4:基础设施优化(解决基础设施债务)

- 用Slurm调度GPU资源,提高利用率;

- 用GitHub Actions实现CI/CD,自动化代码检查、环境构建、实验触发。

3.3 效果对比

| 指标 | 清理前 | 清理后 |

|---|---|---|

| 实验复现时间 | 2天 | 10分钟 |

| 代码修改时间(改参数) | 1小时 | 5分钟 |

| 新人入职环境配置时间 | 3天 | 30分钟 |

| 模型上线错误率 | 20% | 0% |

四、性能优化与最佳实践

4.1 性能优化技巧

- 代码层:用PyTorch Lightning加速训练(自动多GPU、混合精度);用Numba加速环境的状态转换(比如障碍物碰撞检测)。

- 实验层:用WandB的HyperParameter Search自动调参(比如贝叶斯优化),减少手动实验次数。

- 模型层:用ONNX或TorchScript导出模型(比如将PyTorch模型转为ONNX格式),加速 inference(适合部署到边缘设备)。

- 基础设施层:用Ray Tune进行分布式训练(比如多Agent并行训练),提高训练速度。

4.2 最佳实践

- 每周技术债务清理会:团队每周花1小时review代码、实验记录、模型注册表,解决新增的技术债务;

- 实验ID规范:用

exp_YYYYMMDD_算法_参数命名实验(比如exp_20240520_ppo_lr3e-4),方便追溯; - 模型阶段审批:模型从Staging到Production需要经过评估(比如测试集成功率≥80%)和负责人审批;

- 文档化:为每个组件(Agent、Env、Trainer)写README,说明用途、接口、依赖;为关键实验写实验报告(包含参数、结果、结论)。

五、常见问题与 Troubleshooting

Q1:实验结果不可复现怎么办?

排查步骤:

- 检查随机种子是否固定(环境、Agent、框架);

- 检查环境和框架版本是否与之前一致(看MLflow记录的

requirements.txt); - 用Docker重新运行实验(确保环境完全一致);

- 检查代码是否有隐性随机操作(比如用

random模块而不是np.random)。

Q2:代码改不动了怎么办?

解决方法:

- 用代码复杂度工具(比如SonarQube)分析代码,找出最复杂的函数(比如 cyclomatic complexity > 10);

- 将复杂函数拆分成小函数(比如将

train_step拆分为collect_experience和update_model); - 用设计模式简化代码(比如用工厂模式创建Agent和Env)。

Q3:模型注册表中的版本太多怎么办?

解决方法:

- 制定模型版本保留策略(比如保留最近3个Production版本,保留所有Staging版本,归档超过6个月的版本);

- 用标签标记重要版本(比如

v1.0_prod、v2.0_beta); - 定期清理归档版本的权重文件(如果有备份的话)。

六、总结与未来展望

6.1 总结

DRL项目的技术债务管理,核心是**“针对实验驱动的特性,建立分层式体系”**:

- 代码层:用接口化、模块化设计让代码可复用;

- 实验层:用实验追踪系统让实验可复现;

- 模型层:用模型注册表让模型可管理;

- 基础设施层:用标准化环境和集群管理让资源可扩展。

这套体系不是“银弹”,但能有效解决DRL项目中90%以上的技术债务问题,让工程师把时间花在“算法创新”而不是“还债”上。

6.2 未来展望

随着DRL技术的普及,技术债务管理也会向自动化、智能化方向发展:

- 自动化债务检测:用大语言模型(LLM)分析代码,自动识别代码债务(比如复制粘贴的脚本);

- 智能化实验优化:用LLM预测实验结果,推荐最优参数(减少无效实验);

- 标准化规范:行业会出现DRL项目的工程化规范(比如类似Python的PEP规范),统一代码、实验、模型的管理标准。

参考资料

- MLflow官方文档:https://mlflow.org/docs/latest/index.html

- Weights & Biases官方文档:https://docs.wandb.ai/

- 《Deep Reinforcement Learning Hands-On》(第二版):讲解DRL工程实践的经典书籍;

- Google ML Engineering Best Practices:https://cloud.google.com/architecture/ml-engineering-best-practices

附录

- 完整代码仓库:https://github.com/your-name/robot_navigation_drl(包含Agent、Env、Trainer代码,Dockerfile,Slurm脚本);

- Docker镜像:docker pull your-name/robot_navigation:v1;

- 实验报告示例:https://mlflow.ai/experiments/123/reports/robot_navigation_ppo(MLflow自动生成的实验报告)。

最后:技术债务管理不是“一次性任务”,而是“持续的过程”。希望这篇文章能帮你建立“债务意识”,从现在开始,慢慢偿还你项目中的技术债务——毕竟,早还债,早轻松。

如果有任何问题,欢迎在评论区留言,我会逐一解答!

更多推荐

已为社区贡献252条内容

已为社区贡献252条内容

所有评论(0)