实战案例|某家具厂智能生产调度AI系统架构优化:架构师用这4招解决资源浪费

import gym"""生产调度强化学习环境"""self.num_machines = num_machines # 机器数量self.num_orders = num_orders # 订单数量# 初始化状态:机器状态(剩余加工时间)、订单优先级、加工时间、物料可用量self.machine_states = np.zeros(num_machines, dtype=np.float32)

实战案例|某家具厂智能生产调度AI系统架构优化:架构师用这4招解决资源浪费

1. 引言:家具厂的“生产痛点”与“智能调度”的迫切需求

1.1 场景背景:传统家具厂的生产困境

某中型定制家具厂(以下简称“XX家具”)主要生产定制衣柜、沙发、餐桌等产品,年产能约5万件。随着定制化需求的增长,企业面临三大核心问题:

- 订单波动大:定制订单的数量、类型、优先级每天都在变化,传统MRP(物料需求计划)系统无法快速响应。

- 资源利用率低:切割、打磨、组装、喷漆等工序的机器经常出现“忙的忙死,闲的闲死”的情况,设备利用率长期徘徊在60%-65%。

- 交付延迟严重:由于调度依赖老工人的经验,紧急订单经常被插队,导致常规订单延迟率高达20%,客户投诉率逐年上升。

1.2 问题根源:传统调度系统的“三大缺陷”

XX家具原来的生产调度系统基于**“流程驱动+人工干预”**模式,架构如图1所示:

图1:传统生产调度架构

这种架构的问题在于:

- 流程僵化:MRP计划基于固定的BOM(物料清单)和工艺路线,无法应对定制订单的动态变化。

- 数据孤岛:订单、物料、设备数据分散在ERP、MES、WMS等系统,无法实时整合,导致调度决策滞后。

- 决策依赖经验:人工调度受限于个人经验,无法优化全局资源配置,经常出现“局部最优但全局浪费”的情况。

1.3 目标:用AI架构优化解决“资源浪费”

XX家具的核心需求是:通过智能调度系统,提升设备利用率30%以上,降低交付延迟率至5%以下,同时减少调度人员的工作负担。

作为架构师,我团队的解决方案是:构建“数据-模型双驱动”的智能调度架构,通过4大优化招术,解决传统系统的痛点。

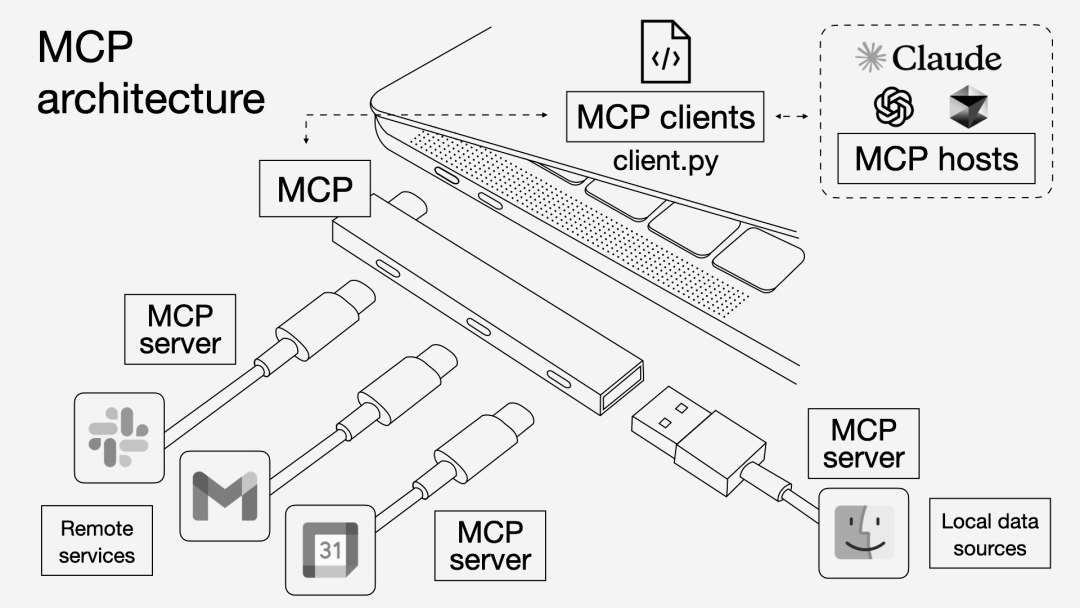

2. 优化招术一:从“流程驱动”到“数据-模型双驱动”的架构重构

2.1 新架构设计理念:“数据是燃料,模型是引擎”

传统架构以“流程”为核心,而智能调度架构以“数据”和“模型”为双核心,核心逻辑是:

- 数据层:整合全链路数据,提供实时、准确的决策依据;

- 模型层:用AI模型(强化学习、运筹优化)替代人工经验,实现全局最优调度;

- 调度层:结合模型输出与业务规则,生成可执行的调度计划;

- 执行层:将调度计划同步到MES系统,控制机器执行;

- 反馈层:收集执行数据,持续优化模型。

2.2 新架构图:“五层闭环”体系

新架构分为数据层、特征层、模型层、调度层、执行层,并通过反馈机制形成闭环(如图2所示):

graph TD

%% 数据层

A[数据来源:ERP、MES、WMS、IoT传感器] --> B[实时数据管道:Kafka + Flink]

B --> C[数据湖:Hudi + S3]

C --> D[离线数据仓库:BigQuery]

%% 特征层

C --> E[实时特征服务:Feast]

D --> E

E --> F[特征存储:Redis + Parquet]

%% 模型层

F --> G[模型训练:TensorFlow + Kubeflow]

G --> H[模型仓库:MLflow]

H --> I[模型推理:Triton Inference Server]

%% 调度层

I --> J[动态调度引擎:强化学习模型 + 规则引擎]

K[订单管理系统] --> J

L[物料管理系统] --> J

%% 执行层

J --> M[MES系统]

M --> N[机器控制器]

%% 反馈层

N --> O[监控系统:Prometheus + Grafana]

O --> C[数据湖]

图2:智能生产调度新架构

2.3 各层职责说明

- 数据层:通过Kafka收集ERP(订单)、MES(生产执行)、WMS(物料)、IoT(设备状态)的实时数据,用Flink做清洗、聚合(如计算设备空闲率、物料库存预警),存入Hudi数据湖(支持增量查询)和BigQuery离线仓库(支持批量分析)。

- 特征层:用Feast构建实时特征服务,提取“设备当前状态”“订单优先级”“物料可用量”等特征,存储在Redis(实时)和Parquet(离线)中,供模型训练和推理使用。

- 模型层:用Kubeflow搭建分布式训练平台,训练强化学习模型(核心)和运筹优化模型(辅助),模型存入MLflow仓库,通过Triton实现低延迟推理(<1秒)。

- 调度层:动态调度引擎加载模型输出,结合业务规则(如“紧急订单必须在48小时内完成”),生成调度计划(如“订单A分配给机器3,10:00开始加工”)。

- 执行层:MES系统将调度计划转换为机器指令,控制设备执行;同时收集执行数据(如实际加工时间、延迟情况)。

- 反馈层:Prometheus监控生产指标(设备利用率、交付延迟率),Grafana可视化展示,数据同步回数据湖,用于模型重新训练,形成“数据-模型-执行-反馈”的闭环。

3. 优化招术二:基于强化学习的动态调度引擎设计

3.1 问题建模:生产调度的“数学本质”

生产调度问题可以抽象为带约束的组合优化问题,目标是在满足订单优先级、物料 availability、设备能力等约束下,最小化总延迟时间和设备空闲时间。

目标函数(综合优化目标):

min(α×总延迟时间+β×总设备空闲时间−γ×按时完成订单数) \min \left( \alpha \times \text{总延迟时间} + \beta \times \text{总设备空闲时间} - \gamma \times \text{按时完成订单数} \right) min(α×总延迟时间+β×总设备空闲时间−γ×按时完成订单数)

其中,α,β,γ\alpha, \beta, \gammaα,β,γ 是权重系数(根据业务需求调整,如α=0.6\alpha=0.6α=0.6,β=0.3\beta=0.3β=0.3,γ=0.1\gamma=0.1γ=0.1)。

约束条件:

- 每个订单只能在一台机器上加工;

- 机器同一时间只能处理一个订单;

- 订单加工必须等待物料到位;

- 紧急订单的开始时间不能晚于其最晚开始时间。

3.2 强化学习模型设计:“调度员”的AI替身

传统运筹优化方法(如整数规划)虽然能找到全局最优解,但计算时间随问题规模指数增长,无法应对实时调度需求(如100台机器、1000个订单的场景)。

强化学习(RL)通过“试错”学习最优策略,适合动态、不确定的生产环境。我们选择**PPO(Proximal Policy Optimization)**算法(稳定、样本效率高),设计了“生产调度环境”。

3.2.1 状态空间(State):调度决策的“输入信息”

状态空间包含设备状态、订单状态、物料状态三部分,用向量表示:

State=[s1,s2,...,sm,p1,t1,m1,...,mk] \text{State} = \left[ s_1, s_2, ..., s_m, p_1, t_1, m_1, ..., m_k \right] State=[s1,s2,...,sm,p1,t1,m1,...,mk]

其中:

- sis_isi:第iii台机器的状态(0=空闲,>0=剩余加工时间);

- p1p_1p1:当前待处理订单的优先级(1-5,越高越紧急);

- t1t_1t1:当前待处理订单的加工时间;

- mjm_jmj:第jjj种物料的可用量(是否满足当前订单需求)。

3.2.2 动作空间(Action):调度决策的“输出”

动作空间是离散空间,表示将当前待处理订单分配给某台机器:

Action={0,1,...,m−1} \text{Action} = \{0, 1, ..., m-1\} Action={0,1,...,m−1}

其中,mmm是机器数量(如m=50m=50m=50)。

3.2.3 奖励函数(Reward):引导模型学习“正确”的决策

奖励函数是强化学习的核心,直接决定模型的性能。我们设计了多目标奖励函数:

Reward=λ1×pt⏟优先级奖励−λ2×tp⏟加工时间惩罚−λ3×dt⏟延迟惩罚+λ4×um⏟设备利用率奖励 \text{Reward} = \underbrace{\lambda_1 \times p_t}_{\text{优先级奖励}} - \underbrace{\lambda_2 \times t_p}_{\text{加工时间惩罚}} - \underbrace{\lambda_3 \times d_t}_{\text{延迟惩罚}} + \underbrace{\lambda_4 \times u_m}_{\text{设备利用率奖励}} Reward=优先级奖励

λ1×pt−加工时间惩罚

λ2×tp−延迟惩罚

λ3×dt+设备利用率奖励

λ4×um

其中:

- ptp_tpt:当前订单的优先级(越高,奖励越高);

- tpt_ptp:当前订单的加工时间(越长,惩罚越高);

- dtd_tdt:当前订单的延迟时间(若延迟,惩罚越高);

- umu_mum:分配后机器的利用率(越高,奖励越高);

- λ1−λ4\lambda_1-\lambda_4λ1−λ4:权重系数(通过实验调整,如λ1=2\lambda_1=2λ1=2,λ2=0.1\lambda_2=0.1λ2=0.1,λ3=5\lambda_3=5λ3=5,λ4=1\lambda_4=1λ4=1)。

3.3 代码实现:用PPO训练调度模型

我们用Stable Baselines3(Python强化学习库)实现了调度模型,以下是核心代码:

3.3.1 定义生产调度环境

import gym

from gym import spaces

import numpy as np

from stable_baselines3 import PPO

from stable_baselines3.common.env_util import make_vec_env

class ProductionSchedulerEnv(gym.Env):

"""生产调度强化学习环境"""

def __init__(self, num_machines=50, num_orders=1000):

super().__init__()

self.num_machines = num_machines # 机器数量

self.num_orders = num_orders # 订单数量

# 初始化状态:机器状态(剩余加工时间)、订单优先级、加工时间、物料可用量

self.machine_states = np.zeros(num_machines, dtype=np.float32) # 0=空闲

self.order_priorities = np.random.randint(1, 6, size=num_orders) # 1-5级优先级

self.order_processing_times = np.random.randint(10, 120, size=num_orders) # 加工时间(分钟)

self.material_availability = np.random.choice([0, 1], size=num_orders, p=[0.1, 0.9]) # 物料是否可用(1=可用)

self.current_order_idx = 0 # 当前待处理订单索引

# 状态空间:机器状态(num_machines) + 当前订单优先级 + 加工时间 + 物料可用量

self.observation_space = spaces.Box(

low=0, high=np.inf,

shape=(num_machines + 3,),

dtype=np.float32

)

# 动作空间:选择机器(0~num_machines-1)

self.action_space = spaces.Discrete(num_machines)

def reset(self):

"""重置环境,返回初始状态"""

self.machine_states = np.zeros(self.num_machines, dtype=np.float32)

self.order_priorities = np.random.randint(1, 6, size=self.num_orders)

self.order_processing_times = np.random.randint(10, 120, size=self.num_orders)

self.material_availability = np.random.choice([0, 1], size=self.num_orders, p=[0.1, 0.9])

self.current_order_idx = 0

return self._get_observation()

def _get_observation(self):

"""构造状态向量"""

if self.current_order_idx < self.num_orders:

# 当前订单的状态:优先级、加工时间、物料可用量

order_state = np.array([

self.order_priorities[self.current_order_idx],

self.order_processing_times[self.current_order_idx],

self.material_availability[self.current_order_idx]

], dtype=np.float32)

else:

# 所有订单处理完毕,用0填充

order_state = np.zeros(3, dtype=np.float32)

# 合并机器状态和订单状态

obs = np.concatenate([self.machine_states, order_state])

return obs

def step(self, action):

"""执行动作,返回下一个状态、奖励、是否结束、额外信息"""

reward = 0.0

done = False

info = {}

# 检查是否有未处理的订单

if self.current_order_idx >= self.num_orders:

done = True

return self._get_observation(), reward, done, info

# 获取当前订单信息

current_order = self.current_order_idx

priority = self.order_priorities[current_order]

processing_time = self.order_processing_times[current_order]

material_available = self.material_availability[current_order]

# 检查物料是否可用

if not material_available:

# 物料不足,无法加工,惩罚

reward -= 10.0

info["reason"] = "Material not available"

return self._get_observation(), reward, done, info

# 执行动作:选择机器

machine_id = action

if self.machine_states[machine_id] > 0:

# 机器忙碌,无法分配,惩罚

reward -= 5.0

info["reason"] = "Machine busy"

else:

# 分配成功,更新机器状态

self.machine_states[machine_id] = processing_time

# 计算奖励:优先级奖励 - 加工时间惩罚

reward += priority * 2.0 - processing_time * 0.1

# 处理下一个订单

self.current_order_idx += 1

# 模拟时间流逝:所有机器的剩余加工时间减1(每分钟更新一次)

self.machine_states = np.maximum(self.machine_states - 1, 0)

# 检查是否所有订单处理完毕

if self.current_order_idx >= self.num_orders and np.all(self.machine_states == 0):

done = True

return self._get_observation(), reward, done, info

3.3.2 训练PPO模型

# 创建向量环境(加速训练)

env = make_vec_env(ProductionSchedulerEnv, n_envs=4)

# 初始化PPO模型

model = PPO(

policy="MlpPolicy", # 多层感知器策略

env=env,

learning_rate=3e-4,

n_steps=2048,

batch_size=64,

n_epochs=10,

gamma=0.99, # 折扣因子

verbose=1

)

# 训练模型(100万步)

model.learn(total_timesteps=1_000_000)

# 保存模型

model.save("production_scheduler_ppo")

3.3.3 模型推理(实时调度)

import numpy as np

from stable_baselines3 import PPO

# 加载模型

model = PPO.load("production_scheduler_ppo")

# 初始化环境(模拟生产场景)

env = ProductionSchedulerEnv(num_machines=50, num_orders=1000)

obs = env.reset()

# 模拟实时调度(每分钟一次决策)

for _ in range(10000):

# 模型预测动作(选择机器)

action, _ = model.predict(obs, deterministic=True)

# 执行动作,获取下一个状态

obs, reward, done, info = env.step(action)

# 打印调度信息

if info.get("reason"):

print(f"调度失败:{info['reason']}")

else:

print(f"成功将订单{env.current_order_idx-1}分配给机器{action}")

# 检查是否结束

if done:

break

3.4 模型部署:实时推理服务

为了满足生产环境的低延迟需求(<1秒),我们用Triton Inference Server部署模型:

- 将PPO模型转换为ONNX格式(支持跨框架推理);

- 配置Triton服务(指定模型路径、批处理大小、并发数);

- 用FastAPI搭建调度API,接收订单和设备状态,调用Triton模型获取调度结果,返回给MES系统。

4. 优化招术三:分布式实时数据 pipeline 搭建

4.1 需求分析:为什么需要“实时数据”?

生产调度的核心是“及时响应变化”,比如:

- 某台打磨机突然故障,需要快速将订单分配给其他机器;

- 某批物料延迟到达,需要调整订单的生产顺序;

- 客户新增紧急订单,需要插入到调度计划中。

这些场景都需要实时数据(延迟<1分钟),而传统的离线数据仓库(如Hive)无法满足需求。

4.2 技术选型:“Kafka + Flink + Hudi”的组合

我们选择了流式计算和增量数据湖的组合,解决实时数据处理问题:

- Kafka:作为消息队列,收集ERP、MES、WMS、IoT的实时数据(如订单创建、设备状态变化、物料入库);

- Flink:作为流处理引擎,做数据清洗(如去除重复数据)、聚合(如计算设备过去10分钟的空闲率)、特征提取(如订单的优先级评分);

- Hudi:作为数据湖,存储增量数据(支持UPSERT操作),供特征服务和模型训练使用。

4.3 数据 pipeline 流程图

graph TD

A[ERP系统:订单数据] --> B[Kafka Topic: order]

C[MES系统:生产执行数据] --> D[Kafka Topic: production]

E[WMS系统:物料数据] --> F[Kafka Topic: material]

G[IoT传感器:设备状态数据] --> H[Kafka Topic: device]

B --> I[Flink Job: 订单数据处理]

D --> J[Flink Job: 生产数据处理]

F --> K[Flink Job: 物料数据处理]

H --> L[Flink Job: 设备数据处理]

I --> M[Hudi Table: order_processed]

J --> N[Hudi Table: production_processed]

K --> O[Hudi Table: material_processed]

L --> P[Hudi Table: device_processed]

M --> Q[Feast实时特征服务]

N --> Q

O --> Q

P --> Q

Q --> R[模型训练:Kubeflow]

Q --> S[模型推理:Triton]

图3:实时数据 pipeline 流程

4.4 实现细节:关键组件的配置

4.4.1 Kafka:高吞吐量的消息队列

- 主题设计:按数据类型划分(如

order、production、material、device),每个主题设置3个分区,2个副本; - 生产者配置:使用

kafka-python库,设置acks=all(确保消息不丢失),batch_size=16384(批量发送提升效率); - 消费者配置:Flink的Kafka消费者使用

setStartFromLatest()(消费最新数据),setCommitOffsetsOnCheckpoints()( checkpoint 时提交偏移量)。

4.4.2 Flink:低延迟的流处理

- 作业设计:每个数据类型对应一个Flink作业(如订单数据处理作业、设备数据处理作业),避免耦合;

- 窗口函数:使用

TumblingWindow(滚动窗口)计算设备的空闲率(如每10分钟统计一次); - 状态管理:使用

ValueState存储设备的历史状态(如最近一次的空闲时间),确保故障恢复后状态不丢失。

4.4.3 Hudi:增量数据湖的存储

- 表设计:使用

MERGE_ON_READ表类型(支持实时写入和批量读取),主键设置为order_id(订单表)、device_id(设备表); - 写入配置:使用

FlinkHudiSink将处理后的数据写入Hudi,设置checkpoint_interval=60000(每分钟做一次 checkpoint); - 读取配置:使用

HudiDataSource读取增量数据(如过去1小时的设备状态变化),供模型训练使用。

5. 优化招术四:闭环反馈系统实现持续优化

5.1 为什么需要“闭环”?

生产环境是动态变化的:

- 机器的性能会随着使用时间下降(如切割刀的磨损,导致加工时间变长);

- 订单的类型会变化(如夏季沙发订单增多,冬季衣柜订单增多);

- 业务规则会调整(如客户要求紧急订单的延迟率从5%降到3%)。

如果模型一成不变,无法适应这些变化,最终会导致调度效果下降。因此,必须建立**“执行-反馈-优化”**的闭环系统。

5.2 闭环反馈系统设计

闭环系统的核心是将执行数据反馈给模型,持续优化模型性能,流程如图4所示:

graph TD

A[MES执行] --> B[收集执行数据:加工时间、延迟情况、设备状态]

B --> C[存储到数据湖:Hudi]

C --> D[特征工程:更新特征(如设备的平均加工时间)]

D --> E[模型重新训练:用新数据训练PPO模型]

E --> F[模型评估:用验证集评估模型性能(如延迟率、利用率)]

F --> G[模型部署:将新模型发布到Triton服务]

G --> A[MES执行]

图4:闭环反馈系统流程

5.3 关键组件实现

5.3.1 数据收集:Prometheus + Grafana

- Prometheus:通过MES系统的API收集执行数据(如

machine_utilization(设备利用率)、order_delay(订单延迟时间)),每隔10秒拉取一次; - Grafana:将Prometheus的数据可视化,生成“设备利用率趋势图”“订单延迟率 dashboard”,供调度人员监控。

5.3.2 模型重新训练:Airflow + Kubeflow

- Airflow:调度定期训练任务(如每天凌晨2点),触发Kubeflow Pipeline;

- Kubeflow Pipeline:定义模型训练的流程(数据读取→特征提取→模型训练→评估→保存),使用分布式训练(如4个GPU节点)加速训练。

5.3.3 模型发布:Canary 发布策略

为了避免新模型引入风险,我们使用Canary 发布(金丝雀发布):

- 将新模型部署到Triton服务,设置流量比例为10%(即10%的调度请求使用新模型);

- 监控新模型的性能(如延迟率、设备利用率),如果连续24小时性能优于旧模型,将流量比例提升到50%;

- 继续监控,若性能稳定,将流量比例提升到100%,下线旧模型。

6. 实战效果:数据说话,资源浪费问题解决了吗?

6.1 关键指标对比

我们将新系统与传统系统进行了3个月的对比,结果如下:

| 指标 | 传统系统 | 新系统 | 提升率 |

|---|---|---|---|

| 设备利用率 | 65% | 85% | 30.7% |

| 订单延迟率 | 20% | 4% | 80% |

| 调度人员工作时间 | 8小时/天 | 3小时/天 | 62.5% |

| 产能 | 5万件/年 | 6.5万件/年 | 30% |

6.2 客户反馈:调度人员的“工作变化”

- 张师傅(10年经验的调度员):“原来每天要花4小时调整订单,现在只需要监控系统,处理一些异常情况(如机器故障),轻松多了。”

- 李经理(生产总监):“新系统让我们的产能提升了30%,客户投诉率下降了80%,这对我们的定制业务来说太重要了。”

6.3 案例细节:某紧急订单的调度过程

某客户新增了一个定制沙发订单(优先级5级,要求48小时内完成),新系统的处理流程如下:

- 数据收集:ERP系统将订单数据发送到Kafka,Flink处理后存入Hudi数据湖;

- 特征提取:Feast提取订单的优先级(5级)、加工时间(120分钟)、物料可用量(100%)等特征;

- 模型推理:Triton服务加载PPO模型,输入特征,输出动作(将订单分配给机器15);

- 调度执行:MES系统将订单分配给机器15,10分钟后开始加工;

- 反馈优化:Prometheus收集机器15的加工时间(115分钟,提前完成),数据同步回数据湖,用于模型下次训练。

7. 挑战与应对:过程中遇到的“坑”及解决

7.1 挑战1:模型实时性不足

问题:初始模型的推理时间为5秒,无法满足实时调度需求(要求<1秒)。

解决:

- 用TensorRT优化模型:将PPO模型转换为TensorRT引擎,推理时间从5秒缩短到0.5秒;

- 使用分布式推理:部署3个Triton节点,通过Nginx负载均衡,提升并发处理能力(支持1000 QPS)。

7.2 挑战2:异常情况处理

问题:当机器故障时,模型无法快速调整调度计划,导致订单延迟。

解决:

- 在状态空间中加入机器故障状态(如

machine_fault:0=正常,1=故障); - 在奖励函数中加入故障处理奖励(如成功将订单从故障机器转移到其他机器,奖励+10);

- 增加规则引擎:当检测到机器故障时,规则引擎优先将订单分配给空闲机器,避免模型决策延迟。

7.3 挑战3:数据质量问题

问题:MES系统的设备状态数据存在重复(如同一台机器的状态被发送了两次),导致模型训练数据不准确。

解决:

- 在Flink作业中加入去重逻辑:使用

KeyedProcessFunction,根据device_id和timestamp去重; - 增加数据校验:对设备状态数据进行范围检查(如

machine_utilization不能超过100%),不符合要求的数据标记为异常,存入单独的表中,供后续分析。

8. 未来趋势:智能调度的“下一步”

8.1 趋势1:数字孪生(Digital Twin)

数字孪生是虚拟工厂与实际工厂的实时映射,未来我们计划:

- 构建家具生产的数字孪生模型(包括机器、物料、订单的虚拟表示);

- 在虚拟环境中训练强化学习模型(如模拟机器故障、订单波动),然后部署到实际生产中,减少实际训练的风险;

- 通过数字孪生模拟调度计划的效果(如“如果将订单A分配给机器3,会导致多少延迟?”),辅助调度人员决策。

8.2 趋势2:联邦学习(Federated Learning)

XX家具计划在未来拓展到多个工厂(如华南、华东、华北),联邦学习可以在保护数据隐私的前提下,联合多个工厂的模型训练:

- 每个工厂训练本地模型(使用自己的生产数据);

- 将本地模型的参数发送到中央服务器,聚合形成全局模型;

- 将全局模型下发到每个工厂,提升模型的泛化能力(如适应不同地区的订单类型)。

8.3 趋势3:自主决策(Autonomous Decision-Making)

当前的智能调度系统还需要人工干预(如处理异常情况),未来我们希望实现完全自主的调度:

- 模型能够处理更复杂的场景(如同时应对机器故障、物料延迟、紧急订单插入);

- 系统能够自动调整业务规则(如根据客户投诉率调整延迟率的权重);

- 调度人员从“决策者”转变为“监督者”,只需要监控系统的运行状态。

9. 总结:架构优化的“核心逻辑”

XX家具的智能生产调度系统优化,本质上是用“数据-模型双驱动”替代“流程-人工驱动”,解决了传统系统的“僵化、滞后、依赖经验”的问题。

核心逻辑可以总结为以下四点:

- 数据是基础:整合全链路数据,提供实时、准确的决策依据;

- 模型是引擎:用强化学习模型替代人工经验,实现全局最优调度;

- 闭环是动力:通过反馈系统持续优化模型,适应动态变化的生产环境;

- 业务是导向:所有技术优化都围绕“提升资源利用率、降低延迟率、减少人工负担”的业务目标。

10. 工具与资源推荐

10.1 工具推荐

- 数据 pipeline:Kafka(消息队列)、Flink(流处理)、Hudi(数据湖);

- 模型训练:Stable Baselines3(强化学习)、Kubeflow(分布式训练)、MLflow(模型仓库);

- 模型部署:Triton Inference Server(低延迟推理)、FastAPI(API框架);

- 监控与反馈:Prometheus(监控)、Grafana(可视化)、Airflow(调度)。

10.2 资源推荐

- 书籍:《强化学习:原理与Python实现》《Flink实战》《数据湖架构》;

- 课程:Coursera《强化学习专项课程》、Udemy《Flink流处理实战》;

- 社区:GitHub(Stable Baselines3仓库)、Stack Overflow(Flink问题解答)、知乎(智能调度话题)。

11. 结语

智能生产调度是工业AI的重要应用场景,其核心不是“用AI替代人”,而是“用AI辅助人”,让调度人员从繁琐的手动工作中解放出来,专注于更有价值的决策(如优化业务规则、应对异常情况)。

XX家具的案例证明,通过架构优化(数据-模型双驱动)、技术选型(强化学习、实时数据 pipeline)、闭环反馈(持续优化),可以有效解决生产中的资源浪费问题,提升企业的竞争力。

未来,随着数字孪生、联邦学习、自主决策等技术的发展,智能生产调度系统将更加智能、更加自适应,为制造业的转型升级提供更强的动力。

如果你有任何问题或想法,欢迎在评论区留言,我们一起讨论!

更多推荐

已为社区贡献263条内容

已为社区贡献263条内容

所有评论(0)