零代码AI智能全流程实现防拐科普教程

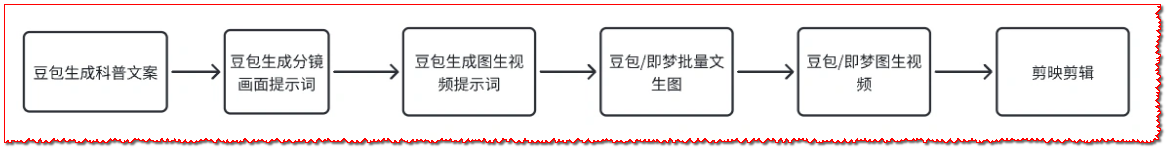

聚焦 0 基础开发者及内容创作者的需求,提供一套基于 AI 工具的儿童防拐科普动画全流程制作方案。从文案生成、分镜设计、静态画面生成,到动态视频转换及后期剪辑,全程无需专业动画技术与团队协作,仅通过主流 AI 工具与剪辑软件即可完成,助力创作者高效产出兼具社会价值与传播力的儿童安全科普内容。

在儿童安全防护领域,科普内容的可视化呈现能大幅提升传播效果,但传统动画制作面临技术门槛高、需专业团队协作、制作周期长等问题,让不少想涉足该领域的创作者望而却步。尤其对于非动画专业的开发者或个人创作者,既缺乏AE、Flash等专业动画软件的操作能力,又难以承担团队制作的成本,导致优质的儿童防拐科普内容难以高效产出。

事实上,借助当前成熟的AI工具,可构建一套“零代码、零团队”的动画制作流程,从核心的内容生成到最终的视频输出,全程通过工具赋能简化操作。下面将分阶段详解具体实现步骤,所涉及工具均为易上手的主流产品,无需复杂技术储备。

首先是核心文案的AI生成环节。儿童防拐科普内容的核心是“贴近场景、直击痛点”,需精准呈现坏人常用的诱拐套路及儿童应对方法。可借助豆包等AI文本生成工具,通过精准的Prompt指令获取符合需求的文案。Prompt设计需包含场景导向与内容重点,例如“生成儿童防拐科普文案,包含3个真实场景(小区门口问路、商场假装采访、借看儿童手表搭讪),每个场景需说明坏人的具体操作方式、儿童易中招的原因及正确应对话术,语言简洁通俗,适合短视频传播,每段控制在120字左右”。生成后可根据实际需求微调,确保内容既专业准确,又符合儿童家长的阅读习惯,避免晦涩表述。

文案确定后,需将其拆解为可视化的分镜,这是连接文字与画面的关键步骤。同样可通过AI工具生成分镜提示词,为后续画面制作提供精准指引。分镜提示词需包含场景元素、人物形象、风格定位三部分核心信息,例如针对“小区门口问路”的文案片段,可生成这样的提示词:“分镜画面:小区门口场景,背景包含门禁、绿植及少量行人;人物:6 - 8岁儿童(穿着休闲装,表情略带疑惑)、陌生成年人(身着日常外套,侧身面向儿童,手部做出问路手势);风格:卡通动画风,色彩明亮柔和,人物形象圆润可爱,场景细节贴近真实生活,避免夸张元素”。每个文案片段对应一个分镜提示词,确保后续生成的画面能精准匹配内容。

接下来进入静态画面生成阶段,可选用豆包网页版或即梦AI的批量生成功能。若使用即梦AI,直接进入其agent模式,将所有分镜提示词批量导入,选择“文生图”功能,设置输出尺寸为16:9(适配短视频平台),无需调整复杂参数,工具会自动按提示词生成对应的静态分镜图。若使用豆包网页版,则逐次输入分镜提示词,每次生成一张图片,生成后可快速预览,对不符合预期的画面,通过补充提示词(如“调整人物比例,让儿童形象更突出”“加深背景色彩饱和度”)重新生成,直至获得满意的静态素材。

AI制作防拐科普动画视频

静态画面完成后,需将其转换为动态视频片段,实现“图片动起来”的效果。此时需先生成“图生视频”提示词,核心是定义画面的动态幅度与节奏,避免过度动画化导致失真。例如针对上述小区门口的分镜图,提示词可设置为:“动态效果:陌生成年人手臂缓慢做出‘指向远方’的动作,儿童头部轻微转向成年人方向,背景行人保持缓慢行走状态;动态节奏:动作幅度适中,速度平缓,整体画面流畅自然,无跳跃感,符合真实生活场景的运动规律”。随后将静态图片与对应的“图生视频”提示词导入AI工具,豆包可直接在对话框上传图片并粘贴提示词,选择“图转视频”功能;即梦AI则在对应模块上传素材,同样选择“图转视频”,等待3 - 5分钟即可生成5 - 8秒的动态片段,每个分镜对应一个独立片段,便于后续剪辑。

import requests

from PIL import Image

import os

from moviepy.editor import concatenate_videoclips, VideoFileClip

# --------------------------

# 1. 配置基础参数(需根据实际情况修改)

# --------------------------

# 模拟AI文本生成API配置(示例,需替换为真实AI工具接口,如豆包API)

AI_TEXT_API_URL = "https://api.example.com/text/generate" # 替换为真实API地址

AI_API_KEY = "your_api_key_here" # 替换为个人API密钥

# 文件路径配置

INPUT_IMAGE_DIR = "./static_frames/" # 静态分镜图片存放目录

OUTPUT_IMAGE_DIR = "./processed_frames/" # 预处理后图片输出目录

INPUT_VIDEO_DIR = "./dynamic_clips/" # AI生成的动态视频片段目录

FINAL_VIDEO_PATH = "./anti_abduction_animation.mp4" # 最终合成视频路径

# --------------------------

# 2. AI生成科普文案与分镜提示词

# --------------------------

def generate_ai_content(content_type: str) -> str:

"""

调用AI工具生成文案或分镜提示词

:param content_type: 生成类型,可选 "copywriting"(文案)或 "storyboard"(分镜提示词)

:return: AI生成的文本内容

"""

# 构建Prompt(贴合儿童防拐科普场景,参考之前教程的内容逻辑)

prompts = {

"copywriting": (

"生成儿童防拐科普短视频文案,包含3个真实场景:"

"1. 小区门口陌生人问路 2. 商场陌生人假装采访 3. 陌生人借看儿童手表"

"每个场景需说明:①坏人操作套路 ②儿童应对方法,语言简洁通俗,每段120字左右"

),

"storyboard": (

"为儿童防拐科普文案的「小区门口陌生人问路」场景生成分镜提示词:"

"包含:①场景(小区门口,带门禁、绿植) ②人物(6-8岁儿童,表情疑惑;陌生成年人,做问路手势)"

"③风格(卡通动画风,色彩明亮,人物圆润可爱,贴近真实生活)"

)

}

# 调用AI API(模拟请求,实际需按真实API文档调整参数)

headers = {"Authorization": f"Bearer {AI_API_KEY}", "Content-Type": "application/json"}

payload = {"prompt": prompts[content_type], "max_length": 500} # 控制输出长度

try:

response = requests.post(AI_TEXT_API_URL, json=payload, headers=headers)

response.raise_for_status() # 捕获HTTP错误

return response.json()["result"] # 假设API返回格式为 {"result": "生成的文本"}

except Exception as e:

return f"生成失败:{str(e)}(请检查API配置是否正确)"

# --------------------------

# 3. 静态分镜图片批量预处理(适配16:9视频尺寸)

# --------------------------

def process_frames(input_dir: str, output_dir: str):

"""

批量调整静态分镜图片尺寸为16:9(短视频主流比例),避免黑边

:param input_dir: 原始图片目录

:param output_dir: 处理后图片输出目录

"""

# 创建输出目录(若不存在)

if not os.path.exists(output_dir):

os.makedirs(output_dir)

# 遍历所有图片文件

for filename in os.listdir(input_dir):

if filename.endswith((".png", ".jpg", ".jpeg")):

img_path = os.path.join(input_dir, filename)

try:

with Image.open(img_path) as img:

# 计算16:9比例下的目标尺寸(保持图片内容完整,裁剪多余部分)

target_ratio = 16 / 9

img_ratio = img.width / img.height

if img_ratio > target_ratio:

# 宽度过大,裁剪左右两侧

new_width = int(img.height * target_ratio)

left = (img.width - new_width) // 2

img_cropped = img.crop((left, 0, left + new_width, img.height))

else:

# 高度过大,裁剪上下两侧

new_height = int(img.width / target_ratio)

top = (img.height - new_height) // 2

img_cropped = img.crop((0, top, img.width, top + new_height))

# 保存处理后的图片

output_path = os.path.join(output_dir, filename)

img_cropped.save(output_path)

print(f"已处理图片:{filename}")

except Exception as e:

print(f"处理图片 {filename} 失败:{str(e)}")

# --------------------------

# 4. 动态视频片段批量拼接(按文案逻辑顺序)

# --------------------------

def concatenate_videos(input_dir: str, output_path: str):

"""

按文件名顺序拼接AI生成的动态视频片段,生成完整动画

:param input_dir: 动态视频片段目录(建议按顺序命名,如 01_scene.mp4, 02_scene.mp4)

:param output_path: 最终合成视频路径

"""

# 按文件名排序(确保片段顺序符合文案逻辑)

video_files = sorted(

[f for f in os.listdir(input_dir) if f.endswith((".mp4", ".mov"))],

key=lambda x: int(x.split("_")[0]) # 假设文件名格式:01_场景名.mp4

)

if not video_files:

print("未找到任何视频片段,请检查输入目录")

return

# 加载所有视频片段

video_clips = []

for file in video_files:

clip_path = os.path.join(input_dir, file)

try:

clip = VideoFileClip(clip_path)

video_clips.append(clip)

print(f"已加载视频片段:{file}")

except Exception as e:

print(f"加载视频片段 {file} 失败:{str(e)}")

# 拼接视频并导出(设置编码适配主流平台)

if video_clips:

final_clip = concatenate_videoclips(video_clips, method="compose")

final_clip.write_videofile(

output_path,

codec="libx264", # H.264编码,兼容多数平台

audio_codec="aac",

fps=24 # 短视频常用帧率

)

# 释放资源

final_clip.close()

for clip in video_clips:

clip.close()

print(f"完整视频已生成:{output_path}")

# --------------------------

# 5. 主函数:执行全流程辅助操作

# --------------------------

if __name__ == "__main__":

print("=== 儿童防拐科普动画制作辅助工具 ===")

# 步骤1:生成文案和分镜提示词

print("\n1. 正在生成科普文案...")

copywriting = generate_ai_content("copywriting")

print("科普文案:\n", copywriting)

print("\n2. 正在生成分镜提示词...")

storyboard = generate_ai_content("storyboard")

print("分镜提示词:\n", storyboard)

# 步骤2:预处理静态分镜图片

print("\n3. 正在预处理静态分镜图片...")

process_frames(INPUT_IMAGE_DIR, OUTPUT_IMAGE_DIR)

# 步骤3:拼接动态视频片段

print("\n4. 正在拼接动态视频片段...")

concatenate_videos(INPUT_VIDEO_DIR, FINAL_VIDEO_PATH)

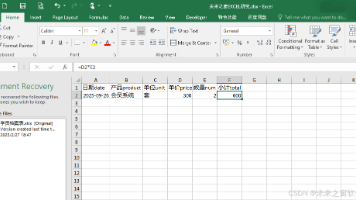

print("\n=== 所有辅助操作执行完毕 ===")最后是后期剪辑整合,剪映是该环节的适配工具,操作简洁且功能全面。新建项目后,按文案逻辑顺序导入所有动态片段,拖拽调整片段时长,确保整体节奏紧凑。随后进入字幕制作,开启“自动识别字幕”功能,工具会根据后续拟添加的语音(或文案内容)生成字幕,手动调整字幕字体为清晰易读的黑体,颜色选择与画面对比明显的深色调,位置固定在画面底部居中处。背景音乐选择轻柔的纯音乐,音量调至不超过人声(若后续配音)的30%,避免干扰内容传递。在关键场景(如坏人递东西给儿童),添加文字提示框,输入“拒绝陌生人的食物/物品”,通过加粗、调整颜色突出显示,强化科普重点。全部设置完成后,预览整个视频,检查画面流畅度、字幕同步性及提示信息准确性,确认无误后导出,分辨率选择1080P,满足主流平台的传播要求。

通过这套AI工具驱动的制作流程,可彻底打破传统动画制作的技术壁垒,个人创作者无需专业知识,即可在1 - 2小时内完成一条儿童防拐科普动画的制作。这种方式不仅降低了内容产出的门槛,更能让创作者聚焦于科普内容的质量打磨,为儿童安全防护领域输出更多优质的可视化作品。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)