【收藏必学】RAG 2.0实现高性能RAG系统,MCP架构大幅降低开发门槛

UltraRAG 2.0是基于Model Context Protocol (MCP)架构设计的RAG框架,通过YAML配置文件实现复杂逻辑,将RAG核心组件封装为标准化MCP Server。与传统框架相比,仅需约50行代码即可完成需要近900行代码的功能,性能提升约12%。其组件化设计大幅降低了复杂RAG系统的技术门槛,让研究者能专注于算法创新而非工程实现。

UltraRAG 2.0是基于Model Context Protocol (MCP)架构设计的RAG框架,通过YAML配置文件实现复杂逻辑,将RAG核心组件封装为标准化MCP Server。与传统框架相比,仅需约50行代码即可完成需要近900行代码的功能,性能提升约12%。其组件化设计大幅降低了复杂RAG系统的技术门槛,让研究者能专注于算法创新而非工程实现。

检索增强生成系统(RAG)正从早期“检索+生成”的简单拼接,走向融合自适应知识组织、多轮推理、动态检索的复杂知识系统(典型代表如 DeepResearch、Search-o1)。

但这种复杂度的提升,使开发者在方法复现、快速迭代新想法时,面临着高昂的工程实现成本。

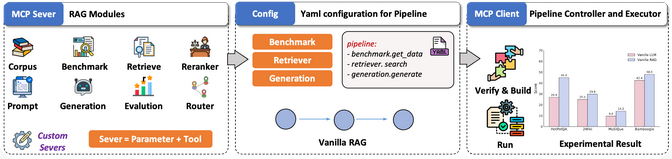

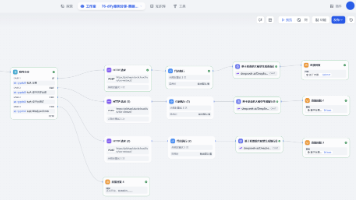

基于 Model Context Protocol (MCP) 架构设计的 RAG 框架。这一设计让科研人员只需编写 YAML 文件,就可以直接声明串行、循环、条件分支等复杂逻辑,从而以极低的代码量快速实现多阶段推理系统。

其核心思路是:

- 组件化封装:将 RAG 的核心组件封装为标准化的独立 MCP Server;

- 灵活调用与扩展:提供函数级 Tool 接口,支持功能的灵活调用与扩展;

- 轻量流程编排:借助 MCP Client,建立自上而下的简洁化链路搭建;

与传统框架相比,UltraRAG 2.0 显著降低了复杂 RAG 系统的技术门槛与学习成本,让研究者能够将更多精力投入到实验设计与算法创新上,而不是陷入冗长的工程实现。

UltraRAG

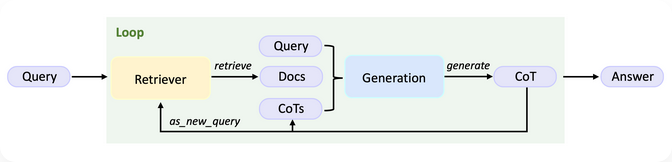

传统的RAG,如:IRCoT,依赖基于模型生成的 CoT 进行多轮检索直至产出最终答案,整体流程相当复杂。

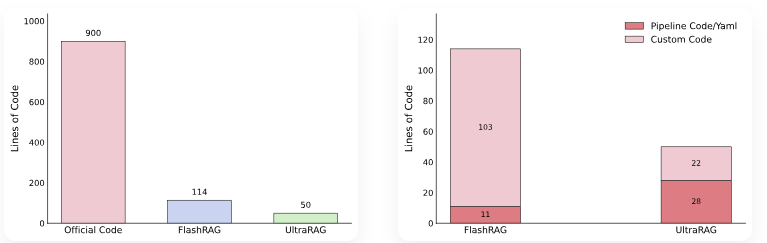

仅 Pipeline 部分就需要近 900 行手写逻辑;即便使用标杆级 RAG 框架(如 FlashRAG),也仍需 超过 110 行代码。相比之下,UltraRAG 2.0 只需约 50 行代码 即可完成同等功能。更值得强调的是,其中约一半还是用于编排的 Yaml 伪代码,这大幅降低了开发门槛与实现成本。

可以看到,FlashRAG 的实现仍然需要较长的控制逻辑,涉及显式的循环、条件判断与状态更新。而在 UltraRAG 2.0 中,这些逻辑仅需 几行 Pipeline YAML 配置 即可表达,分支与循环均以简洁的声明方式完成,避免了繁琐的手动编码。

UltraRAG实现高性能RAG

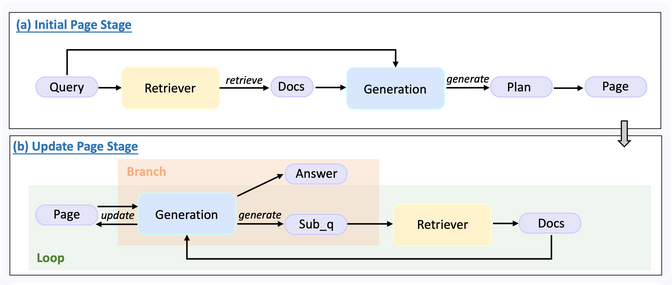

可以将 Retriever、Generation、Router 等模块通过 YAML 串联,构建了一个同时具备循环与条件分支的推理流程,实现了 Plan 生成 → 知识整理 → 子问题生成等关键步骤,而这一切仅需 不到 100 行代码。

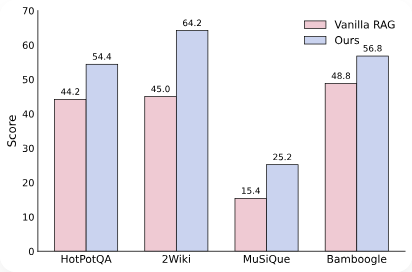

在性能上,该系统在复杂多跳问题上,相较 Vanilla RAG **性能提升约 12%**,充分验证了 UltraRAG 2.0 在快速构建复杂推理系统方面的潜力。

MCP成就高性能UltraRAG

在不同的 RAG 系统中,检索、生成等核心能力在功能上具有高度相似性,但由于开发者实现策略各异,模块之间往往缺乏统一接口,难以跨项目复用。Model Context Protocol (MCP) 作为一种开放协议,规范了为大型语言模型(LLMs)提供上下文的标准方式,并采用 Client–Server 架构,使得遵循该协议开发的 Server 组件可以在不同系统间无缝复用。

UltraRAG 基于 MCP 架构,将 RAG 系统中的检索、生成、评测等核心功能抽象并封装为相互独立的 MCP Server,并通过标准化的 函数级 Tool 接口 实现调用。这一设计既保证了模块功能扩展的灵活性,又允许新模块以“热插拔”的方式接入,无需对全局代码进行侵入式修改。

在科研场景中,这种架构让研究者能够以极低的代码量快速适配新的模型或算法,同时保持整体系统的稳定性与一致性。

UltraRAG之所以能够在 低代码 条件下支持复杂系统的构建,核心在于其底层对多结构 Pipeline 流程控制 的原生支持。无论是 串行、循环还是条件分支,所有控制逻辑均可在 YAML 层完成定义与调度,覆盖复杂推理任务所需的多种流程表达方式。

在实际运行中,推理流程的调度由内置 Client 执行,其逻辑完全由用户编写的外部 Pipeline YAML 脚本 描述,从而完成与底层实现的解耦。开发者可以像使用编程语言关键字一样调用 loop、step 等指令,以声明式方式快速构建多阶段推理流程。

学习大模型 AI 如何助力提升市场竞争优势?

随着新技术的不断涌现,特别是在人工智能领域,大模型的应用正逐渐成为提高社会生产效率的关键因素。这些先进的技术工具不仅优化了工作流程,还极大地提升了工作效率。然而,对于个人而言,掌握这些新技术的时间差异将直接影响到他们的竞争优势。正如在计算机、互联网和移动互联网的早期阶段所展现的那样,那些最先掌握新技术的人往往能够在职场中占据先机。

掌握 AI 大模型技能,不仅能够提高个人工作效率,还能增强在求职市场上的竞争力。在当今快速发展的技术时代,大模型 AI 已成为推动市场竞争力的重要力量。个人和企业必须迅速适应这一变化,以便在市场中保持领先地位。

如何学习大模型 AI ?

在我超过十年的互联网企业工作经验中,我有幸指导了许多同行和后辈,并帮助他们实现个人成长和学习进步。我深刻认识到,分享经验和知识对于推动整个行业的发展至关重要。因此,尽管工作繁忙,我仍然致力于整理和分享各种有价值的AI大模型资料,包括AI大模型入门学习思维导图、精选学习书籍手册、视频教程以及实战学习等内容。通过这些免费的资源,我希望能够帮助更多的互联网行业朋友获取正确的学习资料,进而提升大家的技能和竞争力。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、初阶应用:建立AI基础认知

在第一阶段(10天),重点是对大模型 AI 的基本概念和功能进行深入了解。这将帮助您在相关讨论中发表高级、独特的见解,而不仅仅是跟随他人。您将学习如何调教 AI,以及如何将大模型与业务相结合。

主要学习内容:

- 大模型AI的功能与应用场景:探索AI在各个领域的实际应用

- AI智能的起源与进化:深入了解AI如何获得并提升其智能水平

- AI的核心原理与心法:掌握AI技术的核心概念和关键原理

- 大模型应用的业务与技术架构:学习如何将大模型AI应用于业务场景和技术架构中

- 代码实践:向GPT-3.5注入新知识的示例代码

- 提示工程的重要性与核心思想:理解提示工程在AI应用中的关键作用

- Prompt的构建与指令调优方法:学习如何构建有效的Prompt和进行指令调优

- 思维链与思维树的应用:掌握思维链和思维树在AI推理和决策中的作用

- Prompt攻击与防范策略:了解Prompt攻击的类型和如何进行有效的防范

、、、

二、中阶应用:深入AI实战开发

在第二阶段(30天),您将进入大模型 AI 的进阶实战学习。这将帮助您构建私有知识库,扩展 AI 的能力,并快速开发基于 agent 的对话机器人。适合 Python 和 JavaScript 程序员。

主要学习内容:

- RAG的重要性:理解RAG在AI应用中的关键作用

- 构建基础ChatPDF:动手搭建一个简单的ChatPDF应用

- 检索基础:掌握信息检索的基本概念和原理

- 理解向量表示:深入探讨Embeddings的原理和应用

- 向量数据库与检索技术:学习如何使用向量数据库进行高效检索

- 基于 vector 的 RAG 实现:掌握基于向量的RAG构建方法

- RAG系统的高级扩展:探索RAG系统的进阶知识和技巧

- 混合检索与RAG-Fusion:了解混合检索和RAG-Fusion的概念和应用

- 向量模型的本地部署策略:学习如何在本地环境中部署向量模型

三、高阶应用:模型训练

在这个阶段,你将掌握模型训练的核心技术,能够独立训练和优化大模型AI。你将了解模型训练的基本概念、技术和方法,并能够进行实际操作。

- 模型训练的意义:理解为什么需要进行模型训练。

- 模型训练的基本概念:学习模型训练的基本术语和概念。

- 求解器与损失函数:了解求解器和损失函数在模型训练中的作用。

- 神经网络训练实践:通过实验学习如何手写一个简单的神经网络并进行训练。

- 训练与微调:掌握训练、预训练、微调和轻量化微调的概念和应用。

- Transformer结构:了解Transformer的结构和原理。

- 轻量化微调:学习如何进行轻量化微调以优化模型性能。

- 实验数据集构建:掌握如何构建和准备实验数据集。

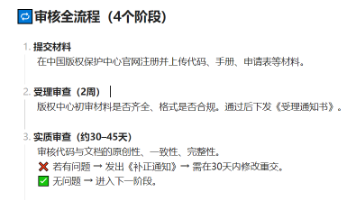

四、专家应用:AI商业应用与创业

在这个阶段,你将了解全球大模型的性能、吞吐量和成本等方面的知识,能够在云端和本地等多种环境下部署大模型。你将找到适合自己的项目或创业方向,成为一名被AI武装的产品经理。

- 硬件选型:学习如何选择合适的硬件来部署和运行大模型AI。

- 全球大模型概览:了解全球大模型的发展趋势和主要玩家。

- 国产大模型服务:探索国产大模型服务的优势和特点。

- OpenAI代理搭建:学习如何搭建OpenAI代理以扩展AI的功能和应用范围。

- 热身练习:在阿里云 PAI 上部署 Stable Diffusion

- 本地化部署:在个人计算机上运行大型模型

- 私有化部署策略:大型模型的内部部署方法

- 利用 vLLM 进行模型部署:高效部署大型模型的技术

- 案例分析:如何在阿里云上优雅地私有部署开源大型模型

- 开源 LLM 项目的全面部署:从零开始部署开源大型语言模型

- 内容安全与合规:确保AI应用的内容安全和合规性

- 算法备案流程:互联网信息服务算法的备案指南

通过这些学习内容,您不仅能够掌握大模型 AI 的基本技能,还能够深入理解其高级应用,从而在市场竞争中占据优势。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你无疑是AI领域的佼佼者。然而,即使你只能完成60-70%的内容,你也已经展现出了成为一名大模型AI大师的潜力。

最后,本文提供的完整版大模型 AI 学习资料已上传至 CSDN,您可以通过微信扫描下方的 CSDN 官方认证二维码免费领取【保证100%免费】。

更多推荐

已为社区贡献140条内容

已为社区贡献140条内容

所有评论(0)