【ComfyUI】Wan 2.1 文本转视频

本文介绍了一个基于 Wan 2.1 的 ComfyUI 文生视频工作流,通过 UNet、CLIP 和 VAE 三个核心模型,将文本提示转化为动态视频。工作流包含模型加载、提示词解析、潜空间采样等7个环节,支持分辨率、帧数等参数设置,最终输出高质量视频文件。该方案适用于创意设计、教育培训和多媒体制作等场景,能快速生成符合语义的动态内容。文章还提供了相关开发资源和学习链接,适合AI视频生成领域的研究者

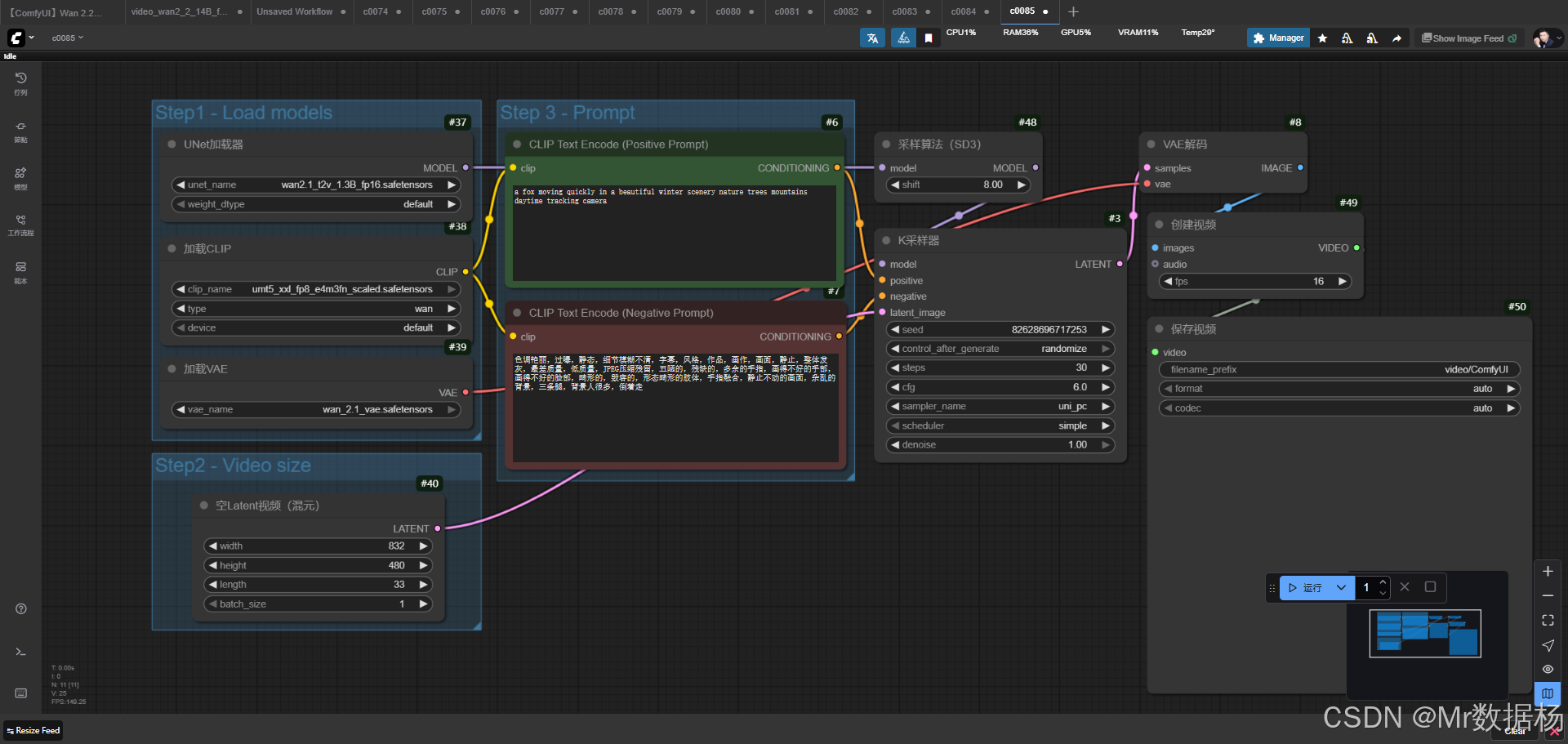

今天展示的案例是一个基于 Wan 2.1 的 ComfyUI 文生视频工作流。通过加载预训练的 UNet、CLIP 文本编码器和 VAE 解码器,结合正负提示词的输入,在给定的分辨率和帧数条件下完成潜空间采样并生成视频。整个过程能够将“文本描述”转化为动态影像,直观展现从静态提示到动态画面的构建方式,适用于学习视频生成工作流的初学者和进阶开发者。

工作流介绍

该工作流以“文本到视频”为核心任务,采用 UNet 模型负责扩散生成,CLIP 模型解析正负提示词语义,VAE 模型实现潜变量与可视化影像的互转。通过 EmptyHunyuanLatentVideo 控制视频分辨率与帧长,再经由 KSampler 在潜空间进行多步迭代采样,最后使用 CreateVideo 与 SaveVideo 将采样结果合成为视频文件。整体设计体现了 ComfyUI 在复杂视频生成链路上的模块化与可视化优势。

核心模型

工作流的核心模型围绕 UNet 扩散模型、CLIP 编码器和 VAE 解码器展开,分别承担语义解析、潜变量迭代生成和影像还原的职责。CLIP 文本编码器支持正负提示词输入,保证了语义条件的精准控制;UNet 模型是扩散过程的主体,直接决定了画面的动态构型;VAE 则负责潜空间与真实画面之间的解码,确保生成结果具备较高的视觉还原度。

| 模型名称 | 说明 |

|---|---|

| wan2.1_t2v_1.3B_fp16.safetensors | UNet 文生视频扩散模型,负责潜空间迭代采样与视频动态生成 |

| umt5_xxl_fp8_e4m3fn_scaled.safetensors | CLIP 文本编码器,解析正向与负向提示词语义 |

| wan_2.1_vae.safetensors | VAE 解码器,将潜变量解码为真实画面 |

Node节点

该工作流由多个 Node 节点组成,涵盖模型加载、文本编码、潜空间采样、解码及视频输出等环节。UNETLoader、CLIPLoader 与 VAELoader 分别负责加载对应的核心模型;CLIPTextEncode 节点处理正负提示词并转化为语义向量;EmptyHunyuanLatentVideo 设置视频分辨率与帧数;KSampler 节点在扩散过程中反复采样;VAEDecode 将潜变量转化为画面;CreateVideo 与 SaveVideo 节点最终生成并保存视频文件。

| 节点名称 | 说明 |

|---|---|

| UNETLoader | 加载 UNet 扩散模型,用于视频潜空间采样 |

| CLIPLoader | 加载 CLIP 文本编码器,为提示词提供语义解析 |

| VAELoader | 加载 VAE 模型,实现潜空间与影像之间的互转 |

| CLIPTextEncode (Positive/Negative Prompt) | 编码提示词,形成正负向条件约束 |

| EmptyHunyuanLatentVideo | 设定视频分辨率、帧数和潜空间初始化 |

| KSampler | 在潜变量空间中进行多步迭代采样,驱动画面生成 |

| VAEDecode | 将采样得到的潜变量解码为图像序列 |

| CreateVideo | 将图像序列合成为视频,可选音频同步 |

| SaveVideo | 保存最终生成的视频文件 |

工作流程

整个工作流的运行逻辑从模型加载开始,逐步完成提示词解析、潜空间初始化、采样迭代、画面解码到视频合成与保存,形成了一条完整的“文本到视频”生成链路。通过 UNETLoader 与 CLIPLoader 载入核心模型后,正负提示词在 CLIPTextEncode 节点被编码为语义条件,驱动扩散过程的方向。EmptyHunyuanLatentVideo 节点设定分辨率与帧长,为潜空间提供初始容器;随后 KSampler 基于提示语义与 UNet 模型进行多步采样,逐渐得到清晰的潜变量序列;在 VAEDecode 中,这些潜变量被还原为实际画面;CreateVideo 将连续画面拼接成视频,最后经 SaveVideo 输出保存。这样的结构使得每个环节的作用清晰独立,便于调试与扩展。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 模型加载 | 加载 UNet、CLIP 和 VAE 等核心模型,确保后续环节具备基础能力 | UNETLoader / CLIPLoader / VAELoader |

| 2 | 提示词解析 | 将正向与负向提示词转换为语义向量,为扩散采样提供条件约束 | CLIPTextEncode (Positive/Negative Prompt) |

| 3 | 潜空间初始化 | 设置视频的分辨率、时长与潜变量初始状态,定义生成范围 | EmptyHunyuanLatentVideo |

| 4 | 采样生成 | 在潜空间进行迭代采样,根据提示语义逐步构建动态画面 | KSampler + ModelSamplingSD3 |

| 5 | 画面解码 | 将采样得到的潜变量解码为实际画面,生成图像序列 | VAEDecode |

| 6 | 视频合成 | 将图像序列整合为视频文件,可添加音频同步 | CreateVideo |

| 7 | 文件保存 | 将生成视频输出到本地目录,便于展示与二次处理 | SaveVideo |

应用场景

该工作流的设计不仅适合学习 ComfyUI 的视频生成机制,也能应用在创意影像、教育演示和多媒体内容制作中。在创意设计领域,用户可以通过简短的文字提示快速生成动态素材;在教育与培训中,可借助这一流程制作具象化的视频示例,提升教学直观性;在多媒体制作环节,该方法能极大缩短前期分镜与动画的生产时间,快速产出可编辑的视频片段。结合正负提示词的语义控制能力,最终输出的视频能够兼顾创意自由与画面质量,为不同类型的用户提供高效的视频生成手段。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 创意影像设计 | 根据文本快速生成动画素材 | 数字艺术家 / 内容创作者 | 短片、动态背景、实验性影像 | 高效获取创意视频,辅助视觉设计 |

| 教学与培训 | 通过文本提示生成演示视频 | 教师 / 教育工作者 | 教学演示、学科案例场景化动画 | 提升教学直观性与趣味性 |

| 多媒体制作 | 提供快速分镜与视频草稿 | 视频制作人 / 新媒体团队 | 剧情预演、短视频内容 | 缩短制作周期,快速产出可用片段 |

| 科研与实验 | 验证 AI 视频生成方法 | 研究人员 / 学术团队 | 生成实验数据与研究样例 | 探索生成式模型的性能与边界 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)