【ComfyUI】Wan 2.1 14B Fun Camera 高级镜头控制

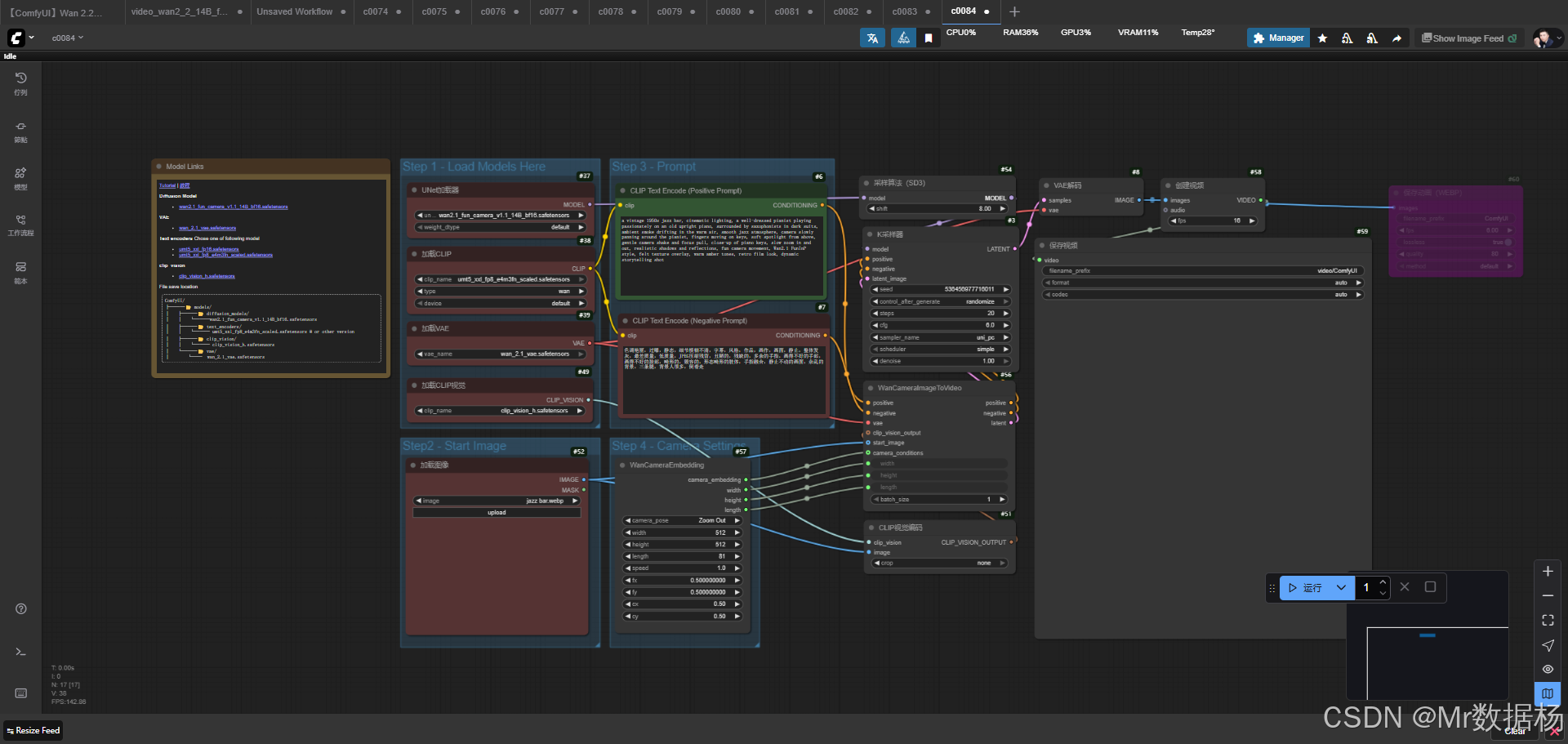

本文介绍了一个基于 Wan2.1 Fun Camera 模型 的 ComfyUI 视频生成工作流,能够将静态图像与文本提示融合,生成具有动态相机运动的视频画面。工作流通过扩散模型、VAE解码器和CLIP编码器的协同配合,实现从潜空间到视频的动态生成,特别适合制作具有电影质感的叙事风格视频。 核心模块包括 WanCameraImageToVideo 节点和 KSampler,前者整合图像、文本提示和

今天展示的案例是一个基于 Wan2.1 Fun Camera 模型 的 ComfyUI 视频生成工作流,整体流程通过加载预训练的扩散模型与文本编码器,结合起始图像与相机条件嵌入,完成从文字提示与图像输入到视频输出的完整链路。在效果层面,这类工作流能够实现带有动态相机运动的叙事风格视频,例如爵士酒吧氛围中的音乐表演镜头,呈现更具电影质感的镜头语言与画面氛围。

工作流介绍

该工作流旨在将静态图像与文本提示融合,生成具有动态相机运动的视频画面。通过 UNet 扩散模型、VAE 解码器、CLIP 文本与视觉编码器 共同配合,系统能够捕捉场景细节并生成流畅的视频镜头。其核心在于利用 WanCameraImageToVideo 节点 将正向与反向提示、图像输入、相机运动参数进行条件整合,从而实现多维度的镜头控制与画面渲染。整个工作流不仅适用于艺术创作,也可作为影视分镜、动画设计、叙事短片的生成工具。

核心模型

本工作流依托一系列 Wan 系列模型与 CLIP 组件,结合扩散模型、变分自编码器和视觉编码器,实现从潜空间到视频的动态生成。扩散模型提供了画面生成的基础能力,VAE 解码器将潜在空间结果还原为清晰图像,CLIP 系列模型则在文本和视觉维度进行特征提取和匹配。

| 模型名称 | 说明 |

|---|---|

| wan2.1_fun_camera_v1.1_14B_bf16.safetensors | 主扩散模型,负责视频帧的生成与画面细节构建 |

| wan_2.1_vae.safetensors | 变分自编码器,用于潜空间结果的解码与图像还原 |

| umt5_xxl_fp8_e4m3fn_scaled.safetensors | 文本编码器,负责将正反向提示转化为条件向量 |

| clip_vision_h.safetensors | 视觉编码器,用于解析输入图像并提供视觉特征条件 |

Node节点

在节点构成方面,该工作流整合了模型加载、图像输入、文本与相机条件编码、潜空间采样、解码与视频保存等多个环节。WanCameraImageToVideo 节点是核心模块,直接将正负提示、视觉输入和相机运动条件整合为潜在表示,再交由 KSampler 完成采样,最终通过 VAEDecode → CreateVideo → SaveVideo 形成输出。这样的节点链条保证了生成过程的完整性与可控性。

| 节点名称 | 说明 |

|---|---|

| UNETLoader | 加载主扩散模型,提供潜空间推理能力 |

| VAELoader | 加载 VAE 模型,用于解码潜空间结果 |

| CLIPLoader | 加载文本编码器,支持正反向提示的特征化 |

| CLIPVisionLoader | 加载视觉编码器,提取输入图像的视觉特征 |

| CLIPTextEncode (Positive/Negative Prompt) | 将文字提示转化为正负条件向量 |

| LoadImage | 输入起始图像,作为生成视频的初始状态 |

| WanCameraEmbedding | 定义相机运动参数,提供镜头动态条件 |

| WanCameraImageToVideo | 核心模块,将图像、提示与相机条件整合为潜在表示 |

| KSampler | 在潜空间中进行采样,生成潜在帧序列 |

| VAEDecode | 解码潜在帧为图像序列 |

| CreateVideo | 将图像序列合成为视频 |

| SaveVideo / SaveAnimatedWEBP | 输出视频或动图文件 |

工作流程

该工作流的执行过程由模型加载、条件设定、潜空间采样、图像解码和视频输出五个主要阶段构成。起始阶段加载扩散模型、VAE、CLIP 文本与视觉模型,确保所需的推理组件齐备。接着通过输入图像和正负提示,结合相机参数的嵌入,生成可控的条件组合。核心的采样阶段由 WanCameraImageToVideo 与 KSampler 协同完成,前者将所有条件整合为潜在表示,后者在潜空间中进行多轮迭代采样,形成动态的潜在帧序列。随后,解码器将这些潜在帧还原为图像序列,最后通过视频合成与保存模块生成视频或动画文件。整体流程保证了从输入到输出的闭环,使得视频不仅具备画面细节,也呈现自然的镜头运动。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 模型加载 | 加载扩散模型、VAE、文本与视觉编码器,为推理提供底层支撑 | UNETLoader、VAELoader、CLIPLoader、CLIPVisionLoader |

| 2 | 条件设定 | 输入正反向提示与起始图像,结合相机嵌入生成多模态条件 | CLIPTextEncode、LoadImage、WanCameraEmbedding |

| 3 | 潜空间生成 | 将条件整合并转化为潜在表示,采样生成潜在帧序列 | WanCameraImageToVideo、KSampler |

| 4 | 解码与渲染 | 将潜在帧解码为图像序列,恢复清晰画面 | VAEDecode |

| 5 | 视频合成 | 将图像序列合成为动态视频或动图并保存 | CreateVideo、SaveVideo、SaveAnimatedWEBP |

应用场景

该工作流的设计具备跨场景应用的灵活性。在创意产业中,它能够生成具有电影感的短片或分镜头预览,为导演和设计师提供快速的视觉原型。在教育与演示领域,可以通过动态场景视频更直观地呈现抽象概念,增强信息的沉浸式表达。在内容生产方面,则适用于自媒体和广告行业,快速产出带有叙事性与氛围感的视频片段。整体而言,这一工作流通过文本、图像与相机条件的结合,突破了传统静态图像的限制,使得生成内容更具表现力与应用价值。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 影视分镜 | 快速生成动态分镜头,辅助叙事构思 | 导演、编剧 | 场景氛围与镜头运动 | 高效产出视觉草稿 |

| 动画创作 | 制作原型视频,测试风格与镜头设计 | 动画师、设计师 | 动画风格与角色表现 | 动态原型预览 |

| 教育演示 | 将抽象概念转化为动态场景 | 教师、讲师 | 模拟实验或故事情境 | 提升教学直观性 |

| 自媒体内容 | 制作氛围视频或叙事短片 | 创作者、博主 | 氛围化场景、动态镜头 | 快速生成原创视频 |

| 广告宣传 | 产出具有叙事张力的短视频 | 品牌方、营销团队 | 产品或场景故事 | 提升视觉感染力 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)