GPT-5幻觉率骤降之谜:OpenAI万字长文揭示,“一本正经地胡说八道”是AI的统计学本能

OpenAI最新研究揭示:AI幻觉是统计学习的必然产物,而非数据缺陷所致。研究表明,语言模型基于"通顺度"而非真实性判断信息,导致面对罕见事实或复杂推理时容易产生错误。论文提出,幻觉无法根除但可管控,GPT-5通过强化学习建立"反思机制",使幻觉率比前代降低45-80%。这为AI发展指明方向:接受统计学局限,通过后期修正提升可靠性。该突破为开发者提供了新思路,如何有效利用AI能力成为关键。

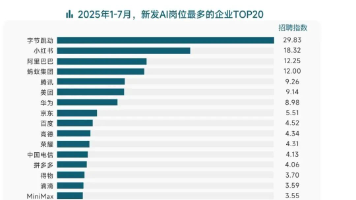

GPT-5的发布,虽未带来业界期待的“AGI时刻”,却在一个关键指标上实现了巨大突破:幻觉率的大幅下降。根据OpenAI官方数据,其出现事实错误的概率比GPT-4o低45%,比o3低80%。

这背后的技术秘诀一直秘而不宣。OpenAI的System Card只是模糊地将其归功于强化学习,称模型学会了“完善自己的思考过程”。直到9月4日,一篇名为**《语言模型为何会产生幻觉》(Why Language Models Hallucinate)**的论文,终于为我们揭开了冰山一角。

这篇论文的核心观点极具颠覆性:幻觉并非模型的“Bug”,而是其统计学习本质下,一种不可避免的、可预测的“本能”。

对于广大的开发者、设计师和技术爱好者来说,仅仅是“看到”还远远不够,如何将这支“神笔”握在自己手中,将其强大的能力集成到自己的项目或工作流中,才是释放更大创造力的关键。

小镜AI开放平台致力于此。我们提供稳定、高效的API服务,让你能轻松调用包括顶尖文生图模型在内的多种AI能力,开启属于你的AI创作与革新之旅。

立即体验 | API 服务入口:

https://open.xiaojingai.com/register?aff=xeu4

核心论点:AI的“幻觉”是统计学的必然

过去,我们普遍将AI的“胡说八道”归咎于训练数据质量不高。但OpenAI的这篇论文从根本上挑战了这一观点,它证明了:幻觉源于语言模型的核心机制。

其论证逻辑非常清晰:对于模型而言,生成一段“看起来可靠”的信息,远比判断这段信息“是否真实可靠”要容易得多,而这个“判断”过程本身就存在天然的缺陷。

模型内心的“靠谱”检测器

为了解释这一点,论文提出了一个名为“是否有效(Is-It-Valid, IIV)”的理论判断器。

我们可以将其通俗地理解为:模型在内部评估一句话时,会像一个经验丰富的老学究,根据其海量阅读经验给出一个“通顺度”或“靠谱分”。这句话听起来越“耳熟”、越符合它学到的语言规律和知识统计,得分就越高。

当这个内部评分超过某个设定的阈值时,模型就认为这句话是“有效的”,并将其输出。简单来说,模型判断的标准是“这句话顺不顺”,而不是“这句话对不对”。

为什么这位“老学究”也会看走眼?

这个基于统计概率的“内部判断器”显然不是完美的。论文指出,它在多种场景下必然会出错,导致幻觉的产生:

-

知识的“长尾效应”(数据稀疏): 对于那些非常见、稀有的“孤例”事实(比如某个冷门历史人物的生卒年),模型在训练数据中见得太少,其内部“靠谱分”自然很低。此时,它只能靠“猜”,生成一个看似合理但实际错误的信息。

-

能力的“天花板”(模型能力不足): 面对需要复杂推理和深刻理解的概念,模型的能力尚不足以进行准确判断,只能生成一个概率上最“像”答案的句子。

-

“垃圾进,垃圾出”(训练数据污染): 这是最广为人知的原因。如果训练数据本身就包含大量错误、矛盾的信息,模型的判断标准从一开始就是混乱的。

-

其他因素: 包括计算资源限制、数据分布偏移等,都会干扰这个内部判断器的准确性。

从“无法避免”到“有效管控”

所以,这篇论文真正告诉我们的是:试图在预训练阶段就从根源上彻底杜绝幻觉,可能是一条走不通的路。

真正的突破口,在于承认其作为统计学副产品的必然性,并在此基础上,建立起更强大的**“纠错”和“反思”**机制。这恰好印证了OpenAI在System Card中提到的——利用强化学习训练模型去“完善自己的思考过程”。

与其期望AI天生就是一个从不说谎的圣人,不如教会它如何在一个充满不确定性的世界里,识别并修正自己的潜在错误。这或许就是GPT-5幻觉率大幅下降的真正秘密,也指明了未来AI发展的核心方向:不是消灭本能,而是驯服本能。

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)