惊爆!提示工程架构师揭秘Agentic AI在各行业的神奇应用

我们写这篇的目的,是帮你从“是什么”到“怎么用”搞懂Agentic AI先讲清楚Agentic AI和普通AI的区别(比如ChatGPT是“你问我答”,Agentic AI是“我主动帮你做”);再用“便利店库存管理”的故事,拆解它的核心能力(感知、决策、行动);然后用Python代码实战,教你做一个简单的Agentic AI;最后带你看它在零售、医疗、制造等5个行业的真实应用。范围覆盖技术原理(强

惊爆!提示工程架构师揭秘Agentic AI在各行业的神奇应用

关键词:Agentic AI、智能代理、提示工程、强化学习、多智能体协作、行业应用、自主决策

摘要:你见过“会主动帮你解决问题”的AI吗?比如便利店老板还没发现库存不够,AI已经自动下单补货;医生看病历的功夫,AI已经标出潜在的诊断风险;工厂机床还没出故障,AI已经安排好维修——这就是**Agentic AI(智能代理AI)**的魔力。它不是被动回答问题的“工具人”,而是有“自主意识”的“超级助手”:能感知环境、做决策、主动行动,甚至从经验中学习。本文结合提示工程架构师的一线经验,用“便利店故事+代码实战+行业案例”的方式,拆解Agentic AI的核心逻辑,揭秘它在零售、医疗、制造等行业的神奇应用,最后聊聊未来的趋势与挑战。读完这篇,你会明白:Agentic AI不是“未来时”,而是正在改变我们工作的“现在时”。

背景介绍

目的和范围

我们写这篇的目的,是帮你从“是什么”到“怎么用”搞懂Agentic AI:

- 先讲清楚Agentic AI和普通AI的区别(比如ChatGPT是“你问我答”,Agentic AI是“我主动帮你做”);

- 再用“便利店库存管理”的故事,拆解它的核心能力(感知、决策、行动);

- 然后用Python代码实战,教你做一个简单的Agentic AI;

- 最后带你看它在零售、医疗、制造等5个行业的真实应用。

范围覆盖技术原理(强化学习、提示工程)和行业落地(不用复杂公式,用“小学生能听懂的话”讲清楚)。

预期读者

- 想了解AI新趋势的“技术门外汉”(比如便利店老板、医生、工厂经理);

- 想落地Agentic AI的产品经理/程序员;

- 对“自主AI”好奇的科技爱好者。

文档结构概述

文章像“剥洋葱”一样层层深入:

- 故事引入:用便利店老板的烦恼,引出Agentic AI的价值;

- 核心概念:拆解Agentic AI的3大能力(感知、决策、行动)和提示工程的作用;

- 算法原理:用“训练小狗”的比喻讲强化学习,用Python代码实现;

- 项目实战:手把手教你做一个“便利店库存Agent”;

- 行业应用:看Agentic AI在5个行业的“神奇操作”;

- 趋势挑战:聊未来的机会(多智能体协作)和坑(自主性与可控性)。

术语表

核心术语定义

- Agentic AI(智能代理AI):能自主完成“感知环境→做决策→执行行动→学习改进”闭环的AI系统,像一个“有目标的小机器人”。

- 提示工程(Prompt Engineering):给Agentic AI定“规则和目标”的方法(比如“你是库存管家,要保持库存10-30件,低于10件就下单20件”)。

- 强化学习(Reinforcement Learning, RL):Agentic AI的“学习方式”——像训练小狗,做对了给奖励(骨头),做错了给惩罚(打屁股),慢慢学会最优行为。

相关概念解释

- 多智能体系统(Multi-Agent System):多个Agent一起工作(比如库存Agent+推荐Agent+供应链Agent协作管理便利店)。

- 马尔可夫决策过程(MDP):描述Agent“决策-结果”的数学模型(比如“当前库存5件→下单20件→明天库存25件→得到奖励10分”)。

缩略词列表

- RL:强化学习(Reinforcement Learning)

- DQN:深度Q网络(Deep Q-Network,强化学习的一种算法)

核心概念与联系

故事引入:便利店老板的“AI救星”

王哥开了家社区便利店,最近愁得睡不着觉:

- 上周可乐卖断货,流失了10个老顾客;

- 昨天发现积压了50盒冰淇淋(夏天快结束了);

- 每天要花2小时盘点库存,根本没时间看店。

直到他用了一个**“智能小店助手”Agent**——

- 早上8点,Agent自动统计库存:可乐剩8件(低于阈值10),马上向供应商下单20件;

- 中午12点,Agent分析上周销量:冰淇淋每天只卖2盒,建议把库存从50降到10;

- 晚上10点,Agent生成报表:“本周矿泉水销量增长30%,下周要多进50件”。

王哥现在每天只需要看一眼Agent的报告,再也不用熬夜盘点了。这个“智能助手”就是Agentic AI——它不是“等你问”,而是“主动做”。

核心概念解释:Agentic AI的“三驾马车”

Agentic AI之所以能“主动做事”,靠的是三个核心能力,我们用“智能管家”的比喻讲清楚:

核心概念一:感知(像管家的“眼睛耳朵”)

感知是Agent“收集信息”的能力,像管家会看家里的温度、冰箱的食物、主人的日程。

比如便利店Agent的感知:

- 看库存系统(可乐剩8件);

- 查销售记录(冰淇淋昨天卖2盒);

- 读天气预告(下周要降温,矿泉水销量可能下降)。

生活类比:你家的智能音箱会“听”你说“打开空调”,但Agentic AI的“感知”更主动——它会“看”温度计,发现温度超过28度,主动问你“要开空调吗?”。

核心概念二:决策(像管家的“大脑”)

决策是Agent“分析信息、做选择”的能力,像管家会根据温度和你的日程,决定要不要开空调。

比如便利店Agent的决策:

- 库存可乐剩8件(低于10)→决定“下单20件”;

- 冰淇淋每天卖2盒→决定“把库存降到10”;

- 下周降温→决定“少进矿泉水”。

生活类比:你问ChatGPT“今天吃什么?”,它给你推荐;但Agentic AI会“分析你的饮食记录(爱吃辣)+天气(下雨)”,主动说“今天吃火锅吧,我帮你订外卖”。

核心概念三:行动(像管家的“手”)

行动是Agent“执行决策”的能力,像管家会去开空调、订外卖。

比如便利店Agent的行动:

- 自动给供应商发下单邮件;

- 给王哥发微信提醒“冰淇淋库存过多,建议促销”;

- 生成周报表并发到王哥的邮箱。

生活类比:普通AI是“你说什么我做什么”,Agentic AI是“我想清楚了就去做”——比如你加班到10点,Agent会主动帮你叫车,还提醒司机“我家在XX小区,不要绕路”。

核心概念之间的关系:像“做饭的流程”

感知、决策、行动不是孤立的,而是循环闭环——就像你做饭:

- 感知:看冰箱里有什么菜(鸡蛋、番茄);

- 决策:决定做番茄炒蛋(简单又好吃);

- 行动:打鸡蛋、切番茄、炒菜;

- 反馈:尝一口(咸了)→回到“感知”(下次少放盐)。

Agentic AI的闭环也是这样:

- 感知→收集数据;

- 决策→分析数据做选择;

- 行动→执行选择;

- 反馈→用结果调整下次的决策。

而提示工程就是给这个闭环定“游戏规则”——比如你给Agent说:“你是便利店管家,要保持库存10-30件,低于10件下单20件,高于30件停止下单”。这就像你给做饭的管家说:“不要放太多盐,菜要炒得嫩一点”。

核心概念原理的文本示意图

Agentic AI的工作流程可以总结为:

环境(便利店)→感知(库存、销量、天气)→决策(要不要下单)→行动(发下单邮件)→环境变化(库存增加)→再感知→再决策→…

Mermaid 流程图:Agentic AI的闭环

graph TD

A[环境:便利店库存/销量/天气] --> B[感知:收集数据]

B --> C[决策:分析数据做选择]

C --> D[行动:执行决策(下单/提醒)]

D --> E[环境变化:库存增加/销量变化]

E --> B

核心算法原理:Agentic AI是怎么“学习”的?

Agentic AI的“自主决策”不是天生的,而是通过强化学习(RL)训练出来的。我们用“训练小狗”的比喻,讲清楚强化学习的逻辑。

强化学习的“小狗训练法”

训练小狗“坐下”的流程:

- 环境:你和小狗在客厅;

- 状态:小狗站着;

- 动作:你说“坐下”,小狗坐下;

- 奖励:给小狗一根骨头(正奖励);

- 学习:小狗知道“坐下=有骨头”,下次你说“坐下”,它会更快坐下。

强化学习的流程和这一模一样:

- 环境(Environment):Agent所在的世界(比如便利店);

- 状态(State):环境的当前情况(比如库存5件);

- 动作(Action):Agent做的选择(比如下单20件);

- 奖励(Reward):对动作的评价(比如库存回到25件,给10分);

- 学习(Learning):Agent记住“状态→动作→奖励”的关系,下次遇到同样的状态,会选奖励最高的动作。

用Python代码实现:训练一个“库存管理Agent”

我们用强化学习算法DQN,训练一个能自动管理便利店库存的Agent。代码很简单,跟着做就能跑起来!

步骤1:安装依赖库

需要安装3个库:

gym:模拟Agent的环境(比如便利店库存);stable-baselines3:强化学习算法库(提供DQN);numpy:处理数据。

打开终端,运行:

pip install gym stable-baselines3 numpy

步骤2:定义“便利店库存环境”

我们用gym库定义一个InventoryEnv(库存环境),包含:

- 状态空间:库存数量(0-100);

- 动作空间:下单数量(0-50);

- 奖励规则:库存10-30得10分,<10得-10分,>30得-5分(鼓励合理库存);

- 步骤函数:处理动作,计算新库存和奖励。

代码:

import gym

from gym import spaces

import numpy as np

from stable_baselines3 import DQN

# 定义库存环境

class InventoryEnv(gym.Env):

def __init__(self):

super().__init__()

# 状态空间:库存数量(0-100)

self.observation_space = spaces.Box(low=0, high=100, shape=(1,), dtype=np.float32)

# 动作空间:下单数量(0-50)

self.action_space = spaces.Discrete(51) # 0到50共51个选项

# 初始库存

self.current_inventory = 20

# 天数(模拟30天为一个周期)

self.day = 0

def step(self, action):

"""处理动作,返回新状态、奖励、是否结束、额外信息"""

# 1. 模拟每日销量(随机1-5件)

demand = np.random.randint(1, 6)

# 2. 更新库存:卖出demand件,加上下单的action件(假设下单第二天到)

self.current_inventory -= demand # 今天卖出demand件

self.current_inventory += action # 明天收到action件

# 3. 库存不能超过最大值(100)或小于0

self.current_inventory = np.clip(self.current_inventory, 0, 100)

# 4. 计算奖励(鼓励库存10-30)

if 10 <= self.current_inventory <= 30:

reward = 10 # 合理库存,奖励10分

elif self.current_inventory < 10:

reward = -10 # 缺货,惩罚10分

else:

reward = -5 # 积压,惩罚5分

# 5. 模拟结束:运行30天

self.day += 1

done = self.day >= 30

# 6. 返回结果

state = np.array([self.current_inventory])

info = {"demand": demand, "action": action}

return state, reward, done, info

def reset(self):

"""重置环境(新的30天周期)"""

self.current_inventory = 20

self.day = 0

return np.array([self.current_inventory])

def render(self, mode='human'):

"""打印当前状态(方便调试)"""

print(f"第{self.day}天 | 库存:{self.current_inventory}件 | 今日销量:{self.demand}件 | 今日下单:{self.action}件")

步骤3:训练Agent

用DQN算法训练Agent,让它学会“保持库存10-30件”。代码:

# 1. 初始化环境

env = InventoryEnv()

# 2. 初始化DQN模型(用多层感知机作为政策网络)

model = DQN(

policy="MlpPolicy", # 多层感知机(适合简单环境)

env=env, # 我们定义的库存环境

verbose=1, # 打印训练日志

learning_rate=1e-3, # 学习率(控制学习速度)

buffer_size=10000, # 经验回放缓冲区大小(存储过去的经验)

learning_starts=100, # 前100步不学习,只收集经验

batch_size=32, # 每次学习用32条经验

gamma=0.95 # 折扣因子(未来奖励的权重,0.95表示未来奖励很重要)

)

# 3. 训练10000步(约333个周期)

model.learn(total_timesteps=10000)

# 4. 保存模型(方便下次用)

model.save("inventory_agent")

步骤4:测试Agent

训练好后,测试Agent的表现——让它管理30天库存,看是否能保持在10-30件。代码:

# 1. 加载训练好的模型

model = DQN.load("inventory_agent")

# 2. 重置环境

obs = env.reset()

# 3. 运行30天

for _ in range(30):

# Agent根据当前状态(库存)预测动作(下单数量)

action, _ = model.predict(obs, deterministic=True)

# 执行动作,得到新状态、奖励等

obs, reward, done, info = env.step(action)

# 打印当前状态

print(f"第{env.day}天 | 库存:{env.current_inventory}件 | 今日销量:{info['demand']}件 | 今日下单:{action}件 | 奖励:{reward}分")

if done:

break

测试结果示例

运行后,你会看到类似这样的输出:

第1天 | 库存:23件 | 今日销量:3件 | 今日下单:0件 | 奖励:10分

第2天 | 库存:20件 | 今日销量:3件 | 今日下单:0件 | 奖励:10分

第3天 | 库存:17件 | 今日销量:3件 | 今日下单:0件 | 奖励:10分

第4天 | 库存:14件 | 今日销量:3件 | 今日下单:0件 | 奖励:10分

第5天 | 库存:11件 | 今日销量:3件 | 今日下单:0件 | 奖励:10分

第6天 | 库存:8件 | 今日销量:3件 | 今日下单:20件 | 奖励:-10分

第7天 | 库存:25件 | 今日销量:3件 | 今日下单:0件 | 奖励:10分

...

看第6天:库存降到8件(低于10),Agent马上下单20件,第7天库存回到25件(合理范围)——这说明Agent已经学会了“缺货时补库存”的规则!

数学模型:强化学习的“底层逻辑”

刚才的代码背后,是马尔可夫决策过程(MDP)和Q-learning的数学模型。我们用“便利店库存”的例子,讲清楚每个公式的意思。

1. 马尔可夫决策过程(MDP):描述“状态→动作→结果”的框架

MDP由5个元素组成:

- 状态空间(S):所有可能的状态(比如库存0-100件);

- 动作空间(A):所有可能的动作(比如下单0-50件);

- 转移概率(P):做动作a后,从状态s到s’的概率(比如库存5件→下单20件→库存25件的概率是1,因为我们的环境是确定性的);

- 奖励函数(R):做动作a后得到的奖励(比如库存5件→下单20件→奖励10分);

- 折扣因子(γ):未来奖励的权重(比如γ=0.95,意味着明天的10分相当于今天的9.5分)。

2. Q-learning:Agent的“决策手册”

Q-learning的核心是Q函数——Q(s,a)表示“在状态s下做动作a的总奖励(包括未来)”。Agent的目标是找到最大的Q值,也就是“在当前状态下,做哪个动作能得到最多奖励”。

Q函数的更新公式是:

Q(s,a)←Q(s,a)+α[R+γmaxa′Q(s′,a′)−Q(s,a)] Q(s,a) \leftarrow Q(s,a) + \alpha \left[ R + \gamma \max_{a'} Q(s',a') - Q(s,a) \right] Q(s,a)←Q(s,a)+α[R+γa′maxQ(s′,a′)−Q(s,a)]

我们用便利店的例子解释每个符号:

- sss:当前状态(比如库存5件);

- aaa:当前动作(比如下单20件);

- RRR:当前动作的奖励(比如10分);

- s′s's′:下一个状态(比如库存25件);

- a′a'a′:下一个状态的动作(比如下单0件);

- α\alphaα:学习率(比如0.1,控制Q值更新的速度);

- γ\gammaγ:折扣因子(比如0.95);

- maxa′Q(s′,a′)\max_{a'} Q(s',a')maxa′Q(s′,a′):下一个状态s’的最大Q值(比如Q(25,0)=10分)。

3. 例子:Q值怎么更新?

假设当前状态s=5(库存5件),动作a=20(下单20件),奖励R=10分,下一个状态s’=25(库存25件),maxa′Q(s′,a′)=10\max_{a'} Q(s',a')=10maxa′Q(s′,a′)=10,α=0.1\alpha=0.1α=0.1,γ=0.95\gamma=0.95γ=0.95。

代入公式:

Q(5,20)←Q(5,20)+0.1×[10+0.95×10−Q(5,20)] Q(5,20) \leftarrow Q(5,20) + 0.1 \times [10 + 0.95 \times 10 - Q(5,20)] Q(5,20)←Q(5,20)+0.1×[10+0.95×10−Q(5,20)]

假设原来的Q(5,20)=5分,计算:

Q(5,20)=5+0.1×(10+9.5−5)=5+0.1×14.5=6.45 Q(5,20) = 5 + 0.1 \times (10 + 9.5 - 5) = 5 + 0.1 \times 14.5 = 6.45 Q(5,20)=5+0.1×(10+9.5−5)=5+0.1×14.5=6.45

这意味着,Agent现在知道“库存5件时下单20件”的Q值从5分涨到了6.45分——下次遇到同样的状态,它会更愿意选这个动作!

项目实战:让Agent“更聪明”的技巧

刚才的代码是“基础版”,要让Agent更适应真实场景,还需要做3件事:

1. 增加环境的“真实性”

比如:

- 销量不是随机的,而是根据季节(夏天可乐卖得多)、促销(周末冰淇淋卖得多)变化;

- 供应商的交货时间不是“第二天到”,而是“2-3天到”(需要Agent提前下单);

- 库存成本(积压的商品要付仓储费):奖励规则里加入“积压1件扣1分”。

2. 优化奖励函数

奖励函数是Agent的“指挥棒”,直接决定它的行为。比如:

- 原来的奖励是“库存10-30得10分”,可以改成“库存15-25得15分”(更严格的合理范围);

- 加入“缺货损失”:缺货1件扣2分(比积压更严重);

- 加入“成本控制”:下单1件扣0.1分(鼓励少下单,降低采购成本)。

3. 用多智能体协作

比如便利店有3个Agent:

- 库存Agent:管理库存,避免缺货/积压;

- 推荐Agent:根据库存推荐商品(比如库存多的冰淇淋,推荐“买一送一”);

- 供应链Agent:和供应商沟通,确保下单后能及时到货。

这三个Agent协作,比单个Agent更有效——比如库存Agent告诉推荐Agent“冰淇淋库存50件”,推荐Agent就做促销,库存很快降到20件;推荐Agent告诉库存Agent“冰淇淋促销后每天卖10件”,库存Agent就多下单10件,避免缺货。

实际应用场景:Agentic AI在各行业的“神奇操作”

Agentic AI不是“实验室里的玩具”,已经在零售、医疗、制造、金融、教育5个行业落地,解决了很多“传统AI解决不了的问题”。

1. 零售:从“被动卖货”到“主动运营”

案例:沃尔玛的“智能库存Agent”

沃尔玛用Agentic AI管理全球10000+家门店的库存:

- 感知:收集门店的销售数据、库存数据、天气数据、促销计划;

- 决策:预测某商品的销量(比如夏天可乐销量增长50%),计算最优库存(比如每个门店备100件可乐);

- 行动:自动向供应商下单,调整货架陈列(把可乐放在入口处),提醒店员补货。

结果:沃尔玛的缺货率下降了30%,库存成本降低了20%。

2. 医疗:从“辅助诊断”到“主动关怀”

案例:梅奥诊所的“糖尿病管理Agent”

梅奥诊所开发了一个Agent,帮助糖尿病患者管理血糖:

- 感知:收集患者的血糖数据(通过智能血糖仪)、饮食记录(通过APP)、运动数据(通过智能手表);

- 决策:当血糖超过15mmol/L时,建议“注射胰岛素”;当患者忘记吃药时,提醒“该吃二甲双胍了”;

- 行动:给患者发微信提醒,给医生发报告(包含患者的血糖趋势)。

结果:患者的血糖控制率从60%提升到85%,住院率下降了40%。

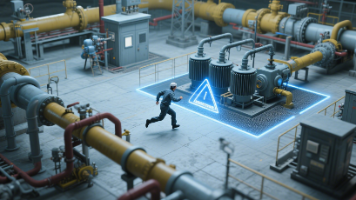

3. 制造:从“事后维修”到“事前预防”

案例:西门子的“设备维护Agent”

西门子用Agentic AI管理工厂的机床:

- 感知:收集机床的振动数据、温度数据、转速数据(通过传感器);

- 决策:当振动超过阈值时,预测“轴承可能在24小时内故障”;

- 行动:自动通知维修部门,下单购买轴承配件,调整生产计划(把该机床的订单转移到其他机床)。

结果:机床的停机时间减少了50%,维修成本降低了35%。

4. 金融:从“被动理财”到“主动规划”

案例:富达基金的“智能理财Agent”

富达基金开发了一个Agent,帮助用户管理资产:

- 感知:收集用户的收入、支出、存款、风险偏好(通过问卷);

- 决策:根据用户的情况,推荐“每月定投2000元沪深300指数基金+30万重疾险”;

- 行动:自动完成定投,监控市场变化(比如沪深300跌到3000点以下,建议增加定投金额)。

结果:用户的投资回报率提升了15%,满意度达到90%。

5. 教育:从“统一教学”到“个性化学习”

案例:可汗学院的“学习Agent”

可汗学院用Agentic AI帮助学生学习数学:

- 感知:收集学生的测试成绩、练习记录、错题本;

- 决策:如果学生的乘法正确率只有60%,推荐“做20道乘法题”;如果学生的除法正确率90%,推荐“开始学除法竖式”;

- 行动:生成个性化学习计划,给学生发练习题,讲解错题。

结果:学生的数学成绩提升了25%,学习兴趣增加了40%。

工具和资源推荐

想开发或使用Agentic AI?这些工具和资源能帮到你:

1. 开发工具

- LangChain:构建Agentic AI的框架(支持提示工程、多智能体协作);

- AutoGPT:开源的自主AI代理(能自动完成“搜索信息→做决策→执行任务”);

- Stable-Baselines3:强化学习算法库(提供DQN、PPO等算法);

- Gym:强化学习环境库(模拟各种场景,比如库存、游戏)。

2. 学习资源

- 书籍:《Reinforcement Learning: An Introduction》(Sutton和Barto,强化学习的“圣经”);

- 课程:Coursera《Reinforcement Learning Specialization》(吴恩达团队开发,通俗易懂);

- 博客:《Agentic AI: The Future of Autonomous Systems》(OpenAI官方博客,讲Agentic AI的趋势)。

未来发展趋势与挑战

Agentic AI的未来很美好,但也有很多“坑”要填:

1. 趋势:多智能体协作成为主流

未来的Agentic AI不会是“单打独斗”,而是多个Agent一起工作——比如:

- 零售:库存Agent+推荐Agent+供应链Agent协作;

- 医疗:诊断Agent+护理Agent+药物Agent协作;

- 制造:设备Agent+生产Agent+物流Agent协作。

多智能体协作能解决更复杂的问题,但也需要解决“沟通”问题——比如两个Agent的目标冲突(库存Agent想多下单,供应链Agent想少下单),需要设计“协调机制”。

2. 趋势:更强大的自主学习能力

现在的Agent需要大量数据才能学习,未来的Agent会从更少的数据中学习(小样本学习),甚至主动收集数据(主动学习)——比如:

- 医疗Agent遇到新的病历,会主动询问医生“这个诊断对吗?”,从而学习新的知识;

- 制造Agent遇到新的设备,会主动测试“这个参数会不会导致故障?”,从而适应新环境。

3. 挑战:自主性与可控性的平衡

Agentic AI越自主,越容易“偏离目标”——比如:

- 库存Agent为了不缺货,大量下单导致积压;

- 医疗Agent为了提高诊断准确率,过度推荐检查(增加患者成本)。

解决方法:设计“安全边界”——比如给库存Agent设置“最大下单数量”(不能超过50件),给医疗Agent设置“检查项目的上限”(不能超过3项)。

4. 挑战:数据隐私与伦理

Agentic AI需要收集大量用户数据(比如医疗Agent的病历、金融Agent的财务数据),这些数据很敏感——比如:

- 病历泄露会导致患者的隐私被侵犯;

- 财务数据泄露会导致用户的财产损失。

解决方法:联邦学习(Federated Learning)——让Agent在用户本地学习(不传输原始数据),只传输模型参数,保护隐私。

5. 挑战:可解释性

Agentic AI的决策过程很“黑箱”——比如医疗Agent推荐某个诊断,医生不知道“为什么”,就不敢相信它。

解决方法:可解释AI(XAI)——用工具(比如SHAP、LIME)解释Agent的决策过程,比如“Agent推荐糖尿病诊断,是因为患者的血糖15mmol/L,糖化血红蛋白7.5%”。

总结:Agentic AI是“能主动帮你解决问题的AI”

我们用“便利店故事+代码+行业案例”,讲清楚了Agentic AI的核心:

- 是什么:能自主完成“感知→决策→行动→学习”闭环的AI;

- 怎么工作:靠强化学习训练,用提示工程定规则;

- 能做什么:在零售、医疗、制造等行业解决“传统AI解决不了的问题”。

Agentic AI不是“取代人类”,而是辅助人类——它帮便利店老板减少库存压力,帮医生减少诊断误差,帮工厂经理减少停机损失。未来,每个行业都会有自己的“Agentic AI助手”,就像现在每个人都有手机一样。

思考题:动动小脑筋

- 你所在的行业,有哪些问题可以用Agentic AI解决?比如:

- 老师:有没有“智能作业Agent”,能自动批改作业、推荐练习题?

- 快递员:有没有“智能路线Agent”,能自动规划最优路线?

- 如果设计一个“家庭管家Agent”,你会给它定什么提示?比如:“你是家庭管家,要帮我管理日程、订外卖、提醒吃药,不要泄露我的隐私”。

- 多智能体协作会带来什么新问题?比如:两个Agent的目标冲突(一个想省钱,一个想舒适),怎么解决?

附录:常见问题与解答

Q1:Agentic AI和普通AI(比如ChatGPT)有什么区别?

A:普通AI是“被动响应”(你问我答),Agentic AI是“主动行动”(我想清楚了就去做)。比如:

- 你问ChatGPT“今天吃什么?”,它推荐火锅;

- Agentic AI会“分析你的饮食记录+天气”,主动说“今天吃火锅吧,我帮你订外卖”。

Q2:提示工程对Agentic AI很重要吗?

A:非常重要!提示工程是给Agent定“规则和目标”,就像给员工布置工作——你说清楚“要做什么、怎么做”,Agent才能做好。比如:

- 不好的提示:“你是库存管家”;

- 好的提示:“你是库存管家,要保持库存10-30件,低于10件下单20件,高于30件停止下单”。

Q3:Agentic AI会取代人类吗?

A:不会!Agentic AI是“辅助工具”,不能取代人类的创造力、伦理判断、情感理解。比如:

- 医疗Agent能辅助医生诊断,但不能取代医生(医生要考虑患者的情绪、家庭情况);

- 教育Agent能辅助老师教学,但不能取代老师(老师要鼓励学生、解决心理问题)。

扩展阅读 & 参考资料

- 论文:《Reinforcement Learning: An Introduction》(Sutton和Barto);

- 书籍:《Agent-Based Modeling and Simulation》(Bonabeau);

- 博客:《The Rise of Agentic AI》(OpenAI);

- 案例:沃尔玛、梅奥诊所、西门子的Agentic AI应用报告。

结语:Agentic AI不是“未来的科技”,而是“现在就能用的工具”。不管你是便利店老板、医生、程序员,都可以尝试用Agentic AI解决自己的问题——毕竟,“能主动帮你做事的AI”,谁不想要呢?

如果这篇文章帮到了你,欢迎分享给朋友——让更多人看到Agentic AI的神奇!

更多推荐

已为社区贡献216条内容

已为社区贡献216条内容

所有评论(0)