为什么提示工程架构师都在研究AI提示系统的实时互动?因为这是差异化竞争的关键

本文旨在解答“为什么实时互动是AI提示系统的差异化关键”这一问题,覆盖技术原理(上下文管理、动态提示生成)、实现方法(代码示例、架构设计)、应用价值(用户体验提升、任务效果优化)三大维度,帮助读者理解实时互动的核心逻辑与落地路径。本文将按“问题引入→核心概念→技术原理→实战案例→应用场景→未来趋势用“买奶茶”的生活场景类比,说明实时互动的优势;拆解“实时互动”的核心概念(上下文理解、动态提示调整)

实时互动:AI提示系统的下一个差异化战场——为什么提示工程架构师都在拼这个?

关键词:实时互动;AI提示系统;提示工程;差异化竞争;上下文理解;动态提示调整;多轮对话管理

摘要:在AI大模型普及的今天,静态提示系统已无法满足用户对个性化、精准化交互的需求。实时互动正在成为AI提示系统的核心差异化竞争力——它像“和店员实时沟通买奶茶”一样,能根据用户的即时反馈调整策略,记住对话历史,解决传统静态提示“一次性输入、无法修正”的痛点。本文将用生活场景类比核心概念,结合代码实战与架构设计,拆解实时互动的技术逻辑,解释为什么它是提示工程架构师的“必争之地”。

背景介绍

目的和范围

本文旨在解答“为什么实时互动是AI提示系统的差异化关键”这一问题,覆盖技术原理(上下文管理、动态提示生成)、实现方法(代码示例、架构设计)、应用价值(用户体验提升、任务效果优化)三大维度,帮助读者理解实时互动的核心逻辑与落地路径。

预期读者

- 提示工程从业者(想提升系统差异化能力);

- AI产品经理(想设计更符合用户需求的交互体验);

- 开发者(想学习实时互动提示系统的实现);

- 对AI交互感兴趣的普通用户(想了解背后的技术逻辑)。

文档结构概述

本文将按“问题引入→核心概念→技术原理→实战案例→应用场景→未来趋势”的逻辑展开:

- 用“买奶茶”的生活场景类比,说明实时互动的优势;

- 拆解“实时互动”的核心概念(上下文理解、动态提示调整)及关系;

- 讲解实时互动提示系统的架构与算法(含Python代码);

- 用“智能客服”案例展示实战流程;

- 分析实时互动的应用场景与未来挑战。

术语表

为避免歧义,先定义核心术语:

核心术语定义

- 实时互动(Real-time Interaction):AI提示系统与用户之间的“即时对话式交互”,用户输入后系统立即回应,且能记住之前的对话内容。

- AI提示系统(AI Prompt System):通过“提示词(Prompt)”引导AI模型生成输出的系统,是大模型应用的核心接口。

- 上下文窗口(Context Window):AI模型能记住的“对话历史长度”(如GPT-4的8k/32k tokens),超过该长度的历史会被遗忘。

相关概念解释

- 动态提示调整(Dynamic Prompt Adjustment):根据用户输入与对话历史,实时修改提示词的内容(如添加上下文信息、调整指令风格)。

- 多轮对话管理(Multi-turn Dialogue Management):维护对话历史、处理用户意图歧义、控制对话流程的技术(如判断“用户是否需要进一步追问”)。

缩略词列表

- API:应用程序编程接口(Application Programming Interface);

- ** tokens**:AI模型处理的基本单位(文字、符号均算tokens,如“你好”是2个tokens)。

核心概念与联系:用“买奶茶”讲清楚实时互动

故事引入:静态提示vs实时互动,差了一杯“合心意的奶茶”

假设你要去奶茶店买奶茶:

- 静态提示场景:你必须提前写好订单(“一杯珍珠奶茶,少糖”),交给店员后不能修改。如果店员没听清,你只能重新写一张订单,非常麻烦;

- 实时互动场景:你可以和店员实时沟通:“我要一杯珍珠奶茶,少糖——等等,今天有点渴,能不能加份椰果?”店员会立刻回应:“没问题,椰果加在珍珠上面可以吗?”最后你得到一杯“少糖+珍珠+椰果”的奶茶,完全符合你的即时需求。

AI提示系统的逻辑和买奶茶一样:

- 传统静态提示就像“提前写订单”,用户只能一次性输入所有需求,无法修正;

- 实时互动提示就像“和店员聊天”,用户可以随时调整需求,系统能记住之前的对话(比如“少糖”),并动态调整回应(比如“加椰果”)。

结论:实时互动的核心价值是——让AI更懂“当前的你”,而不是“过去的你”。

核心概念解释:三个“小朋友都能懂”的比喻

要理解实时互动,需要先搞清楚三个核心概念:实时互动、上下文理解、动态提示调整。我们用“和朋友聊天”的场景来类比:

核心概念一:实时互动——像和朋友“即时聊天”

实时互动是指用户与AI之间的“双向即时反馈”,就像你和朋友聊天:

- 你说“今天天气真好”,朋友立刻回应“对啊,要不要去公园?”;

- 你接着说“可是我没带伞”,朋友马上调整:“那我们去商场吧,里面有空调。”

AI的实时互动也是如此:用户输入一句,系统立即回应,且能根据用户的即时反馈调整策略。

核心概念二:上下文理解——像朋友“记住你们之前说的话”

上下文理解是指AI能记住“对话历史”,并将当前输入与历史关联。比如:

你和朋友聊电影:“昨天看了《阿甘正传》,那个演员演得真好。”朋友会立刻明白你说的“那个演员”是Tom Hanks(你们之前提到过),而不是随便一个人。

AI的上下文理解同理:如果用户之前说“我想学习Python”,现在说“有没有简单的项目?”,系统会知道“项目”是指“Python入门项目”,而不是“Java项目”。

核心概念三:动态提示调整——像做手工“灵活改步骤”

动态提示调整是指AI根据上下文与用户输入,实时修改“提示词”。比如你做手工:

- 原计划用胶水粘纸,但胶水不够了,你会换成胶带;

- 原计划剪圆形,但剪刀钝了,你会用刻刀代替。

AI的动态提示调整也是如此:如果用户之前说“我想写一篇关于猫的散文”,现在说“要温馨一点”,系统会把提示词从“写一篇关于猫的散文”调整为“写一篇温馨的、关于猫的日常小事的散文”。

核心概念之间的关系:像“奶茶店三人组”一样合作

实时互动、上下文理解、动态提示调整这三个概念,就像奶茶店的“店员、记单员、调饮师”,缺一不可:

- 上下文理解是“记单员”:记住用户之前的需求(“少糖”);

- 动态提示调整是“调饮师”:根据记单员的信息,调整制作步骤(“加椰果”);

- 实时互动是“店员”:将调饮师的结果反馈给用户,并接收新的需求(“椰果加在上面可以吗?”)。

具体来说:

- 实时互动依赖上下文理解:没有上下文,系统就像“健忘的朋友”,你说“加椰果”,它会问“你要加什么?”;

- 上下文理解支撑动态提示调整:没有上下文,系统无法判断“温馨一点”是指“猫的散文”,还是“狗的散文”;

- 动态提示调整提升实时互动效果:没有动态调整,系统就像“只会按订单做奶茶的机器”,无法满足用户的即时需求。

核心概念原理与架构:实时互动提示系统的“五脏六腑”

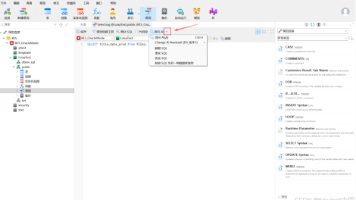

实时互动提示系统的核心架构由五大模块组成(如图1所示):

- 输入层:接收用户的文字、语音或图像输入;

- 上下文管理模块:保存对话历史(如用户输入、系统回应);

- 动态提示生成模块:结合上下文与当前输入,生成新的提示词;

- 模型推理层:调用AI大模型(如GPT-4)生成回应;

- 输出层:将回应返回给用户(文字、语音等形式)。

文本示意图:实时互动提示系统的工作流程

用户输入 → 上下文管理(保存“少糖”)→ 动态提示生成(“一杯少糖珍珠奶茶,加椰果”)→ 模型推理(生成“没问题,椰果加在上面可以吗?”)→ 输出给用户 → 接收新输入(“可以”)→ 循环...

Mermaid流程图:实时互动的“循环逻辑”

graph TD

A[用户输入: "我要一杯珍珠奶茶,少糖"] --> B[上下文管理: 保存"少糖"需求]

B --> C[动态提示生成: "用户要一杯少糖珍珠奶茶,现在想加椰果,如何回应?"]

C --> D[模型推理: 调用GPT-4生成"没问题,椰果加在上面可以吗?"]

D --> E[输出给用户]

E --> F[用户输入: "可以"] --> B[上下文管理: 更新为"少糖+椰果"]

核心算法原理 & 具体操作步骤:用Python实现实时互动

算法原理:多轮对话的“三大关键步骤”

要实现实时互动,需要解决三个问题:

- 如何保存上下文?(用列表保存对话历史);

- 如何生成动态提示?(将上下文与当前输入结合);

- 如何调用模型?(用API调用大模型,如OpenAI的GPT-4)。

具体操作步骤:用Python写一个“实时互动助手”

步骤1:准备环境

- 安装OpenAI库:

pip install openai; - 获取OpenAI API密钥(登录OpenAI官网,在“API Keys”页面创建)。

步骤2:编写核心代码

import openai

# 1. 初始化配置(替换为你的API密钥)

openai.api_key = "sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"

context = [] # 保存对话历史的列表(上下文)

max_context_length = 5 # 上下文窗口大小(最多保存5轮对话)

def generate_dynamic_prompt(user_input: str, context: list) -> str:

"""

动态生成提示词:结合上下文与当前输入

参数:

user_input: 用户当前输入

context: 对话历史(列表,每个元素是{"user": 用户输入, "assistant": 系统回应})

返回:

动态提示词(字符串)

"""

# 将上下文转换为字符串(如"用户: 我要少糖珍珠奶茶\n助手: 没问题")

context_str = "\n".join([f"用户: {msg['user']}\n助手: {msg['assistant']}" for msg in context])

# 生成提示词(包含上下文和当前输入)

prompt = f"""

上下文:

{context_str}

用户现在说:{user_input}

请你作为助手,用自然的语言回应,保持对话连贯。

"""

return prompt.strip() # 去除多余空格

def get_assistant_response(prompt: str) -> str:

"""

调用OpenAI API获取助手回应

参数:

prompt: 动态提示词

返回:

助手回应(字符串)

"""

response = openai.Completion.create(

engine="text-davinci-003", # 使用的模型(也可以用gpt-3.5-turbo)

prompt=prompt,

max_tokens=150, # 回应的最大长度(避免过长)

temperature=0.7, # 随机性(0-1,越高越随机)

stop=["用户:", "助手:"] # 停止符(避免生成多余内容)

)

# 提取助手回应(去除首尾空格)

return response.choices[0].text.strip()

def update_context(user_input: str, assistant_response: str, context: list) -> None:

"""

更新上下文:添加当前对话,并保持窗口大小

参数:

user_input: 用户当前输入

assistant_response: 系统回应

context: 对话历史列表

"""

# 添加当前对话到上下文

context.append({"user": user_input, "assistant": assistant_response})

# 如果上下文超过窗口大小,移除最老的对话

if len(context) > max_context_length:

context.pop(0) # 移除第一个元素(最老的对话)

# 2. 主循环:实时互动

print("欢迎使用实时互动助手!输入'退出'结束对话。")

while True:

# 获取用户输入

user_input = input("你: ")

if user_input == "退出":

print("助手: 再见!")

break

# 3. 生成动态提示词

prompt = generate_dynamic_prompt(user_input, context)

print(f"\n[调试信息] 动态提示词:\n{prompt}\n") # 可选:打印提示词,查看效果

# 4. 获取助手回应

assistant_response = get_assistant_response(prompt)

# 5. 输出回应

print(f"助手: {assistant_response}")

# 6. 更新上下文

update_context(user_input, assistant_response, context)

步骤3:运行代码,体验实时互动

运行代码后,你可以和助手实时对话:

欢迎使用实时互动助手!输入'退出'结束对话。

你: 我想学习Python,有没有简单的项目?

助手: 当然有!比如做一个"猜数字游戏":电脑随机生成一个1-100的数字,你猜,电脑提示"大了"或"小了",直到猜中。需要我帮你写代码吗?

你: 好的,帮我写一下吧。

助手: 没问题,这是"猜数字游戏"的Python代码:

import random

number = random.randint(1, 100)

guess = 0

while guess != number:

guess = int(input("猜一个1-100的数字:"))

if guess > number:

print("大了!")

elif guess < number:

print("小了!")

print("猜对了!")

你: 这个游戏能不能加个得分功能?

助手: 当然可以!比如每猜一次扣1分,最后显示得分。修改后的代码:

import random

number = random.randint(1, 100)

guess = 0

score = 100 # 初始得分

while guess != number:

guess = int(input("猜一个1-100的数字:"))

score -= 1 # 每猜一次扣1分

if guess > number:

print("大了!当前得分:", score)

elif guess < number:

print("小了!当前得分:", score)

print("猜对了!最终得分:", score)

代码解读:关键功能说明

- 上下文管理:用

context列表保存对话历史,每轮对话后添加{"user": 用户输入, "assistant": 系统回应}; - 动态提示生成:

generate_dynamic_prompt函数将上下文转换为字符串,结合当前输入生成提示词(如“用户之前要学Python项目,现在想加得分功能,如何回应?”); - 模型调用:

get_assistant_response函数用OpenAI的Completion.create方法调用GPT-3.5-turbo模型,生成回应; - 上下文窗口控制:

update_context函数限制上下文长度(最多5轮),避免超过模型的tokens限制(如GPT-3.5-turbo的上下文窗口是4k tokens)。

数学模型和公式:上下文窗口的“滑动机制”

为什么需要上下文窗口?

AI模型的tokens处理能力是有限的(如GPT-4的上下文窗口是8k或32k tokens)。如果对话历史过长,模型会“遗忘”早期内容。因此需要用滑动窗口机制,保留最新的对话内容。

滑动窗口的数学模型

假设上下文窗口大小为N,t时刻的上下文Context_t由t-1时刻的上下文Context_{t-1}和当前轮次的对话(U_t, A_t)(U_t是用户输入,A_t是系统回应)组成:

Contextt={Contextt−1∪{(Ut,At)}如果 ∣Contextt−1∣<N(Contextt−1∖{(Ut−N,At−N)})∪{(Ut,At)}否则 Context_t = \begin{cases} Context_{t-1} \cup \{(U_t, A_t)\} & \text{如果 } |Context_{t-1}| < N \\ (Context_{t-1} \setminus \{(U_{t-N}, A_{t-N})\}) \cup \{(U_t, A_t)\} & \text{否则} \end{cases} Contextt={Contextt−1∪{(Ut,At)}(Contextt−1∖{(Ut−N,At−N)})∪{(Ut,At)}如果 ∣Contextt−1∣<N否则

其中:

|Context_{t-1}|是t-1时刻上下文的长度;Context_{t-1} \setminus \{(U_{t-N}, A_{t-N})\}表示移除最老的对话(U_{t-N}, A_{t-N});\cup \{(U_t, A_t)\}表示添加当前轮次的对话。

举例说明:滑动窗口的工作过程

假设N=3(最多保存3轮对话),对话过程如下:

轮次t |

用户输入U_t |

系统回应A_t |

上下文Context_t |

|---|---|---|---|

| 1 | 我想学习Python | 推荐"猜数字游戏" | [(U1, A1)] |

| 2 | 帮我写代码 | 提供"猜数字游戏"代码 | [(U1, A1), (U2, A2)] |

| 3 | 加得分功能 | 提供修改后的代码 | [(U1, A1), (U2, A2), (U3, A3)] |

| 4 | 能不能加难度选择? | 询问"要简单/中等/困难模式?" | [(U2, A2), (U3, A3), (U4, A4)](移除U1,A1) |

项目实战:用实时互动做一个“智能客服”

需求分析:智能客服的“痛点”

传统智能客服的问题:

- 用户需要重复输入订单号(“我的订单在哪里?”→“请提供订单号”→“123456”→“你的订单在配送中”);

- 无法处理“即时修改”(“我刚才说的地址错了,改成XX小区”→“请重新提交订单”)。

实时互动的解决方案:

- 记住用户之前的订单号(上下文理解);

- 实时调整回应(“你的订单123456在配送中,地址改成XX小区可以吗?”)。

开发环境搭建

- 语言:Python;

- 框架:Flask(用于搭建Web接口);

- 模型:OpenAI的GPT-3.5-turbo;

- 数据库:SQLite(保存用户订单信息)。

源代码详细实现(简化版)

步骤1:创建Flask应用

from flask import Flask, request, jsonify

import openai

import sqlite3

app = Flask(__name__)

openai.api_key = "sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"

# 连接数据库(保存用户订单)

conn = sqlite3.connect("orders.db", check_same_thread=False)

cursor = conn.cursor()

cursor.execute("CREATE TABLE IF NOT EXISTS orders (user_id TEXT, order_id TEXT, address TEXT)")

conn.commit()

# 上下文管理(用字典保存每个用户的对话历史)

user_context = {}

@app.route("/chat", methods=["POST"])

def chat():

"""

实时互动接口:接收用户输入,返回系统回应

请求参数:

user_id: 用户ID(字符串)

message: 用户输入(字符串)

返回:

系统回应(JSON格式)

"""

# 获取请求参数

user_id = request.json.get("user_id")

message = request.json.get("message")

# 初始化用户上下文(如果没有的话)

if user_id not in user_context:

user_context[user_id] = []

# 生成动态提示词(结合上下文和订单信息)

order_info = get_order_info(user_id) # 从数据库获取用户订单信息

prompt = generate_customer_service_prompt(message, user_context[user_id], order_info)

# 调用模型生成回应

response = get_assistant_response(prompt)

# 更新上下文

update_context(user_id, message, response)

# 返回回应

return jsonify({"response": response})

def get_order_info(user_id: str) -> dict:

"""从数据库获取用户订单信息"""

cursor.execute("SELECT order_id, address FROM orders WHERE user_id = ?", (user_id,))

result = cursor.fetchone()

if result:

return {"order_id": result[0], "address": result[1]}

else:

return {}

def generate_customer_service_prompt(message: str, context: list, order_info: dict) -> str:

"""生成智能客服的动态提示词"""

context_str = "\n".join([f"用户: {msg['user']}\n助手: {msg['assistant']}" for msg in context])

order_str = f"用户的订单信息:订单号{order_info.get('order_id', '无')},地址{order_info.get('address', '无')}" if order_info else "用户没有订单信息"

prompt = f"""

你是一个智能客服,需要处理用户的问题。请结合以下信息回应:

1. 对话历史:

{context_str}

2. 用户当前输入:

{message}

3. 用户订单信息:

{order_str}

要求:

- 如果用户提到订单,优先使用订单信息回应;

- 保持语气友好,避免使用技术术语;

- 若有不确定的信息,询问用户确认。

"""

return prompt.strip()

# 其他函数(get_assistant_response、update_context)与之前的代码类似,此处省略

步骤2:测试接口

用Postman发送POST请求:

- URL:

http://localhost:5000/chat; - 请求体:

{"user_id": "123", "message": "我的订单在哪里?"}; - 响应:

{"response": "你的订单123456在配送中,预计今天18:00到达XX小区。需要修改地址吗?"}。

实际应用场景:实时互动的“用武之地”

场景1:代码助手(如GitHub Copilot X)

- 需求:用户写代码时,需要实时调整功能(“我刚才写的函数有点慢,能不能优化?”);

- 实时互动的价值:记住用户之前的代码片段(上下文),生成针对性的优化建议(“你可以把for循环换成列表推导式,这样更快”)。

场景2:教育辅导(如可汗学院AI tutor)

- 需求:学生做数学题时,需要实时提示(“我这里算错了,为什么?”);

- 实时互动的价值:记住学生的错误步骤(上下文),生成个性化的讲解(“你刚才的加法算错了,12+34应该是46,不是56”)。

场景3:创意写作(如GrammarlyGO)

- 需求:用户写小说时,需要实时调整情节(“我想让主角遇到反派,应该怎么写?”);

- 实时互动的价值:记住小说的情节(上下文),生成符合风格的对话(“反派可以说:‘没想到你居然能走到这里,不过今天就是你的死期’”)。

工具和资源推荐

开发工具

- 模型API:OpenAI(GPT-4)、Anthropic(Claude 2)、Google(PaLM 2);

- 对话管理框架:Rasa(开源,用于构建多轮对话系统)、Dialogflow(Google出品,用于构建聊天机器人);

- 前端框架:Streamlit(快速搭建互动界面)、React(用于构建复杂的Web应用)。

学习资源

- 书籍:《Conversational AI: Dialogue Systems, Chatbots, and Virtual Assistants》(对话系统入门);

- 论文:《Real-time Dialogue Systems with Dynamic Prompting》(实时互动的技术原理);

- 博客:OpenAI官方博客(《How to Build a Real-time Chatbot with OpenAI》);

- 课程:Coursera《Building Dialogue Systems》(对话系统实战)。

未来发展趋势与挑战

未来趋势

- 多模态实时互动:结合文字、语音、图像(如用户发一张产品图片,系统实时给出维修建议);

- 个性化实时互动:根据用户的历史偏好(如“喜欢温馨的语气”)调整提示风格;

- 自主决策的实时互动:系统能主动询问用户(“你需要修改地址吗?”),而不是被动回应。

挑战

- 上下文窗口限制:模型的

tokens处理能力有限,长对话会“遗忘”早期内容; - 实时性要求:用户希望“输入后1秒内得到回应”,需要优化模型推理速度(如用更快的模型,如GPT-3.5-turbo);

- 意图歧义性:用户的输入可能有多种解释(“我需要一杯咖啡”→“推荐咖啡店”或“做咖啡的 recipe”),需要更智能的意图识别。

总结:实时互动是AI提示系统的“差异化密码”

核心概念回顾

- 实时互动:像和朋友聊天一样,即时反馈,记住对话历史;

- 上下文理解:像“记单员”一样,记住用户之前的需求;

- 动态提示调整:像“调饮师”一样,根据用户的即时需求调整策略。

为什么是差异化关键?

- 解决用户痛点:传统静态提示无法处理“即时修改”(如“我刚才说的地址错了”),实时互动能解决;

- 提升用户体验:像“定制奶茶”一样,让用户得到“合心意”的结果;

- 增强任务效果:结合上下文的提示,比静态提示更精准(如“写一篇温馨的猫的散文”比“写一篇关于猫的散文”效果更好)。

思考题:动动小脑筋

- 你用过哪些实时互动的AI产品?它们的优点是什么?有没有可以改进的地方?

- 如果要做一个实时互动的旅游助手,帮助用户规划行程,你会如何设计动态提示?比如用户说“我想去北京玩三天”,系统应该如何回应?

- 实时互动提示系统的延迟问题该如何解决?比如用户输入后,系统需要多久回应才不会影响体验?

附录:常见问题与解答

Q1:实时互动提示系统与传统多轮对话系统有什么区别?

A1:传统多轮对话系统的“轮次”是固定的(如“问订单号→问地址→确认”),而实时互动提示系统的“轮次”是动态的(用户可以随时修改需求,系统实时调整)。

Q2:上下文窗口的大小如何选择?

A2:根据任务类型选择:

- 简单任务(如问答):窗口大小可以小一些(3-5轮);

- 复杂任务(如创意写作):窗口大小可以大一些(10-20轮)。

Q3:动态提示调整有哪些方法?

A3:

- 基于规则的调整(如“如果用户提到‘错误’,就添加‘请详细说明错误信息’”);

- 基于机器学习的调整(如用分类模型判断用户意图,生成相应的提示);

- 基于历史数据的调整(如根据用户之前的偏好,调整提示风格)。

扩展阅读 & 参考资料

- 论文:《Real-time Dialogue Systems with Dynamic Prompting》(ArXiv);

- 书籍:《Conversational AI: Dialogue Systems, Chatbots, and Virtual Assistants》(O’Reilly);

- 博客:《How to Build a Real-time Chatbot with OpenAI》(Medium);

- 课程:《Building Real-time Dialogue Systems》(Udacity)。

结语:实时互动不是“新技术”,而是“用技术解决用户需求的新方式”。对于提示工程架构师来说,掌握实时互动的技术,就能让自己的系统从“普通奶茶店”变成“能定制的奶茶店”,在竞争中脱颖而出。希望本文能帮助你理解实时互动的核心逻辑,并用它打造更优秀的AI提示系统!

更多推荐

已为社区贡献177条内容

已为社区贡献177条内容

所有评论(0)