人工智能与其发展

最近2年,人工智能确实如火如荼发展。人们口中最常见的说法,从“你百度下”转变为“问问AI”。这个现象其实是一个时代发展的体现:AI已经从科技领域进入大众视野。在这种背景下,AI仿佛已经成为了某种全知全能的存在。大到人生决策,小到今晚吃啥,都要AI来指点一二。但这又不禁让我想问一个问题:什么是AI?如果我问一个路人什么是AI,他可能会理所当然的说:Deepseek是AI、豆包是AI或者文心一言是AI

最近2年,人工智能确实如火如荼发展。人们口中最常见的说法,从“你百度下”转变为“问问AI”。这个现象其实是一个时代发展的体现:AI已经从科技领域进入大众视野。在这种背景下,AI仿佛已经成为了某种全知全能的存在。大到人生决策,小到今晚吃啥,都要AI来指点一二。

但这又不禁让我想问一个问题:什么是AI?如果我问一个路人什么是AI,他可能会理所当然的说:Deepseek是AI、豆包是AI或者文心一言是AI。

而这就是我想指出的:如今,‘AI’一词在很大程度上已经特指大语言模型。当然了,我不打算与跟大家咬文嚼字。这种行为就如同纠正‘硬盘’与‘内存’的区别一样,显得有些较真。我只是想说,AI似乎变成了近5年突然出现的产物。为了纠正这种误区,我决定总结人工智能的发展。

人工智能的目的

人工智能的目的是什么时候提出的?5年前?10年前?还是更早?

事实上,人工智能的概念最早可以追溯到战国时期的《列子》。《列子》中提到了一个木匠做出来一个能歌善舞、以假乱真的伶人。这个伶人有自己的思想,能够听从命令。我认为这就是最早的,关于人工智能的概念的终极目标——让机器能够像人一样思考、学习、推理和解决问题。

但是,这种概念似乎有些过于简单了。在文艺复兴之后,西方又陆陆续续出现了许多关于机器人的科幻小说:《弗兰肯斯坦》、《罗梭的万能工人》,渐渐补全了关于“机器人”的构想。直到1950年,艾萨克·阿西莫夫的《我,机器人》中,正式提出了《机器人三准则》,这为人工智能(此时叫“机器人”)目的添加了一个最大前提——服务与人类。同年,艾伦·图灵提出"图灵测试",为机器智能提供了可操作的评估标准。1956年达特茅斯会议上,"人工智能"一词正式诞生,研究者们希望通过逻辑规则系统实现通用智能。

人工智能的概念

弱人工智能(Artificial Narrow Intelligence, ANI):专精于某一特定任务。这是目前所有现存AI的形式。它只能在某个特定领域或设定下表现出智能,无法超越其预设的范围。

强人工智能(Artificial General Intelligence, AGI):拥有与人类同等水平的通用智能。一台具有AGI的机器可以理解、学习并应用其智力来解决任何复杂问题,就像人类一样。它能够进行抽象思考、背景推理、从经验中学习,并将知识从一个领域应用到另一个领域。

超人工智能(Artificial Superintelligence, ASI):在几乎所有领域都远超最聪明人类大脑的智能。这包括科学创造力、通用智慧和社交技能。

人工智能的发展

目的已经有了,自然会有人去试图实现。

初期探索

1951年,世界上第一台神经网络计算机SNARC(Stochastic Neural Analog Reinforcement Calculator)出现。这台计算机可以模拟40个神经元的连接,使用“用进废退”的思想,解决了老鼠走迷宫的问题。1954年,128个神经元的神经网络计算机诞生。1956年,研究者们通过这种‘进化算法’,已经能让计算机在跳棋领域达到初学者的水平。到了1962年,程序已经能够模拟专家水平并击败人类对手,AI由此开始进入大众视野。而1966年,ELIZA聊天机器人出现,能够使用脚本对自然语言进行回答,成为自然语言处理领域先驱。

1968年,世界上第一个专家系统DENDRAL出现,通过数据匹配来试图推断化学分子式。

AI寒冬

此时AI技术局限:

- 算力严重不足,无法处理复杂问题

- 数据资源匮乏,限制了系统学习能力

- 陷入"常识推理困境",无法处理人类视为常识的知识

- 仅能解决高度结构化的简单问题,缺乏泛化能力

1960年代末至1970年代,AI研究遭遇第一次重大挫折。1966年ALPAC报告指出机器翻译进展缓慢,导致政府资金锐减。技术瓶颈(如"常识推理困境")和过度承诺未兑现是主要原因。

蓬勃发展

20世纪80年代之前,虽然多有尝试,但始终停留在模拟”神经“机制的层面。80年代后,针对第一次寒冬的教训,研究者转向开发特定领域的实用系统,将领域专家的知识编码为规则库,实现专业水平的智能决策。因此又陆续出现了时序差分学习、演员—评论家模型等更高级的算法,以试图解决更为实际的问题。。

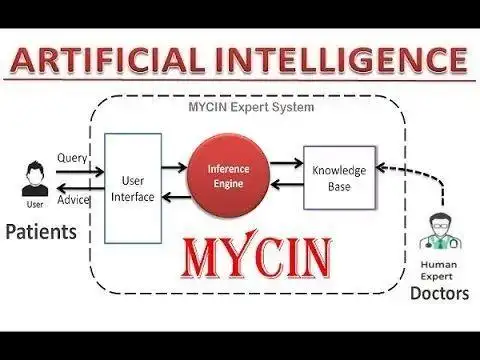

同时,为了解决问题的专家系统开始繁荣发展,成为了当时AI发展的主要研究目标。MYCIN医疗诊断专家系统出现,准确率真实达到了专家水平。

第二次AI寒冬

局限性:

- 依赖人工编码规则,知识获取和维护成本高

- 缺乏学习能力,无法自我改进

- 规则库难以覆盖所有边缘情况

- 系统脆弱,规则冲突可能导致错误

1980s末-1990s初,专家系统的商业化应用暴露出严重问题,导致AI研究再次陷入低谷。

智能崛起

1990s-2000s,此时互联网已然开始蓬勃发展。而人工智能也开始从“规则驱动”转向“数据驱动”,机器学习开始崛起,成为主流。也就是这个时段,现代AI雏形也开始得以形成。

1986年反向传播算法出现,多层神经网络问题得到解决;1992年支持向量机提出,成为了强大的分类工具;数学理论的进步与互联网带来的海量数据提供了发展的温床,贝叶斯网络、随机森林等方法得到广泛应用。

这段时期,算法日益规范,规则更为详细,加之数据资源日益丰富,人工智能取得了巨大进步。。同时这段时期产生的算法与思想也一直沿用到了今天。

也正是这段时间,开始出现了简单的垃圾邮件的过滤功能(基于字符串的匹配),简单的手写体识别(基于模板匹配法,只能识别字母和数字)等基本功能。

深度学习革命

2000-2010年,在计算机性能发展的同时,人工智能也开始向深度学习方向发展。

2006年Geoffrey Hinton团队提出了一种无监督预训练方法。这种方法为深度学习提供了一条可行的道路,为后续发展打下了基础。2011年,微软率先将神经网络用于语音识别,并实现商业化。2012年深度卷积神经网络在ImageNet竞赛中以显著优势击败传统方法,标志着深度学习正式进入计算机视觉主流;直到2014年,生成对抗网络提出,使得生成式AI的出现成为可能。

这一阶段,人工智能百花齐放,计算机视觉、自然语言处理开始蓬勃发展,并从实验室走向应用。

大模型时代

2020年后,随着计算机性能提升与数据规范,人工智能也彻底进入大模型时代。以GPT-3、BERT等为代表的大规模预训练语言模型展现出强大的泛化能力和涌现特性。

2018年,GPT-1出世,开创了生成式语言的先河;2020年GPT-3出现,使用了1750亿参数,且能够少样本学习;2023年GPT-4发布,将生成式大语言模型向通用人工智能发展;2025年,Deepseek等模型的推出,进一步显著降低了人工智能的应用门槛。。

未来展望

因此,当我们今天轻触屏幕、与AI对话之际,所体验的不仅是技术的飞跃,更是人类跨越数十年甚至数个世纪思考与努力的结晶。AI并非一夜之间的奇迹,而是一段充满挫折、寒冬与复兴的漫长征程。从战国的木偶幻想到今天的语言模型,从实验室中的理论推演到生活中的日常助手,人工智能始终在回应人类最根本的渴望——创造能理解、学习并协助我们的伙伴。

我们正站在一个弱人工智能日益成熟、强人工智能仍在远方的路口。未来的AI或许将更深刻地融入社会的脉络,但它的每一步前进,都离不开人类对智能本质的不懈追问与创造的热情。而这,才是AI故事中最动人的部分。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)