论文阅读:PMLR 2023 Better Diffusion Models Further Improve Adversarial Training

更厉害的扩散模型(EDM)生成的高质量假数据,能让对抗训练的效果再上一个台阶——既提升了模型的抗干扰能力,又提高了真实图片的识别准确率,而且没依赖额外的真实数据。同时还搞清楚了“假数据怎么用才最好”,给后面的研究提供了参考。

·

http://proceedings.mlr.press/v202/wang23ad.html

https://www.doubao.com/chat/19480959898910210

速览

这篇文档主要讲了一个关于“让AI模型更抗干扰”的研究,

1. 先搞懂两个核心背景

- 对抗训练(AT):AI模型(比如图像识别模型)很容易被“坑”——比如给一张猫的图片加一点点人眼几乎看不出的干扰,模型就会认错成狗。“对抗训练”就是专门练模型的“抗干扰能力”,让它在有干扰的情况下也能认对。但练这个需要很多数据,数据不够的话,模型抗干扰能力就上不去。

- 扩散模型(比如DDPM、EDM):一种能“造假数据”的AI。它能学真实图片的规律,生成看起来很真实的假图片(比如假的猫、狗图片)。之前研究发现,用早期的扩散模型(DDPM)生成的假数据,能帮对抗训练提升效果,但DDPM有缺点:生成图片慢、质量不算顶尖。

2. 研究要解决的问题

扩散模型这两年进步很快,新出的模型(比如EDM)生成图片又快(只要~20步)、质量又高(用“FID分数”衡量,分数越低越好,EDM是1.97,DDPM是3.17)。那问题来了:用更厉害的扩散模型(EDM)生成的假数据,能不能让对抗训练的效果更好?

3. 实验做了啥,结果怎么样?

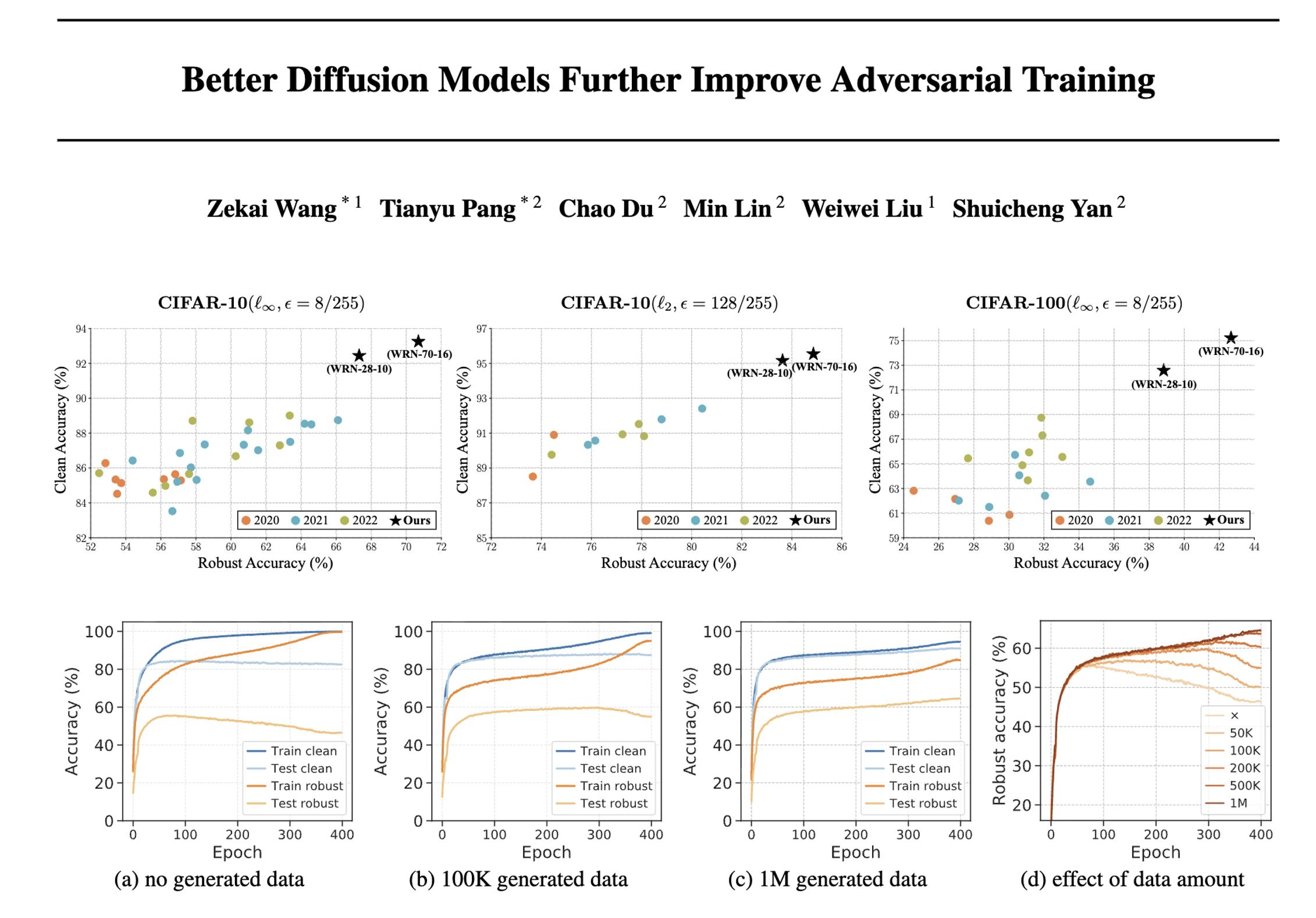

研究者用EDM生成假图片,代替原来的DDPM假图片,再用几乎一样的流程做对抗训练,在多个数据集(比如CIFAR-10、CIFAR-100这些常用的图像数据集)上测试,结果很亮眼:

- 抗干扰能力大幅提升:比如在CIFAR-10数据集上,面对“像素最大干扰8/255”(一种常见的干扰方式),用EDM假数据训练的模型,抗干扰准确率从之前的66.11%涨到了70.69%;在CIFAR-100上,从34.64%涨到了42.67%——而且还没用到任何额外的真实数据集,只靠EDM的假数据。

- 连“真图片识别准确率”也涨了:比如CIFAR-10上,真图片识别准确率从88.74%涨到93.25%,甚至超过了之前用额外真实数据训练的模型。

- 其他数据集也有效:在SVHN(街景数字识别)、TinyImageNet(小图版ImageNet)上测试,EDM假数据也让模型抗干扰能力提升了。

4. 还挖了些“为什么有效”的细节

研究者没只停在“结果好”,还分析了背后的原因:

- 解决了“抗干扰过拟合”问题:之前对抗训练有个毛病——模型在训练数据上抗干扰能力很强,但换了新数据就不行(叫“抗干扰过拟合”)。而EDM的假数据能让模型“见多识广”,减少这种过拟合,让训练和测试的效果更接近。

- 假数据的“质量”比“数量”更重要:EDM生成的假图片质量高(FID低),哪怕用的数量和DDPM一样,效果也更好;而且“按类别生成”(比如专门生成猫的假图片、狗的假图片)比“乱生成”(不指定类别)效果好。

- 训练细节的影响:比如“真实数据和假数据的比例”(1份真实数据配2-3份假数据效果最好)、“训练多久”(用了EDM假数据后,不用提前停止训练,练得越久效果越好)、“批量大小”(批量越大,效果越好)这些细节,都影响最终效果。

5. 总结一下

这篇研究证明了:更厉害的扩散模型(EDM)生成的高质量假数据,能让对抗训练的效果再上一个台阶——既提升了模型的抗干扰能力,又提高了真实图片的识别准确率,而且没依赖额外的真实数据。同时还搞清楚了“假数据怎么用才最好”,给后面的研究提供了参考。

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)