基于大模型的决策支持AI原生应用开发实践

在传统决策支持系统(如CRM、ERP中的规则引擎)中,决策逻辑依赖人工编写的规则或简单的统计模型,难以处理“用户评论隐含情绪”“供应链异常模糊信号”等非结构化信息。而基于大模型的AI原生应用,能直接通过自然语言理解、多模态推理和动态优化,让系统像“人类专家”一样分析复杂问题并给出建议。本文将聚焦如何用大模型重构决策支持系统,覆盖技术原理、开发流程、实战案例三大核心。

基于大模型的决策支持AI原生应用开发实践

关键词:大语言模型、AI原生应用、决策支持系统、提示工程、智能决策

摘要:本文将带您深入探索如何基于大语言模型(LLM)开发AI原生的决策支持应用。我们会从核心概念讲起,用“餐厅智能点单助手”这样的生活案例类比技术原理,逐步拆解大模型如何为决策支持“赋能”,并结合金融风控、医疗诊断等真实场景,手把手教您完成从需求分析到上线落地的全流程开发。无论您是开发者、产品经理,还是对AI应用感兴趣的技术爱好者,都能通过本文掌握AI原生决策系统的开发精髓。

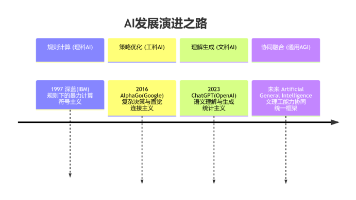

背景介绍

目的和范围

在传统决策支持系统(如CRM、ERP中的规则引擎)中,决策逻辑依赖人工编写的规则或简单的统计模型,难以处理“用户评论隐含情绪”“供应链异常模糊信号”等非结构化信息。而基于大模型的AI原生应用,能直接通过自然语言理解、多模态推理和动态优化,让系统像“人类专家”一样分析复杂问题并给出建议。本文将聚焦如何用大模型重构决策支持系统,覆盖技术原理、开发流程、实战案例三大核心。

预期读者

- 开发者:想了解如何用大模型开发智能应用的后端/AI工程师

- 产品经理:需要设计AI原生功能的需求方

- 技术爱好者:对AI落地应用感兴趣的非技术人员

文档结构概述

本文将按照“概念→原理→实战→趋势”的逻辑展开:先通过生活案例理解核心概念,再拆解大模型如何为决策支持提供技术支撑,接着用金融风控案例演示完整开发流程,最后展望未来挑战与机会。

术语表

核心术语定义

- AI原生应用:以AI模型为核心驱动力的应用(传统应用是“功能+少量AI”,AI原生是“AI+功能”)。

- 决策支持系统(DSS):辅助用户(或系统)在复杂场景下做出选择的智能工具(如投资建议、医疗诊断辅助)。

- 提示工程(Prompt Engineering):通过设计输入文本(提示词)引导大模型输出特定格式或内容的技术(类似“教模型如何思考”)。

相关概念解释

- 微调(Fine-tuning):在预训练大模型基础上,用特定领域数据进一步训练,使其适应具体任务(如用医疗问答数据微调通用大模型)。

- RLHF(人类反馈强化学习):通过人类对模型输出的评分,用强化学习优化模型决策策略(类似“用用户点赞/踩来训练模型”)。

核心概念与联系

故事引入:从“笨手笨脚”的点餐系统到“贴心”的智能助手

假设你开了一家网红餐厅,最初用的是传统点餐系统:

- 顾客说“推荐个不辣的菜”,系统只能按“辣度=0”的规则筛选,完全不懂“最近口腔溃疡”这种隐含需求。

- 顾客问“今天有什么特色?”,系统只会机械回复预设的“招牌红烧肉”,不会结合“暴雨天适合热汤”调整推荐。

后来你引入了基于大模型的智能点单助手:

- 顾客说“最近上火,推荐清淡点的”,助手能理解“上火”隐含“忌辛辣油腻”,推荐“冬瓜排骨汤”。

- 看到“外面下暴雨”(天气数据),助手会主动提示“今天适合喝热汤,您看需要加一份姜茶吗?”。

这个升级的关键,就是用大模型替代了传统规则引擎,让系统具备了“理解复杂需求→关联多源信息→动态优化决策”的能力——这正是基于大模型的决策支持AI原生应用的核心价值。

核心概念解释(像给小学生讲故事一样)

核心概念一:AI原生应用

想象你有一个“万能小助手”:它的“大脑”是AI模型,而不是一堆按钮和菜单。传统应用像“计算器”(功能固定,AI只是附加功能),AI原生应用像“智能管家”(AI是核心,功能围绕AI能力展开)。比如,智能点单助手的核心不是“显示菜单”,而是“理解你想吃什么,然后推荐”。

核心概念二:大模型如何赋能决策支持

大模型就像一个“知识超丰富的万事通”,它能:

- 听懂“弦外之音”(自然语言理解):比如“最近吃辣吃多了”=“需要清淡饮食”。

- 关联各种信息(多模态推理):结合天气、用户历史订单、库存数据,综合判断推荐。

- 越用越聪明(动态优化):用户点了推荐的汤,觉得好喝→模型记住“暴雨天推荐热汤有效”;用户没点→模型调整策略。

核心概念三:提示工程与微调——让大模型“更懂你”

大模型刚出厂时像“大学生”,知道很多知识但不知道“你的餐厅特色”。这时候需要:

- 微调:给它“上培训课”,用你餐厅的历史订单、顾客评价数据训练,让它记住“你家的招牌是红烧肉,辣度分级是1-5星”。

- 提示工程:给它“写说明书”,比如输入“用户说‘最近上火’,请推荐3道清淡菜品,并说明理由”,引导它输出你想要的格式。

核心概念之间的关系(用小学生能理解的比喻)

这三个概念就像“智能助手的三要素”:

- AI原生应用是“身体”,负责和用户互动、展示结果。

- 大模型是“大脑”,负责思考和决策。

- 提示工程+微调是“培训老师”,让大脑更懂你的需求。

比如,智能点单助手的“身体”是手机APP界面,“大脑”是大模型,“培训老师”(提示工程+微调)教会大脑“顾客说‘上火’要推荐清淡汤品”,最终通过APP把推荐结果告诉顾客。

核心概念原理和架构的文本示意图

基于大模型的决策支持AI原生应用架构可概括为:

用户输入(文本/语音/数据)→ 提示工程模块(设计输入模板)→ 大模型(推理决策)→ 结果验证(用户反馈)→ 模型优化(微调/RLHF)→ 输出决策建议

Mermaid 流程图

graph TD

A[用户输入: "最近上火,推荐菜品"] --> B[提示工程模块: 生成结构化提示]

B --> C[大模型: 分析用户意图+关联库存/天气数据]

C --> D[输出: "推荐冬瓜排骨汤(清淡祛湿)"]

D --> E[用户反馈: "满意/不满意"]

E --> F[模型优化: 用反馈数据微调或RLHF训练]

F --> C[大模型迭代升级]

核心算法原理 & 具体操作步骤

大模型在决策支持中的核心能力依赖三大技术:提示工程、领域微调、反馈优化(RLHF)。我们逐一拆解,并结合Python代码示例说明。

1. 提示工程:引导大模型输出高质量决策

大模型的输出高度依赖输入的“提示词”。好的提示词就像“给模型的解题步骤”,明确告诉它“需要什么信息”“按什么格式输出”。

示例:金融风控中的欺诈识别提示词

假设我们要让大模型分析用户的交易日志,判断是否存在欺诈风险。

- 差的提示词:“分析这段交易日志,看看有没有问题。”(模型可能输出模糊的结论)

- 好的提示词:“你是一位金融风控专家,需要分析用户近30天的交易日志(见下文),完成以下任务:

- 列出异常交易特征(如单笔金额超过月均消费200%、深夜交易等);

- 判断是否存在欺诈风险(是/否);

- 给出风险等级(低/中/高)。

交易日志:[具体数据…]”

Python代码实现提示词模板(用LangChain库管理提示词):

from langchain.prompts import PromptTemplate

# 定义提示词模板

fraud_detection_prompt = PromptTemplate(

input_variables=["transaction_log"], # 输入变量:交易日志

template="你是金融风控专家,需要分析以下交易日志:\n{transaction_log}\n请完成:\n1. 异常特征;2. 欺诈判断;3. 风险等级。"

)

# 填充具体交易日志

input_text = fraud_detection_prompt.format(transaction_log="用户A,10月1日消费50元,10月2日消费60元,10月3日消费1500元(月均消费80元)...")

2. 领域微调:让大模型“专研”你的行业

预训练大模型(如GPT-4、Llama 3)有通用知识,但缺乏具体领域(如医疗、金融)的专业知识。通过微调(用领域数据训练),可以让模型更“专业”。

微调原理:在预训练模型的基础上,用领域内的“输入-输出”对(如“医疗问题-诊断建议”“交易日志-风控结论”)继续训练,调整模型参数,使其更适应特定任务。

Python代码示例(用Hugging Face Transformers微调Llama 3):

from transformers import AutoModelForCausalLM, AutoTokenizer, TrainingArguments, Trainer

import datasets

# 加载预训练模型和分词器

model_name = "meta-llama/Llama-2-7b-chat-hf"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

# 加载领域数据集(如金融风控的“交易日志→风控结论”对)

dataset = datasets.load_dataset("financial_fraud_dataset") # 假设已有标注好的数据集

# 数据预处理:将输入-输出对转换为模型可理解的格式(添加“<prompt>...</prompt><response>...</response>”)

def preprocess_function(examples):

prompts = [f"分析交易日志:{log},判断欺诈风险:" for log in examples["transaction_log"]]

responses = examples["risk_judgment"]

inputs = [f"{prompt}{response}" for prompt, response in zip(prompts, responses)]

return tokenizer(inputs, truncation=True, max_length=512)

tokenized_dataset = dataset.map(preprocess_function, batched=True)

# 训练参数配置

training_args = TrainingArguments(

output_dir="./finetuned_llama_fraud",

num_train_epochs=3,

per_device_train_batch_size=4,

learning_rate=2e-5,

)

# 启动训练

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

)

trainer.train()

3. 反馈优化(RLHF):用用户评分让模型“越用越准”

即使微调后的模型,也可能在实际使用中出现偏差(如误判正常交易为欺诈)。通过RLHF,我们可以用用户对决策结果的评分(如“这个建议很准”“这个建议错了”)来优化模型。

RLHF三步骤:

- 收集人类反馈:让用户对模型的决策结果打分(1-5分)。

- 训练奖励模型:用反馈数据训练一个奖励模型,预测“用户会给这个结果打多少分”。

- 强化学习优化:用奖励模型作为“裁判”,调整大模型的参数,让它生成的决策更可能获得高分。

数学公式(简化版):

-

奖励模型的目标:最大化预测评分与真实评分的一致性,损失函数为:

Lreward=−E(x,y,r)[logP(r∣x,y)]\mathcal{L}_{\text{reward}} = -\mathbb{E}_{(x,y,r)} [\log P(r|x,y)]Lreward=−E(x,y,r)[logP(r∣x,y)]

(其中 (x) 是输入,(y) 是模型输出,(r) 是用户评分) -

大模型的优化目标:最大化奖励模型的评分,用PPO(近端策略优化)算法更新模型参数。

数学模型和公式 & 详细讲解 & 举例说明

大模型决策的核心是概率预测:给定输入 (x)(如用户问题),模型输出最可能的决策 (y)(如推荐菜品),即最大化 (P(y|x))。

预训练阶段的数学基础

预训练大模型通过海量文本学习“如何预测下一个词”。例如,输入“今天下雨,我需要带”,模型会预测“伞”的概率最高((P(\text{伞} | \text{今天下雨,我需要带})) 最大)。

损失函数(交叉熵)用于衡量模型预测与真实文本的差距:

Lpretrain=−1N∑i=1NlogP(yi∣xi)\mathcal{L}_{\text{pretrain}} = -\frac{1}{N} \sum_{i=1}^N \log P(y_i | x_i)Lpretrain=−N1i=1∑NlogP(yi∣xi)

((N) 是数据量,(x_i) 是输入文本,(y_i) 是真实下一个词)

微调阶段的数学调整

微调时,我们用领域数据(如“交易日志→风控结论”)继续训练,目标是让模型在特定任务上的预测更准。损失函数与预训练类似,但数据更聚焦:

Lfine-tune=−1M∑j=1MlogP(yj∣xj)\mathcal{L}_{\text{fine-tune}} = -\frac{1}{M} \sum_{j=1}^M \log P(y_j | x_j)Lfine-tune=−M1j=1∑MlogP(yj∣xj)

((M) 是领域数据量,(x_j) 是领域输入,(y_j) 是领域期望输出)

RLHF中的奖励优化

奖励模型 (R(x,y)) 预测用户对输出 (y) 的评分,大模型通过强化学习最大化期望奖励:

maxθEy∼Pθ(y∣x)[R(x,y)]\max_\theta \mathbb{E}_{y \sim P_\theta(y|x)} [R(x,y)]θmaxEy∼Pθ(y∣x)[R(x,y)]

((\theta) 是大模型参数,(P_\theta(y|x)) 是模型生成输出 (y) 的概率)

举例:在智能点单助手中,用户对“推荐冬瓜排骨汤”打了5分(很满意),对“推荐辣子鸡”打了1分(不满意)。奖励模型会学习到“用户上火时推荐清淡汤品=高分”,大模型则会调整参数,增加生成“冬瓜排骨汤”的概率。

项目实战:金融风控决策支持系统开发

开发环境搭建

- 硬件:GPU(推荐A100,至少16GB显存)用于模型训练;CPU服务器(8核16G)用于在线推理。

- 软件:Python 3.9+,PyTorch 2.0+,Hugging Face Transformers库,LangChain(提示词管理),Weights & Biases(训练监控)。

源代码详细实现和代码解读

我们以“金融交易欺诈识别系统”为例,演示从数据准备到模型部署的全流程。

步骤1:需求分析

目标:通过分析用户交易日志(金额、时间、商户类型等),识别高风险欺诈交易,输出“是否欺诈”“风险等级”。

步骤2:数据准备

收集标注好的“交易日志-风险标签”数据集(示例):

| 交易日志 | 风险标签 | 风险等级 |

|---|---|---|

| 用户A,近30天日均消费80元,今日在“虚拟商品店”消费1500元(23:50) | 存在欺诈风险 | 高 |

| 用户B,近30天日均消费1000元,今日在“超市”消费1200元(15:00) | 无欺诈风险 | 低 |

步骤3:模型选择与微调

选择Llama 3-7B(平衡性能与成本),用领域数据微调。

代码示例(微调部分):

# 加载预训练模型和分词器(需替换为你的Hugging Face Token)

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "meta-llama/Llama-3-7b-chat-hf"

tokenizer = AutoTokenizer.from_pretrained(model_name, use_auth_token="YOUR_TOKEN")

model = AutoModelForCausalLM.from_pretrained(model_name, use_auth_token="YOUR_TOKEN")

# 加载自定义数据集(假设已保存为JSON文件)

from datasets import load_dataset

dataset = load_dataset("json", data_files="fraud_dataset.json")

# 数据预处理:将交易日志和标签转换为模型输入格式(添加“<s>分析交易日志:{log} → 风险标签:{label} 风险等级:{level}</s>”)

def preprocess(examples):

inputs = []

for log, label, level in zip(examples["transaction_log"], examples["risk_label"], examples["risk_level"]):

input_text = f"分析交易日志:{log} → 风险标签:{label} 风险等级:{level}"

inputs.append(input_text)

return tokenizer(inputs, truncation=True, max_length=512, padding="max_length")

tokenized_dataset = dataset.map(preprocess, batched=True)

# 训练配置

training_args = TrainingArguments(

output_dir="./fraud_detection_model",

num_train_epochs=3,

per_device_train_batch_size=4,

learning_rate=2e-5,

logging_steps=10,

save_strategy="epoch",

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

)

# 启动训练

trainer.train()

步骤4:提示词设计与推理

部署后,通过API接收交易日志,用提示词引导模型输出结构化结果。

推理代码示例:

from transformers import pipeline

# 加载微调后的模型

fraud_pipeline = pipeline(

"text-generation",

model="./fraud_detection_model",

tokenizer=tokenizer,

device=0 # 使用GPU加速

)

def detect_fraud(transaction_log):

# 设计提示词

prompt = f"分析交易日志:{transaction_log} → 风险标签:"

# 生成结果(限制输出长度)

result = fraud_pipeline(prompt, max_new_tokens=50, temperature=0.7)

# 解析输出(提取风险标签和等级)

output = result[0]["generated_text"].split("→ 风险标签:")[1]

return {"风险标签": output.split(" 风险等级:")[0], "风险等级": output.split(" 风险等级:")[1].split(" ")[0]}

# 测试:输入一条交易日志

test_log = "用户C,近30天日均消费200元,今日在‘游戏充值店’消费1800元(22:45)"

print(detect_fraud(test_log))

# 输出示例:{"风险标签": "存在欺诈风险", "风险等级": "高"}

步骤5:系统集成与测试

将推理接口封装为REST API(用FastAPI),并与银行的交易系统对接。通过A/B测试验证:

- 指标1:欺诈识别准确率(对比人工审核结果)需≥90%。

- 指标2:响应时间≤2秒(满足实时风控需求)。

实际应用场景

1. 金融风控

- 场景:识别信用卡盗刷、异常转账。

- 大模型优势:分析交易时间、商户类型、用户历史行为等非结构化数据,发现“深夜小额试探→次日大额盗刷”等复杂模式。

2. 医疗诊断辅助

- 场景:根据患者病历、检查报告、指南文献,给出初步诊断建议。

- 大模型优势:理解“咳嗽+低热+接触过流感患者”的隐含关联,推荐“流感检测”而非“普通感冒治疗”。

3. 供应链优化

- 场景:预测区域需求,调整库存分布。

- 大模型优势:结合天气(暴雨影响物流)、促销活动(双11前需求激增)、社交舆情(某商品被网红推荐)等多源信息,动态优化库存。

工具和资源推荐

| 类别 | 工具/资源 | 简介 |

|---|---|---|

| 大模型平台 | OpenAI API | 提供GPT-4等模型的调用接口,适合快速验证想法 |

| Hugging Face Hub | 开源大模型仓库(如Llama、Mistral),支持自定义微调 | |

| 提示工程工具 | LangChain | 管理提示词模板、链式调用多个模型(如先分析日志,再生成报告) |

| 微调框架 | LoRA(低秩适应) | 仅训练模型的部分参数,大幅降低微调成本(7B模型仅需1GB显存) |

| 监控工具 | Weights & Biases (W&B) | 跟踪训练过程(损失曲线、指标变化),调试模型性能 |

| 数据标注工具 | Label Studio | 标注“输入-输出”对(如交易日志-风险标签),生成微调所需的数据集 |

未来发展趋势与挑战

趋势1:多模态大模型提升决策广度

未来的决策支持系统将不再局限于文本,而是结合图像(如监控视频中的异常操作)、语音(如客服通话中的情绪波动)、传感器数据(如设备运行参数),提供更全面的决策依据。

趋势2:自主决策代理(Agent)普及

大模型可能与工具(如计算器、数据库)结合,形成“能思考、能行动”的智能代理。例如,风控代理发现异常交易后,自动冻结账户并触发人工审核,全程无需人工干预。

挑战1:可解释性与信任问题

大模型的“黑箱”特性可能导致“为什么推荐这个?”难以回答。未来需要发展可解释AI(XAI),例如用注意力机制可视化模型关注的交易日志关键词(如“深夜”“虚拟商品”)。

挑战2:实时性与成本平衡

大模型推理耗时较长(7B模型推理512token需约0.5秒),对实时性要求高的场景(如高频交易)需优化模型(如量化、蒸馏)或采用轻量级模型(如Mistral-7B)。

挑战3:伦理与安全风险

决策偏差(如对特定用户群体的误判)、数据泄露(训练数据包含敏感信息)是潜在风险。需通过联邦学习(在本地训练模型,不传输原始数据)、伦理审核(测试模型对不同群体的公平性)降低风险。

总结:学到了什么?

核心概念回顾

- AI原生应用:以大模型为核心的智能系统,区别于传统“功能+AI”模式。

- 大模型赋能决策:通过自然语言理解、多模态推理、动态优化,处理复杂决策场景。

- 关键技术:提示工程(引导输出)、微调(领域适配)、RLHF(反馈优化)。

概念关系回顾

大模型是决策支持的“大脑”,提示工程和微调是“训练大脑”的方法,最终通过AI原生应用将智能决策能力传递给用户。三者协同,让系统从“按规则执行”进化为“像专家一样思考”。

思考题:动动小脑筋

-

如果你要开发一个“智能医疗诊断助手”,会如何设计提示词引导大模型输出更准确的诊断建议?(提示:可以要求模型“列出依据的医学指南”“排除其他可能疾病”)

-

假设你有一个电商推荐系统,用户反馈“推荐的商品经常不感兴趣”,如何用RLHF优化模型?(提示:收集用户对推荐商品的点击/购买数据作为反馈评分)

-

大模型决策可能存在偏差(如对老年用户的误判),你会设计哪些测试用例验证系统的公平性?

附录:常见问题与解答

Q:大模型需要多少数据才能微调?

A:通常需要数千到数万条标注数据(具体取决于任务复杂度)。如果数据量少,可以用LoRA等参数高效微调方法,或结合提示工程(用少量示例“演示”任务)。

Q:如何处理大模型决策结果的可解释性?

A:可以要求模型在输出决策时“列出关键依据”(如“因为交易时间是23:50且金额超过月均200%,所以判定高风险”),或用注意力可视化工具(如Hugging Face的Token Attentions)展示模型关注的输入关键词。

Q:大模型推理速度慢,如何优化?

A:方法包括:① 使用轻量级模型(如Mistral-7B);② 模型量化(将参数从FP32转为INT8);③ 部署时使用GPU加速(如TensorRT推理引擎);④ 对长文本输入做截断(只保留关键信息)。

扩展阅读 & 参考资料

- 论文:《Training language models to follow instructions with human feedback》(RLHF原论文)

- 文档:Hugging Face Transformers官方教程(https://huggingface.co/docs/transformers)

- 博客:OpenAI官方博客(https://openai.com/blog)—— 常更新大模型应用案例。

- 书籍:《大模型时代:AIGC与智能应用开发实践》(机械工业出版社)—— 涵盖大模型应用开发全流程。

更多推荐

已为社区贡献136条内容

已为社区贡献136条内容

所有评论(0)