AI项目落地难?别让“垃圾数据”喂出“人工智障”!

人工智能常常被描绘成魔法,但驱动它的不是神秘的咒语,而是严谨的结构、战略和治理。在每一个智能决策的背后,都是数据在无声地诉说。当一个组织不再将数据视为IT部门的副产品,而是将其提升为与资本、人才同等重要的战略资产,并用心去维护它的洁净、联通与可信时,人工智能就不再是那层可有可无的“锦上添花”。它将成为企业肌体中那个最强劲的、创造价值的核心引擎。而这件事本身,就值得我们为之奋斗和庆祝。

摘要:2025年,我们不再怀疑AI的能力,但我们开始怀疑自己的数据。当整个行业都在为大模型和生成式AI的突破而狂欢时,一个更根本的问题却被选择性忽视:无论算法多先进,如果它赖以学习的“养料”是垃圾,那么产出的也只能是“人工智障”。本文将从战略和实践层面,深入探讨为何高质量的数据才是AI时代真正的“核心资产”和“胜负手”。

一、别再让模型背锅了,先审视你的“食材”

许多企业和技术团队在AI转型中,都陷入了一个典型的误区:迷信模型,轻视数据。当一个被寄予厚望的AI项目上线后效果不佳,我们总会下意识地去质疑:“是不是模型选得不对?参数没调优?还是算力不够?”

我们很少会先问自己:“我们喂给模型的是什么?”

这个逻辑其实很简单。一个再顶级的米其林大厨,如果面对的是一堆过期、变质、标签错误的食材,他也断然做不出一席盛宴。AI模型就是我们的大厨,而数据,就是决定成品质量的唯一食材。算法的上限,被数据的质量死死地钉住了。

这个教训是昂贵的。2023年,谷歌的Bard大模型在一次万众瞩目的发布会上,给出了一个错误的事实——它宣称詹姆斯·韦伯太空望远镜拍摄了第一张系外行星的照片。这个源于未经严格验证的互联网数据的错误,让其母公司Alphabet的市值一夜之间蒸发了千亿美元。

(图片说明:一个数据错误引发的“血案”)

这不是AI算法的失败,这是数据治理的溃败。它清晰地警示我们:当AI犯错时,不要只想着去“修复模型”,而要去追溯“模型学到了什么坏东西”。

中国有句老话讲得好:“跟着好人学好人,跟着巫婆跳假神。” 你的AI最终会成为什么,完全取决于你给它提供了什么样的“成长环境”。

二、碎片化的数据,只能产生碎片化的智能

过去的二十年,是企业数字化的“大航海时代”。我们上线了CRM来管理客户,上线了ERP来管理供应链和财务,上线了各种营销平台来触达用户。每一个系统都像一个独立的王国,高效地管理着自己的一亩三分地,同时也筑起了一道道难以逾越的“数据高墙”。

这些林立的“数据孤岛”,正是AI发挥潜力的最大枷锁。

想象一下,你想构建一个精准的客户流失预警模型。AI需要全面洞察一个客户的360度视图。然而,客户的投诉记录沉睡在客服系统里,他的购买频率和客单价记录在ERP里,他对近期营销活动的反馈则躺在邮件营销平台里。如果这些数据无法被有效、实时地打通和关联,AI就成了一个“盲人”,它摸到的永远只是大象的一部分。

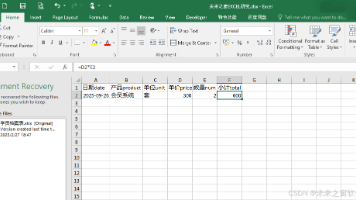

基于这种“残缺”数据训练出的模型,给出的洞察自然也是片面和滞后的。在启动任何AI项目之前,不妨先召开一个“数据素颜会”,坦诚地回答几个问题:

-

我们跨系统的数据定义和格式统一吗?(例如,

“北京市”vs“北京”) -

我们的数据存在多少重复、冲突或空白?

-

我们用来训练模型的标签,其准确性和一致性由谁来保证?

-

我们的数据更新频率,能跟上业务决策的速度吗?

肮脏、不一致的数据会像病毒一样,迅速侵蚀业务部门对AI系统的信任,最终让投入巨资的项目沦为无人问津的“花瓶”。

三、伟大AI应用的背后,是伟大的数据体系

我们所惊叹的每一个成功的AI商业案例,其冰山之下,都隐藏着一个我们看不见但极其强大的数据体系。在AI时代,真正的竞争壁垒,从来都不是你用了哪个模型,而是你拥有怎样的数据资产和驾驭它的能力。

-

UPS的“动态物流神经网络”:这家快递巨头利用AI优化配送路径,每年节省数亿成本。这背后并非某个单一的“路线规划算法”在起作用,而是一个庞大的、活的数据生态系统。它能实时吸纳天气变化、城市交通拥堵、车辆状态、包裹信息等多维度数据,形成一个动态的“物流神经网络”,让AI在瞬息万变的环境中做出最优决策。

-

彭博社的“金融数据帝国”:彭博终端是全球金融人士最信赖的工具之一,它提供的实时市场分析和预测精准而深刻。这种信赖的基石,是彭博花费数十年建立起来的金融数据帝国。每一条进入其模型的数据,都经过了极其严苛的清洗、标注、交叉验证和规范化。正是这种对数据质量近乎偏执的追求,才成就了其AI洞察的权威性。

四、架构先行,算法在后:别用战术的勤奋掩盖战略的懒惰

一个常见的战略错误是,把AI看作一个独立的“工具箱”,可以即插即用。于是,许多企业的AI之旅,都是从一个错误的问题开始的:“我们应该买哪家的AI平台?”

而真正应该问的、更具战略性的问题是:

-

“我们最希望通过AI来改进哪项关键业务决策?”

-

“支撑这项决策所需要的数据,我们准备好了吗?”

AI的成功,本质上是一个系统工程,是精心设计的数据架构所结出的果实。在痴迷于model.fit()之前,大量“枯燥”但至关重要的工作必须先完成。这包括打通业务系统间的壁垒,建立统一的数据标准和口径,设计能够验证数据质量的自动化流程,并与业务专家一起定义和生产高质量的标注数据。

试图跳过这些艰苦的数据基础建设,直接追求光鲜的模型应用,无异于在沙滩上建造摩天大楼。

五、从“大数据”到“好数据”的认知跃迁

“数据越多越好”是大数据时代留给我们的最深误解之一。对于AI来说,一份小而精的高质量数据集,其价值远远超过一份大而糙的噪声数据。

行业的冷静观察已经印证了这一点:

-

据Qlik的2025年调查,高达81%的AI专家承认其项目正受到数据质量问题的困扰。

-

2024年Monte Carlo的报告则更为触目惊心:近七成的数据团队对其用于AI的数据缺乏信心,且普遍因数据问题在半年内就造成超过10万美元的经济损失。

一个能支撑起高性能AI的数据集,至少应具备四大黄金标准:

-

完整性:关键信息无缺失,实体记录无重复。

-

一致性:跨源数据格式统一,业务标签定义一致。

-

平衡性:数据分布能真实反映世界,避免因样本偏差导致AI产生偏见。

-

情境性:数据不仅记录了“是什么”,更蕴含了“为什么”的业务逻辑和上下文。

尤其是在负责任AI和AI伦理日益重要的今天,确保数据的公平、无偏见是所有工作的起点。这意味着我们要抵制“不加选择地从网上扒取海量数据”的诱惑,并负责任地使用合成数据等技术作为补充。

结语:让人工智能成为真正的“蛋糕”

人工智能常常被描绘成魔法,但驱动它的不是神秘的咒语,而是严谨的结构、战略和治理。在每一个智能决策的背后,都是数据在无声地诉说。

当一个组织不再将数据视为IT部门的副产品,而是将其提升为与资本、人才同等重要的战略资产,并用心去维护它的洁净、联通与可信时,人工智能就不再是那层可有可无的“锦上添花”。

它将成为企业肌体中那个最强劲的、创造价值的核心引擎。而这件事本身,就值得我们为之奋斗和庆祝。

更多推荐

已为社区贡献58条内容

已为社区贡献58条内容

所有评论(0)