vllm部署大模型

(1)、下载大模型到本地,我使用魔塔社区中的大模型,先安装 魔塔: pip install modelscope,然后使用运行download.py 从魔塔上下载大模型:python download.py。(3)、启动大模型: vllm serve /root/autodl-tmp/Qwen/Qwen3-0.6B。创建虚拟环境:conda create -n vllm python==3.12。

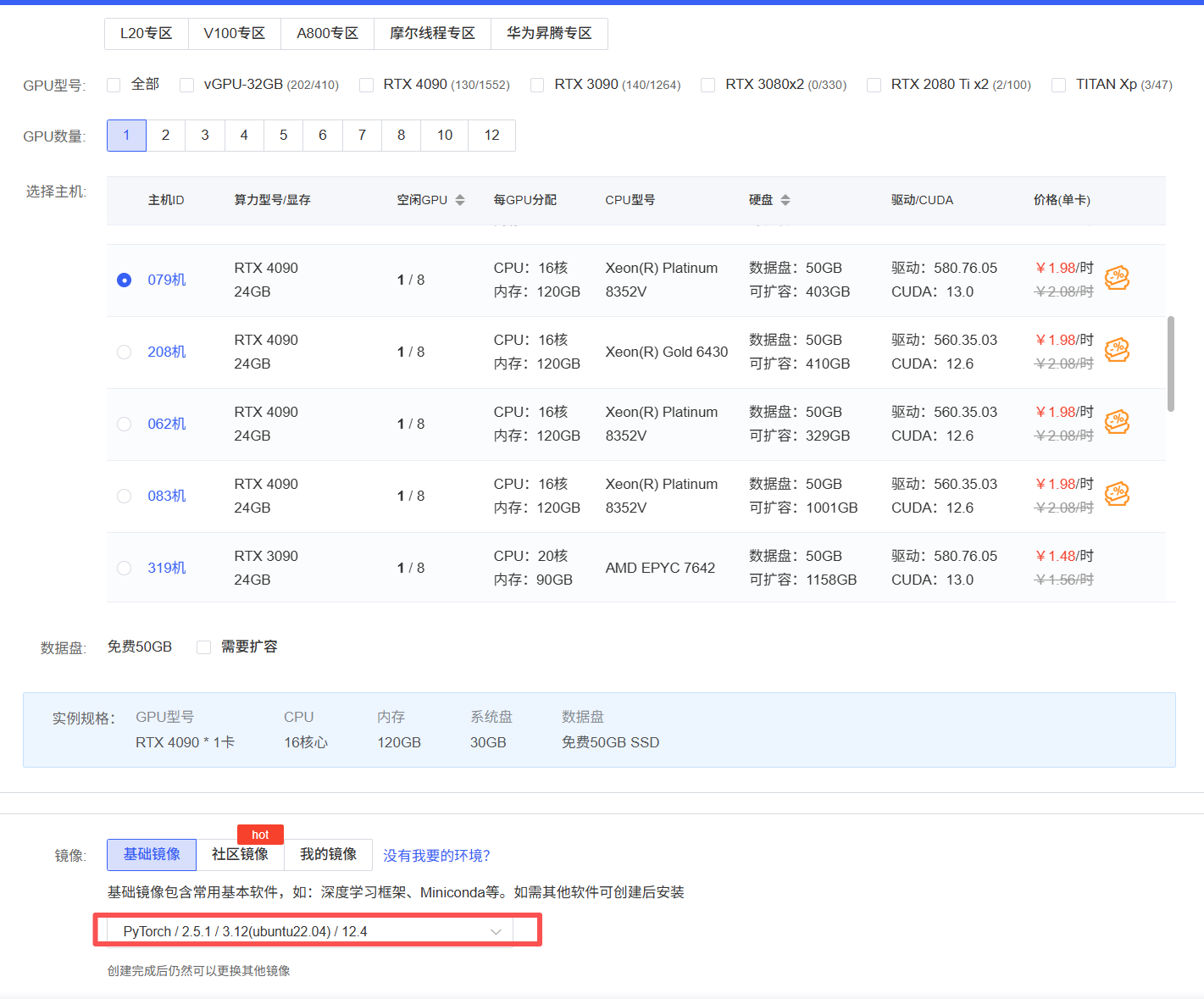

1、申请服务器,我这里使用 autodl: AutoDL算力云 | 弹性、好用、省钱,GPU算力零售价格新标杆

自己去服务器上申请即可,我这里申请 4090 显卡,环境选择 python 12.4

2、vllm 安装

vllm官网: vLLM 是一个快速且易于使用的库,专为大型语言模型 (LLM) 的推理和部署而设计 | vLLM 中文站

使用vllm最好新建一个虚拟环境,我这里就使用vllm作为虚拟环境名称:

创建虚拟环境:conda create -n vllm python==3.12

激活虚拟环境:source activate vllm

3、安装vllm

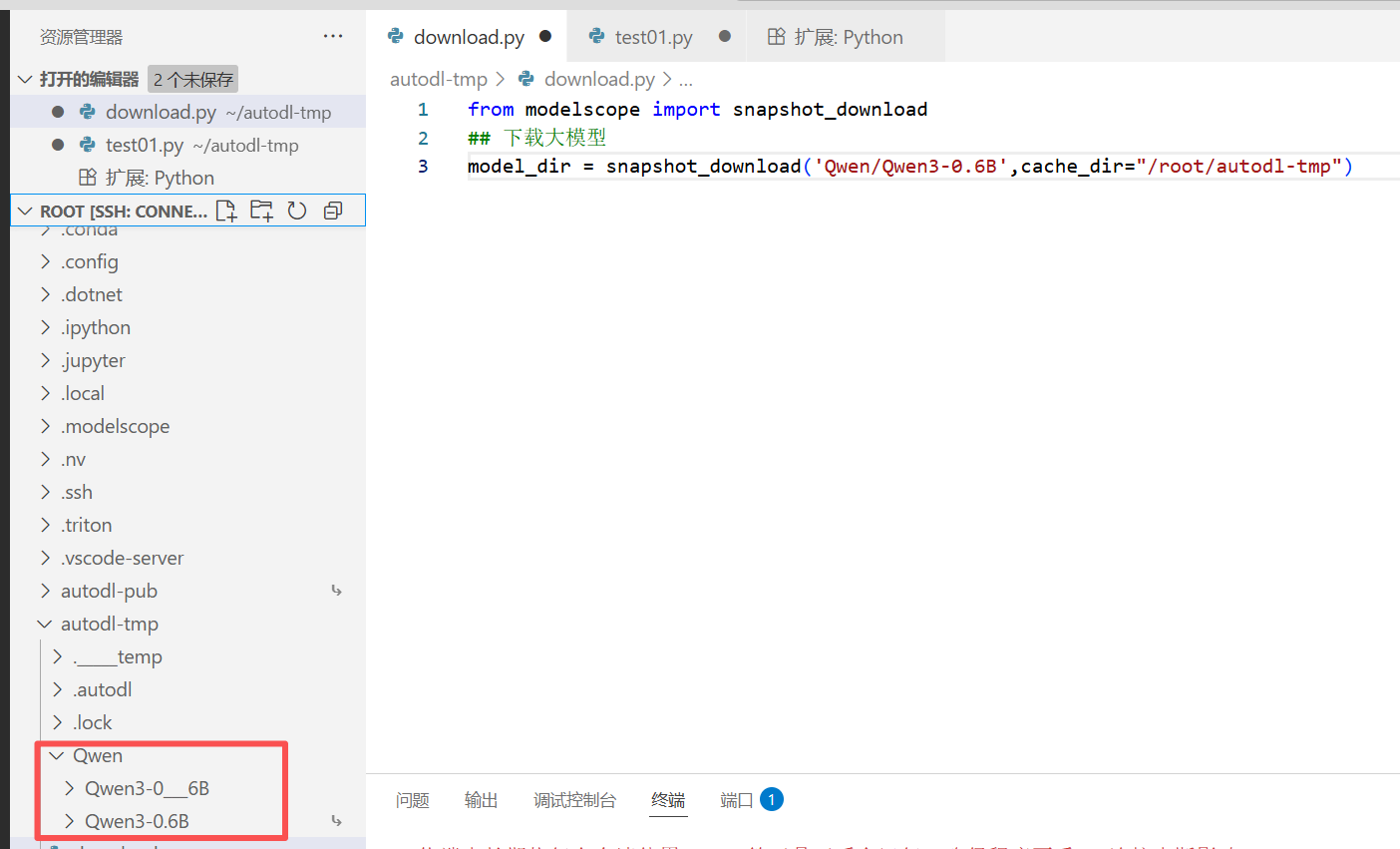

(1)、下载大模型到本地,我使用魔塔社区中的大模型,先安装 魔塔: pip install modelscope,然后使用运行 download.py 从魔塔上下载大模型:python download.py

(2)、安装 vllm: pip install vllm

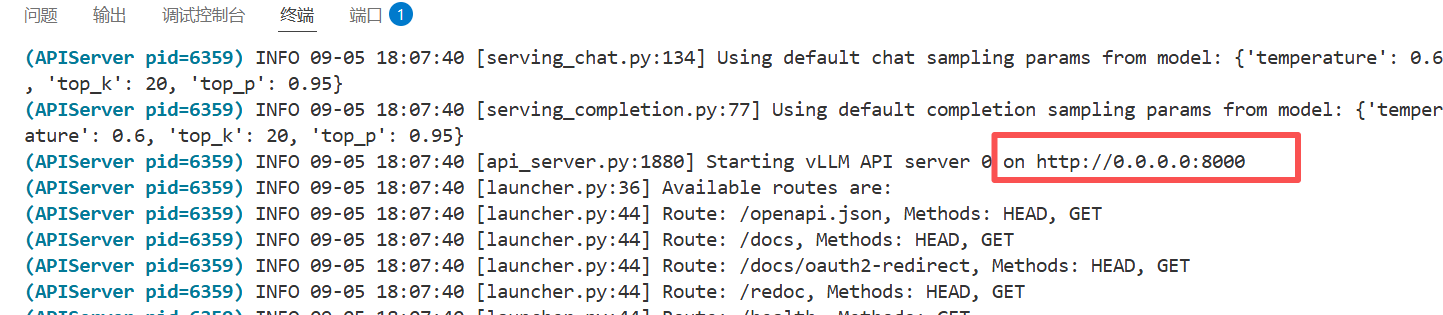

(3)、启动大模型: vllm serve /root/autodl-tmp/Qwen/Qwen3-0.6B

默认是8000端口

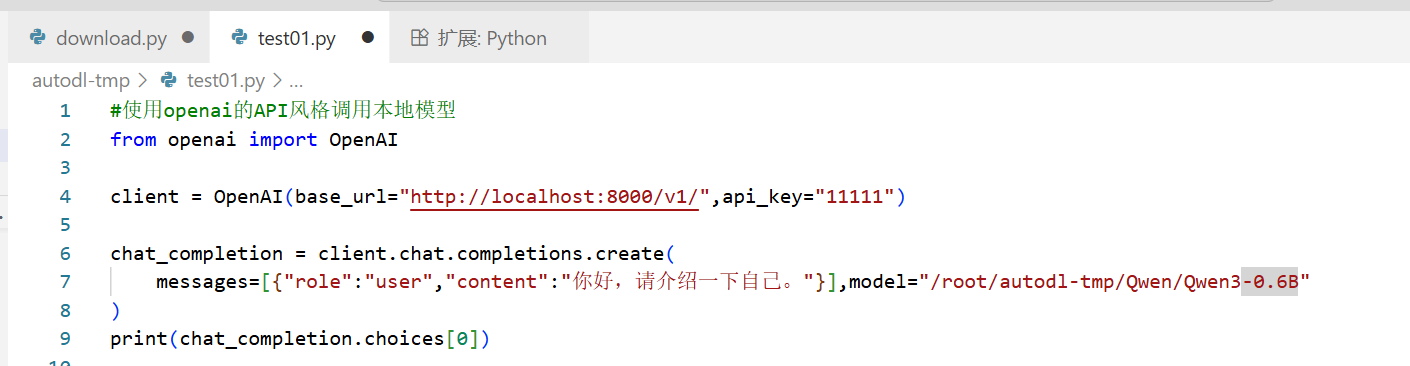

4、调用大模型

运行test.py 文件,python test01.py

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)