机器学习深度学习入门课程(附课件和学习笔记)

第13讲(难度***): 介绍对抗攻击,是指针对机器学习模型,尤其是深度学习模型的一种攻击方式。第9讲(难度***): 介绍Seq2Seq,输入一个序列,输出一个序列的学习任务,深度学习时间序列要解决的问题,重点看看模型结构有哪些部分组成,每一部分的功能,现在其他时间序列模型大部分都是采用这种结构的变体。第16讲(难度***): 介绍强化学习基础,了解强化学习解决的问题,智能体,环境,奖励等概念,

最近很多同学在学习机器学习,深度学习的内容,对于初学者来说,处于迷茫的阶段,不知道机器学习深度学习包含什么内容,以及什么教程是比较适合自己的

往期给大家推荐了机器学习,深度学习的书籍,这一期同样是核心干货

文末附资料获取

下面给大家推荐李宏毅老师的2021版的机器学习深度学习教程,适合新手小白,可以讲视频和课件,以及学习笔记结合起来看

这个课程主要分为18讲

机器学习深度学习目录

-

机器学习深度学习介绍

-

过拟合欠拟合

-

梯度下降算法

-

优化器

-

分类模型

-

卷积神经网络

-

自注意力机制

-

归一化的方式

-

序列到序列的学习

-

生成对抗神经网络

-

Bert模型

-

自编码器

-

对抗攻击

-

机器学习解释性学习

-

领域自适应

-

强化学习介绍

-

终身学习

-

元学习

-

神经网络压缩

下面具体来介绍一下核心章节的内容:

第1讲(难度*):主要是从机器学习解决回归,分类,图像识别等方面来展开介绍机器学习深度学习的应用;

文章中所有的数据和资料,可添加小助手无偿分享~

扫码添加小助手即可无偿获取~

也可以关注“AI技术星球”公众号,关注后回复“221C”获取。

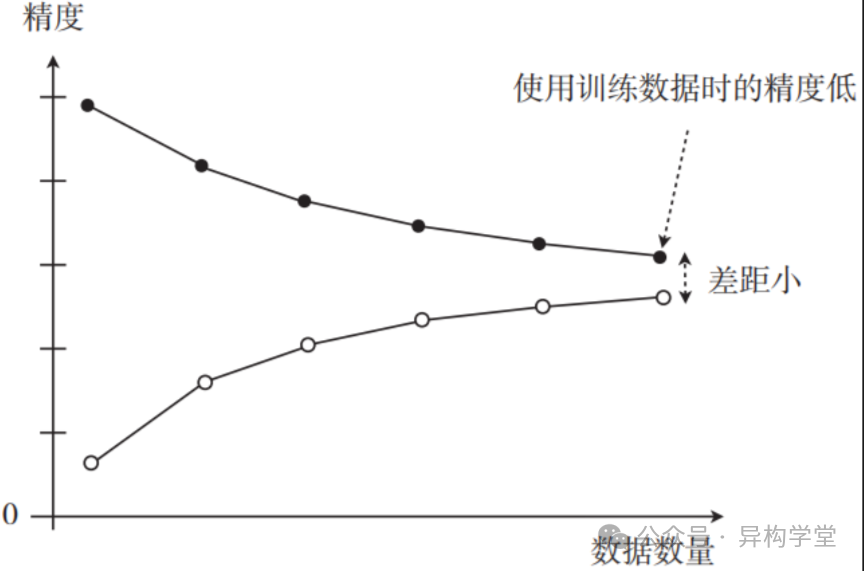

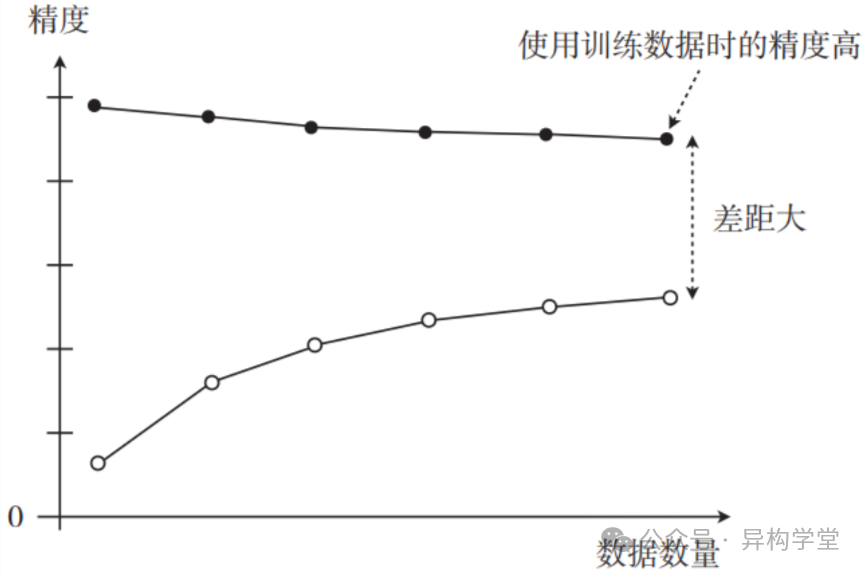

第2讲(难度*):讲解过拟合的问题,以及采用交叉检验等方式来防止过拟合,这里大家可以对比一下过拟合和欠拟合的训练,验证和测试误差曲线,下面分别是欠拟合和过拟合的曲线

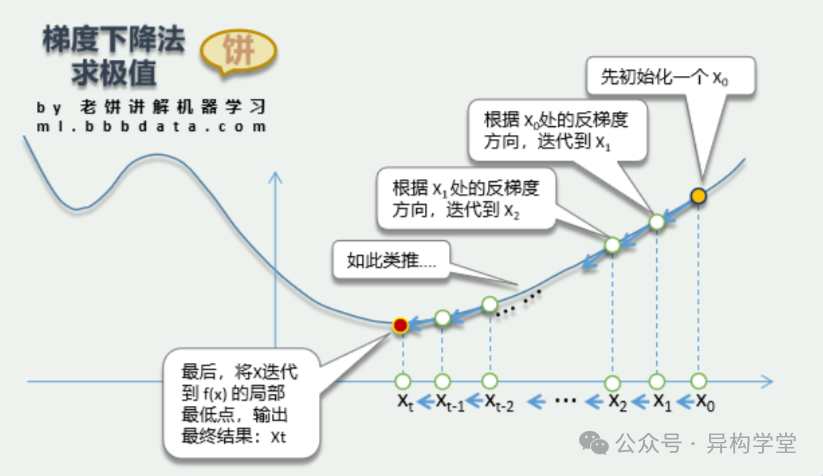

第3讲(难度**): 介绍梯度下降算法,沿什么方向梯度下降最快,单样本梯度下降,小批量梯度下降,全样本梯度下降等有什么优劣

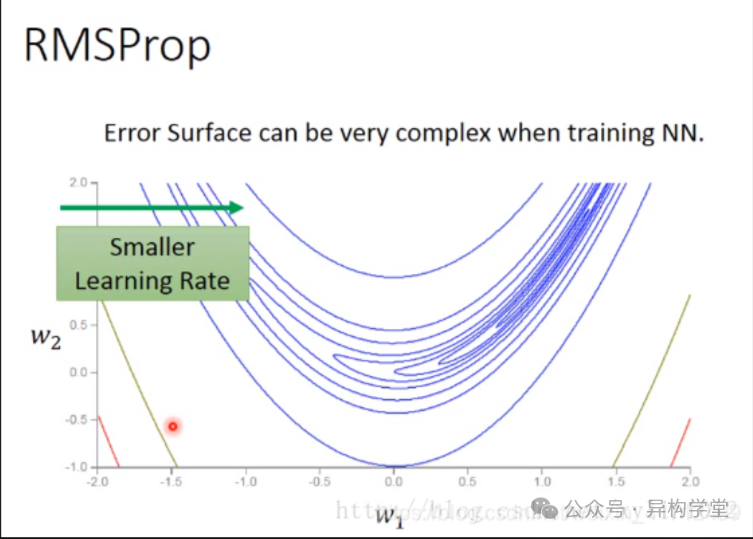

第4讲(难度**): 介绍优化器,加速随机目标函数的优化过程,特别是针对训练深度神经网络时常见的高维优化问题

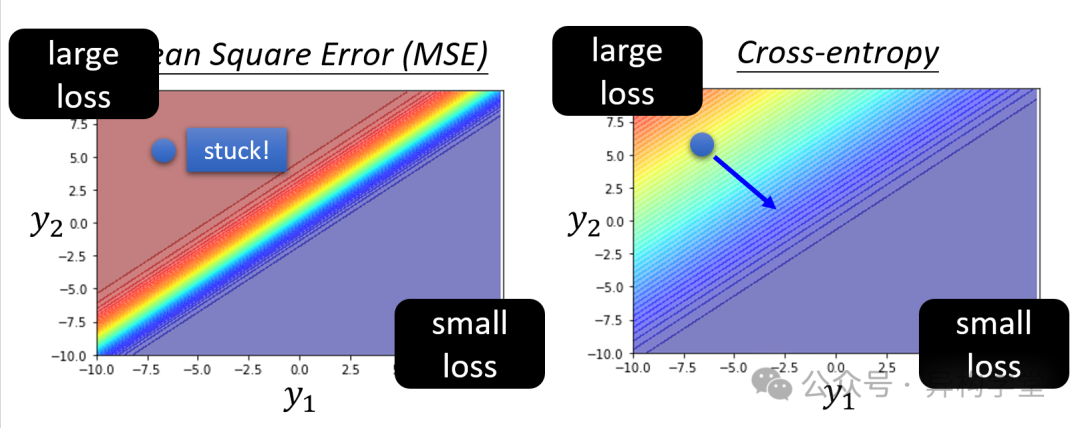

第5讲(难度**): 介绍分类问题VS 回归问题,需要弄清楚分类问题的损失函数与回归问题损失函数的区别,属于比较基础的内容,在面试中也经常会问到

上面5讲属于基础内容,学习机器学习肯定要会的,机器学习深度学习都是要多看几遍才能理解透,可能你看了文本教材,还需要看看视频理解一下,知识就是反复揉,才能揉碎

下面是一些进阶内容,适合想要学习深度学习,强化学习,NLP,大模型等方向的同学

---------------------------------------------------------------------

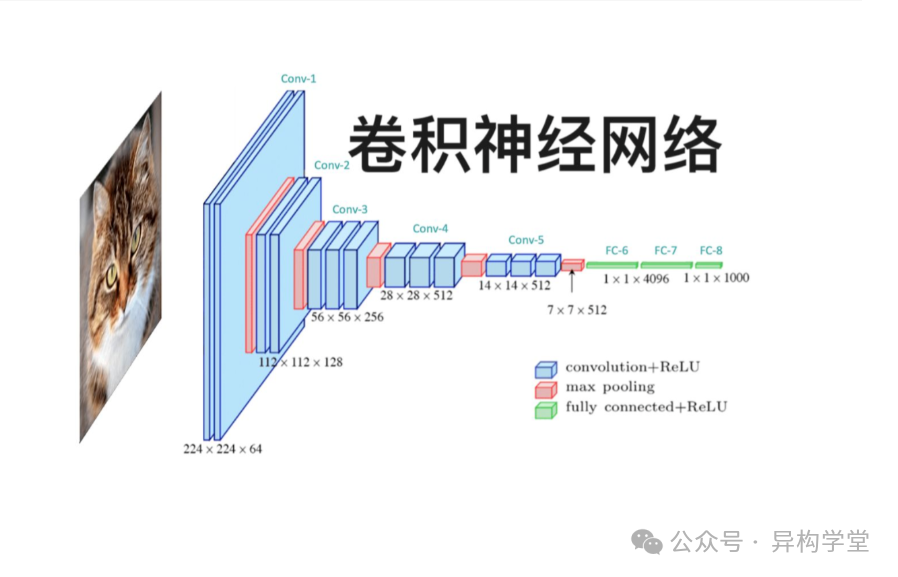

第6讲(难度***): 介绍卷积神经网络,需要理解卷积神经网络的模型结构,看看卷积神经网络的三大特性是怎么在其网络结构中体现的,卷积神经网络在图像领域应用非常广泛

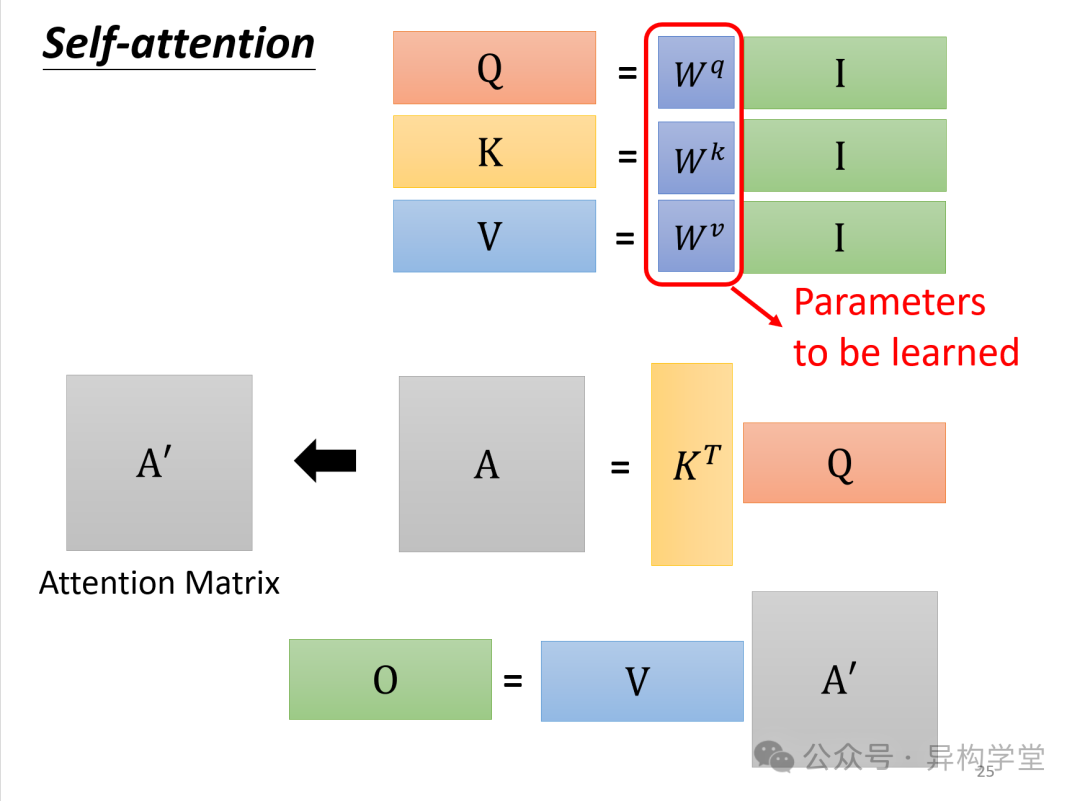

第7讲(难度***): 介绍自注意力机制,需要清楚为什么叫自注意力机制,后面在Transformer中还用到了交叉注意力机制,注意力机制也是深度学习非常重要的一个方向

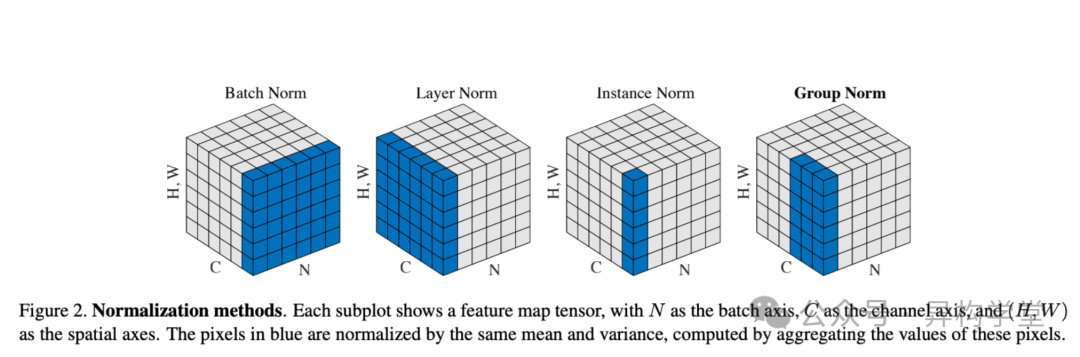

第8讲(难度***): 介绍归一化的方式,归一化的方向有batch normalizatin, layer normalization, instance normalization之类的,要清楚对比不同的归一化方式适合应用于什么神经网络,以及有什么优缺点或者特性

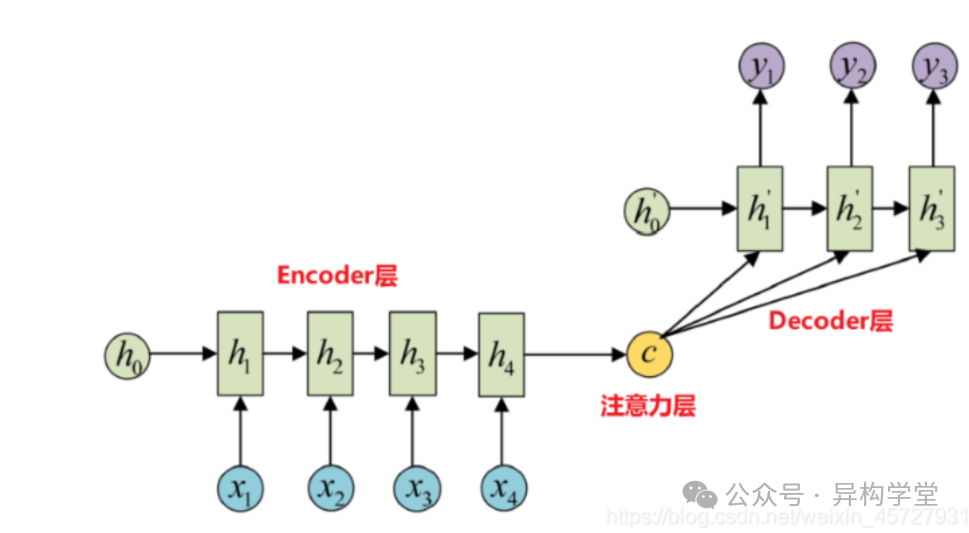

第9讲(难度***): 介绍Seq2Seq,输入一个序列,输出一个序列的学习任务,深度学习时间序列要解决的问题,重点看看模型结构有哪些部分组成,每一部分的功能,现在其他时间序列模型大部分都是采用这种结构的变体

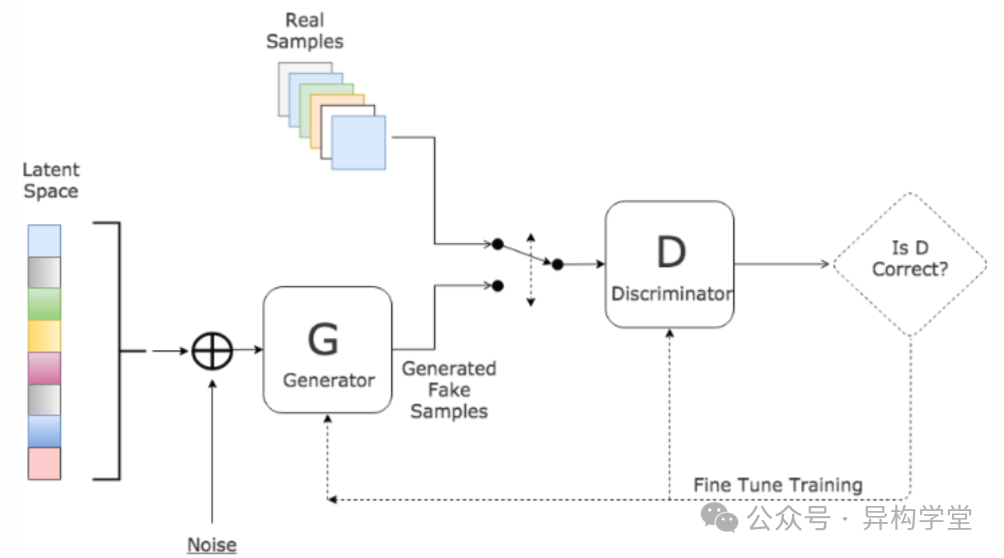

第10讲(难度***): 介绍生成对抗神经网络,GAN和其他神经网络不太一样,因为其是生成器和判别器的博弈学习来提升模型的精度,这种思想非常有意思,对于后续的研究有很大的启发

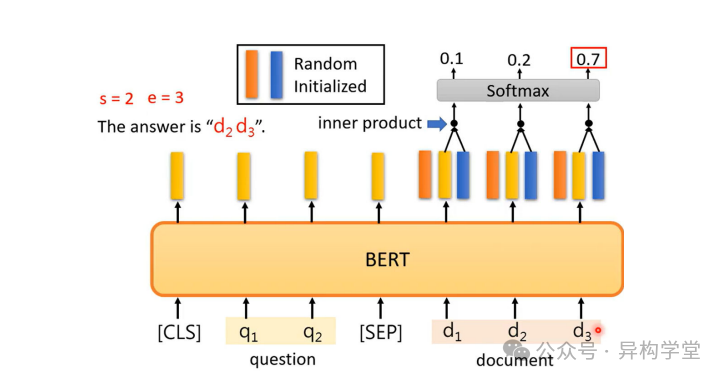

第11讲(难度***): 介绍Bert模型,Bert模型对于NLP领域具有重要的作用,因为其采用预训练的模式,然后在进行其他下游任务时,只需要调整输出层进行微调即可

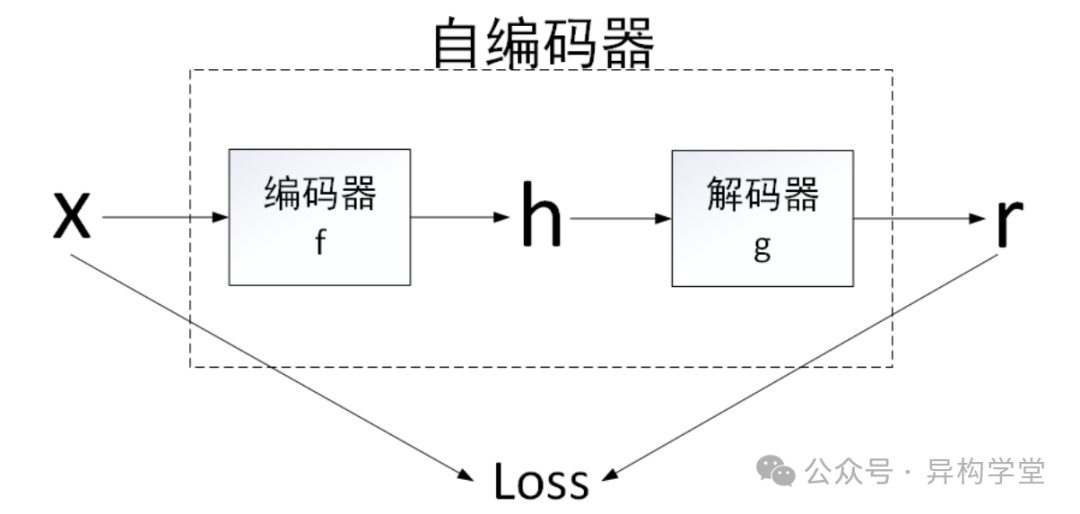

第12讲(难度***): 介绍自编码器,是一种用于无监督学习的人工神经网络,主要用于数据的降维、特征学习以及生成模型。自编码器的基本思想是通过训练一个网络来学习如何将输入数据压缩到一个较低维度的表示(称为编码或潜在空间表示),然后再从这个低维表示重构出原始输入数据

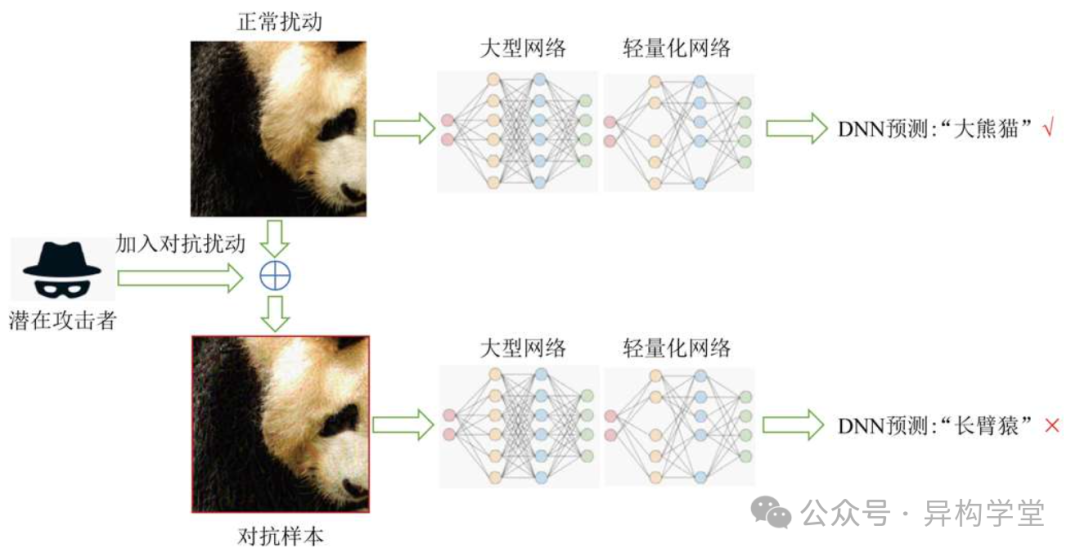

第13讲(难度***): 介绍对抗攻击,是指针对机器学习模型,尤其是深度学习模型的一种攻击方式。其核心思想是通过向输入数据添加细微且精心设计的扰动,使得模型产生错误的预测或分类结果。这些扰动通常是微小到人类难以察觉的程度,但对于机器学习模型来说,却足以导致严重的性能下降甚至完全误导模型

第14讲(难度**): 介绍可解释性机器学习,机器学习深度学习是一个黑盒子,对于如何提升模型的解释性非常重要,比如什么参数对模型有正向作用,什么参数比其他参数更大重要等等

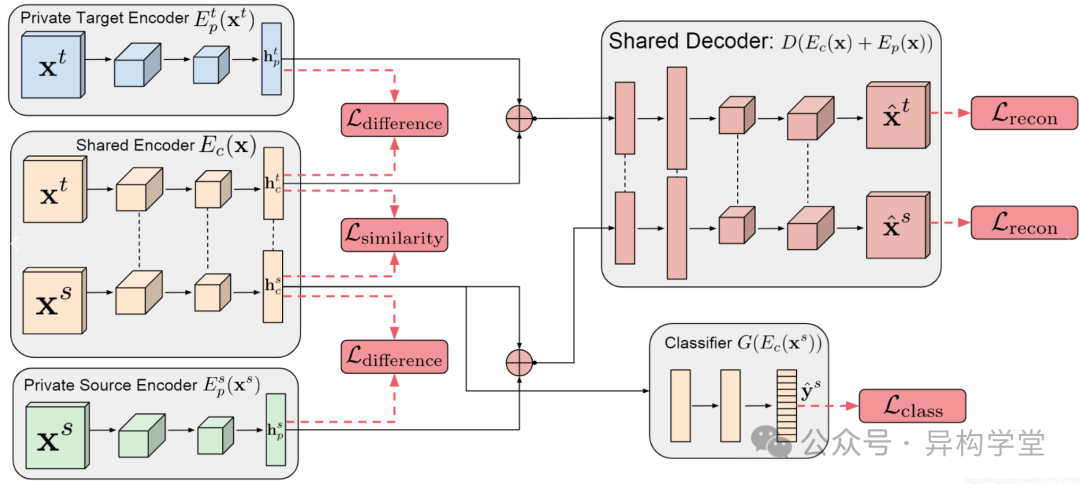

第15讲(难度***): 介绍领域自适应,它主要关注如何将在一个或多个源领域(source domain)上训练的模型应用到不同的但相关的目标领域(target domain),以解决由于领域差异导致的性能下降问题。简单来说,领域适应旨在缩小源领域和目标领域之间的分布差异,使得在源领域上学到的知识能够有效迁移到目标领域中

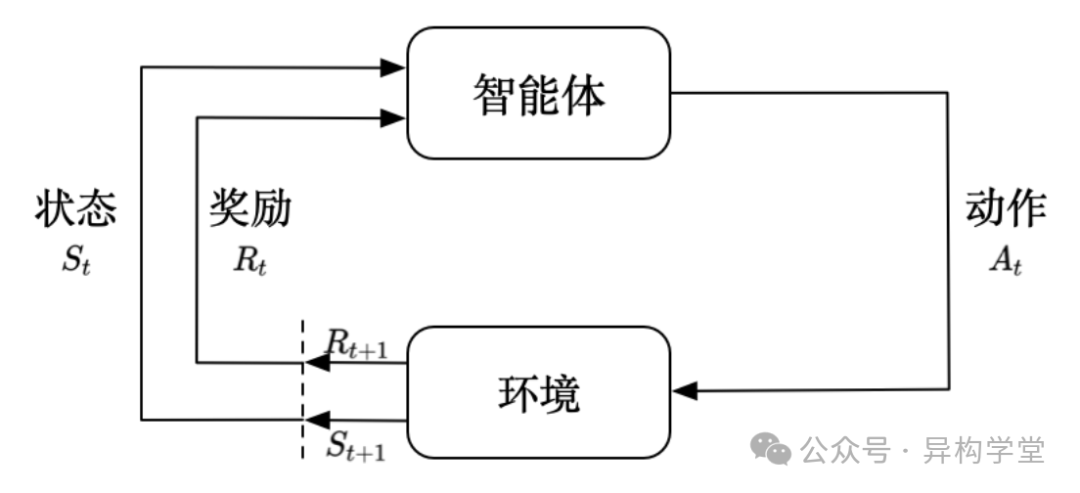

第16讲(难度***): 介绍强化学习基础,了解强化学习解决的问题,智能体,环境,奖励等概念,贝尔曼公式,RLHF, PPO, DPO, IPO等算法,强化学习在大模型领域有重要应用

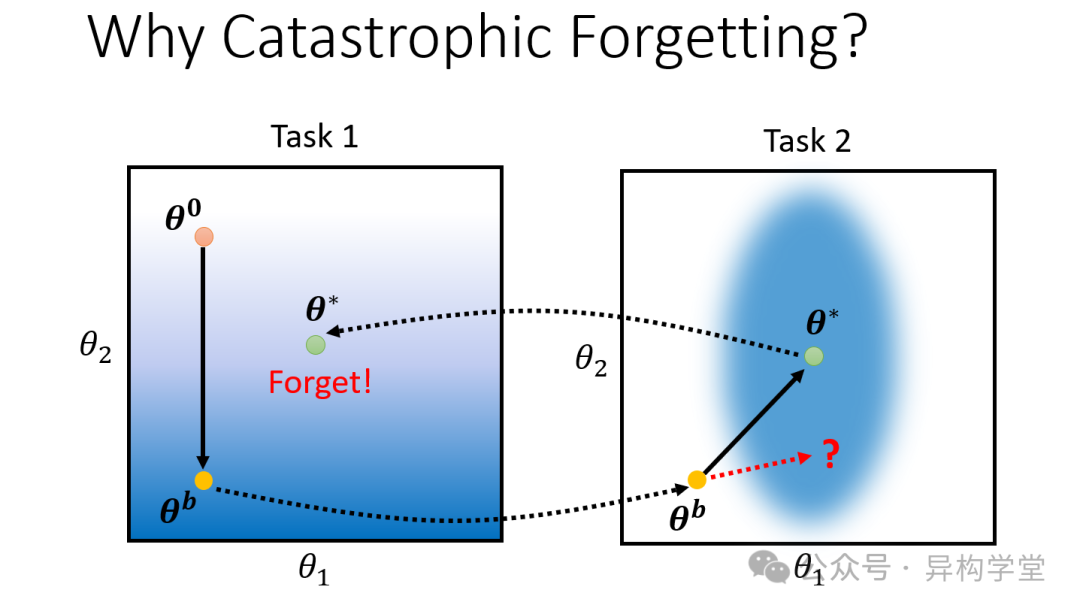

第17讲(难度***): 介绍终身学习,在机器学习和人工智能领域中,指的是系统或模型能够在部署后继续学习新知识,并且能够适应随着时间推移而变化的数据分布、任务需求以及环境条件,同时不会忘记之前学到的重要信息。这种能力对于构建更加智能、灵活和适应性强的人工智能系统至关重要

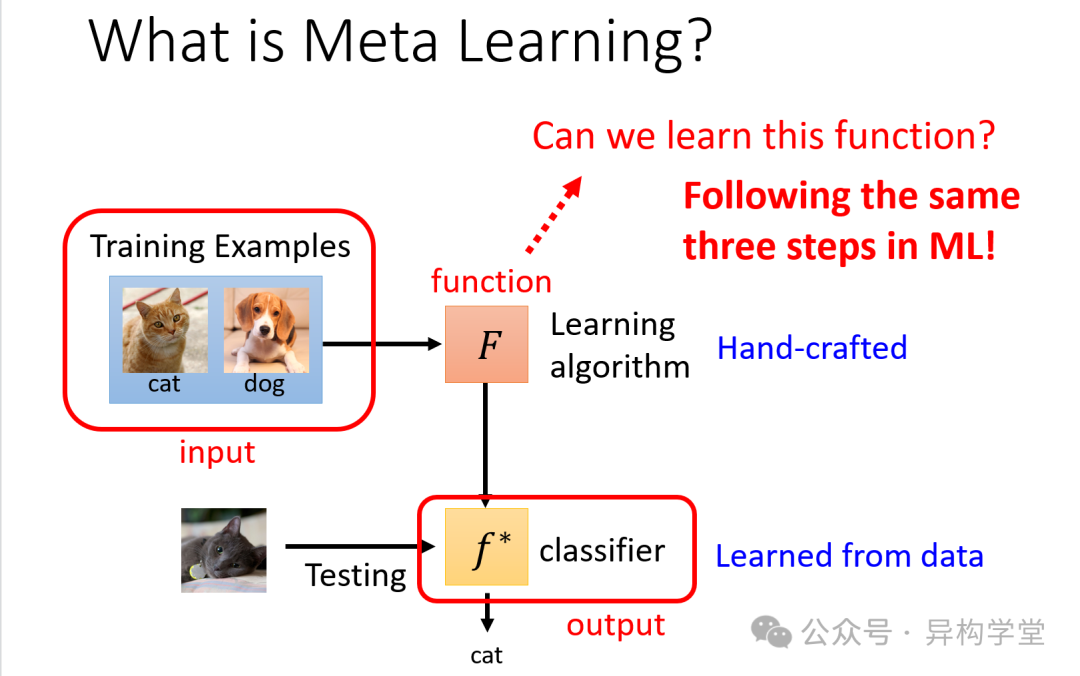

第18讲(难度***): 介绍元学习,是一种旨在让机器学习模型获得快速适应新任务能力的方法。不同于传统的机器学习方法,元学习关注的是如何设计算法和模型架构,使得它们能够从少量的数据或经验中迅速学习,并且能够有效地迁移到未见过的任务上。这种方法特别适用于那些需要处理大量不同但相关任务的场景

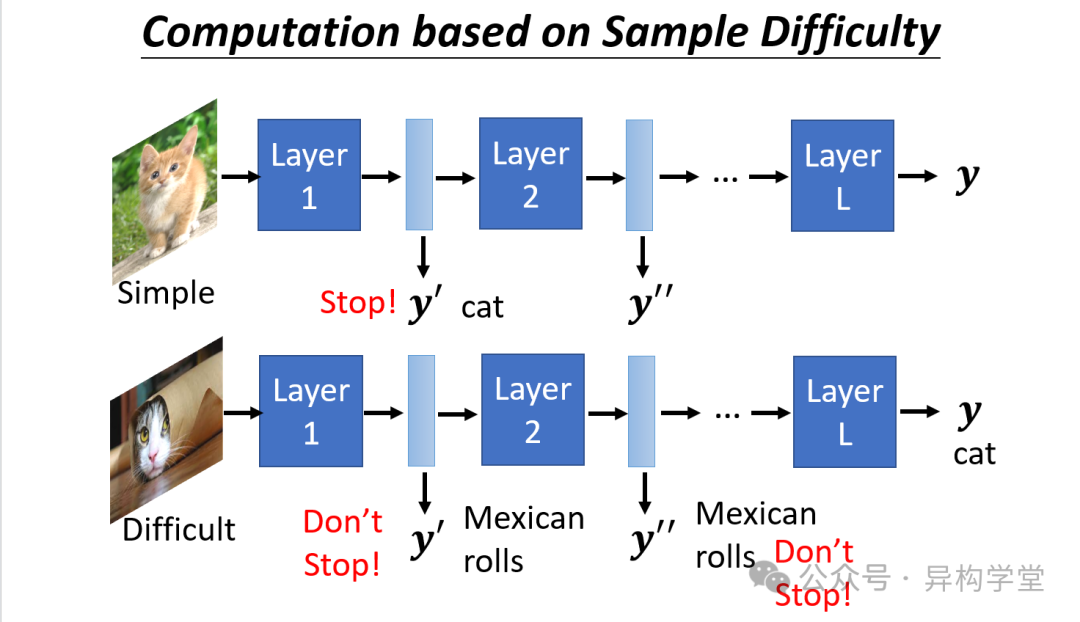

第19讲(难度***): 介绍神经网络压缩技术,是深度学习领域的一个重要研究方向,旨在减少神经网络的计算复杂度和存储需求,同时尽量保持模型的性能。随着深度学习模型变得越来越复杂和庞大,如何有效地压缩这些模型以便于在资源受限的设备上部署(如移动设备、嵌入式系统等)

除了上述的课件和笔记之外,李宏毅老师的机器学习视频教程也已经开源

文章中所有的数据和资料,可添加小助手无偿分享~

扫码添加小助手即可无偿获取~

也可以关注“AI技术星球”公众号,关注后回复“221C”获取。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)