SBD(Meta-AI):AI写文章太慢?科学家给它装上了“预言打字机”

新方法“集合块解码”让AI像预言家般跳跃输出关键词,再智能补全,速度飙升3-5倍!由Meta与牛津团队提出,无需重训模型,即插即用。告别逐字龟速,迎来“预言打字机”时代。

摘要:新方法“集合块解码”让AI像预言家般跳跃输出关键词,再智能补全,速度飙升3-5倍!由Meta与牛津团队提出,无需重训模型,即插即用。告别逐字龟速,迎来“预言打字机”时代。

你有没有试过跟AI聊天,等它慢悠悠地一个字一个字蹦出来,急得你想替它敲键盘?就像排队买奶茶,前面的人一个一个点单,店员一杯一杯做——效率低到让你怀疑人生。现在的大型语言模型(比如帮你写邮件、编故事的那些AI),其实也正卡在这个“逐字输出”的瓶颈上。它们像被设定成“打字机模式”,必须等前一个字敲完,才能思考下一个字该打什么。这不仅慢,还特别耗电、烧显卡。

问题就出在“自回归生成”这个听起来高大上的词儿上。翻译成人话就是:AI必须按顺序、一个字一个字往外蹦。就像你写作文,不能跳着写第三段再回头补第一段——AI也一样。每生成一个字,它都要把之前所有字重新“读”一遍,再算下一个字的概率。生成1000个字?那就得跑1000次计算!这种“龟速流水线”让AI在手机、平板甚至普通电脑上都跑得吃力,更别说实时对话或长文创作了。

过去人们想过不少办法加速,比如“投机解码”——让一个小弟AI先猜几个字,大哥AI再快速审核。或者“块解码”,一次吐出几个连续的字。但这些方法要么容易翻车(猜错了还得重来),要么不够灵活(只能连续输出,不能跳着写)。举个生活化的例子:

想象你在玩填字游戏,旧方法就像必须从左到右、一行一行填,哪怕你知道右下角那个空是“猫”,也得等填完前面所有格子才能写。另一个例子:你让AI续写《哈利波特》,它想直接写出“他挥动魔杖念出‘除你武器’”,但系统硬逼它先打出“他”,再算“挥”,再算“动”……中间任何一个字卡壳,整句话就得重来。

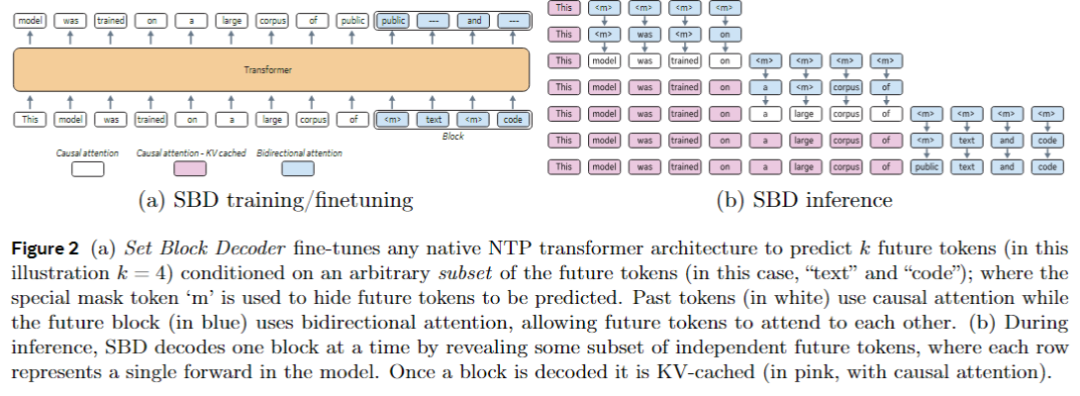

直到2025年9月,来自Meta AI、牛津大学和以色列魏茨曼科学研究所的一群聪明脑袋——Itai Gat、Heli Ben-Hamu、Marton Havasi 等九位作者——甩出了一篇炸裂论文:《Set Block Decoding is a Language Model Inference Accelerator》(集合块解码:一种语言模型推理加速器)。他们不修修补补,而是直接给AI换了个“大脑工作模式”。

他们的秘密武器叫 “集合块解码”(Set Block Decoding, SBD) ——听名字玄乎,其实原理超有趣。想象AI写作团队里突然多了三个“预言专员”:

🔹 “跳跃预测员”小跳:

他的任务不是按顺序猜字,而是像玩“大家来找茬”一样,一眼扫过整段空白,直接圈出几个“最有把握的位置”。比如他知道开头第一个字是“昨”,结尾倒数第三个字肯定是“雨”,中间第五个字八成是“天”——好,这三个位置,我先填!

🔹 “扩散策略师”老扩:

他负责把“离散扩散模型”(一种原本用于图像生成的数学工具,你可以理解为“从模糊猜清晰”的侦探术)搬进文字世界。他告诉小跳:“别怕跳着写!就算中间漏了几个字,我们也能像拼图一样,从边缘往中心推,逐步补全。” 这招让AI敢大胆“隔空取字”,不怕断档。

🔹 “缓存管家”阿缓:

最关键的是,这位管家确保整个过程“不返工”。他用“精确KV缓存”技术(你可以想象成AI的记忆笔记本),把每次计算的结果都记下来,下次直接调用,绝不重复劳动。哪怕小跳跳着写字,阿缓也能瞬间把上下文拼接得天衣无缝。

这三位专员配合起来有多强?论文里拿Llama-3.1 8B 和 Qwen-3 8B 两个主流大模型做了实验:只需3到5次“集体出击”,就能完成原本需要10次以上“单字苦干”的任务量,速度飙升3-5倍,而且质量丝毫不打折! 更妙的是,这套系统不需要重头训练模型,只要对现有AI稍作微调(fine-tuning)就能上岗,堪称“即插即用型外挂”。

回到我们之前的例子:

现在AI写《哈利波特》续集,小跳一看上下文,直接锁定三个关键词位置:“挥动”、“魔杖”、“除你武器”,啪啪啪三下填好;老扩根据这三个锚点,迅速补全中间的“他”、“念出”;阿缓全程记录状态,确保语句连贯。一整句话瞬间成型,不用再一个字一个字憋半天。

从“打字机模式”到“预言打字机”,这是AI生成效率的一次量子跃迁。

未来,这项技术可能让AI助手在手机上秒回长文,让游戏NPC实时生成剧情对话,甚至让盲人阅读器以接近人声的速度“念书”。更重要的是,它打开了“非顺序生成”的大门——也许不久后,AI能像人类作家一样,先写高潮再补开头,先定结局再铺伏笔。

科技的魅力,就在于把不可能变成“怎么没想到这么简单”。SBD没有发明新轮子,只是教会AI:你不必活得像个打字机,你可以是个预言家。

参考文献:

Gat, I., Ben-Hamu, H., Havasi, M., Haziza, D., Reizenstein, J., Synnaeve, G., Lopez-Paz, D., Karrer, B., & Lipman, Y. (2025). Set Block Decoding is a Language Model Inference Accelerator. arXiv preprint arXiv:2509.04185. https://doi.org/10.48550/arXiv.2509.04185

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)