YOLOv13最新创新改进系列:YOLOv13主干改进GhostNetV3 ,以极致轻量化之躯,赋能边缘AI实时检测,速度与精度完美融合,重新定义新一代视觉感知!【幽灵疾速,洞察无界】

YOLOv13结合GhostNetV3主干网络实现极致轻量化,专为边缘AI设备设计。GhostNetV3通过"幽灵特征图"生成机制(线性变换替代传统卷积)和DFC注意力模块,在减少70%计算量的同时保持高精度。实验显示,改进后的模型仅需269M FLOPs和14.46ms延迟即达到79.1% ImageNet top-1准确率,显著优于MobileNet等轻量架构。该技术已开源

YOLOv13最新创新改进系列:YOLOv13主干改进GhostNetV3 ,以极致轻量化之躯,赋能边缘AI实时检测,速度与精度完美融合,重新定义新一代视觉感知!【幽灵疾速,洞察无界】

购买相关资料后畅享一对一答疑!

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

第一部分:GhostNetV3 详细介绍

GhostNet 系列是由华为诺亚方舟实验室提出的一系列轻量级卷积神经网络架构,其核心思想是通过生成“幽灵”特征图来大幅减少计算量和参数量,同时尽量维持模型的性能。

1. 核心思想回顾:GhostNetV1 与 V2

-

GhostNetV1 (2020 CVPR): 其灵感来源于发现卷积层输出的特征图中存在大量冗余。V1 通过以下两步来构建“Ghost模块”:

- 少量卷积: 使用比输出通道数少得多的普通卷积(称为“内在卷积”)来生成一部分原始特征图。

- 线性变换: 对这部分原始特征图中的每个特征图,应用一系列廉价的线性操作(如深度卷积 DWConv)来“幻化”出更多的、与之相似的特征图(“幽灵”特征图)。

- 最后将原始特征图和幽灵特征图拼接起来,形成最终的输出。

优势: 用低成本的线性操作取代了高成本的普通卷积,在几乎不损失精度的情况下,显著降低了 FLOPs(计算量)和参数量。

-

GhostNetV2 (2023): 发现 V1 中的深度卷积(DWConv)缺乏感受野,无法有效捕捉空间信息,导致特征表达能力受限。

改进: 引入了解耦全连接注意力(Decoupled Fully Connected Attention, DFC Attention) 机制。该机制通过水平(H)和垂直(W)方向的两个全连接(FC)层来高效地建立长距离空间依赖关系,增强模型的特征表示能力,弥补了 V1 的不足。

2.原文部分

摘要

紧凑神经网络专为边缘设备上的应用而设计,具有更快的推理速度但性能适中。然而,目前紧凑模型的训练策略借鉴自传统模型,忽略了它们在模型容量上的差异,因此可能阻碍紧凑模型的性能。在本文中,通过系统地研究不同训练成分的影响,我们为紧凑模型引入了一种强大的训练策略。我们发现,重参数化和知识蒸馏的适当设计对于训练高性能紧凑模型至关重要,而一些常用于训练传统模型的数据增强方法,如 Mixup 和 CutMix,会导致性能下降。我们在 ImageNet-1K 数据集上的实验表明,我们为紧凑模型设计的专用训练策略适用于各种架构,包括 GhostNetV3、MobileNetV2 和 ShuffleNetV2。具体来说,配备我们的策略后,GhostNetV3 1.3(\times) 仅用 269M FLOPs 和在移动设备上 14.46ms 的延迟就达到了 79.1% 的 top-1 准确率,大幅超越了其普通训练的对应版本。此外,我们的观察也可以扩展到目标检测场景。PyTorch 代码和检查点可以在 https://github.com/huawei-noah/Efficient-AI-Backbones 找到。

1 引言

为了满足边缘设备(例如,手机)有限的内存和计算资源,各种高效架构 [10, 15, 16, 19, 21, 26, 28] 被开发出来。例如,MobileNetV1 [16] 使用深度可分离卷积来降低计算成本。MobileNetV2 [21] 引入了残差连接,MobileNetV3 [15] 通过神经架构搜索(NAS)进一步优化了架构配置,显著提高了模型的性能。另一个典型架构是 GhostNet [10],它利用特征中的冗余,通过使用廉价操作来复制特征通道。廉价操作。最近,GhostNetV2 [26] 进一步引入了一个硬件友好的注意力模块来捕获长距离像素间的依赖关系,并以显著优势超越了 GhostNet。

除了精心设计的模型架构外,适当的训练策略对于卓越的性能也至关重要。例如,Wightman 等人 [29] 通过集成先进的优化和数据增强方法,将 ResNet-50 [11] 在 ImageNet-1K [5] 上的 top-1 准确率从 76.1% 提高到 80.4%。然而,尽管已经付出了相当大的努力来探索传统模型(例如,ResNet 和 Vision Transformer)的更先进的训练策略,但紧凑模型却很少受到关注。由于不同容量的模型可能具有不同的学习偏好 [24],直接将为传统模型设计的策略应用于训练紧凑模型是不合适的。

为了弥合这一差距,我们系统地研究了几种紧凑模型的训练策略。具体来说,我们的主要关注点放在先前工作 [12, 27] 中讨论的关键训练设置上,包括重参数化、知识蒸馏(KD)、学习调度和数据增强。

重参数化。 深度卷积和 1×1 卷积是紧凑模型架构中的常见组件,因为它们的内存和计算消耗可以忽略不计。受训练传统模型成功经验 [6, 7] 的启发,我们对这两个紧凑模块采用重参数化方法以获得更好的性能。在训练紧凑模型时,我们向深度卷积

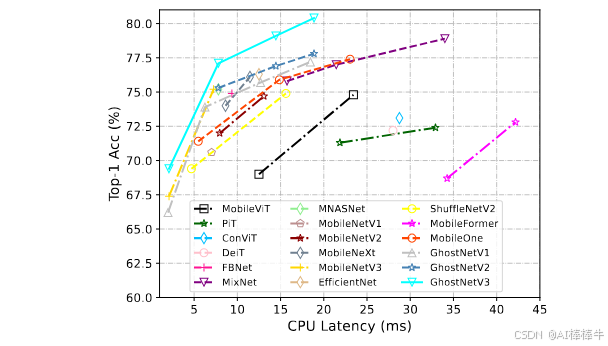

图 1:ImageNet 数据集上各种紧凑模型的 top-1 验证准确率和 CPU 延迟。

和 1×1 卷积中引入线性并行分支。这些额外的并行分支可以在训练后进行重参数化,在推理时不会带来额外成本。为了权衡整体训练成本与性能改进,我们比较了不同数量添加分支的影响。此外,我们发现 1×1 深度卷积分支对 3×3 深度卷积的重参数化具有显著的积极影响。

知识蒸馏。 由于模型容量有限,紧凑模型很难达到与传统模型相当的性能。因此,KD [14] 是一种提高性能的合适方法,它使用一个更大的模型作为教师来指导紧凑模型的学习。我们实证研究了使用 KD 训练紧凑模型时几个典型因素的影响,例如教师模型的选择和超参数的设置。结果表明,合适的教师模型可以显著提升紧凑模型的性能。

学习调度和数据增强。 我们比较了紧凑模型的几种训练设置,包括学习率、权重衰减、指数移动平均(EMA)和数据增强。有趣的是,并非所有为传统模型设计的技巧都对紧凑模型有效。例如,一些广泛使用的数据增强方法,如 Mixup 和 CutMix,实际上会降低紧凑模型的性能。我们在第 5 节详细讨论了它们的影响。

基于我们的研究,我们为紧凑模型开发了一种专门的训练配方。在 ImageNet-1K 数据集上的实验验证了我们提出的配方的优越性。具体来说,使用我们的配方训练的 GhostNetV3 模型在 top-1 准确率和延迟方面都显著优于使用先前策略训练的模型(图 1)。在其他高效架构(如 MobileNetV2 和 ShuffleNetV2)上的实验进一步证实了所提出配方的通用性。

本文的其余部分组织如下。第 2 节回顾了相关工作。第 3 节介绍了 GhostNetV2 的架构。训练策略在第 4 节详细讨论。然后在第 5 节展示了丰富的实验结果。第 6 节对论文进行了总结。

2 相关工作

紧凑模型

设计一个同时具有低推理延迟和高性能的紧凑模型架构是具有挑战性的。SqueezeNet [17] 提出了三种策略来设计紧凑模型,即用 1×1 滤波器替换 3×3 滤波器,减少 3×3 滤波器的输入通道数,以及在网络后期进行下采样以保持大的特征图。这些原则具有建设性,特别是 1×1 卷积的使用。MobileNetV1 [16] 用 1×1 内核和深度可分离卷积替换了几乎所有的滤波器,极大地降低了计算成本。MobileNetV2 [21] 进一步引入了残差连接到紧凑模型,并构建了一个倒残差结构,其中一个块的中间层比其输入和输出具有更多的通道。为了保持表示能力,移除了部分非线性函数。MobileNeXt [36] 重新思考了倒置瓶颈的必要性,并声称经典的瓶颈结构也可以实现高性能。考虑到 1×1 卷积占计算成本的很大一部分,ShuffleNet [34] 用分组卷积替换了它。通道混洗操作有助于信息在不同组之间流动。通过研究影响实际运行速度的因素,ShuffleNetV2 [18] 提出了一种新的硬件友好块。

MnasNet [22] 和 MobileNetV3 [15] 搜索架构参数,例如模型宽度、模型深度、卷积滤波器大小等。通过利用特征的冗余,GhostNet [10] 用廉价操作替换了 1×1 卷积中的一半通道。GhostNetV2 [26] 提出了一种基于全连接层的称为 DFC 注意力的模块,它不仅可以在通用硬件上快速执行,而且可以捕获长距离像素之间的依赖关系。到目前为止,GhostNet 系列仍然是 SOTA 紧凑模型,在准确性和速度之间取得了良好的平衡。

自从 ViT [8] (DeiT) 在计算机视觉任务上取得巨大成功以来,研究人员努力为移动设备设计紧凑的 Transformer 架构。MobileFormer [2] 提出了一种紧凑的交叉注意力来建模 MobileNet 和 Transformer 之间的双向桥梁。MobileViT [19] 借鉴了紧凑 CNN 中的成功经验,并使用 Transformer 替换了卷积中的局部处理。然而,基于 Transformer 的紧凑模型由于复杂的注意力操作,在移动设备上存在高推理延迟的问题。

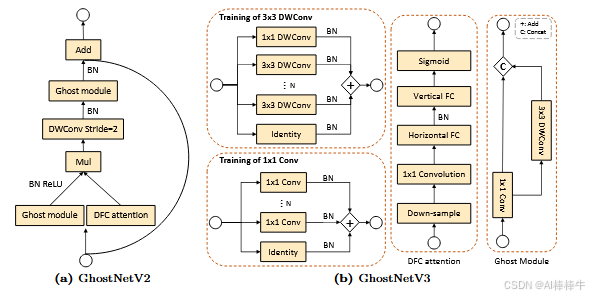

图 2:GhostNetV2 和 GhostNetV3 的架构。

训练 CNN 的技巧包

有一些工作专注于改进训练策略以提高各种模型的性能。He 等人 [12] 讨论了几种对硬件高效训练有用的技巧,并为 ResNet 提出了一种新的模型架构调整。Wrightman 等人 [29] 重新评估了普通 ResNet-50 在使用新颖的优化和数据增强方法训练时的性能。他们在 timm 开源库中分享了有竞争力的训练设置和预训练模型。使用他们的训练配方,一个普通的 ResNet-50 模型达到了 80.4% 的 top-1 准确率。Chen 等人 [1] 研究了训练自监督 ViT 的几个基本组件的影响。然而,所有这些尝试都是为大型模型或自监督模型设计的。由于模型容量不同 [24],直接将它们迁移到紧凑模型是不合适的。

3 预备知识

GhostNets(GhostNetV1 和 GhostNetV2)是为在移动设备上高效推理而设计的最先进的紧凑模型。它们的核心架构是 Ghost 模块,它可以通过廉价操作生成更多特征图来替代原始卷积。

在普通卷积中,输出特征 (Y) 通过 (Y=XW) 获得,其中 (W\in\mathbb{R}^{c_{\text{out}}\times c_{\text{in}}\times k\times k}) 是卷积核,(X) 是输入特征。(c_{in}) 和 (c_{out}) 分别表示输入和输出通道维度。(k) 是核大小,() 表示卷积操作。Ghost 模块通过两个步骤减少普通卷积的参数数量和计算成本。它首先产生内在特征 (Y^{\prime}),其通道维度小于原始特征 (Y)。然后对内在特征 (Y^{\prime}) 应用廉价操作(例如,深度卷积)以生成幽灵特征 (Y^{\prime\prime})。最终输出是通过沿通道维度连接内在和幽灵特征获得的,可以表示为:

[Y^{\prime} =XW_{p},] (1) [Y =\text{Cat}(Y^{\prime},XW_{c}),] (2)

其中 (W_{p}) 和 (W_{c}) 分别表示主卷积和廉价操作中的参数。“Cat”表示连接操作。整个 GhostNet 模型是通过堆叠多个 Ghost 模块构建的。

GhostNetV2 通过设计一个高效的注意力模块(即 DFC 注意力)来增强紧凑模型。考虑到像 GhostNet 这样的紧凑模型通常使用小核卷积,例如 1×1 和 3×3,它们从输入特征中提取全局信息的能力较弱。GhostNetV2 采用一个简单的全连接层来捕获长距离空间信息并生成注意力图。为了计算效率,它将全局信息解耦到水平和垂直方向,并分别沿两个方向聚合像素。如图 1(a) 所示,通过为 Ghost 模块配备 DFC 注意力,GhostNetV2 可以有效地提取全局和局部信息,同时在准确性和计算复杂性之间实现更好的权衡。

4 训练策略

我们的目标是探索训练策略,而不改变推理网络架构,以保持紧凑模型的小模型尺寸和快速速度。我们实证研究了训练神经网络的关键因素,包括学习调度、数据增强、重参数化和知识蒸馏。

重参数化

重参数化已在传统卷积模型 [6, 7] 中证明了其有效性。受其成功的启发,我们通过添加配备 BatchNorm 层的重复分支将重参数化引入紧凑模型。我们重参数化 GhostNetV3 的设计如图 1(b) 所示。值得注意的是,我们在重参数化的 3×3 深度卷积中引入了一个 (1\times 1) 深度卷积分支。实验结果证实了它对紧凑模型性能的积极影响。此外,实验深入探索了重复分支的最佳数量。

详细内容大家阅读我上面提供的原文,加油!!!

2. GhostNetV3 的创新与特点

第二部分,本文基于下述方法进行YOLOv13改进

GhostNetV3: 探索紧凑模型的训练策略

# GhostNetV3 在前两代的基础上进一步演进,其核心创新点在于:

- 硬件友好的注意力机制升级: 虽然 V2 的 DFC Attention 很有效,但其中的全连接(FC)层在硬件(如 GPU、NPU)上的计算效率并不高,无法充分发挥硬件算力。

- 引入 PSA(Pixel-Shuffle Attention)模块: GhostNetV3 用 PSA 模块 取代了 V2 中的 DFC Attention。PSA 模块的核心操作是:

- Pixel-Shuffle(像素重排): 将输入特征图在空间维度上重组到通道维度。这是一个零计算成本的操作,但可以有效地将空间信息编码到通道中。

- 通道注意力: 对重组后的特征图应用高效的通道注意力机制(如使用全局平均池化和全连接层)。

- Pixel-Unshuffle(逆像素重排): 将加权后的特征图重新还原到原始的空间尺寸。

- 优势:

- 硬件友好: PSA 模块主要由常规的卷积、池化和像素重排操作构成,这些操作在主流硬件上都有高度优化的实现,因此比 V2 的 FC 层计算延迟更低、速度更快。

- 保持有效性: 同样能够建立强大的空间长距离依赖,增强特征表示,其性能与 V2 的 DFC Attention 相当甚至更好。

- 即插即用: 可以无缝替换 GhostNetV2 中的注意力模块。

总结 GhostNetV3: 它是一个专为移动端和边缘设备设计的、极度高效且高性能的骨干网络(Backbone)。它通过“幻影”卷积思想减少冗余,并通过硬件友好的 PSA 注意力机制来增强模型能力,实现了“又快又准又小”的完美平衡。

第二部分:GhostNetV3 与 YOLO 结合的优势

YOLO(You Only Look Once)是当前最流行、最先进的目标检测算法系列之一。将 GhostNetV3 作为 YOLO 的骨干网络(替换掉原来的如 CSPDarknet 等),可以带来以下显著优势:

1. 极致的速度与效率提升(核心优势)

- 大幅降低计算量(FLOPs)和参数量(Parameters): GhostNetV3 本身的设计目标就是轻量化。将其作为 Backbone,可以大幅削减 YOLO 模型整体的计算负担。

- 更高的推理帧率(FPS): 更低的计算量直接转化为更快的推理速度。这使得结合后的模型(如 YOLO-GhostNetV3)可以在资源受限的设备上(如 Jetson Nano、手机、无人机、嵌入式摄像头)实现实时或超实时的目标检测。

- 降低能耗: 计算量的减少也意味着功耗的降低,这对于依赖电池的移动设备和物联网设备至关重要。

2. 保持优异的检测精度

- 注意力机制弥补轻量化的精度损失: 单纯的轻量化往往会带来精度下降。GhostNetV3 的 PSA 注意力机制能有效捕捉全局上下文信息,帮助 YOLO 的检测头(Head)更好地定位和识别物体,尤其是对于小物体和复杂场景中的物体。

- 性能与效率的完美平衡: 在相同的计算预算下,GhostNetV3-based YOLO 通常能够达到比其它轻量化骨干网络(如 MobileNetV3、ShuffleNetV2)更高的 mAP(平均精度均值),实现了最佳的“精度-速度”权衡。

3. 硬件友好性,易于部署

- 兼容主流加速硬件: 如前所述,GhostNetV3 的构建块(标准卷积、深度卷积、Pixel-Shuffle)在 NVIDIA GPU、Intel CPU、ARM NPU 等各种硬件上都能获得良好的支持和加速。

- 简化部署流程: 由于其结构的通用性,使用 TensorRT、OpenVINO、MNN、TNN 等推理引擎进行部署和量化(INT8)时更加简单,不易遇到算子不兼容或优化不佳的问题。

4. 灵活性高

- 即插即用: GhostNetV3 可以相对容易地集成到 YOLO 的不同版本中(如 YOLOv5, YOLOv7, YOLOv8, YOLOX 等),为这些模型提供一个高效的轻量化变体。

- 可缩放性: 像其他网络一样,GhostNetV3 通常也提供不同宽度和深度的配置(如 Small, Large),允许开发者根据实际应用对速度和精度的要求进行灵活选择。

总结

| 特性/优势 | 说明 |

|---|---|

| 核心创新 | 使用 PSA(Pixel-Shuffle Attention) 模块,提供硬件友好的强大注意力机制。 |

| 与YOLO结合的速度优势 | 极低的计算量和参数量,带来极高的推理帧率(FPS) 和低能耗,完美适配边缘设备。 |

| 与YOLO结合的精度优势 | PSA注意力机制有效提升特征表达能力,弥补轻量化带来的精度损失,实现优异的“精度-速度”平衡。 |

| 部署优势 | 构建块硬件友好,被主流推理引擎高度优化,易于部署和量化。 |

| 总体价值 | 为 YOLO 提供了一个在边缘设备上实现高精度、超快速、低功耗实时目标检测的最佳骨干网络选择之一。 |

总而言之,GhostNetV3 代表了轻量化CNN设计的一个重要方向:不仅仅是减少参数和计算,更要考虑硬件的实际运行效率。将其与 YOLO 结合,是构建高性能、低延迟、可部署的实时视觉应用的一个非常理想且先进的技术方案。

写在最后

学术因方向、个人实验和写作能力以及具体创新内容的不同而无法做到一通百通,所以本文作者即B站Up主:Ai学术叫叫兽

在所有B站资料中留下联系方式以便在科研之余为家人们答疑解惑,本up主获得过国奖,发表多篇SCI,擅长目标检测领域,拥有多项竞赛经历,拥有软件著作权,核心期刊等经历。因为经历过所以更懂小白的痛苦!因为经历过所以更具有指向性的指导!

祝所有科研工作者都能够在自己的领域上更上一层楼!!!

所有科研参考资料均可点击此链接,合适的才是最好的,希望我的能力配上你的努力刚好合适!

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)