大模型的微调和部署

AI Agent智能体最简洁的定义是:能够自主感知环境、规划任务、调用工具并执行的AI系统。它不是单一模型,而是一套“大模型+记忆+规划+工具”的组合拳。与常见AI助手相比,Agent最大的差异在“主动性”。AI助手像前台接待员,你来问、它来答;Agent更像项目经理,听完目标就自己跑流程。谷歌的对比实验很直观:让传统聊天机器人安排一次三天两晚的京都赏枫之旅,它只会返回景点列表;而Agent会先查

什么是大模型?

大语言模型(简称大模型)是一类具有大量参数(通常在十亿以上),在极为广泛的数据上进行训练,并适用于多种任务和应用的预训练深度学习模型。

大模型主要有以下四个特点:

-

规模和参数量大:大模型通过其庞大的规模(拥有从数亿到数千亿级别的参数数量)来捕获复杂的数据模式,使得它们能够理解和生成极其丰富的信息。

-

适应性和灵活性强:模型具有很强的适应性和灵活性,能够通过微调(fine-tune)或少样本学习高效地迁移到各种下游任务,有很强的跨域能力。

-

广泛数据集的预训练:大模型使用大量多样化的数据进行预训练,以学习广泛的知识表示,能够掌握语言、图像等数据的通用特征。

-

计算资源需求大:巨大的模型规模带来了高昂的计算和资源需求,包括但不限于数据存储、训练时间、能量消耗和硬件设施。

Transformer是大模型吗?

Transformer是一种深度学习架构,其本身并非大模型,但现代大模型(如GPT、BERT等)通常基于Transformer架构构建。

采用llama factory工具进行微调。

大模型的微调

大模型的参数写为A,想调整为C,则可以通过A+B=C。微调时是想找出这个B。如果是对所有的参数都做调整,则称为全量微调。如果是少量的调整,则称为高效的微调(PEFT)。在PEFT中,最常见的技术是LoRA。LoRA将大的权重更新矩阵分解成两个小的矩阵进行训练,从而减少训练参数。

1.数据准备:收集和准备特定任务的数据集。

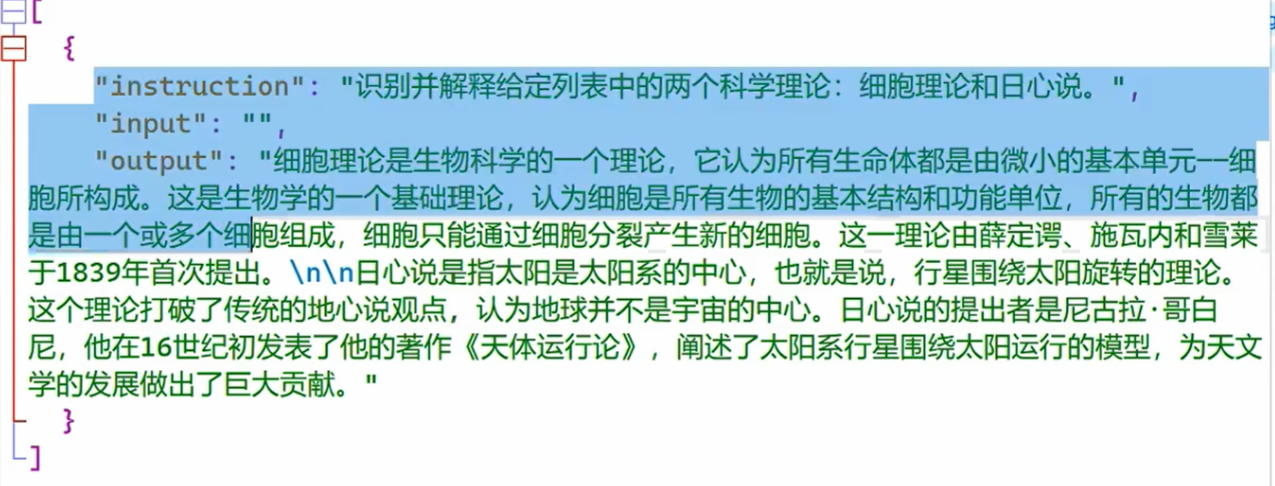

输入数据示例:

2.模型选择:选择一个预训练模型作为基础模型。

3.迁移学习:在新数据集上继续训练模型,同时保留预训练模型的知识。

4.参数调整:根据需要调整模型的参数,如学习率、批大小等。

5.模型评估:在验证集上评估模型的性能,并根据反馈进行调整。

LoRA 的微调方法

LoRA 的核心思想是低秩分解(Low-Rank Decomposition)。

冻结预训练模型:在微调开始时,原始的LLM(比如 LLaMA、GPT 等)所有参数都被冻结,不再进行更新。

插入适配器:在模型的 Transformer 模块中,LoRA 会在权重矩阵 W0 旁边添加两个小的、可训练的矩阵,通常称为 A 和 B。这两个矩阵的乘积 AB 构成了对原始权重矩阵的“增量更新” ΔW。

参数训练:在微调过程中,LoRA 只会训练这两个小矩阵 A 和 B 的参数,而原始的 W0 矩阵保持不变。

模型合并与推理:训练完成后,LoRA 适配器可以与原始模型分离,也可以将其参数合并到原始模型中。在推理时,通常会将 W0+BA 合并为一个新的权重矩阵,从而实现与全量微调相同的推理速度,并且不增加额外的延迟。

这种方法大大减少了需要训练的参数量,将原本可能需要数十亿参数的训练任务,压缩到只需训练几百万参数。

SFT微调(Supervised Fine-Tuning监督微调)

需要一些指令微调数据,数据集的格式是<输入,输出>。指有监督的学习调整参数。核心思想是“迁移学习”: 利用预训练模型已有的知识(如语言理解能力),通过微调快速适配新任务(如文本分类、对话生成)。一般只训练输出层的参数。类似迁移学习。

BERT(Bidirectional Encoder Representations from Transformers)

是由Google于2018年提出的基于Transformer架构的预训练语言模型,通过双向上下文理解显著提升了自然语言处理(NLP)任务的性能。

Prompt Engineering Prompt工程

Prompt是用户向模型提供的输入,用于引导模型生成特定类型、主题或格式的文本输出。这种输入可以是一个问题、一个描述、一组关键词或上下文信息,它告诉模型用户希望得到的输出类型和内容。

大模型RAG是什么?

检索增强生成(Retrieval-augmented Generation),简称RAG

是一种结合信息检索和文本生成的技术,旨在提升大模型回答专业问题时的准确性和可靠性。

RAG可以降低大模型出现幻觉的概率,幻觉指的是大模型答非所问。

1.核心思想:

检索与生成结合:RAG 将检索系统与生成模型无缝衔接,形成一个混合模型架构。当接收到一个查询或问题时,模型首先通过检索模块从大规模知识库中寻找与查询相关的信息片段(如文本片段、文档摘要、知识条目等)。

知识增强:检索到的相关信息被作为额外输入传递给生成模型,使得模型在生成回答时不仅依赖于自身的内部知识,还能利用实时检索到的外部知识资源,从而丰富其输出内容,提高答案的准确性、全面性和时效性。

2.架构组成:

检索模块:通常是一个高效的搜索引擎或索引系统,负责根据查询语句从预先构建的知识库中快速定位并提取相关信息。检索模块可能采用向量相似度搜索、关键词匹配、深度学习嵌入匹配等技术。

生成模型:通常是一个预训练的大型语言模型(如 GPT、BERT 或 T5),具备强大的语言理解和生成能力。生成模型接收查询和检索结果作为输入,综合两者信息生成最终答案。在某些实现中,检索结果可能以注意力机制的形式融入到生成模型的计算过程中。

3.工作流程:

查询阶段:用户提交一个问题或查询,RAG 模型首先通过检索模块在知识库中搜索与查询相关的文档或片段。

融合阶段:检索到的候选文档或片段被编码成向量形式,与查询语句一起作为输入传递给生成模型。生成模型学习如何有效地结合内部知识与检索到的外部知识来生成答案。

生成阶段:生成模型基于整合的信息生成回答。这一过程可能涉及解码器网络的自回归生成,其中检索结果的贡献以某种形式(如注意力权重)影响生成步骤。

什么是AI Agent智能体

AI Agent智能体最简洁的定义是:能够自主感知环境、规划任务、调用工具并执行的AI系统。它不是单一模型,而是一套“大模型+记忆+规划+工具”的组合拳。

与常见AI助手相比,Agent最大的差异在“主动性”。AI助手像前台接待员,你来问、它来答;Agent更像项目经理,听完目标就自己跑流程。谷歌的对比实验很直观:让传统聊天机器人安排一次三天两晚的京都赏枫之旅,它只会返回景点列表;而Agent会先查新干线时刻,再比酒店价格,最后把PDF行程单发到你邮箱,全程无需人工点下一步。

大模型的训练,微调,数据清洗?大模型如何离线使用自己的数据优化来自己使用?

大模型相关面试题,

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)