FrOG开源 | GraphRAG框架,提升大模型透明度与准确性的完整方案

本文介绍了“FrOG: Framework of Open GraphRAG”研究的核心内容,包括其针对大模型知识更新难、答案透明度差、幻觉等问题的解决思路与系统架构。系统在Wikidata、DBpedia和本地KG等多知识库上验证了效果,并对问答管线、组件、实验结果及提升建议进行了全面阐述。适合专业知识图谱与LLM领域人士参考。

程序员必看!FrOG开源GraphRAG框架:提升大模型透明度与准确性的完整方案

FrOG是开源GraphRAG系统,结合知识图谱与LLM解决大模型知识更新难、推理不透明和幻觉问题。系统通过两版Pipeline实现多语言和多知识库支持,在Wikidata、DBpedia和本地KG等数据集上验证效果。实验表明本体检索组件对准确率提升贡献最大,Pipeline v2+Qwen2.5 7B表现最优,为开发透明、可解释的大模型应用提供有效方案。

摘要:

本文介绍了“FrOG: Framework of Open GraphRAG”研究的核心内容,包括其针对大模型知识更新难、答案透明度差、幻觉等问题的解决思路与系统架构。系统在Wikidata、DBpedia和本地KG等多知识库上验证了效果,并对问答管线、组件、实验结果及提升建议进行了全面阐述。适合专业知识图谱与LLM领域人士参考。*

引言:开放知识与可信AI的融合

Wikimedia Indonesia于2024年推出Wikidata Research Fund,以推动知识图谱如Wikidata在人工智能及科研领域中的创新应用。由印尼大学与维也纳经济大学合作的FrOG团队,围绕“AI幻觉”这一难题,提出了将大型语言模型(LLM)与结构性知识图谱(KG)深度结合的技术路线,并研发出FrOG开源RAG问答系统。

https://github.com/Framework-of-Open-GraphRAG/FROG

项目团队

课题组长: Fariz Darari(印尼大学)

成员:

- Jaycent Gunawan Ongris(印尼大学)

- Eduardus Tjitrahardja(印尼大学)

- Fajar Juang Ekaputra(维也纳WU)

一、研究背景

近年来,大型语言模型(LLM, 如ChatGPT、Gemini、Copilot等)在信息检索与自然语言理解领域取得了重大突破,实现了问答、摘要等多项复杂任务。然而,LLM 仍然存在三大核心挑战:

-

知识更新难度大

——模型知识难以动态追踪现实世界变化。

-

推理过程不透明

——“黑盒”操作难以解释答案来源。

-

幻觉问题

——有时输出存在不准确或虚假内容。LLM如ChatGPT、Gemini善于生成流畅自然的语言,但在面对事实性问题时,常出现自信但错误的回答,即“幻觉”。这在教育、法律、科研等领域尤为严重。

为应对上述问题,Retrieval-Augmented Generation(RAG)成为主流办法,通过外部知识检索辅助LLM生成答案,减少对参数记忆的依赖。然而,RAG主流方法一般采用Dense Retriever(如DPR),其向量表达方式使检索过程缺乏可解释性,并易导致上下文片段化,影响复杂查询的整体理解。

知识图谱(Knowledge Graph, KG)则通过实体及其属性与关系将真实世界结构化,能为LLM输出提供精准可查证的支撑,成为Retrieval-Augmented Generation(RAG)技术的理想基础。

二、核心创新

1. 引入知识图谱(KG)驱动RAG

本研究提出以知识图谱(KG)为信息基础,开发了名为FrOG(Framework of Open GraphRAG)的开源RAG系统,通过KG节点关系透明组织事实信息,使推理、溯源更加易于追溯。

KG优点示意

- 以实体为节点、关系为边,高度结构化,便于显性追踪和多跳推理。

- 支持SPARQL等结构化查询语言,易于控制、集成。

- 支持大规模、开放协作(如Wikidata)。

2. 主要研究问题

研究针对以下问题展开:

- 如何高效用开源组件实现GraphRAG架构?

- 哪种大模型最适合该框架?

- GraphRAG架构中哪些组件对答案准确率提升作用最大?

3. 研究范围

- 核心聚焦于事实型问答(factoid QA)。

- 所有系统(含LLM)与依赖均选用开源组件,确保透明复现。

- 评估数据涵盖开放KG(Wikidata、DBpedia)与本地KG(Curriculum KG)。

- LLM实验限定在Qwen2.5 7B、Mistral 7B/NeMo 12B、LLaMA 3.1 8B等主流开源模型。

- 不进行高消耗的模型微调(fine-tune),而利用上下文学习(in-context learning)。

- 评价采用SPARQL查询结果Jaccard相似度(见后文表格与评估图)。

- 多语言能力在Pipeline v2上初步验证,重点为印尼语。

三、技术方案和系统架构

1. 相关背景

-

KG技术快速回顾

借助RDF三元组(主语-谓语-宾语)、SPARQL、Semantic Web理念构建结构化实体网络。

-

LLM分类

Encoder-only(如BERT)、Decoder-only(如GPT)、Encoder-Decoder(如T5)等。

-

RAG机制

结合LLM内部知识与外部知识库,辅助问答准确性。传统RAG用文本语料+DPR检索,GraphRAG用KG,实现复杂语义关系可视推理。

2. Pipeline系统详细设计

Pipeline v1: 初始原型

- 通过prompt工程指导基础LLM把自然语言问题转为SPARQL查询,实现对Wikidata的自动检索与应答。

- 局限:复杂句式、跨语言支持较弱,迁移到其它KG难度较大。

Pipeline v2: 多语言·多知识库能力升级

- 引入多语言LLM(如Qwen2.5 7B)、多轮prompt链,综合矢量(向量)本体检索工具,理解不同KG结构和术语,大幅提升复杂任务対応与多领域应用能力。

- 支持自建学科课程知识图谱(Curriculum KG)等场景,落地性强。

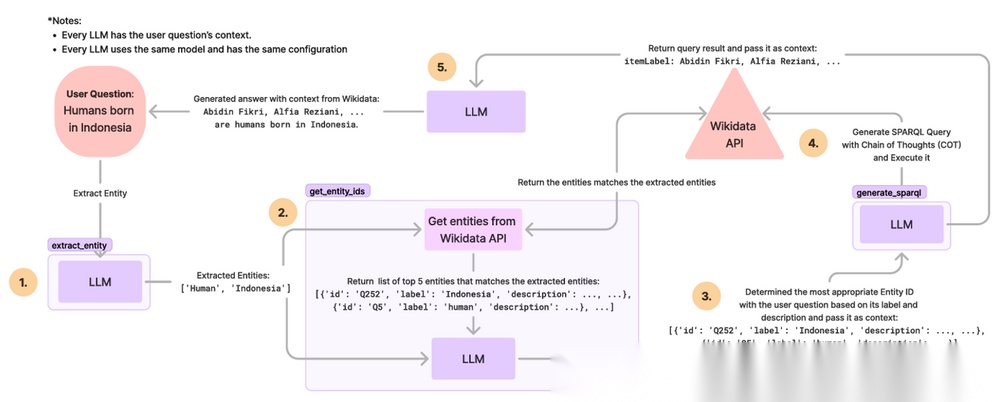

(1)Pipeline v1:全LLM-驱动初步问答流程

-

步骤一:实体抽取

——LLM定位用户提问中的核心实体。

-

步骤二:实体ID检索

——依据关键词对Wikidata API进行检索,返回Top5候选。

-

步骤三:实体消歧与选择

——基于问题和实体描述让LLM判定最相关实体。

-

步骤四:SPARQL生成

——用LLM生成SPARQL查询,辅助参考Wikidata常用属性Top100表。

-

步骤五:查询执行与自然语言生成

——SPARQL拉取数据,最后由LLM生成可读答案。

Pipeline v1系统架构图(Gambar 1)

Pipeline v1系统架构图(Gambar 1)

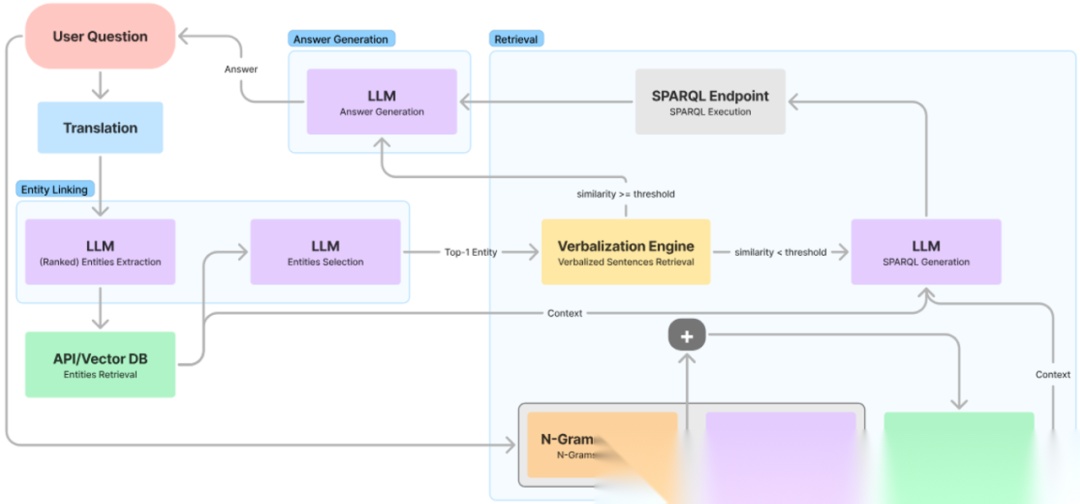

(2)Pipeline v2:多语言/多KG升级流程

在v2架构中,系统不仅支持多语言,还引入矢量数据库辅助属性、类别检索,解决大规模资源prompt膨胀问题,并提升“单跳问答”场景的准确性。

-

问题翻译管理

非英文自动转英文,保证与KG的兼容性。

-

实体链接

综合实体抽取、KG检索和消歧。用few-shot prompting辅助多轮判别。

-

检索流程

-

单跳问题

先用KG实体邻居Verbalisaton检索(如“{实体}的{属性}是{值}”),如未达标再转为LLM驱动SPARQL生成。

-

复杂/多跳问题

切分问题,先用语义检索筛选合适属性和类别,再用few-shot+CoT方式生成SPARQL。

-

答案自然化

取回结果ID/URI后补充为可理解标签,用LLM生成符合用户原语言的流畅答案。

Pipeline v2系统架构图(Gambar 2)

3. 支持的知识库(KGs)

-

Wikidata

:结构RDF,SPARQL接口,实体与属性支持批量矢量检索。

-

DBpedia

:Wikipedia结构化衍生KG,主要用其T-Box本体。

-

Curriculum KG

(本地企业KG示例):信息来源于印尼大学课程规划材料,涵盖课程/先修/能力等多个实体,通过半自动脚本从教材生成三元组数据。

4. 数据集与问答生成

-

QALD-9-Plus

:多语言KG-QA基准(10种语言),用于Wikidata、DBpedia评测,含训练/测试两部分。

-

KG自生成问答数据

:通过实体采样、KG随机游走、资源标签补充、SPARQL模版和LLM自动改写自然语言,半自动产生面向本地KG的数据集。

[表格引用:问答模板类型表(Tabel 1)]

| 类别 | 三元组模式 |

|---|---|

| Simple 1 | { s p ?o } |

| Simple 2 | { ?s p o } |

| Complex 1 | { ?s p1 o1 . ?s p2 o2 } |

| Complex 2 | { ?s p1 ?o1 . ?o1 p2 o2} |

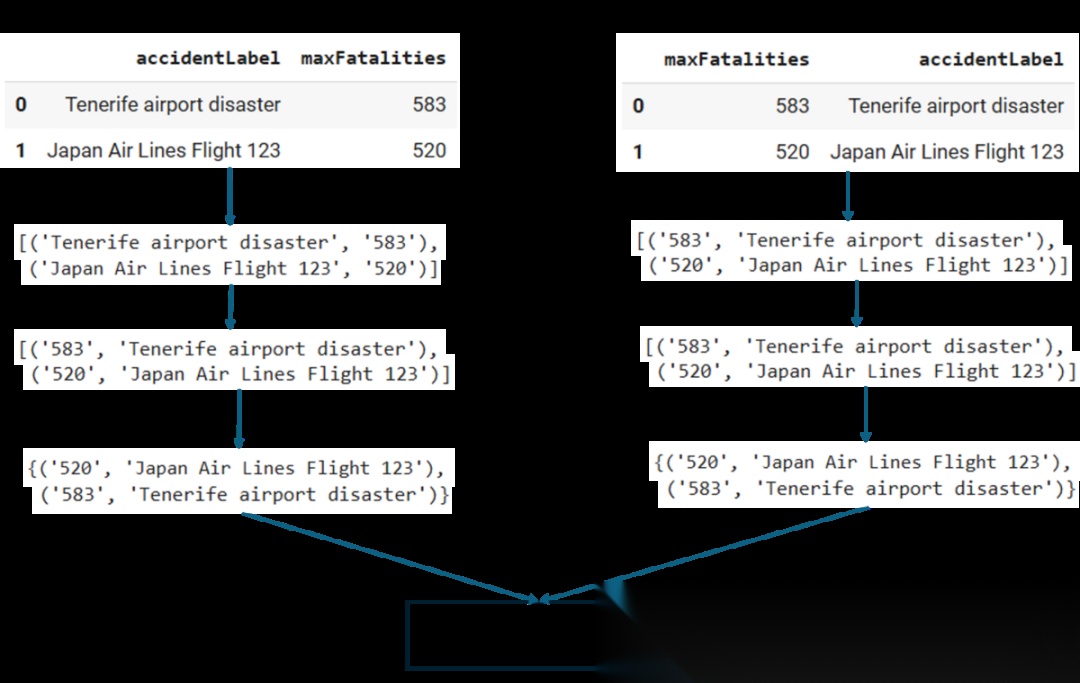

5. 评价方法

-

主指标:Jaccard相似度

——考察Pipeline生成SPARQL和“标准答案”结果的集合重叠程度,不受返回条目顺序影响。

-

执行SPARQL后对元组排序统一化处理,确保公平比对。

Jaccard相似度评测流程图(Gambar 3)

四、关键实验与结果分析

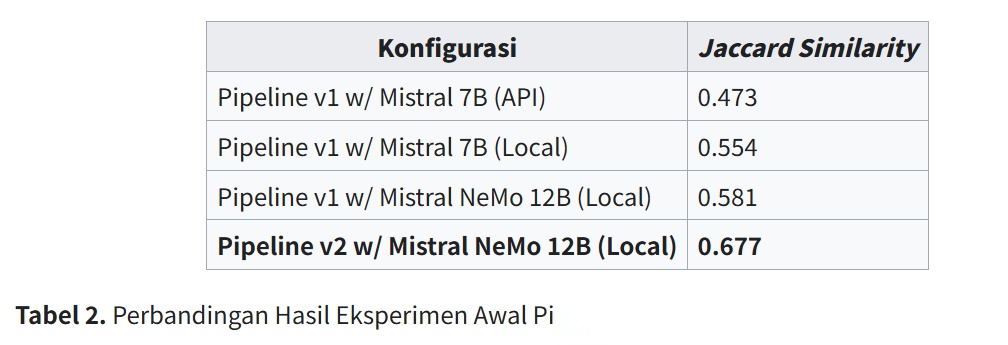

1. 不同Pipeline与模型对比

- 实验比较了两版Pipeline结合三种主流模型的表现:

- Pipeline v1+Mistral 7B(API):0.473

- Pipeline v1+Mistral 7B(本地):0.554

- Pipeline v1+Mistral NeMo 12B(本地):0.581

- Pipeline v2+Mistral NeMo 12B(本地):0.677

相关表格引用:Pipeline v1/v2性能对比表(Tabel 2)

Pipeline v2明显优于v1,证明了升级后的检索和属性识别机制对准确率提升意义重大。

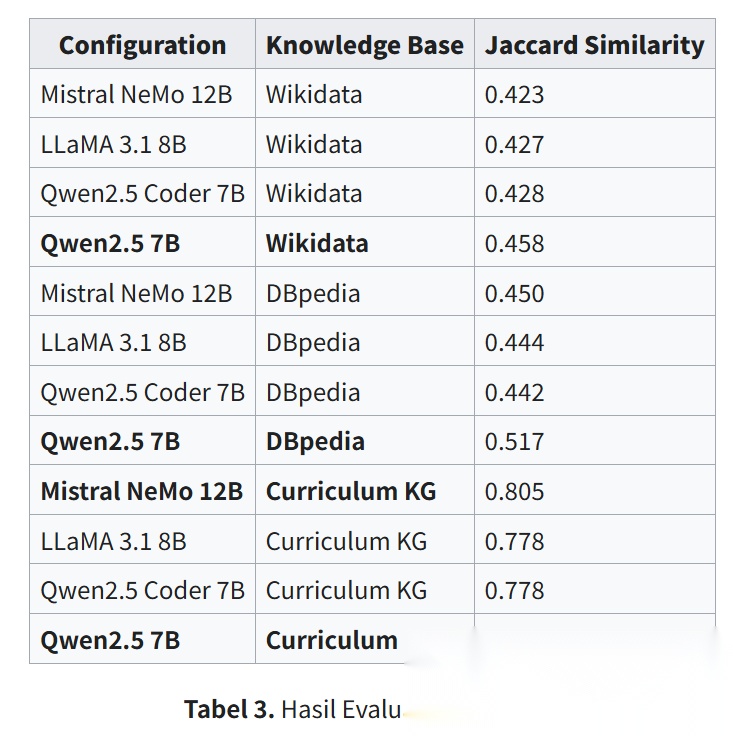

2. 多KG/多模型综合评估

- Wikidata/DBpedia/本地KG(Curriculum KG)上四大模型评测:

-

Wikidata: 0.458

-

DBpedia: 0.517

-

Curriculum KG: 0.805(与Mistral NeMo 12B持平)

-

Qwen2.5 7B 在所有数据集表现最好,如:

各模型各KG表现(Tabel 3)

- 多语言初测(印尼语):存在准确率下降(0.362),归因于机器翻译导致的语义偏移,但系统多语言能力得到基本验证。

- Qwen2.5 7B表现优异,得益于预训练语料规模达18万亿token,对语言和事实理解更深,而Qwen2.5 Coder 7B(面向代码任务)表现偏低。

3. Ablation Study(组件贡献消融分析)

-

Ontology Retrieval

(本体属性检索):影响最大,删除后准确率大幅滑坡。Curriculum KG从0.805→0.183,若再去verbalisaiton降为0。

-

Few-Shot Examples

(小样本示例):删除后Wikidata/DBpedia/Curriculum KG分别下降显著,需保留以辅助LLM跨领域迁移。

-

Verbalization

(属性三元组口语化):复杂KG(Wikidata)上提升大,简洁KG(Curriculum KG)反而影响负向(甚至去除提升到0.949)。

-

Chain-of-Thought(CoT)

:复杂KG效果好,在单纯KG场景益处有限,甚至略降。

五、结论与发展建议

1. 主要结论

-

成功开发了FrOG:基于KG的开源RAG系统,并通过两版管线验证技术路线。

-

Pipeline v2 + Qwen2.5 7B

达到最优:Wikidata 0.458、DBpedia 0.517、Curriculum KG 0.976,已具多语言初步能力。

-

组件中**本体检索(ontology retrieval)**最为核心,小样本示例同样不可或缺。

-

Verbalisaton与CoT可针对不同KG灵活配置。

2. 后续建议

- 深化LLM微调以提升SPARQL生成专用能力。

- 提升系统对中文等亚洲语言本地化支持。

- 拓展更大规模LLM与高效推理优化。

- 动态启用属性verbalisaiton(引入适应性分类器)。

- 采用Jena、GraphDB等持久化KG后端以增强系统扩展性与鲁棒性。

六、相关成果与资源分享

-

开源代码仓库

:Github - FrOG框架

-

主要学术论文

-

Towards an Open NLI LLM-based System for KGs: A Case Study of Wikidata

,已在2024年ISRITI会议发表。

-

FrOG: Framework of Open GraphRAG

2025年欧洲语义网大会(ESWC)分会已接收。

如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

更多推荐

已为社区贡献113条内容

已为社区贡献113条内容

所有评论(0)