通过 Anything LLM + ollama实现本地部署大模型并外挂本地知识库(可实现本地 api 调用大模型)

ollama+Anythingllm 实现本地部署大模型以及挂载本地知识库并实现业务系统 API 调用

·

-

通过 ollama 官网下载并安装自己机器对应的版本

https://ollama.com/

-

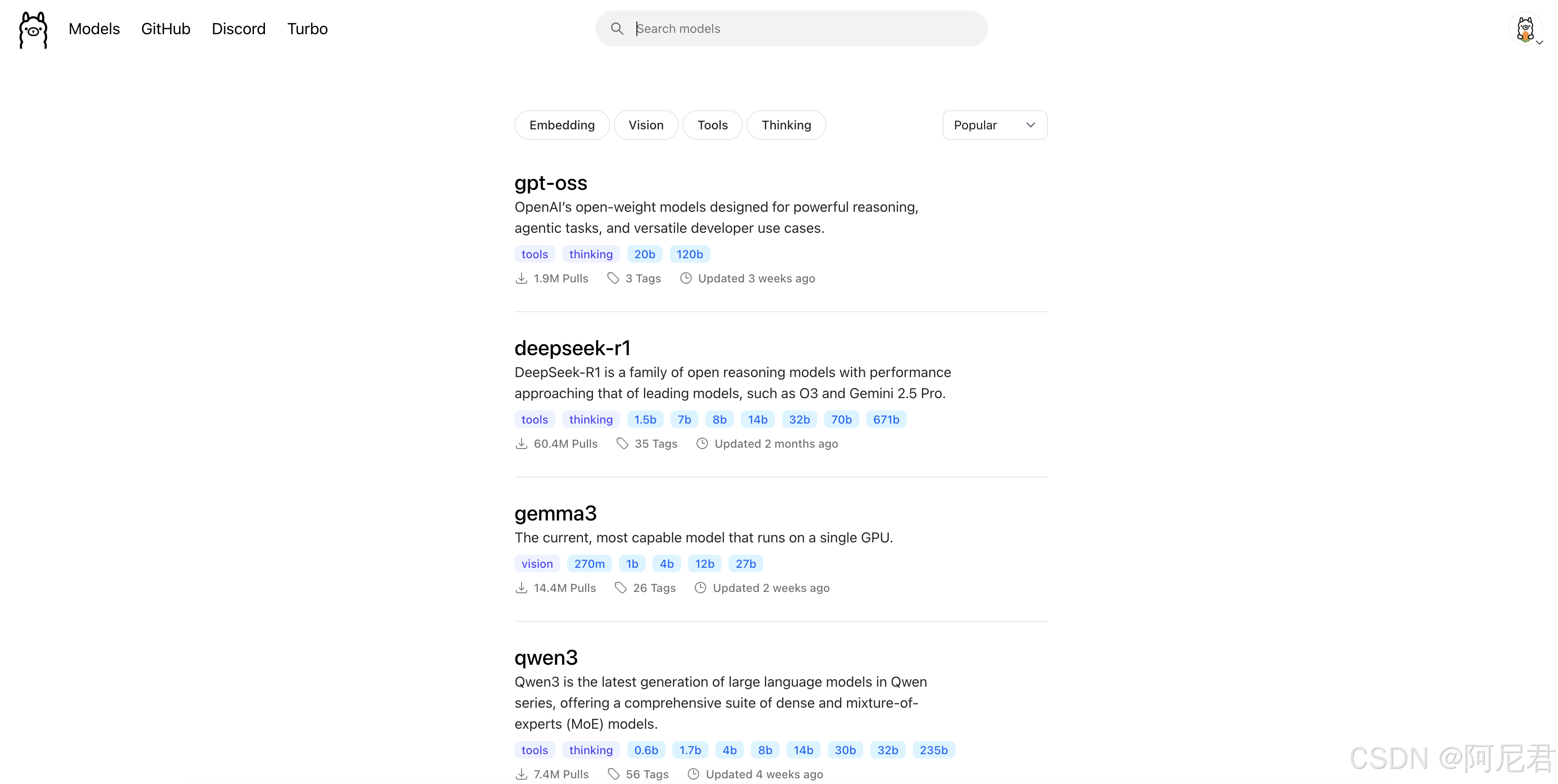

在 ollama 官方模型库找到自己想要部署的模型

https://ollama.com/search

-

本地安装好 ollama 后下载模型

下载:

ollama pull deepseek-r1

启动

ollama run deepseek-r1

- 到 Anythink LLM 官网下载对应机器的安装包

https://anythingllm.com/

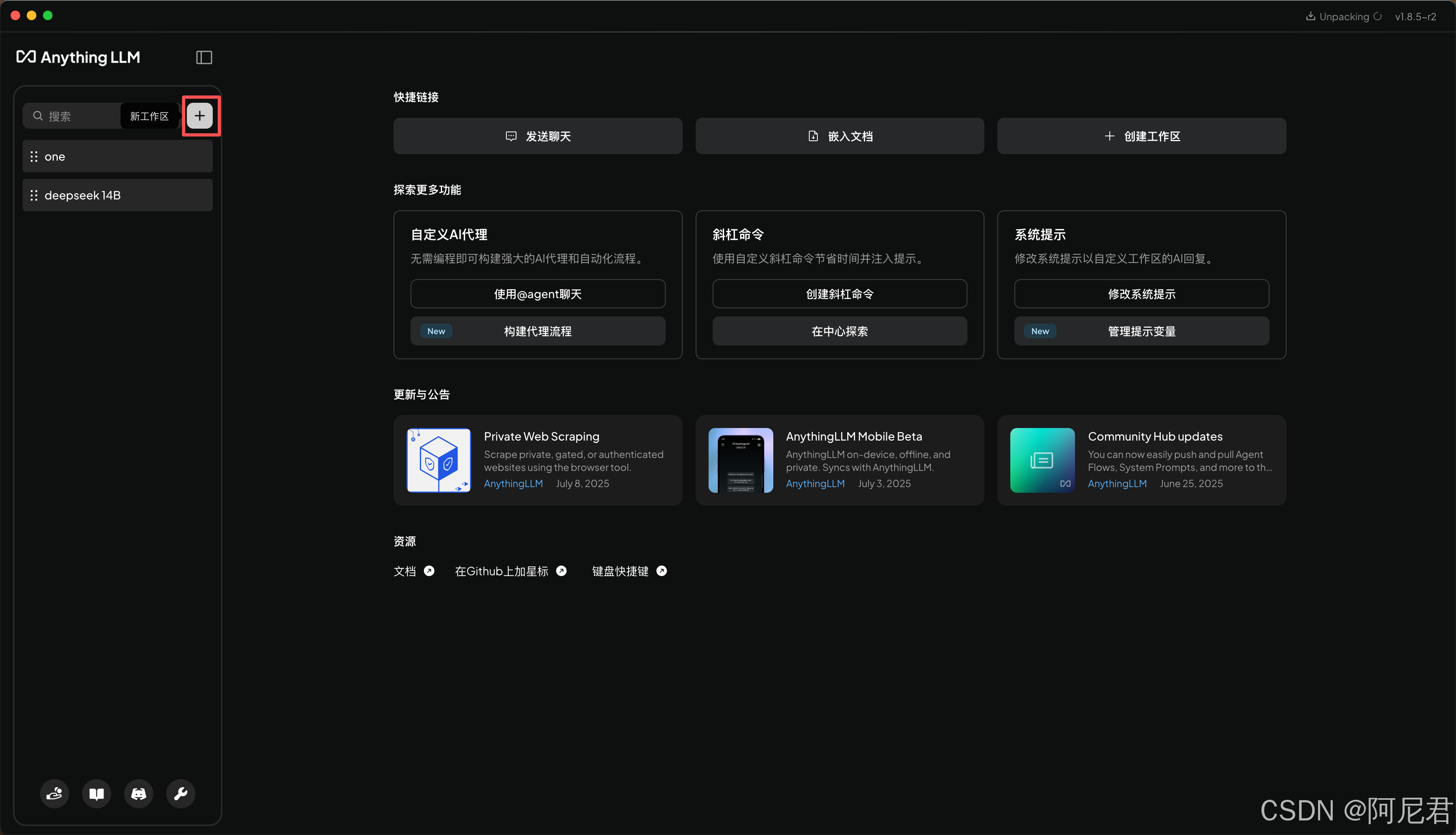

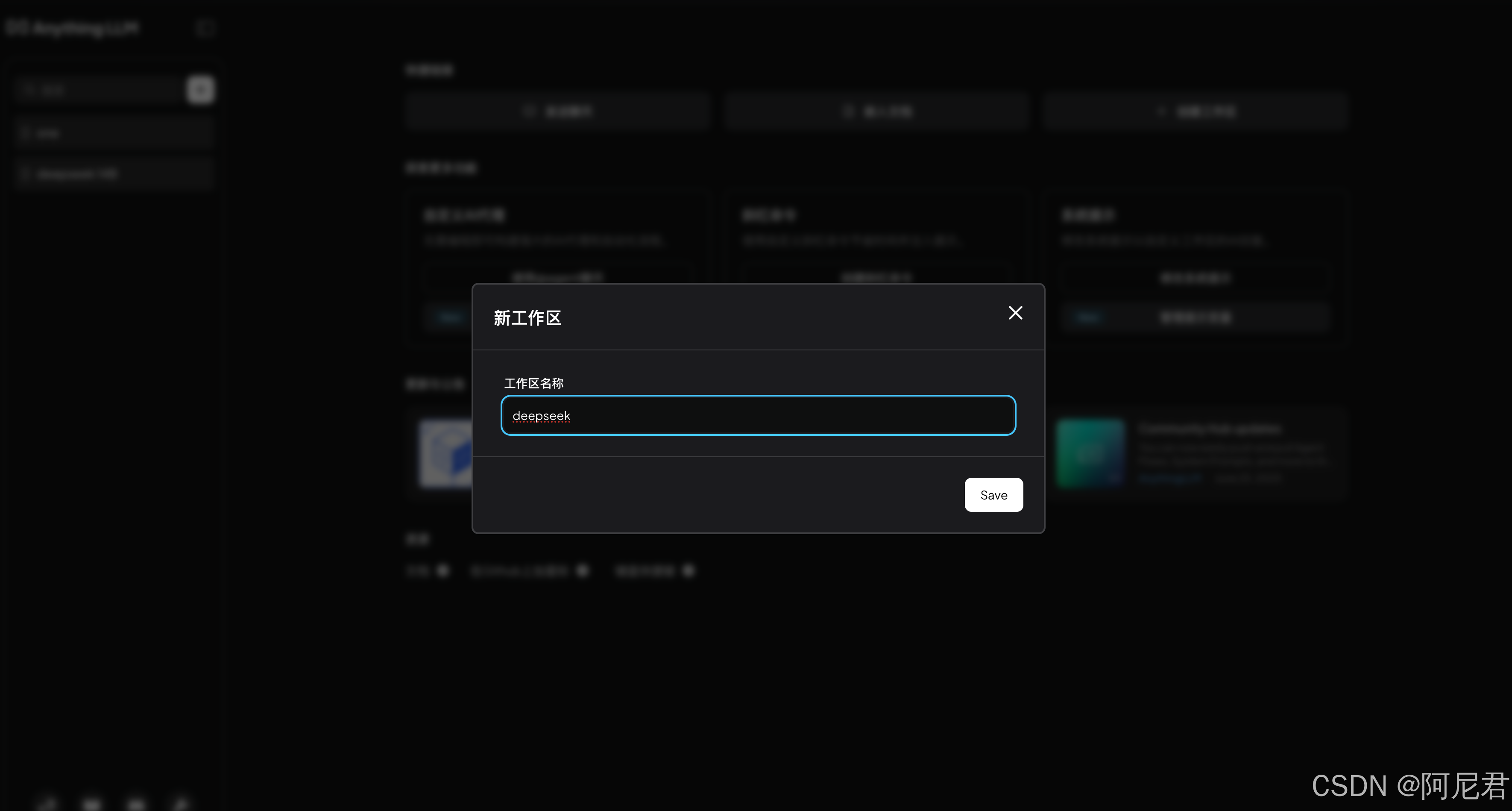

- 打开 AnythinkLLM 并创建工作区

- 设置工作区

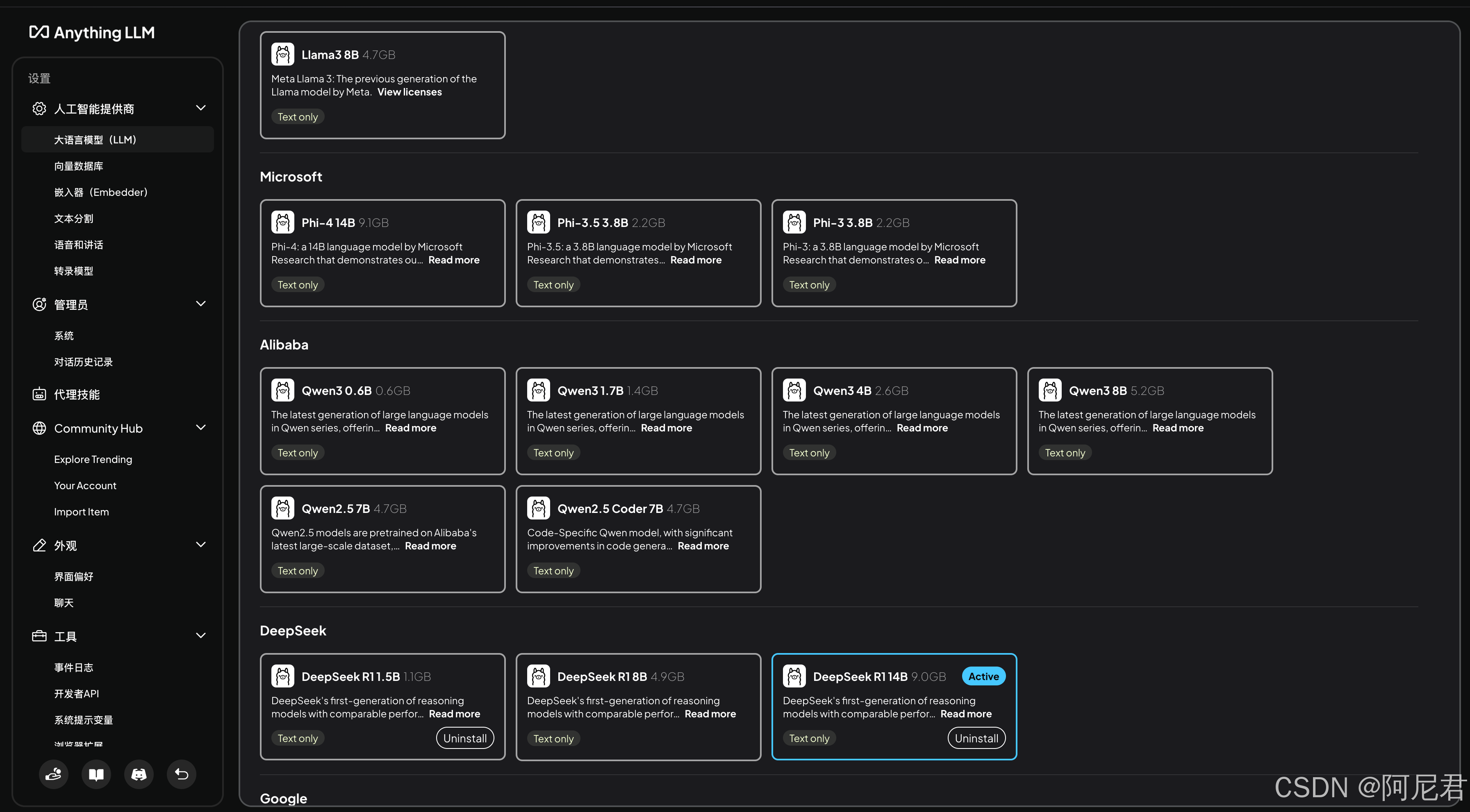

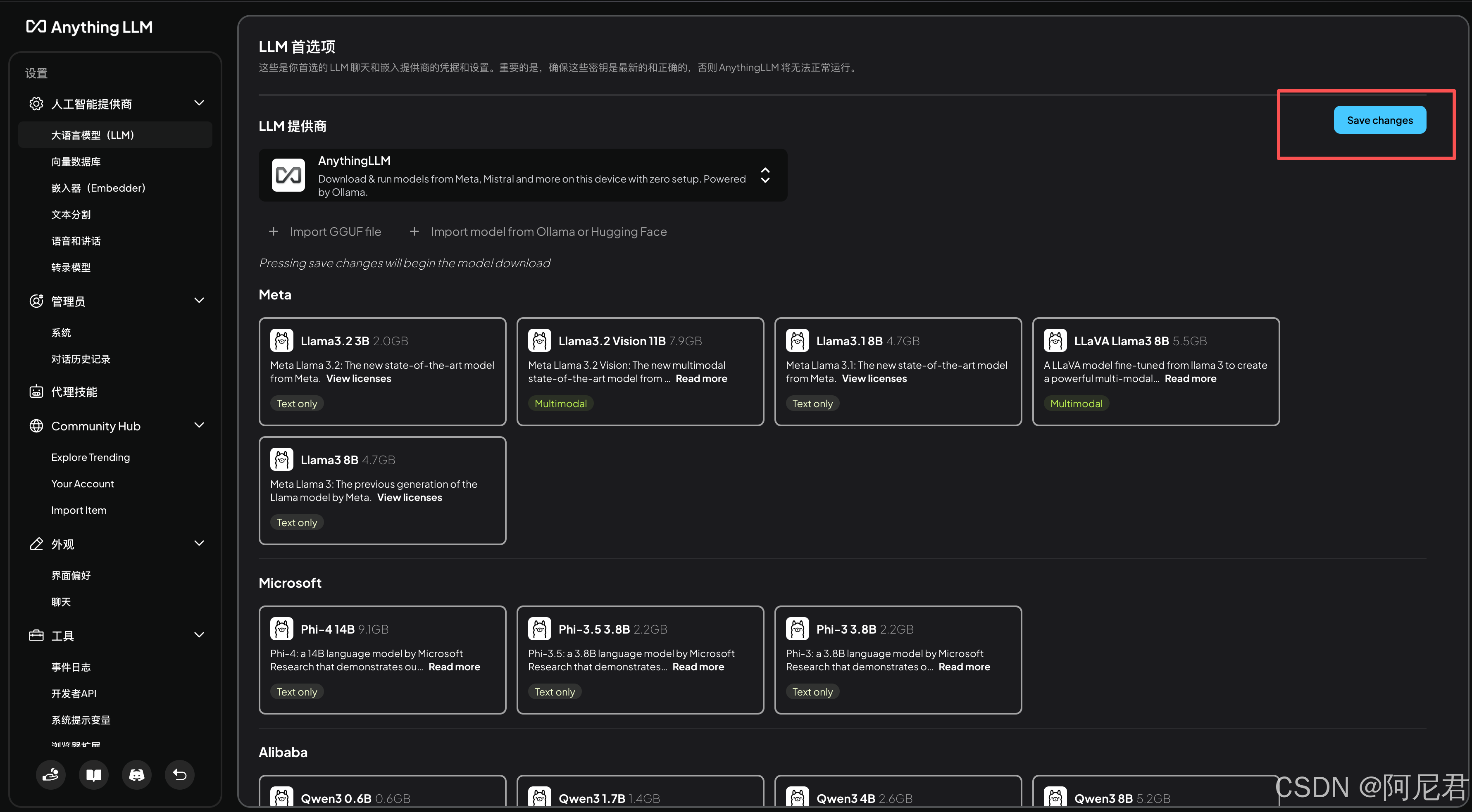

- 配置并下载大模型

选择好之后点击 Save changes 后台就会自动下载模型

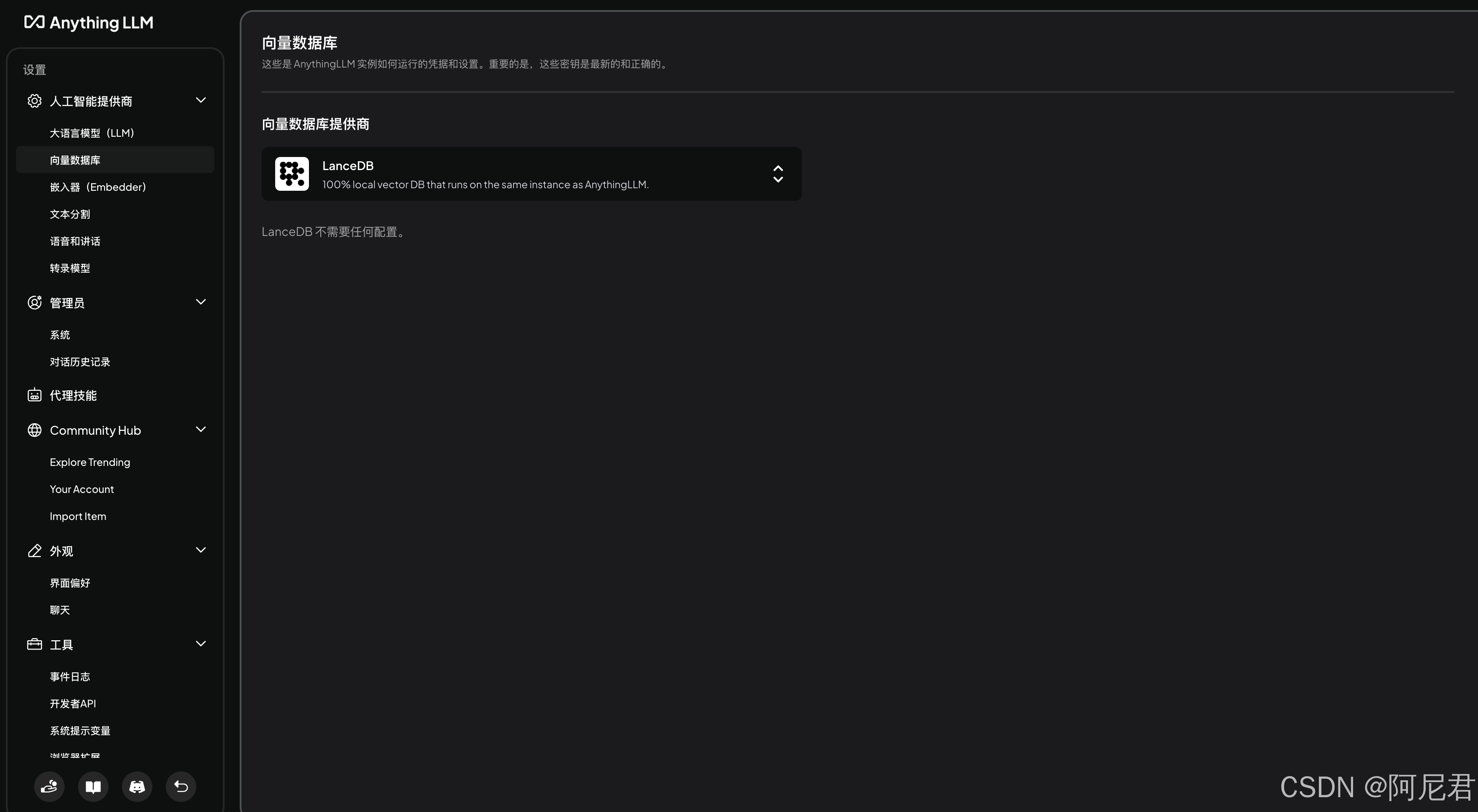

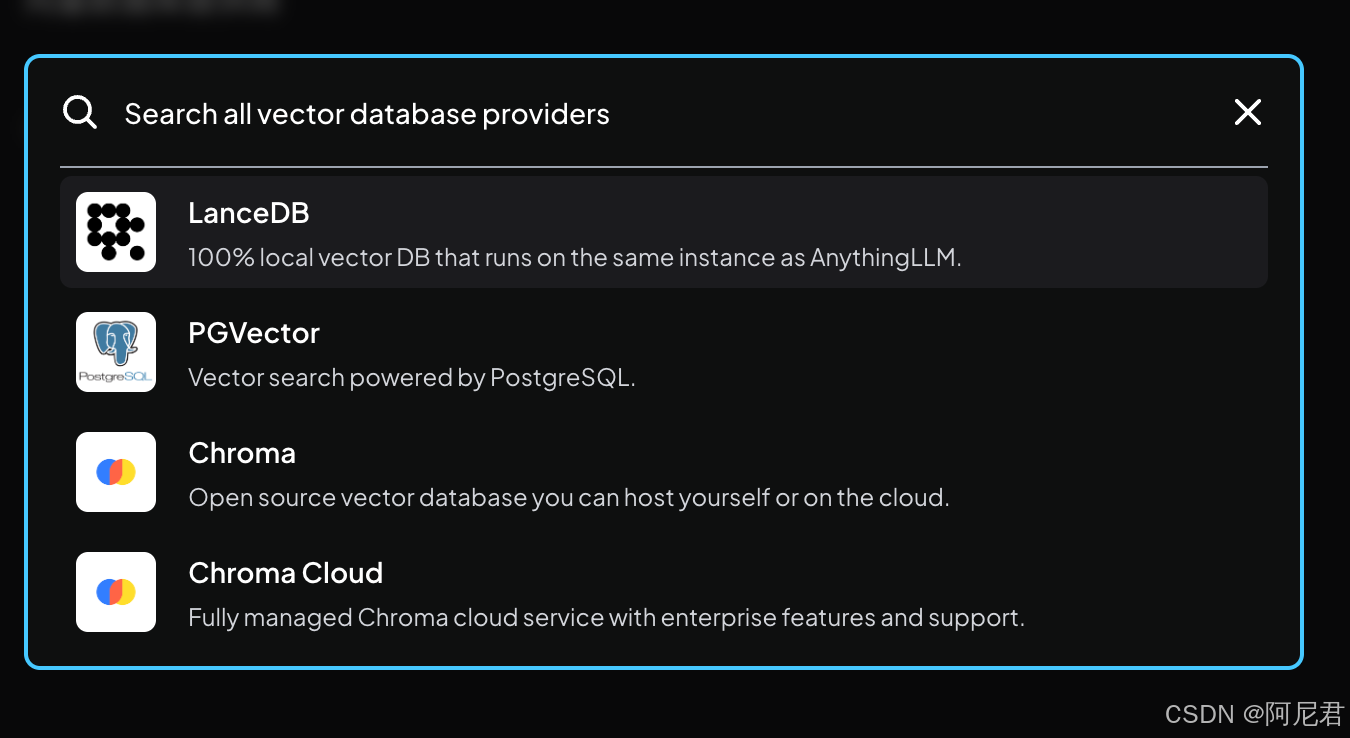

- 配置向量数据库

我这来选择的是系统默认的 LanceDB(实测效果还行)

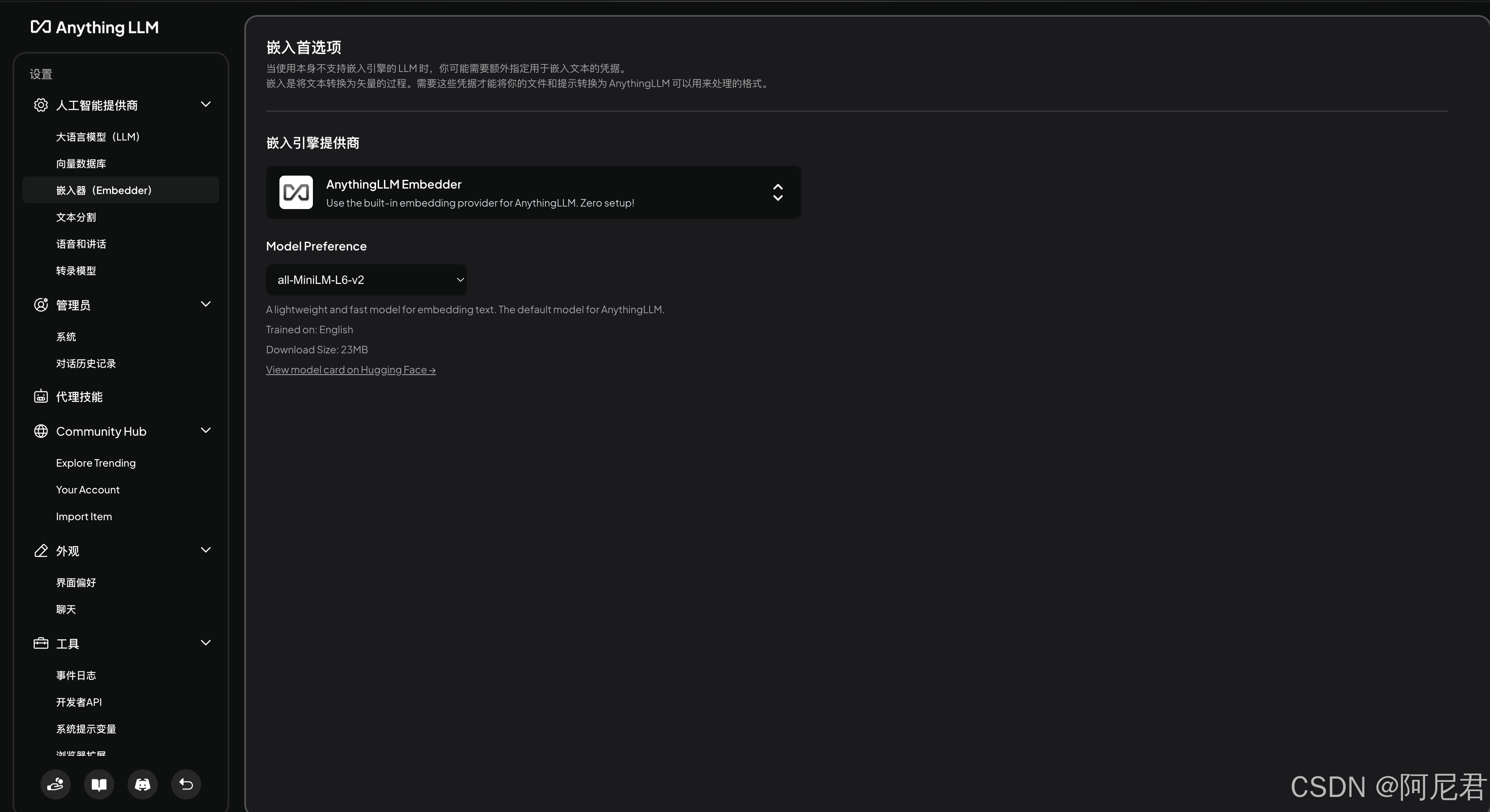

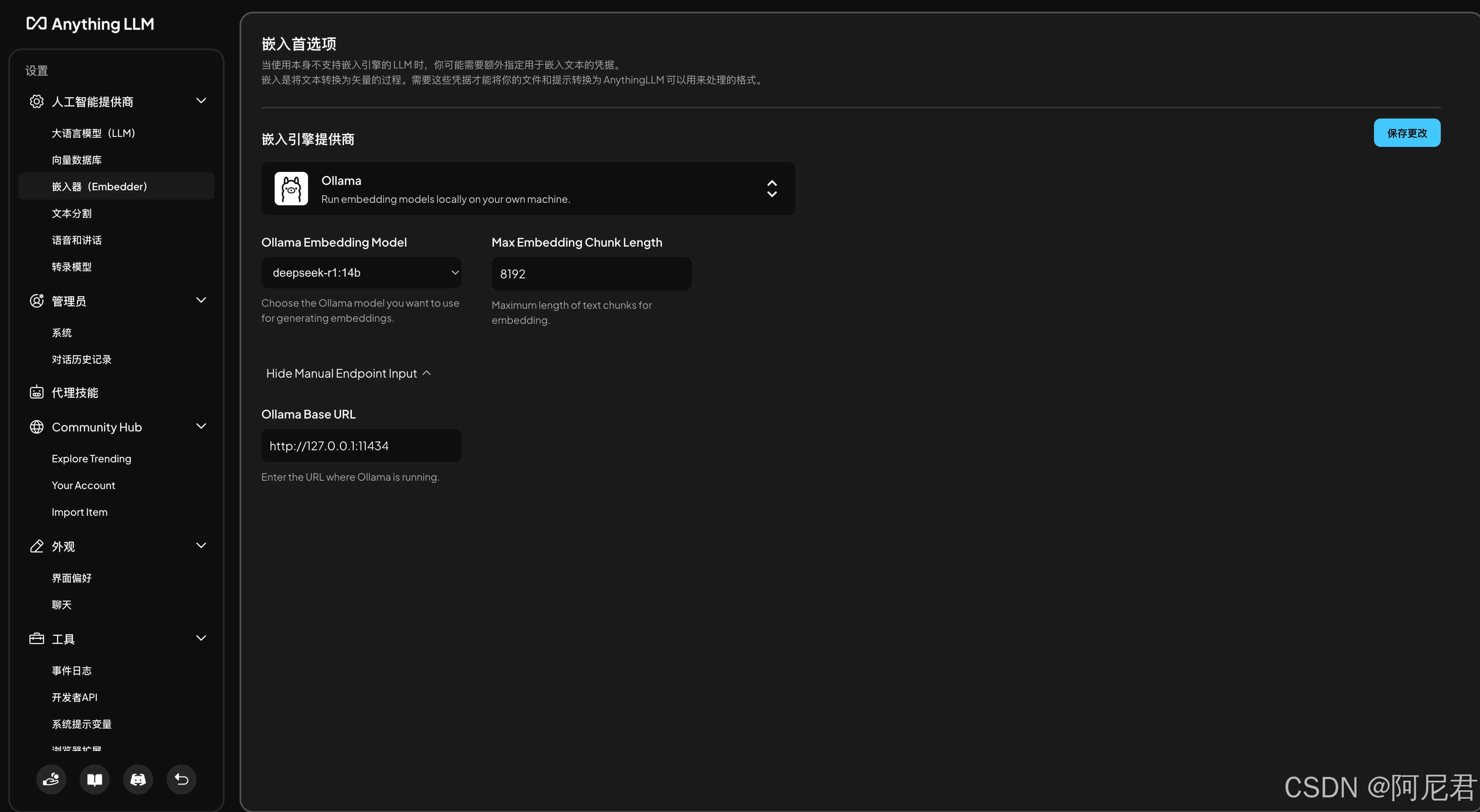

- 配置嵌入器

我这里选择的是ollama(我测试了多个,效果基本大差不差)

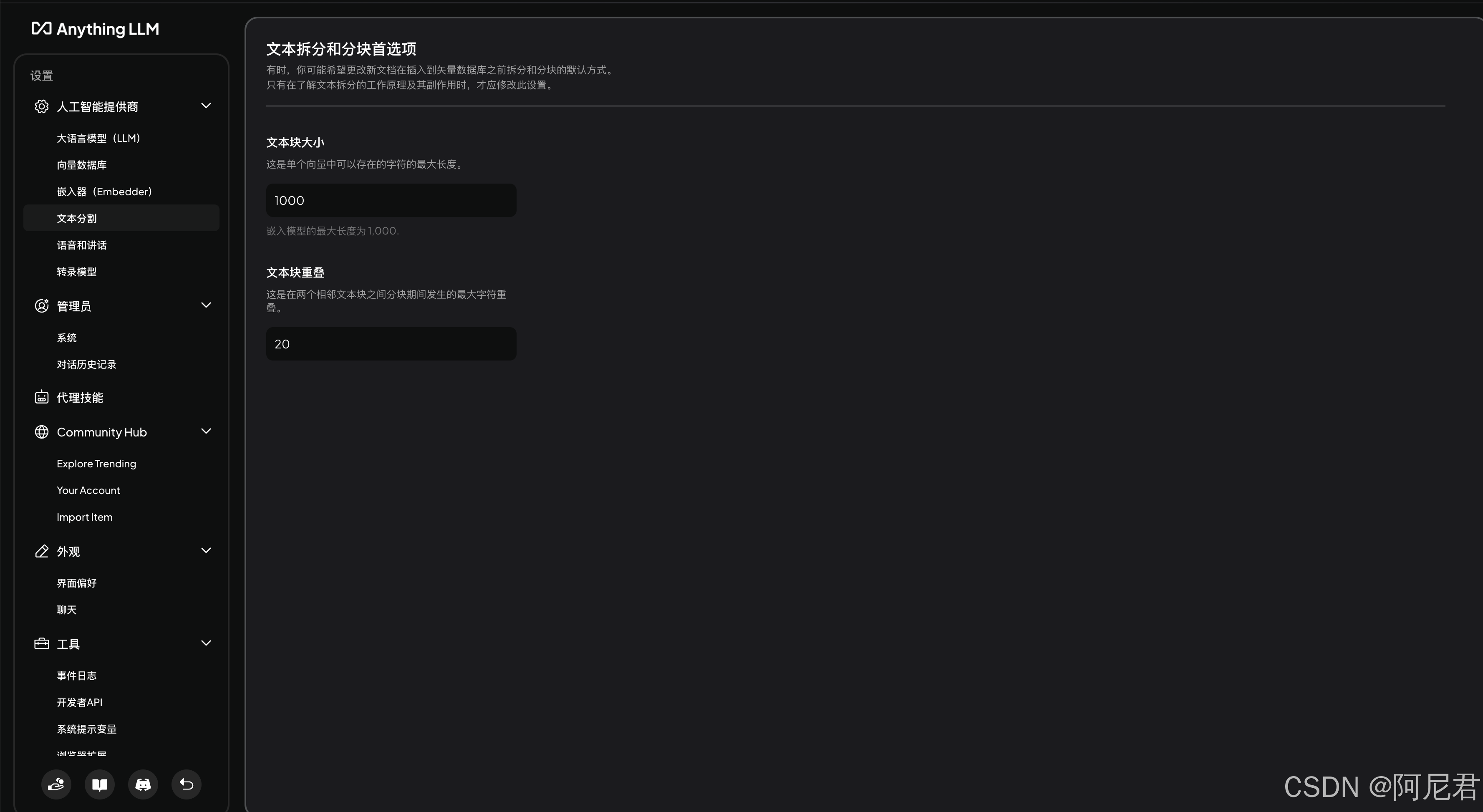

- 配置文本分割(如果没有特殊需求,无需改动)

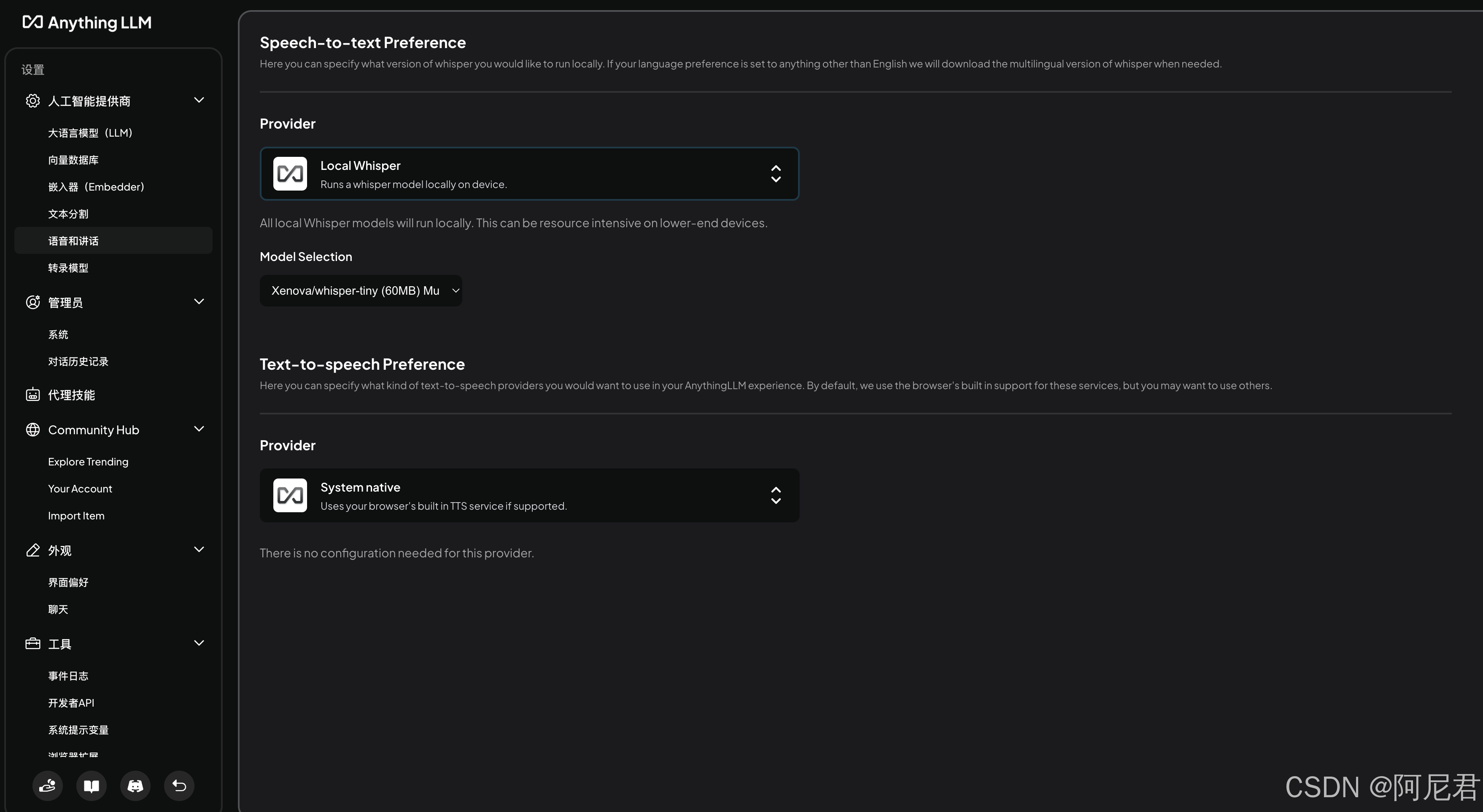

- 配置语音(如果有业务需求的情况下)

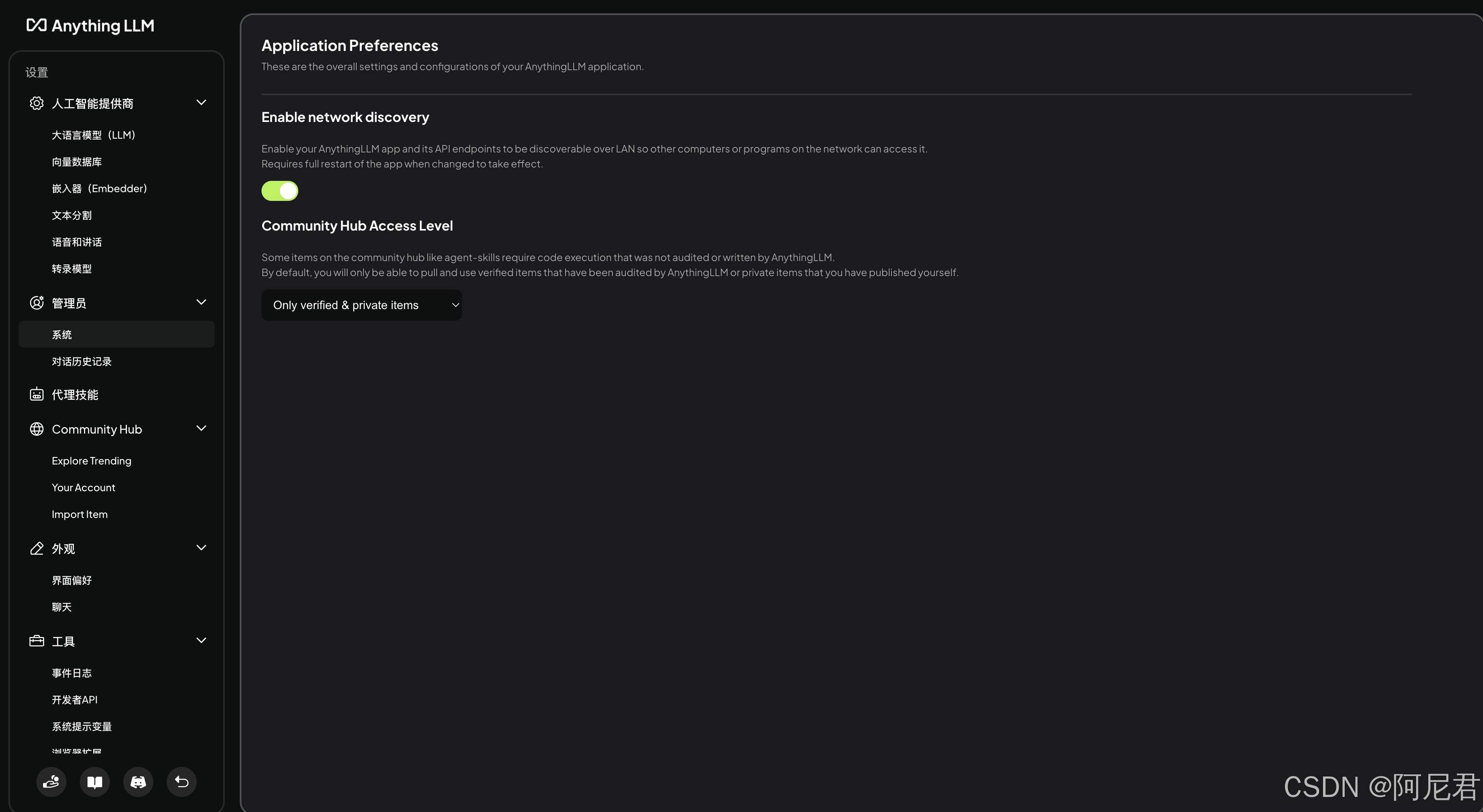

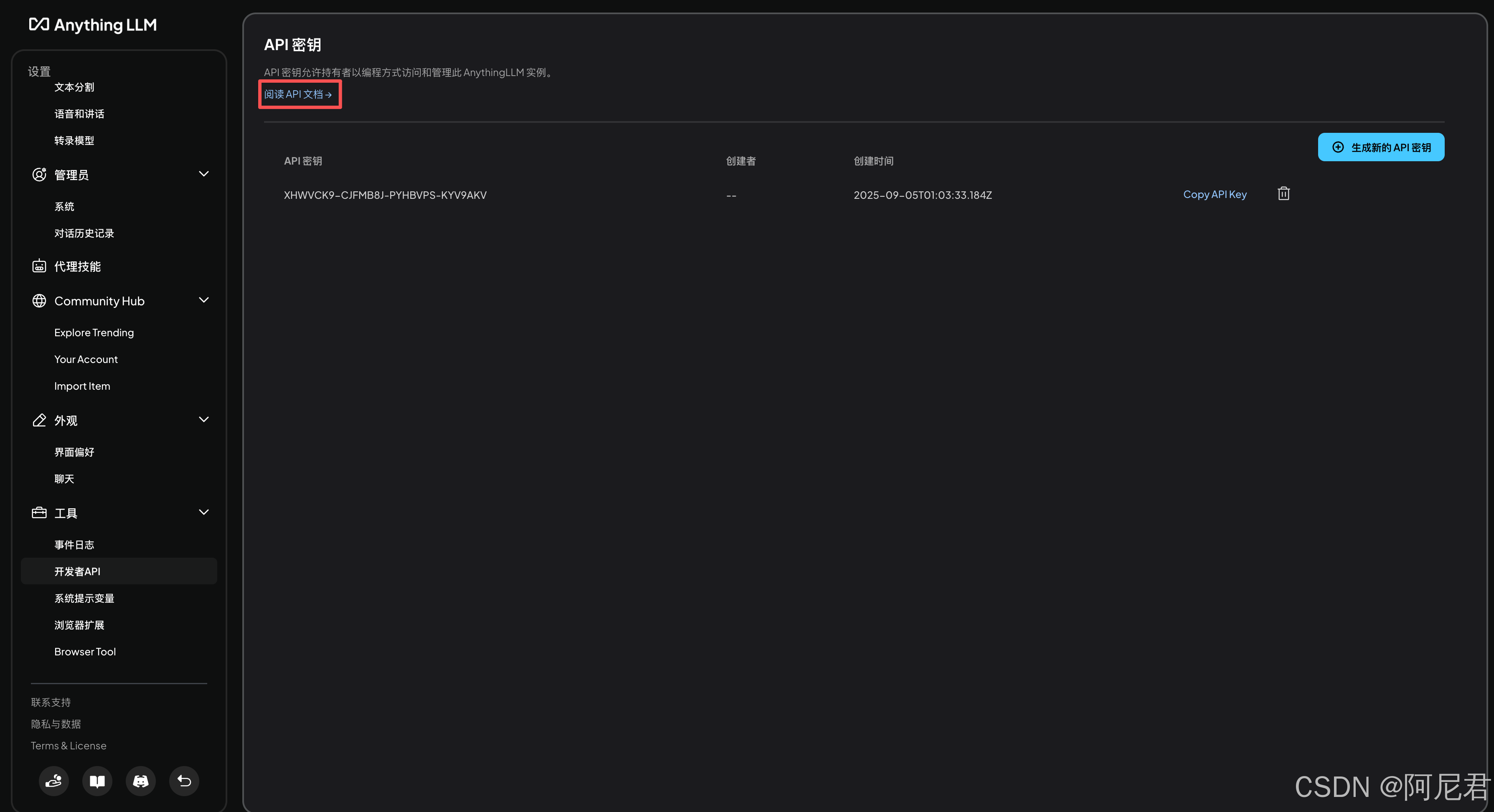

- 打开本地 API 开关(后面业务系统调用模型API时需要用到)

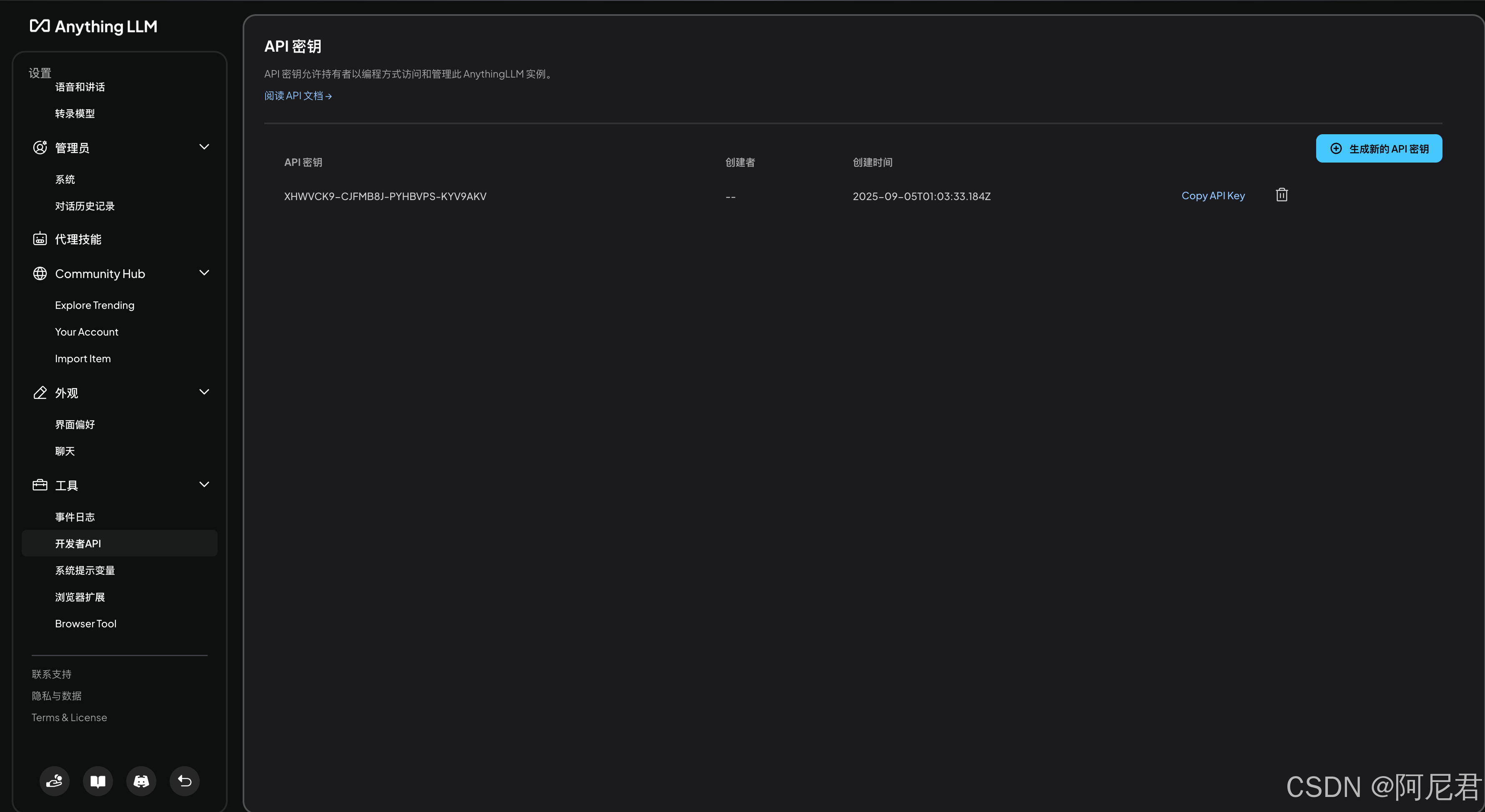

- 生成接口调用 APIKey(后面业务系统调用模型API时需要用到)

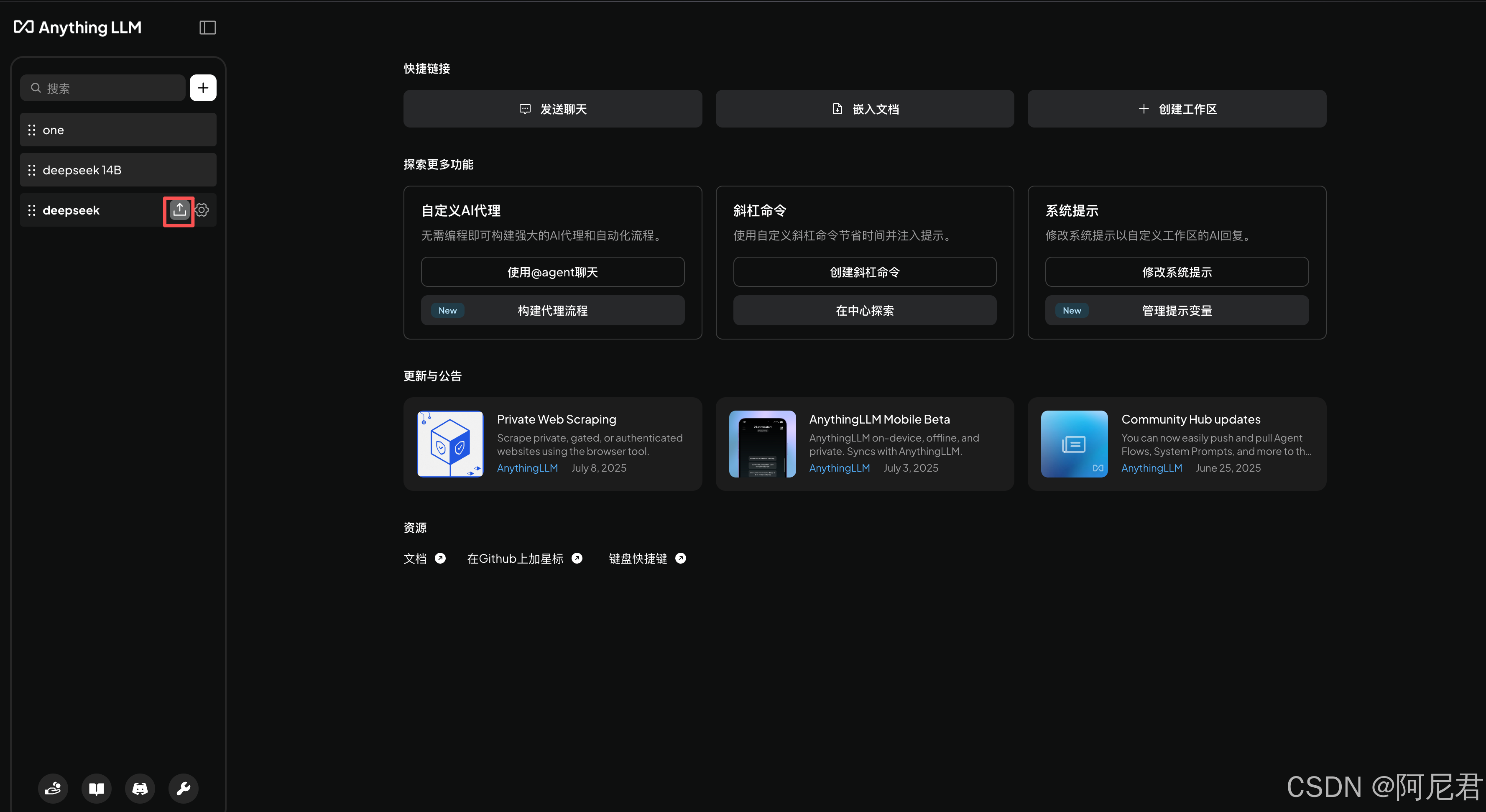

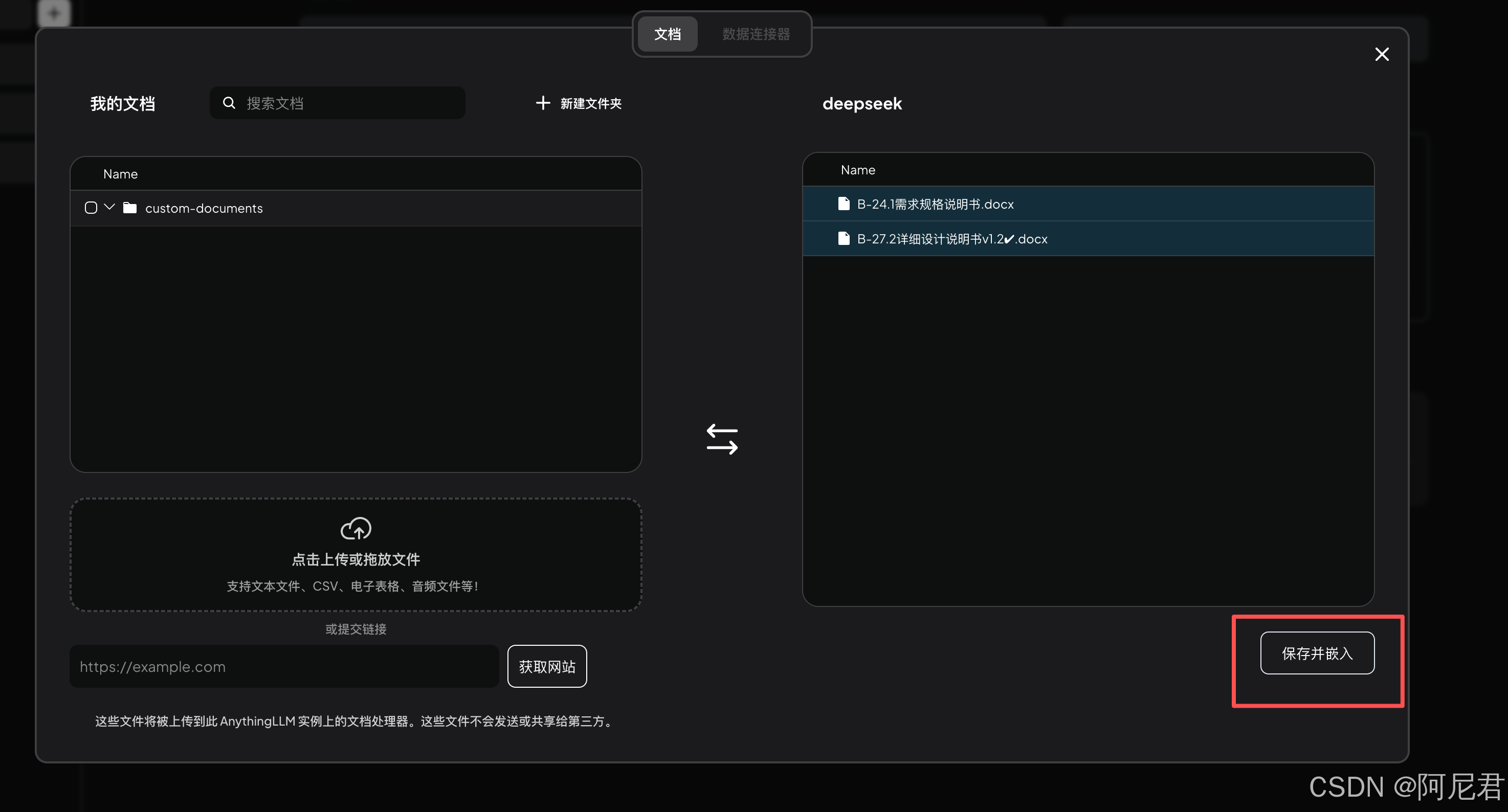

- 返回主界面上传本地知识库文件

- 让模型挂载知识库文件

- 打开聊天界面测试知识库挂载

如果知识库索引成功并且成功引用到知识库文件,那么左下角就会出现一个显示引文的按钮,点击可以查看具体引用的是哪个文档!

进行到这里,恭喜你,已经成功一大半了!

接下来就是比较繁琐的 API 调用了

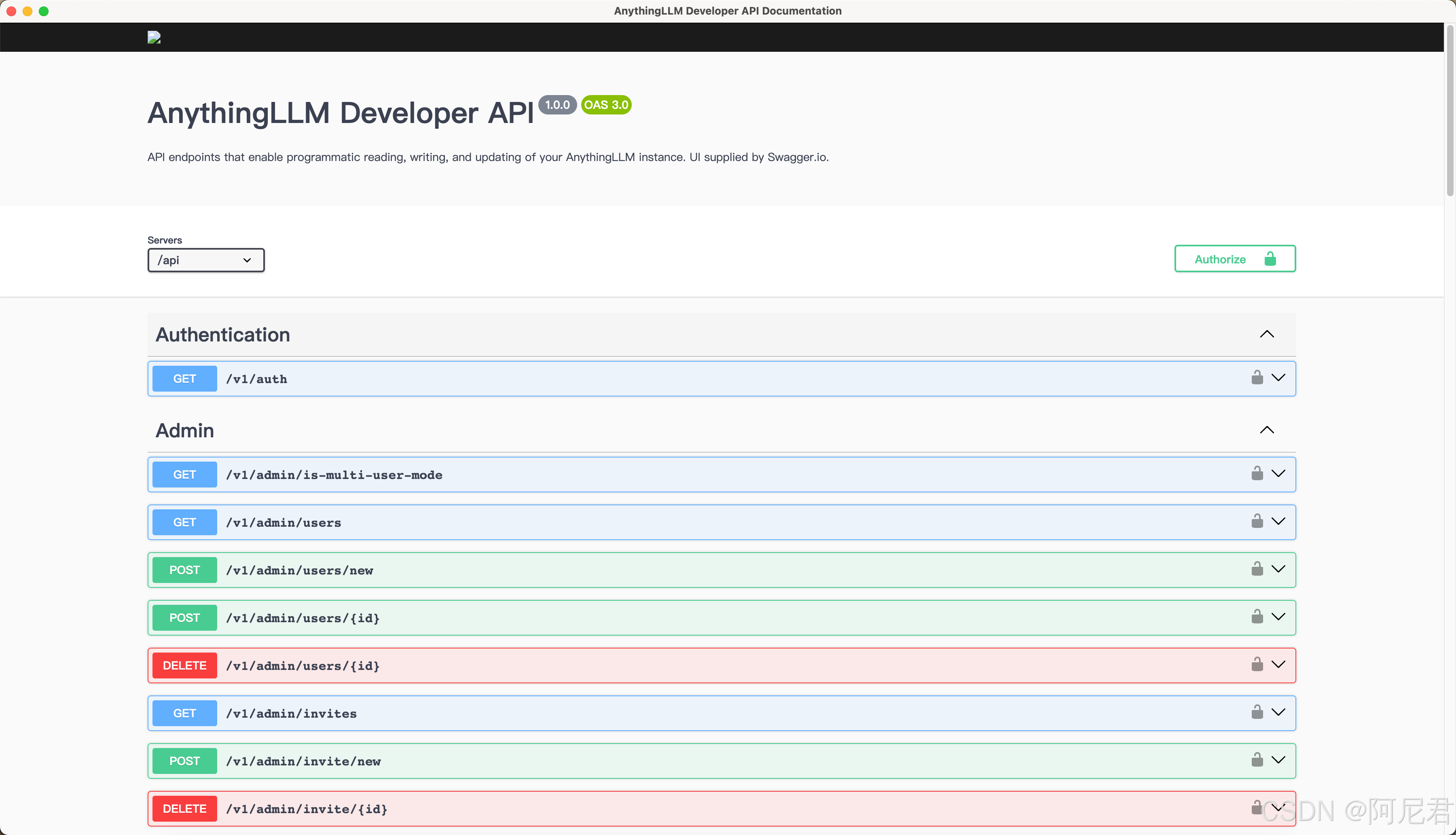

- 返回设置页面,仔细查看阅读 API 文档

熟悉的 swagger 接口页面

接下来就可以根据自己用到的实际开发需求以及业务功能来合理调用相应的 API,

例如:

- 获取工作区

- 创建用户

- 获取用户相关信息

- 上传知识库文档

- 获取知识库文档

- 移除知识库

- 创建工作区

- 发起聊天

- 发起聊天(流式传输)用户体验会更好

- 发起新的聊天

- 系统设置

- 导出聊天信息

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)