【AI论文】SimpleTIR:面向多轮工具集成推理的端到端强化学习

摘要:本研究针对大语言模型在多轮工具集成推理(TIR)中的训练不稳定问题,提出SimpleTIR算法。通过分析发现训练不稳定性源于外部工具反馈导致的分布偏移和低概率标记累积,进而引发梯度爆炸。SimpleTIR采用轨迹过滤机制,识别并剔除包含无效轮次(未生成代码或最终答案)的轨迹,有效阻断有害梯度。实验表明,该算法在数学推理任务上表现优异,将AIME24分数从22.1提升至50.5,同时促进模型发

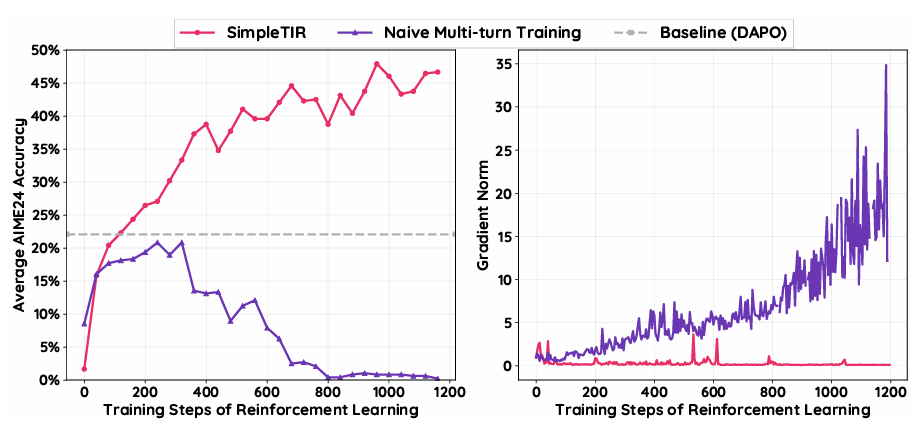

摘要:大语言模型(LLMs)通过与外部工具交互可显著提升推理能力,这一范式被称为工具集成推理(Tool-Integrated Reasoning,TIR)。然而,当利用强化学习(Reinforcement Learning,RL)将TIR扩展至多轮场景时,训练不稳定性和性能崩溃问题常成为阻碍。我们发现,这种不稳定性主要由外部工具反馈引发的分布偏移导致,进而产生低概率标记(token)。这一问题在连续多轮中不断累积,引发灾难性的梯度范数爆炸,最终导致训练过程失控。为应对这一挑战,我们提出SimpleTIR——一种即插即用的算法,可稳定多轮TIR训练。其核心策略是识别并过滤包含无效轮次的轨迹(即既未生成代码块也未给出最终答案的轮次)。通过在策略更新中移除这些存在问题的轨迹,SimpleTIR有效阻断了有害的高幅值梯度,从而稳定了学习动态。大量实验表明,SimpleTIR在具有挑战性的数学推理基准测试中取得了最优性能,特别是在以Qwen2.5-7B基础模型为起点时,将AIME24分数从纯文本基线的22.1显著提升至50.5。此外,通过规避监督微调的限制,SimpleTIR鼓励模型发现多样化且复杂的推理模式,例如自我修正和交叉验证。Huggingface链接:Paper page,论文链接:2509.02479

研究背景和目的

研究背景:

随着大型语言模型(LLMs)的快速发展,其在自然语言处理(NLP)领域的应用日益广泛。然而,传统的LLMs主要依赖于静态的文本生成和理解能力,缺乏在动态、交互式环境中进行多轮推理和决策的能力。特别是在需要外部工具辅助的复杂任务中,如数学推理、代码生成和问题解答等,LLMs往往难以直接给出准确且全面的答案。为了解决这一问题,工具集成推理(Tool-Integrated Reasoning, TIR)作为一种新兴范式应运而生,它允许LLMs通过与外部工具(如计算器、搜索引擎、代码解释器等)进行交互,从而增强其推理和决策能力。

然而,将TIR扩展到多轮场景时,使用强化学习(RL)进行训练往往会遇到训练不稳定和性能崩溃的问题。这主要是由于外部工具反馈引起的分布偏移导致低概率标记的生成,这些低概率标记在连续多轮交互中不断累积,最终引发灾难性的梯度范数爆炸,破坏训练过程。因此,如何设计一种稳定且高效的多轮TIR训练方法,成为当前研究的重要挑战。

研究目的:

本研究旨在提出一种名为SimpleTIR的端到端强化学习框架,以解决多轮工具集成推理中的训练不稳定问题。具体目标包括:

- 稳定性提升:通过引入轨迹过滤机制,识别并过滤掉包含“无效轮次”(即既不生成代码块也不生成最终答案的轮次)的轨迹,从而防止低概率标记引起的梯度爆炸,稳定训练过程。

- 性能优化:在保证训练稳定性的同时,提升模型在多轮TIR任务中的推理性能,特别是在数学推理等复杂任务上的表现。

- 探索多样化推理模式:鼓励模型在训练过程中发现多样化和复杂的推理模式,如自我纠正和交叉验证,从而增强模型的泛化能力和适应性。

研究方法

本研究采用了以下方法来实现上述研究目的:

- 问题分析:

- 识别关键问题:通过理论分析和实验验证,确定多轮TIR训练中不稳定性的根源在于外部工具反馈引起的分布偏移和低概率标记的累积。

- 构建问题模型:将多轮TIR训练过程建模为分层马尔可夫决策过程(Hierarchical Markov Decision Process, HMDP),其中高层次策略控制对话轮次的顺序,低层次策略在每个轮次内生成标记。

- 算法设计:

- 引入轨迹过滤机制:设计SimpleTIR算法,通过识别并过滤掉包含无效轮次的轨迹,防止低概率标记进入梯度计算,从而稳定训练过程。

- 联合策略优化与反馈掩码:采用Group Relative Policy Optimization (GRPO)算法进行策略优化,并通过反馈掩码技术确保仅对智能体生成的标记进行梯度计算,排除外部工具反馈的影响。

- 实验设计:

- 基准测试:选择多个具有挑战性的数学推理基准测试,如Math500、AIME24、AIME25等,评估SimpleTIR在不同任务上的表现。

- 对比实验:与多种基线方法进行对比,包括非TIR的Zero RL方法、基于冷启动SFT的TIR方法以及其他Zero RL与TIR结合的方法,验证SimpleTIR的优势。

- 消融研究:通过消融实验分析轨迹过滤机制在稳定训练和提高性能方面的关键作用。

研究结果

通过一系列实验,本研究取得了以下主要结果:

- 训练稳定性显著提升:

- SimpleTIR在训练过程中表现出高度的稳定性,梯度范数保持平稳,几乎没有出现梯度爆炸现象。相比之下,传统多轮训练方法往往出现严重的梯度不稳定和性能崩溃。

- 消融实验进一步验证了轨迹过滤机制在稳定训练中的关键作用,去除该机制后,训练过程迅速变得不稳定。

- 推理性能显著提高:

- 在多个数学推理基准测试上,SimpleTIR取得了显著优于基线方法的性能。例如,在AIME24测试集上,SimpleTIR将分数从文本基线的22.1提升至50.5,展示了其在复杂推理任务上的强大能力。

- 与其他Zero RL和TIR方法相比,SimpleTIR在保持训练稳定性的同时,实现了更高的推理准确性和更强的泛化能力。

- 多样化推理模式的涌现:

- SimpleTIR在训练过程中鼓励模型发现多样化和复杂的推理模式,如自我纠正、交叉验证和渐进推理等。这些模式显著提高了模型的推理能力和鲁棒性。

- 通过案例分析,展示了SimpleTIR在解决复杂数学问题时的具体推理过程,验证了其有效性和实用性。

研究局限

尽管SimpleTIR在多轮工具集成推理中取得了显著进展,但仍存在以下局限:

- 无效轮次定义的局限性:

- 当前研究使用无效轮次(即既不生成代码块也不生成最终答案的轮次)作为低概率标记的指示器。然而,这一指标可能不适用于多轮TIR之外的其他任务,限制了方法的普适性。

- 交互轮次限制:

- 当前研究将最大交互轮次限制为10,虽然对于数学推理任务已经足够,但更复杂的任务可能需要更多的交互轮次。

- 沙箱环境的依赖:

- 当前训练依赖于高度并行的沙箱环境进行代码执行,开发更快、更可靠的沙箱环境是未来研究的重要方向。

未来研究方向

针对上述局限,未来研究可以从以下几个方面展开:

- 扩展无效轮次定义:

- 探索更通用的低概率标记指示器,以适用于不同任务场景下的多轮TIR训练。

- 增加交互轮次:

- 研究如何在保持训练稳定性的同时,增加最大交互轮次,以应对更复杂的多轮推理任务。

- 优化沙箱环境:

- 开发更高效、更可靠的沙箱环境,以支持大规模、高并发的代码执行需求。

- 异步展开与奖励计算:

- 研究如何实现完全异步的轨迹展开和奖励计算,进一步提高训练效率和稳定性。

- 多任务学习与迁移学习:

- 探索如何将SimpleTIR框架应用于多任务学习和迁移学习场景,实现不同任务之间的知识共享和性能提升。

- 结合其他先进技术:

- 结合其他先进技术(如注意力机制、记忆网络等),进一步提升模型的推理能力和适应性。

更多推荐

已为社区贡献100条内容

已为社区贡献100条内容

所有评论(0)