【人工智能】:搭建本地AI服务——Ollama、LobeChat和Go语言的全方位实践指南

Go语言适合构建高性能中间件。创建Go项目并初始化模块,安装必要的依赖如gin和ollama的Go SDK。编写API路由处理前端请求并转发至Ollama服务。= nil {return})Go语言适合构建高性能中间件。创建Go项目并初始化模块,安装必要的依赖如gin和ollama的Go SDK。编写API路由处理前端请求并转发至Ollama服务。

搭建本地AI服务实践指南

本指南将介绍如何使用Ollama、LobeChat和Go语言搭建一个功能完备的本地AI服务。以下是完整实现方案:

Ollama本地模型部署

package main

import (

"fmt"

"os/exec"

)

func setupOllama() {

cmd := exec.Command("ollama", "pull", "llama2")

output, err := cmd.CombinedOutput()

if err != nil {

fmt.Printf("Error pulling model: %v\n%s", err, output)

return

}

fmt.Println("Model downloaded successfully")

serveCmd := exec.Command("ollama", "serve")

if err := serveCmd.Start(); err != nil {

fmt.Printf("Error starting ollama: %v", err)

return

}

fmt.Println("Ollama service started")

}

LobeChat集成

func configureLobeChat() {

// 安装依赖

cmd := exec.Command("npm", "install", "-g", "lobe-chat")

output, err := cmd.CombinedOutput()

if err != nil {

fmt.Printf("Error installing LobeChat: %v\n%s", err, output)

return

}

// 配置环境变量

os.Setenv("OLLAMA_PROXY", "http://localhost:11434")

os.Setenv("ALLOWED_ORIGINS", "*")

// 启动服务

lobeCmd := exec.Command("lobe-chat", "start")

if err := lobeCmd.Start(); err != nil {

fmt.Printf("Error starting LobeChat: %v", err)

return

}

fmt.Println("LobeChat service started")

}

Go语言API服务

package main

import (

"encoding/json"

"net/http"

"io/ioutil"

)

type ChatRequest struct {

Prompt string `json:"prompt"`

Model string `json:"model"`

}

type ChatResponse struct {

Response string `json:"response"`

}

func chatHandler(w http.ResponseWriter, r *http.Request) {

var req ChatRequest

if err := json.NewDecoder(r.Body).Decode(&req); err != nil {

http.Error(w, err.Error(), http.StatusBadRequest)

return

}

// 调用Ollama API

resp, err := http.Post(

"http://localhost:11434/api/generate",

"application/json",

bytes.NewBuffer([]byte(fmt.Sprintf(`{

"model": "%s",

"prompt": "%s"

}`, req.Model, req.Prompt))),

)

if err != nil {

http.Error(w, err.Error(), http.StatusInternalServerError)

return

}

defer resp.Body.Close()

body, _ := ioutil.ReadAll(resp.Body)

var result ChatResponse

json.Unmarshal(body, &result)

json.NewEncoder(w).Encode(result)

}

func main() {

http.HandleFunc("/api/chat", chatHandler)

fmt.Println("Server running on :8080")

http.ListenAndServe(":8080", nil)

}

前端调用示例

async function sendMessage(prompt) {

const response = await fetch('http://localhost:8080/api/chat', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

},

body: JSON.stringify({

prompt: prompt,

model: 'llama2'

})

});

return await response.json();

}

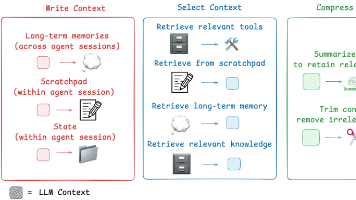

系统架构说明

- Ollama负责本地LLM模型的加载和推理

- LobeChat提供用户友好的聊天界面

- Go语言服务作为中间层处理业务逻辑和API路由

- 前端应用通过HTTP请求与后端交互

部署注意事项

- 确保系统有足够内存运行所选模型

- 开发环境需要安装Node.js和Go

- 生产环境建议使用Docker容器化部署

- 安全考虑应限制API访问权限

安装与配置Ollama

Ollama作为本地AI模型管理工具,支持多种开源模型。从官网下载对应操作系统的安装包,完成基础安装后通过命令行验证是否成功。

启动Ollama服务后,使用ollama pull命令下载所需模型,例如ollama pull llama2。模型下载完成后,通过ollama run llama2进行交互测试,确保模型正常运行。

部署LobeChat前端

LobeChat是一个开源的AI对话界面,支持与Ollama后端对接。克隆LobeChat的GitHub仓库到本地,安装Node.js依赖并启动开发服务器。

修改LobeChat的配置文件,将其API端点指向本地Ollama服务。例如在config.json中设置"API_BASE_URL": "http://localhost:11434"。运行npm run dev启动前端,通过浏览器访问http://localhost:3000验证连接。

使用Go语言开发自定义中间件

Go语言适合构建高性能中间件。创建Go项目并初始化模块,安装必要的依赖如gin和ollama的Go SDK。编写API路由处理前端请求并转发至Ollama服务。

package main

import (

"github.com/gin-gonic/gin"

"github.com/jmorganca/ollama/api"

)

func main() {

r := gin.Default()

r.POST("/chat", func(c *gin.Context) {

client := api.NewClient("http://localhost:11434")

resp, err := client.Chat(c.Request.Context(), &api.ChatRequest{

Model: "llama2",

Messages: []api.Message{

{Role: "user", Content: "Hello"},

},

})

if err != nil {

c.JSON(500, gin.H{"error": err.Error()})

return

}

c.JSON(200, gin.H{"response": resp.Message.Content})

})

r.Run(":8080")

}

集成与测试

将Go中间件部署在LobeChat和Ollama之间,确保三者通信正常。通过Postman或curl测试中间件API,验证请求能否正确转发并返回AI生成的响应。

调整LobeChat的界面配置,使其指向Go中间件地址而非直接连接Ollama。这种架构允许添加额外逻辑,如请求过滤、响应缓存或负载均衡。

性能优化与扩展

启用Ollama的GPU加速功能(若硬件支持),在启动时添加--gpu参数提升推理速度。Go中间件可集成Prometheus监控,实时跟踪请求延迟和成功率。

扩展场景下,可通过Docker容器化Ollama和Go服务,使用Kubernetes管理多实例部署。LobeChat支持插件开发,可自定义UI组件或添加第三方API集成。

安装与配置Ollama

Ollama作为本地AI模型管理工具,支持多种开源模型。从官网下载对应操作系统的安装包,完成基础安装后通过命令行验证是否成功。

启动Ollama服务后,使用ollama pull命令下载所需模型,例如ollama pull llama2。模型下载完成后,通过ollama run llama2进行交互测试,确保模型正常运行。

部署LobeChat前端

LobeChat是一个开源的AI对话界面,支持与Ollama后端对接。克隆LobeChat的GitHub仓库到本地,安装Node.js依赖并启动开发服务器。

修改LobeChat的配置文件,将其API端点指向本地Ollama服务。例如在config.json中设置"API_BASE_URL": "http://localhost:11434"。运行npm run dev启动前端,通过浏览器访问http://localhost:3000验证连接。

使用Go语言开发自定义中间件

Go语言适合构建高性能中间件。创建Go项目并初始化模块,安装必要的依赖如gin和ollama的Go SDK。编写API路由处理前端请求并转发至Ollama服务。

package main

import (

"github.com/gin-gonic/gin"

"github.com/jmorganca/ollama/api"

)

func main() {

r := gin.Default()

r.POST("/chat", func(c *gin.Context) {

client := api.NewClient("http://localhost:11434")

resp, err := client.Chat(c.Request.Context(), &api.ChatRequest{

Model: "llama2",

Messages: []api.Message{

{Role: "user", Content: "Hello"},

},

})

if err != nil {

c.JSON(500, gin.H{"error": err.Error()})

return

}

c.JSON(200, gin.H{"response": resp.Message.Content})

})

r.Run(":8080")

}

集成与测试

将Go中间件部署在LobeChat和Ollama之间,确保三者通信正常。通过Postman或curl测试中间件API,验证请求能否正确转发并返回AI生成的响应。

调整LobeChat的界面配置,使其指向Go中间件地址而非直接连接Ollama。这种架构允许添加额外逻辑,如请求过滤、响应缓存或负载均衡。

性能优化与扩展

启用Ollama的GPU加速功能(若硬件支持),在启动时添加--gpu参数提升推理速度。Go中间件可集成Prometheus监控,实时跟踪请求延迟和成功率。

扩展场景下,可通过Docker容器化Ollama和Go服务,使用Kubernetes管理多实例部署。LobeChat支持插件开发,可自定义UI组件或添加第三方API集成。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)