【面试必看】AI 大模型岗位:机器学习知识点 + 经典考题汇总

机器学习面试核心知识点摘要 偏差与方差:偏差反映模型拟合能力,高偏差导致欠拟合;方差反映模型稳定性,高方差导致过拟合。需平衡两者以最小化总误差。 评估指标:分类问题常用准确率、精确率、召回率等,数据不均衡时准确率会失效,需用F1-Score等指标。 逻辑回归:通过线性加权和+Sigmoid函数输出概率值,虽用于分类但核心步骤基于回归思想。 决策树:递归选择最佳特征分割数据,ID3用信息增益,C4.

这份面试资料内容较完整,建议大家点赞 + 收藏,方便后续随时查看,避免需要时找不到;如果它帮到了你,也欢迎分享给身边有面试需求的朋友~

Q1: 什么是偏差(Bias)和方差(Variance)?如何理解它们与过拟合、欠拟合的关系?

答案:

-

•

偏差:模型预测值的期望与真实值之间的差异。衡量了模型的拟合能力。高偏差意味着模型过于简单,无法捕捉数据中的基本关系,导致欠拟合。

-

•

方差:模型预测值的变化范围或离散程度。衡量了模型的稳定性。高方差意味着模型过于复杂,对训练数据中的噪声过度学习,导致过拟合。

关系图解:

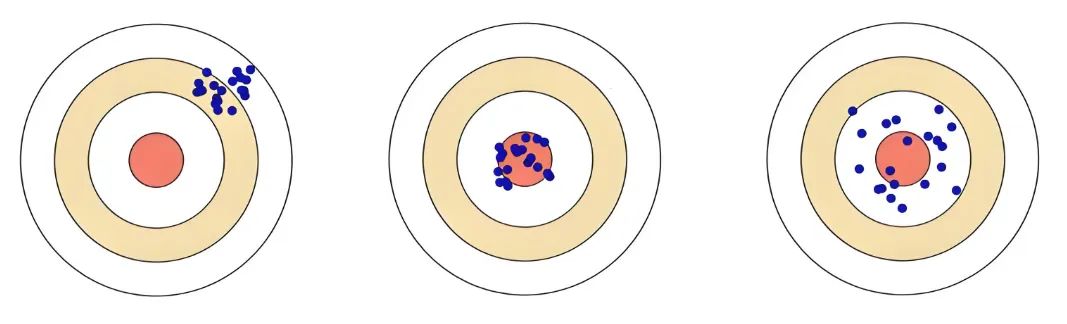

下图经典地展示了偏差-方差权衡(Bias-Variance Trade-off):

-

•

左列(欠拟合):弹孔全部集中在靶心外围,既不精确也不稳定。高偏差,低方差。

-

•

中列(理想):弹孔紧密集中在靶心附近,既精确又稳定。低偏差,低方差。

-

•

右列(过拟合):弹孔散落在靶心周围,平均位置可能在靶心,但非常不稳定。低偏差,高方差。

总误差主要由偏差、方差和不可避免的噪声构成。我们的目标是通过模型选择、正则化等手段,找到两者之间的最佳平衡点,使总误差最小。

Q2: 常用的模型评估指标有哪些?准确率(Accuracy)在什么情况下会失效?

答案:

常用指标:

- 分类问题:准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1-Score、ROC曲线与AUC值、PR曲线。

- 回归问题:均方误差(MSE)、平均绝对误差(MAE)、R平方(R²)。

准确率失效的场景:主要发生在数据分布极度不平衡的数据集上。

例子:在一个欺诈检测数据集中,正常交易(负样本)占99%,欺诈交易(正样本)占1%。如果一个模型简单地将所有样本都预测为“正常”,它的准确率高达99%,但这个模型是毫无用处的。

解决方案:在这种情况下,应使用精确率(预测出的欺诈中有多少是真的欺诈)、召回率(所有真实的欺诈中有多少被抓住了)和F1-Score(两者的调和平均)来评估模型。

Q3: 详细解释逻辑回归(Logistic Regression)的原理。它为什么是分类模型却叫“回归”?

**答案:

原理:

-

线性部分:首先,它和线性回归一样,计算输入特征的加权和:

z = w₁x₁ + w₂x₂ + ... + wₙxₙ + b。 -

激活函数:然后将线性结果

z输入到 Sigmoid函数 中,将输出压缩到(0, 1)区间:σ(z) = 1 / (1 + e^{-z})。这个值可以解释为样本属于正类的概率。 -

决策与损失:通过设定一个阈值(如0.5)来进行类别判断。使用交叉熵损失函数(而非均方误差)来衡量预测概率与真实标签的差异,并通过梯度下降法最小化损失来学习参数

w和b。

为什么叫“回归”:因为它的核心第一步(计算 z)来源于线性回归,是在用线性回归的思想去预测一个“概率值”,只不过后续加了一个非线性映射和决策过程,使其用于分类。它是对线性回归的扩展。

Q4: 简述决策树是如何构建的?以及它的核心算法ID3、C4.5和CART的区别?

答案:

构建过程(递归):从根节点开始,选择最佳特征对数据进行分割,直到满足停止条件(如节点样本数过少、纯度已足够高)。

选择最佳特征的标准:

******* ID3:使用信息增益(Information Gain)。InfoGain = H(D) - H(D|A),其中 H(D)是父节点的经验熵,H(D|A)是按特征A分割后的条件熵。它倾向于选择取值较多的特征。

-

C4.5:使用信息增益比(Gain Ratio),对ID3进行改进。

GainRatio = InfoGain / H_A(D),其中H_A(D)是特征A本身的熵。这克服了ID3偏向多值特征的缺点。 -

CART:使用基尼系数(Gini Index)。

Gini(p) = 1 - Σ p_i²,衡量数据的不纯度。基尼系数计算更快,且大多数情况下与信息熵的效果类似。******

Q5: 解释一下XGBoost的原理和它相比传统GBDT的优势。

答案:

**********原理:XGBoost(eXtreme Gradient Boosting)是梯度提升决策树(GBDT) 的一种高效实现。它是一种加法模型,通过多轮迭代,每轮训练一个新的决策树来拟合前一轮模型的残差(负梯度),最终将多个弱学习器集成为一个强学习器。

核心优势:

-

正则化:在目标函数中加入了L1/L2正则化项,有效控制模型复杂度,防止过拟合。

-

二阶泰勒展开:GBDT只用一阶导数,而XGBoost使用损失函数的一阶和二阶导数,可以更精准地逼近损失函数,从而更快地收敛。

-

并行处理:虽然Boosting是串行思想,但XGBoost在特征粒度上实现了并行,在寻找最佳分裂点时,预先对特征排序并存储为块结构,大大加快了计算速度。

-

灵活性:支持自定义损失函数(只需一阶和二阶可导)。

-

缺失值处理:内置机制能自动学习缺失值的分裂方向。

Q6: 反向传播(Backpropagation)算法是如何工作的?请描述其核心思想。

答案:

反向传播是神经网络训练的核心算法,其核心思想是链式法则。

工作流程:

-

前向传播:输入数据从输入层到输出层,逐层计算并存储每个神经元的输出值。

-

计算损失:在输出层计算预测值与真实值之间的损失(Loss)。

-

反向传播:将损失从输出层向输入层反向传播,利用链式法则计算损失函数相对于每一层权重和偏置的梯度。

-

•

∂L/∂W = (∂L/∂y) * (∂y/∂z) * (∂z/∂W),其中L是损失,y是输出,z是线性激活前的值,W是权重。

-

参数更新:使用优化器(如SGD、Adam)根据计算出的梯度更新网络中的所有权重参数(

W = W - η * ∂L/∂W)。

这个过程循环往复,直到模型收敛。

Q7: 缓解过拟合的常用技术有哪些?

答案:

***** •

数据层面:获取更多训练数据、数据增强(如图像旋转、裁剪)。

-

•

模型层面:简化模型(减少层数、神经元数)、Dropout(训练时随机丢弃一部分神经元,强制网络学习更鲁棒的特征)、权重正则化(L1/L2,给权重增加约束)。

-

•

训练技巧:早停(Early Stopping)(在验证集性能不再提升时停止训练)。

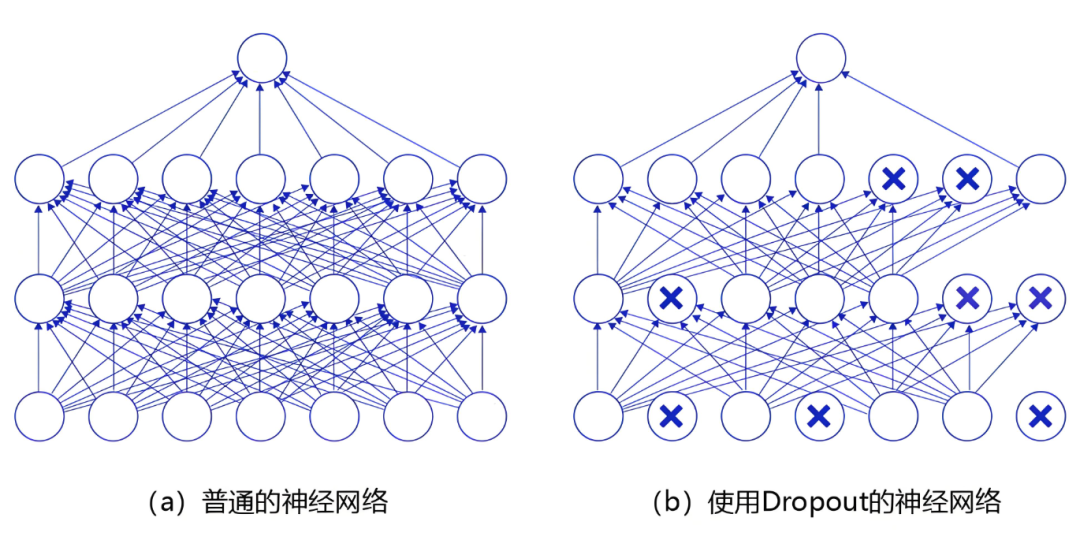

Dropout示意图:

-

•

左图:标准的全连接神经网络。

-

•

右图:应用Dropout之后,会将标了×的神经元从网络中删除,让它们不向后面的层传递信号。在学习过程中,丢弃哪些神经元是随机决定,因此模型不会过度依赖某些神经元,能一定程度上抑制过拟合。

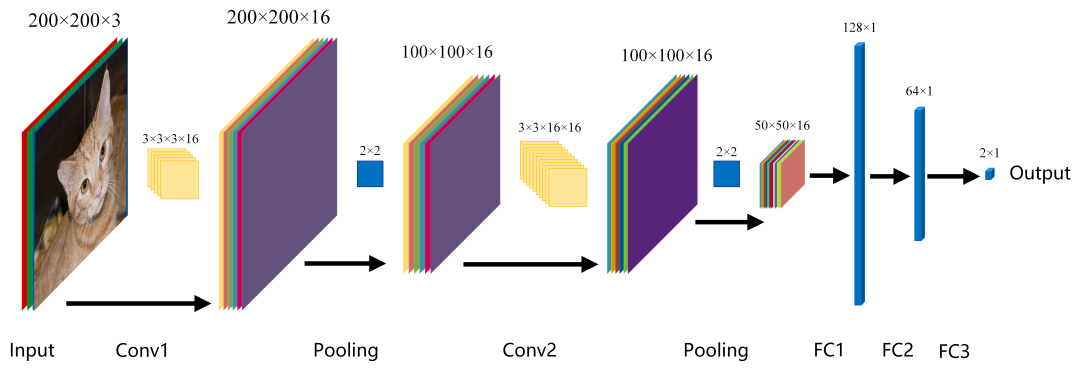

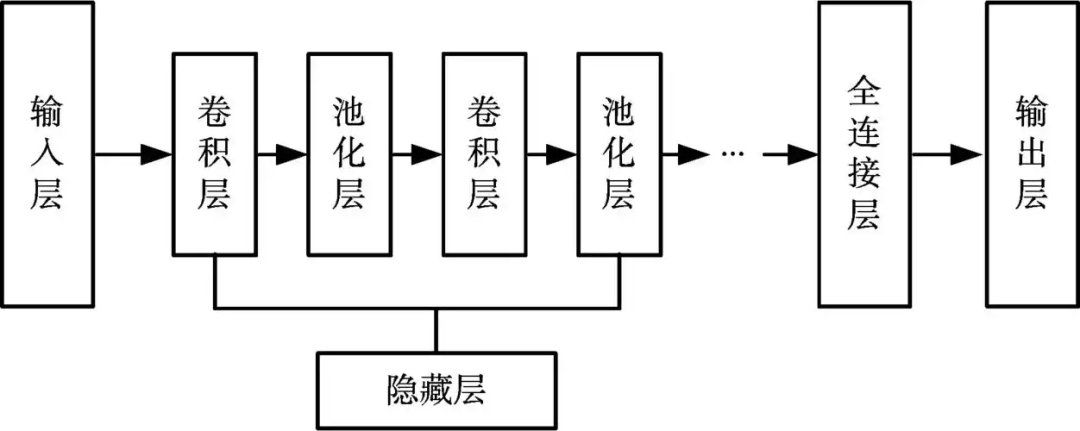

Q8: CNN中的卷积层和池化层分别有什么作用?

答案:

******卷积层(Convolutional Layer):

-

•

作用:使用卷积核(滤波器)在输入数据(如图像)上进行滑动窗口计算,提取局部特征(如边缘、角点、纹理等)。浅层卷积核提取低级特征,深层卷积核组合低级特征形成高级特征(如物体部件)。

-

•

参数共享:一个卷积核在整个输入上共享参数,极大减少了参数量。

池化层(Pooling Layer,如Max Pooling):

-

•

作用:降采样,减少特征图的空间尺寸(Width & Height)和参数量。从而增加感受野,使得网络关注是否存在某种特征而非其精确位置,提供一定的平移不变性并防止过拟合。

CNN特征提取示意图:

Q9: 全量微调(Full Fine-tuning)存在什么问题?介绍两种参数高效微调(PEFT)技术。**

Q9: 全量微调(Full Fine-tuning)存在什么问题?介绍两种参数高效微调(PEFT)技术。**

**答案:

全量微调问题:

-

计算和存储成本高:需要更新LLM所有数十亿的参数,需要大量GPU内存和时间。

-

灾难性遗忘:可能会破坏预训练模型中原有的通用知识。

-

模型管理困难:为每个下游任务都要保存一份完整的模型副本,非常笨重。

-

PEFT技术:

-

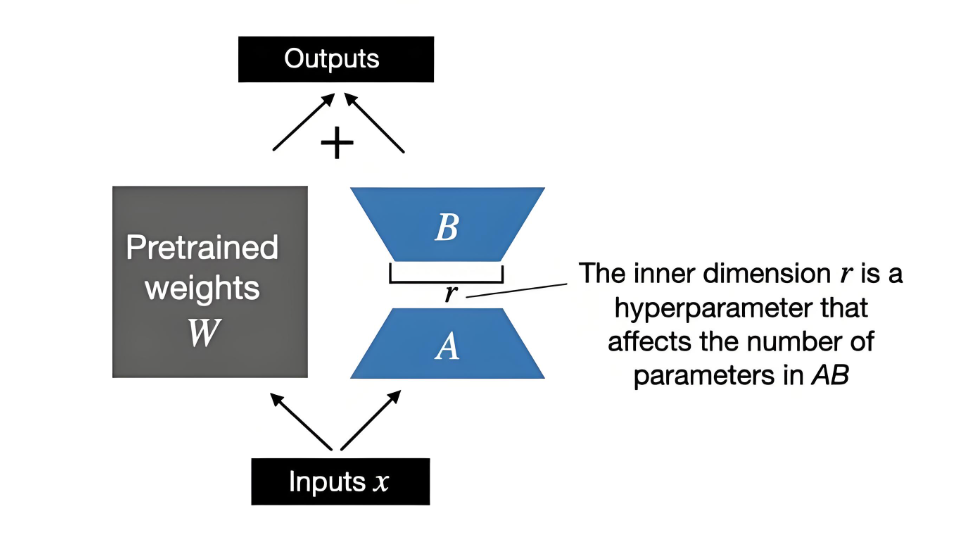

LoRA(Low-Rank Adaptation):核心思想是假设模型微调过程中的参数更新是低秩的。它冻结预训练模型权重,向模型注入可训练的低秩分解矩阵(A和B),只训练这些新增的参数。大大减少了可训练参数量(通常<1%)。

-

Prompt Tuning:冻结整个预训练模型,只在输入序列前添加一段可学习的软提示(Soft Prompts) 向量,通过训练这些提示向量来引导模型适应下游任务。比LoRA更轻量。

LoRA示意图:

Q10: 大模型推理阶段有哪些常见的优化技术?

****答案:

***** •

量化(Quantization):将模型权重和激活值从高精度(如FP32)转换为低精度(如INT8/INT4),减少内存占用和计算延迟。如GPTQ、AWQ等。

-

•

模型剪枝(Pruning):移除模型中不重要的权重或连接,减少模型大小。

-

•

知识蒸馏(Knowledge Distillation):用一个大模型(Teacher)来指导一个小模型(Student)学习,让小模型在性能损失不大的情况下获得更快的推理速度。

-

•

推理框架优化:使用专用推理框架如TensorRT、vLLM等,它们做了大量内核优化、算子融合、连续批处理(Continuous Batching)等,极大提升吞吐量。

Q11: 如果给你一个文本分类任务,但标注数据非常少(比如每类只有几十个样本),你会如何设计解决方案?

答案:

这是一个典型的小样本学习(Few-shot Learning) 场景。方案如下:

-

首选方案 - 大模型提示工程:直接使用ChatGPT/GPT-4等API,通过精心设计提示(Prompt)(如提供任务描述和少数几个示例),让其进行零样本/少样本推理。这是最快、成本最低的方案。

-

次选方案 - 微调大模型:如果API调用效果不佳或数据敏感,选择一个开源的基础模型(如LLaMA 3)。

-

•

使用PEFT技术(如LoRA) 在少量标注数据上进行高效微调。

-

•

利用数据增强技术生成更多训练样本(如回译、同义词替换)。

-

传统方案 - 微调小模型:如果计算资源极其有限,可以选用BERT等较小的预训练模型,在其上添加分类层并进行全量微调。但效果可能不如方案1和2。

-

评估:务必保留一个可靠的测试集来客观评估不同方案的效果。

Q12: 在设计一个面向用户的大模型应用(如聊天机器人)时,除了模型本身,还需要考虑哪些工程和技术问题?

答案:

这是一个系统设计问题,考察工程全局观。

-

•

1. 性能与延迟:如何优化推理速度(如模型量化、使用高性能推理框架)以满足用户对响应时间的期待。

-

•

2. 成本控制:如何管理API调用成本或自建模型的GPU推理成本。考虑缓存、异步处理、负载均衡等策略。

-

•

3. 可用性与可扩展性:如何设计后端服务架构(如微服务)以保证高可用性,并能进行水平扩展以应对流量高峰。

-

•

4. 数据与提示工程:如何构建和管理高质量的提示模板,如何利用检索增强生成(RAG) 技术接入外部知识库,以避免模型幻觉并提升回答质量。

-

•

5. 安全与合规:如何对用户输入和模型输出进行内容过滤,防止生成有害、有偏见或不合规的内容。如何保障用户数据隐私。

-

•

6. 监控与评估:建立完善的监控系统,跟踪API调用次数、延迟、错误率等指标。建立模型效果的线上评估体系(如收集用户反馈、A/B测试)。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献129条内容

已为社区贡献129条内容

所有评论(0)