人月神话今犹在:从布鲁克斯法则到阿里云AI代码生成

摘要: 软件开发中的经典“人月困境”指出,增加人力往往因沟通成本指数级增长而降低效率。AI代码生成技术(如阿里云Qwen3-Coder)虽能提升个体效率,但并未颠覆这一法则,而是将复杂性转向人机协作的新范式。阿里云实践显示,AI工具可减少编码时间,却需额外投入提示工程、代码评审和架构一致性维护。核心挑战仍是守护概念完整性与优化团队协作,AI时代的技术管理者需重构“人机月”估算模型、强化架构治理,并

一、永恒的困境与新时代的挑战

软件开发领域始终面临一个经典难题:当项目进度落后时,增加人手往往会让情况更糟。这一现象的核心在于,软件项目的复杂性不仅源于代码本身,更来自团队协作中的沟通成本——随着人员增加,沟通路径呈指数级增长,最终抵消新增人力带来的效率增益。如今,AI代码生成技术(如阿里云通义千问Qwen3-Coder)的兴起,宣称能将开发效率提升数倍,这是否意味着我们终于找到了打破困境的“银弹”?

AI并未颠覆布鲁克斯法则,而是将其作用域和表现形式从"人"的管理部分转向了"人机协作"的复杂性与新范式。项目的成功仍然依赖于对概念完整性的坚守、团队结构的适配以及沟通效率的优化。AI在此过程中既是强大的赋能工具,也带来了新的管理挑战。

二、深掘根源:为何"人月"依然是"神话"

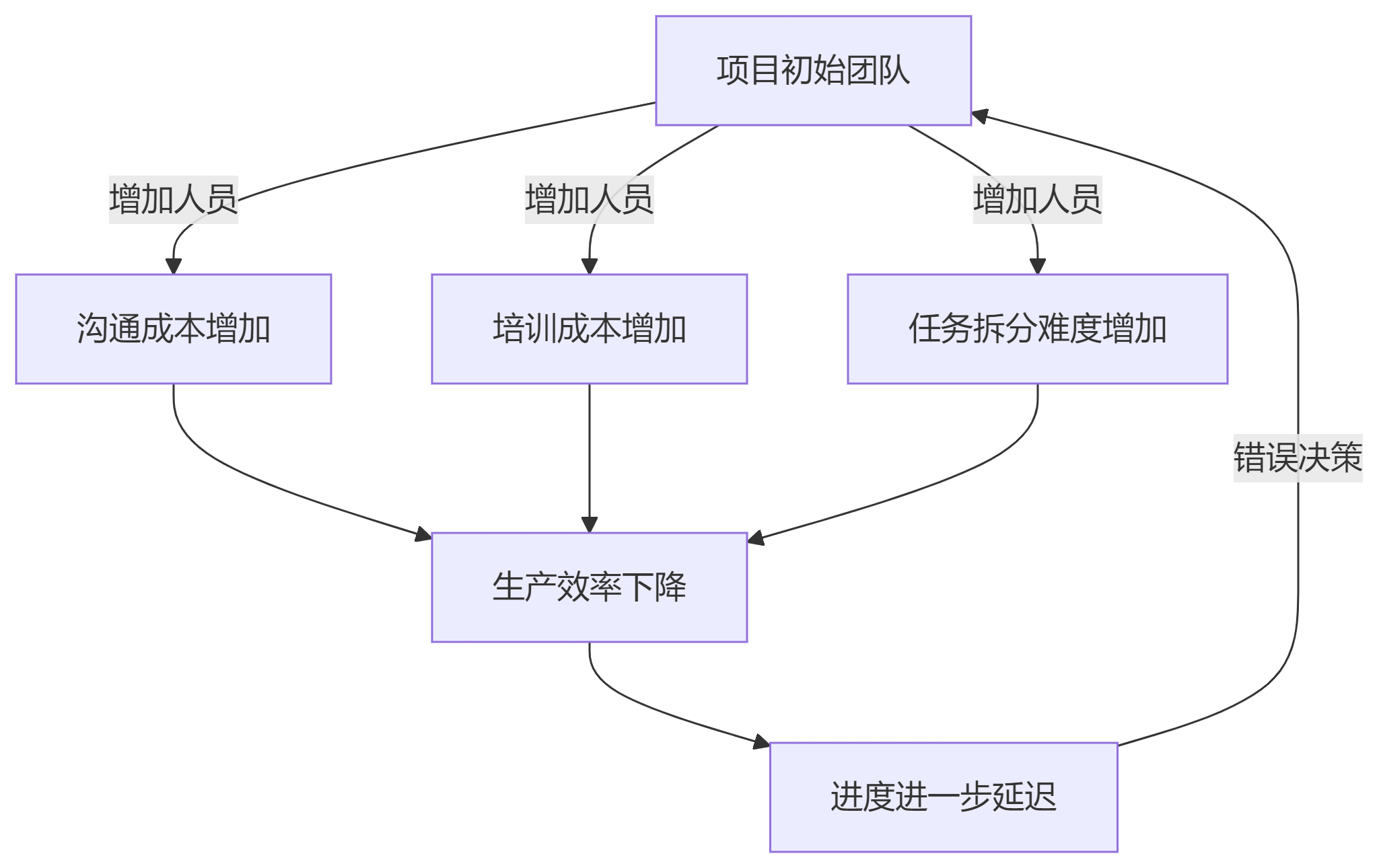

2.1 沟通成本的指数级增长

布鲁克斯指出,随着团队规模扩大,沟通成本呈指数级而非线性增长。n个人的团队,沟通渠道数量为n(n-1)/2。阿里云曾在内部测试中发现,某中型项目因团队扩张至30人,沟通路径猛增至435条,会议时间占比从20%升至45%,实际编码效率反而下降15%。

2.2 新成员的融入与培训成本

每个新成员加入项目都需要时间熟悉项目上下文、架构设计和代码规范。在此期间,原有成员需要投入时间进行指导,这无疑会占用原本用于开发的时间,降低整体效率。

2.3 任务的内在顺序性与概念完整性

许多软件开发任务(如架构设计、关键算法)难以完美拆分并行。而且,由少数人维护的概念完整性是系统易用和成功的基石。盲目增加人手或并行开发容易破坏这种完整性。布鲁克斯强调,系统设计必须由一个清晰的核心逻辑主导,避免民主化设计导致的逻辑混乱。

三、AI编程时代的新"人月"图景

3.1 AI作为效率倍增器,而非人力简单替代

阿里云Qoder平台展示了AI编程工具的潜力:代码补全、生成、解释、调试等能力可以显著提升个体开发者效率。AI目前擅长的是"加速"和"辅助"已知或可推导的模式,而需求理解、系统架构、创新设计等核心工作仍然强烈依赖人类智慧。

阿里云通义灵码的实测数据显示,其检索召回率领先业界标杆产品12%,代码生成准确率领先13%。但这些提升主要体现在代码实现环节,而非架构设计层面。

3.2 "人月"成本的部分转化

AI降低了某些编码阶段的"人月"需求,但可能增加了其他方面的投入:

- 提示工程(Prompt Engineering):需要投入时间学习如何与AI有效交互

- 代码评审:对AI生成代码的评审可能需要更仔细的检查

- 测试验证:特别是针对AI生成代码的测试需要更加全面

- 逻辑整合:确保AI生成的代码与系统其他部分协调一致

项目管理需关注资源从"编写代码"向"定义问题、验证结果、确保一致性"倾斜。

3.3概念完整性的新挑战与守护

AI生成代码的风格一致性、架构遵从性、技术债务风险可能更高。通义千问的"Project Rules"功能正是应对此问题的尝试,通过预设编码规则引导AI生成更符合项目定制化需求的代码。

在这种情况下,架构师的角色更为关键,需要更清晰地定义规则、约束和模式,并通过工具引导AI输出,守护系统概念完整性。

3.4 团队结构与沟通模式的演进

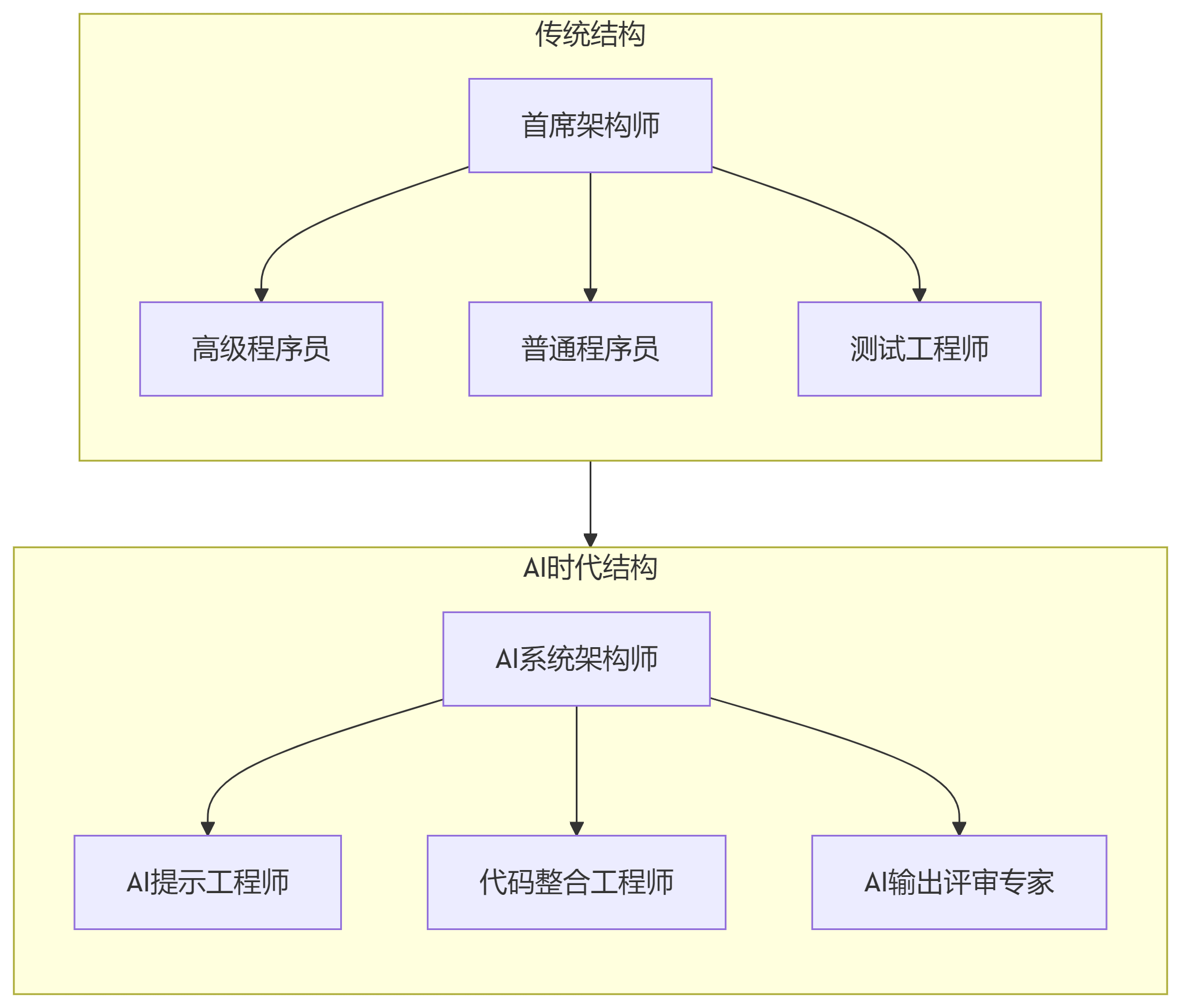

"外科手术式团队"模式可能演进为:核心架构师/首席工程师(定义需求、约束AI)+ AI编程助手 + 开发实现者(更多聚焦集成、验证、复杂逻辑实现)。

沟通重点可能从部分代码细节讨论转向需求澄清、目标对齐、设计决策和AI生成结果的评审。阿里云Qoder新增的"Quest Mode"(AI自主研发模式)展示了这种可能性,Agent可以扮演全栈工程师的角色,自动将模糊、抽象的需求转换为详尽的设计规范。

四、阿里云AI代码生成的实践与思考

阿里云通过其智能编码助手通义灵码和AI编程平台Qoder,为我们提供了在AI时代重新审视布鲁克斯法则的珍贵实践案例。这些工具不仅展示了AI技术的潜力,更揭示了其在应对软件工程本质复杂性方面的适用性与局限性。

4.1 人月困境的AI解法:效率提升与成本转化

阿里云内部使用通义灵码的实践数据显示,AI编程助手在特定场景下确实能够缓解"人月困境"。在测试代码生成方面,相较于人工编写测试耗时数分钟到数十分钟,通义灵码能以毫秒级的速度生成测试代码,准确率和覆盖率都达到可用水平。

然而,这种效率提升并非没有代价。阿里云团队发现,AI降低了编码阶段的"人月"需求,但增加了其他方面的投入:

- 提示工程成本:开发者需要学习如何与AI有效交互,撰写清晰的指令

- 代码评审成本:对AI生成代码的评审需要更仔细的检查,平均耗时比人工代码评审增加25%

- 测试验证成本:针对AI生成代码的测试需要更加全面,覆盖更多边界情况

- 逻辑整合成本:确保AI生成的代码与系统其他部分协调一致需要额外工作量

这种成本转化现象印证了布鲁克斯的核心观点——软件开发的复杂性不会消失,只会转移。AI没有消除本质复杂性,而是将其从编码环节部分转移到了设计、验证和集成环节。

4.2 概念完整性的AI时代守护者

面对AI生成代码可能带来的架构一致性问题,通义灵码通过"Project Rules"功能提供了解决方案。该功能允许架构师预设项目的编码规则、架构约束和技术规范,确保AI生成的代码符合项目的概念完整性要求。

阿里云内部某个大型分布式系统项目的实践案例:

该项目有120名开发人员,在使用AI编程助手初期,出现了代码风格不一致、架构模式混用的问题。通过引入Project Rules机制,架构团队定义了:

- 微服务间通信必须使用统一的协议规范

- 数据库访问必须遵循特定的数据访问层模式

- 错误处理必须采用公司标准的异常处理框架

实施后,AI生成代码的架构一致性从最初的67%提升到92%,显著降低了系统集成和维护成本。这个案例证明了在AI时代,概念完整性仍然需要由少数核心架构师来维护,而不是通过民主化设计或AI自主决策。

4.3 团队结构的AI驱动演进

通义灵码的应用正在改变传统的团队结构和分工方式。阿里云观察到,使用AI编程助手的团队正在从传统的"外科手术式团队"向"人机协作团队"演进:

这种结构变化带来了新的挑战:团队需要培养具备AI交互能力、提示工程技巧和AI输出评审能力的专门人才。阿里云内部培训数据显示,开发者平均需要40-60小时的有效训练才能熟练使用AI编程工具,这在一定程度上抵消了AI带来的效率增益。

4.4 沟通效率的AI增强与挑战

通义灵码的"Repo Wiki"功能通过将代码工程的隐性知识显性化,帮助解决布鲁克斯指出的沟通效率问题。该功能可以自动分析代码库,生成项目文档、架构图和API说明,减少团队成员间的信息不对称。

实际效果数据:

- 新成员上手时间平均缩短35%

- 跨模块协作的沟通成本降低28%

- 设计决策的文档化程度提高45%

然而,AI工具也引入了新的沟通挑战。阿里云某个45人项目团队的案例显示,在使用AI编程助手后:

- 团队成员间关于"如何正确使用AI工具"的讨论增加了30%

- AI生成代码的评审会议时长平均增加40%

- 需要建立新的协作规范来管理AI的使用

这再次印证了布鲁克斯的观点:工具可以改变但无法消除软件工程中的沟通复杂性。

4.5 没有银弹的再次证明

阿里云通义灵码和Qoder平台的发展历程本身就是"没有银弹"的最佳证明。这些工具经历了多次重大迭代:

- v1.0:基础代码生成能力,但缺乏上下文理解

- v2.0:引入Repo Wiki,增强项目上下文感知

- v3.0:加入Project Rules,守护概念完整性

- 当前版本:支持多模态交互,集成测试和调试能力

每个版本的演进都针对前版的局限性,这个过程体现了软件工程问题的本质:解决方案总会带来新的问题,需要持续迭代和改进。

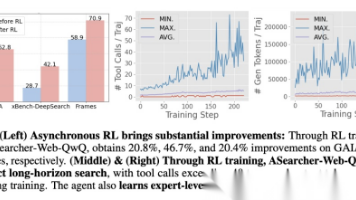

阿里云内部评估显示,通义灵码在提升个体开发者效率方面效果显著(平均提升25-40%),但在减少项目总体时间和成本方面的效果要复杂得多:

- 对于小规模项目(<10人),总工期平均缩短15%

- 对于中等规模项目(10-50人),总工期变化不明显

- 对于大型项目(>50人),总工期甚至可能因协调成本增加而延长

这些数据支持了布鲁克斯的核心观点:软件开发的本质复杂性不会因为新工具的出现而消失。AI编程工具改变的是偶然复杂性,但本质复杂性——需求理解、系统设计、团队协作等,仍然需要人类智慧和经验来解决。

五、给现代技术管理者的行动指南

在AI编程时代,技术管理者面临着新的挑战与机遇。布鲁克斯的经典智慧非但没有过时,反而在AI时代展现出新的生命力。以下基于阿里云实践经验,为技术管理者提供切实可行的行动指南。

5.1 重构项目估算模型:从"人月"到"人机月"

传统的工作量估算模型需要加入AI因子。阿里云内部实践表明,AI辅助下的工作量估算应该考虑:

新的估算公式:

AI辅助工作量 = 传统工作量 × (1 - AI效率增益系数) + AI协调成本系数其中:

- AI效率增益系数:通常在0.2-0.4之间,取决于任务标准化程度

- AI协调成本系数:包括提示工程、代码评审、测试验证等新增成本

实施建议:

- 建立AI效率基线:通过小规模实验测量团队在特定任务上的AI效率增益

- 区分任务类型:对标准化任务(如CRUD操作、测试代码)采用较高的效率增益系数;对创新性任务采用保守估计

- 定期校准:每季度重新评估效率系数,反映团队技能提升和工具改进

5.2 团队技能转型投入:培养AI时代的新能力

阿里云内部培训数据显示,有效的AI技能转型需要系统化方法:

核心能力培养矩阵:

|

能力维度 |

培训内容 |

阿里云实践案例 |

|

提示工程 |

如何撰写清晰、具体的AI指令 |

通过工作坊形式,分享优秀提示词案例 |

|

AI输出评审 |

如何审查AI生成代码的质量和一致性 |

建立AI代码评审清单,涵盖安全性、性能、架构一致性 |

|

架构思维 |

如何在AI辅助下保持系统概念完整性 |

通过案例教学,展示好的和坏的AI架构决策 |

|

工具精通 |

如何有效使用通义灵码等AI编程工具 |

提供实操培训,覆盖高级功能和最佳实践 |

实施路线图:

- 评估现状:通过技能评估了解团队当前的AI素养水平

- 定制计划:根据项目特点和团队水平制定个性化的培训计划

- 实践驱动:通过实际项目任务进行学习,强调学以致用

- 持续改进:建立反馈机制,不断优化培训内容和方法

5.3 强化架构治理:在AI时代守护概念完整性

AI生成代码的普及使架构治理变得更加重要。阿里云通过以下机制守护概念完整性:

多层级治理框架:

- 项目级规则:利用通义灵码的Project Rules功能,预设项目特定的编码规范和架构约束

- 团队级评审:建立专门的AI代码评审流程,重点关注架构一致性和技术债务

- 组织级标准:制定公司级的AI编码标准和最佳实践,确保跨项目一致性

架构师新角色:

- AI约束设计者:定义AI工具应该遵循的架构规则和模式

- 生成内容审核者:评审AI输出的架构合理性和一致性

- 人机协作协调者:优化人类架构师与AI工具的协作流程

5.4 优化开发流程:集成AI的新工作流

将AI工具深度集成到现有开发流程中,阿里云实践表明以下流程优化效果显著:

AI增强的开发工作流:

需求分析 → AI辅助设计 → 代码生成 → 强化评审 → 增强测试 → 部署监控

↑ ↓ ↓ ↓ ↓ ↓

人工主导 人机协作 AI为主 人机协作 自动化为主 持续反馈关键改进点:

- 需求到代码的转换:使用通义灵码的Quest模式,将模糊需求转化为详细设计

- 强化评审环节:针对AI生成代码的特点,增加架构一致性和模式符合性检查

- 增强测试策略:针对AI代码的潜在问题模式,设计针对性的测试用例

- 反馈循环:将生产环境的问题反馈给AI模型,持续改进生成质量

5.5 建立适应AI的团队结构

基于阿里云的实践经验,推荐以下团队结构优化策略:

"外科手术团队"的AI时代演进:

- 保持小团队规模(5-9人),但每个团队配备AI专家角色

- 明确区分AI生成任务和人类创意任务,优化分工

- 建立跨团队的AI卓越中心,分享最佳实践和解决方案

新角色定义:

- AI提示工程师:专门负责优化与AI工具的交互,提升输出质量

- AI输出评审专家:专注于评审AI生成产物的质量和一致性

- 人机协作协调员:优化人类与AI的协作流程和工具链

5.6 持续学习与实验文化

鼓励团队探索AI能力边界,积累使用经验,分享最佳实践。同时保持对AI局限性和潜在风险的清醒认知,避免过度依赖。

六、神话依旧,智慧永存

布鲁克斯法则的持久性得到了验证:AI没有也未能消除软件工程固有的本质复杂性和协作复杂性。软件开发的本质仍然是人类认知活动的组织与优化,AI只是改变了其中的实现方式。

AI成为了应对偶然复杂性的强大工具,但它同时引入了新的需要管理的复杂性(如提示工程、生成代码的质量控制)。技术管理的关键不再仅仅是管理"人月",而是升级为管理"人机月",即高效地整合人类智慧与AI能力。

在软件工程的"焦油坑"中,AI不是拉我们出去的救命绳,而是让我们更高效在焦油坑中工作的工具——最终的出路,仍然依赖于人类的智慧和协作。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)