YOLOv11最新创新改进系列:多模态融合RGB+红外线(IR),可直接使用的数据集推荐。

YOLOv11最新改进系列推出多模态融合技术,支持RGB+红外线(IR)双模态输入,并推荐两大可直接使用的数据集:M3FD(包含严格配对的可见光与红外图像及目标检测标注)和LLVIP(专注弱光环境下的可见光-红外配对数据,含密集行人标注)。博主提供40+单模态和20+多模态改进方案,组合方式可达上百万种。相关源码和教程可通过B站"AI学术叫叫兽"获取,支持一对一答疑服务。两个数

YOLOv11最新创新改进系列:多模态融合RGB+红外线(IR),可直接使用的数据集推荐。

购买相关资料后畅享一对一答疑!

截止到发稿时,B站YOLOv11最新改进系列的源码包,已更新了40+种的单模态改进!20+种多模态改进!

自己排列组合2-4种后,考虑位置不同后可排列组合上千万种!!专注AI学术,关注B站博主:Ai学术叫叫兽!

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

一、M3FD 数据集

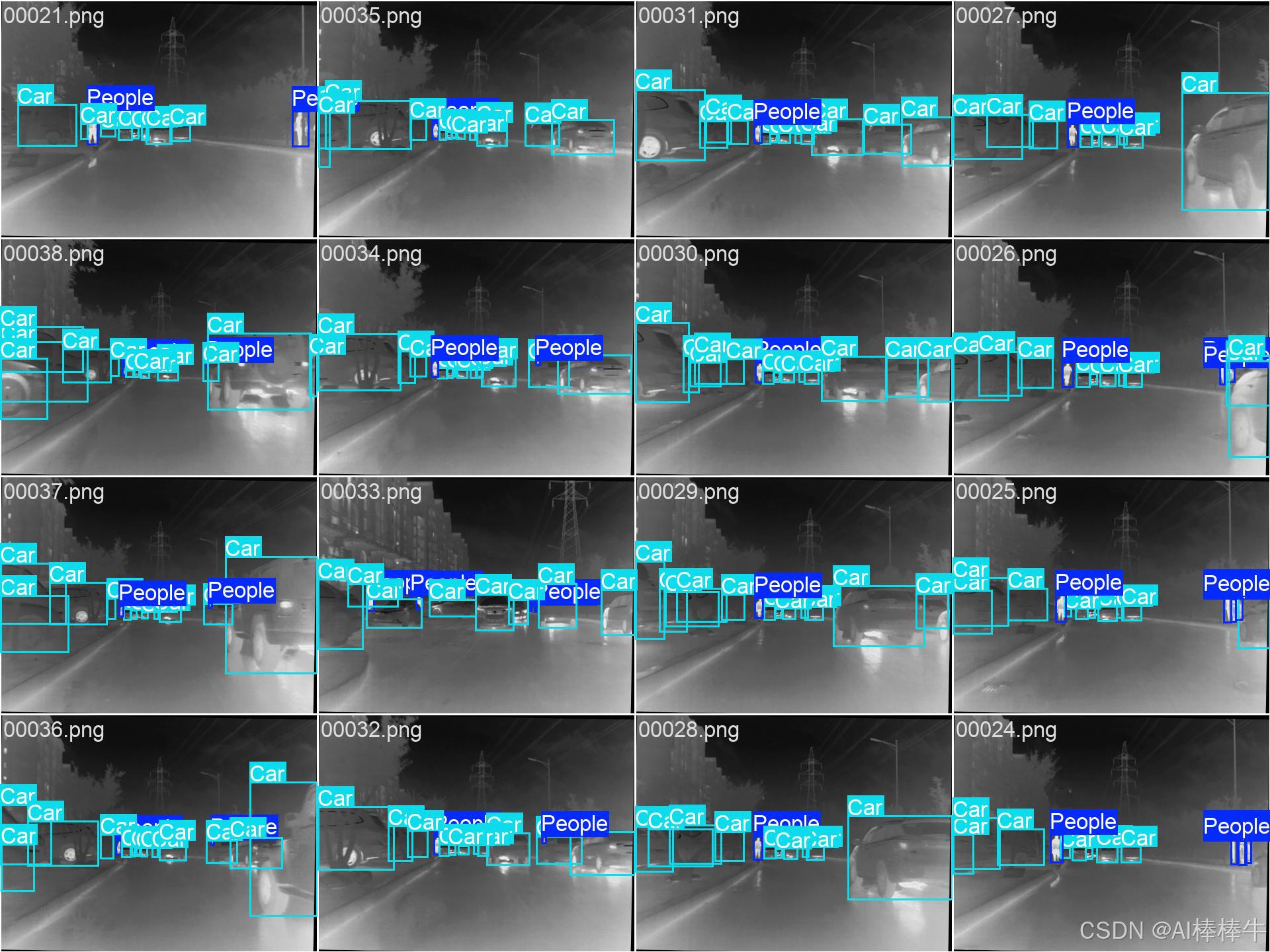

M3FD 数据集是一个专注于红外与可见光图像融合及其相关计算机视觉任务(如目标检测)的多模态图像数据集。

下面是一个简要的表格,概括了M3FD数据集的核心信息:

| 特性 | 描述 |

|---|---|

| 数据集 | M3FD 数据集 |

| 核心模态 | 可见光RGB图像 + 红外图像 |

| 主要用途 | 红外与可见光图像融合方法的研究与评估 ,也可用于目标检测任务 |

| 标注信息 | 包含目标检测的标注框 |

| 标注格式 | XML (可转换为YOLO训练所需的TXT格式) |

| 部分数据来源/应用场景 | 作为红外与可见光图像融合方法研究的训练集或测试集使用 |

🔍 数据内容与特点

M3FD数据集主要包含可见光RGB图像和与之对应的红外图像对。这些图像通常是在不同场景和条件下采集的,旨在为多模态图像融合算法提供训练和测试资源。

数据集提供了目标检测的标注信息,默认格式为XML文件。这些XML文件包含了图像中目标的类别以及边界框(Bounding Box)的坐标信息。例如,一个XML文件中可能包含多个 <object> 标签,每个标签内包含目标类别(如 People)和其对应的边界框坐标(<xmin>, <ymin>, <xmax>, <ymax>)。

许多目标检测算法(如YOLO系列)训练时所需的标签格式是特定的TXT文件。因此,在使用M3FD数据集进行目标检测研究时,通常需要将其XML格式的标注转换为YOLO所需的TXT格式。转换后的TXT文件内容通常遵循:类别ID 归一化后的中心点x坐标 归一化后的中心点y坐标 归一化后的宽度 归一化后的高度。

💡 主要用途

M3FD数据集主要用于红外与可见光图像融合方法的研究与评估。图像融合旨在将不同模态(如可见光和红外)传感器获取的信息整合成一幅更全面、更适用于人类视觉或计算机后续处理的图像。例如,可见光图像纹理细节丰富,但受光照影响大;红外图像能反映目标的热辐射信息,在夜间或恶劣天气下表现较好,但缺乏细节。融合两者可以优势互补。

除了图像融合,该数据集也可用于目标检测任务。由于其提供了目标级别的标注,研究者可以利用它来训练或评估在多模态数据(尤其是红外数据)上的目标检测性能。

📝 获取与使用

数据集的**官方地址**,戳蓝色字体下载就行。

M3FD数据集为红外与可见光图像融合以及多模态目标检测的研究提供了重要的数据资源。它包含了配对的可见光和红外图像,并提供了目标检测标注(XML格式)。

二、LLVIP(Visible-infrared Paired Dataset for Low-light Vision)是一个专注于弱光环境下的**可见光-红外图像配对数据集

LLVIP(Visible-infrared Paired Dataset for Low-light Vision)是一个专注于弱光环境下的可见光-红外图像配对数据集,旨在推动图像融合、行人检测和图像转换等计算机视觉任务的研究。下面我将为你详细介绍这个数据集。

以下是LLVIP数据集的一个简要概述表格,帮助你快速了解其核心特征:

| 特征维度 | 详细描述 |

|---|---|

| 数据集全称 | LLVIP: A Visible-infrared Paired Dataset for Low-light Vision |

| 发布信息 | 由北京邮电大学团队构建,并在ICCV 2021上发布 |

| 核心特点 | 弱光环境、严格时空对齐的可见光-红外图像对、密集行人标注 |

| 数据规模 | 总计33,672张图像(即16,836对配对图像) |

| 图像来源 | 26个不同地点,每晚6点至10点采集,包含多名行人和骑行者 |

| 标注信息 | 所有图像均包含行人标注(边界框) |

| 原始分辨率 | 可见光图像:1920×1080;红外图像:1280×720 |

| 主要应用场景 | 图像融合、弱光行人检测、图像转换(可见光与红外相互转换) |

| 许可协议 | 非商业用途(使用前务必确认最新许可信息) |

🧿 LLVIP数据集的特点与优势

LLVIP数据集的出现,主要是为了解决弱光环境下视觉任务的一些挑战,以及弥补之前一些多模态数据集的不足。它具有以下几个显著的优势:

- 极端的弱光条件:数据集中的图像大多采集于夜间极暗环境(傍晚6点至10点),可见光图像的信噪比极低,目标难以辨识,充分体现了红外图像在弱光下的补充价值。

- 严格的时空对齐:通过专用的双目相机硬件采集,并经过半人工的配准和裁剪处理,确保了同一场景的可见光和红外图像在空间和时间上高度一致。这对于图像融合等任务至关重要。

- 高质量的密集行人标注:虽然弱光下标注非常困难,但团队创新地利用在清晰的红外图像上先标注,再利用配准关系映射到可见光图像的方法,完成了所有图像中行人的边界框标注。数据集中包含大量行人目标。

- 丰富的应用场景:由于其高质量的配对数据和标注,LLVIP非常适合用于图像融合(可见光与红外融合)、弱光下的行人检测(同时支持可见光、红外及融合检测)以及图像转换(如可见光到红外的转换)等任务。

⚖️ 局限性

尽管LLVIP数据集有很多优点,但也存在一些局限性:

数据集中的图像主要是在中等距离采集的,因此图像中的行人尺寸也多为中等大小。这意味着它可能不适用于研究远距离小目标行人检测问题。

🔍 与其他多光谱数据集对比

在LLVIP之前,已存在一些可见光-红外数据集,如TNO、KAIST、FLIR等,但它们在不同方面存在一些限制,例如场景并非专门针对低光照、图像未严格对齐、行人目标稀少或缺乏详细标注等。LLVIP在一定程度上弥补了这些不足,特别是在低光照、严格对齐和行人检测方面。

🚀 主要应用任务

LLVIP数据集主要支持以下计算机视觉任务的研究:

- 图像融合:将可见光图像丰富的纹理细节与红外图像不受光照影响的目标显著性相结合,生成信息更全面、更适用于人眼观察或机器处理的融合图像。

- 弱光行人检测:利用红外信息来显著提升在极弱光环境下可见光图像的行人检测性能,对于自动驾驶、视频监控等应用具有重要意义。许多研究也在此数据集上验证了多模态融合检测算法的有效性。

- 图像转换:例如将可见光图像转换为红外图像,或者反之,可用于数据增强或研究不同模态间的关联。

📊 数据获取与使用

- 官方获取:LLVIP数据集官方发布于GitHub:https://github.com/bupt-ai-cz/LLVIP

- 许可协议:该数据集通常遵循

非商业用途许可协议,这意味着商业使用需要额外授权。在使用前,请务必核实其最新的官方许可信息。

💎 总结

LLVIP数据集是一个高质量的、专注于弱光环境的可见光-红外配对数据集,其严格的时空对齐和高质量的行人标注使其成为研究多模态图像融合、弱光条件下目标检测(尤其是行人检测)等任务的宝贵资源。

希望这些信息能帮助你全面了解LLVIP数据集。如果你有特定的应用场景或研究方向,我可以尝试提供更具体的建议。

改进策略

目前在此项目中,截止发文时,多模态融合改进已经达到20+种,持续永久更新!足够小伙伴发文参考的需要!关注本upB站,更多干货,助力快速科研!!!!!!

写在最后

学术因方向、个人实验和写作能力以及具体创新内容的不同而无法做到一通百通,所以本文作者即B站Up主:Ai学术叫叫兽

在所有B站资料中留下联系方式以便在科研之余为家人们答疑解惑,本up主获得过国奖,发表多篇SCI,擅长目标检测领域,拥有多项竞赛经历,拥有软件著作权,核心期刊等经历。因为经历过所以更懂小白的痛苦!因为经历过所以更具有指向性的指导!

祝所有科研工作者都能够在自己的领域上更上一层楼!!!

所有科研参考资料均可点击此链接,合适的才是最好的,希望我的能力配上你的努力刚好合适!

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)