YOLOv11最新创新改进系列:多模态融合RGB+红外线(IR),基于YOLOFuse,对YOLOv11进行多模态融合改进。

YOLOv11推出多模态融合改进YOLOFuse系统,支持RGB+红外等多模态数据融合,显著提升复杂环境下的检测性能。该系统采用双流处理架构,提供数据级、特征级和决策级三种融合策略,在LLVIP数据集测试中mAP@50最高达0.955。项目已更新20+种多模态改进方案,支持40+单模态改进组合。配套提供M3FD数据集配置、云服务器环境教程和训练脚本,适用于安防、自动驾驶、工业检测等场景。相关资料可

YOLOv11最新创新改进系列:多模态融合RGB+红外线(IR),基于YOLOFuse,对YOLOv11进行多模态融合改进。

购买相关资料后畅享一对一答疑!

截止到发稿时,B站YOLOv11最新改进系列的源码包,已更新了40+种的单模态改进!20+种多模态改进!

自己排列组合2-4种后,考虑位置不同后可排列组合上千万种!!专注AI学术,关注B站博主:Ai学术叫叫兽!

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

多模态简介

YOLOFuse 是一个基于 Ultralytics YOLO 框架构建的增强型多模态目标检测系统。它通过创新的双流处理架构,协同分析与融合不同模态的图像数据(如 RGB 和红外 IR),显著提升了在复杂环境(如低照度、烟雾遮挡、极端天气)下的检测鲁棒性和准确性。

下面是一个简要的对比表格,帮助你快速了解 YOLOFuse 的主要特性:

| 特性维度 | 描述 |

|---|---|

| 核心架构 | 基于 Ultralytics YOLO 的双流处理架构,支持端到端联合训练与推理 |

| 支持模态 | 主要支持 RGB + 红外 (IR),可扩展至 RGB-D、毫米波雷达等多模态数据 |

| 融合策略 | 提供数据级、特征级(早期/中期)、决策级等多种融合方式 |

| 关键改进 | 兼容 YOLOv8 API,引入坐标注意力机制、自适应空间特征融合等模块 |

| 主要优势 | 在复杂环境下(低光照、遮挡)检测精度高;模型轻量化;部署便捷 |

| 应用场景 | 安防监控、自动驾驶、工业检测、灾害救援、农业监测等 |

🔧 核心架构与工作原理

YOLOFuse 的核心在于其双流编码器-解码器架构,能够高效处理并融合来自不同传感器的异构数据。

- 双流输入处理:YOLOFuse 首先通过两个独立的输入分支分别提取 RGB 图像和红外图像(IR)的原始特征。这两个分支可以共享部分底层结构,但允许各自处理特定模态的信息。

- 主干特征提取网络:每个流通常会使用一个类似于 CSPDarknet53-Tiny 或 YOLO的骨干网络(Backbone)进行深度特征提取。

- 多层次特征融合模块:这是 YOLOFuse 的关键。它提供了多种融合策略,在不同网络层次上对双流特征进行融合:

- 数据级融合 (Data-level Fusion):在输入阶段直接拼接或加权叠加不同模态的原始图像数据。这种方式简单、计算开销小,但对传感器的配准要求高。

- 特征级融合 (Feature-level Fusion):

- 早期特征融合 (Early-level Feature Fusion):在骨干网络之前或浅层进行特征融合,能保留更多原始模态信息。

- 中期特征融合 (Mid-level Feature Fusion):在网络中间层(如特征金字塔网络FPN阶段)进行融合,是性能和计算效率的较好平衡。

- 决策级融合 (Decision-level Fusion):两个模态的数据分别通过独立的检测网络进行推理,最终在输出层(即检测结果层面)进行融合(如加权平均、非极大值抑制-NMS)。这种方式容错性高,适合快速集成现有模型,但计算成本相对较高。

- 检测头与输出:融合后的丰富特征会送入检测头(Head),进行目标分类和边界框回归,最终输出检测结果。

📊 性能表现

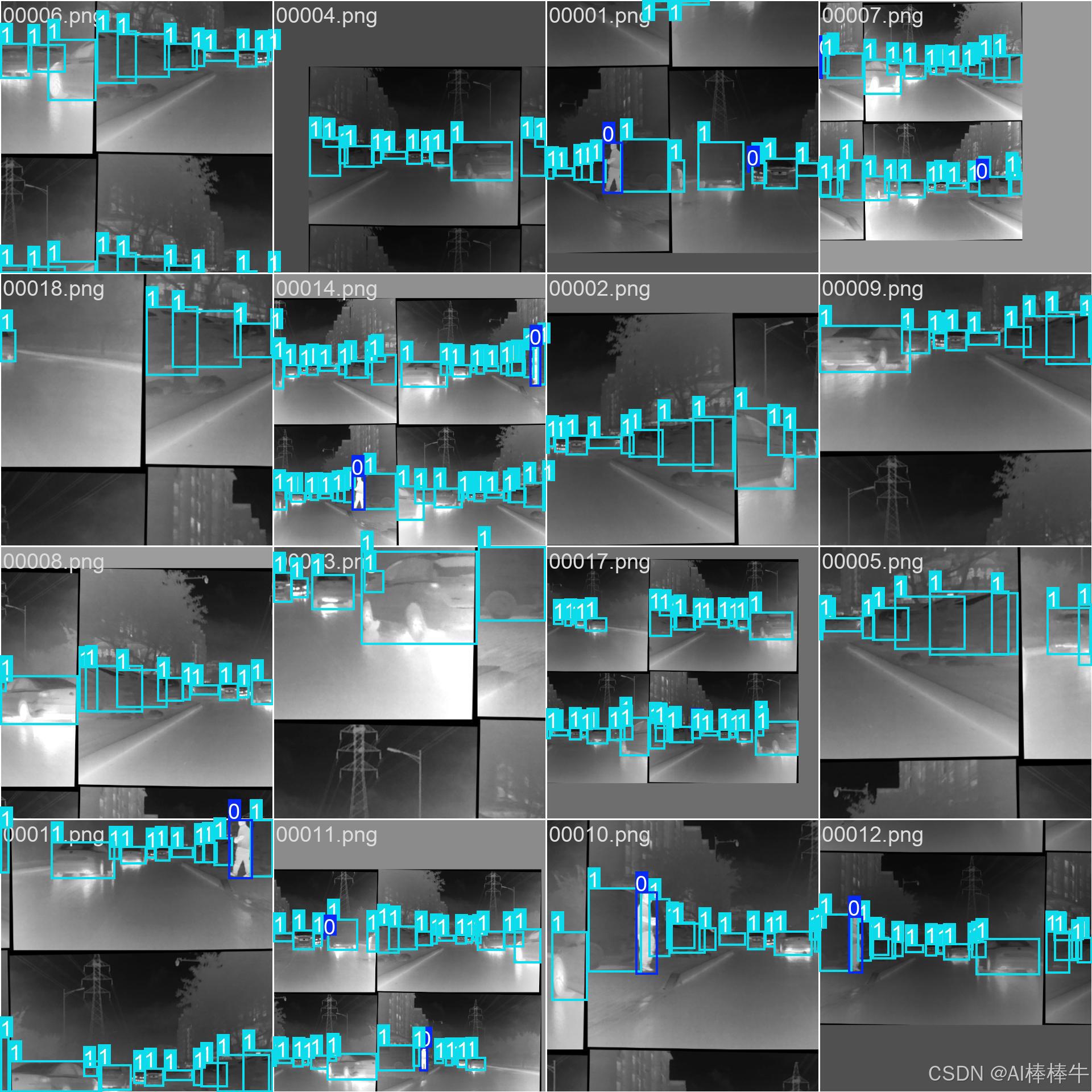

根据在 LLVIP(可见光-红外配对行人检测数据集)上的基准测试结果,YOLOFuse 相比传统的单模态 YOLO 模型展现出了显著优势:

| 模型架构 | 模态 | 精度 § | 召回率 ® | mAP@50 | mAP@50:95 | 模型大小 (MB) | 计算量 (GFLOPs) |

|---|---|---|---|---|---|---|---|

| YOLOv8n (baseline) | RGB | 0.888 | 0.829 | 0.891 | 0.500 | 6.20 | 8.1 |

| YOLO-Fuse-中期特征融合 | RGB+IR | 0.951 | 0.881 | 0.947 | 0.601 | 2.61 | 3.2 |

| YOLO-Fuse-早期特征融合 | RGB+IR | 0.950 | 0.896 | 0.955 | 0.623 | 5.20 | 6.7 |

| YOLO-Fuse-决策级融合 | RGB+IR | 0.956 | 0.905 | 0.955 | 0.612 | 8.80 | 10.7 |

表:YOLOFuse 在 LLVIP 数据集上的性能表现对比

这表明引入红外信息并通过适当方式融合,能有效提升模型在复杂场景下的感知能力。

🛠️ 如何使用改进后的代码包

数据准备

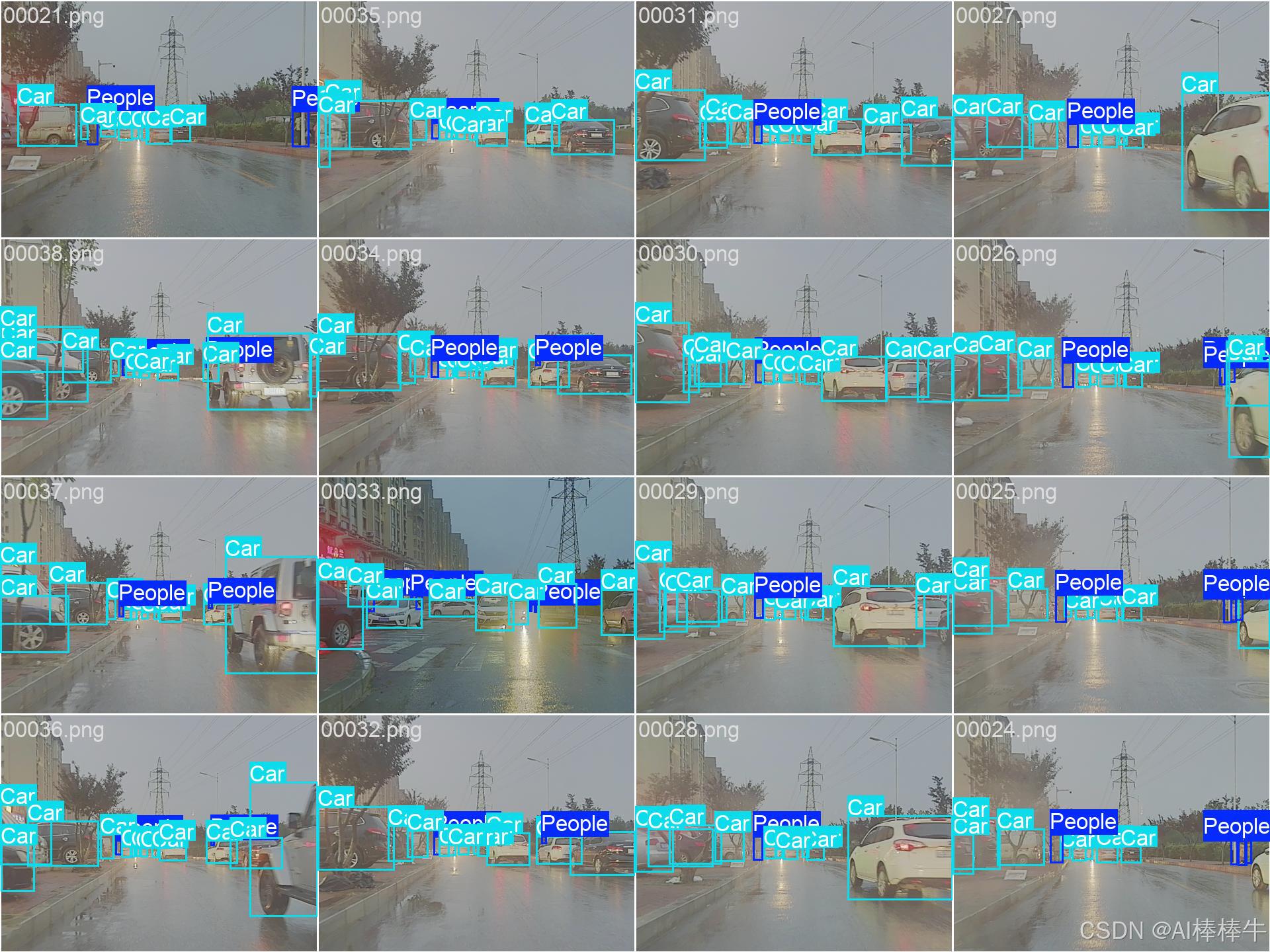

我给大家配置了默认的M3FD.yaml,大家可以直接在代码中使用,然后按照自己的数据进行简单的替换就行!非常简单!

# Ultralytics YOLO , AGPL-3.0 license

# M3FD dataset

# Example usage: yolo train data=M3FD.yaml

# Train/val/test sets as dir: path/to/imgs

path: # dataset root dir

train: images/train # train visible images (relative to 'path')

train2: imagesTR/train # train infrared images (relative to 'path')

val: images/val # val visible images (relative to 'path')

val2: imagesIR/val # val infrared images (relative to 'path')

test: # test images (optional)

#image_weights: True

nc: 6

# Classes

names:

0: People

1: Car

2: Bus

3: Motorcycle

4: Lamp

5: Truck

环境配置

大家使用YOLOv11的环境完全可以跑通!

我给大家配置了云服务器的环境大家可以一键操作,上传代码跑通就行!下方是视频教程,一文搞定哈!

模型训练

- 训练:YOLOFuse 提供了训练的脚本。本文提供了更为简洁的训练脚本。一键跑通!

from ultralytics import YOLO

model = YOLO("ultralytics/cfg/models/V11-Mid-level/yolo11-Mid-level-Copy1.yaml")

# results = model.train(data="coco128.yaml", epochs=20, imgsz=640,ch=3)

results = model.train(data="M3FD.yaml", epochs=20, imgsz=640,ch=6 )

上述yaml中,ch=3的配置(注释掉的)为单模态的数据集训练配置,两者可自由切换!

🌐 应用场景

YOLO+的多模态融合 使其在众多要求苛刻的场景中具有巨大潜力:

- 安防监控与边境巡逻:融合可见光与热成像,实现24小时全天候监控,有效应对低光照、雾霾、伪装等挑战。

- 自动驾驶与智能交通:结合 RGB 摄像头和激光雷达 (LiDAR) 或毫米波雷达,精准感知车辆、行人、障碍物,提升不同天气条件下的安全性。

- 工业检测与自动化:在生产线上,融合可见光、红外或深度信息,高效检测产品缺陷(如苹果检测、电路板故障)、引导机械臂精准操作。

- 灾害救援与公共安全:通过分析红外热成像快速在烟雾、废墟中定位生命体,提升搜救效率。

- 农业监测:如同甘肃农业大学的研究,利用 RGB-D 数据精准识别果实,为自动化采摘提供视觉支持。

改进策略

目前在此项目中,截止发文时,多模态融合改进已经达到20+种,持续永久更新!足够小伙伴发文参考的需要!关注本upB站,更多干货,助力快速科研!!!!!!

写在最后

学术因方向、个人实验和写作能力以及具体创新内容的不同而无法做到一通百通,所以本文作者即B站Up主:Ai学术叫叫兽

在所有B站资料中留下联系方式以便在科研之余为家人们答疑解惑,本up主获得过国奖,发表多篇SCI,擅长目标检测领域,拥有多项竞赛经历,拥有软件著作权,核心期刊等经历。因为经历过所以更懂小白的痛苦!因为经历过所以更具有指向性的指导!

祝所有科研工作者都能够在自己的领域上更上一层楼!!!

所有科研参考资料均可点击此链接,合适的才是最好的,希望我的能力配上你的努力刚好合适!

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)