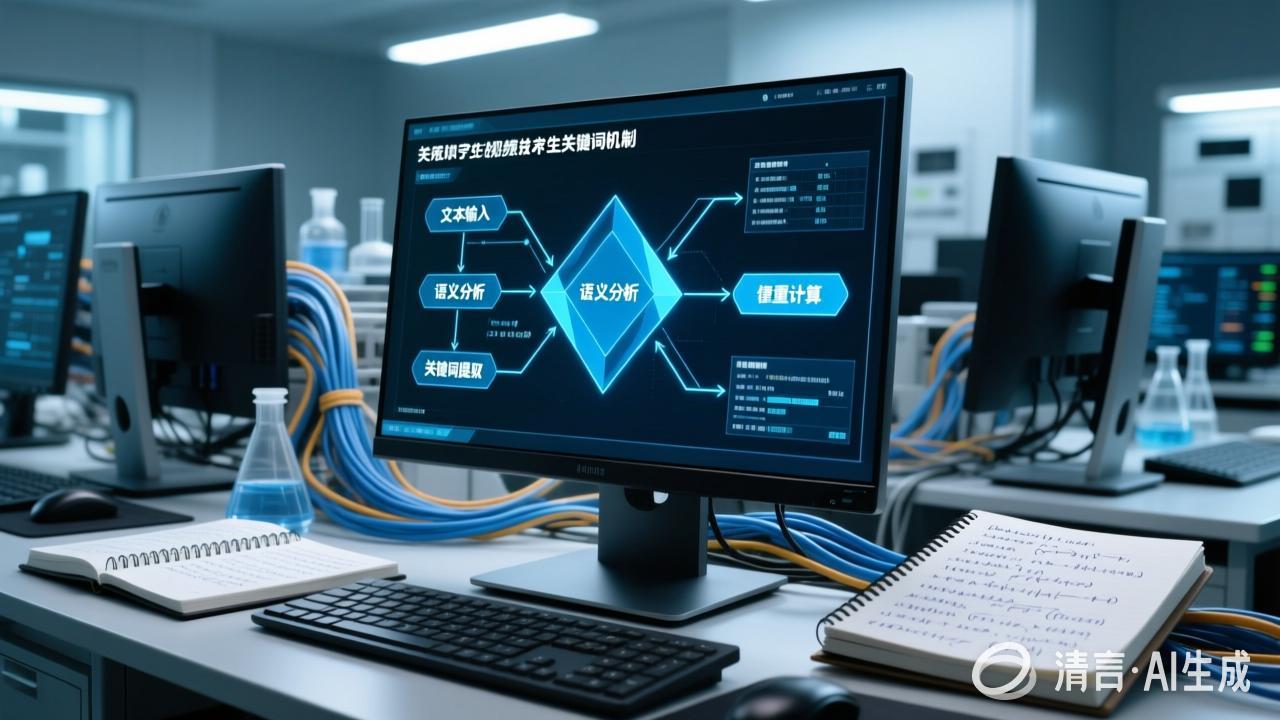

文字生视频技术中关键词提炼的原理与机制分析

本文系统分析了文字生视频技术的核心机制,重点探讨了关键词提炼在视频生成中的关键作用。文章梳理了该技术的发展脉络和主要技术派系,详细阐述了文本语义理解、关键词提取算法、跨模态对齐等关键技术环节。研究显示,现代系统通过TF-IDF、TextRank等算法结合深度学习模型实现高质量关键词提取,并利用扩散模型等生成机制将文本语义转化为视频内容。随着OpenAI Sora等突破性模型的推出,该技术正快速演进

文字生视频技术作为人工智能领域最新突破性成果,已能够将文本描述忠实地转化为高质量视频内容。本文深入分析该技术中关键词提炼的原理和机制,探讨提取关键词如何用于控制视频生成过程。

一、文字生视频技术的整体架构与工作流程

1.1 技术发展脉络

文字生视频技术建立在多个AI技术突破的基础上,其发展可追溯到以下关键节点:

- 2020年:PaLM模型首次展现出通过文本生成视频的初步能力,奠定了多模态生成的基础

- 2023年:相关技术取得重大突破,开始能够生成具有一定连贯性的视频帧

- 2024年2月:OpenAI推出Sora模型,能够生成长达60秒的高保真视频,代表了该领域的里程碑

- 2024年6月:OpenAI又发布了Lumiere模型,在视频质量上进一步提升

1.2 现有技术派系

根据多个资料,当前文字生视频技术主要分为以下几种派系:

| 技术派系 | 核心原理 | 代表模型 | 优缺点 |

|---|---|---|---|

| 扩散模型派系 | 基于噪声预测和去除的过程生成视频 | OpenAI Sora、Lumiere | 能生成高质量细节,但速度较慢、计算资源需求大 |

| 生成对抗网络派系 | 通过生成器和判别器的对抗训练生成内容 | 早期视频生成模型 | 结构稳定,但生成内容多样性受限 |

| Transformer派系 | 利用自注意力机制处理时空序列 | VideoCrafter | 在处理长时序依赖性上有优势,但对硬件要求极高 |

| 多模态融合派系 | 融合多种模态信息引导视频生成 | 微软MistralVideo | 生成内容更加丰富,能处理复杂场景描述 |

1.3 系统级工作流程

根据多种资料,现代文字生视频系统通常遵循以下工作流程:

- 文本处理与关键词提取:分析输入文本,提取关键概念、对象和动作

- 语义理解与增强:通过预训练模型增强文本描述,如Sora使用GPT模型将简短提示扩展为详细描述

- 视频表示学习:将视频分解为时空块或关键帧,如Sora使用"视频压缩网络"将视频转换为低维潜在空间数据

- 条件生成:基于文本语义引导,通过扩散过程或其它生成机制生成视频表示

- 视频重建与细化:将生成的表示重建为完整视频,并进行细节增强和后处理

二、自然语言处理在视频生成中的关键作用

2.1 文本理解与语义提取机制

在文字生视频系统中,NLP技术扮演着基础但复杂的关键角色:

-

深度语言理解:模型需要准确理解输入文本的语义、情感和上下文关系。这通常通过预训练语言模型(如BERT、GPT系列)的编码层来实现,这些模型能够捕捉词汇间的复杂依赖关系。

-

多粒度抽象表示:系统需要在不同粒度级别上表示文本语义:

- 单词/短语级别:识别基本概念和实体

- 句子级别:理解语法结构和从句关系

- 文本片段级别:把握整体主题和场景描述

-

跨模态语义对齐:根据文本和视频模态之间的对齐是关键环节,系统需要在潜在语义空间中找到两种模态的共同表示,确保生成的视频与文本描述在语义上一致。

2.2 关键词提取的高级策略

现代文字生视频系统中,关键词提取已超越简单的频率统计,采用多种高级策略:

-

基于预训练语言模型的关键词抽取:系统使用BERT等预训练模型识别文本中最具信息量的词汇和短语,考虑词汇重要性和独特性。

-

TextRank图排序算法:例如将文本视为图结构,通过PageRank-like算法计算词汇重要性得分,实现无监督关键词提取。

-

TF-IDF与统计显著性:结合 corpus-level 统计信息,识别在语料库中具有区分性的词汇。

-

词性标注与依存句法分析:基于语法结构识别关键名词、动词和形容词,理解词汇间的依存关系,提取描述主体和关键动作。

-

语义角色标注:识别文本中的动作执行者、承受者等语义成分,这对视频生成中的角色定位尤为重要。

TextRank算法因其无需预先训练且仅利用单篇文档信息的特点,被广泛应用于视频生成前的关键词提取过程。

2.3 实体识别与动作解析

系统需要将提取的关键词进一步分类为以下几类,以控制视频生成:

| 类别 | 描述 | 作用于视频生成的方面 |

|---|---|---|

| 主体实体 | 描述视频中主要人物、物体或概念 | 确定视频主体和内容焦点 |

| 属性特征 | 描述颜色、形状、大小、风格等视觉特性 | 控制主体的视觉表现 |

| 动作与行为 | 描述运动、交互或变化 | 生成动态内容和动作序列 |

| 场景元素 | 指定地点、环境、背景等 | 构建视频场景和环境 |

| 情感与氛围 | 表达情绪、气氛、风格等 | 影响色彩、构图和整体感觉 |

三、关键词提炼的核心算法与实现机制

3.1 TF-IDF在视频生成中的应用

TF-IDF(Term Frequency-Inverse Document Frequency)是最基础的关键词提取方法之一。其在文字生视频系统中的应用有特殊考虑:

-

适应视频语料库的TF-IDF变体:系统通常使用专门针对视频描述文本训练的IDF权重,使得关键词提取更符合视频内容特点。

-

局部与全局权重结合:同时考虑词在单个句子中的重要性和在整个描述文本中的分布情况。

-

视觉词汇增强:增加视觉相关词汇的权重,确保生成的视频能够准确反映文本中视觉描述。

3.2 TextRank算法原理与实现

TextRank作为一种无监督学习方法,被多个文字生视频系统采用。其在视频生成中的应用原理如下:

-

图构建过程:

- 将文本预处理后得到的词汇构建为图节点

- 如果两个词在文本中相邻或在语义上相关,则建立边连接

- 边的权重反映词汇共现频率或语义相似度

-

PageRank-like评分:通过迭代计算节点重要性得分,公式为:

rank(v) = (1 - d) + d * Σ(rank(u)/L(u))其中,u链接到v,L(u)是u的外链数,d是阻尼系数。

-

关键词选择:根据节点得分选择排名靠前的词汇作为关键词。

相比TF-IDF,TextRank能更好地捕捉词汇间的语义关系,提取的关键词更具描述性,更适合视频这种需要丰富语义理解的生成任务。

3.3 基于深度学习的关键词提取方法

现代文字生视频系统越来越多地采用深度学习技术进行关键词提取:

-

BERT-based提取模型:利用BERT等预训练模型的语义理解能力,识别文本中最具信息量的词汇。这种方法考虑了词汇的上下文依赖关系和语义重要性。

-

注意力机制应用:使用注意力机制识别文本中关键信息所在的位置,对重要词汇赋予更高权重。

-

条件随机字段(CRF):结合全局特征和序列依赖关系,更准确地识别关键词边界和组成。

-

强化学习优化:根据生成视频的质量反馈,优化关键词提取策略,使提取的关键词更有利于生成高质量视频。

3.4 关键词图谱构建与关系挖掘

仅仅提取关键词是不够的,系统还需要理解关键词之间的关系:

-

实体关系识别:识别关键词之间的主谓宾、修饰等语法和语义关系。

-

知识图谱增强:系统可能接入知识图谱,丰富关键词的语义信息,例如理解"泰坦尼克号"不仅是一艘船,还与"沉没"、“1912年”、"灾难"等概念相关。

-

事件结构分析:识别关键词如何组成事件,包括时间顺序、因果关系等,这对于生成动态视频至关重要。

-

图结构表示:将关键词及其关系构建为图结构,作为视频生成的语义引导图。

四、视频生成中的文本语义理解与对齐机制

4.1 跨模态对齐的重要性

文本-视频对齐是文字生视频技术的核心挑战:

-

语义空间映射:将文本语义空间与视频视觉特征空间进行映射,确保两者语义的一致性。

-

时间维度对齐:处理文本中的时序信息与视频帧序列之间的对应关系。

-

事件结构对齐:确保文本描述的事件在视频中得到正确的时间安排和呈现。

-

属性特征对齐:将文本中的属性描述(如颜色、形状、动作方式)与视频中的视觉元素相对应。

4.2 基于潜在空间的对齐方法

现代文字生视频系统通常在潜在空间进行跨模态对齐:

-

潜在表示学习:Sora使用视频压缩网络将视频转换为低维潜在空间数据,再进行处理。这种方法使得不同模态数据能在低维空间中找到统一表示。

-

对齐损失函数:在训练过程中使用对比学习(contrastive learning)或其它技术,使相同语义的文本向量和视频向量在潜在空间中靠近。

-

时序建模:在潜在空间中保留或重建视频的时序信息,确保生成视频的连贯性。

4.3 视频生成的条件控制机制

提取的关键词通过以下机制控制视频生成过程:

-

条件向量构建:将关键词表示整合为条件向量,指导生成模型。

-

分层控制结构:

- 高层控制:确定视频整体风格、场景和主要事件

- 中层控制:安排视频中的主要动作序列和事件发展

- 低层控制:精确控制每一帧的视觉内容和变化

-

时序规划:根据关键词的时序关系和重要性,规划视频内容的时间安排。

-

注意力引导:在生成过程中,使用注意力机制将重点聚焦在重要关键词对应的内容上。

4.4 扩散模型中的关键词控制机制

对于基于扩散模型的文字生视频技术:

-

前向扩散:将清晰的视频表示逐步添加噪声的过程。

-

反向扩散:根据文本语义信息,逐步去除噪声,恢复清晰视频的过程。在每一步中,文本关键词提供指导信号,帮助模型做出正确的去噪决策。

-

条件扩散:扩散模型在每一步迭代中都融入文本关键词条件信息,确保生成结果与文本描述一致。

-

预训练视觉特征:模型通过预训练学习大量视觉概念,在接收到关键词时能激活相应的视觉特征生成。

五、预训练模型与多模态融合

5.1 大型预训练模型的作用

预训练模型在文字生视频技术中发挥着关键作用:

-

多模态预训练:模型如CLIP、DALL·E等在大规模文本-图像/视频对上预训练,学习跨模态对齐。

-

文本编码器:通常使用BERT、GPT或其变体作为文本编码器,提供强大的语义理解能力。

-

视觉编码器:用于理解目标视频特征,通常基于ResNet、Vision Transformer等架构。

-

参数量与能力:Sora拥有150亿参数,Lumiere拥有650亿参数,大规模参数使模型能够更好地理解复杂语义并生成高质量视频。

5.2 多模态融合策略

根据66,现代文字生视频系统采用多种多模态融合策略:

-

特征空间融合:将文本特征和视觉特征投影到同一特征空间,进行点积或加法融合。

-

注意力机制融合:让文本和视觉特征通过注意力机制相互作用,实现跨模态信息流。

-

门控融合:使用门控机制控制模态间信息流动,如使用文本信息门控视觉特征的激活。

-

时序对齐:特别在视频生成中,需要将文本特征与视频的时间序列对齐,可能使用时序注意力或动态对齐网络。

5.3 跨模态对齐与一致性保证

文本到视频模型的质量很大程度上取决于训练数据中文本与视频之间的对齐程度:

-

高质量训练数据:

- 使用自动标注技术生成更精确的视频文本描述

- 应用数据清洗技术,去除低质量或不一致的样本

-

对齐机制:

- 使用动态时间规整(DTW)等技术处理不同长度的文本和视频序列

- 在训练过程中引入对齐损失,鼓励模型学习文本和视频之间的对应关系

-

自监督对齐:利用视频自身的时空结构和文本的语法语义结构,在没有显式标注的情况下学习对齐。

六、视频生成中的关键帧检测与场景分割

6.1 关键帧检测方法

关键帧检测在视频生成中发挥着重要作用:

-

基于聚类的方法:将视频帧聚类,选择每个聚类的中心帧作为关键帧。

-

基于熵的方法:计算帧的熵或变差,选择信息量最大的帧作为关键帧。

-

深度学习方法:使用CNN或RNN识别视频中的重要场景和动作,标记关键帧。

-

时序动作定位:识别视频中动作的起始、高峰和结束点,作为关键帧候选。

6.2 场景分割技术

场景分割对视频生成至关重要,尤其对于长视频:

-

基于变化检测的方法:通过检测视频中显著的亮度、颜色或结构变化来分割场景。

-

基于深度学习的方法:使用RNN、LSTM或Transformer捕捉视频的长期依赖关系,识别场景边界。

-

多粒度分割:同时在不同时间粒度上进行分割,捕捉不同尺度的场景变化。

-

语义场景理解:结合语义理解,基于内容意义进行场景分割,而不仅仅是视觉变化。

6.3 关键帧与关键词的对应

关键词与关键帧之间的有效对应是确保视频生成与文本描述一致的关键:

-

双向对齐:建立关键词序列和关键帧序列之间的对应关系,确保每个重要关键词都有对应的关键帧展示。

-

注意力矩阵:使用注意力矩阵记录每个关键词对每个关键帧的贡献度,指导视频生成。

-

时序定位:为关键词添加时间信息,指导其在视频中的出现时机。

-

事件结构对齐:将文本描述的事件结构与视频的关键帧序列相对应,确保事件的因果关系在视频中得到正确呈现。

七、商业产品中的关键词提炼实现

7.1 OpenAI Sora/Lumiere的技术实现

OpenAI的Sora和Lumiere模型具有以下特点:

-

技术架构:

- 基于扩散模型和Transformer架构

- 使用"时空潜在块"(spacetime patches)作为基本处理单元

- 将视频压缩到低维潜在空间,便于处理

-

文本理解机制:

- 使用GPT模型将用户简短提示扩展为更详细、更富有描述性的文本

- 应用re-captioning技术增强视频-文本对齐

-

关键词提取与控制:

- 提取文本中的高频且具有代表性的词汇作为关键词

- 分析句子结构,揭示文本中各个成分之间的关系

- 通过条件向量形式融入扩散模型的反向过程

-

主要特性:

- Sora可生成长达60秒的高清视频

- Lumiere在视频质量上更进一步,但生成速度较慢

7.2 国内云服务厂商实现

国内主要云服务厂商已纷纷推出文字生视频服务:

-

百度智能云"泉":

- 支持根据文本描述自动生成视频

- 提供数字人视频创作功能

- 支持多种模态融合,包括文本、图像等

-

腾讯云"混元":

- 依托腾讯云TMH平台打造的文生视频模型

- 能根据文本内容生成视频,支持提示词控制

- 结合腾讯丰富的多媒体技术生态

-

阿里云:

- 提供文生视频API服务

- 支持自定义参数控制输出视频特性

- 与阿里云视觉智能平台集成

这些服务在关键词提炼方面普遍采用了基于深度学习的方案,结合TextRank等图排序算法,以及领域特定的TF-IDF优化技术。

7.3 关键词提炼的商业挑战

文字生视频服务在关键词提炼方面面临以下商业挑战:

-

算力成本:高质量的关键词提取和语义分析需要大量算力支持,增加了服务成本。

-

生成速度:例如Sora模型虽然能生成高质量视频,但速度较慢,用户通常需要等待几分钟才能获得生成结果。

-

算力和设备需求升级:随着模型规模增大,对硬件设备特别是GPU/TPU的需求不断提升。

-

内容控制与审核:自动内容生成带来的内容安全挑战,需要额外的技术和流程保障。

八、技术发展趋势与未来方向

8.1 更精细的语义理解

文字生视频技术在关键词提炼方面的未来发展趋势包括:

-

细粒度事件理解:更深入理解文本中描述的事件结构,包括事件的参与者、动作、时间、地点和因果关系。

-

常识推理能力:结合未明确表达的常识知识,推断文本描述中隐含的语义信息。

-

多级抽象表示:同时把握文本的不同抽象层次,从具体细节到整体主题。

-

跨文化语义理解:增强对不同文化背景和语言习惯的适应性,支持多语言文字生视频。

8.2 更高效的对齐机制

提升文本与视频的对齐效率是未来重要方向:

-

轻量级对齐模型:开发计算效率更高的对齐模型,减少资源消耗。

-

层次化对齐策略:在不同抽象层次上实现文本和视频的对齐,从低级视觉特征到高级语义概念。

-

自适应对齐:根据输入文本和生成视频的特性,动态调整对齐策略。

-

多模态融合架构创新:探索更有效的多模态融合网络架构,如联合Transformer变体。

8.3 交互式关键词控制

未来系统可能会提供更精细的交互式关键词控制:

-

关键词权重调整:允许用户调整关键词的相对重要性,控制其在视频中的表现程度。

-

视觉特征指定:让用户为关键词指定具体的视觉特征,如颜色、风格、视角等。

-

时序调整接口:允许用户调整关键词在视频中出现的时间点或持续时长。

-

生成空间探索:帮助用户探索不同关键词组合可能带来的视频生成结果差异。

8.4 创新应用场景拓展

文字生视频技术将开辟多种创新应用场景:

-

创意内容创作加速:大幅降低视频制作门槛,使个人创作者也能生产专业级视频内容。

-

教育内容自动生成:根据教学大纲或知识点描述自动生成教学视频。

-

个性化广告创作:根据受众特征和营销目标自动生成个性化广告视频。

-

历史事件或科幻场景可视化:将文字记录或科幻设定转化为逼真视频。

-

辅助设计与预览:在影视制作、游戏开发等领域提供创意参考和前期预览。

文生视频技术有望带动算力和设备需求升级,推动相关产业链发展。

九、总结与展望

文字生视频技术中的关键词提炼是连接自然语言理解和视频生成的关键桥梁。通过对文本进行深度语义分析、提取关键信息并构建合适的控制机制,系统能够将文字描述忠实地转化为视觉上逼真、内容上准确的视频内容。

从技术层面看,TF-IDF、TextRank等传统方法与BERT、GPT等深度学习模型相结合,形成了当前主流的关键词提取解决方案。在未来,随着跨模态对齐技术的进步和更强大的预训练模型出现,文字生视频技术将朝着更高真实感、更精细控制和更低使用门槛的方向发展。

这一技术的成熟将极大地降低视频内容创作的门槛,为创意表达提供更多可能性,同时也为AI带来更多令人期待的应用场景。随着OpenAI等公司不断推出突破性模型,文字生视频技术正迅速发展,并有望成为未来媒体内容创作的重要工具。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)