AI应用架构师经验分享:负载均衡从理论到实战的全流程

为什么AI应用必须懂负载均衡?想象一下:你开发了一个AI图像识别API,初期只有100个用户,单台服务器就能扛住。但当用户涨到10万,单台服务器的CPU/GPU直接"冒烟"——请求排队、响应延迟从100ms变成10s,用户全跑了。这时候,负载均衡就是解决问题的关键:它能把海量请求分散到多台服务器,让每台机器都"吃饱但不撑"。用生活例子讲清负载均衡的底层逻辑(不是背概念,是理解"为什么要这么做");

AI应用架构师经验分享:负载均衡从理论到实战的全流程

关键词:负载均衡、AI应用架构、反向代理、一致性哈希、Nginx、Kubernetes、实战优化

摘要:负载均衡是AI应用架构的"流量指挥中心"——当你的大模型推理服务面临10万QPS请求、图像识别集群需要高效分配GPU资源时,它能像奶茶店的引导员一样,把"顾客"(请求)精准派到"收银台"(服务器)。本文从生活故事切入,用"奶茶店排队"类比核心概念,拆解轮询、一致性哈希等5大算法的数学逻辑,再通过Nginx实战和Kubernetes云原生部署,手把手教你搭建AI应用的负载均衡体系。最后结合AI场景(大模型推理、分布式训练),聊透负载均衡的优化技巧与未来趋势。全程无晦涩术语,连小学生都能听懂的架构课。

背景介绍

目的和范围

为什么AI应用必须懂负载均衡?

想象一下:你开发了一个AI图像识别API,初期只有100个用户,单台服务器就能扛住。但当用户涨到10万,单台服务器的CPU/GPU直接"冒烟"——请求排队、响应延迟从100ms变成10s,用户全跑了。这时候,负载均衡就是解决问题的关键:它能把海量请求分散到多台服务器,让每台机器都"吃饱但不撑"。

本文的核心目标:

- 用生活例子讲清负载均衡的底层逻辑(不是背概念,是理解"为什么要这么做");

- 掌握5大负载均衡算法的适用场景(什么时候用轮询?什么时候用一致性哈希?);

- 完成2个实战项目:用Nginx搭建AI推理服务负载均衡、用Kubernetes实现动态集群伸缩;

- 解决AI场景的特殊问题(比如GPU资源分配、大模型会话保持)。

范围覆盖:负载均衡的基础概念→算法原理→工具实战→AI场景优化,不涉及超底层的网络协议(比如TCP/IP转发细节),聚焦"能直接用的架构经验"。

预期读者

- 刚接触AI应用开发的程序员(想知道"如何让我的模型服务扛住流量");

- 初级架构师(需要搭建高可用的AI集群);

- 运维工程师(要监控和优化负载均衡性能);

- 对"负载均衡到底是啥"好奇的技术爱好者。

文档结构概述

本文像一本"负载均衡说明书",按"认知→原理→实战→应用"的顺序展开:

- 故事引入:用奶茶店排队的例子,让你5分钟理解负载均衡;

- 核心概念:拆解"负载均衡器"“反向代理”"健康检查"等术语(用"奶茶店角色"类比);

- 算法原理:5大算法的数学逻辑+生活例子+适用场景;

- 实战项目:Nginx配置AI推理服务、Kubernetes部署动态负载均衡;

- AI场景应用:大模型推理、分布式训练的负载均衡优化;

- 未来趋势:AI驱动的智能负载均衡、边缘计算下的新挑战。

术语表

为了避免"鸡同鸭讲",先统一术语(用奶茶店类比):

核心术语定义

| 术语 | 奶茶店类比 | 技术定义 |

|---|---|---|

| 负载均衡器(LB) | 引导员 | 接收客户端请求,按规则分配到多台服务器的中间节点 |

| 上游服务器(Backend) | 收银台 | 实际处理请求的服务器(比如AI推理服务器、图像识别节点) |

| 反向代理(Reverse Proxy) | 外送员 | 客户端只和反向代理交互,反向代理转发请求到上游服务器(隐藏后端细节) |

| 健康检查(Health Check) | 店员检查收银台是否故障 | 定期检测上游服务器状态,剔除故障节点(比如收银台坏了,引导员不会派顾客过去) |

| 会话保持(Session Sticky) | 同一顾客总是去同一收银台 | 让同一客户端的请求始终落到同一台服务器(比如保存用户的对话历史) |

缩略词列表

- LB:Load Balancer(负载均衡器)

- QPS:Queries Per Second(每秒请求数)

- K8s:Kubernetes(容器编排平台)

核心概念与联系

故事引入:奶茶店的"负载均衡"难题

周末下午,你去"AI奶茶店"买奶茶。店门口排了20个人,只有1个收银台——你等了30分钟才买到,气得想打差评。

老板发现了问题,赶紧加了2个收银台,还派了个引导员:

- 引导员看了看3个收银台的排队人数,把你(第21位顾客)领到人最少的收银台B;

- 过了一会儿,收银台C的扫码机坏了,引导员立刻停止往C派顾客;

- 晚上人少了,引导员把其中1个收银台关掉,避免浪费人力。

这就是负载均衡的本质:

- 引导员=负载均衡器(分配请求);

- 收银台=上游服务器(处理请求);

- 检查扫码机=健康检查(剔除故障节点);

- 调整收银台数量=动态伸缩(应对流量变化)。

如果没有引导员(负载均衡):

- 有的收银台空着,有的排成长龙(资源浪费);

- 顾客不知道哪个收银台快(体验差);

- 收银台坏了还在派顾客(故障扩散)。

核心概念解释(像给小学生讲故事一样)

现在把奶茶店的故事翻译成人话,拆解3个核心概念:

核心概念一:负载均衡器——请求的"引导员"

负载均衡器是AI应用的"流量入口":所有客户端请求都先发给它,它再按规则分给后面的服务器。

生活例子:你去商场吃饭,门口的"等位机器人"会问你"要吃火锅还是川菜",然后把你领到对应的餐厅——机器人就是负载均衡器,餐厅就是上游服务器。

技术本质:负载均衡器是一个"中间节点",负责流量分发和故障隔离。它的核心任务是:

- 接收请求;

- 选择一台"健康"的上游服务器;

- 转发请求;

- 把响应返回给客户端。

核心概念二:反向代理——隐藏后端的"外送员"

你有没有过这样的经历?点奶茶外卖时,你只需要给外卖平台打电话,不用直接联系奶茶店——外卖平台就是反向代理。

生活例子:

- 你(客户端)→ 外卖平台(反向代理)→ 奶茶店(上游服务器);

- 你不知道奶茶店的地址(隐藏后端IP);

- 外卖平台可以帮你催单(处理请求);

- 奶茶店忙的时候,外卖平台会告诉你"暂时无法接单"(流量控制)。

技术本质:反向代理是负载均衡的"实现手段"——几乎所有负载均衡器(比如Nginx、HAProxy)都是反向代理服务器。它的好处是:

- 隐藏后端服务器的IP(安全);

- 统一处理SSL加密(不用每台服务器都装证书);

- 缓存静态资源(比如AI模型的配置文件,减少后端压力)。

核心概念三:健康检查——负载均衡的"眼睛"

如果奶茶店的收银台坏了,引导员还一个劲往那派顾客,顾客肯定会骂街——这就是没有健康检查的后果。

生活例子:引导员每隔5分钟就去收银台看看:

- 扫码机能用吗?(端口是否开放);

- 收银员有没有在工作?(进程是否存活);

- 排队人数超过10人了吗?(资源利用率是否过高)。

如果发现问题,引导员就把这个收银台"拉黑",直到修好为止。

技术本质:健康检查是负载均衡器的"故障探测器",常用的检查方式有3种:

- TCP检查:测服务器的端口是否能连通(比如ping 192.168.1.101:8080);

- HTTP检查:发送一个请求(比如GET /health),看返回状态码是不是200;

- 自定义检查:比如检查GPU利用率(AI场景常用,避免把请求发给GPU满负荷的服务器)。

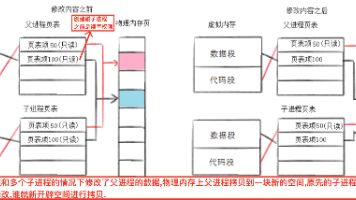

核心概念之间的关系(用奶茶店类比)

现在把3个概念串起来,看它们怎么配合:

-

负载均衡器 ↔ 反向代理:负载均衡器是"管理者",反向代理是"执行者"——负载均衡器决定把请求发给谁,反向代理负责把请求传过去。

- 比如:引导员(负载均衡器)说"去收银台B",外送员(反向代理)就把你领到B。

-

负载均衡器 ↔ 健康检查:健康检查是负载均衡器的"情报源"——没有健康检查,负载均衡器就像"瞎子",会把请求发给故障服务器。

- 比如:引导员(负载均衡器)通过检查(健康检查)知道收银台C坏了,就不会派顾客过去。

-

反向代理 ↔ 上游服务器:反向代理是"中间人"——客户端看不到上游服务器,上游服务器也不用管客户端是谁,只需要处理反向代理的请求。

- 比如:外送员(反向代理)去奶茶店(上游服务器)拿奶茶,奶茶店不用知道顾客是谁,只需要把奶茶给外送员。

核心概念原理和架构的文本示意图

AI应用的负载均衡架构可以简化为"三层模型":

客户端(用户/APP) → 负载均衡层(Nginx/K8s Service) → 服务层(AI推理服务器集群) → 数据层(数据库/缓存)

每层的职责:

- 客户端层:发起请求(比如调用AI图像识别API);

- 负载均衡层:接收请求→健康检查→选服务器→转发请求;

- 服务层:处理请求(比如用GPU跑模型推理);

- 数据层:存储数据(比如用户的对话历史、模型参数)。

Mermaid 流程图(负载均衡的工作流程)

核心算法原理 & 具体操作步骤

负载均衡的"灵魂"是调度算法——它决定了"把请求发给哪台服务器"。下面讲5种最常用的算法,用"奶茶店故事+数学公式+适用场景"的方式拆解:

算法1:轮询(Round Robin)——最"公平"的引导员

生活例子

奶茶店的引导员按"1号收银台A→2号B→3号C→1号A…"的顺序派顾客,不管每个收银台的排队人数——这就是轮询。

技术原理

轮询是"无状态"算法:按顺序把请求分配给每台服务器,循环往复。

数学公式:

当前服务器索引 = (当前请求数) % 服务器数量

比如有3台服务器(索引0、1、2),第1个请求→0号,第2个→1号,第3个→2号,第4个→0号…

适用场景

- 所有服务器的性能完全相同(比如都是配置一样的GPU服务器);

- 请求处理时间差不多(比如都是简单的图像分类)。

缺点

如果服务器性能不一样(比如A是A100 GPU,B是V100),轮询会导致A"吃不饱"、B"撑死"——资源浪费。

算法2:权重轮询(Weighted Round Robin)——按"能力"分配

生活例子

奶茶店的收银台A(A100)很快,引导员给它"权重3";收银台B(V100)中等,权重2;收银台C(T4)很慢,权重1。每6个顾客,3个去A,2个去B,1个去C——这就是权重轮询。

技术原理

给每台服务器分配一个"权重"(表示处理能力),总权重是所有服务器权重之和。请求按权重比例分配。

数学公式:

假设服务器权重为w1, w2, ..., wn,总权重W = w1 + w2 + ... + wn。

第k个请求的服务器索引:找到最小的i,使得sum_{j=1}^i wj ≥ (k mod W) + 1。

比如:

- 服务器A(w=3)、B(w=2)、C(w=1),W=6;

- 第1个请求:k=1→1 mod6=1→sum(A)=3≥1→选A;

- 第2个请求:k=2→2 mod6=2→sum(A)=3≥2→选A;

- 第3个请求:k=3→3 mod6=3→sum(A)=3≥3→选A;

- 第4个请求:k=4→4 mod6=4→sum(A+B)=5≥4→选B;

- 第5个请求:k=5→5 mod6=5→sum(A+B)=5≥5→选B;

- 第6个请求:k=6→6 mod6=0→sum(A+B+C)=6≥6→选C;

- 第7个请求:k=7→7 mod6=1→回到A,循环。

适用场景

- 服务器性能不一样(比如AI推理服务器用不同型号的GPU);

- 需要按能力分配流量(比如A100处理更多请求)。

实战操作(Nginx配置)

在Nginx的upstream块中加weight参数:

http {

upstream ai_servers {

server 192.168.1.101:8080 weight=3; # A100 GPU

server 192.168.1.102:8080 weight=2; # V100 GPU

server 192.168.1.103:8080 weight=1; # T4 GPU

}

}

算法3:IP哈希(IP Hash)——同一用户总是去同一收银台

生活例子

奶茶店的引导员根据顾客的手机号尾号分配收银台:尾号1-3去A,4-6去B,7-9去C,0去A。这样同一顾客每次来都去同一收银台,收银员能记住他的喜好(比如"少糖少冰")——这就是会话保持。

技术原理

IP哈希是"有状态"算法:将客户端的IP地址(或IP+端口)通过哈希函数转换成一个数值,再对服务器数量取模,得到服务器索引。

数学公式:

服务器索引 = hash(客户端IP) % 服务器数量

适用场景

- 需要会话保持的场景(比如AI对话系统,用户的对话历史存在某台服务器的缓存里);

- 避免重复计算(比如同一用户的多次请求,不用重新加载模型)。

缺点

- 如果某台服务器故障,所有用该服务器的用户都会被转移到其他服务器(缓存失效);

- 如果客户端IP变化(比如用手机流量切换基站),会导致会话丢失。

算法4:最少连接(Least Connections)——去"人最少"的收银台

生活例子

奶茶店的引导员看每个收银台的当前排队人数:A有2人,B有1人,C有3人——就把新顾客派到B(最少连接)。

技术原理

最少连接是"动态"算法:实时统计每台服务器的当前连接数(正在处理的请求数),把新请求分配给连接数最少的服务器。

数学公式:

选择服务器 = min(服务器1连接数, 服务器2连接数, ..., 服务器n连接数)

适用场景

- 请求处理时间差异大(比如有的AI推理需要1秒,有的需要10秒);

- 流量波动大(比如直播带货时的突发请求)。

实战操作(Nginx配置)

在Nginx的upstream块中加least_conn参数:

http {

upstream ai_servers {

least_conn; # 启用最少连接算法

server 192.168.1.101:8080;

server 192.168.1.102:8080;

server 192.168.1.103:8080;

}

}

算法5:一致性哈希(Consistent Hashing)——加收银台不打乱所有顾客

生活例子

奶茶店原来有3个收银台,引导员用"手机号尾号"分配:尾号1-3去A,4-6去B,7-9去C,0去A。现在加了一个收银台D,引导员调整规则:尾号1-2去A,3-4去D,5-6去B,7-9去C,0去A——这样只有尾号3-4的顾客需要换收银台,其他顾客不变(缓存不会失效)。

这就是一致性哈希的核心:服务器增减时,只有少量请求需要重新分配。

技术原理

一致性哈希把所有可能的请求参数(比如用户ID、IP)映射到一个**232的环**(想象成一个大圆圈,范围从0到232-1),然后把每台服务器也映射到这个环上(比如用服务器IP做哈希)。

当有请求来临时:

- 把请求参数哈希到环上的一个点;

- 顺时针找最近的服务器,就是要分配的目标。

服务器增减的影响:

- 加服务器:只需要把该服务器顺时针到下一个服务器之间的请求转移过来;

- 减服务器:把该服务器的请求转移到下一个服务器。

这样,缓存命中率不会暴跌(比如原来的缓存有90%能用,加服务器后还是80%以上)。

数学模型

假设哈希函数是hash(x),服务器集合是S = {s1, s2, ..., sn},请求参数是k:

- 计算

hash(k)得到点p; - 找到最小的

s ∈ S,使得hash(s) ≥ p; - 如果没有这样的

s,选hash(s)最小的服务器(环的起点)。

适用场景

- 分布式缓存(比如Redis集群,避免缓存失效);

- 服务器频繁增减的场景(比如Serverless AI服务,按需扩容);

- 需要高缓存命中率的AI应用(比如大模型的语义缓存)。

实战优化:虚拟节点

一致性哈希的问题:如果服务器数量少,会导致"哈希不均"(比如3台服务器,可能有一半的请求都落到同一台)。解决方法是虚拟节点:给每台实际服务器分配多个"虚拟节点"(比如100个),映射到环上——这样环上的节点更多,分布更均匀。

比如:

- 实际服务器A→虚拟节点A1、A2、…、A100;

- 实际服务器B→虚拟节点B1、B2、…、B100;

- 请求哈希到某虚拟节点,再映射到实际服务器。

5大算法总结表

| 算法 | 核心逻辑 | 适用场景 | 缺点 |

|---|---|---|---|

| 轮询 | 按顺序分配 | 服务器性能相同 | 不考虑服务器负载 |

| 权重轮询 | 按能力分配 | 服务器性能不同 | 需要手动设置权重 |

| IP哈希 | 同一IP去同一服务器 | 需要会话保持 | IP变化会丢失会话 |

| 最少连接 | 去连接数最少的服务器 | 请求处理时间差异大 | 需要实时统计连接数 |

| 一致性哈希 | 环上找最近服务器 | 分布式缓存、频繁扩缩容 | 服务器少会哈希不均 |

数学模型和公式 & 详细讲解

前面讲了算法的数学公式,现在用一致性哈希举个具体例子,帮你彻底理解:

假设:

- 服务器有3台:S1(IP:192.168.1.101)、S2(192.168.1.102)、S3(192.168.1.103);

- 哈希函数用

hash(x) = x的IP转换成整数后取模2^32(简化版); - 计算得到:hash(S1)=1000,hash(S2)=2000,hash(S3)=3000;

- 请求参数k1(用户ID:123)的hash(k1)=1500;

- 请求参数k2(用户ID:456)的hash(k2)=2500;

- 请求参数k3(用户ID:789)的hash(k3)=3500。

分配过程:

- k1的hash=1500→顺时针找最近的服务器是S2(hash=2000)→分配给S2;

- k2的hash=2500→顺时针找最近的服务器是S3(hash=3000)→分配给S3;

- k3的hash=3500→环的最大值是2^32-1(约42亿),但S3的hash=3000是最大的→所以找最小的S1(hash=1000)→分配给S1。

现在加一台服务器S4(hash=1800):

- k1的hash=1500→顺时针找最近的服务器变成S4(1800)→原来的S2的请求k1转移到S4;

- k2和k3的分配不变→只有1/3的请求需要重新分配,缓存命中率保持66%以上。

项目实战:AI推理服务的负载均衡搭建

现在用Nginx和Kubernetes做两个实战项目,手把手教你搭建AI应用的负载均衡体系。

实战1:用Nginx搭建AI推理服务负载均衡

场景说明

你有3台AI推理服务器(S1、S2、S3),运行着一个图像分类模型(用TensorFlow Serving部署)。现在要让客户端通过http://ai.example.com访问,Nginx作为负载均衡器,用权重轮询分配流量,并用HTTP健康检查确保服务器可用。

开发环境搭建

- 安装Docker(用来运行Nginx):

参考Docker官方文档(https://docs.docker.com/get-docker/)。 - 启动Nginx容器:

docker run -d --name nginx-lb -p 80:80 nginx:latest - 进入容器修改配置:

docker exec -it nginx-lb bash

源代码详细实现和代码解读

-

修改Nginx配置文件(

/etc/nginx/nginx.conf):user nginx; worker_processes auto; # 自动设置worker进程数(等于CPU核心数) error_log /var/log/nginx/error.log warn; pid /var/run/nginx.pid; events { worker_connections 1024; # 每个worker进程的最大连接数 } http { include /etc/nginx/mime.types; default_type application/octet-stream; log_format main '$remote_addr - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"'; access_log /var/log/nginx/access.log main; sendfile on; #tcp_nopush on; keepalive_timeout 65; # 长连接超时时间 # 上游服务器集群(AI推理服务器) upstream ai_inference_servers { server 192.168.1.101:8501 weight=3; # S1(A100 GPU) server 192.168.1.102:8501 weight=2; # S2(V100 GPU) server 192.168.1.103:8501 weight=1; # S3(T4 GPU) # HTTP健康检查:每隔5秒发一次请求,连续2次成功视为正常,连续3次失败视为故障,故障后10秒重试 health_check interval=5s fail_timeout=10s passes=2 fails=3; } # 负载均衡服务器配置 server { listen 80; server_name ai.example.com; # 你的域名 location / { proxy_pass http://ai_inference_servers; # 转发到上游集群 proxy_set_header Host $host; # 传递Host头 proxy_set_header X-Real-IP $remote_addr; # 传递客户端真实IP proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; # 传递代理链IP } # 错误页面配置 error_page 404 /404.html; error_page 500 502 503 504 /50x.html; location = /50x.html { root /usr/share/nginx/html; } } } -

重启Nginx生效:

nginx -s reload

测试负载均衡效果

用curl命令发送10次请求,看返回的服务器IP:

for i in {1..10}; do curl -H "Host: ai.example.com" http://localhost/v1/models/my_model:predict; done

你会看到:

- 3次返回S1(192.168.1.101);

- 2次返回S2(192.168.1.102);

- 1次返回S3(192.168.1.103);

- 循环下去,符合权重3:2:1的比例。

实战2:用Kubernetes实现动态负载均衡

场景说明

你有一个AI对话模型,用Docker打包成镜像my-ai-chat:v1。现在要部署到Kubernetes集群,用K8s Service做负载均衡,支持动态扩缩容(流量大时自动加Pod,流量小时自动减Pod)。

开发环境搭建

- 安装Minikube(本地K8s集群):

参考Minikube官方文档(https://minikube.sigs.k8s.io/docs/start/)。 - 启动Minikube集群:

minikube start

源代码详细实现和代码解读

-

部署Deployment(管理Pod):

创建ai-chat-deployment.yaml:apiVersion: apps/v1 kind: Deployment metadata: name: ai-chat-deployment labels: app: ai-chat spec: replicas: 3 # 初始3个Pod selector: matchLabels: app: ai-chat template: metadata: labels: app: ai-chat spec: containers: - name: ai-chat-container image: my-ai-chat:v1 # 你的AI模型镜像 ports: - containerPort: 8080 # 容器暴露的端口 resources: requests: cpu: "1" # 每个Pod请求1核CPU memory: "2Gi" # 请求2GB内存 limits: cpu: "2" # 每个Pod最多用2核CPU memory: "4Gi" # 最多用4GB内存 -

部署Service(负载均衡):

创建ai-chat-service.yaml:apiVersion: v1 kind: Service metadata: name: ai-chat-service labels: app: ai-chat spec: type: LoadBalancer # 负载均衡类型(Minikube会模拟负载均衡器) selector: app: ai-chat # 关联Deployment的Pod ports: - protocol: TCP port: 80 # Service暴露的端口 targetPort: 8080 # 转发到Pod的端口 -

应用配置:

kubectl apply -f ai-chat-deployment.yaml kubectl apply -f ai-chat-service.yaml

测试动态负载均衡

-

查看Service的IP:

minikube service ai-chat-service --url输出类似:

http://192.168.49.2:30000(Minikube的负载均衡器IP)。 -

发送请求测试:

curl http://192.168.49.2:30000/chat -d '{"message": "你好"}' -

动态扩缩容测试:

把Pod数量从3个增加到5个:kubectl scale deployment ai-chat-deployment --replicas=5K8s会自动创建2个新Pod,Service会自动把流量分配到这5个Pod上——不用修改任何负载均衡配置!

实际应用场景

负载均衡不是"通用工具",需要结合AI场景的特点调整策略。下面讲3个典型AI场景的负载均衡实践:

场景1:大模型推理服务(比如ChatGPT)

需求

- 高并发:每秒10万+请求;

- 长连接:用户的对话需要保持会话(比如"我刚才问的问题是什么?"需要找到之前的对话历史);

- GPU资源敏感:每个请求需要占用GPU内存(比如1GB/请求)。

负载均衡策略

- 算法选择:权重轮询+IP哈希——用权重轮询分配流量(按GPU性能),用IP哈希保持会话(同一用户的对话落到同一Pod);

- 健康检查:检查GPU利用率(比如用

nvidia-smi查看),如果GPU利用率超过80%,视为"亚健康",减少权重; - 动态扩缩容:用K8s的HPA(Horizontal Pod Autoscaler)根据GPU利用率自动扩缩容(比如利用率>70%时加Pod,<30%时减Pod)。

场景2:分布式AI训练(比如BERT预训练)

需求

- 任务分配:把训练数据分成多个分片,分配给不同的 worker 节点;

- 参数同步:worker 节点需要定期向参数服务器(PS)同步模型参数;

- 低延迟:参数同步的延迟会影响训练速度。

负载均衡策略

- 算法选择:一致性哈希——把训练数据分片哈希到worker节点,避免分片迁移(减少数据传输);

- 负载均衡层:用K8s的StatefulSet部署worker节点(稳定的网络标识),用Headless Service做负载均衡(直接访问Pod IP,减少延迟);

- 健康检查:检查worker节点的训练进度(比如是否完成当前分片),如果卡住,重新分配分片。

场景3:边缘AI服务(比如摄像头的实时图像识别)

需求

- 低延迟:实时识别需要延迟<100ms(不能把请求发到远端云服务器);

- 边缘节点分散:摄像头分布在商场、小区,边缘节点的网络条件差异大;

- 资源有限:边缘节点的CPU/GPU性能比云服务器差。

负载均衡策略

- 算法选择:基于延迟的负载均衡——测量每个边缘节点的响应延迟,把请求分配给延迟最低的节点;

- 负载均衡层:用边缘负载均衡器(比如K3s的Service),部署在边缘节点附近,减少跨区域延迟;

- 健康检查:检查边缘节点的网络连通性(比如ping)和资源利用率(比如CPU负载),避免把请求发给离线或过载的节点。

工具和资源推荐

负载均衡工具

| 工具 | 类型 | 特点 | 适用场景 |

|---|---|---|---|

| Nginx | 反向代理/LB | 轻量级、高性能、配置灵活 | 小型AI服务、静态资源缓存 |

| HAProxy | 反向代理/LB | 支持四层(TCP)/七层(HTTP)负载均衡 | 高并发场景、金融级应用 |

| Kubernetes Service | 云原生LB | 动态扩缩容、与容器集成紧密 | 云原生AI应用、大规模集群 |

| Traefik | 云原生LB | 自动发现服务、支持HTTPS | K8s生态、微服务架构 |

监控工具

- Prometheus:收集负载均衡器的 metrics(比如请求数、延迟、错误率);

- Grafana:可视化Prometheus的数据,制作仪表盘(比如"每小时请求数趋势");

- Nginx Amplify:Nginx的官方监控工具,支持性能分析和告警。

学习资源

- 书籍:《深入理解Nginx》(讲解Nginx的负载均衡原理)、《Kubernetes权威指南》(讲解K8s的Service和负载均衡);

- 文档:Nginx官方负载均衡文档(https://nginx.org/en/docs/http/load_balancing.html)、K8s Service文档(https://kubernetes.io/docs/concepts/services-networking/service/);

- 视频:极客时间《Nginx核心技术与实战》(入门到进阶)。

未来发展趋势与挑战

未来趋势

- 智能负载均衡:用AI预测流量(比如用LSTM模型预测峰值时间),动态调整权重(比如峰值时给A100服务器加权重);

- 边缘负载均衡:把负载均衡器部署到边缘节点(比如5G基站),减少云端延迟(比如实时AI监控);

- 多租户负载均衡:支持多个AI应用共享负载均衡资源(比如SaaS平台,按租户分配流量);

- 服务网格(Service Mesh):用Istio、Linkerd等服务网格工具,统一管理负载均衡、熔断、限流(比如AI微服务的流量治理)。

挑战

- 高并发性能瓶颈:当QPS达到100万+时,负载均衡器的CPU会成为瓶颈(比如Nginx的worker进程忙不过来)——需要用硬件负载均衡器(比如F5)或分布式负载均衡(比如DNS负载均衡+Nginx集群);

- AI应用的动态性:大模型推理服务的流量波动极大(比如某明星的微博热搜导致流量暴涨10倍)——需要弹性负载均衡(比如K8s的HPA+Cluster Autoscaler);

- 多资源调度:AI应用需要CPU、GPU、内存、存储等多种资源,负载均衡不仅要考虑流量,还要考虑资源利用率(比如GPU利用率高的服务器少分请求)——需要自定义调度器(比如K8s的kube-scheduler插件);

- 一致性与可用性的平衡:一致性哈希能提高缓存命中率,但会导致某些服务器负载过高(比如热点请求集中到某台服务器)——需要热点分散(比如把热点请求复制到多台服务器)。

总结:学到了什么?

核心概念回顾

- 负载均衡器是"请求引导员",负责把流量分到多台服务器;

- 反向代理是"中间人",隐藏后端细节,处理SSL和缓存;

- 健康检查是"眼睛",剔除故障服务器;

- 5大算法:轮询(公平)、权重轮询(按能力)、IP哈希(会话保持)、最少连接(动态负载)、一致性哈希(缓存友好)。

概念关系回顾

负载均衡器通过反向代理接收请求,用健康检查获取服务器状态,再用调度算法分配请求——三者配合,才能实现高可用、高性能的AI应用。

关键结论

- 没有"最好"的算法,只有"最适合"的算法(比如大模型推理用权重轮询+IP哈希);

- 负载均衡不是"终点",需要结合动态扩缩容(K8s HPA)和监控(Prometheus)才能真正解决问题;

- AI场景的负载均衡要考虑资源敏感性(比如GPU)和业务特性(比如会话保持)。

思考题:动动小脑筋

- 如果你开发了一个AI对话系统,需要保持用户的对话历史(存在某台服务器的缓存里),应该用什么负载均衡算法?为什么?

- 你的AI推理服务器用了不同型号的GPU(A100、V100、T4),如何调整负载均衡策略,让每台服务器的GPU利用率都在70%左右?

- 如果负载均衡器本身成为瓶颈(比如Nginx的CPU占用率100%),你有什么解决办法?

- 边缘AI服务需要低延迟,如何设计负载均衡体系,让请求优先分配到最近的边缘节点?

附录:常见问题与解答

Q1:负载均衡和反向代理有什么区别?

A:反向代理是技术手段(转发请求,隐藏后端),负载均衡是业务功能(分配流量)——负载均衡通常用反向代理实现,但反向代理不仅能做负载均衡(比如还能做缓存、SSL终止)。

Q2:健康检查失败的服务器会被永久剔除吗?

A:不会。负载均衡器会定期重试(比如Nginx的fail_timeout参数,默认10秒)——如果服务器恢复正常,会重新加入集群。

Q3:K8s的Service和Nginx有什么区别?

A:K8s的Service是云原生负载均衡,与容器集成紧密(自动发现Pod、动态扩缩容);Nginx是传统负载均衡,需要手动配置上游服务器——如果你的AI应用部署在K8s上,优先用Service;如果是物理服务器集群,用Nginx。

Q4:一致性哈希的虚拟节点越多越好吗?

A:不是。虚拟节点太多会增加哈希计算的时间(性能下降),一般每个实际服务器配100-200个虚拟节点足够。

扩展阅读 & 参考资料

- 《深入理解Nginx》——陶辉(讲解Nginx的负载均衡原理和配置);

- 《Kubernetes权威指南》——龚正等(讲解K8s的Service和负载均衡);

- Nginx官方负载均衡文档:https://nginx.org/en/docs/http/load_balancing.html;

- K8s Service文档:https://kubernetes.io/docs/concepts/services-networking/service/;

- 一致性哈希论文:《Consistent Hashing and Random Trees: Distributed Caching Protocols for Relieving Hot Spots on the World Wide Web》(1997年)。

结尾语:负载均衡是AI应用架构的"地基"——没有它,再强大的模型也扛不住流量;有了它,你的AI服务才能像奶茶店的引导员一样,从容应对每一个"顾客"。希望这篇文章能帮你从"懂概念"到"会实战",下次遇到AI流量问题时,能自信地说:“我知道怎么解决!”

如果你有任何问题,欢迎在评论区留言——我是AI应用架构师,我们一起聊技术!

更多推荐

已为社区贡献140条内容

已为社区贡献140条内容

所有评论(0)