为什么你问一个问题,AI 要“思考”好几秒?

大模型推理为何慢?揭秘AI生成背后的计算瓶颈。不同于搜索引擎查表,大模型采用自回归生成方式,需逐字计算上下文,每生成一个字就完整跑一次推理。性能瓶颈主要来自:1)KVCache显存占用过高;2)序列长度二次方级计算复杂度;3)批处理效率低下。当前优化方向包括vLLM的显存分页管理和参数量化技术。AI的"思考"实则是千亿次数学运算的累加过程。

你有没有这样的体验:

在对话框里输入“讲个笑话”,然后看着加载圈转了两三秒,AI才慢悠悠地回你一句“从前有个程序员……”?

明明是机器,为什么不能像搜索引擎一样秒出结果?

难道它真在“思考”?

真相是:AI 的“思考”,其实是数学计算的累加。

每一个字,都是上万个参数在显卡上疯狂运算的结果。

今天,我们就来揭开大模型推理背后的“延迟黑箱”——

为什么生成一句话要花几秒?瓶颈在哪?未来如何提速?

一、推理 ≠ 查表:AI 不是背答案,而是“逐字写作文”

很多人以为,大模型像一本百科全书,你问问题,它查一下就答。

但事实恰恰相反:大模型不会“回忆”,它只会“生成”。

它的回答过程,就像一个学生在考试时从头写作文——

一个字一个字地“写”出来,而且每写一个字,都要重新理解整段上下文。

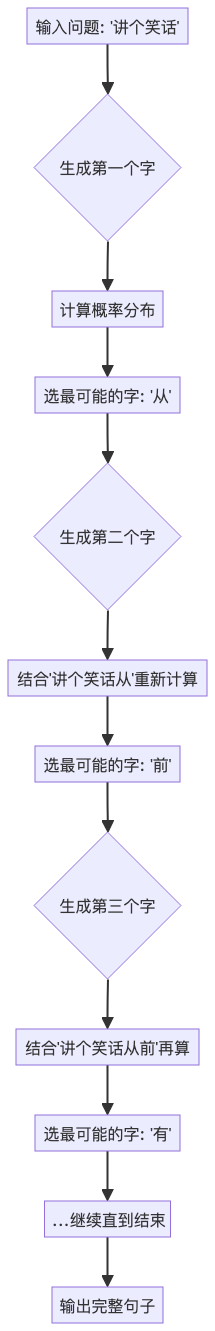

这个过程,叫做 自回归生成(Autoregressive Generation)。

🌀 自回归生成流程图(Mermaid)

每一步都依赖前一步的输出,像多米诺骨牌,一步接一步。

二、生成一个字,到底要算什么?

你以为只是“选个字”?

其实每一步,模型都在做一次 完整的前向推理:

- 把你输入的提示(Prompt) + 已生成的所有字,拼成一个序列;

- 将这个序列送入 Transformer 模型;

- 计算每个位置的注意力(Attention);

- 输出下一个字的概率分布;

- 按策略选一个字(比如最可能的,或随机采样);

- 把这个字加进去,重新来一遍。

也就是说:

生成第10个字时,模型已经完整跑了10次推理。

序列越长,计算越重,速度越慢。

三、生成策略:AI 怎么决定下一个字?

模型算出每个字的概率后,怎么选?不同策略影响速度和质量。

|

策略 |

原理 |

速度 |

多样性 |

|

贪婪搜索(Greedy) |

每次选概率最高的字 |

⚡️快 |

❌低(容易重复) |

|

随机采样(Sampling) |

按概率随机选 |

中等 |

✅高(更自然) |

|

束搜索(Beam Search) |

保留多个候选路径 |

❌慢 |

中等 |

例如:生成“人工智能是__”,模型可能给出:

- “伟大的”(概率 30%)

- “未来的”(25%)

- “复杂的”(20%)

贪婪搜索直接选“伟大的”,采样可能随机选“未来的”,束搜索则同时探索多个可能路径。

束搜索最准,但也最慢——它相当于让AI同时写5篇作文,最后挑最好的。

四、为什么这么慢?三大性能瓶颈

别怪AI反应慢,它背负着三个沉重的包袱:

瓶颈一:KV Cache 显存爆炸

Transformer 模型的核心是 注意力机制,它需要记住前面所有字的信息。

为了提速,模型会缓存每一步的 Key 和 Value 向量(即 KV Cache)。

但问题来了:

每生成一个字,KV Cache 就增大一点。

- 一个 32 层的 Llama-2-7B 模型,

- 处理 2048 长度序列,

- KV Cache 占用显存高达 1.6GB!

📌 KV Cache 占了总显存的 60% 以上,严重限制了并发能力。

瓶颈二:长序列拖慢整体速度

Transformer 的计算复杂度是 序列长度的平方(O(n²))。

这意味着:

|

序列长度 |

计算量(相对) |

|

512 |

1x |

|

1024 |

4x |

|

2048 |

16x |

2048 长度的计算量,是 512 的 16 倍!

你输入一篇长文,AI 不是“读一遍”,而是对每个字都“回头看全文”——

越往后,越慢。

瓶颈三:批处理效率低

理想情况下,GPU 应该同时处理多个请求,发挥并行优势。

但现实中:

- 用户提问时间随机,请求不整齐;

- 每个请求生成长度不同(有人问“你好”生成2字,有人让写千字文);

- 导致 GPU 利用率低,经常“等最后一个任务”。

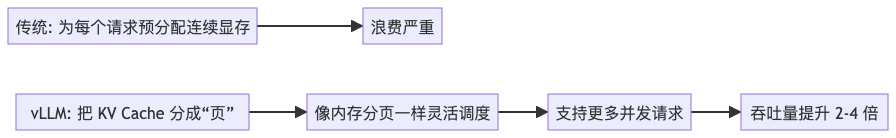

传统推理框架(如 Hugging Face Transformers)采用 Per-Request 管理,资源浪费严重。

五、如何提速?两大方向破局

面对瓶颈,技术正在进化。

✅ 方向一:优化 KV Cache 管理 —— vLLM

vLLM(由伯克利推出)提出 PagedAttention 技术,灵感来自操作系统内存分页。

vLLM 让显存利用率从 30% 提升到 70%+,成为 LLM 服务的新标准。

✅ 方向二:模型瘦身 —— 量化(Quantization)

大模型参数通常是 FP16(16位浮点数),占显存大。

量化技术 把参数压缩成 INT8 甚至 INT4:

|

精度 |

每参数大小 |

显存节省 |

速度提升 |

质量影响 |

|

FP16 |

2 字节 |

- |

- |

基准 |

|

INT8 |

1 字节 |

50% |

~20% |

轻微 |

|

INT4 |

0.5 字节 |

75% |

~40% |

可接受 |

7B 模型从 14GB → 6GB,能在消费级显卡上跑起来。

结语:AI 的“思考”,是数学的马拉松

下次当你看到 AI “思考”几秒才回复,

请记住:

它不是在犹豫,而是在用千亿次计算,

为你生成一个合适的字。

🔔 金句:AI 的‘思考’,其实是数学计算的累加。

而我们正在做的,就是让这场计算更快、更高效、更普惠。

作者简介:

本文作者为AI系统架构师,专注高可用机器学习服务平台设计。欢迎关注我的公众号【一只鱼丸yo】,获取更多AI工程化实战经验。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)