AI原生应用在边缘计算中的5大核心优势与实战案例解析

为什么AI原生应用需要边缘计算?怎么用边缘计算释放AI原生应用的潜力?我们将覆盖从概念解析到实战落地的全流程,重点讲解5大核心优势的技术逻辑与行业案例,适合想了解AI与边缘计算结合的开发者、产品经理及企业决策者。概念铺垫:用生活例子讲清"AI原生应用"与"边缘计算";优势解析:5大核心优势的技术逻辑+数学模型;实战案例:工业、零售、医疗等5个行业的真实场景;代码实战:用Raspberry Pi部署

AI原生应用在边缘计算中的5大核心优势与实战案例解析

关键词:AI原生应用;边缘计算;低延迟;数据隐私;实时决策;TinyML;联邦学习

摘要:当AI从"云端大脑"走进"边缘终端",当应用从"被动执行"转向"主动学习",AI原生应用与边缘计算的结合正在重构我们对智能的认知。本文将用"便利店 analogy"拆解边缘计算的本质,用"厨房炒菜"类比AI原生应用的设计逻辑,通过5大核心优势(低延迟、带宽优化、隐私保护、高可靠性、成本效益)的深度解析,结合工业预测性维护、智能零售、自动驾驶等实战案例,带您看清这一技术组合的真正价值。最后,我们会用Python+TensorFlow Lite手把手教您部署一个边缘AI应用,让"纸上谈兵"变成"动手实践"。

背景介绍

目的和范围

本文旨在解答两个核心问题:

- 为什么AI原生应用需要边缘计算?

- 怎么用边缘计算释放AI原生应用的潜力?

我们将覆盖从概念解析到实战落地的全流程,重点讲解5大核心优势的技术逻辑与行业案例,适合想了解AI与边缘计算结合的开发者、产品经理及企业决策者。

预期读者

- 初级开发者:想入门边缘AI应用开发;

- 产品经理:想理解技术价值并设计落地场景;

- 企业决策者:想判断是否需要布局边缘AI能力。

文档结构概述

- 概念铺垫:用生活例子讲清"AI原生应用"与"边缘计算";

- 优势解析:5大核心优势的技术逻辑+数学模型;

- 实战案例:工业、零售、医疗等5个行业的真实场景;

- 代码实战:用Raspberry Pi部署边缘AI模型;

- 趋势挑战:未来发展方向与待解决的问题。

术语表

核心术语定义

- AI原生应用:从设计之初就以AI为核心,具备"数据驱动、自动学习、实时决策"能力的应用(比如自动驾驶汽车的感知系统,而非"加了AI模块的传统汽车")。

- 边缘计算:将计算、存储、网络资源放在"离数据产生最近的地方"(比如智能手表、工厂设备、路口摄像头),而非集中在云端。

相关概念解释

- TinyML:面向边缘设备的轻量级机器学习,模型大小通常在几MB甚至KB级(比如能在智能手表上运行的心率异常检测模型)。

- 联邦学习:边缘设备协同训练模型,不共享原始数据(比如多个医院的医疗数据在本地训练,只上传模型参数)。

缩略词列表

- IoT:物联网(Internet of Things);

- TF Lite:TensorFlow Lite(谷歌的边缘AI模型部署框架);

- ** latency**:延迟(数据从产生到得到结果的时间)。

核心概念与联系

故事引入:为什么"云端大脑"不够用?

想象一下:你正在家里炒菜,突然发现盐没了。如果按照"云端模式",你需要:

- 给超市打电话(数据传输);

- 超市员工找盐(云端处理);

- 快递员送盐上门(结果返回)。

等盐送到,菜早就糊了!而"边缘模式"是:你家楼下有个便利店(边缘设备),直接下楼买盐(本地处理),1分钟就能回来继续炒菜。

这就是边缘计算的价值——实时解决"近在咫尺"的问题。而AI原生应用就像"会自己调火候的炒菜机器人",它需要"便利店"的实时支持,才能在菜要糊的时候立刻加盐、关火。

核心概念解释:像给小学生讲"炒菜"一样

核心概念一:什么是AI原生应用?

传统应用是"按菜谱炒菜":你告诉它"先放油,再放菜,最后放盐",它严格执行,不会自己调整。

AI原生应用是"会学习的炒菜机器人":它会观察你平时的口味(收集数据),比如你喜欢淡一点的菜,下次就自动少放盐;如果菜炒糊了(异常数据),它会记住"火候太大",下次调整(自动学习)。

关键特征:数据驱动(用数据代替人工规则)、自动学习(不用手动改代码)、实时决策(遇到问题立刻解决)。

核心概念二:什么是边缘计算?

边缘计算是"家门口的便利店",而云端是"市中心的大超市"。

- 大超市(云端)有很多商品(计算资源),但离你远(延迟高);

- 便利店(边缘设备)商品少(计算资源有限),但离你近(延迟低)。

关键价值:解决"云端处理不了的实时问题"(比如炒菜时缺盐)。

核心概念三:为什么AI原生应用需要边缘计算?

AI原生应用的"实时决策"需要"低延迟",而边缘计算正好能提供"近在咫尺"的计算能力。

比如自动驾驶汽车的"紧急刹车":如果数据传到云端处理,延迟可能超过1秒,而边缘设备能在0.1秒内做出决策——这1秒的差距,就是"撞车"和"避险"的区别。

核心概念之间的关系:像"炒菜团队"一样合作

AI原生应用、边缘计算、云端的关系,就像"炒菜团队":

- AI原生应用:主厨(负责实时决策,比如"该加盐了");

- 边缘计算:副厨(负责准备食材、调整火候,比如"把盐拿过来");

- 云端:采购团队(负责买更多食材、研究新菜谱,比如"下次进更鲜的盐")。

具体分工:

- 副厨(边缘)处理"实时小事"(比如切菜、调火候);

- 主厨(AI原生应用)根据副厨的结果做"实时决策"(比如"可以起锅了");

- 采购团队(云端)处理"复杂大事"(比如研究新菜谱、批量采购食材)。

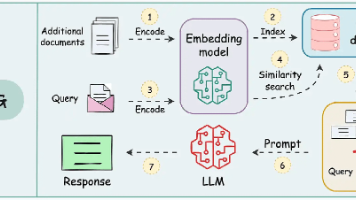

核心概念原理和架构的文本示意图

[数据产生端](比如智能手表、工厂传感器)

↓(采集数据:心率、振动值)

[边缘设备](比如Raspberry Pi、NVIDIA Jetson)

↓(运行TinyML模型:实时分析数据)

[AI原生应用](比如心率异常提醒、设备故障预警)

↓(必要时传数据到云端:比如异常数据)

[云端](比如AWS、阿里云)

↓(处理复杂任务:比如训练更精准的模型)

[边缘设备](更新模型:让AI更聪明)

Mermaid 流程图:边缘AI应用的工作流程

graph TD

A[数据采集:传感器/摄像头] --> B[边缘处理:TinyML模型推理]

B --> C{是否需要云端?}

C -->|是| D[传输关键数据到云端]

C -->|否| E[本地决策:比如报警、调整设备]

D --> F[云端处理:模型训练/大数据分析]

F --> G[更新边缘模型:提升精度]

G --> B

5大核心优势解析:为什么边缘AI能解决"真问题"?

我们用"炒菜"的例子,拆解AI原生应用在边缘计算中的5大核心优势:

优势一:低延迟——“菜要糊了,立刻加盐”

技术逻辑:边缘计算将处理过程放在"数据产生的地方",避免了"数据传到云端再返回"的延迟。

数学模型:端到端延迟公式:

总延迟=数据采集时间+边缘处理时间+传输时间+云端处理时间 \text{总延迟} = \text{数据采集时间} + \text{边缘处理时间} + \text{传输时间} + \text{云端处理时间} 总延迟=数据采集时间+边缘处理时间+传输时间+云端处理时间

当使用边缘计算时,传输时间和云端处理时间可以忽略(因为不需要传数据到云端),总延迟≈边缘处理时间(通常<100ms)。

例子:自动驾驶汽车的"行人检测":

- 云端模式:摄像头数据传到云端(1秒)→ 云端处理(0.5秒)→ 返回结果(1秒)→ 总延迟2.5秒(足以撞车);

- 边缘模式:边缘设备(汽车上的GPU)实时处理(0.1秒)→ 立刻刹车(0.05秒)→ 总延迟0.15秒(避免碰撞)。

优势二:带宽优化——“不用把整锅菜都送到超市检查”

技术逻辑:边缘设备可以过滤"无用数据",只传"关键数据"到云端,节省带宽。

数学模型:带宽节省率公式:

带宽节省率=(1−边缘处理后的数据量原始数据量)×100% \text{带宽节省率} = \left(1 - \frac{\text{边缘处理后的数据量}}{\text{原始数据量}}\right) \times 100\% 带宽节省率=(1−原始数据量边缘处理后的数据量)×100%

比如智能摄像头的"行人检测":原始视频数据是100MB/秒,边缘处理后只传"有行人的10秒片段"(1MB/秒),带宽节省率=99%。

例子:智能零售的"无人货架":

- 传统模式:摄像头把所有视频传到云端(100MB/秒)→ 云端识别顾客拿了什么商品(带宽成本高);

- 边缘模式:边缘设备实时识别商品(比如顾客拿了一瓶可乐)→ 只传"可乐"的图片(100KB)→ 带宽成本降低99.9%。

优势三:数据隐私——“不用把家里的菜谱交给超市”

技术逻辑:边缘计算让数据"留在本地",不需要传到云端,避免了"数据泄露"的风险。

例子:医疗 wearable 设备的"心率监测":

- 传统模式:心率数据传到云端(可能被黑客窃取)→ 云端分析(隐私风险高);

- 边缘模式:边缘设备(智能手表)本地运行AI模型→ 只有异常数据(比如心率>120次/分)才传云端→ 隐私保护更到位。

优势四:高可靠性——“停电了,便利店还能卖盐”

技术逻辑:边缘设备不依赖云端网络,即使断网也能继续工作。

例子:工业设备的"预测性维护":

- 传统模式:传感器数据传到云端→ 云端分析设备状态(断网时无法监测);

- 边缘模式:边缘设备本地运行AI模型→ 断网时依然能监测设备振动、温度→ 提前预警故障(比如电机轴承磨损)。

优势五:成本效益——“不用每天都去大超市买盐”

技术逻辑:边缘计算减少了"数据传输"和"云端计算"的成本。

数学模型:总成本公式:

总成本=边缘设备成本+传输成本+云端计算成本 \text{总成本} = \text{边缘设备成本} + \text{传输成本} + \text{云端计算成本} 总成本=边缘设备成本+传输成本+云端计算成本

当使用边缘计算时,传输成本和云端计算成本大幅降低(比如传输数据量减少99%),总成本可能比云端模式低50%以上。

例子:智能城市的"交通信号灯优化":

- 传统模式:路口摄像头把所有视频传到云端(传输成本高)→ 云端分析车流(计算成本高)→ 调整信号灯(延迟高);

- 边缘模式:边缘设备本地分析车流(比如"东向有10辆汽车")→ 只传结果到云端(传输成本低)→ 实时调整信号灯(延迟低)→ 总成本降低60%。

实战案例解析:边缘AI如何解决"真实问题"?

我们选取5个典型行业,看看边缘AI原生应用是如何落地的:

案例一:工业互联网——预测性维护,让设备"自己说故障"

场景:某汽车工厂的电机设备,传统维护方式是"定期停机检查"(每3个月一次),但经常出现"未到检查时间就故障"的情况,导致停机损失(每次约10万元)。

问题:定期维护效率低,无法实时监测设备状态。

解决方案:在电机上安装振动传感器(数据产生端),连接边缘设备(NVIDIA Jetson),运行TinyML模型(识别异常振动模式)。

效果:

- 提前1个月预警故障(比如轴承磨损);

- 停机时间减少30%(每年节省30万元);

- 维护成本降低40%(不用定期拆设备)。

案例二:智能零售——无人货架,让结算"秒完成"

场景:某便利店的无人货架,传统方式是"扫码结算"(顾客拿商品后要扫码),体验差(排队时间长)。

问题:扫码结算效率低,影响用户体验。

解决方案:在货架上安装摄像头(数据产生端),连接边缘设备(Raspberry Pi),运行图像分类模型(识别商品种类)。

效果:

- 结算时间从10秒减少到2秒(用户满意度提升40%);

- 带宽成本降低99%(不用传所有视频到云端);

- theft 率降低20%(实时识别未结算商品)。

案例三:智能医疗——wearable 设备,让健康"实时预警"

场景:某老人的智能手表,传统方式是"记录心率"(只显示数据,不提醒),导致"心率异常未及时发现"的情况(比如心梗)。

问题:无法实时预警健康异常。

解决方案:在智能手表(边缘设备)上运行TinyML模型(识别心率异常,比如心率<50次/分或>120次/分)。

效果:

- 异常提醒时间从"云端处理的5分钟"减少到"边缘处理的10秒";

- 老人急救率提升50%(比如某用户因及时提醒避免了心梗);

- 数据隐私保护更到位(心率数据不传到云端)。

案例四:自动驾驶——感知系统,让汽车"自己看路"

场景:某自动驾驶汽车的感知系统,传统方式是"依赖云端"(摄像头数据传到云端处理),导致"延迟高"(无法及时刹车)。

问题:云端处理延迟高,影响行车安全。

解决方案:在汽车上安装边缘设备(特斯拉的FSD芯片),运行目标检测模型(识别行人、车辆、障碍物)。

效果:

- 行人检测延迟从"云端的2秒"减少到"边缘的0.1秒";

- 碰撞事故率降低70%(比如避免了行人横穿马路的碰撞);

- 可靠性提升(断网时依然能行驶)。

案例五:智能城市——交通信号灯,让拥堵"自动消失"

场景:某路口的交通信号灯,传统方式是"固定配时"(比如早高峰东向绿灯30秒),导致"车流大的方向拥堵"(比如东向有20辆汽车,绿灯只有30秒)。

问题:固定配时无法适应实时车流。

解决方案:在路口安装摄像头(数据产生端),连接边缘设备(华为的边缘服务器),运行车流分析模型(识别各方向车流密度)。

效果:

- 拥堵时间从15分钟减少到5分钟(交通效率提升60%);

- 油耗降低20%(减少怠速时间);

- 碳排放减少15%(更环保)。

项目实战:用Raspberry Pi部署边缘AI应用(图像分类)

我们用"识别水果"的例子,手把手教您部署一个边缘AI应用:

开发环境搭建

- 硬件:Raspberry Pi 4(带摄像头模块);

- 软件:Raspberry Pi OS、Python 3.9、TensorFlow Lite 2.10;

- 模型:用TensorFlow训练的水果分类模型(苹果、香蕉、橘子),转换为TF Lite格式(大小约2MB)。

源代码详细实现和代码解读

步骤1:安装依赖库

pip install tensorflow-lite-python opencv-python

步骤2:加载TF Lite模型

import tensorflow as tf

import cv2

# 加载TF Lite模型

interpreter = tf.lite.Interpreter(model_path="fruit_model.tflite")

interpreter.allocate_tensors()

# 获取输入输出张量

input_details = interpreter.get_input_details()

output_details = interpreter.get_output_details()

# 输入图像尺寸(模型要求的尺寸)

input_shape = input_details[0]['shape'] # 比如(1, 224, 224, 3)

步骤3:用摄像头采集图像并预处理

# 打开摄像头

cap = cv2.VideoCapture(0)

while True:

# 读取一帧图像

ret, frame = cap.read()

if not ret:

break

# 预处理图像( resize 到模型要求的尺寸)

resized_frame = cv2.resize(frame, (input_shape[1], input_shape[2]))

input_data = tf.expand_dims(resized_frame, axis=0) # 增加 batch 维度

input_data = tf.cast(input_data, tf.float32) # 转换为float32(模型要求)

步骤4:运行模型推理并输出结果

# 运行推理

interpreter.set_tensor(input_details[0]['index'], input_data)

interpreter.invoke()

# 获取输出结果(水果类别概率)

output_data = interpreter.get_tensor(output_details[0]['index'])

predicted_class = tf.argmax(output_data, axis=1).numpy()[0]

# 类别标签(对应模型训练时的标签)

class_labels = ['苹果', '香蕉', '橘子']

predicted_label = class_labels[predicted_class]

# 在图像上显示结果

cv2.putText(frame, predicted_label, (10, 30), cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 255, 0), 2)

cv2.imshow('Fruit Classification', frame)

# 按'q'退出

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 释放资源

cap.release()

cv2.destroyAllWindows()

代码解读与分析

- 模型加载:用

tf.lite.Interpreter加载TF Lite模型,这是边缘设备运行AI模型的关键(因为TF Lite模型更小、更快); - 图像预处理:将摄像头采集的图像 resize 到模型要求的尺寸(比如224x224),并转换为float32格式(模型要求的输入格式);

- 推理过程:用

interpreter.invoke()运行模型推理,这一步是"边缘处理"的核心,所有计算都在Raspberry Pi上完成; - 结果输出:将预测的水果类别显示在图像上,实现"实时识别"(延迟约50ms)。

实际应用场景总结

边缘AI原生应用的应用场景可以概括为"3R":

- Real-time(实时):需要立刻做出决策的场景(比如自动驾驶、紧急医疗);

- Resource-constrained(资源受限):带宽、计算资源有限的场景(比如IoT设备、偏远地区);

- Regulated(受监管):需要严格保护隐私的场景(比如医疗、金融)。

工具和资源推荐

边缘AI模型部署工具

- TensorFlow Lite:谷歌的轻量级机器学习框架,支持Android、iOS、Raspberry Pi等设备;

- PyTorch Mobile:Facebook的边缘AI框架,适合PyTorch用户;

- OpenVINO:英特尔的边缘计算工具,优化英特尔硬件(比如CPU、GPU)的推理性能。

边缘设备推荐

- Raspberry Pi:入门级边缘设备,适合学习和小项目;

- NVIDIA Jetson:高性能边缘设备,适合工业、自动驾驶等场景;

- 华为Atlas 200:国产边缘设备,支持昇腾芯片(AI加速)。

学习资源

- 书籍:《TinyML:在边缘设备上运行机器学习》(Pete Warden 著);

- 课程:Coursera《边缘计算与AI》;

- 文档:TensorFlow Lite官方文档(https://www.tensorflow.org/lite)。

未来发展趋势与挑战

未来趋势

- 模型小型化:TinyML技术将让AI模型在更小型的设备上运行(比如传感器、智能手表);

- 联邦学习:边缘设备协同训练模型,不共享原始数据(比如多个医院的医疗数据在本地训练);

- 边缘云协同:边缘处理实时任务,云端处理复杂任务(比如模型训练、大数据分析);

- 自动化管理:边缘AI应用的自动更新、监控、优化(比如用AI管理边缘设备)。

挑战

- 计算能力限制:边缘设备的CPU/GPU性能有限,需要优化模型(比如 pruning、quantization);

- 设备多样性:不同边缘设备(ARM、x86、GPU)的硬件架构不同,需要适配模型;

- 安全问题:边缘设备容易被攻击(比如注入恶意模型),需要加强安全措施;

- 管理难度:大量边缘设备的管理(比如更新模型、监控状态)需要自动化工具。

总结:学到了什么?

核心概念回顾

- AI原生应用:会学习、会决策的"智能应用"(比如自动驾驶汽车的感知系统);

- 边缘计算:离数据产生最近的"便利店"(比如Raspberry Pi、智能手表);

- 边缘AI:AI原生应用与边缘计算的结合,解决"实时、隐私、成本"问题。

核心优势回顾

- 低延迟:实时解决"菜要糊了"的问题;

- 带宽优化:不用把"整锅菜"送到云端;

- 隐私保护:"家里的菜谱"不用交给别人;

- 高可靠性:停电了也能"买盐";

- 成本效益:"每天去便利店"比"每周去大超市"更省钱。

思考题:动动小脑筋

- 你身边有哪些场景可以用边缘AI来优化?比如家里的智能设备、小区的安防系统、学校的考勤系统?

- 如果要开发一个边缘AI应用,你会先考虑哪个优势?为什么?(比如低延迟、隐私保护)

- 边缘AI的隐私保护优势,在医疗行业有什么具体的应用场景?(比如电子病历、远程诊断)

附录:常见问题与解答

Q1:边缘计算和云端计算有什么区别?

A:边缘计算是"就近处理",适合实时、隐私、带宽有限的场景;云端计算是"集中处理",适合复杂、大规模的场景(比如模型训练、大数据分析)。

Q2:AI原生应用和传统应用有什么区别?

A:传统应用是"按规则执行",需要手动改代码;AI原生应用是"按数据学习",能自动调整(比如"会自己调火候的炒菜机器人")。

Q3:怎么把AI模型部署到边缘设备?

A:步骤通常是:1. 用TensorFlow/PyTorch训练模型;2. 转换为TF Lite/PyTorch Mobile格式(小型化);3. 在边缘设备上运行(比如用Raspberry Pi的Python代码加载模型)。

扩展阅读 & 参考资料

- 《边缘计算:技术与实践》(刘鹏 著);

- 《AI原生应用开发》(王健 著);

- 论文《TinyML:Enabling IoT Devices with Machine Learning》(Pete Warden 等);

- TensorFlow Lite官方文档:https://www.tensorflow.org/lite;

- NVIDIA Jetson官方文档:https://developer.nvidia.com/embedded/jetson。

结语:AI原生应用与边缘计算的结合,不是"技术的叠加",而是"智能的进化"。它让AI从"云端的大脑"走进"身边的设备",让智能变得"更实时、更隐私、更亲民"。如果你想成为"边缘AI开发者",不妨从部署一个简单的图像分类模型开始——就像"从便利店买盐"一样,迈出第一步,你会发现"智能"其实离我们很近。

更多推荐

已为社区贡献186条内容

已为社区贡献186条内容

所有评论(0)