英伟达针对中国市场推出特供芯片B40与B20:技术调整与市场策略分析

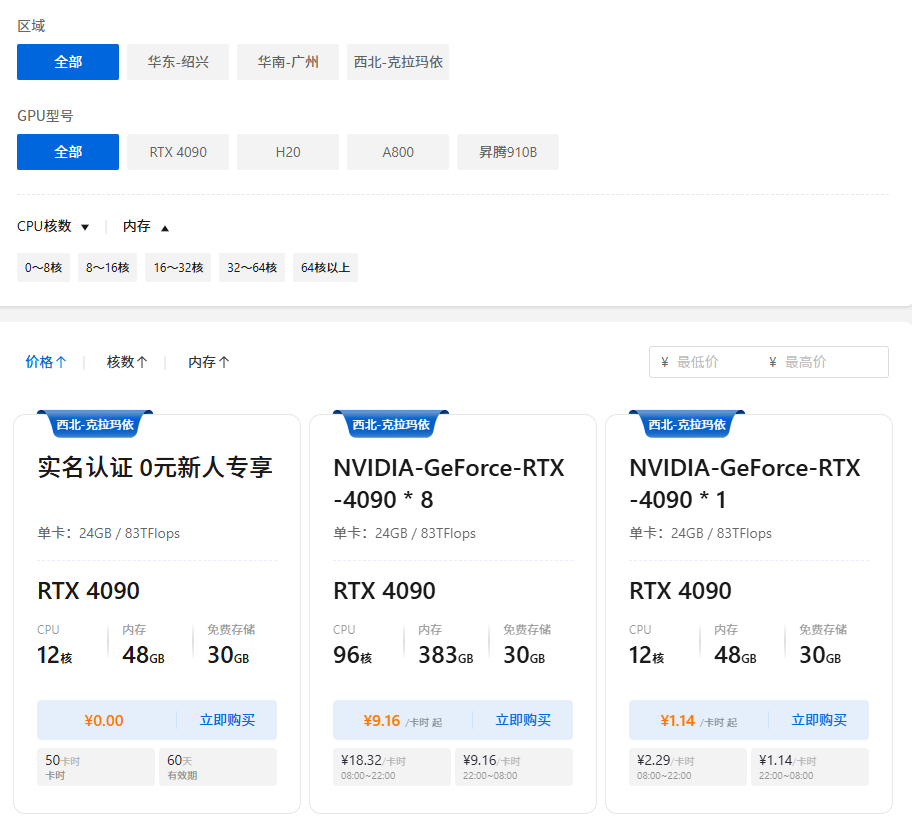

企业对算力的需求,促进了算力平台的发展,天罡智算平台(https://www.tiangangaitp.com)就是其中的佼佼者:提供弹性GPU算力,灵活选择GPU类型和数量,按需动态使用,打破固定时长租期的束缚,只需为实际使用的资源付费。除了算力,还提供镜像、存储服务等一系列配套服务,并对完成实名认证的企业客户,提供4090 GPU 50个卡时的免费使用优惠。,主打中小规模训练任务。通过同一核心

在中美科技竞争持续深化的背景下,美国于2025年再次加强了对华AI芯片的出口管制,新增了对算力、显存带宽及芯片面积等多方面限制。此举使得英伟达此前专为中国市场开发的H20芯片也被纳入禁售范围。

为应对政策变化并维持在中国市场的地位,英伟达迅速开发了符合新规的下一代特供芯片——B20和B40。目前,国内多家互联网企业已收到样卡并进行测试,预计最早将于今年7月进入公开市场。

核心架构:与消费级旗舰同源的GB202

与上一代基于Hopper架构并大幅缩减规格的H20不同,B20和B40采用了英伟达最新Blackwell架构中的GB202核心。该核心同时用于下一代消费级旗舰显卡RTX 5090及专业工作站显卡RTX pro 6000,这一选择带来两方面优势:

其一,借助GB202现有开发与生产线,英伟达能够快速完成合规性改造,显著缩短产品研发与上市时间。据悉相关适配工作早在2024年中便已启动。

其二,出于规避监管及降低市场敏感度的考虑,英伟达可能不以Blackwell系列常规命名方式对外宣传,而是将其纳入RTX pro 6000系列或其变种。

显存配置:由HBM转向GDDR

新出口管制明确限制了显存带宽,因此B20与B40均放弃使用高带宽内存(HBM),转为搭载GDDR显存,预计将为最新一代GDDR7。

显存容量方面,可能提供48GB与96GB等配置,其中48GB(由16颗3GB GDDR7颗粒实现)为最可能方案。未来亦不排除通过固件升级实现类似RTX pro 6000的双面显存高密度方案。这一调整虽导致单卡显存带宽显著降低,却是符合当前政策的必要之举。

互联方案区分产品定位

尽管B20与B40出自同一晶圆,却通过互联技术的差异明确划分出不同应用场景:

- B40保留NVLink互联,主打中小规模训练任务。其NVLink带宽限制为900Gbps,与H20保持一致。该芯片采用OAM板卡形态,支持4卡单机配置,并具备扩展至NVL72或NVL144等集群的潜力。受限于算力与带宽,B40更适合数百卡规模以内的模型微调及后续训练任务。

- B20则采用以太网互联,专注于推理市场。通过外接ConnectX-8芯片,经NVLink总线实现800Gbps互联带宽,以标准PCIe卡形态出现。该设计适用于8至16卡的小规模集群,主要用于模型推理及轻量级训练任务,因并行效率较低,不适用于大规模模型训练。

市场定价与前景展望

尽管在绝对性能上做出妥协,B20/B40在定价方面表现出较强竞争力。据行业消息透露,芯片单价预计介于6500至8000美元之间,大幅低于此前H20的10000–12000美元。其中B40综合性能约为H20的85%,具备较高的性价比。

整机服务器价格预计介于6万至10万美元:基于B20的以太网互联系统约6万美元,而基于B40的OAM NVLink系统则接近10万美元。

国内厂商反应各异

目前,国内主要科技企业已表现出不同偏好:

- 腾讯更倾向采购B20,因其业务以推理为主,注重网络调度与管理效率;

- 字节跳动更关注B40,试图以此弥补H20禁售带来的算力缺口;

- 阿里巴巴虽未明确型号倾向,但已表现出较强的采购意愿。

各大厂商已完成样卡接收,预计将于未来一个多月内展开测试,评估结束后将决定实际订单规模。

总结和展望

企业对算力的需求,促进了算力平台的发展,天罡智算平台(https://www.tiangangaitp.com)就是其中的佼佼者:提供弹性GPU算力,灵活选择GPU类型和数量,按需动态使用,打破固定时长租期的束缚,只需为实际使用的资源付费。除了算力,还提供镜像、存储服务等一系列配套服务,并对完成实名认证的企业客户,提供4090 GPU 50个卡时的免费使用优惠。

英伟达B20/B40系列是在出口管制政策下为维持中国市场所采取的技术与市场双重策略的产物。通过同一核心、不同互联方案的组合,覆盖推理及中小规模训练两类场景,并以积极定价维持其CUDA生态优势,抵御本土竞争。

尽管以华为为代表的国内AI芯片企业正在加速发展,英伟仍通过灵活的产品策略试图稳固市场地位。这批特供芯片能否持续满足中国AI产业高速发展的算力需求,仍需待实际部署与应用后进一步观察。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)