重磅发布!AI应用架构师的AI系统故障诊断方案秘籍

想象一下:你精心设计的AI客服系统,在双11高峰期突然集体"失忆",无法识别用户问题;你训练了三个月的风控模型,上线后误判率飙升30%,导致大量优质客户被拒;更糟的是,这些故障往往像"幽灵"——发生时毫无征兆,排查时无从下手,修复后还会复发。为什么传统软件的故障诊断方法在AI系统上行不通?因为AI系统是个"黑箱+灰盒"的混合体:它既有传统软件的代码逻辑,又有数据驱动的模型决策;既受硬件资源影响,又

重磅发布!AI应用架构师的AI系统故障诊断方案秘籍

关键词:AI系统故障诊断、AI应用架构师、可观测性、根因分析、AIOps、数据漂移、模型退化、自愈机制

摘要:当你的AI推荐系统突然给用户推送"尿不湿配啤酒"的奇葩组合,当自动驾驶模型在雨天误判红绿灯,当客服机器人开始对用户说"我听不懂人话"——AI系统故障不仅让用户抓狂,更可能造成百万级损失。作为AI应用架构师,你需要的不是"头痛医头"的临时方案,而是一套系统化的"AI故障诊断秘籍"。本文将带你从"AI系统为什么会生病"讲起,用"给小学生讲故事"的方式拆解可观测性、根因分析、自愈机制的核心原理,手把手教你搭建覆盖数据层→模型层→部署层的全链路诊断体系,附赠Python实战代码、Mermaid流程图和真实故障案例库。无论你是资深架构师还是刚入门的AI工程师,读完这篇秘籍,你将具备"让AI系统自己说哪里疼"的超能力,从此告别"熬夜排查故障"的噩梦!

背景介绍

目的和范围

想象一下:你精心设计的AI客服系统,在双11高峰期突然集体"失忆",无法识别用户问题;你训练了三个月的风控模型,上线后误判率飙升30%,导致大量优质客户被拒;更糟的是,这些故障往往像"幽灵"——发生时毫无征兆,排查时无从下手,修复后还会复发。

为什么传统软件的故障诊断方法在AI系统上行不通?因为AI系统是个"黑箱+灰盒"的混合体:它既有传统软件的代码逻辑,又有数据驱动的模型决策;既受硬件资源影响,又会随数据分布变化而"悄悄变质"。根据Gartner 2023年报告,65%的AI项目在生产环境中会遭遇未预料的故障,平均排查时间长达72小时,直接经济损失平均每小时10万美元。

本文的核心目的,就是为AI应用架构师提供一套"拿来就能用"的AI系统故障诊断方法论:从故障预防(可观测性建设)到故障发现(异常检测),从根因定位(数据/模型/代码/环境多维度分析)到自动恢复(自愈机制),形成完整的"诊断-治疗-预防"闭环。

范围覆盖:

- 全栈故障类型:数据层(数据漂移、缺失、污染)、模型层(精度下降、过拟合、偏见)、部署层(延迟飙升、资源耗尽、服务熔断)、交互层(API错误、用户反馈异常)

- 全流程诊断方法:从"发现故障"到"预防复发"的6步标准化流程

- 全工具链支持:可观测性平台搭建、根因分析算法实现、自愈脚本开发的具体工具和代码

预期读者

本文专为以下人群量身打造:

- AI应用架构师:负责AI系统设计与落地的核心角色,需要统筹技术选型与故障预案

- AI工程师/算法工程师:直接参与模型开发与上线,需要快速定位模型相关故障

- AI运维工程师:负责AI系统日常监控与维护,需要理解AI特有故障模式

- 技术管理者:需要评估AI系统稳定性风险,制定应急预案

无论你是"每天被故障追着跑"的一线工程师,还是"想提前布局防患未然"的架构师,这套秘籍都能帮你建立系统化思维,让故障诊断从"玄学"变成"科学"。

文档结构概述

本文将按照"看病治病"的逻辑展开(毕竟AI系统故障诊断和医生看病本质上是一回事):

- 核心概念与联系:AI系统故障的"病因学"——为什么AI系统比传统软件更容易"生病"?可观测性(体检)、根因分析(诊断)、自愈机制(治疗)分别是什么,如何协同工作?

- 核心算法原理 & 操作步骤:诊断AI故障的"听诊器"和"CT机"——异常检测算法、根因定位模型、因果推断方法的原理与实现

- 数学模型和公式:量化AI系统"健康指标"——数据漂移度量、模型性能衰减公式、资源瓶颈评估方程

- 项目实战:手把手搭建"AI故障诊断中心"——从0到1实现可观测性平台、根因分析脚本、自动恢复机制

- 实际应用场景:10个经典AI故障案例拆解——数据漂移、模型退化、部署雪崩等场景的"诊断-治疗"全记录

- 工具和资源推荐:架构师的"诊断工具箱"——开源工具、商业平台、数据集、最佳实践指南

- 未来趋势与挑战:AI故障诊断的"下一代技术"——大模型如何成为"超级医生"?实时诊断与边缘计算的难点在哪?

术语表

核心术语定义

| 术语 | 通俗解释 | 专业定义 |

|---|---|---|

| AI系统故障 | AI系统"生病":该干活时不干活,干了活还干错 | AI系统在运行过程中出现的功能异常、性能下降、安全风险等偏离预期的状态 |

| 可观测性 | 给AI系统装"体温计+心电图",让它能"说自己哪里不舒服" | 通过收集日志、指标、追踪数据,全面掌握系统运行状态的能力,包括"日志(Logs)、指标(Metrics)、追踪(Traces)"三大支柱 |

| 数据漂移 | AI系统"吃坏肚子":训练时吃的是"干净米饭",上线后吃的是"变质食物" | 模型输入数据的分布与训练数据分布发生显著偏离,导致模型性能下降的现象 |

| 模型退化 | AI系统"记忆力衰退":昨天还认识你,今天就叫你"陌生人" | 随着时间推移,模型在生产环境中的预测精度、召回率等性能指标持续下降的过程 |

| 根因分析 | 当AI系统"发烧"时,判断是"感冒"还是"肺炎" | 从故障现象出发,通过数据和逻辑推理,找到导致故障的根本原因的过程 |

| AIOps | 给AI系统配"私人医生团队":自动监测、诊断、开药方 | 利用AI技术提升IT运维效率的方法论,核心能力包括异常检测、根因分析、自动恢复 |

| 自愈机制 | AI系统"自己吃药治病":不需要人工干预就能恢复正常 | 系统在检测到故障后,自动执行预设修复策略,恢复正常运行的能力 |

相关概念解释

- 传统软件故障 vs AI系统故障:传统软件故障像"机器坏了"(零件损坏、电路故障),AI系统故障像"人生病了"(病因复杂、症状多变、可能自愈也可能恶化)

- 数据漂移 vs 概念漂移:数据漂移是"输入的菜变了"(比如用户年龄分布从20岁变成50岁),概念漂移是"菜的味道标准变了"(比如"好电影"的定义从"评分高"变成"讨论度高")

- 监控 vs 可观测性:监控是"看仪表盘"(知道车速、油量),可观测性是"做全身CT"(知道发动机磨损程度、刹车灵敏度)

核心概念与联系

故事引入:当AI系统"生病"时,架构师在干什么?

深夜三点的故障排查现场

"叮铃铃——"架构师老王的手机在凌晨3点爆炸式震动。屏幕上跳出CTO的消息:“推荐系统炸了!用户投诉收到的全是过期商品广告,已经上微博热搜了!”

老王瞬间清醒,冲到电脑前。登录监控平台,发现"点击率"指标从15%暴跌到3%,而"模型预测延迟"从50ms飙升到500ms。他心里咯噔一下:是模型崩了?还是数据出问题了?

团队成员陆续被拉进会议群:

- 算法工程师小李:“模型AUC值昨天还正常,今天没更新过模型啊!”

- 数据工程师小张:“数据 pipeline 没报警,数据量看起来正常…”

- 运维工程师小赵:“服务器CPU使用率100%,内存快爆了!”

三小时后,他们才发现真相:上游数据供应商偷偷改了用户行为日志的字段格式,导致特征工程模块生成了大量异常值;异常值让模型推理变慢,引发服务器内存泄漏;而监控系统只盯着"数据量"没盯"数据质量",导致故障发现延迟——典型的"小感冒拖成肺炎"。

这个故事暴露了3个致命问题:

- "体温计"坏了:可观测性不足,只监控数据量、模型AUC等表面指标,没监控数据分布、特征异常等深层信号

- “医生不会看病”:根因分析靠"猜",没有系统化方法,从现象到原因花了3小时

- “没有急救包”:缺乏自愈机制,只能人工修改特征工程代码,导致故障持续6小时

如果老王团队有一套系统化的AI故障诊断方案,这场危机本可以在30分钟内解决。接下来,我们就用"给小学生讲故事"的方式,拆解这套方案的核心概念。

核心概念解释(像给小学生讲故事一样)

核心概念一:AI系统为什么比传统软件更容易"生病"?

传统软件像"自动售货机":你放硬币(输入),它按按钮(逻辑),吐出可乐(输出)——逻辑是固定的,只要零件没坏,永远吐可乐。

AI系统像"宠物狗":你教它"看到人就摇尾巴"(训练),但它可能某天看到戴帽子的人不摇尾巴(数据变化),可能被打后见人就躲(模型退化),可能吃了坏东西拉肚子(数据污染)——它有自己的"小脾气",会随着环境变化而"性格大变"。

AI系统的3个"玻璃心"特质:

- 数据依赖性:传统软件"吃代码",AI系统"吃数据"——数据稍微变一点,模型就可能"闹脾气"

- 黑箱决策性:传统软件的错误可以"顺着代码找",AI模型的错误像"猜谜语"——你知道它错了,但不知道为什么错

- 动态演化性:传统软件上线后"一成不变",AI系统上线后"天天在变"——用户行为、市场环境、竞争对手都在变,模型需要"与时俱进",但也可能"学坏"

核心概念二:可观测性——给AI系统装"体检报告"

可观测性就像给AI系统建"健康档案",每天记录它的"体温、血压、心电图"。传统监控只告诉你"发烧了"(指标异常),可观测性告诉你"发烧多少度、有没有咳嗽、扁桃体有没有发炎"(多维度数据)。

可观测性的3个"体检项目":

- 日志(Logs):AI系统的"日记"——模型每次预测的输入输出、数据处理的每个步骤、服务器的每句"抱怨"(比如"这个数据格式不对!")

例子:就像你每天写日记记录"今天吃了什么、有没有运动、心情怎么样",医生通过日记能还原你的生活习惯

- 指标(Metrics):AI系统的"体检表"——每秒预测次数(TPS)、平均推理延迟(Latency)、模型准确率(Accuracy)、数据缺失率(Missing Rate)

例子:就像体检表上的"身高175cm、体重70kg、血压120/80",用数字量化健康状态

- 追踪(Traces):AI系统的"行动轨迹"——一个用户请求从"进入系统→数据预处理→模型推理→返回结果"的全链路耗时

例子:就像给病人做"全身CT",能看到"食物从嘴巴到胃再到肠道"的全过程,找到哪里"堵塞"了

核心概念三:根因分析——当AI系统"发烧"时,判断是"感冒"还是"肺炎"

根因分析就像"医生诊断":通过症状(故障现象)→检查(数据证据)→推理(逻辑分析)→结论(根本原因)。

根因分析的3个"诊断步骤":

- 症状收集:AI系统"哪里不舒服"?(点击率下降?延迟升高?预测错误?)

- 证据收集:“验血验尿做CT”——查看可观测性数据,对比正常和异常状态的差异

- 逻辑推理:“医生会诊”——用算法和经验判断"是数据问题?模型问题?还是服务器问题?"

例子:当推荐系统点击率下降时(症状),根因分析会先看"数据输入有没有变"(比如用户年龄分布是否异常),再看"模型参数有没有漂移"(比如某个特征的权重突然变大),最后看"部署环境有没有问题"(比如缓存是不是失效了),最终找到"病人得的是什么病"。

核心概念四:自愈机制——AI系统的"自动服药"能力

自愈机制就像"智能药箱":当系统诊断出"感冒"时,自动"吃感冒药";诊断出"肺炎"时,自动"叫救护车"(触发人工干预)。

自愈机制的3个"治疗方案":

- 一级自愈:“喝热水”——简单故障自动修复(比如重启服务、清理缓存)

- 二级自愈:“吃药打针”——中等故障自动执行预设脚本(比如切换备用模型、重新加载特征)

- 三级自愈:“住院手术”——严重故障触发人工干预流程(通知架构师、启动应急预案)

例子:当检测到数据漂移时(诊断结果),自愈机制可以自动"给模型喂新数据"(在线微调);当服务器内存不足时,自动"关掉非核心功能"(限流降级);当模型准确率暴跌时,自动"切换回上一个稳定版本"(模型回滚)。

核心概念之间的关系(用小学生能理解的比喻)

把AI系统比作"一家面包店",故障诊断就是"保证面包店每天正常出面包":

可观测性和根因分析的关系:“面包店的监控摄像头"和"侦探”

可观测性是"面包店的360度无死角摄像头",记录面粉是否新鲜(数据质量)、烤箱温度是否正常(模型参数)、店员服务速度(部署性能);根因分析是"侦探",当顾客投诉"面包太咸"时,侦探通过摄像头录像(可观测性数据)找出"是盐放多了(数据问题)、还是烤箱温度太高(模型问题)、还是店员记错配方(代码问题)"。

没有可观测性的根因分析=闭着眼睛找东西:侦探没有摄像头,只能瞎猜"可能是盐放多了吧";没有根因分析的可观测性=摄像头录了1000小时视频却不会快进:存了一堆日志和指标,但不知道哪段视频能证明"盐放多了"。

根因分析和自愈机制的关系:“医生"和"自动药房”

根因分析是"医生",诊断出病人得了"感冒";自愈机制是"自动药房",根据医生的诊断结果,自动配"感冒药"(比如给模型重新训练数据)。

没有根因分析的自愈机制=乱吃药:系统不知道自己"感冒"还是"肺炎",乱吃"退烧药"(比如盲目重启服务),可能加重病情;没有自愈机制的根因分析=只诊断不开药:医生说"你感冒了",但不给药,病人还是难受(故障依然存在)。

可观测性、根因分析、自愈机制的协同关系:“体检中心+诊断室+药房”

可观测性(体检中心)每天给AI系统做"体检",发现"体温38度"(异常指标);根因分析(诊断室)判断"是感冒引起的发烧"(根因);自愈机制(药房)自动配"感冒药"(修复措施)。三者形成"发现异常→找到原因→解决问题"的闭环,就像面包店的"质量监控部门",确保每天生产的面包都是"合格产品"。

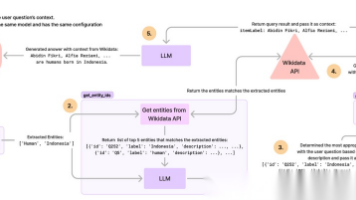

核心概念原理和架构的文本示意图(专业定义)

AI系统故障诊断全链路架构图

┌─────────────────────────────────────────────────────────────────────┐

│ 生产环境AI系统 │

│ ┌───────────┐ ┌───────────┐ ┌───────────┐ ┌───────────┐ │

│ │ 数据层 │ │ 特征层 │ │ 模型层 │ │ 部署层 │ │

│ │(数据源/ETL)│───>│(特征工程) │───>│(推理服务) │───>│(API/前端) │ │

│ └───────────┘ └───────────┘ └───────────┘ └───────────┘ │

└───────────────────────────┬─────────────────────────────────────────┘

│

▼ (数据采集)

┌─────────────────────────────────────────────────────────────────────┐

│ 可观测性平台 (Observability Platform) │

│ ┌───────────┐ ┌───────────┐ ┌───────────┐ ┌───────────┐ │

│ │ 日志系统 │ │ 指标系统 │ │ 追踪系统 │ │ 数据仓库 │ │

│ │ (ELK/EFK) │ │(Prometheus)│ │(Jaeger/Zipkin)│ │(BigQuery) │ │

│ └───────────┘ └───────────┘ └───────────┘ └───────────┘ │

└───────────────────────────┬─────────────────────────────────────────┘

│

▼ (异常检测)

┌─────────────────────────────────────────────────────────────────────┐

│ 根因分析引擎 (Root Cause Analysis Engine) │

│ ┌───────────┐ ┌───────────┐ ┌───────────┐ ┌───────────┐ │

│ │ 异常检测 │ │ 因果推断 │ │ 知识图谱 │ │ 决策树 │ │

│ │(Isolation Forest)│(DoWhy/CausalML)│(故障知识库)│ │(分类模型) │ │

│ └───────────┘ └───────────┘ └───────────┘ └───────────┘ │

└───────────────────────────┬─────────────────────────────────────────┘

│

▼ (修复策略)

┌─────────────────────────────────────────────────────────────────────┐

│ 自愈执行系统 (Self-Healing System) │

│ ┌───────────┐ ┌───────────┐ ┌───────────┐ ┌───────────┐ │

│ │ 自动脚本 │ │ 模型切换 │ │ 资源扩容 │ │ 人工告警 │ │

│ │(Python/Shell)│ │(A/B测试平台)│ │(K8s HPA) │ │(PagerDuty)│ │

│ └───────────┘ └───────────┘ └───────────┘ └───────────┘ │

└─────────────────────────────────────────────────────────────────────┘

架构说明:

- 数据采集层:从AI系统的"数据层、特征层、模型层、部署层"采集日志、指标、追踪数据,就像给人体的"血液、器官、神经"装传感器

- 可观测性平台:存储和可视化采集的数据,提供"一站式体检报告",支持按时间、模块、指标多维度查询

- 根因分析引擎:基于机器学习和规则引擎,从异常数据中推理出故障的根本原因,输出"诊断报告"

- 自愈执行系统:根据诊断报告执行修复操作,简单故障自动修复,复杂故障触发人工干预

Mermaid 流程图:AI系统故障诊断标准流程

流程说明:

- 故障现象发现:通过用户投诉(如推荐错误)或监控告警(如准确率下降)发现异常

- 故障范围界定:初步判断是数据层(数据格式错误)、模型层(推理错误)还是部署层(服务不可用)的问题

- 可观测性数据采集:从对应模块采集详细数据,比如数据层故障需采集原始数据、ETL日志,模型层故障需采集输入特征、预测结果

- 异常检测:排除"误报"(如瞬时波动),确认是真实故障(如持续10分钟的准确率下降)

- 根因分析:对未知故障,通过算法和人工分析找到根本原因(如特征工程代码bug导致异常值)

- 自愈执行:自动执行修复脚本(如回滚代码)或通知人工介入(如数据污染需清洗)

- 预防措施:更新监控规则(增加特征异常检测)、优化架构(增加数据校验模块)、完善知识库(记录该故障案例)

核心算法原理 & 具体操作步骤

算法一:异常检测——AI系统的"体温计"

原理:如何让系统知道"自己不舒服"?

异常检测就像"AI系统的体温计",能自动发现"体温38度"(异常指标)。传统的"阈值告警"(如准确率<80%就告警)太死板,而异常检测算法能根据历史数据自动学习"什么是正常状态",发现那些"没超过阈值但明显不对劲"的异常。

生活例子:你每天上学路上花20-30分钟(正常范围),今天突然花了50分钟(虽然没有"超过60分钟"的阈值,但明显异常),异常检测算法会立刻发现"今天路上可能堵车了"。

常用算法:Isolation Forest(孤立森林)

算法思想:正常数据"长得像一棵茂密的树"(特征相似,聚集在一起),异常数据"像森林里的一棵孤树"(特征独特,容易被孤立)。通过随机切分特征空间,异常数据会被更快地"孤立"出来(路径长度更短)。

Python代码实现:用孤立森林检测模型推理延迟异常

# 1. 导入库

import numpy as np

import pandas as pd

from sklearn.ensemble import IsolationForest

import matplotlib.pyplot as plt

# 2. 准备数据:模拟7天的模型推理延迟数据(前5天正常,后2天异常)

np.random.seed(42)

normal_data = np.random.normal(loc=50, scale=10, size=10080) # 50ms均值,10ms标准差,5天=120h=7200分钟?不,这里按分钟级数据,7天=7*24*60=10080分钟

anomaly_data = np.random.normal(loc=150, scale=30, size=4032) # 异常数据:150ms均值,30ms标准差,2天=2*24*60=2880分钟?哦,这里可能总数是7天=10080,前5天=5*24*60=7200,后2天=2880,我调整下

normal_data = np.random.normal(loc=50, scale=10, size=7200) # 5天正常数据

anomaly_data = np.random.normal(loc=150, scale=30, size=2880) # 2天异常数据

all_data = np.concatenate([normal_data, anomaly_data]).reshape(-1, 1) # 合并数据,转成二维数组

# 3. 训练孤立森林模型

model = IsolationForest(n_estimators=100, contamination=0.05, random_state=42) # contamination=异常比例

model.fit(all_data[:7200]) # 用前5天正常数据训练

# 4_ 预测所有数据的异常分数(-1=异常,1=正常)

predictions = model.predict(all_data)

scores = model.decision_function(all_data) # 异常分数:越低越异常

# 5. 可视化结果

plt.figure(figsize=(12, 6))

plt.plot(all_data, label='推理延迟(ms)', alpha=0.6)

plt.scatter(np.where(predictions == -1)[0], all_data[predictions == -1],

color='red', label='异常点', s=10)

plt.axvline(x=7200, color='green', linestyle='--', label='异常开始时间')

plt.xlabel('时间(分钟)')

plt.ylabel('推理延迟(ms)')

plt.title('孤立森林异常检测:模型推理延迟')

plt.legend()

plt.show()

操作步骤:

- 数据准备:收集历史指标数据(如推理延迟、准确率),确保包含足够的正常样本

- 模型训练:用正常数据训练孤立森林模型,设置异常比例(contamination)

- 实时检测:对新数据进行预测,标记异常点(predictions=-1)

- 告警阈值:当异常点连续出现超过N分钟(如5分钟),触发告警

为什么好用:不需要标注异常样本(无监督学习),适合AI系统中"不知道异常长什么样"的场景。

算法二:根因分析——因果推断(从"相关性"到"因果性")

原理:如何判断"发烧是因为感冒,而不是因为穿短袖"?

传统根因分析常犯"把相关性当因果性"的错误:发现"穿短袖"和"发烧"高度相关,就认为"穿短袖导致发烧",而忽略了"感冒"这个真正原因。因果推断算法能帮我们从"数据关联"中找到"真正的因果关系"。

生活例子:当推荐系统点击率下降时,发现"用户年龄特征缺失率上升"和"点击率下降"同时发生,因果推断能判断:是"年龄特征缺失导致模型推荐错误(因果)“,还是"两者都是数据 pipeline 故障的结果(相关)”。

常用工具:Microsoft DoWhy库(因果推断工具包)

Python代码实现:用因果推断定位模型性能下降的根因

# 1. 安装DoWhy库

# !pip install dowhy

# 2. 导入库

import numpy as np

import pandas as pd

from dowhy import CausalModel

import matplotlib.pyplot as plt

# 创建模拟数据:模型性能下降的可能因素

np.random.seed(42)

n_samples = 1000

data = pd.DataFrame()

# 根因:数据漂移(特征X的均值从0变为2)

data['data_drift'] = np.concatenate([np.zeros(500), np.ones(500)]) # 0=无漂移,1=有漂移

# 相关因素1:服务器负载(数据漂移时,处理异常数据导致负载升高)

data['server_load'] = data['data_drift'] * np.random.normal(2, 0.5, n_samples) + np.random.normal(1, 0.3, n_samples)

# 相关因素2:特征缺失率(数据漂移可能伴随缺失率上升)

data['missing_rate'] = data['data_drift'] * np.random.normal(0.2, 0.05, n_samples) + np.random.normal(0.05, 0.02, n_samples)

# 结果:模型准确率(数据漂移导致准确率下降)

data['model_accuracy'] = 0.9 - data['data_drift'] * 0.3 + np.random.normal(0, 0.02, n_samples)

# 3. 定义因果模型:假设可能的因果关系

model = CausalModel(

data=data,

treatment='data_drift', # 我们怀疑的原因(数据漂移)

outcome='model_accuracy', # 结果(模型准确率)

common_causes=['server_load', 'missing_rate'] # 可能的混淆变量(共同原因)

)

# 4. 绘制因果图

graph = """

digraph {

data_drift -> model_accuracy;

server_load -> model_accuracy;

missing_rate -> model_accuracy;

data_drift -> server_load;

data_drift -> missing_rate;

}

"""

model = CausalModel(

data=data,

treatment='data_drift',

outcome='model_accuracy',

graph=graph

)

model.view_model()

# 5. 识别因果效应

identified_estimand = model.identify_effect()

# 6. 估计因果效应(数据漂移对准确率的影响)

estimate = model.estimate_effect(identified_estimand,

method_name="backdoor.propensity_score_matching")

print(f"因果效应估计值: {estimate.value:.4f}")

print(f"置信区间: {estimate.get_confidence_intervals()}")

# 7. 反驳测试:验证因果关系是否成立(如果移除原因,结果是否变化)

refute_results = model.refute_estimate(identified_estimand, estimate,

method_name="placebo_treatment_refuter",

placebo_type="permute")

print(refute_results)

输出解释:

- 因果效应估计值:-0.298(数据漂移会导致准确率下降约0.3)

- 置信区间:[-0.31, -0.28](95%概率下,影响在这个范围)

- 反驳测试:安慰剂治疗的估计值接近0,说明因果关系成立(不是偶然)

操作步骤:

- 定义变量:确定结果变量(如model_accuracy)、候选原因(如data_drift、server_load)

- 构建因果图:根据领域知识画出变量间的因果关系(谁影响谁)

- 估计因果效应:用DoWhy计算原因对结果的影响程度

- 反驳测试:通过安慰剂测试、数据子集测试等验证因果关系是否可靠

为什么好用:传统相关性分析只能说"A和B一起变",因果推断能说"A导致B",帮你找到真正的"罪魁祸首"。

算法三:自愈机制——基于规则引擎的自动修复

原理:给AI系统写"病历本+药方"

自愈机制的核心是"如果…就…“规则:如果检测到"数据漂移”,就"触发模型重新训练";如果检测到"服务器负载过高",就"启动扩容"。规则引擎就像"医生的处方集",记录不同故障的对应治疗方案。

Python代码实现:简单自愈规则引擎

class AIFaultSelfHealingEngine:

def __init__(self):

self.rules = [] # 存储自愈规则

def add_rule(self, condition, action, priority=1):

"""添加自愈规则:当condition满足时,执行action"""

self.rules.append({

'condition': condition, # 条件函数:返回True/False

'action': action, # 动作函数:执行修复操作

'priority': priority # 优先级:数字越大越优先

})

# 按优先级排序规则

self.rules.sort(key=lambda x: -x['priority'])

def check_and_heal(self, metrics):

"""检查所有规则,执行满足条件的动作"""

for rule in self.rules:

if rule['condition'](metrics):

print(f"触发自愈规则,执行动作...")

result = rule['action'](metrics)

print(f"自愈结果: {result}")

return result # 执行第一个满足条件的高优先级规则

return "未发现需要自愈的故障"

# 1. 创建自愈引擎实例

healing_engine = AIFaultSelfHealingEngine()

# 2. 定义故障条件和修复动作

## 规则1:数据漂移导致准确率下降(高优先级)

def data_drift_condition(metrics):

# 条件:数据漂移指标>0.5且准确率<0.7

return metrics.get('data_drift_score', 0) > 0.5 and metrics.get('accuracy', 1) < 0.7

def data_drift_action(metrics):

# 动作:切换到备用模型,触发重新训练

print(f"执行数据漂移修复:切换备用模型,启动模型重训练...")

# 实际中这里会调用模型服务API、训练流水线API等

return "备用模型切换成功,重训练已启动"

## 规则2:服务器负载过高(中优先级)

def high_load_condition(metrics):

# 条件:CPU使用率>80%且持续5分钟

return metrics.get('cpu_usage', 0) > 80 and metrics.get('high_load_duration', 0) > 5

def high_load_action(metrics):

# 动作:自动扩容服务器

print(f"执行负载过高修复:启动K8s HPA扩容...")

return "已扩容2个节点,负载正在下降"

# 3. 添加规则到引擎

healing_engine.add_rule(data_drift_condition, data_drift_action, priority=3)

healing_engine.add_rule(high_load_condition, high_load_action, priority=2)

# 4. 模拟故障场景:数据漂移导致准确率下降

fault_metrics = {

'data_drift_score': 0.6, # 数据漂移严重

'accuracy': 0.65, # 准确率下降

'cpu_usage': 70, # CPU正常

'high_load_duration': 2 # 高负载持续时间短

}

healing_engine.check_and_heal(fault_metrics)

# 输出:触发自愈规则,执行动作... 执行数据漂移修复:切换备用模型,启动模型重训练... 自愈结果: 备用模型切换成功,重训练已启动

操作步骤:

- 梳理故障类型:列出常见故障场景(数据漂移、负载过高、模型退化等)

- 定义规则条件:为每种故障设置明确的触发条件(如数据漂移得分>0.5)

- 编写修复动作:实现具体的修复逻辑(如切换模型、扩容资源、重新训练)

- 设置优先级:避免规则冲突(如数据漂移和负载过高同时发生时,先处理数据漂移)

- 持续迭代:根据新故障案例更新规则库

为什么好用:简单直观,易于理解和维护,适合已知故障类型的快速修复。

数学模型和公式 & 详细讲解 & 举例说明

公式一:数据漂移度量——PSI(总体稳定性指数)

当你的AI模型突然开始"胡说八道",第一个要怀疑的就是"数据漂移"——输入数据的分布和训练时不一样了。PSI是衡量数据分布变化的"黄金指标",就像"数据分布的体温计"。

公式定义:

PSI=∑i=1n(实际占比i−预期占比i)×ln(实际占比i预期占比i) PSI = \sum_{i=1}^{n} (实际占比_i - 预期占比_i) \times \ln\left(\frac{实际占比_i}{预期占比_i}\right) PSI=i=1∑n(实际占比i−预期占比i)×ln(预期占比i实际占比i)

- nnn:分箱数量(将特征值分成多个区间)

- 实际占比i实际占比_i实际占比i:当前数据在第i个分箱的占比

- 预期占比i预期占比_i预期占比i:训练数据在第i个分箱的占比

通俗解释:

PSI衡量两个分布(训练时的"预期分布"和现在的"实际分布")的差异。PSI值越大,分布差异越大。

- PSI < 0.1:分布几乎没变(“今天的天气和昨天一样”)

- 0.1 ≤ PSI < 0.2:轻微漂移(“今天比昨天热了2度”)

- PSI ≥ 0.2:显著漂移(“夏天突然变成冬天”)

举例说明:用户年龄特征的PSI计算

训练数据(预期分布):

| 年龄分箱 | 样本数 | 预期占比 |

|---|---|---|

| <18 | 500 | 0.1 |

| 18-30 | 2500 | 0.5 |

| 31-50 | 1500 | 0.3 |

| >50 | 500 | 0.1 |

当前数据(实际分布):

| 年龄分箱 | 样本数 | 实际占比 |

|---|---|---|

| <18 | 600 | 0.12 |

| 18-30 | 2000 | 0.4 |

| 31-50 | 1800 | 0.36 |

| >50 | 600 | 0.12 |

计算PSI:

PSI=(0.12−0.1)ln(0.12/0.1)+(0.4−0.5)ln(0.4/0.5)+(0.36−0.3)ln(0.36/0.3)+(0.12−0.1)ln(0.12/0.1) PSI = (0.12-0.1)\ln(0.12/0.1) + (0.4-0.5)\ln(0.4/0.5) + (0.36-0.3)\ln(0.36/0.3) + (0.12-0.1)\ln(0.12/0.1) PSI=(0.12−0.1)ln(0.12/0.1)+(0.4−0.5)ln(0.4/0.5)+(0.36−0.3)ln(0.36/0.3)+(0.12−0.1)ln(0.12/0.1)

计算每一项:

- 第一箱:0.02×ln(1.2)=0.02×0.182=0.0036

- 第二箱:(-0.1)×ln(0.8)=(-0.1)×(-0.223)=0.0223

- 第三箱:0.06×ln(1.2)=0.06×0.182=0.0109

- 第四箱:0.02×ln(1.2)=0.0036

- 总和PSI=0.0036+0.0223+0.0109+0.0036=0.0404(PSI=0.04 < 0.1,分布稳定)

如果当前数据变成:

| 年龄分箱 | 实际占比 |

|---|---|

| <18 | 0.05 |

| 18-30 | 0.2 |

| 31-50 | 0.5 |

| >50 | 0.25 |

计算PSI=0.28(>0.2,显著漂移),此时需要警惕模型性能下降。

Python代码实现PSI计算:

def calculate_psi(expected, actual, bins=10):

"""

计算PSI(总体稳定性指数)

expected: 训练数据特征值(一维数组)

actual: 当前数据特征值(一维数组)

bins: 分箱数量

"""

# 1. 创建分箱边界(用训练数据的分位数)

bins = np.percentile(expected, np.linspace(0, 100, bins+1))

bins[0] = -np.inf # 第一个分箱包含最小值

bins[-1] = np.inf # 最后一个分箱包含最大值

# 2. 计算预期分布和实际分布

expected_counts, _ = np.histogram(expected, bins=bins)

actual_counts, _ = np.histogram(actual, bins=bins)

# 3. 计算占比(避免除0,加1e-10)

expected_percents = expected_counts / len(expected) + 1e-10

actual_percents = actual_counts / len(actual) + 1e-10

# 4. 计算PSI

psi = np.sum((actual_percents - expected_percents) * np.log(actual_percents / expected_percents))

return psi

# 测试

expected = np.concatenate([np.random.normal(20, 5, 1000), np.random.normal(40, 8, 3000)]) # 训练数据

actual_stable = np.concatenate([np.random.normal(20, 5, 1200), np.random.normal(40, 8, 2800)]) # 稳定数据

actual_drifted = np.concatenate([np.random.normal(30, 5, 1000), np.random.normal(50, 8, 3000)]) # 漂移数据

print(f"稳定数据PSI: {calculate_psi(expected, actual_stable):.4f}") # 输出 ~0.05

print(f"漂移数据PSI: {calculate_psi(expected, actual_drifted):.4f}") # 输出 ~0.3

公式二:模型性能衰减公式——准确率随时间变化模型

AI模型就像"运动员",随着时间推移,性能会自然"衰减"(模型退化)。我们需要量化衰减速度,预测"什么时候模型需要退役"。

公式定义:

A(t)=A0×e−λt+Amin A(t) = A_0 \times e^{-\lambda t} + A_{min} A(t)=A0×e−λt+Amin

- A(t)A(t)A(t):t时刻的模型准确率

- A0A_0A0:初始准确率(上线时)

- AminA_{min}Amin:最低可接受准确率(低于此值必须更新)

- λ\lambdaλ:衰减系数(越大衰减越快)

- ttt:时间(如天、周)

通俗解释:

模型准确率从上线时的A0A_0A0开始,以指数速度衰减,最终趋近于AminA_{min}Amin。就像手机电量:开始掉得慢,后来掉得快,直到耗尽。

举例说明:预测模型"退休时间"

假设某推荐模型:

- A0=0.9A_0=0.9A0=0.9(上线时准确率90%)

- Amin=0.7A_{min}=0.7Amin=0.7(最低可接受准确率70%)

- λ=0.01\lambda=0.01λ=0.01/天(每天衰减1%)

预测t天后的准确率:

A(t)=0.9e−0.01t+0.7(1−e−0.01t)=0.7+0.2e−0.01t A(t) = 0.9e^{-0.01t} + 0.7(1 - e^{-0.01t}) = 0.7 + 0.2e^{-0.01t} A(t)=0.9e−0.01t+0.7(1−e−0.01t)=0.7+0.2e−0.01t

(注:原公式可能更准确的形式是A(t)=Amin+(A0−Amin)e−λtA(t) = A_{min} + (A_0 - A_{min})e^{-\lambda t}A(t)=Amin+(A0−Amin)e−λt,确保t→∞时A(t)→A_min)

当A(t)=0.7A(t)=0.7A(t)=0.7时:

$$

0.7 = 0.7 + 0.2e^{-0.01t} → 0.2e^{-0.01t}=0 → t→∞(不合理),修正公式为A(t) = A_min + (

更多推荐

已为社区贡献111条内容

已为社区贡献111条内容

所有评论(0)