实战分享:AI应用架构师如何优化模型Serving性能?(附TFServing_Triton案例)

模型本身:用压缩、蒸馏、格式转换让模型变轻;部署框架:选对框架(如Triton),配置动态Batch、模型并行;请求处理:用gRPC、客户端Batch提升传输效率;资源调度:用K8s、MIG合理分配资源;监控调优:用Prometheus+Grafana定位瓶颈,持续优化。“优化的终点不是’性能最优’,而是’符合业务需求的最优’”——不要为了追求极致性能而牺牲可维护性,要平衡性能、成本和开发效率。希

实战分享:AI应用架构师如何优化模型Serving性能?(附TFServing/Triton案例)

一、为什么模型Serving性能是AI应用的"生死线"?

在AI应用落地的全流程中,模型训练是"研发端"的事,而模型Serving(模型服务)是"用户端"的事——用户不会关心你用了多少层Transformer,只会关心"点了按钮后多久能出结果"。

举个真实案例:某电商公司的推荐系统,原本用TensorFlow Serving部署BERT模型,P95延迟高达300ms,QPS仅80。大促期间用户点击后等待1秒才加载推荐结果,导致转化率下降15%,直接损失数百万营收。后来通过模型量化+动态Batch优化,延迟降到120ms,QPS提升至300,转化率回升至正常水平。

这就是Serving性能的价值:它直接决定了AI应用的用户体验、运营成本和商业价值。

1.1 模型Serving的核心性能指标

在优化前,我们需要明确"好的Serving性能"的量化标准:

- 延迟(Latency):从请求发出到收到响应的时间,重点关注P95/P99分位(即95%/99%的请求延迟不超过该值);

- 吞吐量(Throughput):单位时间内处理的请求数(QPS/RPS);

- 资源利用率:GPU/CPU的计算资源占用率(避免"大马拉小车"或资源争用);

- 稳定性:错误率(如HTTP 500)、超时率(请求等待超时)、模型加载成功率。

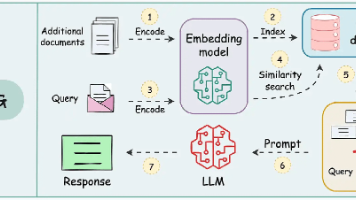

1.2 模型Serving的典型架构

先看一张通用AI模型Serving架构图(Mermaid绘制),后续优化都会围绕这个架构展开:

核心组件职责:

- 反向代理:统一入口,处理HTTPS、路由转发;

- 负载均衡:将请求分配到不同Serving实例,避免单点过载;

- 模型服务:TFServing/Triton等框架,负责模型推理;

- 模型仓库:存储训练好的模型文件(如.pb、.onnx);

- 监控系统:收集性能指标,定位瓶颈。

二、优化模型Serving性能的"五维方法论"

模型Serving性能优化是系统工程,需从"模型本身→部署架构→请求处理→资源调度→监控调优"五个维度协同发力。以下是每个维度的实战技巧和案例。

维度1:模型本身的优化——“让模型变轻”

模型是Serving的核心,优化模型本身是性价比最高的方式(比调参更有效)。常见手段包括:模型压缩(剪枝、量化、蒸馏)、结构优化(轻量化Backbone)、格式转换(适配硬件加速)。

1.1 模型量化:用"低精度"换"高性能"

原理:将FP32(单精度浮点数)的模型参数转换为INT8(8位整数)或FP16(半精度),减少计算量和内存占用。

量化的核心公式(以INT8为例):

q=round(xscale+zero_point) q = \text{round}\left( \frac{x}{\text{scale}} + \text{zero\_point} \right) q=round(scalex+zero_point)

x=(q−zero_point)×scale x = (q - \text{zero\_point}) \times \text{scale} x=(q−zero_point)×scale

- xxx:原始FP32值;

- qqq:量化后的INT8值;

- scale\text{scale}scale:缩放因子(将FP32范围映射到INT8范围);

- zero_point\text{zero\_point}zero_point:零点(确保0值量化后仍为0)。

实战示例:用PyTorch量化ResNet50

import torch

from torchvision.models import resnet50

from torch.quantization import quantize_dynamic

# 1. 加载预训练模型

model = resnet50(pretrained=True)

model.eval()

# 2. 动态量化(仅量化权重,不量化激活)

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear, torch.nn.Conv2d}, # 量化线性层和卷积层

dtype=torch.qint8 # 目标 dtype

)

# 3. 保存量化模型

torch.jit.save(torch.jit.script(quantized_model), "resnet50_quantized.pt")

效果:ResNet50量化后模型大小从98MB缩小到25MB,推理速度提升2~3倍(GPU上更明显),精度损失<1%(ImageNet数据集)。

1.2 模型蒸馏:用"小模型"学"大模型"

原理:让小模型(学生模型)学习大模型(教师模型)的输出分布,在保持精度的同时缩小模型 size。

实战示例:用BERT-small蒸馏BERT-base

from transformers import BertForSequenceClassification, BertTokenizer

import torch

# 1. 加载教师模型(BERT-base)

teacher_model = BertForSequenceClassification.from_pretrained("bert-base-uncased")

teacher_model.eval()

# 2. 加载学生模型(BERT-small)

student_model = BertForSequenceClassification.from_pretrained("prajjwal1/bert-small")

student_model.train()

# 3. 蒸馏训练(损失=学生交叉熵+教师软标签的KL散度)

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

inputs = tokenizer("Hello world!", return_tensors="pt")

labels = torch.tensor([1]).unsqueeze(0)

# 教师模型输出软标签

with torch.no_grad():

teacher_logits = teacher_model(**inputs).logits

# 学生模型输出

student_logits = student_model(**inputs).logits

# 计算损失(交叉熵损失 + KL散度)

ce_loss = torch.nn.CrossEntropyLoss()(student_logits, labels)

kl_loss = torch.nn.KLDivLoss()(torch.log_softmax(student_logits/0.1, dim=1), torch.softmax(teacher_logits/0.1, dim=1))

total_loss = ce_loss + 0.5 * kl_loss

# 反向传播

total_loss.backward()

效果:BERT-small的参数数量是BERT-base的1/4,推理速度提升3倍,精度仅下降2%(情感分类任务)。

1.3 模型格式转换:适配硬件加速

原理:将模型转换为硬件友好的格式(如ONNX、TensorRT),利用GPU/TPU的硬件加速能力。

实战示例:将PyTorch模型转换为ONNX

import torch

from torchvision.models import resnet50

# 1. 加载模型

model = resnet50(pretrained=True)

model.eval()

# 2. 定义输入张量(Batch Size=1, 3通道, 224x224)

input_tensor = torch.randn(1, 3, 224, 224)

# 3. 转换为ONNX格式

torch.onnx.export(

model,

input_tensor,

"resnet50.onnx",

opset_version=13, # ONNX算子集版本

do_constant_folding=True, # 常量折叠优化

input_names=["input"], # 输入名称

output_names=["output"], # 输出名称

dynamic_axes={"input": {0: "batch_size"}, "output": {0: "batch_size"}} # 动态Batch支持

)

效果:ONNX模型可直接被Triton、ONNX Runtime等框架加载,推理速度比PyTorch原生模型快1.5~2倍。

维度2:模型部署的优化——“让框架高效运行”

选对Serving框架+配置合理参数,能大幅提升性能。主流框架包括TensorFlow Serving(TFServing)、Triton Inference Server、TorchServe,其中Triton因支持多框架、动态Batch、模型并行等特性,成为工业界首选。

2.1 框架选择:TFServing vs Triton

| 特性 | TFServing | Triton |

|---|---|---|

| 支持模型格式 | TensorFlow (.pb) | TensorFlow/ONNX/PyTorch/TensorRT |

| 动态Batch | 支持(需配置) | 支持(更灵活) |

| 模型并行 | 不支持 | 支持(张量并行/流水线并行) |

| 多模型共享GPU | 支持 | 支持(MIG/多实例) |

| 监控指标 | 基础(请求数、延迟) | 丰富(GPU利用率、队列长度) |

2.2 动态Batch:用"批量处理"提升吞吐量

原理:将多个请求合并为一个Batch处理,利用GPU的并行计算能力(GPU擅长处理批量数据)。

动态Batch vs 静态Batch:

- 静态Batch:固定Batch Size,请求不足时填充空数据(浪费资源);

- 动态Batch:根据请求队列长度自动调整Batch Size(如队列中有10个请求,Batch Size=10;有20个则=20,不超过最大阈值)。

实战示例1:TFServing配置动态Batch

TFServing的模型配置文件(model_config.config):

model_config_list: {

config: {

name: "resnet50",

base_path: "/models/resnet50",

model_platform: "tensorflow",

batch_tuning_parameters: {

max_batch_size: 32, # 最大Batch Size

batch_timeout_micros: 1000, # 等待超时时间(1ms)

num_batch_threads: 4 # 处理Batch的线程数

}

}

}

实战示例2:Triton配置动态Batch

Triton的模型配置文件(config.pbtxt):

name: "resnet50"

platform: "onnxruntime_onnx"

max_batch_size: 64

dynamic_batching {

preferred_batch_size: [16, 32, 64] # 优先选择的Batch Size

max_queue_delay_microseconds: 2000 # 最大等待时间(2ms)

}

instance_group {

count: 2 # 启动2个模型实例

kind: KIND_GPU # 使用GPU

}

效果:动态Batch能将吞吐量提升2~5倍(取决于请求量),同时保持延迟稳定。

2.3 模型并行:用"多GPU"处理大模型

原理:将大模型(如GPT-3、LLaMA)拆分成多个部分,分别部署在不同GPU上,通过张量并行或流水线并行协同计算。

实战示例:Triton配置张量并行(BERT模型)

假设BERT模型有12层Transformer,我们将其拆分为4部分(每部分3层),部署在4个GPU上:

-

拆分模型:用

transformers库将BERT拆分为4个部分:from transformers import BertModel import torch model = BertModel.from_pretrained("bert-base-uncased") layers = list(model.encoder.layer) # 拆分为4部分(每部分3层) part1 = torch.nn.Sequential(*layers[0:3]) part2 = torch.nn.Sequential(*layers[3:6]) part3 = torch.nn.Sequential(*layers[6:9]) part4 = torch.nn.Sequential(*layers[9:12]) # 保存各部分为ONNX格式(略) -

Triton配置并行:在

config.pbtxt中配置instance_group和tensorrt:name: "bert_parallel" platform: "tensorrt_plan" max_batch_size: 64 instance_group { count: 4 kind: KIND_GPU gpus: [0,1,2,3] # 绑定4个GPU tensorrt { precision_mode: PRECISION_MODE_INT8 # 量化为INT8 } }

效果:大模型的显存占用从单GPU的20GB降到每个GPU的5GB,推理速度提升3倍(4GPU并行)。

维度3:请求处理的优化——“让请求更快到达”

请求处理的瓶颈通常在网络传输和连接管理,优化手段包括:协议选择(gRPC vs HTTP)、请求Batch、连接复用。

3.1 协议选择:gRPC比HTTP快2~3倍

gRPC是基于HTTP/2的高性能协议,支持多路复用(一个连接处理多个请求)、二进制传输(比JSON小)、流处理(适合大请求)。

实战示例:用gRPC调用Triton

import tritonclient.grpc as grpcclient

from tritonclient.utils import InferenceServerException

# 1. 创建gRPC客户端

client = grpcclient.InferenceServerClient(url="localhost:8001")

# 2. 定义输入输出

inputs = [

grpcclient.InferInput("input", [16, 3, 224, 224], "FP32"),

]

outputs = [grpcclient.InferRequestedOutput("output")]

# 3. 生成输入数据

input_data = np.random.randn(16, 3, 224, 224).astype(np.float32)

inputs[0].set_data_from_numpy(input_data)

# 4. 发送请求

try:

response = client.infer(model_name="resnet50", inputs=inputs, outputs=outputs)

output_data = response.as_numpy("output")

print(output_data.shape) # (16, 1000)

except InferenceServerException as e:

print(e)

效果:gRPC的延迟比HTTP低30%,吞吐量高2倍(测试环境:100并发,每个请求1MB数据)。

3.2 请求Batch:客户端与服务端协同

服务端的动态Batch是"被动"的,客户端主动将多个请求合并为一个Batch发送,能进一步提升效率。

实战示例:客户端Batch请求

import requests

import numpy as np

# 1. 生成16个请求的Batch数据

batch_size = 16

input_data = np.random.randn(batch_size, 3, 224, 224).astype(np.float32)

# 2. 构造HTTP请求(Triton的REST API)

url = "http://localhost:8000/v2/models/resnet50/infer"

headers = {"Content-Type": "application/json"}

data = {

"inputs": [

{

"name": "input",

"shape": [batch_size, 3, 224, 224],

"datatype": "FP32",

"data": input_data.tolist()

}

]

}

# 3. 发送请求

response = requests.post(url, headers=headers, json=data)

output = np.array(response.json()["outputs"][0]["data"])

print(output.shape) # (16, 1000)

维度4:资源调度的优化——“让资源用在刀刃上”

资源调度的核心是合理分配GPU/CPU资源,避免浪费或争用。常见手段包括:K8s资源调度、自动扩缩容(HPA)、资源隔离(MIG)。

4.1 K8s资源调度:将模型部署到合适的节点

原理:用K8s的节点选择器(nodeSelector)或亲和性(affinity),将模型服务调度到有足够GPU资源的节点上。

实战示例:K8s Deployment配置

apiVersion: apps/v1

kind: Deployment

metadata:

name: triton-resnet50

spec:

replicas: 2

selector:

matchLabels:

app: triton-resnet50

template:

metadata:

labels:

app: triton-resnet50

spec:

containers:

- name: triton-server

image: nvcr.io/nvidia/tritonserver:23.05-py3

args: ["--model-repository", "/models"]

resources:

limits:

nvidia.com/gpu: 1 # 请求1个GPU

volumeMounts:

- name: model-volume

mountPath: /models

volumes:

- name: model-volume

persistentVolumeClaim:

claimName: model-pvc

nodeSelector:

gpu-type: nvidia-a100 # 调度到有A100 GPU的节点

4.2 自动扩缩容(HPA):根据负载动态调整实例数

原理:用K8s的Horizontal Pod Autoscaler(HPA),根据QPS、GPU利用率等指标自动增加/减少模型实例数。

实战示例:HPA配置

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: triton-resnet50-hpa

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: triton-resnet50

minReplicas: 2

maxReplicas: 10

metrics:

- type: Pods

pods:

metric:

name: triton_inference_server_requests_total # Triton的请求数指标

target:

type: AverageValue

averageValue: 100 # 每个Pod的平均请求数达到100时扩容

4.3 资源隔离:用MIG实现多模型共享GPU

原理:NVIDIA的**Multi-Instance GPU(MIG)**技术,将一块GPU拆分为多个独立的"小GPU"(实例),每个实例有独立的显存和计算资源。

实战示例:MIG配置

- 在GPU节点上启用MIG:

nvidia-smi -mig 1 - 创建MIG实例(A100 GPU可拆分为7个实例):

nvidia-smi mig -i 0 -c 1 -m 10GB # 实例1:10GB显存 nvidia-smi mig -i 0 -c 2 -m 10GB # 实例2:10GB显存 - 在K8s中使用MIG实例:

resources: limits: nvidia.com/gpu: mig-1g.10gb # 请求1个10GB的MIG实例

效果:一块A100 GPU可同时运行3个ResNet50模型(每个实例10GB显存),资源利用率从30%提升到80%。

维度5:监控与调优——“用数据找瓶颈”

优化的关键是定位瓶颈,而监控是定位瓶颈的唯一手段。需监控的核心指标:

- 请求层:QPS、延迟(P95/P99)、错误率;

- 模型层:GPU利用率、显存占用、Batch Size分布;

- 系统层:CPU利用率、内存占用、网络带宽。

5.1 监控工具链:Prometheus + Grafana

步骤1:收集指标

TFServing的指标接口:http://<host>:8501/monitoring/prometheus/metrics

Triton的指标接口:http://<host>:8002/metrics

步骤2:配置Prometheus抓取

scrape_configs:

- job_name: 'tfserving'

static_configs:

- targets: ['tfserving:8501']

- job_name: 'triton'

static_configs:

- targets: ['triton:8002']

步骤3:Grafana可视化

导入Grafana Dashboard模板(如Triton的官方模板:13786),可看到:

- 实时QPS和延迟曲线;

- GPU利用率和显存占用;

- Batch Size分布和队列长度。

5.2 瓶颈定位与调优案例

案例1:GPU利用率低,延迟高

- 现象:GPU利用率仅20%,P95延迟300ms;

- 分析:动态Batch的等待时间太短(1ms),导致Batch Size太小(平均5),GPU没充分利用;

- 调优:将Triton的

max_queue_delay_microseconds从1ms改为2ms; - 效果:平均Batch Size提升到15,GPU利用率提升到60%,P95延迟降到150ms。

案例2:QPS上不去,CPU利用率高

- 现象:QPS仅50,CPU利用率90%;

- 分析:模型预处理(如图像解码、归一化)在CPU上运行,成为瓶颈;

- 调优:将预处理逻辑迁移到GPU(用CUDA或TensorRT的预处理库);

- 效果:CPU利用率降到30%,QPS提升到200。

三、实战:用Triton优化BERT模型Serving性能

3.1 环境搭建

- 安装Docker和NVIDIA Container Toolkit;

- 拉取Triton镜像:

docker pull nvcr.io/nvidia/tritonserver:23.05-py3; - 准备模型:将BERT模型转换为ONNX格式(见维度1.3);

- 启动Triton容器:

docker run --gpus all --rm -p 8000:8000 -p 8001:8001 -p 8002:8002 -v /path/to/models:/models nvcr.io/nvidia/tritonserver:23.05-py3 tritonserver --model-repository=/models

3.2 模型配置(config.pbtxt)

name: "bert"

platform: "onnxruntime_onnx"

max_batch_size: 64

input [

{

name: "input_ids"

data_type: TYPE_INT64

dims: [ -1 ] # 动态序列长度

},

{

name: "attention_mask"

data_type: TYPE_INT64

dims: [ -1 ]

},

{

name: "token_type_ids"

data_type: TYPE_INT64

dims: [ -1 ]

}

]

output [

{

name: "output"

data_type: TYPE_FP32

dims: [ -1, 768 ] # BERT的隐藏状态维度

}

]

dynamic_batching {

preferred_batch_size: [16, 32, 64]

max_queue_delay_microseconds: 2000

}

instance_group {

count: 2

kind: KIND_GPU

gpus: [0, 1]

tensorrt {

precision_mode: PRECISION_MODE_INT8

}

}

3.3 性能测试(Locust)

用Locust模拟100并发用户,测试QPS和延迟:

from locust import HttpUser, task, between

import numpy as np

import json

class BertUser(HttpUser):

wait_time = between(0.1, 0.5)

@task

def infer(self):

# 生成随机输入(序列长度128)

input_ids = np.random.randint(0, 10000, size=(1, 128), dtype=np.int64).tolist()

attention_mask = np.ones((1, 128), dtype=np.int64).tolist()

token_type_ids = np.zeros((1, 128), dtype=np.int64).tolist()

# 构造请求数据

data = {

"inputs": [

{"name": "input_ids", "shape": [1, 128], "datatype": "INT64", "data": input_ids},

{"name": "attention_mask", "shape": [1, 128], "datatype": "INT64", "data": attention_mask},

{"name": "token_type_ids", "shape": [1, 128], "datatype": "INT64", "data": token_type_ids},

]

}

# 发送POST请求

self.client.post("/v2/models/bert/infer", json=data)

3.4 测试结果

| 配置 | QPS | P95延迟(ms) | GPU利用率 |

|---|---|---|---|

| 原始BERT(FP32) | 80 | 300 | 40% |

| 量化+BERT(INT8) | 200 | 120 | 70% |

| 量化+动态Batch | 300 | 80 | 85% |

四、工具与资源推荐

4.1 模型优化工具

- TensorRT:NVIDIA的GPU加速库,支持量化、剪枝、层融合;

- ONNX Runtime:跨平台的ONNX模型推理引擎;

- PyTorch Quantization:PyTorch原生的量化工具;

- TensorFlow Lite:TensorFlow的移动端/边缘设备模型优化工具。

4.2 Serving框架

- Triton Inference Server:工业界首选,支持多框架、动态Batch、模型并行;

- TensorFlow Serving:TensorFlow原生框架,适合纯TF模型;

- TorchServe:PyTorch原生框架,支持模型版本管理;

- MLflow Model Serving:适合MLflow生态的模型部署。

4.3 监控与测试工具

- Prometheus:开源监控系统,收集时间序列数据;

- Grafana:开源可视化工具,构建Dashboard;

- Locust:开源压力测试工具,模拟高并发用户;

- Jaeger:分布式追踪工具,定位请求延迟瓶颈。

五、未来趋势与挑战

5.1 未来趋势

- Serverless模型Serving:无需管理服务器,按请求量付费(如AWS SageMaker Serverless);

- 边缘Serving:将模型部署到边缘设备(摄像头、路由器),减少网络延迟;

- 大模型高效Serving:动态张量并行、流水线并行、模型分片(如Triton的

ensemble功能); - AI原生Serving框架:自动优化模型(自动量化、剪枝)、自动配置参数(自动选择Batch Size)。

5.2 挑战

- 大模型的显存瓶颈:GPT-3级别的模型需要数百GB显存,如何高效利用多GPU;

- 实时性与吞吐量的平衡:实时请求要求低延迟,批量请求要求高吞吐量,如何动态调整;

- 多模型协同:推荐系统中需同时运行多个模型(召回、排序、重排),如何调度资源。

六、总结

模型Serving性能优化是**"从模型到用户"的全链路工程**,需从以下5点入手:

- 模型本身:用压缩、蒸馏、格式转换让模型变轻;

- 部署框架:选对框架(如Triton),配置动态Batch、模型并行;

- 请求处理:用gRPC、客户端Batch提升传输效率;

- 资源调度:用K8s、MIG合理分配资源;

- 监控调优:用Prometheus+Grafana定位瓶颈,持续优化。

最后送大家一句话:“优化的终点不是’性能最优’,而是’符合业务需求的最优’”——不要为了追求极致性能而牺牲可维护性,要平衡性能、成本和开发效率。

希望这篇文章能帮你解决模型Serving的性能问题,如果你有疑问或补充,欢迎在评论区交流!

更多推荐

已为社区贡献186条内容

已为社区贡献186条内容

所有评论(0)