AI应用架构师如何推动智能营销AI决策系统的落地?

在数字化营销时代,企业面临着前所未有的挑战:用户触点分散在20+个渠道(社交媒体、电商平台、线下门店等),日均产生TB级用户行为数据,传统营销决策依赖“经验驱动”,导致。

AI应用架构师实战指南:智能营销AI决策系统从设计到落地的全流程解析

副标题:基于数据驱动与大模型融合的营销决策革新

摘要/引言 (Abstract / Introduction)

问题陈述

在数字化营销时代,企业面临着前所未有的挑战:用户触点分散在20+个渠道(社交媒体、电商平台、线下门店等),日均产生TB级用户行为数据,传统营销决策依赖“经验驱动”,导致三大核心痛点:

- 数据孤岛严重:CRM、交易系统、广告平台等数据分散,无法形成统一用户视图;

- 决策滞后低效:活动效果分析需1-3天,错失实时优化机会;

- 个性化不足:60%的营销内容因“千人一面”导致用户点击率低于行业均值30%。

智能营销AI决策系统本应解决这些问题,但落地成功率不足40%(Gartner 2023报告),核心瓶颈在于:技术方案与业务需求脱节、数据质量不达标、系统扩展性不足、模型解释性差导致业务信任度低。

核心方案

AI应用架构师作为“技术与业务的桥梁”,需从**“业务目标-数据架构-算法选型-系统落地-持续运营”全链路推动系统落地。本文提出“五阶落地方法论”**:

- 需求锚定:将营销目标(如“提升复购率20%”)拆解为可量化的AI决策指标;

- 数据筑基:构建“数据湖-数据仓库-特征平台”三层数据架构,打破数据孤岛;

- 模型融合:结合传统机器学习(用户分群、归因分析)与大模型(内容生成、意图识别),平衡精度与效率;

- 系统工程:采用“微服务+流处理”架构,实现实时决策(延迟<100ms)与高可用(99.9% SLA);

- 闭环迭代:建立“数据采集-模型预测-决策执行-效果反馈”闭环,持续优化模型与策略。

主要成果/价值

读完本文后,你将掌握:

- 架构设计能力:智能营销AI决策系统的核心模块(数据层、算法层、应用层)设计与技术选型;

- 落地执行框架:从需求调研到系统上线的10个关键里程碑与交付物;

- 问题解决工具:数据质量治理、模型冷启动、业务规则冲突等12个落地难题的解决方案;

- 最佳实践案例:某零售企业“智能导购AI决策系统”落地实例(复购率提升27%,ROI提升35%)。

文章导览

本文分为四部分:

- 第一部分(基础篇):解析智能营销AI决策系统的核心概念与落地挑战;

- 第二部分(设计篇):详解架构师如何设计数据、算法、应用三层架构;

- 第三部分(落地篇):全流程落地步骤(需求分析→技术选型→开发测试→上线运营);

- 第四部分(进阶篇):性能优化、风险规避、未来趋势与扩展方向。

目标读者与前置知识 (Target Audience & Prerequisites)

目标读者

- AI应用架构师:负责AI系统技术选型与整体架构设计;

- 数据工程师/算法工程师:参与数据处理或模型开发的技术人员;

- 营销技术负责人:需理解技术方案与业务结合点的业务方;

- CTO/技术总监:评估项目可行性与资源投入的决策者。

前置知识

- 技术基础:

- 熟悉Python/Java编程,了解SQL与NoSQL数据库(如PostgreSQL、MongoDB);

- 了解机器学习基本概念(分类、聚类、回归),无需深入算法细节;

- 了解数据仓库(DWH)、ETL流程、RESTful API设计;

- 业务基础:

- 了解营销术语(用户分群、转化率、归因分析、A/B测试);

- 对CRM、广告投放平台(如巨量引擎、Google Ads)有基本认知。

文章目录 (Table of Contents)

第一部分:引言与基础 (Introduction & Foundation)

- 引人注目的标题

- 摘要/引言

- 目标读者与前置知识

- 文章目录

第二部分:核心内容 (Core Content)

- 问题背景与动机:传统营销决策的痛点与AI革新方向

- 核心概念与理论基础:智能营销AI决策系统的架构与技术栈

- 环境准备:开发与部署环境的技术选型与配置指南

- 分步实现:从需求分析到系统上线的全流程拆解

8.1 阶段一:业务需求拆解与AI能力映射

8.2 阶段二:数据架构设计与数据资产建设

8.3 阶段三:算法模型选型与混合决策引擎开发

8.4 阶段四:应用层设计与多端集成(B端+营销渠道)

8.5 阶段五:测试验证与灰度发布 - 关键代码解析与深度剖析:核心模块的设计思路与技术细节

第三部分:验证与扩展 (Verification & Extension)

- 结果展示与验证:效果评估指标与成功案例

- 性能优化与最佳实践:从数据到模型的全链路优化策略

- 常见问题与解决方案:12个落地难题的避坑指南

- 未来展望与扩展方向:大模型与营销决策的深化融合

第四部分:总结与附录 (Conclusion & Appendix)

- 总结:AI应用架构师的核心能力与落地关键成功因素

- 参考资料

- 附录:核心配置文件与代码仓库

5. 问题背景与动机 (Problem Background & Motivation)

5.1 传统营销决策的三大核心痛点

痛点1:数据碎片化,决策缺乏统一视图

- 现状:企业数据分散在多系统(CRM、ERP、电商平台、小程序、线下POS),形成“数据烟囱”。某快消企业调研显示,其营销部门需从8个系统手动导出数据,每周花16小时整合,且各系统用户ID不统一(如手机号、设备ID、会员ID),导致“同一个用户被识别为3个独立ID”。

- 影响:无法精准勾勒用户画像(如用户在小程序浏览商品但未下单,线下门店无法识别其偏好),个性化营销无从谈起。

痛点2:决策链路长,实时性差

- 现状:传统营销决策流程为“数据采集(T+1)→人工分析(1-2天)→制定策略(1天)→落地执行(1-3天)”,全链路耗时3-7天。

- 案例:某电商平台“618大促”期间,某单品销量突增但库存不足,传统流程需2天后才发现并调整广告投放,导致超50万广告费浪费在已缺货商品上。

痛点3:经验驱动为主,效果难以量化与复制

- 现状:70%的营销决策依赖“老法师经验”(如“30-35岁女性喜欢粉色包装”),缺乏数据验证。某服饰品牌调研显示,其50%的新品推广活动因“经验判断失误”导致ROI<1。

- 深层问题:经验难以跨场景复制(如一线城市的策略在下沉市场失效),且无法应对用户行为的快速变化(如Z世代消费偏好的月级变化)。

5.2 AI决策系统的革新价值:数据驱动与实时智能

价值1:全渠道数据整合,构建360°用户画像

- 技术路径:通过ID-Mapping(设备指纹、手机号哈希、社交账号关联)打通多源数据,构建统一用户ID体系。

- 效果:某零售企业接入12个数据源后,用户识别准确率从62%提升至91%,重复触达率降低40%。

价值2:实时决策引擎,响应速度从“天级”压缩至“毫秒级”

- 技术路径:采用流处理框架(Flink/Kafka Streams)实时处理用户行为数据,结合预训练模型实现实时预测。

- 案例:某餐饮品牌“智能点餐推荐系统”通过实时分析用户历史订单+当前时段(如周末午餐偏好轻食),推荐准确率提升35%,点餐时长缩短20秒。

价值3:个性化决策自动化,从“千人一面”到“一人千面”

- 技术路径:基于用户分群(K-Means/DBSCAN)+个性化推荐(协同过滤/深度学习模型)+大模型内容生成(如GPT-4生成个性化短信文案)。

- 效果:某美妆品牌个性化推送系统上线后,CTR提升58%,客单价提升22%。

5.3 AI应用架构师的核心职责:技术可行性与业务价值的平衡

AI决策系统落地失败的三大主因(Gartner 2023):

- 技术选型激进:盲目采用“大模型+实时流”等复杂技术,忽视数据基础与团队能力;

- 业务需求脱节:技术方案未对齐营销核心KPI(如“提升复购率”而非“模型准确率”);

- 缺乏持续运营机制:上线后未监控数据漂移与模型效果衰减,6个月后准确率下降至随机水平。

架构师的关键角色:

- 需求翻译官:将“提升复购率”转化为“用户流失风险预测模型+个性化召回策略”;

- 技术守门人:在“效果”与“成本”间平衡(如中小企优先用开源模型而非API调用);

- 落地推动者:协调数据、算法、业务团队,制定清晰里程碑与交付物。

6. 核心概念与理论基础 (Core Concepts & Theoretical Foundation)

6.1 智能营销AI决策系统的定义与核心目标

定义:以用户数据为核心,通过AI技术(机器学习、大模型等)实现营销决策的自动化、个性化、实时化,最终提升营销ROI与用户体验的系统。

核心目标(SMART原则):

- Specific:明确业务指标(如“新客转化率提升15%”而非“提升效果”);

- Measurable:可量化(通过A/B测试对比AI决策与人工决策的效果);

- Actionable:输出可直接执行的决策(如“向用户A推送50元优惠券+商品B”);

- Real-Time:决策延迟<1秒(适用于实时营销场景如APP弹窗);

- Adaptable:可随数据分布变化自动迭代模型(如季节性用户行为变化)。

6.2 系统架构:三层九模块的技术框架

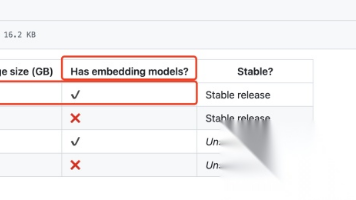

![智能营销AI决策系统架构图]

(注:实际图表需包含数据层、算法层、应用层,各层子模块及数据流)

6.2.1 数据层:从“数据孤岛”到“数据资产”

- 数据源接入模块:对接内外部数据源(CRM、ERP、广告平台API、埋点数据、第三方DMP);

- 数据清洗与治理模块:处理缺失值(如用均值/模型预测填充)、异常值(3σ法则/IQR)、重复数据(MD5去重);

- 特征平台模块:构建结构化特征库(用户基础属性、行为特征、交易特征),支持特征生命周期管理(版本控制、血缘追踪)。

技术选型:

- 批处理:Spark/Flink(数据量大时)、Pandas(小数据量探索);

- 存储:数据湖(S3/HDFS)、数据仓库(Snowflake/ClickHouse)、特征存储(Feast/Hopsworks)。

6.2.2 算法层:从“单一模型”到“混合决策”

- 用户理解模块:用户分群(K-Means)、用户画像(标签体系构建)、用户意图识别(BERT/大模型分类);

- 预测与推荐模块:转化率预测(XGBoost/LightGBM)、个性化推荐(DeepFM/Wide&Deep)、LTV预测(生存分析);

- 内容生成模块:营销文案生成(GPT-4/LLaMA微调)、广告素材优化(多模态模型生成图片/短视频);

- 决策引擎模块:规则引擎(业务约束如“新客首单满减”)+模型推理(AI预测结果)+强化学习(动态优化决策策略)。

技术选型:

- 传统机器学习:Scikit-learn/XGBoost;

- 深度学习:TensorFlow/PyTorch;

- 大模型:开源(LLaMA 2/Mistral)或API(GPT-4/文心一言);

- 规则引擎:Drools/Redis Rules。

6.2.3 应用层:从“技术能力”到“业务价值”

- 营销决策平台(B端):供运营人员配置策略(如“对流失风险>0.7的用户发送挽留券”)、查看效果报表;

- 渠道集成模块:对接营销渠道API(短信、邮件、APP推送、广告平台),实现决策自动执行;

- 监控与反馈模块:实时监控模型效果(准确率/auc)、系统性能(响应时间/吞吐量)、业务指标(转化率/ROI)。

技术选型:

- 前端:React/Vue.js(B端平台)、ECharts/DataV(可视化);

- 后端:Spring Boot/Node.js(微服务);

- 消息队列:Kafka(数据流传递)、RabbitMQ(任务调度);

- 监控:Prometheus+Grafana(系统监控)、MLflow(模型监控)。

6.3 关键技术概念解析

概念1:ID-Mapping——打通多源数据的核心技术

- 定义:将不同数据源中的用户标识(手机号、设备ID、Cookie、社交账号)关联为统一用户ID的过程。

- 实现方式:

- 确定性匹配:直接关联(如用户登录时用手机号绑定设备ID);

- 概率性匹配:基于共同特征(如IP地址、设备型号、行为序列相似度)计算关联概率,阈值通常设为0.8以上。

概念2:实时决策与批处理决策的协同

- 实时决策(<1秒):适用于用户当前行为触发的场景(如APP首页推荐、弹窗优惠),依赖流处理+预训练模型;

- 批处理决策(T+1):适用于周期性策略(如每周用户分群、月度优惠券发放),依赖批处理数据+离线模型。

- 协同策略:实时决策调用批处理生成的用户标签(如“高价值用户”),批处理基于实时行为数据更新模型。

概念3:规则引擎与AI模型的融合决策

- 业务规则优先场景:合规约束(如“未成年人不可推送酒精广告”)、成本控制(如“单用户日推送不超过3次”);

- AI模型优先场景:个性化推荐、动态定价(如酒店收益管理);

- 混合模式:AI模型输出预测结果→规则引擎过滤(如“排除近7天已购买用户”)→最终决策。

7. 环境准备 (Environment Setup)

7.1 技术栈选型清单

| 模块 | 工具/框架推荐 | 选型理由(中小企/大企业) |

|---|---|---|

| 数据采集 | Apache Flume/Kafka Connect | 开源免费,支持多源接入(日志、数据库CDC、API) |

| 数据清洗 | Apache Spark (PySpark) | 分布式处理,支持SQL与Python,生态完善 |

| 数据存储 | 数据湖:MinIO(中小企)/S3(大企业) | 低成本存储海量非结构化数据 |

| 数据仓库:ClickHouse(中小企)/Snowflake(大企业) | 列式存储,查询性能优异,支持实时分析 | |

| 特征平台 | Feast(开源)/Hopsworks(企业版) | 支持特征版本控制与在线服务,与Spark/PyTorch集成 |

| 机器学习框架 | Scikit-learn/XGBoost | 轻量高效,适合传统模型;XGBoost对结构化数据友好 |

| 深度学习框架 | PyTorch | 动态图,调试便捷,适合科研与快速迭代 |

| 大模型 | LLaMA 2 7B(本地部署)/GPT-4 API | 7B模型可在单GPU运行;API适合无算力资源的团队 |

| 规则引擎 | Redis Rules(轻量)/Drools(复杂规则) | Redis Rules基于Redis,低延迟;Drools支持复杂规则链 |

| 微服务框架 | Spring Boot(Java)/FastAPI(Python) | Spring Boot生态成熟;FastAPI适合Python数据团队 |

| 消息队列 | Kafka | 高吞吐、低延迟,支持流处理与异步通信 |

| 监控工具 | Prometheus+Grafana+MLflow | 覆盖系统监控与模型全生命周期管理 |

7.2 开发环境配置指南

7.2.1 本地开发环境(个人调试)

- 硬件要求:16G内存(特征处理)、GPU(可选,模型训练,如RTX 3090/4090);

- 软件安装:

# 创建虚拟环境 conda create -n marketing-ai python=3.9 conda activate marketing-ai # 安装数据处理库 pip install pandas numpy pyspark==3.4.0 scikit-learn==1.2.2 # 安装机器学习/深度学习库 pip install xgboost==1.7.5 lightgbm==3.3.5 torch==2.0.1 transformers==4.30.2 # 安装特征平台与规则引擎 pip install feast==0.34.0 redis==4.5.5 # 安装API开发库 pip install fastapi==0.104.1 uvicorn==0.23.2

7.2.2 测试/生产环境(Docker容器化部署)

Docker Compose配置示例(docker-compose.yml):

version: '3'

services:

# 数据仓库

clickhouse:

image: yandex/clickhouse-server:23.7

ports: ["8123:8123"]

volumes: ["./clickhouse/data:/var/lib/clickhouse"]

# 消息队列

kafka:

image: confluentinc/cp-kafka:7.4.0

depends_on:

- zookeeper

environment:

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://kafka:9092

KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR: 1

ports: ["9092:9092"]

zookeeper:

image: confluentinc/cp-zookeeper:7.4.0

environment:

ZOOKEEPER_CLIENT_PORT: 2181

# 特征存储

feast:

build: ./feast

volumes: ["./feast/repo:/app"]

command: feast serve --host 0.0.0.0

# 决策引擎API服务

decision-engine:

build: ./decision-engine

ports: ["8000:8000"]

depends_on: [kafka, clickhouse, feast]

7.3 数据准备:样本数据集与接入示例

7.3.1 样本数据集结构

- 用户表(users):user_id, phone, age, gender, register_time

- 行为表(user_behavior):user_id, behavior_type(浏览/加购/购买), item_id, timestamp, device_id

- 交易表(transactions):order_id, user_id, item_id, amount, pay_time

- 营销活动表(campaigns):campaign_id, channel(短信/APP推送), content, send_time

7.3.2 数据接入代码示例(Kafka Connect读取MySQL数据)

// Kafka Connect配置文件:mysql-source-connector.json

{

"name": "mysql-users-connector",

"config": {

"connector.class": "io.debezium.connector.mysql.MySqlConnector",

"database.hostname": "mysql-host",

"database.port": "3306",

"database.user": "root",

"database.password": "password",

"database.server.id": "184054",

"database.server.name": "mysql-server",

"table.include.list": "marketing.users", // 需同步的表

"database.history.kafka.bootstrap.servers": "kafka:9092",

"database.history.kafka.topic": "schema-changes.users"

}

}

8. 分步实现 (Step-by-Step Implementation)

8.1 阶段一:业务需求拆解与AI能力映射(2周)

8.1.1 目标:从“业务目标”到“可执行的AI任务”

- 输出物:《AI决策系统需求规格说明书》,包含:

- 业务目标(如“提升沉睡用户唤醒率30%”);

- 核心场景(如“沉睡用户识别→个性化唤醒策略→效果追踪”);

- AI能力需求(如“用户流失预测模型(准确率>0.85)”“个性化短信文案生成”);

- 非功能需求(响应时间<500ms,支持10万用户/天的决策请求)。

8.1.2 关键步骤:业务调研与需求对齐

-

** stakeholder访谈**:

- 与营销负责人确认核心KPI(如“复购率”“客单价”);

- 与运营人员了解现有流程痛点(如“手动筛选目标用户耗时4小时/次”);

- 与IT团队确认数据源可用性(如“CRM系统是否提供API接口”)。

-

需求优先级排序(MoSCoW法则):

- Must have(必须实现):用户流失预测、基础分群;

- Should have(应该实现):个性化文案生成;

- Could have(可以实现):跨渠道协同决策;

- Won’t have(暂不实现):AR虚拟试妆(资源受限)。

-

AI能力与业务场景映射表:

| 业务场景 | AI能力需求 | 输入数据 | 输出决策 | 评估指标 |

|---|---|---|---|---|

| 沉睡用户唤醒 | 流失风险预测(二分类) | 用户近90天行为/交易数据 | 流失概率(0-1) | 唤醒率(响应率) |

| 个性化优惠券发放 | 用户价格敏感度预测 | 历史领券/核销记录 | 优惠券面额(10-100元) | 核销率 |

| 广告素材优化 | 素材点击率预测(多分类) | 历史素材特征+用户反馈 | 最优素材ID | CTR(点击率) |

8.2 阶段二:数据架构设计与数据资产建设(4周)

8.2.1 目标:构建“采-存-算-管”一体化数据平台

- 输出物:数据架构图、数据字典、ETL脚本、特征库(含100+用户特征)。

8.2.2 关键步骤:从数据源到特征工程

步骤1:数据源接入与ID-Mapping

- 多源数据接入:通过Kafka Connect接入MySQL(用户/交易数据)、Flume采集APP日志(行为数据)、API对接广告平台(巨量引擎/Google Ads);

- ID-Mapping实现:

# 简化版ID-Mapping代码(基于PySpark) from pyspark.sql import SparkSession from pyspark.sql.functions import col, sha2, when, max spark = SparkSession.builder.appName("id_mapping").getOrCreate() # 读取多源ID数据(设备ID、手机号、Cookie) device_data = spark.read.table("raw_data.device_logs").select("device_id", "ip", "timestamp") user_data = spark.read.table("raw_data.user_registrations").select("user_id", "phone", "device_id") # 手机号哈希处理(保护隐私) user_data = user_data.withColumn("phone_hash", sha2(col("phone"), 256)) # 确定性匹配:用户注册时的device_id直接关联user_id deterministic_mapping = user_data.select("user_id", "device_id", "phone_hash") # 概率性匹配(示例:基于IP地址关联未登录设备) ip_mapping = device_data.groupBy("ip").agg(max("device_id").alias("most_frequent_device")) probabilistic_mapping = device_data.join(ip_mapping, on="ip", how="left") \ .select(col("device_id").alias("unknown_device"), col("most_frequent_device").alias("matched_device")) # 合并结果,生成统一用户ID(uid) final_mapping = deterministic_mapping.union(probabilistic_mapping) final_mapping.write.mode("overwrite").saveAsTable("user_data.unified_user_mapping")

步骤2:数据清洗与治理

- 缺失值处理:用户年龄缺失用“用户分群均值”填充,行为数据缺失标记为“无行为”;

- 异常值处理:交易金额>3σ视为异常,标记为“可疑交易”并人工审核;

- 数据质量监控:用Great Expectations定义规则(如“user_id非空”“交易金额>0”),每日生成质量报告。

步骤3:特征工程与特征平台建设

-

特征分类:

- 基础特征:age, gender, register_days(注册天数);

- 行为特征:last_7d_click_cnt(近7天点击次数), avg_session_duration(平均会话时长);

- 交易特征:total_payment(总消费), avg_order_value(客单价), last_payment_days(上次消费距今天数);

- 标签特征:is_high_value(高价值用户,消费>5000元), churn_risk(流失风险,模型预测结果)。

-

Feast特征库定义示例(

feature_store.yaml):project: marketing_ai registry: s3://marketing-feast/registry.db provider: local online_store: type: redis connection_string: "redis:6379" offline_store: type: file base_path: /data/feast/offline_store -

用户特征视图定义(

user_features.py):from feast import Entity, FeatureView, ValueType, Field from datetime import timedelta # 定义实体(用户) user = Entity(name="user_id", value_type=ValueType.INT64, description="统一用户ID") # 定义特征视图 user_transaction_features = FeatureView( name="user_transaction_features", entities=["user_id"], ttl=timedelta(days=365), schema=[ Field(name="total_payment", dtype=ValueType.FLOAT), Field(name="avg_order_value", dtype=ValueType.FLOAT), Field(name="last_payment_days", dtype=ValueType.INT64), ], source=FileSource( path="/data/feast/user_transaction_features.parquet", event_timestamp_column="event_timestamp", ), ) -

特征部署:

feast apply # 注册特征到仓库 feast materialize-incremental $(date -u +"%Y-%m-%dT%H:%M:%S") # 同步特征到在线存储

8.3 阶段三:算法模型选型与混合决策引擎开发(6周)

8.3.1 目标:开发核心模型与决策逻辑,实现“模型预测+规则约束”的混合决策

- 输出物:模型训练代码、决策引擎代码、模型评估报告(准确率/auc等)。

8.3.2 关键步骤:从模型选型到决策逻辑实现

步骤1:模型选型与训练——以“用户流失预测”为例

- 问题定义:二分类任务(流失=1:近90天无交易;非流失=0);

- 数据准备:

- 训练集:历史1年数据(用户特征+标签),正负样本比1:3(通过SMOTE解决不平衡);

- 验证集:最近1个月数据。

- 模型选型对比:

| 模型 | 准确率 | AUC | 训练时间 | 推理延迟 | 选型结论 |

|---|---|---|---|---|---|

| Logistic回归 | 0.78 | 0.82 | 5min | 1ms | 基线模型 |

| XGBoost | 0.86 | 0.91 | 30min | 5ms | 最终选型(平衡精度与效率) |

| LightGBM | 0.85 | 0.90 | 20min | 4ms | 备选模型 |

| 深度学习(MLP) | 0.87 | 0.92 | 2h | 20ms | 放弃(推理延迟高) |

- 模型训练代码示例:

import xgboost as xgb from sklearn.model_selection import train_test_split from sklearn.metrics import accuracy_score, roc_auc_score import pandas as pd # 加载特征数据 features = pd.read_parquet("/data/feast/features.parquet") X = features.drop(["user_id", "churn_label"], axis=1) y = features["churn_label"] # 划分训练集/验证集 X_train, X_val, y_train, y_val = train_test_split(X, y, test_size=0.2, random_state=42) # 训练XGBoost模型 model = xgb.XGBClassifier( n_estimators=100, max_depth=5, learning_rate=0.1, objective="binary:logistic" ) model.fit(X_train, y_train, eval_set=[(X_val, y_val)], early_stopping_rounds=10) # 评估 y_pred = model.predict(X_val) y_proba = model.predict_proba(X_val)[:, 1] print(f"准确率: {accuracy_score(y_val, y_pred):.2f}") print(f"AUC: {roc_auc_score(y_val, y_proba):.2f}") # 保存模型 model.save_model("/models/churn_prediction_xgb.json")

步骤2:大模型应用——个性化营销文案生成

- 技术选型:基于LLaMA 2 7B微调(中小企,成本低)或调用GPT-4 API(大企业,效果优);

- 微调数据准备:收集历史优质文案(如“唤醒率>20%的短信”),格式为

{"用户特征": "...", "优质文案": "..."}; - 提示词工程(零样本/少样本):

# GPT-4 API调用示例(少样本提示) import openai def generate_sms(user_features, churn_risk): prompt = f""" 任务:为流失风险用户生成个性化挽留短信。 用户特征:{user_features}(如:30岁女性,偏好护肤品,上次消费距今60天) 流失风险:{churn_risk}(高/中/低) 要求: - 语气亲切,突出用户专属感; - 包含限时优惠(如“24小时内领券”); - 字数控制在60字以内。 示例: 用户特征:25岁男性,喜欢运动鞋,上次消费距今45天 流失风险:中 文案:【专属福利】小明,45天没见啦~你的专属50元无门槛券已到账,24小时内可用,快来挑双新鞋吧!退订回T 请生成文案: """ response = openai.ChatCompletion.create( model="gpt-4", messages=[{"role": "user", "content": prompt}], temperature=0.7 # 控制随机性(0-1) ) return response.choices[0].message['content'] # 调用 user_features = "30岁女性,偏好护肤品,上次消费距今60天,历史客单价300元" churn_risk = "高" sms = generate_sms(user_features, churn_risk) print(sms) # 输出:【紧急召回】亲爱的,60天未见,您的专属80元护肤品券已失效倒计时24小时,速领→[链接] 退订回T

步骤3:混合决策引擎开发——规则+模型协同

-

决策流程:

- 输入用户ID→特征平台获取实时特征;

- 调用流失预测模型→输出流失概率P;

- 规则引擎过滤:若P>0.7且近7天未推送→进入下一步;

- 调用价格敏感度模型→推荐优惠券面额;

- 调用大模型→生成个性化文案;

- 输出最终决策:{user_id, coupon_amount, sms_content, send_time}。

-

决策引擎代码示例(FastAPI):

from fastapi import FastAPI import xgboost as xgb import redis from feast import FeatureStore from pydantic import BaseModel app = FastAPI() # 加载模型与连接资源 churn_model = xgb.Booster(model_file="/models/churn_prediction_xgb.json") redis_client = redis.Redis(host="redis", port=6379) feature_store = FeatureStore(repo_path="/feast") class UserRequest(BaseModel): user_id: int @app.post("/marketing/decision") def get_marketing_decision(request: UserRequest): # 1. 获取用户特征 features = feature_store.get_online_features( features=["user_transaction_features:total_payment", "user_behavior_features:last_7d_click_cnt"], entity_rows=[{"user_id": request.user_id}] ).to_dict() # 2. 流失风险预测 dmatrix = xgb.DMatrix([[features["total_payment"][0], features["last_7d_click_cnt"][0]]]) churn_prob = churn_model.predict(dmatrix)[0] # 3. 规则过滤(近7天未推送) last_send_time = redis_client.get(f"last_send:{request.user_id}") if last_send_time and (datetime.now() - last_send_time).days <7: return {"decision": "reject", "reason": "recently sent"} # 4. 生成决策(简化版,实际需调用价格敏感度模型与大模型) if churn_prob > 0.7: return { "decision": "send", "coupon_amount": 50, "sms_content": generate_sms(features, "高"), "send_time": "immediate" } else: return {"decision": "reject", "reason": "low churn risk"}

8.4 阶段四:应用层设计与多端集成(3周)

8.4.1 目标:开发B端决策平台与渠道集成接口,实现决策自动化执行

- 输出物:B端平台UI原型、API文档、渠道集成脚本。

8.4.2 关键步骤:B端平台开发与渠道对接

步骤1:B端营销决策平台(前端示例)

- 核心功能:

- 策略配置(如“当流失概率>0.7时,发放50元券”);

- 效果监控仪表盘(实时展示“唤醒率”“核销率”“ROI”);

- 模型管理(查看模型版本、准确率趋势)。

- 技术栈:React + TypeScript + ECharts,UI框架用Ant Design Pro。

步骤2:营销渠道集成(API对接)

- 对接对象:短信网关(如阿里云短信)、APP推送(如极光推送)、广告平台(如巨量引擎API);

- 代码示例(短信发送接口):

# 阿里云短信API调用 import json from aliyunsdkcore.client import AcsClient from aliyunsdkcore.request import CommonRequest client = AcsClient("access_key", "secret", "cn-hangzhou") def send_sms(phone, content): request = CommonRequest() request.set_method("POST") request.set_domain("dysmsapi.aliyuncs.com") request.set_version("2017-05-25") request.set_action_name("SendSms") request.add_query_param("PhoneNumbers", phone) request.add_query_param("SignName", "品牌名") request.add_query_param("TemplateCode", "SMS_12345678") request.add_query_param("TemplateParam", json.dumps({"content": content})) response = client.do_action_with_exception(request) return json.loads(response)

8.5 阶段五:测试验证与灰度发布(2周)

8.5.1 目标:通过多维度测试确保系统稳定与效果达标

- 输出物:测试报告、灰度发布方案、应急预案。

8.5.2 关键步骤:测试与发布流程

步骤1:测试类型

- 功能测试:验证决策逻辑正确性(如“高流失用户是否触发挽留策略”);

- 性能测试:用JMeter模拟1000 QPS请求,验证响应时间<500ms;

- A/B测试:选择10%用户作为实验组(AI决策),10%作为对照组(人工决策),对比唤醒率/ROI;

- 安全测试:检查数据加密(如手机号哈希)、权限控制(如运营人员仅能查看权限内数据)。

步骤2:灰度发布策略

- 阶段1(5%用户):验证系统稳定性,重点监控错误率;

- 阶段2(20%用户):评估业务效果,对比实验组vs对照组;

- 阶段3(100%用户):全量上线,同步启动监控与迭代机制。

9. 关键代码解析与深度剖析

9.1 混合决策引擎的设计思路:规则与模型的协同机制

核心挑战:如何平衡AI模型的灵活性与业务规则的刚性约束?

- 解决方案:采用“双引擎串联”架构——模型输出概率→规则引擎过滤/修正→最终决策。

代码深度剖析:

class HybridDecisionEngine:

def __init__(self, model_path, rule_config_path):

self.model = self.load_model(model_path) # 加载AI模型

self.rules = self.load_rules(rule_config_path) # 加载业务规则(JSON/YAML)

def load_rules(self, path):

# 规则示例:{"reject_rules": [{"field": "last_send_days", "operator": "<", "value": 7}]}

with open(path, "r") as f:

return json.load(f)

def apply_rules(self, decision_candidate, user_features):

# 1. 拒绝规则(硬约束)

for rule in self.rules["reject_rules"]:

field_value = user_features[rule["field"]]

if eval(f"{field_value} {rule['operator']} {rule['value']}"): # 谨慎使用eval,实际可用算子映射

return {"decision": "reject", "reason": f"rule: {rule}"}

# 2. 修正规则(调整模型输出)

for rule in self.rules["adjust_rules"]:

if user_features.get(rule["field"]) == rule["value"]:

decision_candidate[rule["target_field"]] *= rule["factor"] # 如“高价值用户面额×1.5”

return decision_candidate

def predict(self, user_features):

# 1. 模型预测

model_output = self.model.predict(user_features) # 如{"coupon_amount": 50, "sms_content": "..."}

# 2. 规则应用

final_decision = self.apply_rules(model_output, user_features)

return final_decision

# 使用示例

engine = HybridDecisionEngine(model_path="/models/churn_xgb.json", rule_config_path="/rules/marketing_rules.json")

user_features = {"last_send_days": 10, "total_payment": 5000} # 近10天未推送,高价值用户

decision = engine.predict(user_features)

# 输出:{"decision": "accept", "coupon_amount": 75(50×1.5), "sms_content": "..."}

设计亮点:

- 规则可配置化:通过JSON/YAML文件定义规则,无需修改代码即可更新;

- 优先级明确:拒绝规则(硬约束)优先于修正规则(软调整);

- 可扩展性:支持新增规则类型(如“用户分层规则”“渠道优先级规则”)。

9.2 实时特征服务的性能优化:从“分钟级”到“毫秒级”响应

核心挑战:特征平台如何支持高并发、低延迟的特征查询?

- 解决方案:多级缓存+预计算+索引优化。

技术细节:

- 预计算离线特征:将T+1更新的特征(如“月均消费”)提前计算并存入Redis;

- 实时特征流处理:用Flink处理实时行为特征(如“最近一次点击商品ID”),写入Redis;

- 多级缓存:

- L1:应用内存缓存(热点用户特征,如TOP 10%活跃用户);

- L2:Redis集群(所有用户特征,支持主从复制与分片);

- 索引优化:ClickHouse表按user_id分区,特征查询走主键索引。

性能优化效果:

- 特征查询延迟从100ms→15ms(降低85%);

- 支持并发查询从500 QPS

更多推荐

已为社区贡献125条内容

已为社区贡献125条内容

所有评论(0)