GSPO算法:从Token级到序列级,优化大模型强化学习训练的关键突破

大语言模型训练分预训练和后训练两阶段。针对强化学习中的不稳定性问题,Qwen团队提出GSPO算法,将优化从Token级提升至序列级。GSPO通过序列级重要性采样,削减方差、规避路由震荡,显著提升MoE模型训练效率,且对AI基础设施更友好。该算法通过统一序列级优化目标,实现从"局部纠偏"到"全局协同"的转变,为大型语言模型提供更稳定的训练范式。

简介

大语言模型训练分预训练和后训练两阶段。针对强化学习中的不稳定性问题,Qwen团队提出GSPO算法,将优化从Token级提升至序列级。GSPO通过序列级重要性采样,削减方差、规避路由震荡,显著提升MoE模型训练效率,且对AI基础设施更友好。该算法通过统一序列级优化目标,实现从"局部纠偏"到"全局协同"的转变,为大型语言模型提供更稳定的训练范式。

一、背景

当前大语言模型(LLM)的训练已经形成了清晰的两阶段范式:Pre-training(预训练) 和 Post-training(后训练)。这两个阶段目标不同,所需数据和资源各异,共同塑造了模型的最终能力。

在Pre-training(预训练)阶段,目标是利用**海量、多样化(多语言)、未标注的文本数据输入,以自监督学习作为核心方法,**学习通用语言表示和世界知识,构建出一个强大的基础模型(Base model)。需要注意的是基础模型拥有强大的语言理解和生成潜力,但行为不可控、可能生成有害/偏见内容、以及难以可靠地遵循指令。

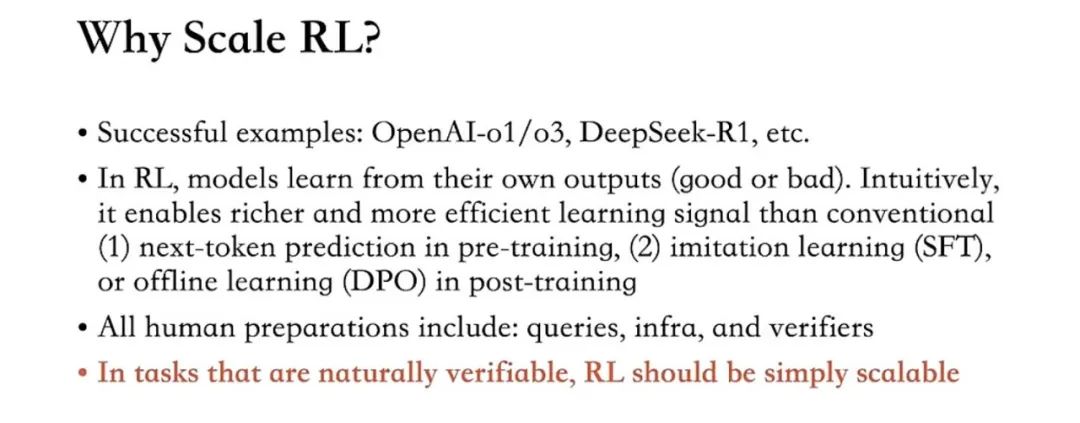

在Post-training(后训练)阶段,目标是在基础模型的基础上,利用高质量、标注精细的数据进行训练,使模型的行为****更安全、更有用、更符合人类意图。Post-training包含了多种技术,包括指令微调(SFT)、强化学习 (RL)、模型对齐(Alignment)等。 这其中,强化学习 (Reinforcement Learning,RL)已成为拓展语言模型、增强其深度推理与问题求解能力的关键技术范式,并且有了OpenAI-O1/O3、DeepSeek-R1的成功经验在先。

为了持续拓展RL,Qwen研究团队7月底发表了最新的《Group Sequence Policy Optimization》论文,并在本周技术直播中解读了背后的训练秘籍。具体而言,是观察到现有的 RL 常用算法如PPO、GRPO在长期训练中会暴露出严重的不稳定性问题并招致不可逆转的模型崩溃,阻碍了通过增加计算以获得进一步的性能提升。论文中提出了 Group Sequence Policy Optimization (GSPO) 算法,不同于过去的 RL 算法,GSPO 定义了序列级别(Sequence)的重要性比率,并在序列层面执行裁剪、奖励和优化。

二、GSPO算法的优化

强化学习GRPO、GSPO等算法的核心流程是对同一提示(Prompt)并行生成多个响应之后,构成一个比较组(Group),通过组内奖励归一化计算相对优势和优化损失函数,并更新语言模型策略。

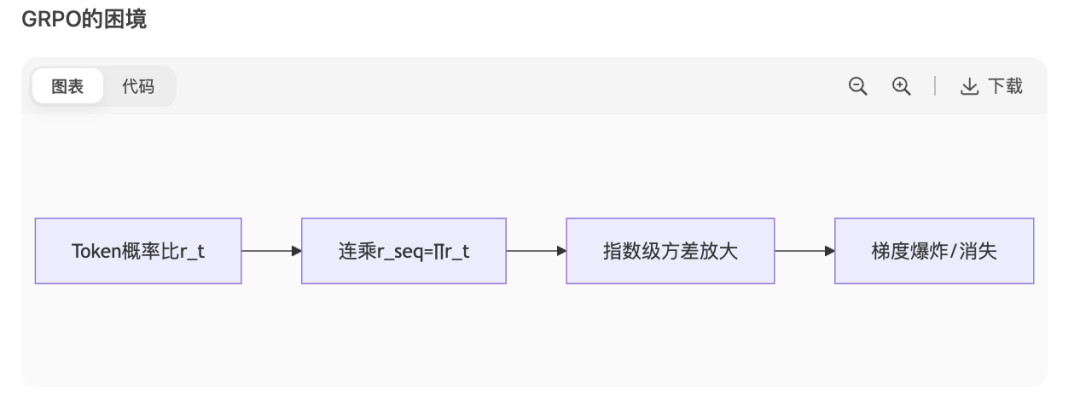

不同点在于,GRPO算法的采样是Token级,GSPO将重要性采样从Token级提升至序列级,基于整个响应的似然计算权重,并通过长度归一化控制方差。【通俗来讲:GRPO关注每个token生成的好不好进行打分,GSPO关注整个序列生成的好不好进行打分】,这样做带来的最直观的改变在于:

- 方差削减:GRPO中的Token级权重连乘会导致指数级方差增长,GSPO序列级权重作为整体计算,方差恒定可控。

图:GRPO算法中token指数级的方差放大带来的梯度爆炸/消失

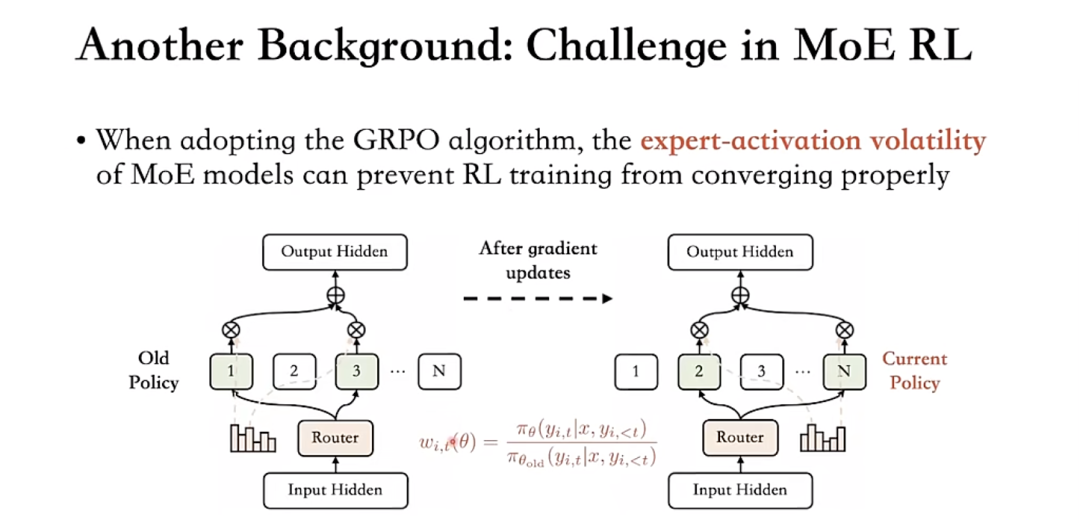

- 规避路由震荡:对于MoE(Mixture of Experts)模型,GRPO的Token级采样会因路由策略变化导致权重剧烈波动(每次激活的专家不一定是同一个),而GSPO序列级采样忽略内部路由细节,只关注最终输出分布。

图:MOE架构中专家激活的波动性

三、带来的改进(Benefits of GSPO)

3.1 训练效率与性能的提升—尤其在MOE模型中

与密集模型的强化学习(RL)训练相比,MoE 模型的稀疏激活特性带来了独特的稳定性挑战。具体而言,我们发现采用 GRPO 算法时,MoE 模型的专家激活波动性会阻碍 RL 训练的收敛。具体来说,经过一个或多个梯度更新后,为同一响应激活的专家可能会发生显著变化…这种现象在更深层的 MoE 模型中更为突出,导致 token 级重要性比率大幅波动,并进一步使其失效,如 § 3 和 4.2 所讨论,最终阻碍了 RL 训练的正常收敛。

https://www.arxiv.org/abs/2507.18071

在混合专家(Mixture-of-Experts,MoE)模型架构中,针对上述问题,先前的做法是采用路由回放(Routing Replay),路由重放策略在 MoE 模型的 GRPO 训练的正常收敛中起着关键作用,尽管路由重放能够使 MoE 模型的 GRPO 训练正常收敛,但显而易见是,其重复使用路由模式的做法会带来额外的内存和通信开销,同时也会限制 MoE 模型的实际容量。

由于**GSPO 序列级采样忽略内部路由细节,只关注最终输出分布,则无需该策略,自然而然的GSPO 表现出比 GRPO **显著更高的训练效率**,即在同等计算开销下能够取得更优的性能。**

3.2 AI infra友好

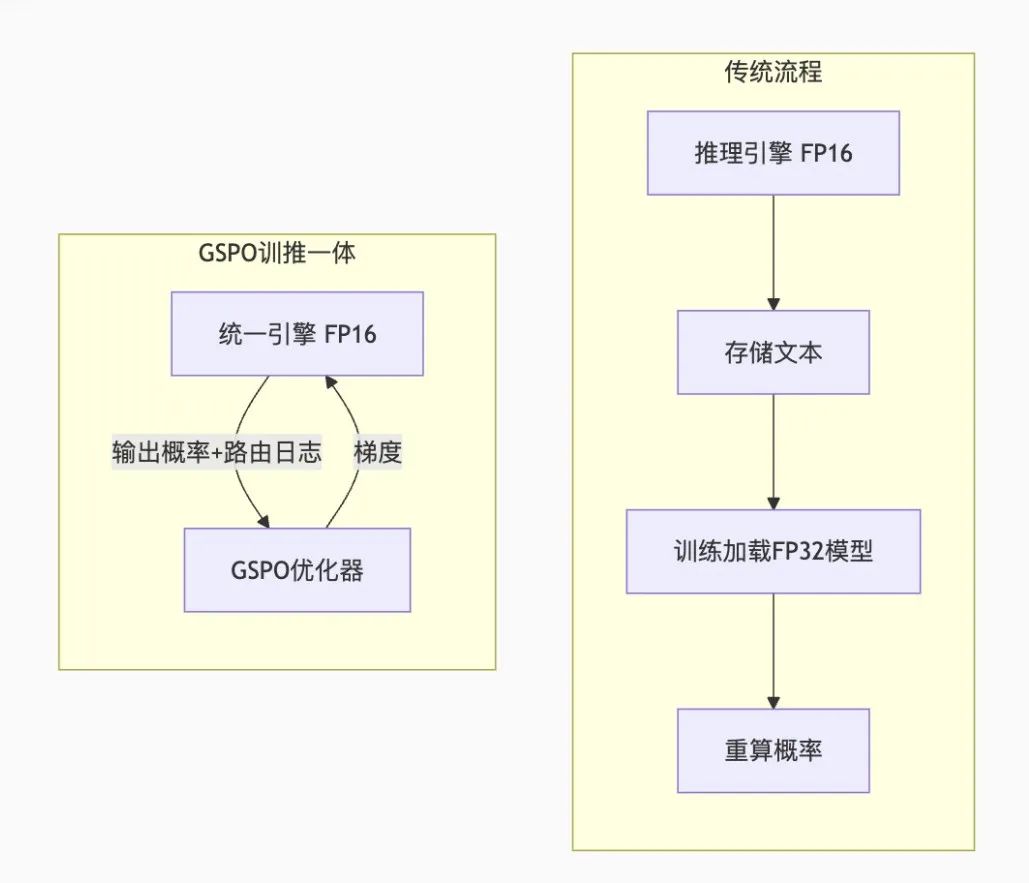

除了在上述MOE中带来的计算开销节省(infra和算法同学皆大欢喜,至少不用这么重的Routing Replay),同时由于在序列层面执行优化,GSPO 原则上对精度容忍度更高,具有简化 RL 基础设施的诱人前景。

先延伸温习一下基础知识:模型训练与推理的本质差异导致了精度需求的分歧,根本矛盾在于训练需反向传播,推理只需前向计算。在推理阶段,单次前向的误差容忍性较大,输出概率分布只需保持****相对大小(例:Top-3概率不变即可),因此可用低精度(FP16/INT8)。在训练阶段,反向传播本质是链式法则下的连续微分,而连乘会导致误差指数放大。受限于梯度计算的脆弱性,因此训练要优先高精度(FP32),否则会导致低精度误差带来的灾难案例——误差飞到上天,优化方向完全错。

传统强化学习算法中梯度计算需要计算整个序列的概率连乘,长文本容易导致概率值极小,在FP16下会下溢归零。GSPO算法它只关心同一模型对不同响应的相对偏好,不计算长文本的联合概率,进而梯度更新仅绕过了概率连乘的问题。GSPO 仅使用序列级别而非 token 级别的似然进行优化(直观上前者对精度差异的容忍度要高得多)再叠加长度归一化,抑制了极端值的出现,使梯度幅度更稳定。

GSPO 使得直接使用推理引擎返回的似然进行优化成为可能,从而无需使用训练引擎重新计算,推理和训练的精度需求不同带来的重算,会带来工程级灾难,如显存消耗、计算冗余、时间代价等。

图:GSPO 使得直接使用推理引擎返回的似然进行优化成为可能

需要注意的是,即使算法本身虽然兼容,这里也仍有一些别的问题需工程手段“保驾护航”:Loss Scaling(损失缩放)、混合精度训练(AMP)、梯度裁剪(Gradient Clipping)等。

3.3 可拓展性的展望

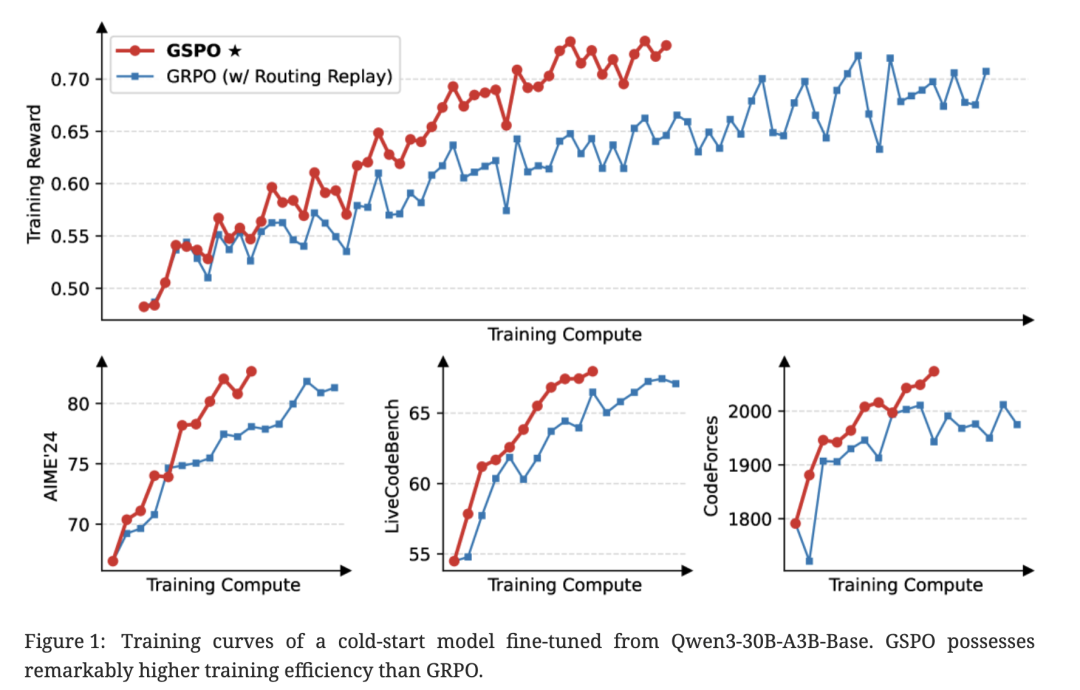

使用 GSPO 进行训练的整个过程是稳定的。我们观察到,通过增加训练计算量、定期更新查询集和扩展生成长度,GSPO 能够实现持续的性能提升。此外,GSPO 在训练效率方面也优于 GRPO,在相同的训练计算量和消耗的查询量下,实现了更好的训练精度和基准性能。最后,我们已成功将 GSPO 应用于最新 Qwen3 模型的 RL 训练,有力地证明了 GSPO 在释放 RL 扩展对大型语言模型的作用方面的有效性。

https://www.arxiv.org/abs/2507.18071

从论文中来看,GSPO 表现出比 GRPO 显著更高的训练效率,即在同等计算开销下取得了更优的性能表现,尤其是 “GSPO 可以通过增加算力来获得持续的性能提升——这正是我们所期待的算法的可拓展性。 ”(Scaling Law未死)

图:从 Qwen3-30B-A3B-Base 微调得到的冷启动模型的训练曲线。GSPO 的训练效率明显优于 GRPO

结论:GSPO 相较于 GRPO 算法,在训练效率和性能上均表现更优,尤其是显著稳定了专家混合(MoE)RL 训练,并具有简化 RL 基础设施设计和可拓展性的潜力,这些优势促成了最新 Qwen3 模型中的显著改进。

结束语:更深层次的讨论

传统强化学习算法(如PPO、GRPO),普遍技术路线是对模型输出的每个Token逐个优化,核心假设是局部最优可逼近全局最优,但在大模型尤其是长文本场景下反而会引入噪声和偏差,甚至导致模型迷失方向。

问题的本质是:我们日常使用中,会用模型的整体回复内容来评价它的表现(如最新发布的GPT-5),这样的背景下如果我们用逐词的方法去训练优化它,却用整体回复内容去评价它,这样就会导致奖励和优化的目标出现错配。

大道至简,GSPO的核心思路就是返璞归真:把奖励和优化目标重新对齐,从逐词打分到整句优化,这种思路切换最终带来了上述出人意料的效果。GSPO通过统一序列级优化目标,将大模型RL训练从“局部纠偏”推向“全局协同”,尤其为MoE模型提供了稳定的训练范式。其设计哲学优化粒度需匹配任务本质也或将成为下一代RL算法的黄金准则。

AI大模型学习路线

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献203条内容

已为社区贡献203条内容

所有评论(0)