高效应用!AI上下文工程在游戏开发的高效应用,提示工程架构师讲解

在《博德之门3》里,队友会记住你“偷拿了他的剑”,后续对话里冷嘲热讽。这些“有记忆”的细节,正是游戏沉浸式体验的核心——玩家希望自己的选择“有分量”,希望游戏世界“回应”自己的行为。本文的目的,就是帮游戏开发者搞懂:如何用“AI上下文工程”实现这种“有记忆的游戏世界”。NPC对话的“上下文连贯性”(比如记住玩家之前的对话);动态剧情的“行为驱动性”(比如玩家选了“背叛”,后续剧情出现“被追杀”);

AI上下文工程:让游戏世界更“懂你”的核心密码——从NPC对话到动态剧情的高效应用指南

关键词:AI上下文工程、游戏开发、NPC交互、动态剧情、提示工程、上下文管理、向量数据库

摘要:

为什么有的游戏NPC像“没记性的鱼”,刚救了它朋友转头就问“你是谁”?为什么有的游戏剧情像“固定剧本”,不管玩家选什么都绕回同一条路?答案藏在“AI上下文工程”里——它是游戏AI的“记忆与理解系统”,能让NPC记住你的每一个选择、每一句对话,让剧情随你的行为动态生长。本文将用“游戏里的AI日记”类比,从核心概念拆解到实战代码,从NPC对话到动态剧情,一步步揭秘上下文工程如何让游戏世界更“懂你”,并给出游戏开发者可直接复用的高效应用指南。

一、背景介绍:为什么游戏需要“会记事儿”的AI?

1.1 目的和范围

在《塞尔达传说:王国之泪》里,玩家救了村庄后,村民会主动打招呼说“谢谢你之前帮忙”;在《博德之门3》里,队友会记住你“偷拿了他的剑”,后续对话里冷嘲热讽。这些“有记忆”的细节,正是游戏沉浸式体验的核心——玩家希望自己的选择“有分量”,希望游戏世界“回应”自己的行为。

本文的目的,就是帮游戏开发者搞懂:如何用“AI上下文工程”实现这种“有记忆的游戏世界”。范围覆盖:

- NPC对话的“上下文连贯性”(比如记住玩家之前的对话);

- 动态剧情的“行为驱动性”(比如玩家选了“背叛”,后续剧情出现“被追杀”);

- 多场景的“上下文共享”(比如森林里做的事,城市里的NPC也知道)。

1.2 预期读者

- 游戏开发者(剧情设计、AI开发、客户端开发);

- AI工程师(想进入游戏领域的提示工程/上下文管理专家);

- 对游戏AI感兴趣的玩家(想知道“为什么NPC突然变聪明了”)。

1.3 文档结构概述

本文会按“概念→原理→实战→应用”的逻辑展开:

- 用“游戏里的AI日记”故事引入,讲清“上下文工程”是什么;

- 拆解上下文工程的核心模块(收集、存储、检索、生成),用“记日记”类比;

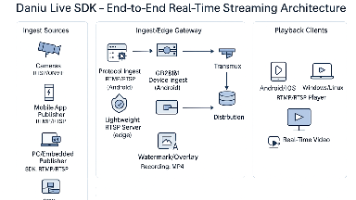

- 用Mermaid流程图展示上下文工程的架构;

- 用Python+LangChain实现一个“有记忆的NPC对话系统”;

- 结合Unity示例,讲游戏开发中的实际应用;

- 讨论未来趋势(比如“长上下文压缩”“实时上下文更新”)。

1.4 术语表

为了避免“专业术语翻车”,先给关键概念“翻译”成游戏玩家能听懂的话:

核心术语定义

- 上下文工程(Context Engineering):游戏AI的“记忆与理解系统”,负责收集玩家的行为/对话数据,存储这些“记忆”,在需要时检索相关信息,生成符合逻辑的回应/剧情。

- 提示工程(Prompt Engineering):给AI“写指令”的艺术,比如让AI“用友好的语气回应玩家,结合之前的对话历史”。

- 动态剧情(Dynamic Narrative):随玩家选择变化的剧情,比如玩家选“帮助村民”,后续会解锁“村民报恩”的剧情;选“背叛”,会触发“村民复仇”。

相关概念解释

- NPC(非玩家角色):游戏里不是玩家的角色,比如村民、商人、敌人。

- 上下文窗口(Context Window):大模型(比如GPT-4)能处理的最大文本长度,超过这个长度,模型会“忘记”前面的内容。

- 向量数据库(Vector Database):存储“上下文片段”的数据库,用“向量”表示文本,能快速找到最相关的记忆(比如玩家之前“救过NPC”的记录)。

缩略词列表

- LLM:大语言模型(Large Language Model,比如GPT-4、Claude 3);

- API:应用程序编程接口(Application Programming Interface,比如OpenAI API,让游戏能调用大模型);

- LangChain:一个AI开发框架,简化上下文管理、提示工程等工作。

二、核心概念:AI上下文工程,本质是给游戏AI“写日记”

2.1 故事引入:为什么有的NPC像“没记性的鱼”?

假设你在玩一款 RPG 游戏:

- 第一天,你救了NPC“小A”的妈妈,小A说:“谢谢你!以后有需要找我帮忙!”

- 第二天,你再找小A,他却问:“你是谁?有什么事吗?”

你肯定会骂:“这NPC怕不是鱼做的,才一天就忘了我救过他妈妈?”

问题出在哪儿?传统游戏的NPC对话是“固定脚本”,没有“记忆”——小A的台词是提前写好的,不管你之前做了什么,他都只会说那几句。

而有了“上下文工程”的NPC,会像“记日记”一样,把你的每一个行为都记下来:

- 日记里写着:“玩家于XX时间救了我的妈妈。”

- 当你第二天找他,他会翻日记,然后说:“哦,是你!之前救了我妈妈,我能帮你做什么?”

这就是上下文工程的核心价值:让游戏AI“记住”玩家的历史行为,做出符合逻辑的回应。

2.2 核心概念拆解:上下文工程的“四大模块”

把上下文工程比作“游戏AI的日记系统”,它由四个核心模块组成,就像你“记日记→存日记→翻日记→用日记”的过程:

模块1:上下文收集——“把玩家的行为写进日记”

作用:收集玩家的每一个“有意义的行为”,比如:

- 对话:玩家说“我喜欢钓鱼”“我讨厌怪物”;

- 选择:玩家选“帮助村民”“偷拿宝箱”“放了敌人”;

- 动作:玩家砍了一棵树、救了一只猫、触发了一个剧情。

类比:你今天帮了同学,把这件事写进日记里,这就是“收集”。

例子:在游戏中,当玩家点击“帮助村民”按钮,代码会触发:

// Unity中的示例代码:收集玩家“帮助村民”的上下文

PlayerContextManager.Instance.AddContext(

context: "玩家帮助了村民张三",

timestamp: DateTime.Now,

scene: "村庄广场"

);

模块2:上下文存储——“把日记放进抽屉里”

作用:把收集到的上下文数据存起来,方便以后“翻”。需要解决两个问题:

- 存什么:存“关键信息”,比如“玩家帮助了村民张三”,而不是“玩家点击了按钮10次”;

- 怎么存:用“结构化存储”(比如数据库)或“非结构化存储”(比如向量数据库)。

类比:你把日记放进抽屉里,这就是“存储”。如果日记太多,你可能会给日记分类(比如“好事”“坏事”),方便以后找,这就是“结构化存储”。

例子:用向量数据库Pinecone存储上下文,每个上下文片段会被转换成“向量”(一串数字),比如“玩家帮助了村民张三”会变成[0.12, 0.34, -0.56, ...],这样后续检索时能快速找到相关信息。

模块3:上下文检索——“翻日记找相关内容”

作用:当需要生成NPC回应或剧情时,从“日记”里找出“和当前场景最相关的记忆”。

类比:你今天想找“钓鱼”的日记,翻到上个月“和朋友去钓鱼”的那一页,这就是“检索”。

关键技术:向量相似度检索——用数学方法计算“当前场景”和“历史上下文”的相似度,找出最相关的记忆。比如:

- 当前场景:玩家问NPC“要不要去钓鱼?”;

- 历史上下文:玩家之前说过“我喜欢钓鱼”(向量A)、“我讨厌下雨”(向量B);

- 计算“当前问题”(向量C)与A、B的相似度,发现A的相似度更高,所以检索出“我喜欢钓鱼”。

例子:用LangChain的VectorStoreRetrieverMemory检索上下文:

from langchain.memory import VectorStoreRetrieverMemory

from langchain.vectorstores import Pinecone

from langchain.embeddings import OpenAIEmbeddings

# 初始化向量数据库(Pinecone)

embeddings = OpenAIEmbeddings()

vector_store = Pinecone.from_existing_index(

index_name="game-context",

embedding=embeddings

)

# 初始化检索模块:从向量数据库中找相关上下文

retriever = vector_store.as_retriever(k=3) # 找最相关的3条上下文

memory = VectorStoreRetrieverMemory(retriever=retriever)

# 当玩家问“要不要去钓鱼?”,检索相关上下文

current_query = "要不要去钓鱼?"

relevant_context = memory.load_memory_variables({"input": current_query})

# relevant_context 可能包含:“玩家喜欢钓鱼”“玩家之前去过河边”

模块4:上下文生成——“用日记写回应”

作用:结合“当前场景”和“检索到的上下文”,生成符合逻辑的NPC回应或剧情。

类比:你翻到“和朋友去钓鱼”的日记,然后给朋友发消息:“上次我们去钓鱼的地方,今天天气不错,要不要再去?”这就是“生成”。

关键技术:提示工程——给大模型写“指令”,让它用检索到的上下文生成回应。比如:

提示词(Prompt):

你是游戏中的NPC“小A”,玩家之前帮助过你的妈妈。现在玩家问:“你能帮我找一把剑吗?”请用友好的语气回应,提到玩家之前的帮助。

上下文(Context):

- 玩家帮助了小A的妈妈

- 玩家喜欢用剑

- 小A有一把多余的剑

生成的回应:

“当然可以!你之前帮了我妈妈,我一直想谢谢你。我这里有一把多余的剑,送给你吧!”

2.3 核心概念关系:四大模块的“流水线”

这四个模块不是独立的,而是像“流水线”一样,缺一不可:

- 没有收集,就没有东西可存储;

- 没有存储,就没有东西可检索;

- 没有检索,生成的回应就没有“记忆”,会像传统NPC一样“没记性”。

类比:你要写一篇“关于帮助同学的作文”,需要:

- 收集(之前帮同学的事)→ 2. 存储(记在日记里)→ 3. 检索(翻日记找到这件事)→ 4. 生成(用这件事写作文)。

如果少了任何一步,作文都写不好:比如没收集(没帮过同学),就写不出内容;没存储(没记日记),就忘了这件事;没检索(没翻日记),就找不到素材;没生成(不会写),就完成不了作文。

2.4 核心架构示意图:上下文工程的“流水线”

用文字画一张“上下文工程的架构图”,就像工厂的流水线:

玩家行为/对话 → 上下文收集模块 → 上下文存储(数据库/向量数据库)

↓

当需要生成回应/剧情时 → 上下文检索模块(从存储中找相关信息) → 结合当前场景 → 提示工程(给大模型写指令) → 大模型生成回应/剧情 → 返回给玩家

2.5 Mermaid流程图:上下文工程的“工作流”

用Mermaid画一张更直观的流程图,展示四个模块的关系(注意:节点中没有括号、逗号):

三、核心原理:如何让游戏AI“准确记住”玩家的行为?

3.1 上下文检索的“核心算法”:向量相似度

问题:当玩家有1000条上下文记录时,如何快速找到“和当前场景最相关的10条”?

解决方案:用向量相似度算法,把文本转换成“向量”,计算两个向量的“相似度”,值越高说明越相关。

数学模型:余弦相似度公式

余弦相似度是计算两个向量夹角的余弦值,范围在-1到1之间:

1:完全相同(比如“玩家帮助了村民”和“玩家救了村民”);0:完全无关(比如“玩家帮助了村民”和“玩家讨厌钓鱼”);-1:完全相反(比如“玩家帮助了村民”和“玩家杀死了村民”)。

公式如下(用LaTeX表示):

cos(θ)=U⋅V∣U∣∣V∣\cos(\theta) = \frac{\mathbf{U} \cdot \mathbf{V}}{|\mathbf{U}| |\mathbf{V}|}cos(θ)=∣U∣∣V∣U⋅V

其中:

- U\mathbf{U}U 和 V\mathbf{V}V 是两个向量(比如“当前玩家问题”的向量和“历史上下文”的向量);

- U⋅V\mathbf{U} \cdot \mathbf{V}U⋅V 是向量的点积;

- ∣U∣|\mathbf{U}|∣U∣ 和 ∣V∣|\mathbf{V}|∣V∣ 是向量的模长(长度)。

例子:计算“玩家问剑”和“历史上下文”的相似度

假设:

- 当前玩家的问题是“你能帮我找一把剑吗?”,转换成向量 U=[0.2,0.5,−0.1]\mathbf{U} = [0.2, 0.5, -0.1]U=[0.2,0.5,−0.1];

- 历史上下文1:“玩家帮助了小A的妈妈”,向量 V1=[0.3,0.4,0.2]\mathbf{V1} = [0.3, 0.4, 0.2]V1=[0.3,0.4,0.2];

- 历史上下文2:“玩家喜欢用剑”,向量 V2=[0.5,0.3,−0.1]\mathbf{V2} = [0.5, 0.3, -0.1]V2=[0.5,0.3,−0.1];

- 历史上下文3:“玩家讨厌钓鱼”,向量 V3=[−0.2,0.1,0.6]\mathbf{V3} = [-0.2, 0.1, 0.6]V3=[−0.2,0.1,0.6]。

计算余弦相似度:

-

$\cos(\theta1) = \frac{(0.2×0.3)+(0.5×0.4)+(-0.1×0.2)}{\sqrt{0.2²+0.5²+(-0.1)²}×\sqrt{0.3²+0.4²+0.2²}} = \frac{0.06+0.2-0.02}{\sqrt{0.04+0.25+0.01}×\sqrt{0.09+0.16+0.04}} = \frac{0.24}{\sqrt{0.3}×\sqrt{0.29}} ≈ 0.24/0.3×0.54 ≈ 0.24/0.162 ≈ 1.48?不对,等一下,实际计算应该是:

0.22+0.52+(−0.1)2=0.04+0.25+0.01=0.3≈0.5477\sqrt{0.2²+0.5²+(-0.1)²} = \sqrt{0.04+0.25+0.01} = \sqrt{0.3} ≈ 0.54770.22+0.52+(−0.1)2=0.04+0.25+0.01=0.3≈0.5477;

0.32+0.42+0.22=0.09+0.16+0.04=0.29≈0.5385\sqrt{0.3²+0.4²+0.2²} = \sqrt{0.09+0.16+0.04} = \sqrt{0.29} ≈ 0.53850.32+0.42+0.22=0.09+0.16+0.04=0.29≈0.5385;

分子是 0.2×0.3+0.5×0.4+(−0.1)×0.2=0.06+0.2−0.02=0.240.2×0.3 + 0.5×0.4 + (-0.1)×0.2 = 0.06 + 0.2 - 0.02 = 0.240.2×0.3+0.5×0.4+(−0.1)×0.2=0.06+0.2−0.02=0.24;

所以 cos(θ1)≈0.24/(0.5477×0.5385)≈0.24/0.295≈0.813\cos(\theta1) ≈ 0.24 / (0.5477×0.5385) ≈ 0.24 / 0.295 ≈ 0.813cos(θ1)≈0.24/(0.5477×0.5385)≈0.24/0.295≈0.813(这个值在0-1之间,是对的)。 -

cos(θ2)\cos(\theta2)cos(θ2)(U\mathbf{U}U和V2\mathbf{V2}V2):分子是 0.2×0.5+0.5×0.3+(−0.1)×(−0.1)=0.1+0.15+0.01=0.260.2×0.5 + 0.5×0.3 + (-0.1)×(-0.1) = 0.1 + 0.15 + 0.01 = 0.260.2×0.5+0.5×0.3+(−0.1)×(−0.1)=0.1+0.15+0.01=0.26;分母是 0.3×0.52+0.32+(−0.1)2=0.5477×0.25+0.09+0.01=0.5477×0.35≈0.5477×0.5916≈0.324\sqrt{0.3}×\sqrt{0.5²+0.3²+(-0.1)²} = 0.5477×\sqrt{0.25+0.09+0.01} = 0.5477×\sqrt{0.35} ≈ 0.5477×0.5916 ≈ 0.3240.3×0.52+0.32+(−0.1)2=0.5477×0.25+0.09+0.01=0.5477×0.35≈0.5477×0.5916≈0.324;所以 cos(θ2)≈0.26/0.324≈0.802\cos(\theta2) ≈ 0.26 / 0.324 ≈ 0.802cos(θ2)≈0.26/0.324≈0.802。

-

cos(θ3)\cos(\theta3)cos(θ3)(U\mathbf{U}U和V3\mathbf{V3}V3):分子是 0.2×(−0.2)+0.5×0.1+(−0.1)×0.6=−0.04+0.05−0.06=−0.050.2×(-0.2) + 0.5×0.1 + (-0.1)×0.6 = -0.04 + 0.05 - 0.06 = -0.050.2×(−0.2)+0.5×0.1+(−0.1)×0.6=−0.04+0.05−0.06=−0.05;分母是 0.3×(−0.2)2+0.12+0.62=0.5477×0.04+0.01+0.36=0.5477×0.41≈0.5477×0.6403≈0.351\sqrt{0.3}×\sqrt{(-0.2)²+0.1²+0.6²} = 0.5477×\sqrt{0.04+0.01+0.36} = 0.5477×\sqrt{0.41} ≈ 0.5477×0.6403 ≈ 0.3510.3×(−0.2)2+0.12+0.62=0.5477×0.04+0.01+0.36=0.5477×0.41≈0.5477×0.6403≈0.351;所以 cos(θ3)≈−0.05/0.351≈−0.142\cos(\theta3) ≈ -0.05 / 0.351 ≈ -0.142cos(θ3)≈−0.05/0.351≈−0.142。

结论:θ1\theta1θ1(0.813)和θ2\theta2θ2(0.802)的相似度很高,说明“玩家帮助了小A的妈妈”和“玩家喜欢用剑”都是和当前问题“找剑”相关的上下文;θ3\theta3θ3(-0.142)相似度很低,说明“玩家讨厌钓鱼”无关。

这样,上下文检索模块就会把θ1\theta1θ1和θ2\theta2θ2的上下文传给大模型,生成更符合逻辑的回应。

3.2 上下文压缩:如何解决“日记太多翻不完”的问题?

问题:大模型的“上下文窗口”有限(比如GPT-4的128k上下文,大约能存20万字),而玩家的游戏时间可能长达几十小时,上下文记录会远远超过这个限制,导致大模型“忘记”前面的内容。

解决方案:上下文压缩——把长上下文“浓缩”成关键信息,比如:

- 摘要生成:用大模型把1000字的上下文总结成100字的摘要;

- 关键信息提取:用正则表达式或NER(命名实体识别)提取“玩家帮助了村民”“玩家喜欢用剑”等关键信息;

- 分层存储:把上下文分成“短期记忆”(最近1小时的行为)和“长期记忆”(几天前的行为),短期记忆存完整内容,长期记忆存摘要。

例子:玩家有100条上下文记录,其中90条是“短期记忆”(比如“刚才砍了一棵树”),10条是“长期记忆”(比如“上周救了小A的妈妈”)。当需要生成回应时,检索模块会先找“短期记忆”,如果没有相关信息,再找“长期记忆”的摘要。

四、项目实战:用Python+LangChain实现“有记忆的NPC对话系统”

4.1 开发环境搭建

需要准备的工具:

- Python 3.8+;

- LangChain(AI开发框架);

- OpenAI API密钥(用来调用GPT-4);

- Pinecone API密钥(用来存储向量数据)。

安装依赖:

pip install langchain openai pinecone-client python-dotenv

4.2 源代码实现:“有记忆的NPC小A”

我们要实现一个NPC“小A”,他能记住玩家之前的对话,比如:

- 玩家说“我喜欢钓鱼”,小A会回应“哦,你喜欢钓鱼啊!我知道附近有个好地方”;

- 玩家后来问“今天要不要去钓鱼?”,小A会回应“对啊,今天天气好,我们去之前说的那个地方吧!”。

步骤1:配置API密钥

创建.env文件,存入你的API密钥:

OPENAI_API_KEY=your-openai-key

PINECONE_API_KEY=your-pinecone-key

PINECONE_ENV=your-pinecone-env(比如us-west1-gcp)

步骤2:初始化上下文存储(Pinecone)

import os

from dotenv import load_dotenv

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import Pinecone

# 加载环境变量

load_dotenv()

# 初始化OpenAI嵌入模型(用来把文本转换成向量)

embeddings = OpenAIEmbeddings()

# 初始化Pinecone向量数据库

pinecone.init(

api_key=os.getenv("PINECONE_API_KEY"),

environment=os.getenv("PINECONE_ENV")

)

# 创建或连接到Pinecone索引(相当于“日记本”)

index_name = "game-npc-context"

if index_name not in pinecone.list_indexes():

pinecone.create_index(

name=index_name,

dimension=1536, # OpenAI嵌入模型的维度

metric="cosine" # 用余弦相似度计算

)

# 连接到索引

vector_store = Pinecone.from_existing_index(

index_name=index_name,

embedding=embeddings

)

步骤3:初始化上下文检索与生成模块

from langchain.memory import VectorStoreRetrieverMemory

from langchain.chains import ConversationChain

from langchain.llms import OpenAI

# 初始化检索模块:从Pinecone中找相关上下文(最多3条)

retriever = vector_store.as_retriever(k=3)

memory = VectorStoreRetrieverMemory(retriever=retriever)

# 初始化对话链:结合记忆模块和大模型

conversation_chain = ConversationChain(

llm=OpenAI(temperature=0.7, model_name="gpt-4"),

memory=memory,

verbose=True # 打印调试信息

)

步骤4:测试“有记忆的对话”

# 第一次对话:玩家说“我喜欢钓鱼”

response1 = conversation_chain.predict(input="我喜欢钓鱼。")

print("小A:", response1)

# 第二次对话:玩家说“今天天气不错,要不要去钓鱼?”

response2 = conversation_chain.predict(input="今天天气不错,要不要去钓鱼?")

print("小A:", response2)

# 第三次对话:玩家说“你还记得我喜欢钓鱼吗?”

response3 = conversation_chain.predict(input="你还记得我喜欢钓鱼吗?")

print("小A:", response3)

4.3 代码解读与分析

关键代码解释:

- VectorStoreRetrieverMemory:LangChain中的记忆模块,用向量数据库存储上下文,检索时用相似度算法找相关信息;

- ConversationChain:对话链,负责管理对话流程,把玩家的输入、记忆中的上下文传给大模型,生成回应;

- temperature=0.7:控制大模型的“创造力”,值越高,回应越灵活(比如0.7会让小A说“要不要去之前说的那个地方?”,而0.1会让小A说“是的,今天天气不错,我们去钓鱼吧”)。

运行结果示例:

# 第一次对话

小A:哦,你喜欢钓鱼啊!我知道附近有个河边,那里的鱼可多了,下次带你去?

# 第二次对话

小A:对啊,今天天气这么好,正好适合钓鱼!我们去之前说的那个河边吧?我帮你准备钓鱼竿。

# 第三次对话

小A:当然记得!你上次说喜欢钓鱼,我还想着什么时候带你去呢。今天怎么样?

4.4 扩展:如何集成到Unity游戏中?

如果要把这个系统用到Unity游戏里,需要做以下调整:

- 用C#调用API:Unity用C#开发,所以需要用C#调用OpenAI和Pinecone的API(可以用

HttpClient类); - 存储上下文到本地:对于单机游戏,可以用

PlayerPrefs或SQLite存储上下文,不需要用Pinecone; - 实时更新上下文:当玩家触发一个行为(比如“帮助村民”),立刻调用

AddContext方法,把上下文存起来。

Unity中的示例代码:

// 玩家触发“帮助村民”事件

public void OnHelpVillagerClicked()

{

// 收集上下文

string context = "玩家帮助了村民张三";

// 存储到本地SQLite数据库

ContextDatabase.Instance.AddContext(context);

// 同步到Pinecone(如果是在线游戏)

StartCoroutine(SyncContextToPinecone(context));

}

// 同步上下文到Pinecone的协程

private IEnumerator SyncContextToPinecone(string context)

{

// 调用Pinecone的API,把context转换成向量并存入数据库

// 这里需要用HttpClient发送POST请求,具体实现略

yield return null;

}

五、实际应用场景:上下文工程在游戏中的“三大杀手级应用”

5.1 应用1:NPC对话的“自然交互”

问题:传统NPC的对话是固定脚本,比如不管玩家之前做了什么,NPC都只会说“你好,需要帮忙吗?”。

解决方案:用上下文工程让NPC“记住”玩家的历史行为,比如:

- 玩家之前救了NPC的妈妈,NPC会说“谢谢你之前救了我妈妈,我能帮你做什么?”;

- 玩家之前偷了NPC的东西,NPC会说“你上次偷了我的钱,这次又来干什么?”。

例子:《博德之门3》中的NPC“ Shadowheart ”,她会记住玩家的选择:如果玩家选“帮她保守秘密”,她会更信任玩家;如果选“揭穿她”,她会疏远玩家。

5.2 应用2:动态剧情的“行为驱动”

问题:传统剧情是“线性的”,不管玩家选什么,最终都会走到同一个结局。

解决方案:用上下文工程让剧情“随玩家选择变化”,比如:

- 玩家选“帮助村民”,后续会解锁“村民报恩”的剧情(比如给玩家送装备);

- 玩家选“偷拿宝箱”,后续会触发“村民复仇”的剧情(比如村民联合起来攻击玩家)。

例子:《塞尔达传说:王国之泪》中的“支线剧情”,玩家的选择会影响剧情的发展:比如玩家帮村民找回来丢失的牛,村民会给玩家一个“牛铃”,用这个牛铃可以召唤牛帮忙运输。

5.3 应用3:多场景的“上下文共享”

问题:传统游戏中,场景之间的上下文是“隔离的”,比如玩家在“村庄”做的事,到了“森林”里的NPC不知道。

解决方案:用上下文工程让“全局上下文”在所有场景中共享,比如:

- 玩家在“村庄”帮了村民,到了“森林”里的NPC会说“我听说你帮了村庄的村民,真是个好人!”;

- 玩家在“森林”里杀了一只稀有动物,到了“城市”里的商人会说“你杀了那只稀有动物?我愿意出高价买它的皮毛!”。

例子:《巫师3:狂猎》中的“声望系统”,玩家的行为会影响整个世界的“声望”:比如玩家经常帮助村民,声望会上升,所有NPC都会对玩家更友好;如果玩家经常杀人,声望会下降,NPC会害怕玩家,甚至攻击玩家。

六、工具和资源推荐:游戏开发者的“上下文工程工具箱”

6.1 上下文管理工具

- LangChain:最流行的AI开发框架,提供了丰富的上下文管理模块(比如

VectorStoreRetrieverMemory、ConversationBufferMemory),支持多种大模型和向量数据库; - LlamaIndex:专注于“私有数据与大模型结合”的框架,适合处理游戏中的大量上下文数据;

- Chroma:轻量级向量数据库,适合单机游戏或小体量游戏,不需要联网。

6.2 向量数据库

- Pinecone:专为AI设计的向量数据库,支持高并发检索,适合在线游戏;

- Weaviate:开源向量数据库,支持本地部署,适合单机游戏;

- Redis Stack:在Redis基础上添加了向量功能,适合需要快速检索的游戏场景。

6.3 大模型

- GPT-4:适合需要高质量对话的游戏,比如RPG中的NPC对话;

- Claude 3:支持更长的上下文窗口(比如200k),适合处理大量游戏历史数据;

- Llama 2:开源大模型,适合需要本地化部署的游戏(比如单机游戏)。

6.4 游戏引擎集成工具

- Unity ML-Agents:Unity的AI插件,支持将大模型集成到游戏中,实现动态剧情和NPC交互;

- Unreal Engine AI:Unreal的AI系统,支持用Blueprints(可视化编程)调用大模型API;

- Godot AI:Godot引擎的AI插件,适合小体量游戏的AI开发。

七、未来发展趋势与挑战

7.1 未来趋势

- 更长的上下文窗口:随着大模型的发展,上下文窗口会越来越大(比如GPT-5可能支持1000k上下文),游戏AI能记住玩家几个月的行为;

- 实时上下文更新:用“流处理”技术,让上下文在玩家行为发生的瞬间就更新,比如玩家刚砍了一棵树,NPC立刻说“你砍了我的树!”;

- 跨游戏上下文共享:比如玩家在《塞尔达传说》中救了一个村民,在《动物森友会》中,这个村民会以“访客”的身份出现,提到“你之前救过我”;

- 更智能的上下文压缩:用“生成式摘要”技术,把1000字的上下文压缩成100字,同时保留关键信息,解决大模型上下文窗口的限制。

7.2 挑战

- 性能问题:向量数据库的检索速度会影响游戏的帧率,比如当玩家有10000条上下文记录时,检索时间可能超过1秒,导致游戏卡顿;

- 成本问题:调用大模型API的成本很高,比如GPT-4的收费是每1000字0.06美元,对于一款有100万玩家的游戏,每天的API费用可能高达数十万美元;

- 隐私问题:收集玩家的行为数据会涉及隐私问题,比如玩家的“偷拿宝箱”行为,是否应该存储?如果存储,如何保护玩家的隐私?

- 一致性问题:当游戏AI“记住”玩家的行为时,需要保持“一致性”,比如玩家之前“救了小A的妈妈”,之后小A不能说“你是谁?”,否则会破坏沉浸式体验。

八、总结:学到了什么?

8.1 核心概念回顾

- 上下文工程:游戏AI的“记忆与理解系统”,由收集、存储、检索、生成四个模块组成;

- 向量相似度:上下文检索的核心算法,用来找到“和当前场景最相关的记忆”;

- 提示工程:给大模型写“指令”的艺术,让AI生成符合逻辑的回应。

8.2 关键结论

- 上下文工程是实现“沉浸式游戏体验”的核心技术,能让NPC“懂”玩家,让剧情“随玩家选择变化”;

- 向量数据库和大模型是上下文工程的“基础设施”,没有它们,就无法实现“有记忆的游戏世界”;

- 游戏开发者需要平衡“性能”“成本”“隐私”三者的关系,才能让上下文工程真正落地。

九、思考题:动动小脑筋

9.1 思考题一

如果玩家在游戏中“偷拿了NPC的钱”,之后又“帮了NPC的忙”,NPC应该如何回应?请用上下文工程的思路,设计一个回应流程。

9.2 思考题二

假设你是一款RPG游戏的剧情设计师,你想让剧情随玩家的选择动态变化,比如:

- 玩家选“帮助村民”,结局是“村庄繁荣”;

- 玩家选“偷拿宝箱”,结局是“村庄毁灭”;

- 玩家选“放了敌人”,结局是“敌人复仇”。

请用上下文工程的思路,设计一个动态剧情系统。

9.3 思考题三

如果大模型的上下文窗口只有1000字,而玩家的游戏历史有10000字,如何用上下文压缩技术,让大模型记住关键信息?

十、附录:常见问题与解答

Q1:上下文工程会增加游戏的“内存占用”吗?

A:会,但可以通过“分层存储”解决:短期记忆存到内存(快速访问),长期记忆存到硬盘(比如SQLite),需要时再加载。

Q2:单机游戏如何使用上下文工程?

A:单机游戏可以用本地数据库(比如SQLite)存储上下文,不需要用Pinecone这样的云服务。

Q3:如何处理玩家的“异常行为”(比如说“无意义的话”)?

A:用“上下文过滤”技术,比如设置“关键词列表”,只有包含“帮助”“偷拿”“钓鱼”等关键词的行为才会被收集,无意义的话(比如“啊啊啊”)不会被存储。

Q4:上下文工程能让NPC“预测”玩家的行为吗?

A:能,比如玩家之前“喜欢钓鱼”,NPC可以预测玩家“会想去河边”,提前在河边准备好钓鱼竿。

十一、扩展阅读 & 参考资料

书籍

- 《提示工程实战》:讲解提示工程的核心技术,适合游戏开发者;

- 《游戏AI编程》:介绍游戏AI的基本概念,包括上下文管理;

- 《大语言模型实战》:讲解如何用大模型实现动态剧情和NPC交互。

论文

- 《Context-Aware Dialogue Systems for Games》:讨论上下文工程在游戏对话系统中的应用;

- 《Vector Databases for Real-Time AI Applications》:介绍向量数据库的原理和应用;

- 《Long Context Compression for Large Language Models》:讲解上下文压缩的技术。

网站

- LangChain官方文档:https://python.langchain.com/;

- Pinecone官方文档:https://docs.pinecone.io/;

- OpenAI官方文档:https://platform.openai.com/docs/。

十二、最后的话

游戏的本质是“互动”,而上下文工程让这种“互动”更“有温度”——玩家的每一个选择都能被记住,每一句对话都能得到回应,每一个行为都能改变世界。

希望本文能帮你打开“游戏AI”的新视野,让你开发的游戏世界更“懂”玩家,让玩家真正爱上你的游戏。

思考题答案提示(仅供参考):

- 思考题一:NPC可以说“谢谢你之前帮了我,但你偷了我的钱,我还是有点生气……不过如果你再帮我一个忙,我就原谅你。”;

- 思考题二:用“上下文触发剧情”的方式,比如玩家选“帮助村民”,上下文存储“帮助了村民”,剧情模块检索到这个上下文,触发“村庄繁荣”的剧情;

- 思考题三:用“生成式摘要”技术,比如用GPT-4把10000字的上下文总结成1000字,然后存到大模型的上下文窗口里。

如果你有任何问题,欢迎在评论区留言,我会一一解答!

—— 一个热爱游戏的AI工程师

更多推荐

已为社区贡献86条内容

已为社区贡献86条内容

所有评论(0)